前文我們聊到了人工智能大模型的關鍵之一數據,今天,我們再聊聊另外一個關鍵點——算力。

1. 海量的算力市場空間

早在1961年,計算機科學家和人工智能先驅約翰·麥卡錫 (John McCarthy)就在麻省理工學院百年慶典上的演講上講過:“如果我提倡的那種計算機成為未來的計算機,那么計算可能有一天會被組織成一種公共事業,就像電話系統是一種公共事業一樣……計算機事業可能成為一個新的重要行業的基礎。”。不得不承認,這種觀點在當時是非常先進和前瞻性的。經過IT行業和通信行業辛苦奮斗大半個世紀,如今,他的設想已經成為現實。在數字浪潮下,算力已經成為像水力、電力一樣的公共基礎資源,而數據中心和通信網絡,已經成為重要的公共基礎設施。隨著數字化轉型的加速和科技創新的蓬勃發展,對于處理大規模數據、進行復雜計算和實現人工智能的需求日益增長。在當今信息時代,算力儼然成為了推動科技和社會發展的重要驅動力。

根據華為發布的《計算2030》的數據統計,全球數據量每年以指數級別增長,到2030年,人類將迎來YB數據時代。其中的"YB"代表著"Yottabyte",是數據存儲容量的一個極大單位,相當于2的80次方字節,或者1兆兆兆兆字節。YB數據時代代表了一個數據爆炸和數據價值的新時代,通用計算算力(FP32)將增長10倍,達到3.3 ZFLOPS。而AI智算算力(FP16),將增長500倍,達到105 ZFLOPS。這里的Z代表"zetta",是國際計量單位前綴之一,表示10^21的倍數。ZFLOPS表示的是每秒鐘進行的浮點運算次數,具體為每秒鐘進行的10^21次浮點運算。這是一個非常龐大的數值,用于衡量超級計算機或高性能計算集群的計算能力。

2. 什么是算力?

算力(Computing Power)是指計算機系統或設備處理數據和執行計算任務的能力。它衡量了計算機系統能夠在單位時間內完成的計算操作的數量或速度。算力通常與計算速度、計算容量和計算效率等因素相關。

衡量算力需要一系列的指標:

MIPS(Million Instructions Per Second,每秒百萬條指令數):

IPS(Instructions Per Second,每秒指令數)表示處理器每秒鐘能夠執行的指令數量。它衡量了處理器的指令執行能力,適用于通用計算任務。由于計算機性能的提升,現在普遍使用MIPS來衡量計算機或處理器每秒鐘能夠執行的百萬條指令數量。

DMIPS(Dhrystone MIPS,德赫斯頓百萬指令數):

DMIPS也是衡量計算機或處理器每秒鐘能夠執行的百萬條指令數量,是一種常用的基準測試程序。但它是基于Dhrystone基準測試的結果。Dhrystone由Reinhold P. Weicker于1984年開發,旨在模擬實際應用中的整數計算工作負載。這也是和MIPS的關鍵差別。DMIPS對整數運算的重要性更為突出,能夠更好地評估處理器在整數計算方面的性能。而MIPS則更加通用,包括整數和浮點計算等不同類型的指令。因此,某些芯片在整數計算方面表現出色,可能在DMIPS上得分較高,但在包括浮點計算的MIPS測試中可能相對較低。

FLOPS(Floating Point Operations Per Second,每秒浮點運算次數):

OPS(Operations Per Second,每秒操作數)表示設備或系統每秒鐘能夠處理的操作數量。這個指標可以是通用計算任務的操作數,也可以是特定任務中的特定操作數,取決于具體的應用場景。FLOPS就是衡量設備或系統每秒鐘能夠執行的浮點運算次數。它是衡量計算設備在浮點計算方面的性能的指標,通常用于評估處理器、GPU、加速器等在科學計算、圖形渲染、機器學習等需要大量浮點計算的應用中的計算能力。隨著處理器浮點計算性能的提升我們從一開始的MFLOP(每秒百萬浮點運算數),提升到GFLOP(每秒十億浮點運算數)、TFLOP(每秒萬億浮點運算數)、PFLOP(每秒千萬億浮點運算數)、EFLOP(每秒百億億浮點運算數)和ZZFLOP(每秒十萬億億浮點運算數)。

IOPS(Input/Output Operations Per Second,每秒輸入/輸出操作數):

IOPS是衡量存儲設備或系統每秒鐘可以處理的輸入/輸出操作數量。它通常用于衡量存儲設備的讀寫能力,如硬盤、固態硬盤(SSD)等。

TDP(Thermal Design Power):

TDP是指在標準工作負載下芯片或處理器的最大熱設計功耗。它表示芯片在設計中考慮的散熱和冷卻要求,是制造商提供的一個指導值。TDP通常以瓦特(W)為單位。

功率效率:

功耗效率是指芯片在執行特定任務時所消耗的能量與完成任務所需計算能力之間的比率。功耗效率通常以特定的計算能力單位(如FLOPS或IPS)為基準,表示為每瓦特(W)的計算能力或任務完成量。單位可以是FLOPS/W(每瓦特的浮點操作數)或IPS/W(每瓦特的指令數)。功耗效率越高,芯片在給定能源限制下能夠提供更高的計算性能。

Rpeak(峰值性能):

Rpeak(Peak Performance)是衡量處理器或系統在理論上可以達到的最高性能水平。它通常以每秒鐘可以執行的浮點運算次數(FLOPS)或整數運算次數(DMIPS)來表示。它反映了設備在理論上的最大計算能力,通常是在理想化的情況下,假設沒有任何限制和瓶頸。

Ravg(均值性能):

實際應用中的計算性能往往無法達到峰值性能。這是因為實際應用中存在各種因素的限制,例如數據依賴性、存儲訪問延遲、算法效率等。因此,考慮到這些限制因素,需要對均值性能(Ravg)進行評估。Ravg(Average Performance)是指在實際應用中,設備或系統在給定工作負載下的平均計算性能。它考慮了實際應用中的各種因素,并提供了更接近實際應用場景的性能指標。Ravg通常基于實際測試或模擬運行應用程序來獲得。

另外,在現實的場景中,衡量算力的狀況會更為復雜。單個芯片算力指標強大,未必多個芯片疊加,指標性能也會想當然的翻倍關系,因為這牽扯到:

-

-

芯片的擴展性能:需要考慮芯片之間的通信、協同工作、負載均衡等方面。

-

吞吐量和并行性:要考慮它能夠同時處理多少任務、支持多少并發操作以及整體的吞吐量。這可以通過測試系統在高負載情況下的性能來評估。

-

通信和數據傳輸:評估疊加系統時,要考慮芯片之間的通信帶寬、延遲以及數據傳輸的效率。高效的通信和數據傳輸能夠提高整體系統性能。

-

總體能耗和功耗:如果能耗過高,也意味著運行的OPEX高過,這在成本計算中非常重要,所以評估系統性能時,需要考慮功耗和能耗的因素,以確保疊加系統在提供高性能的同時,能夠保持適當的功耗和能效。

-

立體計算的復雜性:立體計算(Computing Continuum)是一個綜合了云計算和邊緣計算的概念,旨在提供更全面和靈活的算力支持。在傳統的計算模式中,云計算主要依靠中央數據中心提供計算和存儲資源,而邊緣計算則將計算任務分布到離數據源更近的邊緣設備上。而立體計算則結合了這兩種模式,將計算能力在云端和邊緣設備之間進行協同和整合。立體計算的復雜性主要體現在算力評估和資源調度方面。由于計算任務可以在云端和邊緣設備之間進行遷移和分配,需要綜合考慮多個因素來評估最佳的計算資源配置。這些因素包括任務的性質和要求、數據的位置和訪問延遲、設備的計算能力和網絡帶寬等。

-

在互聯網誕生之前,算力主要指的是單機計算能力,以大型機為代表。這些大型機由主機、終端和終端接口設備組成,擁有強大的計算和存儲能力,通常由大型企業或機構使用。

隨著互聯網和通信技術的發展,計算能力逐漸向云端遷移,引發了云計算的興起。云計算利用互聯網實現對計算資源(包括處理能力、存儲空間和軟件服務)的按需訪問和共享。云計算提供了高度靈活、可擴展和經濟高效的計算模式,使個人用戶和企業能夠根據需求快速獲取和使用計算能力,而無需投資大量資金建設自己的計算基礎設施。

隨著云計算的發展,人們開始意識到在特定領域或應用場景中,需要更強大的計算能力來處理更大規模的數據和更復雜的計算任務。這促使了超算中心(Supercomputing Center)的出現。超算中心致力于構建和運營高性能計算系統,通過集群、并行計算和優化算法等技術實現超級計算能力。超算中心廣泛應用于科學研究、天氣預報、模擬計算、大規模數據分析等領域。

智算中心(Intelligent Computing Center)則是在超算中心基礎上發展起來的概念。智算中心著重于結合人工智能和大數據分析等技術,提供高性能的智能計算能力。智算中心通過深度學習、機器學習和推理等算法,實現對復雜任務的智能處理和決策支持。智算中心的興起與人工智能應用的快速發展密切相關。

和提供虛擬化云計算服務的獲取、資源存儲、彈性擴展和靈活性的云數據中心(Cloud Data Center)以及專門用于解決科學、工程、天氣預報、氣候模擬等領域的復雜科學計算問題進行高性能計算的超級計算中心(Supercomputing Center)不同,也和注重哈希計算的比特幣礦機農場不同,今天我們談的算力,主要說的是用于用于進行復雜的人工智能數據分析、模型訓練和智能決策的智算中心(Intelligent Computing Center)。智能計算中心可以支持人工智能應用的開發、訓練和部署,例如圖像識別、自動駕駛、自然語言處理、知識圖譜、智慧家居、智能制造、智能醫療、智慧城市等領域。它通常具有優化的硬件架構和軟件工具,以提供高效的AI計算能力。智算中心需求正在呈指數級增長,未來在社會總計算需求中將占據80%以上。智算中心是智慧時代社會經濟運行必不可少的基礎設施,目的是實現智算的普惠。

隨著算力的不斷提升,計算能力會變得無處不在,滲透到人們日常生活和工作環境的每一個毛孔,每一個環節。"泛在計算"(Ubiquitous Computing)會結合智能終端、物聯網的計算能力,數據在最合適的地方,以最合適的算力來計算,減少數據搬移,提高整體系統的性能。

4. 眼花繚亂的算力芯片

從基本大類來說,基本上就是兩類,一類是通用芯片(General-Purpose Chip),一類是專用芯片(Specialized Chip)。從名稱上就可以看出來,前者具有廣泛的計算能力,設計用于處理多種不同類型任務,后者是根據特定的計算需求和應用場景而設計的芯片。它們通常針對特定的計算任務進行優化,以提供更高效的計算能力。

通用芯片基本上說的就是CPU(Central Processing Unit),x86和ARM都是最常見的通用芯片架構。x86架構是由英特爾(Intel)公司最早推出的一種指令集架構。它廣泛應用于個人電腦和服務器領域,并成為主流的桌面和數據中心處理器架構。x86架構的代表性產品包括英特爾的Core系列處理器和AMD的Ryzen系列處理器。ARM架構是一種低功耗、高性能的指令集架構,主要用于移動設備和嵌入式系統。它在智能手機、平板電腦和物聯網設備等領域得到廣泛應用。ARM架構的特點是能夠提供高性能和能效的平衡,使其適合于移動設備的需求。ARM架構的代表性產品包括高通(Qualcomm)、聯發科(MediaTek)和蘋果(Apple)等公司的處理器。APU(Accelerated Processing Unit)也是一種通用芯片。將CPU和GPU的計算能力集成在同一個芯片上,以提供更好的整體性能和能效。CPU負責通用計算任務,而GPU則專注于圖形渲染和并行計算任務。通過在同一芯片上集成CPU和GPU,APU可以提供更緊密的協同工作和更高效的數據傳輸,從而提供更好的圖形處理和整體計算性能。

專用芯片就很多種類了,我們經常聽到的DPU、GPU、NPU、TPU、FPGA和ASIC這些眼花繚亂的分類,都是專用芯片的范疇:

GPU(圖形處理器):

GPU最初設計用于圖形渲染,但由于其并行計算能力,逐漸被應用于通用計算和人工智能。GPU具有大規模的并行處理單元,適用于并行計算密集型任務,如深度學習訓練和大規模數據處理。相比于CPU,GPU在并行計算方面表現出更高的性能,但功耗也相對較高。

DPU(深度學習處理器):

DPU是專門為深度學習任務而設計的芯片。它具有高度優化的硬件和軟件結構,可以加速神經網絡的推理和訓練過程。DPU通常具有高效的矩陣計算能力和低功耗特性,使其在邊緣設備和嵌入式系統上表現出色。

NPU(神經網絡處理器):

NPU是專門為神經網絡推理任務而設計的芯片。它通過硬件優化和高度并行的計算結構,提供高效的神經網絡推理性能。NPU通常在移動設備和邊緣計算平臺上使用,以提供低功耗、實時的人工智能計算能力。

FPGA(現場可編程門陣列):

FPGA是一種可編程的硬件芯片,可以通過配置來實現不同的功能和計算任務。FPGA具有高度的靈活性和可定制性,能夠適應各種應用需求。在人工智能計算中,FPGA可以通過編程實現特定的神經網絡架構和加速算法,從而提供高性能的定制化計算。

ASIC(專用集成電路):

ASIC是專門為特定應用而設計的定制芯片,其功能在制造時已經固定,無法重新編程。在人工智能計算中,一些公司開發了專用的AI芯片(如Google的TPU),它們采用ASIC設計,通過專門的電路優化實現高效的人工智能計算。ASIC可以提供極高的性能和能效,但對于通用計算任務缺乏靈活性。

TPU(張量處理器):

TPU是由谷歌開發的專門用于人工智能加速的芯片。TPU針對大規模的深度學習工作負載進行了優化,特別擅長進行高度并行的矩陣計算。TPU在訓練和推理任務中都具有較高的性能和能效,廣泛用于云端的人工智能計算。

5. 一枝獨秀的GPU

在所有上述的專用芯片中,GPU最近是最熱門的一種。因為眾所周知,GPT就是用GPU進行訓練的。所以也讓做GPU最牛的目前絕對領先的市場地位的英偉達(NVIDIA)賺了個盤滿缽滿。

自2012年起,GPU開始被廣泛應用于構建和加速深度神經網絡。Kepler、Maxwell和Pascal架構的GPU在人工智能領域得到越來越廣泛的應用。隨著人工智能和云計算的快速發展,Volta成為第一個專注于計算方向的GPU架構,首次引入了張量核心(Tensor Cores),在深度學習場景下的性能比上一代Pascal架構提高了5倍以上。從此,GPU算力正式分化為計算和圖形兩個不同的發展方向。Turing架構更側重于圖形處理,并引入了廣為人知的RTX系列產品線,推出了許多面向消費級市場的圖形卡。

最新的Ampere架構則大幅增強了GPU在計算方向的能力。其技術突破包括采用7nm工藝、第三代張量核心(Tensor Cores)、多實例GPU(MIG)、第三代NVIDIA NVLink互聯技術、細粒度結構稀疏性等。這些新技術帶來的特性組合使得Ampere架構的A100 GPU成為多面手,適用于大數據分析、科學計算、深度學習訓練和推理等主流計算場景。A100 GPU支持構建具有高吞吐量和多功能性的彈性數據中心,大幅降低數據中心成本,使其成為云上算力的高性價比選擇,甚至成為行業算力計量的"通用貨幣"。許多關于算力的計算都以A100的數量為基準。據估計,海外巨頭平均擁有50萬片以上的A100 GPU。國內大廠也紛紛部署大型模型,因此可以預見,對A100 GPU的需求將迅速增長到百萬級別。

6. 算力部署的極限思維

但我們也必須意識到依賴進口芯片存在大概率技術依賴和供應鏈風險。如何通過發展國產人工智能芯片,降低對進口技術和產品的依賴,提高技術獨立性,減少潛在的安全和政策風險,是不可回避的問題。

中美關系的復雜性,使得我國大廠直接采用英偉達A100的可能性在下降,更不要說新發布的更強算力的H100了。所以要極限思維,做到提前戰略部署,是非常急迫的挑戰。

近期看到了北京、深圳在提升算力方面的政策出臺:

《北京市加快建設具有全球影響力的人工智能創新策源地實施方案(2023-2025年)》(簡稱《實施方案》)提出,推動國產人工智能芯片實現突破。面向人工智能云端分布式訓練需求,開展通用高算力訓練芯片研發;面向邊緣端應用場景的低功耗需求,研制多模態智能傳感芯片、自主智能決策執行芯片、高能效邊緣端異構智能芯片;面向創新型芯片架構,探索可重構、存算一體、類腦計算、Chiplet等創新架構路線。積極引導大模型研發企業應用國產人工智能芯片,加快提升人工智能算力供給的國產化率。

《深圳市加快推動人工智能高質量發展高水平應用行動方案(2023—2024年)》也提到了強化智能算力集群供給,包括:建設城市級智能算力平臺、打造大灣區智能算力樞紐以及建設企業級智能算力平臺。

從這些動作看來,加強技術獨立性,加快智能芯片開發、加快智算中心的部署迫在眉睫,刻不容緩。為北京和深圳點贊。

針對算力,除了芯片,其實還有很多可以聊的話題,為此,還是拆成兩期,智愿君下期再深入談一下智算中心所涉及的技術,咱們下期再見。

-

開源技術

+關注

關注

0文章

389瀏覽量

7914 -

OpenHarmony

+關注

關注

25文章

3660瀏覽量

16156

原文標題:河套IT TALK 89:(原創)算力引爆智能時代:解鎖無限潛能

文章出處:【微信號:開源技術服務中心,微信公眾號:共熵服務中心】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

大模型時代的算力需求

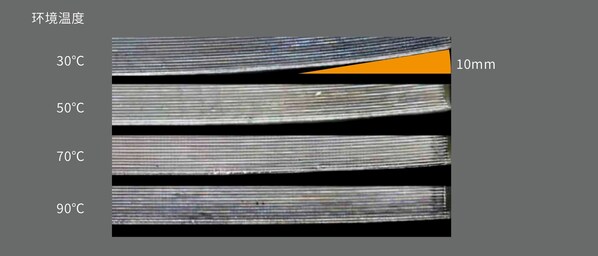

遠鑄智能發布最新白皮書 高溫腔室解鎖FDM 3D打印無限潛能

異構計算:解鎖算力潛能的新途徑

大算力時代, 如何打破內存墻

立足算力,聚焦AI!順網科技全面走進AI智算時代

河套IT TALK 89:(原創)算力引爆智能時代:解鎖無限潛能

河套IT TALK 89:(原創)算力引爆智能時代:解鎖無限潛能

評論