AI 簡(jiǎn)報(bào) 20230602 期

1. GPT-4變笨引爆輿論!文本代碼質(zhì)量都下降,OpenAI剛剛回應(yīng)了降本減料質(zhì)疑

原文:https://mp.weixin.qq.com/s/K8W5Wy95YsDo8gfFyIUmvA

大模型天花板GPT-4,它是不是……變笨了?

先是少數(shù)用戶提出質(zhì)疑,隨后大量網(wǎng)友表示自己也注意到了,還貼出不少證據(jù)。

有人反饋,把GPT-4的3小時(shí)25條對(duì)話額度一口氣用完了,都沒(méi)解決自己的代碼問(wèn)題。

無(wú)奈切換到GPT-3.5,反倒解決了。

總結(jié)下大家的反饋,最主要的幾種表現(xiàn)有:

-

以前GPT-4能寫(xiě)對(duì)的代碼,現(xiàn)在滿是Bug

-

回答問(wèn)題的深度和分析變少了

-

響應(yīng)速度比以前快了

這就引起不少人懷疑,OpenAI是不是為了節(jié)省成本,開(kāi)始偷工減料?

兩個(gè)月前GPT-4是世界上最偉大的寫(xiě)作助手,幾周前它開(kāi)始變得平庸。我懷疑他們削減了算力或者把它變得沒(méi)那么智能。

這就不免讓人想起微軟新必應(yīng)“出道即巔峰”,后來(lái)慘遭“前額葉切除手術(shù)”能力變差的事情……

網(wǎng)友們相互交流自己的遭遇后,“幾周之前開(kāi)始變差”,成了大家的共識(shí)。

一場(chǎng)輿論風(fēng)暴同時(shí)在Hacker News、Reddit和Twitter等技術(shù)社區(qū)形成。

這下官方也坐不住了。

OpenAI開(kāi)發(fā)者推廣大使Logan Kilpatrick,出面回復(fù)了一位網(wǎng)友的質(zhì)疑:

API 不會(huì)在沒(méi)有我們通知您的情況下更改。那里的模型處于靜止?fàn)顟B(tài)。

是不是真的變笨了,請(qǐng)大家也踴躍討論~

2. 能聽(tīng)懂語(yǔ)音的ChatGPT來(lái)了:10小時(shí)錄音扔進(jìn)去,想問(wèn)什么問(wèn)什么

原文:https://mp.weixin.qq.com/s/C7VzXhuG0T6Njo2pNpGRQA

類 ChatGPT 模型的輸入框里可以粘貼語(yǔ)音文檔了。

大型語(yǔ)言模型(LLM)正在改變每個(gè)行業(yè)的用戶期望。然而,建立以人類語(yǔ)音為中心的生成式人工智能產(chǎn)品仍然很困難,因?yàn)?a target="_blank">音頻文件對(duì)大型語(yǔ)言模型構(gòu)成了挑戰(zhàn)。

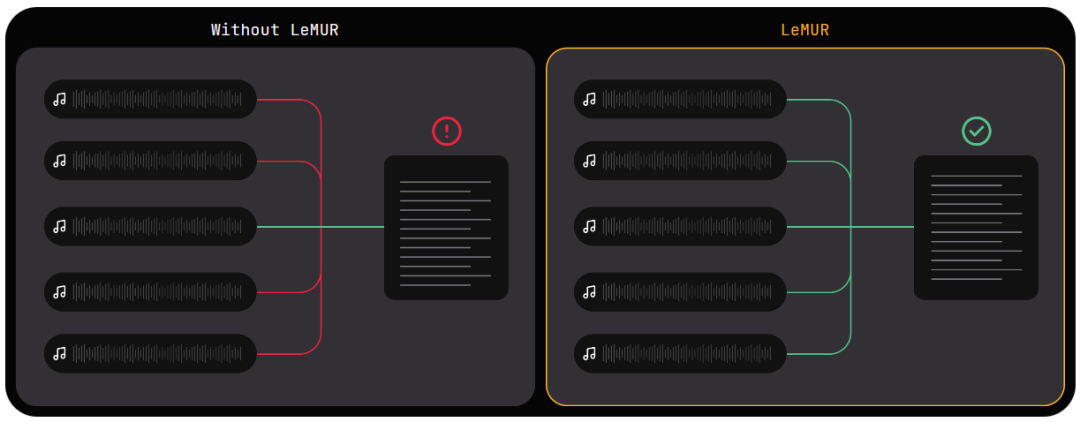

將 LLM 應(yīng)用于音頻文件的一個(gè)關(guān)鍵挑戰(zhàn)是,LLM 受其上下文窗口的限制。在一個(gè)音頻文件能夠被送入 LLM 之前,它需要被轉(zhuǎn)換成文本。音頻文件越長(zhǎng),繞過(guò) LLM 的上下文窗口限制的工程挑戰(zhàn)就越大。但工作場(chǎng)景中,我們往往需要 LLM 幫我們處理非常長(zhǎng)的語(yǔ)音文件,比如從一段幾個(gè)小時(shí)的會(huì)議錄音中抽取核心內(nèi)容、從一段訪談中找到某個(gè)問(wèn)題的答案……

最近,語(yǔ)音識(shí)別 AI 公司 AssemblyAI 推出了一個(gè)名為 LeMUR 的新模型。就像 ChatGPT 處理幾十頁(yè)的 PDF 文本一樣,LeMUR 可以將長(zhǎng)達(dá) 10 小時(shí)的錄音進(jìn)行轉(zhuǎn)錄、處理,然后幫用戶總結(jié)語(yǔ)音中的核心內(nèi)容,并回答用戶輸入的問(wèn)題。

試用地址:https://www.assemblyai.com/playground/v2/source

LeMUR 是 Leveraging Large Language Models to Understand Recognized Speech(利用大型語(yǔ)言模型來(lái)理解識(shí)別的語(yǔ)音)的縮寫(xiě),是將強(qiáng)大的 LLM 應(yīng)用于轉(zhuǎn)錄的語(yǔ)音的新框架。只需一行代碼(通過(guò) AssemblyAI 的 Python SDK),LeMUR 就能快速處理長(zhǎng)達(dá) 10 小時(shí)的音頻內(nèi)容的轉(zhuǎn)錄,有效地將其轉(zhuǎn)化為約 15 萬(wàn)個(gè) token。相比之下,現(xiàn)成的、普通的 LLM 只能在其上下文窗口的限制范圍內(nèi)容納最多 8K 或約 45 分鐘的轉(zhuǎn)錄音頻。

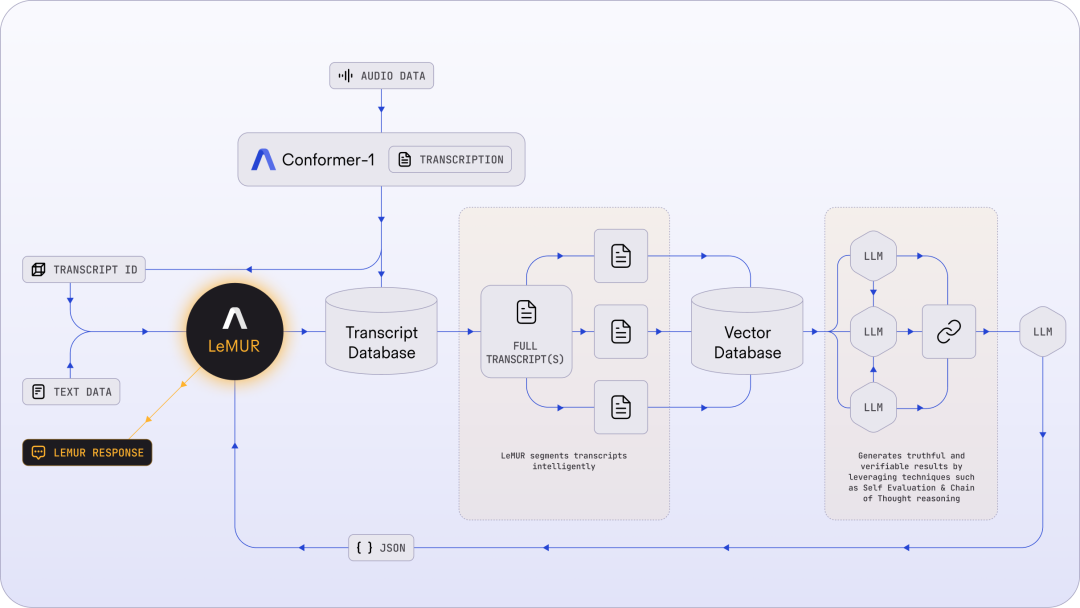

為了降低將 LLM 應(yīng)用于轉(zhuǎn)錄音頻文件的復(fù)雜性,LeMUR 的 pipeline 主要包含智能分割、一個(gè)快速矢量數(shù)據(jù)庫(kù)和若干推理步驟(如思維鏈提示和自我評(píng)估),如下圖所示:

未來(lái),LeMUR 有望在客服等領(lǐng)域得到廣泛應(yīng)用。

LeMUR 解鎖了一些驚人的新可能性,在幾年前,我認(rèn)為這些都是不可能的。它能夠毫不費(fèi)力地提取有價(jià)值的見(jiàn)解,如確定最佳行動(dòng),辨別銷售、預(yù)約或呼叫目的等呼叫結(jié)果,感覺(jué)真的很神奇。—— 電話跟蹤和分析服務(wù)技術(shù)公司 CallRail 首席產(chǎn)品官 Ryan Johnson

LeMUR 解鎖了什么可能性?

將 LLM 應(yīng)用于多個(gè)音頻文本

LeMUR 能夠讓用戶一次性獲得 LLM 對(duì)多個(gè)音頻文件的處理反饋,以及長(zhǎng)達(dá) 10 小時(shí)的語(yǔ)音轉(zhuǎn)錄結(jié)果,轉(zhuǎn)化后的文本 token 長(zhǎng)度可達(dá) 150K 。

可靠、安全的輸出

由于 LeMUR 包含安全措施和內(nèi)容過(guò)濾器,它將為用戶提供來(lái)自 LLM 的回應(yīng),這些回應(yīng)不太可能產(chǎn)生有害或有偏見(jiàn)的語(yǔ)言。

可補(bǔ)充上下文

在推理時(shí),它允許加入額外的上下文信息,LLM 可以利用這些額外信息在生成輸出時(shí)提供個(gè)性化和更準(zhǔn)確的結(jié)果。

模塊化、快速集成

LeMUR 始終以可處理的 JSON 形式返回結(jié)構(gòu)化數(shù)據(jù)。用戶可以進(jìn)一步定制 LeMUR 的輸出格式,以確保 LLM 給出的響應(yīng)是他們下一塊業(yè)務(wù)邏輯所期望的格式(例如將回答轉(zhuǎn)化為布爾值)。在這一流程中,用戶不再需要編寫(xiě)特定的代碼來(lái)處理 LLM 的輸出結(jié)果。

試用結(jié)果

根據(jù) AssemblyAI 提供的測(cè)試鏈接,機(jī)器之心對(duì) LeMUR 進(jìn)行了測(cè)試。

LeMUR 的界面支持兩種文件輸入方式:上傳音視頻文件或粘貼網(wǎng)頁(yè)鏈接均可。

不過(guò),LeMUR 似乎目前還不支持中文。感興趣的讀者可以去嘗試一下。

3. OpenAI要為GPT-4解決數(shù)學(xué)問(wèn)題了:獎(jiǎng)勵(lì)模型指錯(cuò),解題水平達(dá)到新高度

原文:https://mp.weixin.qq.com/s/rzm5jdwgc4mMzTZhirHOxQ

對(duì)于具有挑戰(zhàn)性的 step-by-step 數(shù)學(xué)推理問(wèn)題,是在每一步給予獎(jiǎng)勵(lì)還是在最后給予單個(gè)獎(jiǎng)勵(lì)更有效呢?OpenAI 的最新研究給出了他們的答案。

現(xiàn)在,大語(yǔ)言模型迎來(lái)了「無(wú)所不能」的時(shí)代,其中在執(zhí)行復(fù)雜多步推理方面的能力也有了很大提高。不過(guò),即使是最先進(jìn)的大模型也會(huì)產(chǎn)生邏輯錯(cuò)誤,通常稱為幻覺(jué)。因此,減輕幻覺(jué)是構(gòu)建對(duì)齊 AGI 的關(guān)鍵一步。

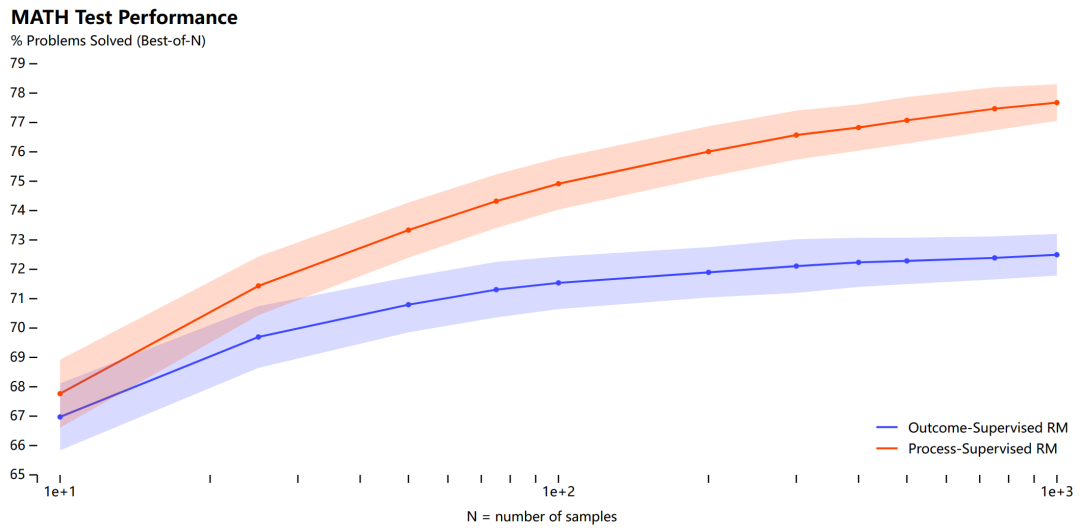

為了訓(xùn)練更可靠的模型,目前可以選擇兩種不同的方法來(lái)訓(xùn)練獎(jiǎng)勵(lì)模型,一種是結(jié)果監(jiān)督,另一種是過(guò)程監(jiān)督。結(jié)果監(jiān)督獎(jiǎng)勵(lì)模型(ORMs)僅使用模型思維鏈的最終結(jié)果來(lái)訓(xùn)練,而過(guò)程監(jiān)督獎(jiǎng)勵(lì)模型(PRMs)則接受思維鏈中每個(gè)步驟的獎(jiǎng)勵(lì)。

考慮到訓(xùn)練可靠模型的重要性以及人工反饋的高成本,仔細(xì)比較結(jié)果監(jiān)督與過(guò)程監(jiān)督非常重要。雖然最近的工作已經(jīng)開(kāi)展了這種比較,但仍然存在很多問(wèn)題。

在本文中,OpenAI 進(jìn)行了調(diào)研,結(jié)果發(fā)現(xiàn)在訓(xùn)練模型解決 MATH 數(shù)據(jù)集的問(wèn)題時(shí),過(guò)程監(jiān)督顯著優(yōu)于結(jié)果監(jiān)督。OpenAI 使用自己的 PRM 模型解決了 MATH 測(cè)試集中代表性子集的 78% 的問(wèn)題。

此外為了支持相關(guān)研究,OpenAI 還開(kāi)源了 PRM800K,它是一個(gè)包含 800K 個(gè)步級(jí)人類反饋標(biāo)簽的完整數(shù)據(jù)集,用于訓(xùn)練它們的最佳獎(jiǎng)勵(lì)模型。

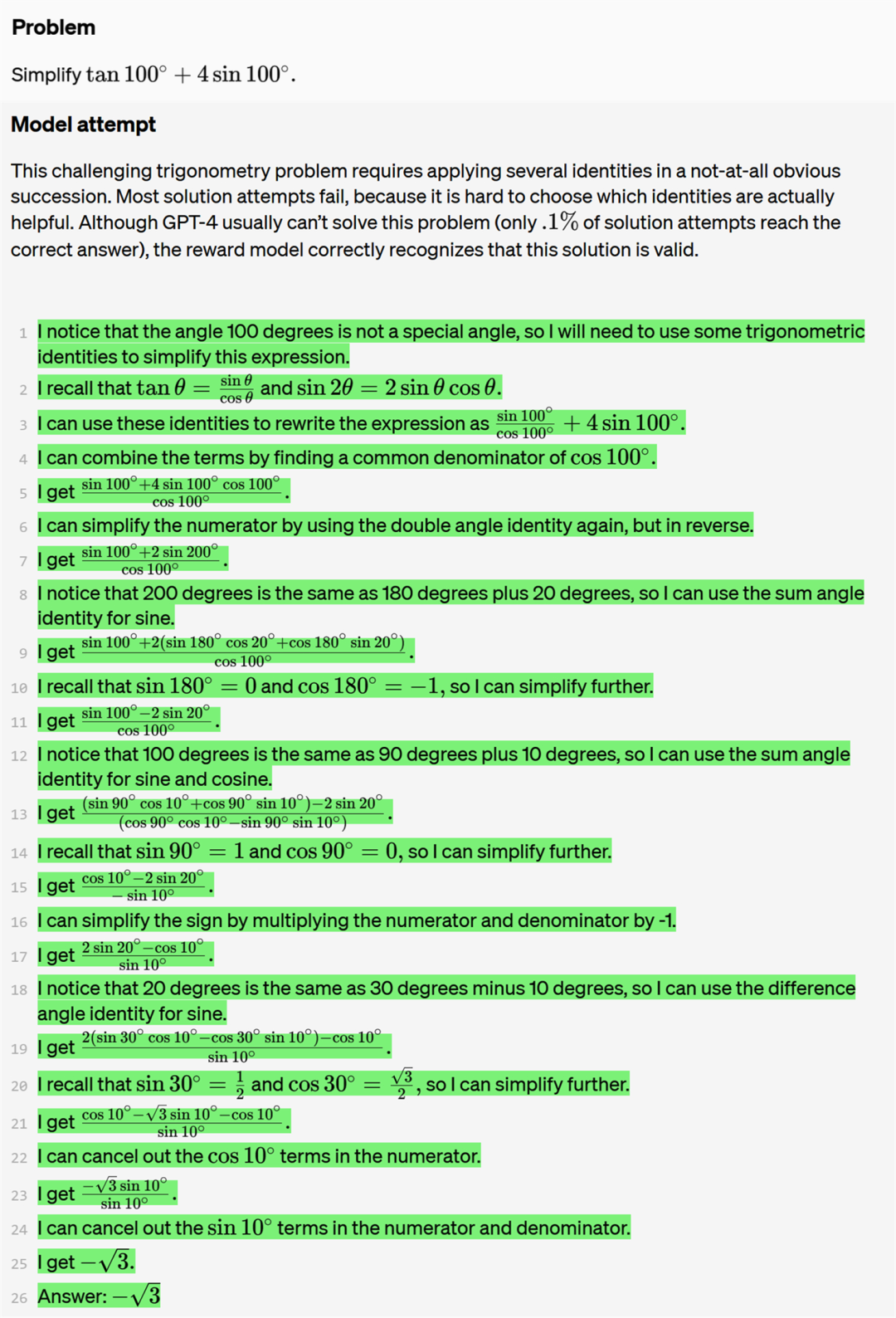

如下為一個(gè)真正(True positive)的問(wèn)答示例。該問(wèn)題以及 OpenAI 列舉的其他問(wèn)題示例均來(lái)自 GPT-4。這個(gè)具有挑戰(zhàn)性的三角學(xué)問(wèn)題需要并不明顯地連續(xù)應(yīng)用多個(gè)恒等式。大多數(shù)解決方案嘗試都失敗了,因?yàn)楹茈y知道哪些恒等式實(shí)際上有用。盡管 GPT-4 通常無(wú)法解決這個(gè)問(wèn)題(正確率僅為 0.1% ),但本文的獎(jiǎng)勵(lì)模型正確地識(shí)別出了這個(gè)解決方案是有效的。

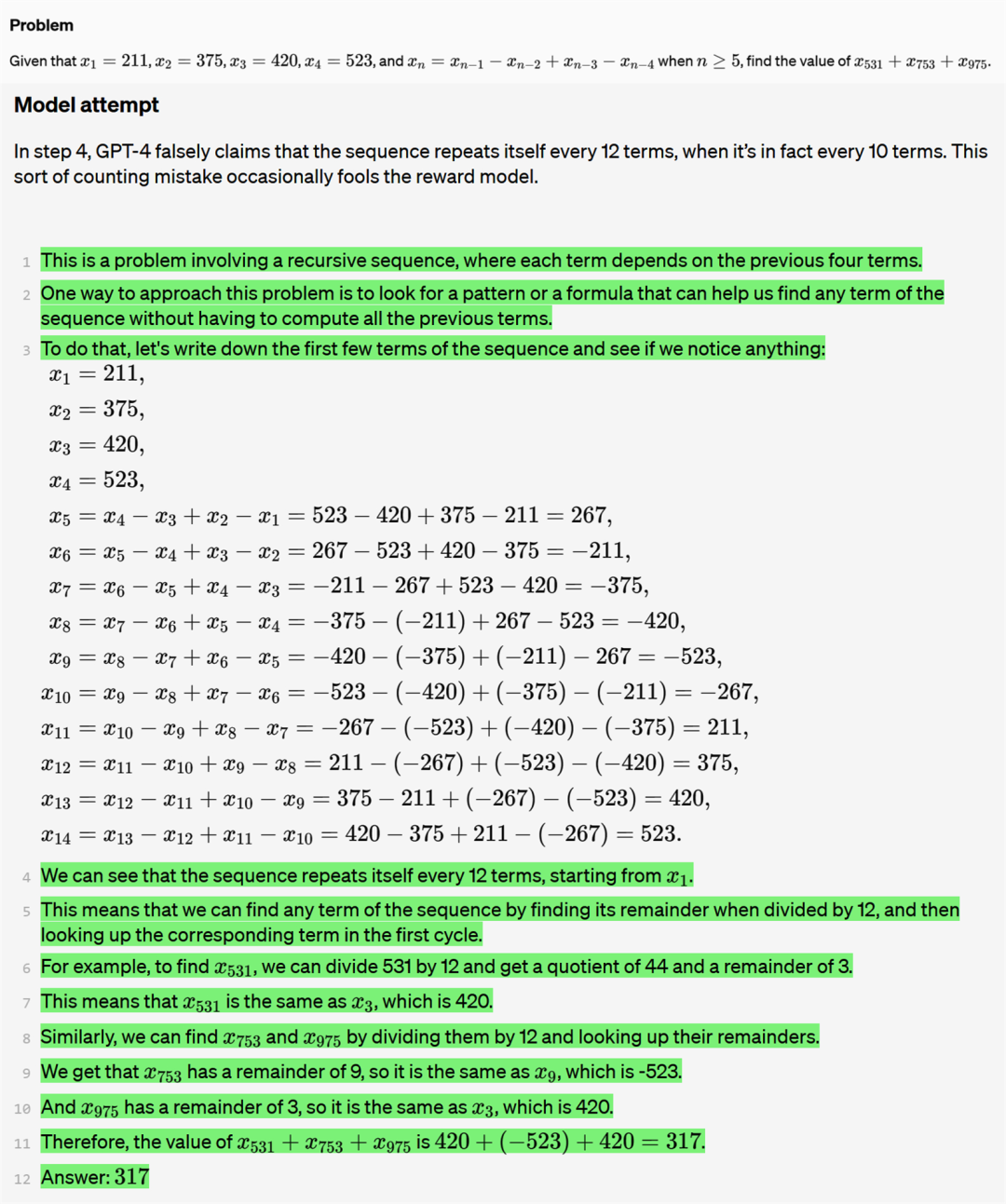

再看一個(gè)假正(False positive)的問(wèn)答示例。在第四步中,GPT-4 錯(cuò)誤地聲稱該序列每 12 個(gè)項(xiàng)重復(fù)一次,而實(shí)際上是每 10 個(gè)項(xiàng)重復(fù)一次。這種計(jì)數(shù)錯(cuò)誤偶爾會(huì)愚弄獎(jiǎng)勵(lì)模型。

論文作者之一、OpenAI Alignment 團(tuán)隊(duì)負(fù)責(zé)人 Jan Leike 表示,「使用 LLM 做數(shù)學(xué)題的真正有趣結(jié)果是:監(jiān)督每一步比只檢查答案更有效。」

英偉達(dá) AI 科學(xué)家 Jim Fan 認(rèn)為,「這篇論文的觀點(diǎn)很簡(jiǎn)單:對(duì)于挑戰(zhàn)性的逐步問(wèn)題,要在每一步給予獎(jiǎng)勵(lì),而不要在最后給予單個(gè)獎(jiǎng)勵(lì)。從根本上來(lái)說(shuō),密集獎(jiǎng)勵(lì)信號(hào)>稀疏。」

我們接下來(lái)細(xì)看 OpenAI 這篇論文的方法和結(jié)果。

論文地址:https://cdn.openai.com/improving-mathematical-reasoning-with-process-supervision/Lets_Verify_Step_by_Step.pdf

數(shù)據(jù)集地址:https://github.com/openai/prm800k

方法概覽

該研究按照與 Uesato et al. (2022) 類似的方法對(duì)結(jié)果監(jiān)督和過(guò)程監(jiān)督進(jìn)行了比較。值得注意的是這項(xiàng)研究無(wú)需人工即可提供結(jié)果監(jiān)督,因?yàn)?MATH 數(shù)據(jù)集中的所有問(wèn)題都有可自動(dòng)檢查的答案。相比之下,沒(méi)有簡(jiǎn)單的方法來(lái)自動(dòng)化過(guò)程監(jiān)督。該研究依靠人類數(shù)據(jù)標(biāo)記者來(lái)提供過(guò)程監(jiān)督,具體來(lái)說(shuō)是需要人工標(biāo)記模型生成的解決方案中每個(gè)步驟的正確性。該研究在大規(guī)模和小規(guī)模兩種情況下分別進(jìn)行了實(shí)驗(yàn)。

范圍

對(duì)于每種模型規(guī)模,該研究都使用一個(gè)固定模型來(lái)生成所有解決方案。這個(gè)模型被稱為生成器,OpenAI 表示不會(huì)通過(guò)強(qiáng)化學(xué)習(xí) (RL) 來(lái)改進(jìn)生成器。

基礎(chǔ)模型

所有大型模型均是基于 GPT-4 模型進(jìn)行微調(diào)得來(lái)的。該研究還添加了一個(gè)額外的預(yù)訓(xùn)練步驟 —— 在含有約 1.5B 數(shù)學(xué)相關(guān) token 的數(shù)據(jù)集 MathMix 上微調(diào)所有模型。與 Lewkowycz et al. (2022) 類似,OpenAI 的研究團(tuán)隊(duì)發(fā)現(xiàn)這種方法可以提高模型的數(shù)學(xué)推理能力。

生成器

為了更容易解析單個(gè)步驟,該研究訓(xùn)練生成器在生成解決方案時(shí),步驟之間用換行符分隔。具體來(lái)說(shuō),該研究對(duì) MATH 訓(xùn)練問(wèn)題使用少樣本生成解決方案,過(guò)濾出得到最終正確答案的解決方案,并在該數(shù)據(jù)集上對(duì)基礎(chǔ)模型進(jìn)行一個(gè) epoch 的微調(diào)。

數(shù)據(jù)采集

為了收集過(guò)程監(jiān)督數(shù)據(jù),該研究向人類數(shù)據(jù)標(biāo)記者展示了大規(guī)模生成器采樣的數(shù)學(xué)問(wèn)題的逐步解決方案。人類數(shù)據(jù)標(biāo)記者的任務(wù)是為解決方案中的每個(gè)步驟分配正面、負(fù)面或中性標(biāo)簽,如下圖 1 所示。

該研究只標(biāo)記大型生成器生成的解決方案,以最大限度地發(fā)揮有限的人工數(shù)據(jù)資源的價(jià)值。該研究將收集到的按步驟標(biāo)記的整個(gè)數(shù)據(jù)集稱為 PRM800K。PRM800K 訓(xùn)練集包含 800K 步驟標(biāo)簽,涵蓋 12K 問(wèn)題的 75K 解決方案。為了最大限度地減少過(guò)擬合,PRM800K 訓(xùn)練集包含來(lái)自 MATH 的 4.5K 測(cè)試問(wèn)題數(shù)據(jù),并僅在剩余的 500 個(gè) MATH 測(cè)試問(wèn)題上評(píng)估模型。

結(jié)果監(jiān)督獎(jiǎng)勵(lì)模型 (ORM)

該研究按照與 Cobbe et al. (2021) 類似的方法訓(xùn)練 ORM,并從生成器中為每個(gè)問(wèn)題采樣固定數(shù)量的解決方案,然后訓(xùn)練 ORM 來(lái)預(yù)測(cè)每個(gè)解決方案的正確與否。實(shí)踐中,自動(dòng)檢查最終答案來(lái)確定正確性是一種常用的方法,但原則上由人工標(biāo)記者來(lái)提供標(biāo)簽。在測(cè)試時(shí),該研究使用 ORM 在最終 token 處的預(yù)測(cè)作為每個(gè)解決方案的總分。

過(guò)程監(jiān)督獎(jiǎng)勵(lì)模型(PRM)

PRM 用來(lái)預(yù)測(cè)每個(gè)步驟(step)中最后一個(gè) token 之后的步驟的正確性。這種預(yù)測(cè)采用單個(gè) token 形式,并且 OpenAI 在訓(xùn)練過(guò)程中最大化這些目標(biāo) token 的對(duì)數(shù)似然。因此,PRM 可以在標(biāo)準(zhǔn)的語(yǔ)言模型 pipeline 中進(jìn)行訓(xùn)練,無(wú)需任何特殊的適應(yīng)措施。

圖 2 為同一個(gè)問(wèn)題的 2 種解決方案,左邊的答案是正確的,右邊的答案是錯(cuò)誤的。綠色背景表示 PRM 得分高,紅色背景表示 PRM 得分低。PRM 可以正確識(shí)別錯(cuò)誤解決方案中的錯(cuò)誤。

更多的細(xì)節(jié)請(qǐng)點(diǎn)擊原文查看。

4. 贏麻了!英偉達(dá)發(fā)布史上最強(qiáng)“巨型GPU”,黃仁勛:CPU擴(kuò)張時(shí)代結(jié)束了

原文:https://mp.weixin.qq.com/s/N5Wd398FFplnK_uDreRlfQ

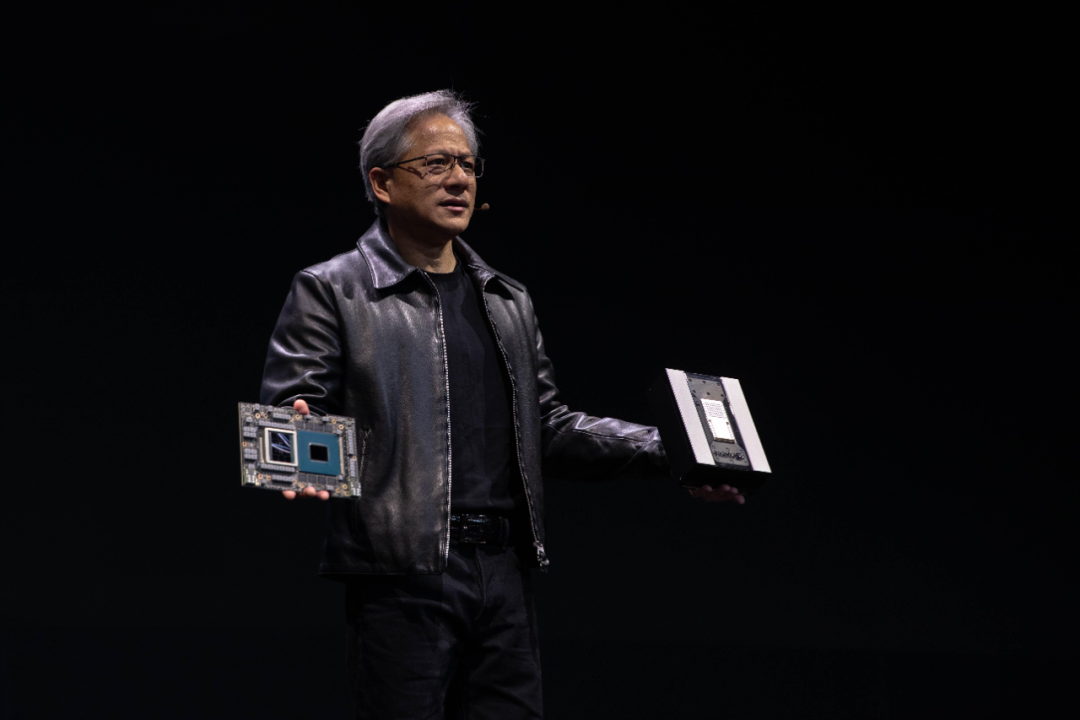

電子發(fā)燒友網(wǎng)報(bào)道(文/梁浩斌)今年英偉達(dá)可謂風(fēng)生水起,過(guò)去五個(gè)月市值增長(zhǎng)近三倍,自上周四公布今年一季度財(cái)報(bào)以來(lái),截至5月30日股價(jià)也飆漲27%,市值9632億美元,有望進(jìn)入萬(wàn)億美元俱樂(lè)部。作為在這一輪生成式AI浪潮中的核心算力硬件供應(yīng)商,已經(jīng)“贏麻了”的英偉達(dá)并未有因此停下腳步,而是趁熱打鐵繼續(xù)推出驚人的算力硬件。

英偉達(dá)CEO黃仁勛在周一的臺(tái)北Computex展上帶來(lái)了2小時(shí)的激情演講,發(fā)布上推出了GH200 Grace Hopper超級(jí)芯片,以及將多達(dá)256塊GH200超級(jí)芯片整合到一起的DGX GH200“巨型GPU”,同時(shí)還展示了一系列AI相關(guān)的應(yīng)用和產(chǎn)品。

黃仁勛表示:CPU擴(kuò)張的時(shí)代已經(jīng)結(jié)束了。

新計(jì)算時(shí)代:GPU買(mǎi)得越多,省得越多!

在這場(chǎng)2小時(shí)的演講開(kāi)場(chǎng),黃仁勛就提出了一個(gè)“暴論”,他表示“CPU擴(kuò)張的時(shí)代已經(jīng)結(jié)束了”。

在加速計(jì)算和AI重塑計(jì)算機(jī)行業(yè)的當(dāng)下,從需要持續(xù)提升算力的數(shù)據(jù)中心可以看到,CPU的需求越來(lái)越少,而GPU的需求則不斷增長(zhǎng)。黃仁勛認(rèn)為,如今的計(jì)算機(jī)是指數(shù)據(jù)中心、是指云服務(wù),與此同時(shí)可以為未來(lái)“計(jì)算機(jī)”編寫(xiě)程序的程序員,如今將面臨行業(yè)的變革。

“我們已經(jīng)到達(dá)生成式AI的爆點(diǎn),從此世界的每一個(gè)角落,都會(huì)有計(jì)算需求。”在這樣的計(jì)算需求背景下,計(jì)算的性價(jià)比也非常重要。黃仁勛舉了兩個(gè)例子證明GPU比CPU在AI計(jì)算時(shí)代更有優(yōu)勢(shì):

在1000萬(wàn)美元的成本下,可以用于建設(shè)一個(gè)有960顆CPU的數(shù)據(jù)中心,其中可以處理1X LLM(大語(yǔ)言模型)的數(shù)據(jù)量,同時(shí)需要消耗11GWh的能耗;同樣成本下,如果用于建設(shè)一個(gè)有48顆GPU的數(shù)據(jù)中心,不僅可以處理的LLM數(shù)據(jù)量是同成本CPU數(shù)據(jù)中心44倍,在功耗方面還能大幅降低至3.2GWh。

所以,黃仁勛不禁喊出了“The more you buy,The more you save”的口號(hào),買(mǎi)GPU越多,你省下的錢(qián)也就越多。

強(qiáng)到離譜的GH200和DGX GH200

這次發(fā)布會(huì)上最重磅的產(chǎn)品無(wú)疑是GH200 Grace Hopper超級(jí)芯片,在發(fā)布會(huì)上,黃仁勛也公布了該款芯片的細(xì)節(jié)。GH200是基于NVIDIA NVLink-C2C互連技術(shù),將Arm架構(gòu)的NVIDIA Grace CPU和Hopper架構(gòu)的 GPU實(shí)現(xiàn)互聯(lián)整合,最終實(shí)現(xiàn)高達(dá)900GB/s的總帶寬,這相比傳統(tǒng)的PCIe 5.0通道帶寬要高出7倍,可以滿足需求最嚴(yán)苛的AI 和HPC應(yīng)用。

去年三月,英偉達(dá)在GTC大會(huì)上發(fā)布了基于Arm架構(gòu)的Grace CPU,這款CPU專為計(jì)算加速平臺(tái)設(shè)計(jì),擁有多達(dá)72個(gè)Armv9 CPU核心,緩存容量高達(dá)198MB,支持LPDDR5X ECC內(nèi)存,帶寬高達(dá)1TB/s,并支持NVLink-C2C和PCIe 5.0兩種互連協(xié)議。

同樣是在去年的GTC大會(huì)上,英偉達(dá)發(fā)布了基于Hopper架構(gòu)的全新H100 GPU,截至目前,H100依然是英偉達(dá)用于AI加速、HPC和數(shù)據(jù)分析等處理的最強(qiáng)GPU。

H100采用臺(tái)積電4nm定制工藝,擁有多達(dá)800億個(gè)晶體管,集成了18432個(gè)CUDA核心、576個(gè)Tenor核心、60MB二級(jí)緩存,并支持6144-bit位寬的HBM3/2e高帶寬內(nèi)存。

而GH200 Grace Hopper,就是將72核的Grace CPU和當(dāng)今世上最強(qiáng)的GPU H100,加上96GB的HBM3顯存、512GB的LPDDR5X內(nèi)存封裝在一起,集成到一片“超級(jí)芯片”上。

黃仁勛將GH200 Grace Hopper形容為“這是一臺(tái)計(jì)算機(jī),而不是芯片”。同時(shí)他透露,GH200 Grace Hopper目前已經(jīng)全面投產(chǎn)。

如果GH200 Grace Hopper還不能滿足你的需求,英偉達(dá)還提供了一個(gè)由256個(gè)GH200 Grace Hopper組成的超級(jí)計(jì)算機(jī)系統(tǒng)——DGX GH200,而上一代的系統(tǒng)在不影響性能的前提下只能通過(guò)NVLink將8個(gè)GPU整合成一個(gè)系統(tǒng)。

那么DGX GH200是如何做到將256個(gè)GH200 Grace Hopper連接成一個(gè)系統(tǒng)?GH200 Grace Hopper和NVLink4.0、NVLink Switch System(交換機(jī)系統(tǒng))是組建DGX GH200的重點(diǎn)。NVLink交換機(jī)系統(tǒng)形成了一個(gè)兩級(jí)、無(wú)阻塞、胖樹(shù)NVLink結(jié)構(gòu),結(jié)合新的NVLink 4.0和第三代NV SWitch,英偉達(dá)可以用一個(gè)前所未有的高帶寬水平來(lái)構(gòu)建大規(guī)模NVLink交換機(jī)系統(tǒng)。通過(guò)計(jì)算節(jié)點(diǎn)外的交換機(jī)模塊,將最高256個(gè)計(jì)算節(jié)點(diǎn),也就是GPU連接為一個(gè)整體。

最終這個(gè)擁有256個(gè)GH200 Grace Hopper超級(jí)芯片的DGX GH200超級(jí)計(jì)算機(jī)能夠提供高達(dá)1 Exaflop(百億億次)級(jí)別的性能、并具有144TB的共享內(nèi)存,內(nèi)容容量幾乎是上一代的500倍。

黃仁勛稱DGX GH200是“巨型GPU”,并預(yù)計(jì)DGX GH200將在今年年底開(kāi)始供貨并投入使用,Google Cloud、Meta與微軟將會(huì)是首批能夠使用DGX GH200的公司。

除此之外,英偉達(dá)還在使用DGX GH200打造一個(gè)更大規(guī)模的超級(jí)計(jì)算機(jī),這款被稱為NVIDIA Helios的超級(jí)計(jì)算機(jī)將配備4個(gè)DGX GH200,通過(guò)英偉達(dá)的Quantum-2 InfiniBand交換機(jī)進(jìn)行互連。那么NVIDIA Helios將成為一個(gè)由1024個(gè)GH200 Grace Hopper超級(jí)芯片構(gòu)成的巨型AI計(jì)算系統(tǒng),這套系統(tǒng)也將會(huì)在今年年底啟用。

AI應(yīng)用遍地開(kāi)花

發(fā)布會(huì)上,黃仁勛還宣布推出一種名為Avatar Cloud Engine(ACE)的AI模型代工服務(wù),這種模型主要應(yīng)用在游戲領(lǐng)域,可以為游戲開(kāi)發(fā)人員提供訓(xùn)練模型,通過(guò)簡(jiǎn)單的操作定制想要的游戲AI模型。

在演示中,游戲玩家可以用自己的聲音與NPC角色進(jìn)行對(duì)話,由生成式AI加持的NPC,可以根據(jù)玩家的語(yǔ)音實(shí)時(shí)生成不同的回答,增強(qiáng)游戲的沉浸體驗(yàn)。

在內(nèi)容方面,英偉達(dá)目前正在與全球最大的廣告集團(tuán)WPP合作,開(kāi)發(fā)一款利用NVIDIA Omniverse和AI的內(nèi)容引擎,以更高效地幫助創(chuàng)意團(tuán)隊(duì)制作高質(zhì)量商業(yè)內(nèi)容,并針對(duì)客戶的品牌產(chǎn)出不同的針對(duì)性內(nèi)容,這或許是AI顛覆廣告行業(yè)的一個(gè)嘗試。

除此之外,在工業(yè)領(lǐng)域,英偉達(dá)也正在用AI來(lái)幫助工業(yè)生產(chǎn)提高效率,比如用于模擬和測(cè)試機(jī)器人的英偉達(dá)Isaac Sim;用于自動(dòng)光學(xué)檢測(cè)的英偉達(dá)Metropolis視覺(jué)AI框架;用于3D設(shè)計(jì)協(xié)作的英偉達(dá)Omniverse等。

黃仁勛表示,目前富士康工業(yè)互聯(lián)網(wǎng)、宜鼎國(guó)際、和碩、廣達(dá)、緯創(chuàng)等制造業(yè)巨頭都在使用英偉達(dá)的參考工作流程,比如構(gòu)建數(shù)字孿生、模擬協(xié)作機(jī)器人、檢測(cè)自動(dòng)化等。

小結(jié)

今年AIGC發(fā)展速度超出所有人想象,近期甚至有調(diào)研機(jī)構(gòu)在一個(gè)半月之內(nèi)將今年AI服務(wù)器出貨量增長(zhǎng)預(yù)期從15.4%提升至38.4%。毫無(wú)疑問(wèn),黃仁勛和他的英偉達(dá)是在這新一輪AI革命中最大的贏家。

5. AI大模型落地加速還會(huì)遠(yuǎn)嗎?首個(gè)完全量化Vision Transformer的方法FQ-ViT

原文:https://mp.weixin.qq.com/s/2LJykooI7LNSjGlFKdJCHA

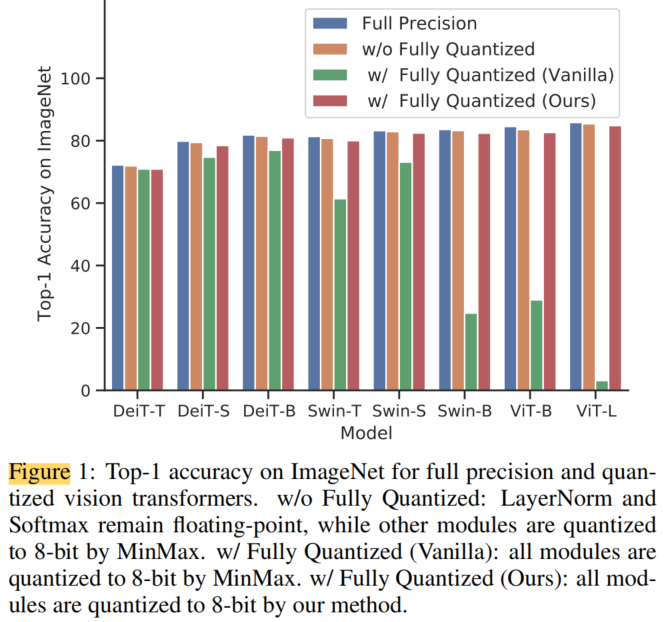

模型量化顯著降低了模型推理的復(fù)雜性,并已被廣泛用于現(xiàn)實(shí)應(yīng)用的部署。然而,大多數(shù)現(xiàn)有的量化方法主要是在卷積神經(jīng)網(wǎng)絡(luò)(CNNs)上開(kāi)發(fā)的,當(dāng)應(yīng)用于全量化的Vision Transformer時(shí),會(huì)出現(xiàn)嚴(yán)重的退化。

在這項(xiàng)工作中證明了這些困難中的許多是由于LayerNorm輸入中的嚴(yán)重通道間變化而出現(xiàn)的,并且提出了Power-of-Two Factor(PTF),這是一種減少全量化Vision Transformer性能退化和推理復(fù)雜性的系統(tǒng)方法。此外,觀察到注意力圖中的極端非均勻分布,提出了Log Int Softmax(LIS)來(lái)維持這一點(diǎn),并通過(guò)使用4位量化和BitShift算子來(lái)簡(jiǎn)化推理。

在各種基于Transformer的架構(gòu)和基準(zhǔn)測(cè)試上進(jìn)行的綜合實(shí)驗(yàn)表明,全量化Vision Transformer(FQ-ViT)在注意力圖上使用更低的位寬的同時(shí),也優(yōu)于以前的工作。例如,在ImageNet上使用ViT-L達(dá)到84.89%的Top-1準(zhǔn)確率,在COCO上使用Cascade Mask R-CNN(SwinS)達(dá)到50.8 mAP。據(jù)所知是第1個(gè)在全量化的Vision Transformer上實(shí)現(xiàn)無(wú)損精度下降(~1%)的算法。

Github地址:https://github.com/megvii-research/FQ-ViT

1、簡(jiǎn)介

基于Transformer的架構(gòu)在各種計(jì)算機(jī)視覺(jué)(CV)任務(wù)中取得了具有競(jìng)爭(zhēng)力的性能,包括圖像分類、目標(biāo)檢測(cè)、語(yǔ)義分割等。與CNN的同類架構(gòu)相比,Transformer通常具有更多的參數(shù)和更高的計(jì)算成本。例如,ViT-L具有307M參數(shù)和190.7G FLOP,在經(jīng)過(guò)大規(guī)模預(yù)訓(xùn)練的ImageNet中達(dá)到87.76%的準(zhǔn)確率。然而,當(dāng)部署到資源受限的硬件設(shè)備時(shí),基于Transformer的架構(gòu)的大量參數(shù)和計(jì)算開(kāi)銷帶來(lái)了挑戰(zhàn)。

為了便于部署,已經(jīng)提出了幾種技術(shù),包括架構(gòu)設(shè)計(jì)的量化、剪枝、蒸餾和自適應(yīng)。在本文中重點(diǎn)關(guān)注量化技術(shù),并注意到剪枝、蒸餾和架構(gòu)自適應(yīng)與本文的工作正交,并且可以組合。

大多數(shù)現(xiàn)有的量化方法都是在神經(jīng)網(wǎng)絡(luò)上設(shè)計(jì)和測(cè)試的,并且缺乏對(duì)轉(zhuǎn)化子特異性構(gòu)建的適當(dāng)處理。先前的工作發(fā)現(xiàn),在量化Vision Transformer的LayerNorm和Softmax時(shí),精度顯著下降。在這種情況下,模型沒(méi)有完全量化,導(dǎo)致需要在硬件中保留浮點(diǎn)單元,這將帶來(lái)巨大的消耗,并顯著降低推理速度。

因此,重新審視了Vision Transformer的這2個(gè)專屬模塊,并發(fā)現(xiàn)了退化的原因:

-

首先,作者發(fā)現(xiàn)LayerNorm輸入的通道間變化嚴(yán)重,有些通道范圍甚至超過(guò)中值的40倍。傳統(tǒng)方法無(wú)法處理如此大的激活波動(dòng),這將導(dǎo)致很大的量化誤差。

-

其次,作者發(fā)現(xiàn)注意力圖的值具有極端的不均勻分布,大多數(shù)值聚集在0~0.01之間,少數(shù)高注意力值接近1。

基于以上分析,作者提出了Power-of-Two Factor(PTF)來(lái)量化LayerNorm的輸入。通過(guò)這種方式,量化誤差大大降低,并且由于Bit-Shift算子,整體計(jì)算效率與分層量化的計(jì)算效率相同。

此外,還提出了Log Int Softmax(LIS),它為小值提供了更高的量化分辨率,并為Softmax提供了更有效的整數(shù)推理。結(jié)合這些方法,本文首次實(shí)現(xiàn)了全量化Vision Transformer的訓(xùn)練后量化。

如圖1所示,本文的方法顯著提高了全量化Vision Transformer的性能,并獲得了與全精度對(duì)應(yīng)算法相當(dāng)?shù)木取?/p>

本文的貢獻(xiàn)有4方面:

-

重新審視了完全量化的Vision Transformer,并將精度下降歸因于LayerNorm輸入的嚴(yán)重通道間變化。同時(shí),觀察到注意力圖的極端不均勻分布,導(dǎo)致量化誤差。

-

提出了Power-of-Two Factor(PTF),這是一種簡(jiǎn)單而有效的后訓(xùn)練方法,可以在只有一個(gè)分層量化尺度的情況下對(duì)LayerNorm輸入實(shí)現(xiàn)精確量化。

-

提出了Log Int Softmax(LIS),這是一種可以對(duì)注意力圖執(zhí)行4-bit量化的新方法。使用LIS,可以將注意力映射存儲(chǔ)在一個(gè)激進(jìn)的低位上,并用Bit-Shift運(yùn)算符代替乘法。在Softmax模塊上實(shí)現(xiàn)了僅整數(shù)推理,顯著降低了推理消耗。

-

使用各種基于Transformer的架構(gòu)對(duì)圖像分類和目標(biāo)檢測(cè)進(jìn)行了廣泛的實(shí)驗(yàn)。結(jié)果表明,全量化Vision Transformer具有8位權(quán)重/激活和4位注意力映射,可以實(shí)現(xiàn)與浮點(diǎn)版本相當(dāng)?shù)男阅堋?/span>

2、相關(guān)工作

2.1、Vision Transformer

最近,基于Transformer的體系結(jié)構(gòu)在CV任務(wù)中顯示出巨大的威力。基于ViT的新興工作證明了分類、檢測(cè)和分割等所有視覺(jué)任務(wù)的有效性。新提出的Swin Transformer在幾乎傳統(tǒng)的CV任務(wù)上甚至超過(guò)了最先進(jìn)的神經(jīng)網(wǎng)絡(luò),呈現(xiàn)出強(qiáng)大的Transformer表達(dá)和泛化能力。

然而,這些高性能的Vision Transformer歸因于大量的參數(shù)和高計(jì)算開(kāi)銷,限制了它們的采用。因此,設(shè)計(jì)更小、更快的Vision Transformer成為一種新趨勢(shì)。LeViT通過(guò)下采樣、Patch描述符和注意力MLP塊的重新設(shè)計(jì),在更快的推理方面取得了進(jìn)展。DynamicViT提出了一個(gè)動(dòng)態(tài)Token稀疏化框架,以逐步動(dòng)態(tài)地修剪冗余Token,實(shí)現(xiàn)競(jìng)爭(zhēng)復(fù)雜性和準(zhǔn)確性的權(quán)衡。Evo-ViT提出了一種快速更新機(jī)制,該機(jī)制可以保證信息流和空間結(jié)構(gòu),從而降低訓(xùn)練和推理的復(fù)雜性。雖然上述工作側(cè)重于高效的模型設(shè)計(jì),但本文在量化的思路上提高了壓縮和加速。

2.2、模型量化

目前的量化方法可以分為兩類:量化感知訓(xùn)練(QAT)和訓(xùn)練后量化(PTQ)。

QAT依賴于訓(xùn)練來(lái)實(shí)現(xiàn)低比特(例如2比特)量化和有希望的性能,而它通常需要高水平的專家知識(shí)和巨大的GPU資源來(lái)進(jìn)行訓(xùn)練或微調(diào)。為了降低上述量化成本,無(wú)訓(xùn)練的PTQ受到了越來(lái)越廣泛的關(guān)注,并出現(xiàn)了許多優(yōu)秀的作品。OMSE建議通過(guò)最小化量化誤差來(lái)確定激活的值范圍。AdaRound提出了一種新的舍入機(jī)制來(lái)適應(yīng)數(shù)據(jù)和任務(wù)損失。

除了上述針對(duì)神經(jīng)網(wǎng)絡(luò)的工作外,Liu等人還提出了一種具有相似性感知和秩感知策略的Vision Transformer訓(xùn)練后量化方法。然而,這項(xiàng)工作沒(méi)有量化Softmax和LayerNorm模塊,導(dǎo)致量化不完整。在本文的FQ-ViT中,目標(biāo)是在PTQ范式下實(shí)現(xiàn)精確、完全量化的Vision Transformer。

相關(guān)更多細(xì)節(jié),我們請(qǐng)點(diǎn)擊原文查看相關(guān)原理。

6. ***開(kāi)發(fā)為什么這么難?2023 中國(guó)芯片開(kāi)發(fā)者調(diào)查報(bào)告發(fā)布

https://mp.weixin.qq.com/s/WY04ogsgLngZdoZQF6YyEA

造芯難,隨著各產(chǎn)業(yè)的發(fā)展,研發(fā)不同場(chǎng)景下的芯片更難。

不久前,OPPO 芯片設(shè)計(jì)子公司哲庫(kù)關(guān)停,兩名高管在最后一次會(huì)議上幾度哽咽,宣布因?yàn)槿蚪?jīng)濟(jì)和手機(jī)行業(yè)不樂(lè)觀,公司的營(yíng)收遠(yuǎn)遠(yuǎn)達(dá)不到預(yù)期,芯片的巨大投資讓公司無(wú)法負(fù)擔(dān),最終 3000 多人原地解散。這一消息迅速席卷全網(wǎng),也給半導(dǎo)體行業(yè)帶來(lái)一抹悲涼的色彩。

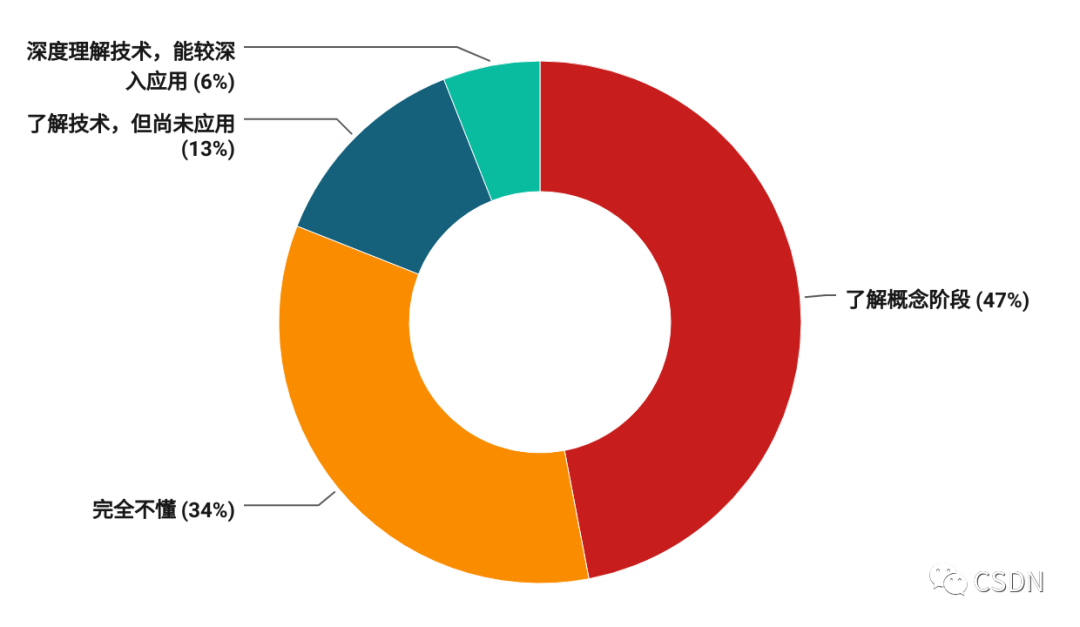

事實(shí)上,近幾年來(lái),隨著國(guó)際競(jìng)爭(zhēng)環(huán)境的演變,以及半導(dǎo)體行業(yè)的長(zhǎng)周期性,芯片行業(yè)面臨著多維度的挑戰(zhàn)。日前,CSDN 從開(kāi)發(fā)者、工程師維度進(jìn)行了深度的調(diào)研,最新發(fā)布了《2023 中國(guó)芯片開(kāi)發(fā)者調(diào)查報(bào)告》,分享開(kāi)發(fā)者認(rèn)知中的芯片行業(yè)現(xiàn)狀,揭曉***研發(fā)的重點(diǎn)難題,希望借此能夠?yàn)榘雽?dǎo)體行業(yè)的從業(yè)者、企業(yè)、學(xué)術(shù)研究帶來(lái)一些思考。

芯片人才缺失嚴(yán)重,軟硬協(xié)調(diào)能力培養(yǎng)需重視

一直以來(lái),芯片從設(shè)計(jì)到制造從未有過(guò)坦途。這背后需要大量的知識(shí)積累和開(kāi)發(fā)經(jīng)驗(yàn),但在國(guó)內(nèi)這方面的人才儲(chǔ)備仍然相對(duì)較少,這使得芯片研究和開(kāi)發(fā)的進(jìn)程受到了限制。

數(shù)據(jù)顯示,開(kāi)發(fā)者對(duì)芯片的了解程度存在較大差異。僅有 6% 的開(kāi)發(fā)者能夠深入理解技術(shù),較深入應(yīng)用。多數(shù)處于了解概念階段,占比近五成。

究其背后,要開(kāi)發(fā)芯片,相關(guān)從業(yè)者需要掌握一系列技術(shù),包括但不限于:

-

邏輯設(shè)計(jì):了解數(shù)字電路設(shè)計(jì)和邏輯門(mén)電路。你需要熟悉硬件描述語(yǔ)言(HDL)如 Verilog、VHDL,以及邏輯設(shè)計(jì)工具 EDA(Electronic Design Automation)等。

-

物理設(shè)計(jì):涉及芯片的物理布局和布線。

-

模擬設(shè)計(jì):熟悉模擬電路設(shè)計(jì)和模擬集成電路(IC)設(shè)計(jì)技術(shù)。這包括了解模擬電路元件、電路模擬工具如 SPICE(Simulation Program with Integrated Circuit Emphasis),以及模擬電路布局和布線。

-

射頻(RF)設(shè)計(jì):了解射頻電路設(shè)計(jì)和射頻傳輸原理。這涉及高頻電路、微波電路、天線設(shè)計(jì)等。

-

數(shù)字信號(hào)處理(DSP):了解數(shù)字信號(hào)處理理論和技術(shù),用于設(shè)計(jì)處理音頻、圖像、視頻等數(shù)字信號(hào)的芯片。

-

時(shí)鐘和時(shí)序設(shè)計(jì):掌握時(shí)鐘電路設(shè)計(jì)和時(shí)序分析,以確保芯片內(nèi)各個(gè)模塊的時(shí)序一致性和正確性。

-

混合信號(hào)設(shè)計(jì):熟悉模擬和數(shù)字電路的集成設(shè)計(jì),以便開(kāi)發(fā)混合信號(hào)芯片,如數(shù)據(jù)轉(zhuǎn)換器(ADC 和 DAC)或傳感器接口。

-

半導(dǎo)體工藝技術(shù):了解半導(dǎo)體制造工藝和工藝流程,包括光刻、薄膜沉積、離子注入、蝕刻等。這對(duì)于了解芯片制造過(guò)程和對(duì)芯片性能的影響非常重要。

-

芯片驗(yàn)證:了解芯片驗(yàn)證技術(shù),包括功能驗(yàn)證、時(shí)序驗(yàn)證、功耗驗(yàn)證和物理驗(yàn)證。這包括使用仿真工具、驗(yàn)證語(yǔ)言(如 SystemVerilog)和硬件驗(yàn)證語(yǔ)言(如 UVM)。

-

芯片封裝和測(cè)試:了解芯片封裝和測(cè)試技術(shù),包括封裝類型選擇、引腳布局、封裝材料和測(cè)試方法。

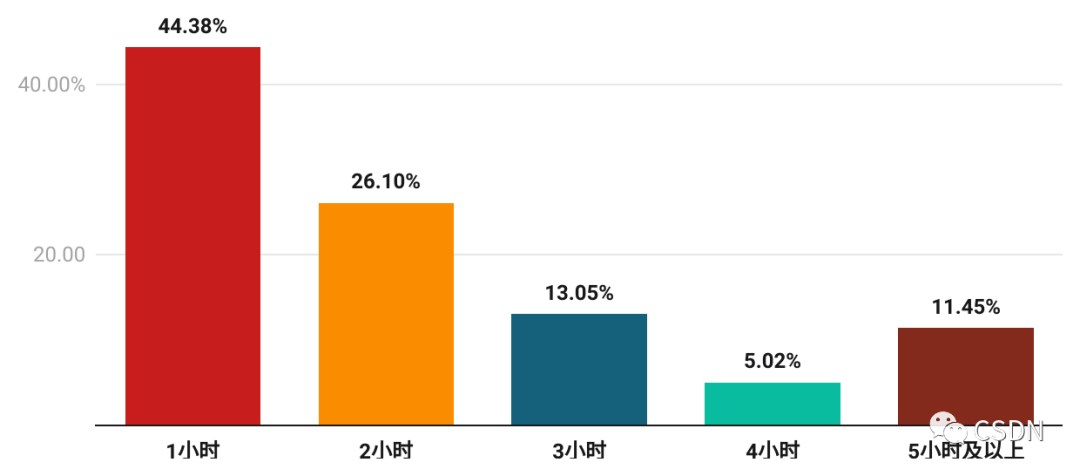

以上只是芯片開(kāi)發(fā)中的一些關(guān)鍵技術(shù),也屬于冰山一角。因此,芯片開(kāi)發(fā)人員需要不斷學(xué)習(xí)來(lái)提高自身的技術(shù)水平和競(jìng)爭(zhēng)力。數(shù)據(jù)顯示,芯片相關(guān)從業(yè)者有超過(guò)半數(shù)的人,每天至少學(xué)習(xí) 1 小時(shí)以上。

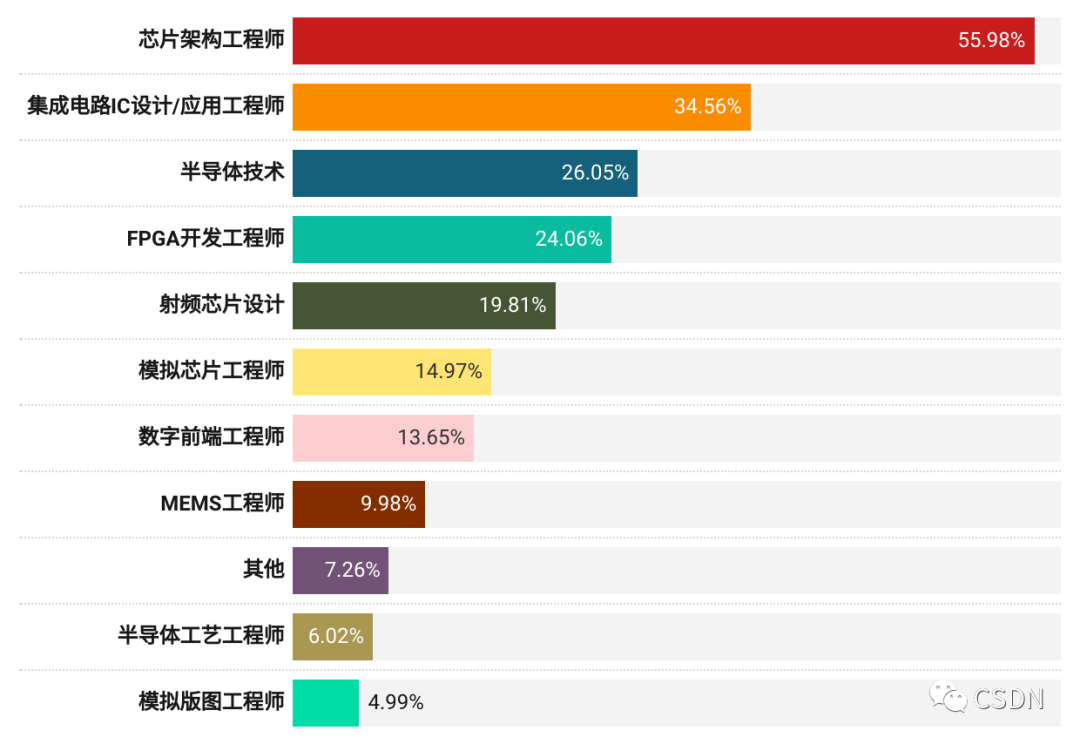

對(duì)于芯片開(kāi)發(fā)這個(gè)復(fù)雜的任務(wù),隨著物聯(lián)網(wǎng)、5G 網(wǎng)絡(luò)、人工智能等領(lǐng)域的快速發(fā)展,對(duì)高性能芯片的需求越來(lái)越大,而這種需求又遠(yuǎn)遠(yuǎn)超過(guò)了現(xiàn)有的芯片工程師數(shù)量。55.98% 的開(kāi)發(fā)者表示,他們團(tuán)隊(duì)當(dāng)前最急需的是芯片架構(gòu)工程師。其次是集成電路 IC 設(shè)計(jì)/應(yīng)用工程師、半導(dǎo)體技術(shù)工程師。

對(duì)此,中國(guó)科學(xué)院計(jì)算技術(shù)研究所副所長(zhǎng)包云崗點(diǎn)評(píng)道,芯片設(shè)計(jì)人才嚴(yán)重短缺,軟硬件協(xié)同能力培養(yǎng)需重視。在調(diào)研的開(kāi)發(fā)者中,只有 6% 的開(kāi)發(fā)者能夠深入理解芯片技術(shù),也就是芯片設(shè)計(jì)人員僅占軟件開(kāi)發(fā)人員的 1/16 左右(6% vs. 94%)。用軟件行業(yè)來(lái)對(duì)比,2021 年軟件相關(guān)產(chǎn)品營(yíng)業(yè)額約為 36000 億(軟件產(chǎn)品收入 26583 億元+嵌入式系統(tǒng)軟件收入 9376 億元),芯片設(shè)計(jì)行業(yè)產(chǎn)值約為軟件開(kāi)發(fā)行業(yè)產(chǎn)值的 1/7。這些統(tǒng)計(jì)數(shù)據(jù)口徑并不一致,但也一定程度上能反映出芯片設(shè)計(jì)人員的嚴(yán)重短缺。

小團(tuán)隊(duì)作戰(zhàn),AI 成為芯片應(yīng)用的重要場(chǎng)景之一

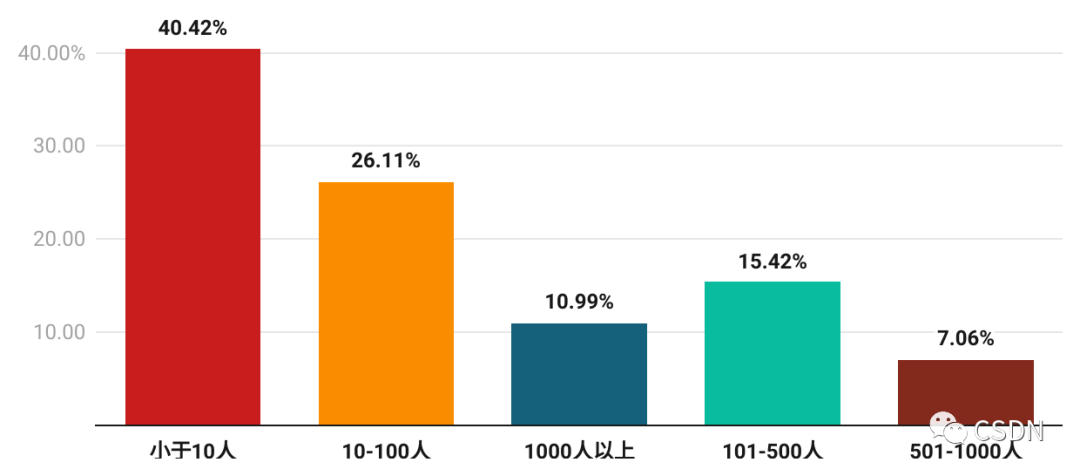

放眼當(dāng)前國(guó)內(nèi)芯片市場(chǎng)入局的公司規(guī)模,呈現(xiàn)出一定的分散趨勢(shì)。40.42% 的公司人數(shù)小于 10 人,這些公司可能是由獨(dú)立的芯片設(shè)計(jì)師或者小團(tuán)隊(duì)組成,可能主要專注于某個(gè)細(xì)分領(lǐng)域的應(yīng)用開(kāi)發(fā)。

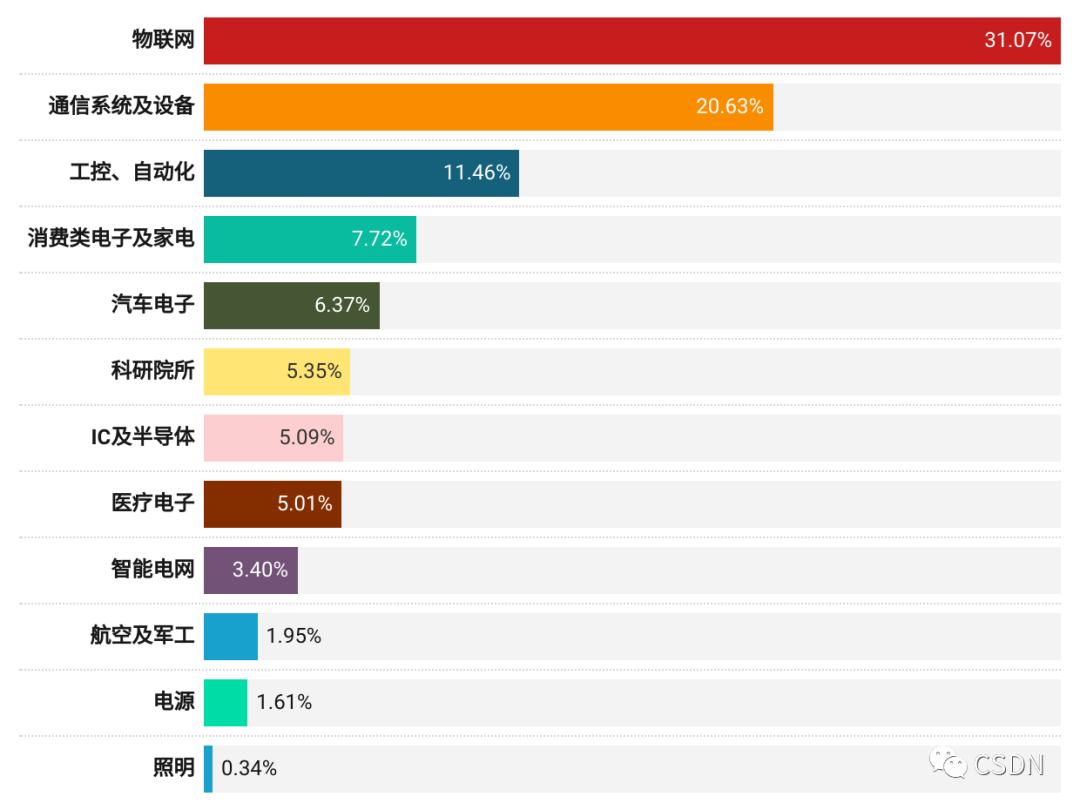

數(shù)據(jù)顯示,當(dāng)前的芯片公司的芯片主要服務(wù)于物聯(lián)網(wǎng)以及通信系統(tǒng)及設(shè)備。其中,物聯(lián)網(wǎng)占比最大且遠(yuǎn)高于其他產(chǎn)品/服務(wù),占比 31.07%,其次為通信系統(tǒng)及設(shè)備,占比 20.63%。

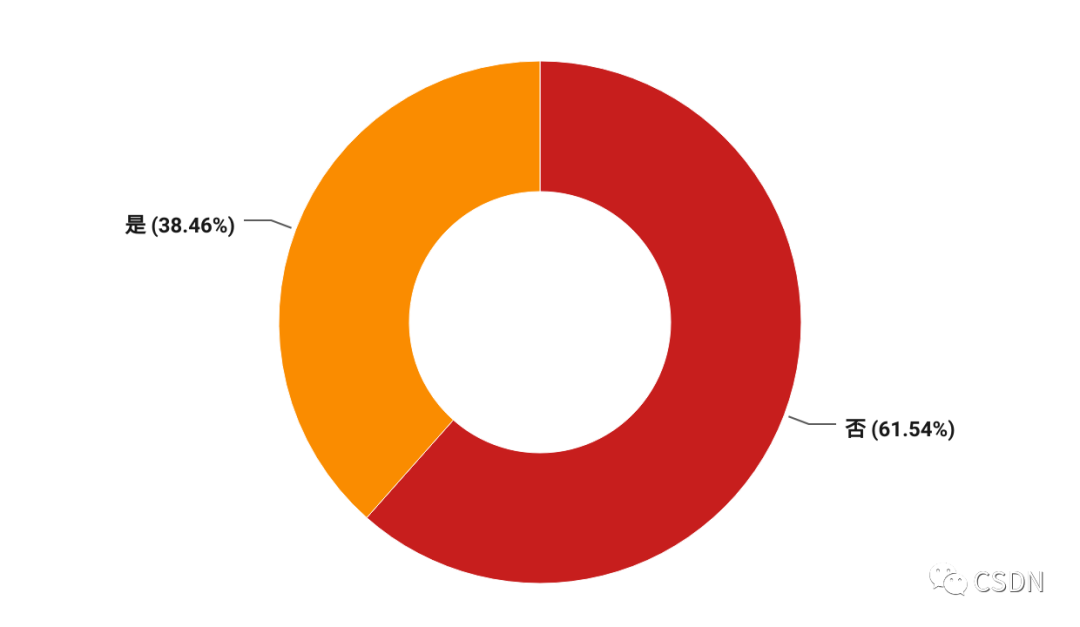

人工智能蓬勃發(fā)展,越來(lái)越多的專用芯片設(shè)計(jì)用于人工智能領(lǐng)域,它們的特點(diǎn)是針對(duì)特定的計(jì)算任務(wù)進(jìn)行了高度優(yōu)化。數(shù)據(jù)顯示,在國(guó)內(nèi)的芯片公司中,有 38.46% 的芯片是搭載人工智能技術(shù)的,能為人工智能應(yīng)用提供更加高效的計(jì)算能力。

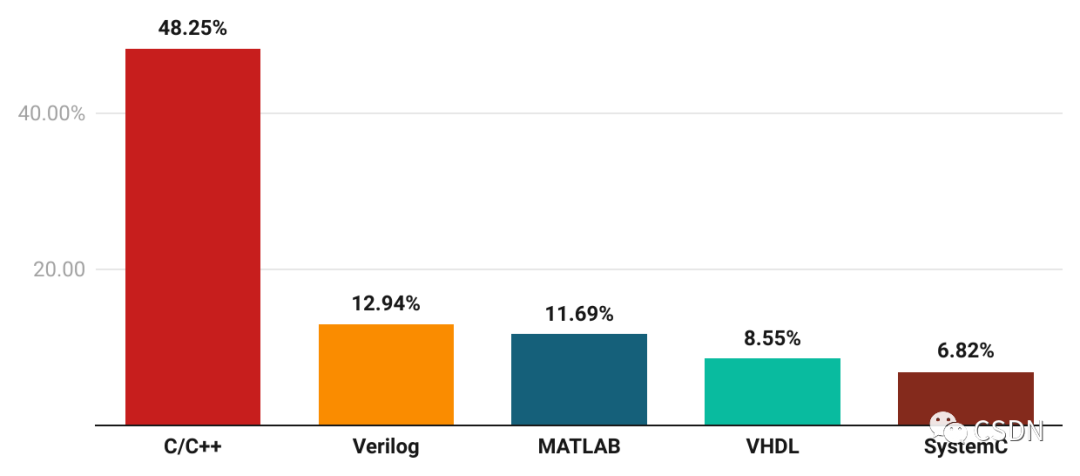

C/C++ 和 Verilog 是開(kāi)發(fā)者最為常用的編程語(yǔ)言

在芯片開(kāi)發(fā)工具層面,芯片開(kāi)發(fā)人員在開(kāi)發(fā)語(yǔ)言的選擇上多樣性較高,其中最常用的兩種語(yǔ)言分別是 C/C++ 和 Verilog。C/C++ 是一種常見(jiàn)的通用程序設(shè)計(jì)語(yǔ)言,可用于高級(jí)的應(yīng)用程序和底層系統(tǒng)編程,數(shù)據(jù)顯示,近五成的開(kāi)發(fā)者在使用它們進(jìn)行編寫(xiě)代碼;而 Verilog 則是一種硬件描述語(yǔ)言,主要用于數(shù)字電路的建模和仿真,使用的開(kāi)發(fā)者占比 12.94%。

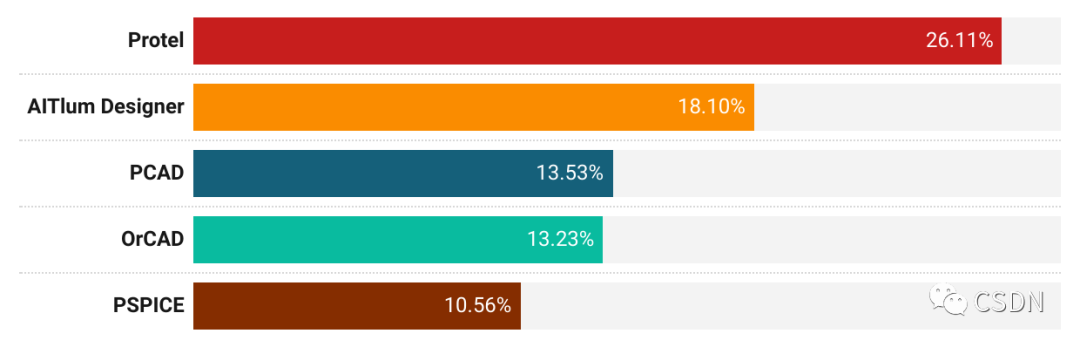

芯片開(kāi)發(fā)中使用的 EDA 工具多種多樣,且芯片開(kāi)發(fā)人員常用的 EDA 工具呈現(xiàn)出多樣性和分散性。

數(shù)據(jù)顯示,使用最廣泛的工具是 Protel,占 26.11%;其次是 AlTIum Designer,占 18.10%;開(kāi)發(fā)人員可以根據(jù)自己的需求、意愿和實(shí)踐經(jīng)驗(yàn),選擇最適合自己的工具來(lái)進(jìn)行芯片設(shè)計(jì)、仿真和測(cè)試。

***開(kāi)發(fā)的挑戰(zhàn):設(shè)計(jì)、低功耗和專利

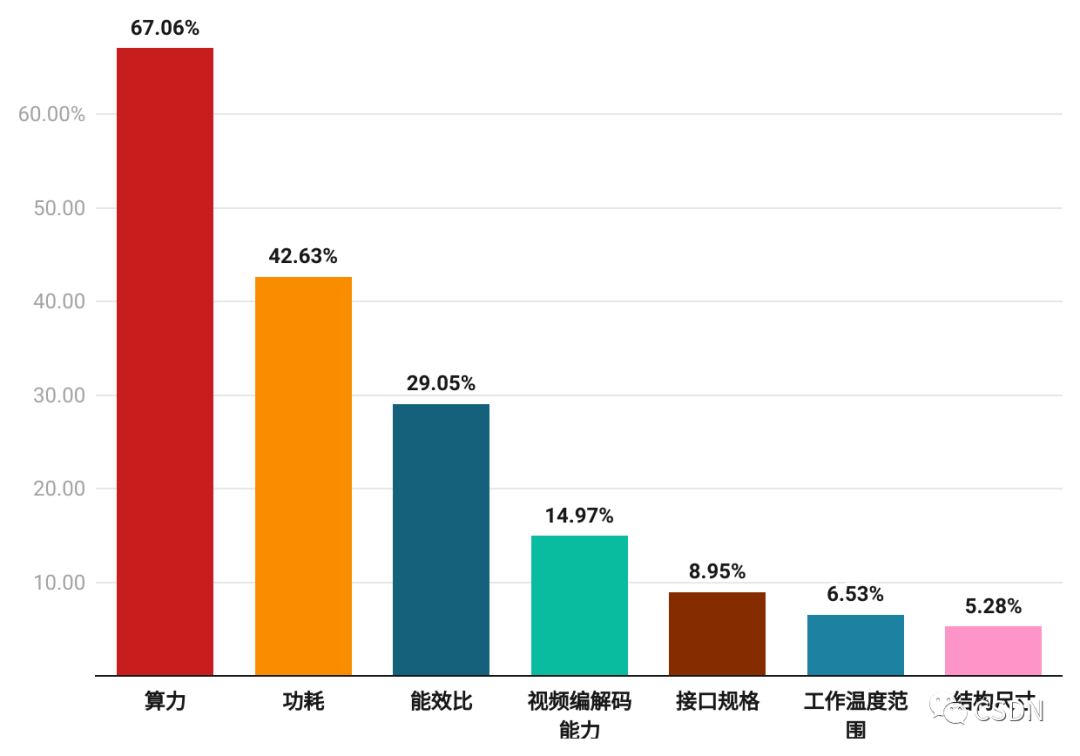

在現(xiàn)代技術(shù)中,芯片作為基礎(chǔ)設(shè)施之一,芯片參數(shù)也是開(kāi)發(fā)者們最為關(guān)注的話題。首先是算力,它衡量芯片處理速度的指標(biāo),67.06% 的開(kāi)發(fā)者表示他們關(guān)心芯片算力參數(shù);其次是功耗,它也是衡量芯片的重要指標(biāo)之一,42.63% 的開(kāi)發(fā)者也比較關(guān)心。

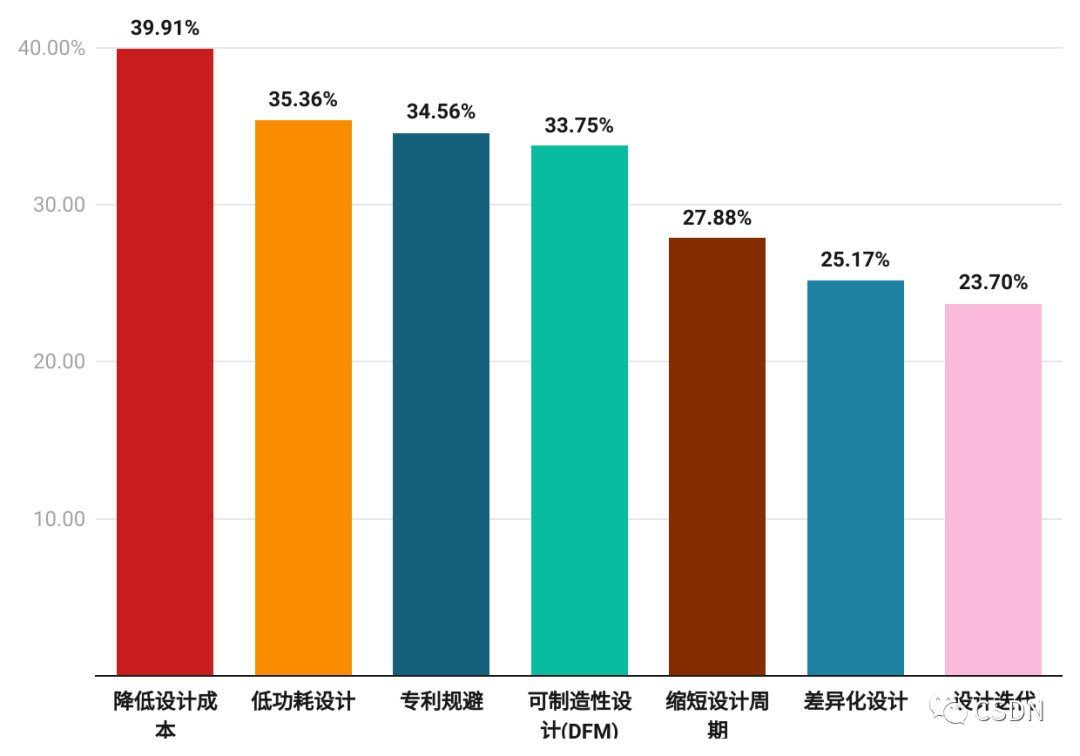

***在開(kāi)發(fā)中面臨很多挑戰(zhàn)和難題,以下是一些主要的方面:

-

設(shè)計(jì)能力:芯片設(shè)計(jì)是復(fù)雜而艱巨的工作,需要高超的技術(shù)和精湛的設(shè)計(jì)能力。39.91% 的開(kāi)發(fā)者表示,當(dāng)前以國(guó)內(nèi)的設(shè)計(jì)能力,很難去降低芯片設(shè)計(jì)成本。其次便是低功耗設(shè)計(jì),35.36% 的開(kāi)發(fā)者表示要實(shí)現(xiàn)低功耗也非常困難。

-

專利保護(hù):芯片制造涉及到大量的專利技術(shù),國(guó)內(nèi)芯片開(kāi)發(fā)中,需要進(jìn)行專利規(guī)避

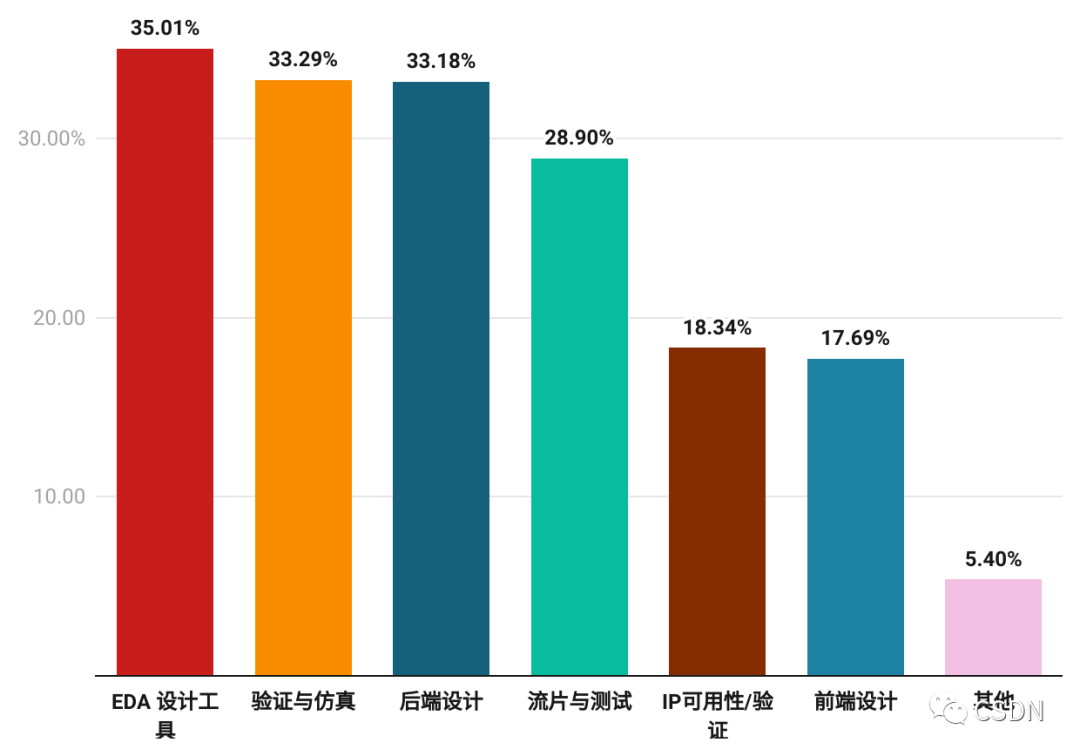

在芯片設(shè)計(jì)上,開(kāi)發(fā)者最擔(dān)憂的是 EDA 設(shè)計(jì)工具,現(xiàn)代芯片的復(fù)雜度非常高,一個(gè)芯片可能包含數(shù)十億個(gè)晶體管和數(shù)百萬(wàn)條線路,因此設(shè)計(jì)過(guò)程中需要更優(yōu)秀的工具來(lái)幫助工程師處理如此巨大的設(shè)計(jì)空間。

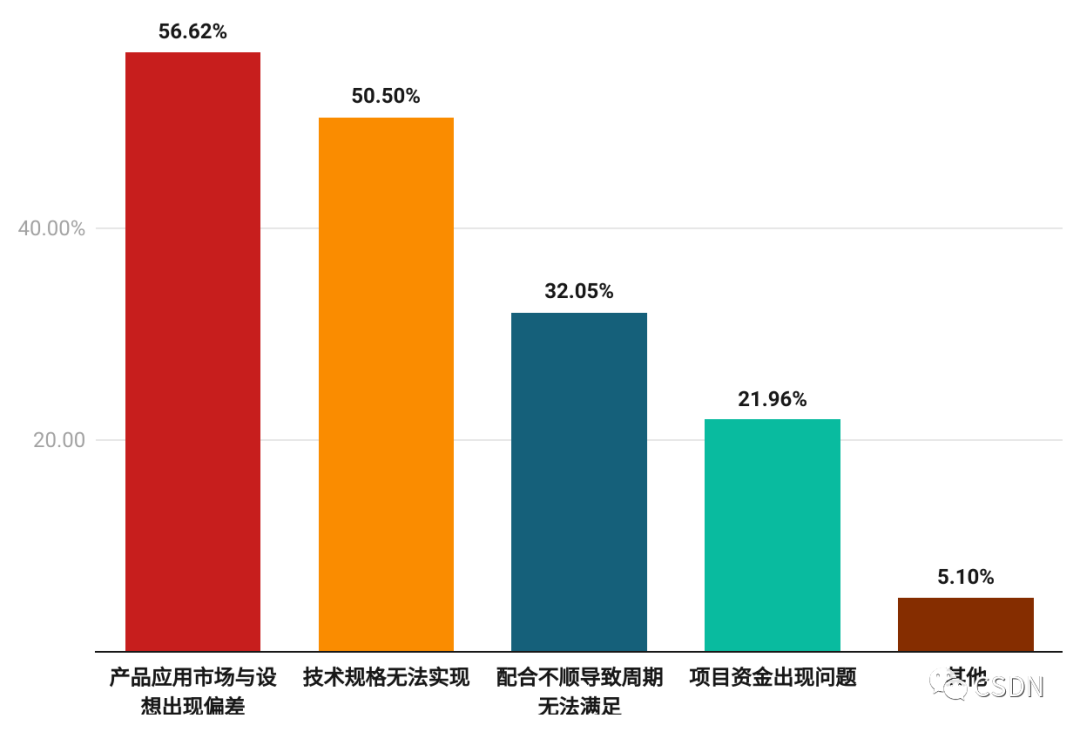

芯片制造與軟件開(kāi)發(fā)流程不同,不能像軟件開(kāi)發(fā)那進(jìn)行小步快跑的迭代,整個(gè)制造過(guò)程的成本也比較高。

56.62% 的開(kāi)發(fā)者認(rèn)為在芯片制造中,容易出現(xiàn)產(chǎn)品應(yīng)用市場(chǎng)與設(shè)想出現(xiàn)偏差,從而導(dǎo)致研發(fā)投入、生產(chǎn)成本等方面的浪費(fèi)。其次是在芯片開(kāi)發(fā)過(guò)程中,某些設(shè)計(jì)規(guī)格無(wú)法實(shí)現(xiàn),半數(shù)的開(kāi)發(fā)者都對(duì)此表示擔(dān)心。

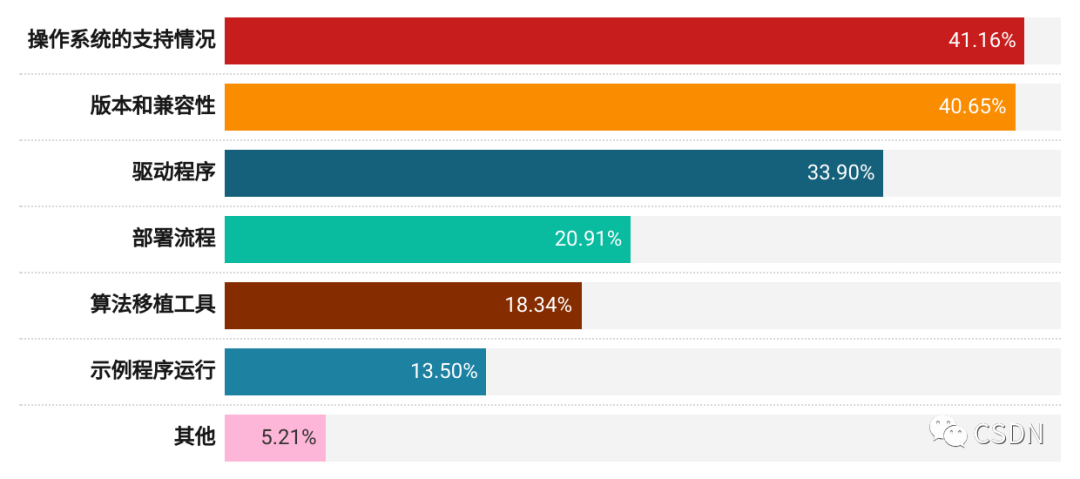

包云崗認(rèn)為,超過(guò) 41% 的開(kāi)發(fā)者最關(guān)心的是芯片對(duì)操作系統(tǒng)的支持情況。由此可見(jiàn),優(yōu)秀的芯片設(shè)計(jì)人才不僅僅懂芯片架構(gòu),也需要懂操作系統(tǒng)等軟件棧知識(shí)。然而,這類人才在國(guó)內(nèi)更是稀缺,因?yàn)楹芏嗉呻娐穼W(xué)院并不開(kāi)設(shè)操作系統(tǒng)等軟件課程。要解決人才急缺問(wèn)題,當(dāng)前人才培養(yǎng)理念與方案需要改變,需要更重視軟硬件協(xié)同能力的培養(yǎng)。開(kāi)源芯片的未來(lái)

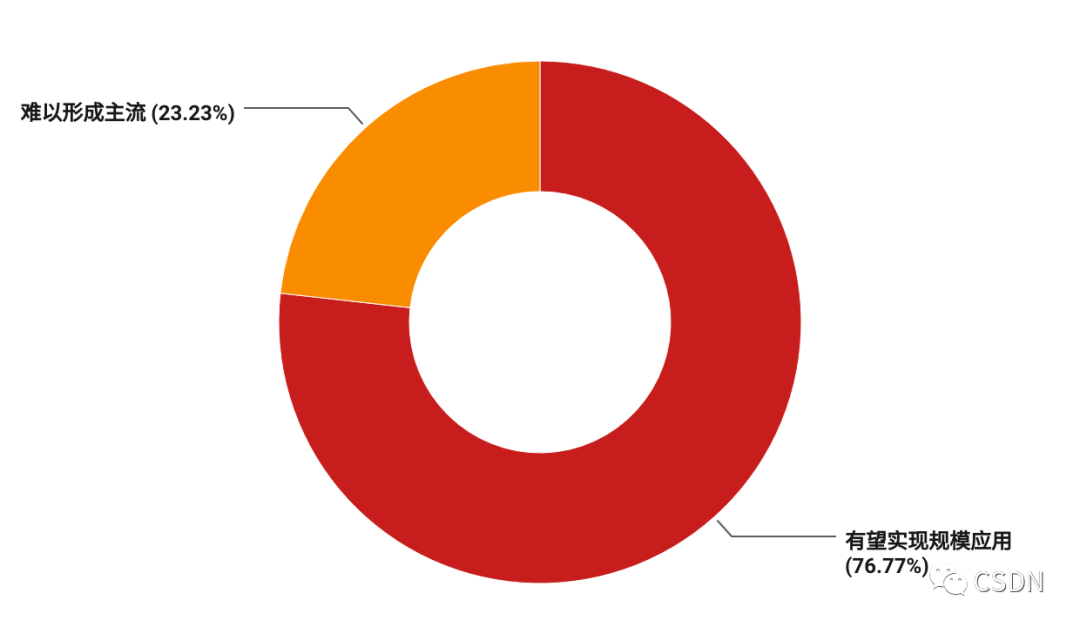

隨著開(kāi)源芯片技術(shù)的日益成熟,其市場(chǎng)份額也將逐漸增加,開(kāi)源芯片平臺(tái)如 RISC-V 等已經(jīng)被廣泛應(yīng)用于各種應(yīng)用場(chǎng)合。它作為一項(xiàng)新興技術(shù),其未來(lái)的發(fā)展前景非常廣闊,76.77% 的開(kāi)發(fā)者都看好開(kāi)源芯片的發(fā)展,有望實(shí)現(xiàn)規(guī)模應(yīng)用,將會(huì)在未來(lái)的幾年中迎來(lái)爆發(fā)式增長(zhǎng)。

包云崗認(rèn)為,超過(guò) 41% 的開(kāi)發(fā)者最關(guān)心的是芯片對(duì)操作系統(tǒng)的支持情況。由此可見(jiàn),優(yōu)秀的芯片設(shè)計(jì)人才不僅僅懂芯片架構(gòu),也需要懂操作系統(tǒng)等軟件棧知識(shí)。然而,這類人才在國(guó)內(nèi)更是稀缺,因?yàn)楹芏嗉呻娐穼W(xué)院并不開(kāi)設(shè)操作系統(tǒng)等軟件課程。要解決人才急缺問(wèn)題,當(dāng)前人才培養(yǎng)理念與方案需要改變,需要更重視軟硬件協(xié)同能力的培養(yǎng)。開(kāi)源芯片的未來(lái)

隨著開(kāi)源芯片技術(shù)的日益成熟,其市場(chǎng)份額也將逐漸增加,開(kāi)源芯片平臺(tái)如 RISC-V 等已經(jīng)被廣泛應(yīng)用于各種應(yīng)用場(chǎng)合。它作為一項(xiàng)新興技術(shù),其未來(lái)的發(fā)展前景非常廣闊,76.77% 的開(kāi)發(fā)者都看好開(kāi)源芯片的發(fā)展,有望實(shí)現(xiàn)規(guī)模應(yīng)用,將會(huì)在未來(lái)的幾年中迎來(lái)爆發(fā)式增長(zhǎng)。 整體而言,包云崗總結(jié)道,新興領(lǐng)域芯片需求快速增長(zhǎng),開(kāi)源芯片未來(lái)可期。

一方面,報(bào)告中顯示當(dāng)前芯片主要服務(wù)于物聯(lián)網(wǎng)(31%)以及通信系統(tǒng)及設(shè)備(21%)。在調(diào)研的企業(yè)中,研發(fā)的芯片中有 38% 搭載人工智能技術(shù),這也反映了當(dāng)前人工智能領(lǐng)域的蓬勃發(fā)展。兩項(xiàng)數(shù)據(jù)結(jié)合,可以大致反映出很多物聯(lián)網(wǎng)場(chǎng)景也有人工智能需求。

另一方面,在被調(diào)研的芯片公司中,40% 的公司人數(shù)小于 10 人,26%的公司人數(shù)為 10-100 人。結(jié)合 2022 年 12 月魏少軍教授在 ICCAD 會(huì)上的關(guān)于中國(guó)芯片設(shè)計(jì)產(chǎn)業(yè)總體發(fā)展情況的報(bào)告數(shù)據(jù)顯示,全國(guó)甚至有 2700 余家(占84%)芯片設(shè)計(jì)公司人數(shù)不足 100。

總之,國(guó)內(nèi)絕大多數(shù)芯片設(shè)計(jì)企業(yè)人員規(guī)模并不大,他們主要專注于某個(gè)細(xì)分領(lǐng)域的芯片開(kāi)發(fā)。這些企業(yè)的存在是因?yàn)槲锫?lián)網(wǎng)等新興領(lǐng)域帶來(lái)的芯片碎片化需求,而以 RISC-V 為代表的開(kāi)源芯片允許企業(yè)更方便地定制芯片,是應(yīng)對(duì)碎片化需求的有效方式,也有助于實(shí)現(xiàn)企業(yè)非常關(guān)心的降低芯片設(shè)計(jì)成本的需求。

?

整體而言,包云崗總結(jié)道,新興領(lǐng)域芯片需求快速增長(zhǎng),開(kāi)源芯片未來(lái)可期。

一方面,報(bào)告中顯示當(dāng)前芯片主要服務(wù)于物聯(lián)網(wǎng)(31%)以及通信系統(tǒng)及設(shè)備(21%)。在調(diào)研的企業(yè)中,研發(fā)的芯片中有 38% 搭載人工智能技術(shù),這也反映了當(dāng)前人工智能領(lǐng)域的蓬勃發(fā)展。兩項(xiàng)數(shù)據(jù)結(jié)合,可以大致反映出很多物聯(lián)網(wǎng)場(chǎng)景也有人工智能需求。

另一方面,在被調(diào)研的芯片公司中,40% 的公司人數(shù)小于 10 人,26%的公司人數(shù)為 10-100 人。結(jié)合 2022 年 12 月魏少軍教授在 ICCAD 會(huì)上的關(guān)于中國(guó)芯片設(shè)計(jì)產(chǎn)業(yè)總體發(fā)展情況的報(bào)告數(shù)據(jù)顯示,全國(guó)甚至有 2700 余家(占84%)芯片設(shè)計(jì)公司人數(shù)不足 100。

總之,國(guó)內(nèi)絕大多數(shù)芯片設(shè)計(jì)企業(yè)人員規(guī)模并不大,他們主要專注于某個(gè)細(xì)分領(lǐng)域的芯片開(kāi)發(fā)。這些企業(yè)的存在是因?yàn)槲锫?lián)網(wǎng)等新興領(lǐng)域帶來(lái)的芯片碎片化需求,而以 RISC-V 為代表的開(kāi)源芯片允許企業(yè)更方便地定制芯片,是應(yīng)對(duì)碎片化需求的有效方式,也有助于實(shí)現(xiàn)企業(yè)非常關(guān)心的降低芯片設(shè)計(jì)成本的需求。

?———————End———————

RT-Thread線下入門(mén)培訓(xùn)

6月 - 鄭州、杭州、深圳

1.免費(fèi)2.動(dòng)手實(shí)驗(yàn)+理論3.主辦方免費(fèi)提供開(kāi)發(fā)板4.自行攜帶電腦,及插線板用于筆記本電腦充電5.參與者需要有C語(yǔ)言、單片機(jī)(ARM Cortex-M核)基礎(chǔ),請(qǐng)?zhí)崆鞍惭b好RT-Thread Studio 開(kāi)發(fā)環(huán)境

立即掃碼報(bào)名

報(bào)名鏈接

https://jinshuju.net/f/UYxS2k

巡回城市:青島、北京、西安、成都、武漢、鄭州、杭州、深圳、上海、南京

你可以添加微信:rtthread2020 為好友,注明:公司+姓名,拉進(jìn)RT-Thread官方微信交流群!

點(diǎn)擊閱讀原文,進(jìn)入RT-Thread 官網(wǎng)

原文標(biāo)題:【AI簡(jiǎn)報(bào)20230602】能聽(tīng)懂語(yǔ)音的ChatGPT來(lái)了!***開(kāi)發(fā)調(diào)查報(bào)告發(fā)布

文章出處:【微信公眾號(hào):RTThread物聯(lián)網(wǎng)操作系統(tǒng)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

-

RT-Thread

+關(guān)注

關(guān)注

31文章

1272瀏覽量

39923

原文標(biāo)題:【AI簡(jiǎn)報(bào)20230602】能聽(tīng)懂語(yǔ)音的ChatGPT來(lái)了!國(guó)產(chǎn)芯片開(kāi)發(fā)調(diào)查報(bào)告發(fā)布

文章出處:【微信號(hào):RTThread,微信公眾號(hào):RTThread物聯(lián)網(wǎng)操作系統(tǒng)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

萬(wàn)物皆AI 基于聯(lián)發(fā)科科技 MTK Genio 130 結(jié)合 ChatGPT 功能的解決方案

訊飛開(kāi)放平臺(tái)攜手開(kāi)發(fā)者共建繁榮生態(tài)

韓企人工智能使用率僅為30.6%

OpenAI 深夜拋出王炸 “ChatGPT- 4o”, “她” 來(lái)了

蘋(píng)果首款折疊屏MacBook或提前至2026年發(fā)布

芯盾時(shí)代入選2024安在新榜網(wǎng)絡(luò)安全產(chǎn)品“大眾點(diǎn)評(píng)”百?gòu)?qiáng)榜

富士通發(fā)布2024 SX調(diào)查報(bào)告 揭示可持續(xù)發(fā)展的關(guān)鍵成功因素

【Longan Pi 3H 開(kāi)發(fā)板試用連載體驗(yàn)】給ChatGPT裝上眼睛,還可以語(yǔ)音對(duì)話

在FPGA設(shè)計(jì)中是否可以應(yīng)用ChatGPT生成想要的程序呢

OpenAI完成罷免總裁調(diào)查,奧特曼重回董事會(huì),并迎三位新董事

愛(ài)立信消費(fèi)者實(shí)驗(yàn)室報(bào)告發(fā)布

【國(guó)產(chǎn)FPGA+OMAPL138開(kāi)發(fā)板體驗(yàn)】(原創(chuàng))6.FPGA連接ChatGPT 4

【先楫HPM5361EVK開(kāi)發(fā)板試用體驗(yàn)】(原創(chuàng))5.手把手實(shí)戰(zhàn)AI機(jī)械臂

大眾汽車(chē)推出AI語(yǔ)音助手ChatGPT

【AI簡(jiǎn)報(bào)20230602】能聽(tīng)懂語(yǔ)音的ChatGPT來(lái)了!***開(kāi)發(fā)調(diào)查報(bào)告發(fā)布

【AI簡(jiǎn)報(bào)20230602】能聽(tīng)懂語(yǔ)音的ChatGPT來(lái)了!***開(kāi)發(fā)調(diào)查報(bào)告發(fā)布

評(píng)論