設備直通給虛擬機能夠極大提升虛擬機對物理設備訪問的性能,本文通過vfio內核模塊和qemu用戶態實現介紹vfio設備直通時的關鍵部分,包括:用戶態訪問設備IO地址空間,DMA重映射,中斷重映射等.

VFIO訪問直通設備IO地址空間

1.PIO和MMIO

設備的IO地址空間的訪問有PIO和MMIO兩種方式,前者通過獨立的IO端口訪問設備,而MMIO是在物理內存中映射一段區間,直接訪問該內存就可以訪問設備的配置空間.在虛擬化的場景下,虛擬機通過PIO訪問直通設備時,首先會VM-exit到qemu,由qemu通過轉換表完成對該PIO操作的轉發.對于PCI設備而言,其bar空間地址是通過PIO的方式設置的,如果將設備的PIO訪問完全暴露給虛擬機,虛擬機修改了真實的物理設備的PCI Bar空間基地址配置,與host上不一致,可能會出現嚴重的問題,所以對于設備的PIO訪問需要建立轉換表,在VM-exit之后由qemu來完成設置的轉發.

對于設備的MMIO空間訪問,則可以通過建立EPT頁表將設備的MMIO物理內存映射到虛擬的MMIO地址空間,讓虛擬機能夠直接通過MMIO訪問PCI設備的bar空間,提高IO性能.

2.獲取直通設備信息

通過VFIO提供的接口可以獲取到設備的基本信息,包括設備的描述符、region的數量等。

vfio_get_device:

fd = ioctl(group- >fd, VFIO_GROUP_GET_DEVICE_FD, name);

ret = ioctl(fd, VFIO_DEVICE_GET_INFO, &dev_info);

vbasedev- >fd = fd;

vbasedev- >group = group;

QLIST_INSERT_HEAD(&group- >device_list, vbasedev, next);

vbasedev- >num_irqs = dev_info.num_irqs;

vbasedev- >num_regions = dev_info.num_regions;

vbasedev- >flags = dev_info.flags;

2.直通設備PCI配置空間模擬

Qemu為每個PCI直通設備都建立一個虛擬數據結構 VFIOPCIDevice,保存物理PCI設備的相關信息,由vfio_get_device來獲取,保存到vbasedev中。

typedef struct VFIOPCIDevice {

PCIDevice pdev;

VFIODevice vbasedev;

VFIO設備作為qemu的設備模型的一部分,qemu對直通設備的模擬初始化入口在 vfio_realize,通過vfio_get_device獲取到直通設備的基本信息之后,會調用pread設備的fd獲取到設備的配置空間信息的一份拷貝,qemu會寫入一些自定義的config配置。

vfio_realize:

/* Get a copy of config space */

ret = pread(vdev- >vbasedev.fd, vdev- >pdev.config,

MIN(pci_config_size(&vdev- >pdev), vdev- >config_size),

vdev- >config_offset);

if (ret < (int)MIN(pci_config_size(&vdev- >pdev), vdev- >config_size)) {

ret = ret < 0 ? -errno : -EFAULT;

error_setg_errno(errp, -ret, "failed to read device config space");

goto error;

}

/* vfio emulates a lot for us, but some bits need extra love */

vdev- >emulated_config_bits = g_malloc0(vdev- >config_size);

/* QEMU can choose to expose the ROM or not */

memset(vdev- >emulated_config_bits + PCI_ROM_ADDRESS, 0xff, 4);

/* QEMU can change multi-function devices to single function, or reverse */

vdev- >emulated_config_bits[PCI_HEADER_TYPE] =

PCI_HEADER_TYPE_MULTI_FUNCTION;

/* Restore or clear multifunction, this is always controlled by QEMU */

if (vdev- >pdev.cap_present & QEMU_PCI_CAP_MULTIFUNCTION) {

vdev- >pdev.config[PCI_HEADER_TYPE] |= PCI_HEADER_TYPE_MULTI_FUNCTION;

} else {

vdev- >pdev.config[PCI_HEADER_TYPE] &= ~PCI_HEADER_TYPE_MULTI_FUNCTION;

}

/*

* Clear host resource mapping info. If we choose not to register a

* BAR, such as might be the case with the option ROM, we can get

* confusing, unwritable, residual addresses from the host here.

*/

memset(&vdev- >pdev.config[PCI_BASE_ADDRESS_0], 0, 24);

memset(&vdev- >pdev.config[PCI_ROM_ADDRESS], 0, 4);

3.直通設備MMIO映射

直通PCI設備的MMIO內存主要是指其Bar空間,qemu使用vfio_populate_device函數調用VFIO接口獲取到PCI設備的Bar空間信息,然后通過vfio_region_setup獲取到對應region的信息,并將qemu內存虛擬化的MemoryRegion設置為IO類型的region。重要的是,qemu會為該IO類型的MemoryRegion設置ops為vfio_region_ops,這樣后續對于該塊內存的讀寫會經過qemu VFIO模塊注冊的接口來進行。

vfio_populate_device:

for (i = VFIO_PCI_BAR0_REGION_INDEX; i < VFIO_PCI_ROM_REGION_INDEX; i++) {

char *name = g_strdup_printf("%s BAR %d", vbasedev- >name, i);

ret = vfio_region_setup(OBJECT(vdev), vbasedev, &vdev- >bars[i].region, i, name);

- > vfio_get_region_info

- > memory_region_init_io(region- >mem, obj, &vfio_region_ops,

region, name, region- >size);

QLIST_INIT(&vdev- >bars[i].quirks);

}

ret = vfio_get_region_info(vbasedev, VFIO_PCI_CONFIG_REGION_INDEX, ®_info);

- > ioctl(vbasedev- >fd, VFIO_DEVICE_GET_REGION_INFO, *info))

ret = ioctl(vdev- >vbasedev.fd, VFIO_DEVICE_GET_IRQ_INFO, &irq_info);

到這里已經獲取到了PCI設備的MMIO內存信息,但是還沒有真正的將物理內存中的Bar空間映射到qemu,這一動作在vfio_bars_setup中完成,vfio_region_mmap會對region中每個需要map的內存地址完成映射,然后將映射的物理內存通過qemu注冊到虛擬機作為一段虛擬機的物理地址空間。

vfio_bars_setup:

for (i = 0; i < PCI_ROM_SLOT; i++)

vfio_bar_setup(vdev, i);

vfio_region_mmap(&bar- >region)

for (i = 0; i < region- >nr_mmaps; i++) {

region- >mmaps[i].mmap = mmap(NULL, region- >mmaps[i].size, prot,

MAP_SHARED, region- >vbasedev- >fd,

region- >fd_offset +

region- >mmaps[i].offset);

memory_region_init_ram_device_ptr

memory_region_add_subregion

pci_register_bar(&vdev- >pdev, nr, type, bar- >region.mem);

這里的映射mmap接口對應的是VFIO設備在內核中注冊的vfio_pci_mmap 函數,在內核中,該函數會為vma注冊一個mmap的ops,對應著注冊了一個缺頁處理函數,當用戶態程序訪問該段虛擬內存缺頁時,調用注冊的缺頁處理函數,完成虛擬地址到實際物理地址的映射。

vfio_pci_mmap:

vma- >vm_flags |= VM_IO | VM_PFNMAP | VM_DONTEXPAND | VM_DONTDUMP;

vma- >vm_ops = &vfio_pci_mmap_ops;

- > .fault = vfio_pci_mmap_fault,

- > if (remap_pfn_range(vma, vma- >vm_start, vma- >vm_pgoff,

vma- >vm_end - vma- >vm_start, vma- >vm_page_prot))

簡單來說,對于MMIO內存的的映射,主要是將物理內存中的MMIO空間映射到了qemu的虛擬地址空間,然后再由qemu將該段內存注冊進虛擬機作為虛擬機的一段物理內存,在這個過程中會建立從gpa到hpa的EPT頁表映射,提升MMIO的性能。

DMA重映射

首先關于DMA,設備通過DMA可以直接使用iova地址訪問物理內存,從iova到實際物理地址的映射是在IOMMU中完成的,一般在dma_allooc分配設備能夠訪問的內存的時候,會分配iova地址和實際的物理地址空間,并在iommu中建立映射關系。 所以說要讓設備進行DMA最關鍵的幾個部分:

- 設備能夠識別的地址:IOVA

- 一段物理內存

- IOVA到物理內存在IOMMU中的映射關系

基于這幾點來看VFIO的DMA重映射就比較清晰,首先從VFIO設備的初始化開始,在獲取設備信息之前會先獲取到設備所屬的group和Container,并調用VFIO_SET_IOMMU完成container和IOMMU的綁定,并attach由VFIO管理的所有設備。此外注意到這里的 pci_device_iommu_address_space 函數,意思是qemu為設備dma注冊了一段專門的地址空間,這段內存作為虛擬機的一段物理內存存在,在VFIO_SET_IOMMU之后,注冊該地址空間,其region_add函數為 vfio_listener_region_add,意思是當內存空間布局發生變化這里是增加內存的時候都會調用該接口。

vfio_realize:

group = vfio_get_group(groupid, pci_device_iommu_address_space(pdev), errp);

vfio_connect_container(group, as, errp)

ret = ioctl(fd, VFIO_SET_IOMMU, container- >iommu_type);

container- >listener = vfio_memory_listener;

memory_listener_register(&container- >listener, container- >space- >as);

- > .region_add = vfio_listener_region_add,

那么跟DMA有什么關系呢,當為設備進行DMA分配一塊內存時,實際是以MemoryRegion的形式存在的,也就是說虛擬機進行dma alloc 會調用region_add函數,進而調用注冊的memory_listener_region_add函數,MemoryRegion有了意味著分配了一塊物理內存,還需要IOVA和映射關系才行。這里,IOVA地址使用的是section->offset_within_address_space,為什么可以這樣,因為IOVA地址只是作為設備識別的地址,只要建立了映射關系就有意義。

vfio_listener_region_add:

iova = TARGET_PAGE_ALIGN(section- >offset_within_address_space);

/* Here we assume that memory_region_is_ram(section- >mr)==true */

vaddr = memory_region_get_ram_ptr(section- >mr) +

section- >offset_within_region +

(iova - section- >offset_within_address_space);

ret = vfio_dma_map(container, iova, int128_get64(llsize),

vaddr, section- >readonly);

vfio_dma_map:

struct vfio_iommu_type1_dma_map map = {

.argsz = sizeof(map),

.flags = VFIO_DMA_MAP_FLAG_READ,

.vaddr = (__u64)(uintptr_t)vaddr,

.iova = iova,

.size = size,

};

ioctl(container- >fd, VFIO_IOMMU_MAP_DMA, &map)

建立映射的關鍵在于vfio_dma_map,通過ioctl調用container->fd接口VFIO_IOMMU_MAP_DMA完成DMA重映射。為什么是container->fd,因為VFIO Container管理內存資源,與IOMMU直接綁定,而IOMMU是完成IOVA到實際物理內存映射的關鍵。值得注意的是qemu只知道這一段內存的虛擬地址vaddr,所以將vaddr,iova和size傳給內核,由內核獲取物理內存信息完成映射。

vfio_dma_do_map:

vfio_pin_map_dma

while (size) {

/* Pin a contiguous chunk of memory */

npage = vfio_pin_pages_remote(dma, vaddr + dma- >size,

size > > PAGE_SHIFT, &pfn, limit);

/* Map it! */

vfio_iommu_map(iommu, iova + dma- >size, pfn, npage,

dma- >prot);

list_for_each_entry(d, &iommu- >domain_list, next)

iommu_map(d- >domain, iova, (phys_addr_t)pfn < < PAGE_SHIFT,

npage < < PAGE_SHIFT, prot | d- >prot);

arm_smmu_map

__arm_lpae_map

size -= npage < < PAGE_SHIFT;

dma- >size += npage < < PAGE_SHIFT;

}

內核完成建立iova到物理內存的映射之前會將分配的DMA內存給pin住,使用vfio_pin_pages_remote接口可以獲取到虛擬地址對應的物理地址和pin住的頁數量,然后vfio_iommu_map進而調用iommu以及smmu的map函數,最終用iova,物理地址信息pfn以及要映射的頁數量在設備IO頁表中建立映射關系。

+--------+ iova +--------+ gpa +----+

| device | - > | memory | < - | vm |

+--------+ +--------+ +----+

最終完成了DMA重映射,設備使用qemu分配的iova地址通過IOMMU映射訪問內存,虛擬機使用gpa通過Stage 2頁表映射訪問內存

中斷重映射

對于PCI直通設備中斷的虛擬化,主要包括三種類型INTx,Msi和Msi-X。

1.INTx中斷初始化及enable

對于INTx類型的中斷,在初始化的時候就進行使能了,qemu通過VFIO device的接口將中斷irq set設置到內核中,并且會注冊一個eventfd,設置了eventfd的handler,當發生intx類型的中斷時,內核會通過eventfd通知qemu進行處理,qemu會通知虛擬機進行處理。

vfio_realize:

if (vfio_pci_read_config(&vdev- >pdev, PCI_INTERRUPT_PIN, 1)) {

pci_device_set_intx_routing_notifier(&vdev- >pdev, vfio_intx_update);

ret = vfio_intx_enable(vdev, errp);

*pfd = event_notifier_get_fd(&vdev- >intx.interrupt);

qemu_set_fd_handler(*pfd, vfio_intx_interrupt, NULL, vdev);

ret = ioctl(vdev- >vbasedev.fd, VFIO_DEVICE_SET_IRQS, irq_set);

2.MSI-X初始化

MSIX在vfio_realzie初始化時,首先獲取到物理設備的中斷相關的配置信息,將其設置到注冊給對應的MMIO內存中

vfio_msix_early_setup:

pos = pci_find_capability(&vdev- >pdev, PCI_CAP_ID_MSIX);

if (pread(fd, &ctrl, sizeof(ctrl),

vdev- >config_offset + pos + PCI_MSIX_FLAGS) != sizeof(ctrl)) {

if (pread(fd, &table, sizeof(table),

vdev- >config_offset + pos + PCI_MSIX_TABLE) != sizeof(table)) {

if (pread(fd, &pba, sizeof(pba),

vdev- >config_offset + pos + PCI_MSIX_PBA) != sizeof(pba)) {

ctrl = le16_to_cpu(ctrl);

table = le32_to_cpu(table);

pba = le32_to_cpu(pba);

msix = g_malloc0(sizeof(*msix));

msix- >table_bar = table & PCI_MSIX_FLAGS_BIRMASK;

msix- >table_offset = table & ~PCI_MSIX_FLAGS_BIRMASK;

msix- >pba_bar = pba & PCI_MSIX_FLAGS_BIRMASK;

msix- >pba_offset = pba & ~PCI_MSIX_FLAGS_BIRMASK;

msix- >entries = (ctrl & PCI_MSIX_FLAGS_QSIZE) + 1;

vfio_msix_setup:

msix_init(&vdev- >pdev, vdev- >msix- >entries,

vdev- >bars[vdev- >msix- >table_bar].region.mem,

vdev- >msix- >table_bar, vdev- >msix- >table_offset,

vdev- >bars[vdev- >msix- >pba_bar].region.mem,

vdev- >msix- >pba_bar, vdev- >msix- >pba_offset, pos);

memory_region_init_io(&dev- >msix_table_mmio, OBJECT(dev), &msix_table_mmio_ops, dev,

"msix-table", table_size);

memory_region_add_subregion(table_bar, table_offset, &dev- >msix_table_mmio);

memory_region_init_io(&dev- >msix_pba_mmio, OBJECT(dev), &msix_pba_mmio_ops, dev,

"msix-pba", pba_size);

memory_region_add_subregion(pba_bar, pba_offset, &dev- >msix_pba_mmio);

vfio_realize:

/* QEMU emulates all of MSI & MSIX */

if (pdev- >cap_present & QEMU_PCI_CAP_MSIX) {

memset(vdev- >emulated_config_bits + pdev- >msix_cap, 0xff,

MSIX_CAP_LENGTH);

if (pdev- >cap_present & QEMU_PCI_CAP_MSI) {

memset(vdev- >emulated_config_bits + pdev- >msi_cap, 0xff,

vdev- >msi_cap_size);

- MSI/MSI-X enable 與 irqfd的注冊

當虛擬機因為寫PCI配置空間而發生VM-exit時,最終會完成msi和msix的使能,以MSIX的使能為例,在qemu側會設置eventfd的處理函數,并通過kvm將irqfd注冊到內核中,進而注冊虛擬中斷給虛擬機。

kvm_cpu_exec:

vfio_pci_write_config:

vfio_msi_enable(vdev);

vfio_msix_enable(vdev);

for (i = 0; i < vdev- >nr_vectors; i++) {

if (event_notifier_init(&vector- >interrupt, 0)) {

qemu_set_fd_handler(event_notifier_get_fd(&vector- >interrupt),

vfio_msi_interrupt, NULL, vector);

vfio_add_kvm_msi_virq(vdev, vector, i, false);

kvm_irqchip_add_msi_route(kvm_state, vector_n, &vdev- >pdev);

vfio_add_kvm_msi_virq

kvm_irqchip_add_irqfd_notifier_gsi

kvm_vm_ioctl(s, KVM_IRQFD, &irqfd);

/* Set interrupt type prior to possible interrupts */

vdev- >interrupt = VFIO_INT_MSI;

ret = vfio_enable_vectors(vdev, false);

ret = ioctl(vdev- >vbasedev.fd, VFIO_DEVICE_SET_IRQS, irq_set);

小結

要讓設備直通給虛擬機,需要將設備的DMA能力、中斷響應和IO地址空間訪問安全地暴露給用戶態,本文主要介紹了VFIO設備直通關鍵的幾個環節,包括如何在用戶態訪問物理設備的IO地址空間、如何進行DMA重映射和中斷重映射。

-

dma

+關注

關注

3文章

559瀏覽量

100442 -

虛擬機

+關注

關注

1文章

908瀏覽量

28107 -

MMU

+關注

關注

0文章

91瀏覽量

18268 -

串口中斷

+關注

關注

0文章

64瀏覽量

13859 -

qemu

+關注

關注

0文章

57瀏覽量

5334

發布評論請先 登錄

相關推薦

詳解交換機測試中的直通時延和存儲轉發時延二者區別

什么是直通線?直通線的做法?

Linux設備與驅動的手動解綁與手動綁定

IGBT直通短路過程問題分析

Arm對虛擬化下設備直通的支持

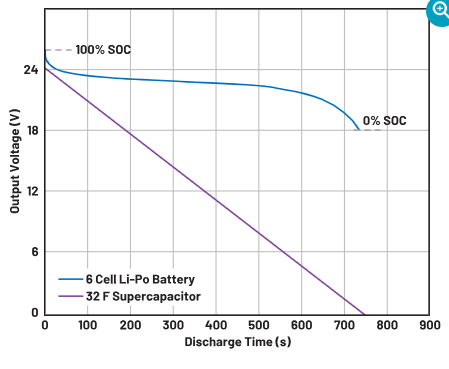

為什么使用直通技術可以幫助延長儲能系統的使用壽命

VFIO設備直通原理

VFIO設備直通原理

評論