電子發(fā)燒友網(wǎng)報道(文/黃山明)美國時間本周二,AMD舉行了重磅發(fā)布會,推出了一款全新的人工智能GPU Instinct MI300,并表示這款處理器將于今年晚些時候開始向部分客戶發(fā)貨。自英偉達發(fā)布了AI芯片后,便徹底帶動了市場的投資熱情,也推動英偉達登上萬億美元市值的高峰。此次AMD發(fā)布重磅AI芯片,有望對英偉達當前的市場地位形成一定沖擊。

AMD推出高性能AI芯片

在這次AMD的新品發(fā)布會中,核心產(chǎn)品無疑是用于訓練大模型的GPU Instinct MI300。早在今年初,AMD便已經(jīng)宣布了新一代Instinct MI300,是全球首款同時集成CPU、GPU的數(shù)據(jù)中心APU。

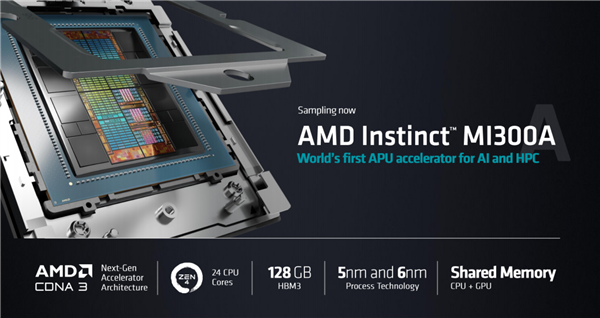

如今,這款芯片的名字變成了Instinct MI300A,而純GPU產(chǎn)品則命名為Instinct MI300X。據(jù)AMD的CEO蘇姿豐透露,MI300A是全球首個為AI和HPC(高性能計算)打造的APU加速卡,擁有13個小芯片,總共包含1460億個晶體管,24個Zen 4 CPU核心,1個CDNA 3圖形引擎和128GB HBM3內(nèi)存。

相比前代MI250,MI300的性能提高八倍,效率提高五倍。AMD在發(fā)布會稍早介紹,新的Zen 4c內(nèi)核比標準的Zen 4內(nèi)核密度更高,比標準Zen 4的內(nèi)核小35%,同時保持100%的軟件兼容性。

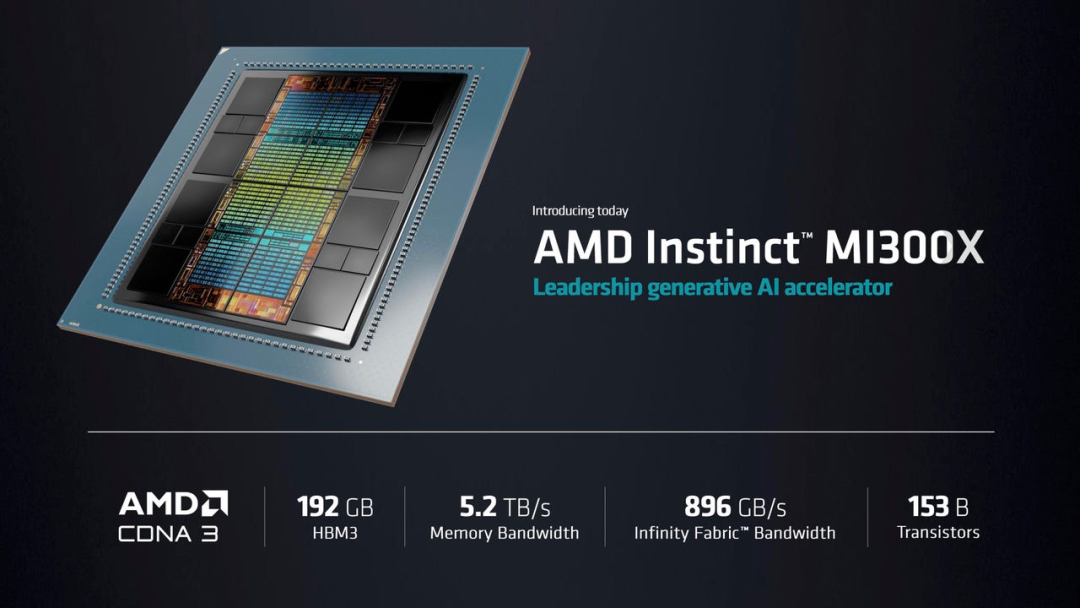

而GPU MI300X更是本次發(fā)布會的重點,這款芯片是AMD針對大語言模型優(yōu)化的版本,該產(chǎn)品的晶體管數(shù)量達到1530億個,內(nèi)存達到了192GB,內(nèi)存帶寬為5.2TB/s,Infinity Fabric帶寬為896GB/s。對比英偉達的H100,MI300X提供的HBM(高帶寬內(nèi)存)密度約為H100的2.4倍,HBM帶寬是1.6倍。

這意味著AMD的這款產(chǎn)品可以運行比英偉達H100更大的模型,在現(xiàn)場AMD演示了MI300X運行400億參數(shù)的Falcon模型,而OpenAI的GPT-3模型有1750億個參數(shù)。蘇姿豐還用Hugging Face基于MI300X的大模型寫了一首關(guān)于活動舉辦地舊金山的詩。

這也是全球首次在單個GPU上運行這么大的模型,據(jù)AMD介紹,單個MI300X可以運行一個參數(shù)多達800億的模型。而在未來隨著AI模型越來越大,意味著需要更多GPU來運行最新的大模型,而AMD芯片上內(nèi)存的增加,意味著開發(fā)人員不需要那么多GPU,可以為用戶節(jié)省大量成本。

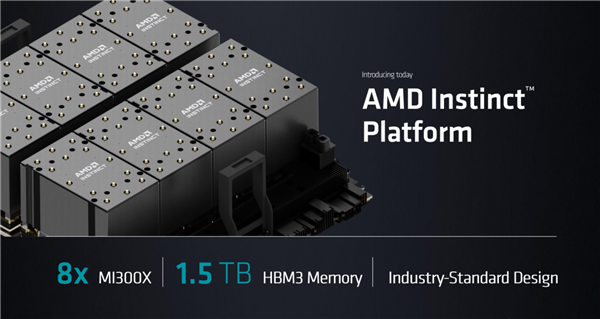

蘇姿豐表示,MI300X將于今年第三季度向一些客戶提供樣品,并于第四季度量產(chǎn)。同時AMD還發(fā)布了AMD Instinct Platform,集合了8個MI300X,可提供總計1.5TB的HBM3內(nèi)存。對標英偉達的CUDA,AMD也介紹了自身的芯片軟件ROCm,AMD總裁Victor Peng稱,在構(gòu)建強大的軟件堆棧方面,AMD取得了真正的巨大進步,ROCm軟件棧可與模型、庫、框架和工具的開放生態(tài)系統(tǒng)配合使用。

之所以將重心放在AI芯片,也是因為AMD非常看好未來的AI市場。蘇姿豐認為,數(shù)據(jù)中心人工智能加速器的潛在市場總額將從今年的300億美元增長到2027年的1500億美元以上。

硬剛英偉達,但尚未透露大客戶

從AMD所介紹的產(chǎn)品性能來看,將成為當下AI市場的有力競爭者,尤其在ChatGPT等生成式AI的帶動下,市場對高性能GPU需求旺盛。不過當前市場中,英偉達處于絕對優(yōu)勢,占據(jù)80%的市場。

而AMD并沒有公布這款GPU的具體價格,但是對比英偉達H100價格大多在3萬美元以上,如果MI300X價格能夠更加實惠,將顯著的對英偉達產(chǎn)品造成沖擊,并有助于降低生成式AI的研發(fā)成本。

有意思的是,在如此強勁的性能面前,市場卻似乎并不買單。截至當日收盤,AMD股價反而下降了3.61%,市值來到2000億元關(guān)口。而英偉達股價則拉升了3.9%,總市值達到1.01萬億美元,是AMD的五倍。

此次AMD并未透露哪些公司會采用MI300X或簡配版MI300A,而在此前的發(fā)布會中,AMD都會披露新產(chǎn)品的大客戶。這可能讓市場認為,目前并沒有大客戶為這款芯片買單。

另一方面,AMD并沒有透露新款AI芯片的具體售價,但想要有顯著的成本優(yōu)勢可能不太現(xiàn)實,因為高密度的HBM價格昂貴。即便MI300X的內(nèi)存達到了192GB,但這也不是顯著優(yōu)勢,因為英偉達也擁有相同內(nèi)存規(guī)格的產(chǎn)品。

更重要的原因在于,MI300并不具備H100所擁有的Transformer Engine。Transformer Engine能夠用于加速Transformer模型,以在AI的訓練和推理中以較低的內(nèi)存利用率提供更好的性能。

有分析師認為,如果訓練一個新的模型,需要投入數(shù)千個GPU,并耗費一年的時間,那么幾乎不會有人會浪費2-3年或者投入3倍數(shù)量的GPU。而Transformer Engine能夠讓大模型實現(xiàn)三倍的性能表達。

盡管市場中認為,AMD的MI300芯片應該是除了谷歌的TPU之外,能與英偉達在AI訓練端上匹敵的產(chǎn)品。成為當前大企業(yè)在訓練AI大模型時,除了英偉達之外的另一個重要選擇。

但想要在短時間內(nèi)挑戰(zhàn)英偉達,顯然還是比較困難的。就如AMD總裁VictorPeng說的那樣,“盡管這是一個過程,但我們在構(gòu)建強大的軟件堆棧方面取得了很大進展,該軟件堆棧與開放的模型、庫、框架和工具生態(tài)系統(tǒng)兼容。”

無論如何需要市場中有大客戶切實的使用AMD新款芯片。

小結(jié)

AMD此次重磅發(fā)布的MI300系列芯片,無疑為AI市場注入了一劑強心針,不僅預示著AMD在持續(xù)看好未來的AI市場,也將表明AMD將在這一市場中與英偉達正面競爭。至少對于相關(guān)企業(yè)及用戶而言,有更多的選擇是一件好事。

-

amd

+關(guān)注

關(guān)注

25文章

5449瀏覽量

133959 -

英偉達

+關(guān)注

關(guān)注

22文章

3749瀏覽量

90859

發(fā)布評論請先 登錄

相關(guān)推薦

IBM與AMD攜手將在IBM云上部署AMD Instinct MI300X加速器

三星首度引入AMD MI300X,緩解AI GPU短缺

AMD發(fā)布全新AI芯片Instinct MI325X

人工智能市場風向轉(zhuǎn)變,AMD Instinct MI300X GPU更受歡迎

AMD Instinct MI300新版將采用HBM3e內(nèi)存,競爭英偉達B100

英偉達繁榮背后的挑戰(zhàn) 仍面臨著各種內(nèi)憂外患

AMD首批Instinct MI300X已開始交付

AMD Instinct MI300X已向LaminiAI批量供貨

不同算力芯片的特點與區(qū)別

英偉達與AMD激戰(zhàn)AI芯片市場,臺積電成最大贏家

AMD Instinct MI300A獲得德國訂單

AMD硬剛英偉達,推出Instinct MI300,單芯片可運行800億參數(shù)

AMD硬剛英偉達,推出Instinct MI300,單芯片可運行800億參數(shù)

評論