baichuan-7B 主要是參考LLaMA進行的改進,且模型架構與LLaMA一致。而在開源大模型中,LLaMA無疑是其中最閃亮的星,但LLaMA存在如下問題:

LLaMA 原生僅支持 Latin 或 Cyrillic 語系,只使用了少量中文數據集進行訓練,因此,對于中文支持不是特別理想。

原版LLaMA模型的詞表大小是32K,僅有少量中文詞,對于中文的解碼效率較低。

baichuan-7B的改進如下:

效果改進:用于提升模型的效果以及解碼效率。

分詞改進:詞表大小為64K(使用2000萬條以中英為主的多語言語料訓練分詞模型,顯著提升對于中文的壓縮率),而LLaMA詞表大小為32K。

數據集改進:使用了大約 1.2T 中英 tokens 進行訓練(基于開源的中英文數據和自行抓取的中文互聯網數據以及部分高質量知識性數據進行的數據清洗),而 LLaMA 7B 使用 1T 英文 tokens 進行訓練。

技術改進:用于提升訓練穩定性和吞吐量。

算子優化技術:采用更高效算子,如 Flash-attention,NVIDIA apex 的 RMSNorm 等。

算子切分技術:將部分計算算子進行切分,減小內存峰值。

混合精度技術:降低在不損失模型精度的情況下加速計算過程。

訓練容災技術:訓練平臺和訓練框架聯合優化,IaaS + PaaS 實現分鐘級的故障定位和任務恢復。

通信優化技術,具體包括:

采用拓撲感知的集合通信算法,避免網絡擁塞問題,提高通信效率。

根據卡數自適應設置 bucket size,提高帶寬利用率。

根據模型和集群環境,調優通信原語的觸發時機,從而將計算和通信重疊。

此外,該模型開源可商用,也算是一個優勢吧。

可以看到,現在的大模型,從算法層面改進的空間似乎很小了,更多的是從工程和數據層面上進行改進從而來提升其性能。

最后,希望國產大模型越來越好~~

責任編輯:彭菁

-

帶寬

+關注

關注

3文章

917瀏覽量

40851 -

開源

+關注

關注

3文章

3256瀏覽量

42420 -

模型

+關注

關注

1文章

3178瀏覽量

48730

原文標題:百川智能開源大模型baichuan-7B剖析

文章出處:【微信號:zenRRan,微信公眾號:深度學習自然語言處理】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

wifi智能開關和zigbee智能開關有哪些區別?

中國人工智能開源軟件前生今生到底如何?

寒武紀的思元(MLU)云端智能加速卡與百川智能完成大模型適配,攜手創新生成式AI

百川智能發布超千億大模型Baichuan 3

IBM在watsonx上提供開源的Mistral AI模型

高通推出第三代驍龍7+移動平臺

百川智能發布Baichuan 4大模型及首款AI助手“百小應”

亞馬遜云科技接入百川智能和零一萬物基礎模型

高通第三代驍龍7s移動平臺發布,賦能中端智能手機以卓越AI新體驗

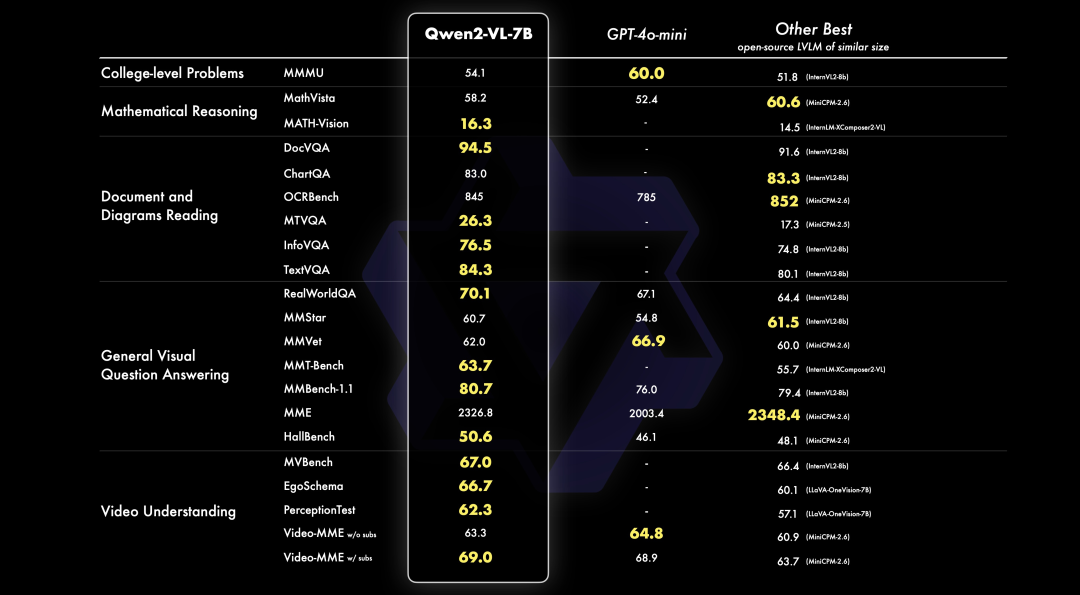

PerfXCloud重磅升級 阿里開源最強視覺語言模型Qwen2-VL-7B強勢上線!

智能開源大模型baichuan-7B技術改進

智能開源大模型baichuan-7B技術改進

評論