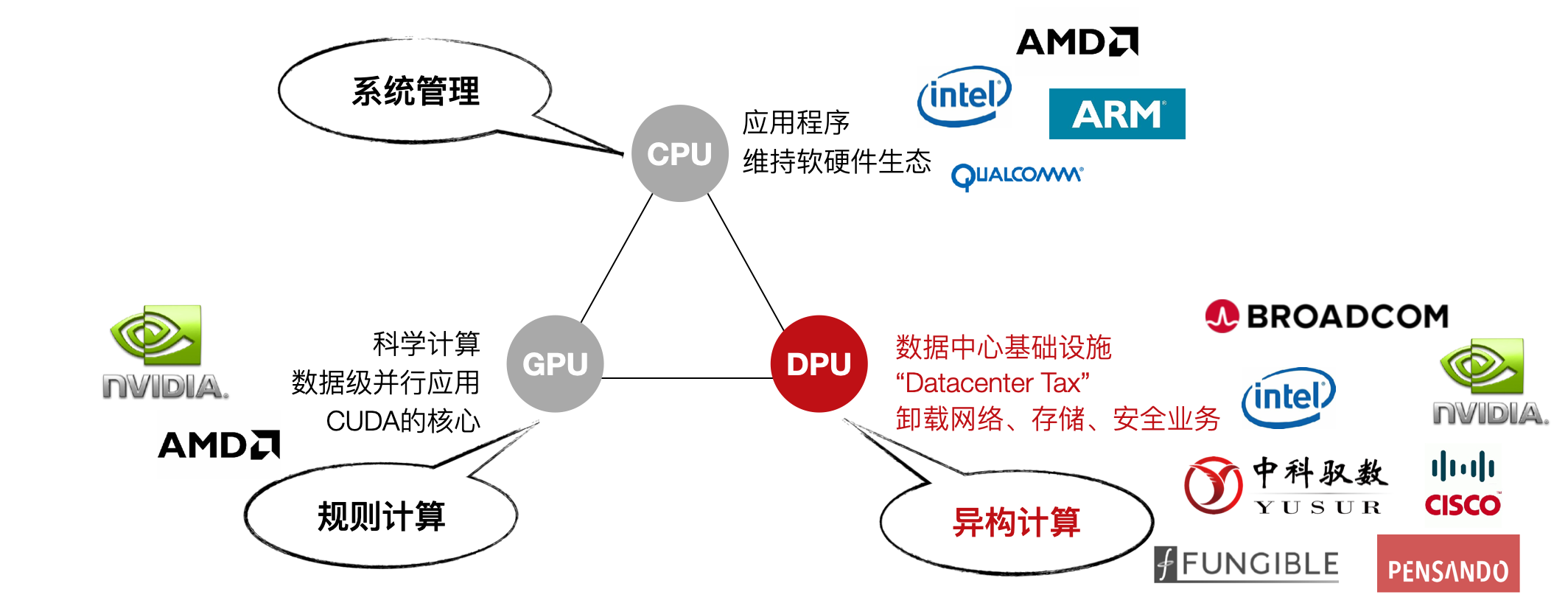

CPU是整個IT生態(tài)的定義者,無論是服務器端的x86還是移動端的ARM,都各自是構(gòu)建了穩(wěn)固的生態(tài)系統(tǒng),不僅形成技術(shù)生態(tài)圈,還形成了閉合價值鏈。

GPU是執(zhí)行規(guī)則計算的主力芯片,如圖形渲染。經(jīng)過NVIDIA對通用GPU(GPGPU)和CUDA編程框架的推廣,GPU在數(shù)據(jù)并行的任務如圖形圖像、深度學習、矩陣運算等方面成為了主力算力引擎,并且成為了高性能計算最重要的輔助計算單元。2021年6月公布的Top500高性能計算機(超級計算機)的前10名中,有六臺(第2、3、5、6、8、9名)都部署有NVIDIA的GPU。

圖未來算力生態(tài)(相關(guān)廠商為不完全列舉,僅做為示意參考)

數(shù)據(jù)中心與超極計算機不同,后者主要面向科學計算,如大飛機研制,石油勘探、新藥物研發(fā)、氣象預報、電磁環(huán)境計算等應用,性能是主要指標,對接入帶寬要求不高;但數(shù)據(jù)中心面向云計算商業(yè)化應用,對接入帶寬,可靠性、災備、彈性擴展等要求更高,與之相適應發(fā)展起來的虛擬機、容器云、并行編程框、內(nèi)容分發(fā)網(wǎng)等等技術(shù),都是為了更好的支撐上層商業(yè)應用如電商、支付、視頻流、網(wǎng)盤、辦公OA等。但是這些IaaS和PaaS層的服務開銷極大,Amazon曾公布AWS的系統(tǒng)開銷在30%以上。如果需要實現(xiàn)更好的QoS,在網(wǎng)絡、存儲、安全等基礎設施服務上的開銷還會更高。

這些基礎層應用類型與CPU架構(gòu)匹配程度不高導致計算效率低下。現(xiàn)有的CPU的架構(gòu)有兩個大類:多核架構(gòu)(數(shù)個或數(shù)十幾個核)和眾核架構(gòu)(數(shù)百個核以上),每種架構(gòu)支持唯一的規(guī)范通用指令集之一,如x86、ARM等。以指令集為界,軟件和硬件被劃分開來分別獨立發(fā)展,迅速的催生了軟件產(chǎn)業(yè)和微處理器產(chǎn)業(yè)的協(xié)同發(fā)展。但是,隨著軟件復雜度的上升,軟件的生產(chǎn)率(Productivity)得到更多的重視,軟件工程學科也更加關(guān)注如何高效地構(gòu)建大型軟件系統(tǒng),而非如何用更少的硬件資源獲得盡可能高的執(zhí)行性能。業(yè)界有個被戲稱的“安迪比爾定律”,其內(nèi)容是“What Andy gives, Bill takes away”,安迪(Andy)指英特爾前CEO安迪·格魯夫,比爾(Bill)指微軟前任CEO比爾·蓋茨,意為硬件提高的性能,很快被軟件消耗掉了。

正如CPU在處理圖像處理時不夠高效一樣,現(xiàn)在有大量的基礎層應用CPU處理起來也比較低效,例如網(wǎng)絡協(xié)議處理,交換路由計算,加密解密,數(shù)據(jù)壓縮等這類計算密集的任務,還有支持分布式處理的數(shù)據(jù)一致性協(xié)議如RAFT等。這些數(shù)據(jù)或者通過從網(wǎng)絡IO接入系統(tǒng),或者通過板級高速PCIe總線接入系統(tǒng),再通過共享主存經(jīng)由DMA機制將數(shù)據(jù)提供給CPU或GPU來處理。既要處理大量的上層應用,又要維持底層軟件的基礎設施,還要處理各種特殊的IO類協(xié)議,復雜的計算任務讓CPU不堪重負。

這些基礎層負載給“異構(gòu)計算”提供了一個廣闊的發(fā)展空間。將這些基礎層負載從CPU上卸載下來,短期內(nèi)可以“提質(zhì)增效”,長遠來看還為新的業(yè)務增長提供技術(shù)保障。DPU將有望成為承接這些負載的代表性芯片,與CPU和GPU優(yōu)勢互補,建立起一個更加高效的算力平臺。可以預測,用于數(shù)據(jù)中心的DPU的量將達到和數(shù)據(jù)中心服務器等量的級別,每年千萬級新增,算上存量的替代,估算五年總體的需求量將突破兩億顆,超過獨立GPU卡的需求量。每臺服務器可能沒有GPU,但必須有DPU,好比每臺服務器都必須配網(wǎng)卡一樣。

來源:專用數(shù)據(jù)處理器(DPU)技術(shù)白皮書,中國科學院計算技術(shù)研究所,鄢貴海等

-

DPU

+關(guān)注

關(guān)注

0文章

354瀏覽量

24127

發(fā)布評論請先 登錄

相關(guān)推薦

中科馭數(shù)分析DPU在云原生網(wǎng)絡與智算網(wǎng)絡中的實際應用

IaaS+on+DPU(IoD)+下一代高性能算力底座技術(shù)白皮書

中科馭數(shù):DPU是構(gòu)建高效智算中心基礎設施的必選項

中科馭數(shù)CEO鄢貴海:從計算系統(tǒng)的三個視角重新審視DPU的核心價值

中科馭數(shù)發(fā)布高性能DPU芯片K2-Pro

一文看懂DPU與CPU、GPU的關(guān)系

DPU技術(shù)賦能下一代AI算力基礎設施

明天線上見!DPU構(gòu)建高性能云算力底座——DPU技術(shù)開放日最新議程公布!

中科馭數(shù)DPU技術(shù)開放日秀“肌肉”:云原生網(wǎng)絡、RDMA、安全加速、低延時網(wǎng)絡等方案組團亮相

FPGA-Based DPU網(wǎng)卡的發(fā)展和應用

DPU技術(shù)發(fā)展及落地實戰(zhàn)

《數(shù)據(jù)處理器:DPU編程入門》DPU計算入門書籍測評

《數(shù)據(jù)處理器:DPU編程入門》讀書筆記

淺談DPU和CPU、GPU的關(guān)系

DPU 技術(shù)發(fā)展概況系列(五)DPU與CPU、GPU的關(guān)系

DPU 技術(shù)發(fā)展概況系列(五)DPU與CPU、GPU的關(guān)系

評論