如果您看不到或想象自己穿著一件衣服,就很難知道它是否適合您。有多少次你在網(wǎng)上買(mǎi)了一件東西,當(dāng)它送到你家門(mén)口時(shí)興奮地打開(kāi)盒子,沖上去試穿,然后……困惑地盯著鏡子?它可能以您意想不到的方式垂墜。或者在您身上看起來(lái)與在在線模型上看起來(lái)完全不同。

本周,google將在 Google.com 上發(fā)布一項(xiàng)新的購(gòu)物功能,旨在為人們提供更有用的在線購(gòu)物體驗(yàn)。虛擬試穿 (VTO) 在具有不同體型和尺寸的真實(shí)模特身上生成栩栩如生的服裝寫(xiě)照。這些圖像包括那些微妙但至關(guān)重要的細(xì)節(jié),例如某些東西如何懸垂、折疊、緊貼、拉伸和皺紋——所有這些都具有為 VTO 開(kāi)發(fā)的新生成 AI 模型的強(qiáng)大功能。

購(gòu)物者只需選擇一件他們感興趣的服裝,然后選擇一個(gè)款式,瞧,他們已經(jīng)看到試穿了。

“VTO 是在線購(gòu)物向前邁出的激動(dòng)人心的一步,尤其是在顯然需要更多代表性的服裝領(lǐng)域,”購(gòu)物產(chǎn)品經(jīng)理 Shyam Sunder 說(shuō)。“服裝是谷歌搜索最多的購(gòu)物類(lèi)別之一,因此對(duì)人們和品牌的幫助潛力巨大。統(tǒng)計(jì)數(shù)據(jù)顯示了一個(gè)明確的需求:42% 的在線購(gòu)物者覺(jué)得模特圖片無(wú)法代表他們,59% 的人對(duì)他們?cè)诰W(wǎng)上購(gòu)買(mǎi)的商品感到不滿意,因?yàn)樗雌饋?lái)與他們預(yù)期的不一樣。”

從一開(kāi)始,該團(tuán)隊(duì)就想為購(gòu)物者提供一系列可以解決這個(gè)問(wèn)題的模型。“當(dāng)我們?cè)?a target="_blank">網(wǎng)絡(luò)上搜索服裝時(shí),當(dāng)涉及到穿著這些衣服的模特時(shí),我們會(huì)發(fā)現(xiàn)結(jié)果差異很小,”Shyam 說(shuō)。“我記得一個(gè)例子,50 張圖片中只有四張是有色人種。所以問(wèn)題是,即使我們想在購(gòu)物中顯示不同的圖像,我們也做不到,因?yàn)榫W(wǎng)絡(luò)上沒(méi)有足夠的圖像。這是我熱切想要解決的問(wèn)題。”

因此,該團(tuán)隊(duì)創(chuàng)建了他們自己的資料庫(kù),其中包含 80 個(gè)代表多種尺寸、膚色、身高、年齡和性別的模特,以便在 Google 上購(gòu)物的人可以選擇他們最感興趣的模特,并查看衣服穿在身上的效果。

“一個(gè)關(guān)鍵問(wèn)題是如何在每個(gè)模型上自動(dòng)生成任何服裝,”購(gòu)物研究科學(xué)家 Ira Kemelmacher-Shlizerman 說(shuō)。“人們研究類(lèi)似技術(shù)已經(jīng)有一段時(shí)間了,但最終的圖像從來(lái)沒(méi)有完全達(dá)到目標(biāo)——它們存在視覺(jué)缺陷,比如錯(cuò)位的褶皺,使衣服看起來(lái)畸形和不自然。所以我們給自己設(shè)定了一個(gè)挑戰(zhàn):創(chuàng)造一種方法,可以為任何體型和體形的人合成逼真的高質(zhì)量圖像。這就是生成人工智能的用武之地。”

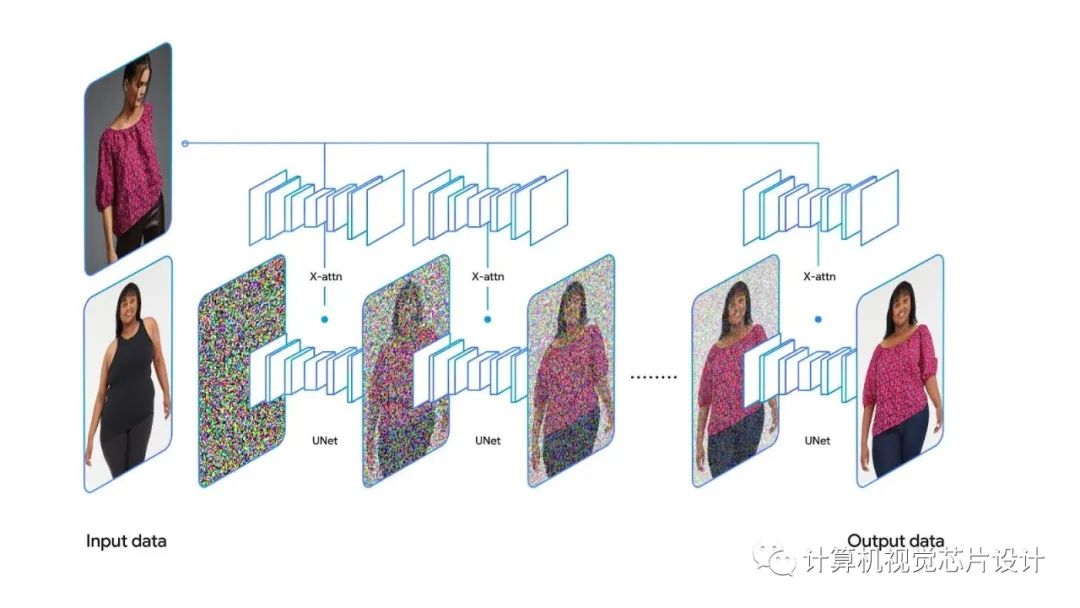

該團(tuán)隊(duì)轉(zhuǎn)向了 VTO 的文本到圖像模型,該模型能夠從文本輸入創(chuàng)建高度逼真的圖像。尤其重要的是一種稱(chēng)為擴(kuò)散的技術(shù),該技術(shù)會(huì)逐漸將噪聲添加到照片中,并訓(xùn)練神經(jīng)網(wǎng)絡(luò)去除這些噪聲像素。

對(duì)于 VTO,該團(tuán)隊(duì)沒(méi)有使用單一的擴(kuò)散網(wǎng)絡(luò)和大型語(yǔ)言模型(如在文本到圖像中使用的那樣),而是創(chuàng)建了一種稱(chēng)為并行 U-net 的新架構(gòu),它接受兩幅圖像:人物圖像和服裝圖像。每張圖片都通過(guò)自己的神經(jīng)網(wǎng)絡(luò)——U-net——同時(shí)通過(guò)稱(chēng)為“交叉注意力”的過(guò)程進(jìn)一步相互交流。“結(jié)果是驚人的,”艾拉說(shuō)。“我們的用戶研究表明,我們的方法比最先進(jìn)的方法有很大的優(yōu)勢(shì)——超過(guò) 95% 的時(shí)間。”

該團(tuán)隊(duì)使用 Google 的 Shopping Graph 對(duì)新的 AI 模型進(jìn)行嚴(yán)格訓(xùn)練,這是世界上最全面的產(chǎn)品、賣(mài)家、品牌、評(píng)論和庫(kù)存數(shù)據(jù)集。他們使用數(shù)百萬(wàn)對(duì)圖像來(lái)訓(xùn)練模型,每對(duì)圖像都包括一個(gè)穿著衣服的人以兩種不同的姿勢(shì)。人工智能模型學(xué)習(xí)將一個(gè)姿勢(shì)的襯衫形狀與另一個(gè)姿勢(shì)的人相匹配,反之亦然,直到它可以從各個(gè)角度生成該人穿著襯衫的逼真圖像。

在一個(gè)例子中,試穿結(jié)果似乎比原來(lái)的衣服顏色更亮。該團(tuán)隊(duì)對(duì)這些類(lèi)型的示例進(jìn)行了數(shù)天的審議,但最終決定在發(fā)布時(shí)謹(jǐn)慎行事,當(dāng)出現(xiàn)任何此類(lèi)錯(cuò)誤時(shí),刪除在模型上虛擬試穿服裝的選項(xiàng)。隨著他們從用戶和品牌那里得到反饋,他們將繼續(xù)做出調(diào)整。“為生成圖像發(fā)明全自動(dòng)評(píng)估仍然是一個(gè)懸而未決的問(wèn)題,我們正在積極努力,”艾拉說(shuō)。

如今,Google Shopping Graph 上數(shù)百個(gè)品牌和零售商的女裝上衣均可試穿,包括 Anthropologie、LOFT、H&M 和 Everlane。隨著時(shí)間的推移,該工具將變得更加精確并擴(kuò)展到更多品牌。到目前為止,品牌反響非常積極。

“當(dāng)我們讓他們了解這項(xiàng)技術(shù)時(shí),我們收到了一些很好的反饋,并且也非常渴望參與,”Shyam 說(shuō)。“他們中的一些人非常喜歡它,他們要求使用這項(xiàng)技術(shù)來(lái)支持他們自己的網(wǎng)站。”

-

Google

+關(guān)注

關(guān)注

5文章

1757瀏覽量

57414 -

AI

+關(guān)注

關(guān)注

87文章

30146瀏覽量

268418 -

人工智能

+關(guān)注

關(guān)注

1791文章

46859瀏覽量

237577 -

模型

+關(guān)注

關(guān)注

1文章

3172瀏覽量

48714

原文標(biāo)題:Google: 時(shí)尚與人工智能相遇

文章出處:【微信號(hào):計(jì)算機(jī)視覺(jué)芯片設(shè)計(jì),微信公眾號(hào):計(jì)算機(jī)視覺(jué)芯片設(shè)計(jì)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

Google: 時(shí)尚與人工智能相遇

Google: 時(shí)尚與人工智能相遇

評(píng)論