1、800G 時代已來,高景氣周期開啟

1.1、光模塊:由產品升級驅動的周期成長性行業

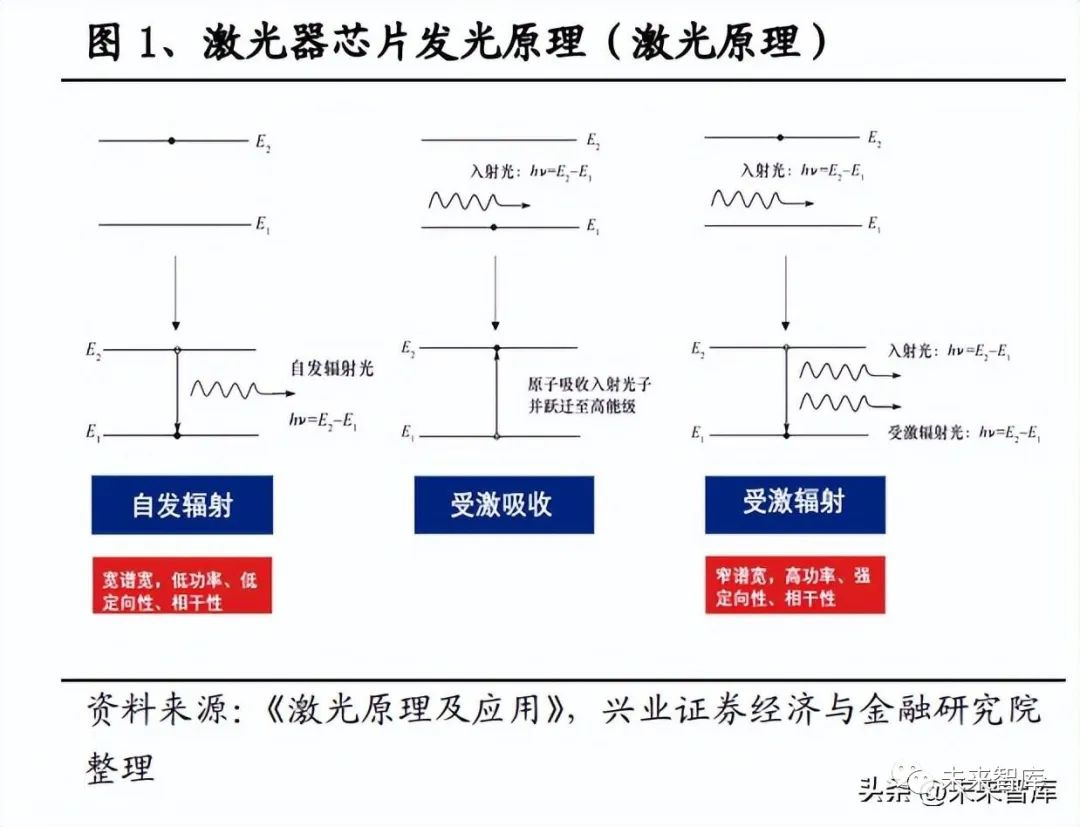

光模塊是光纖通信中的核心組成部分,實現光信號傳輸過程中光電轉換和電光轉 換功能。光模塊工作在 OSI 模型的物理層,主要由光電子器件(光發射器、光接 收器)、功能電路和光接口等部分組成,主要作用是實現光纖通信中的光電轉換和 電光轉換功能。光芯片是光模塊的核心元件,基于激光的受激輻射原理完成光電 轉換功能:處于基態(穩態)的原子在外來輻射光(由電/光泵浦源產生)作用下 先受激吸收躍遷到高能級(不穩態),再通過合適的能級系統形成粒子數反轉,躍 遷到基態,實現受激輻射,發出光子和外來光子的頻率、傳播方向、偏振、相位 等均相同,從而產生窄譜寬、高功率、強定向性的激光。

光模塊處于產業鏈中游,上游是光芯片與光器件廠商,下游主要應用于電信市場 和數通市場。目前光芯片與光器件國產化程度較低,國內產品多為無源器件、低 速率光芯片,根據 ICC 預測,2021 年我國 25G 光芯片國產化率約 20%,25G 以 上光芯片國產化率僅 5%。高速率產品多為國外頭部廠商如博通等壟斷,因此上游 光芯片成本占比較高。根據頭豹研究院數據,光器件在光模塊成本占比超過 70%, 主要來自 TOSA 與 ROSA 組件。下游主要客戶包括設備商、運營商以及互聯網云 廠商,市場份額集中,客戶議價能力較強。在上下游的擠壓下,光模塊行業競爭 較為激烈,產品量價隨產品升級周期性變動。出貨量方面,新產品導入階段出貨 量較少,升級中期出貨量開始爆發式增長,后期成熟產品的需求逐漸下降。價格 方面,產品價格以每年 17%-18%的平均幅度下降,尤其是新產品出貨量達到高水 平后,標準化 ASP 通常迎來大幅下滑,根據 Lightcounting 統計,2018 年標準化 產品的價格同比下跌 37%,打破了 2011 年創下的下跌 33%的紀錄。

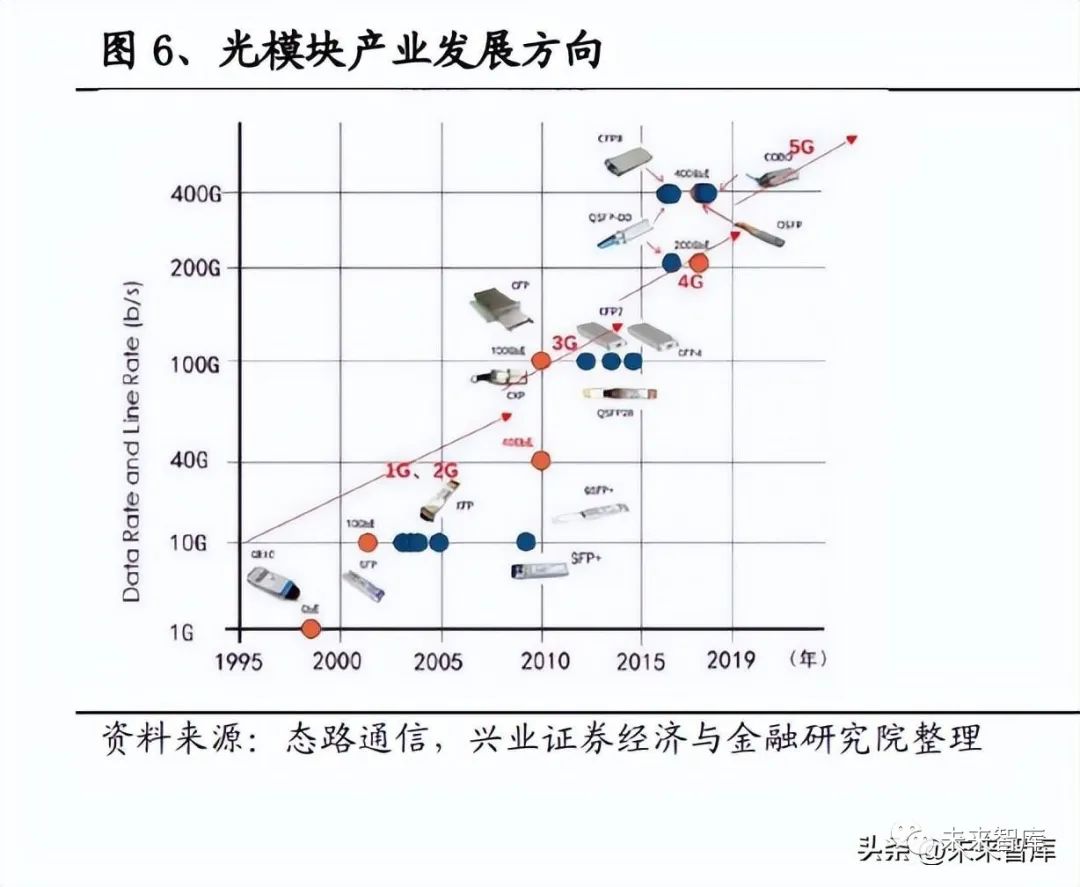

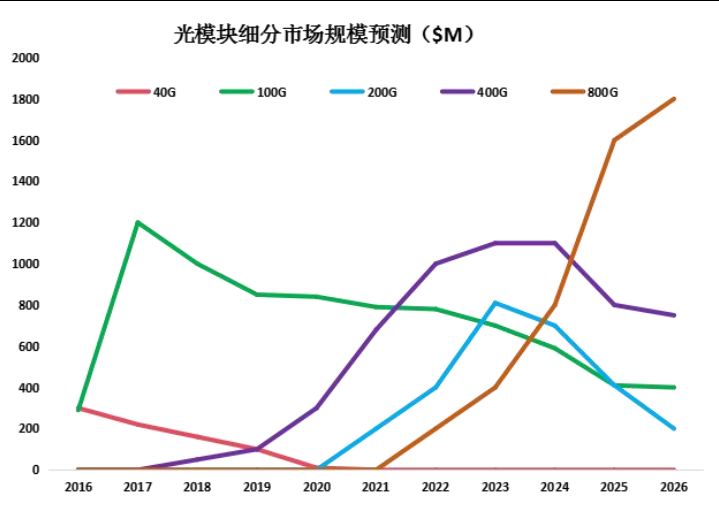

因此,我們判斷光模塊是典型的由產品升級驅動的周期成長性行業,判斷行業景 氣度的關鍵是產品升級階段。光模塊種類多、升級快,不同應用場景對傳輸距離、 帶寬等性能有不同要求,流量高速增長帶來的帶寬壓力驅動高速率光模塊率先在 數據中心部署,電信市場產品升級壓力相對較小。技術成熟周期推動數通市場光 模塊以 5 年左右的升級周期迭代:2015 年以前,數據中心光模塊以 10G、40G 為 主;2016 年,25G、100G 光模塊開始部署,2019 年開始大規模放量;2019 年光 模塊進入后 100G 時代,上層交換機光模塊速率開始向 200G/400G 升級。2022 年, 200G、400G 產品大規模放量,800G 光模塊進入導入階段。

1.2、800G 新產品周期開啟,迎來行業新一輪高景氣

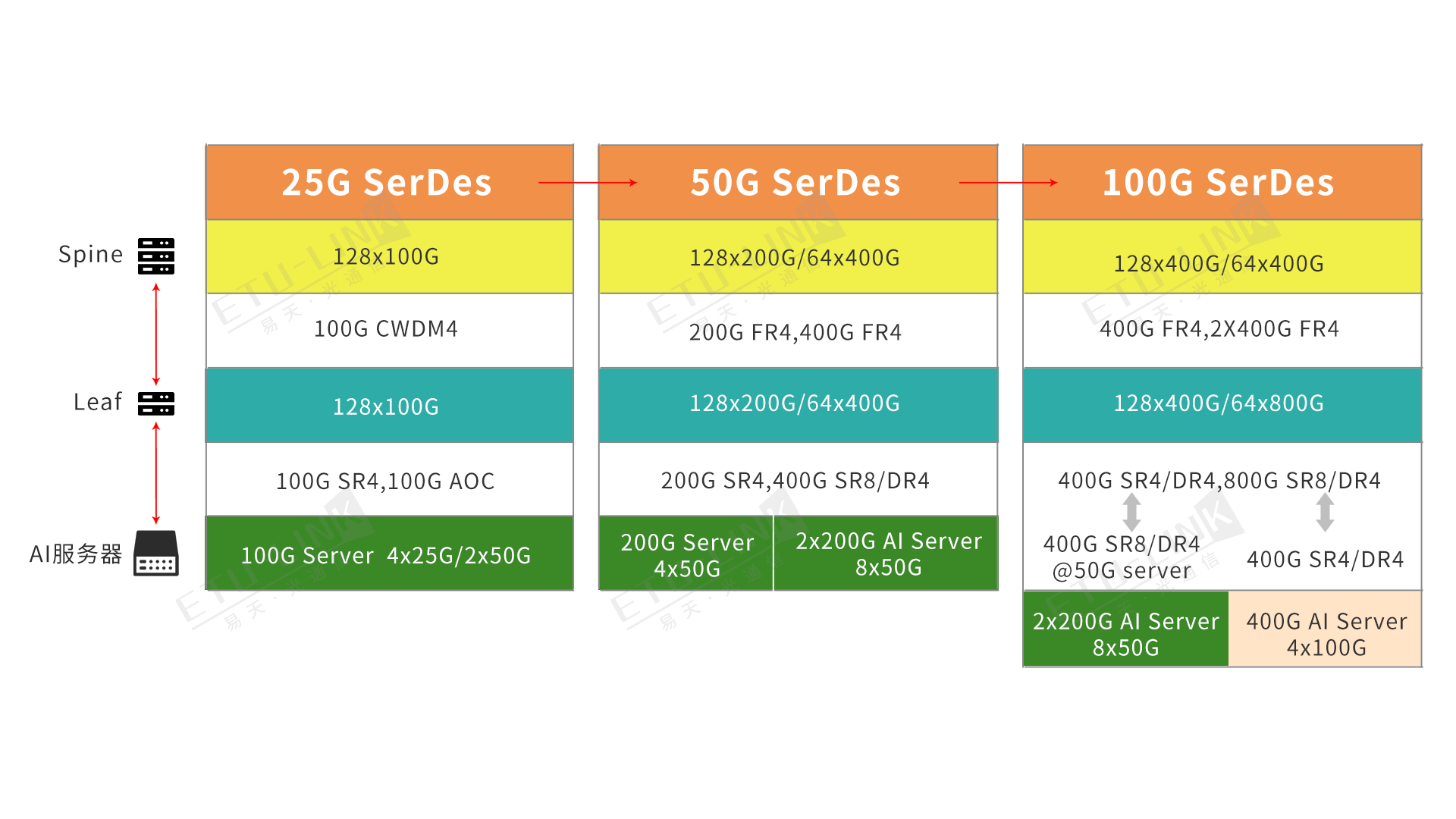

上游交換機芯片已突破:交換機芯片升級是光模塊升級的基礎條件,800G 交換機 及芯片市場技術逐漸成熟,51.2Tbps 芯片已突破,800G 光模塊升級確定性強。回顧交換機芯片及光模塊部署歷程,交換機芯片升級是光模塊升級部署的先行條 件:2014 年首款 100G 交換芯片(Tomahawk)送樣,2016 年 100G 交換機開始規模部署;2017 年 12 月首款 400G 芯片(Tomahawk3)送樣,2019 年 12 月推出 Tomahawk4(支持雙倍端口和容量),2020 年起 200G 和 400G 光模塊開始上量。目前多款 800G 交換機芯片已發布,800G 光模塊有望開始規模部署。交換機芯片 分為自研與商用兩種,自研芯片中思科的 Silicon One G100 交換機芯片支持 25.6T 交換能力,提供 32 個 800G 端口,總交換能力達 25.6T,每個端口也可以拆成 8 × 100G 或者 2×400G 應用。商用交換芯片廠商主要包括博通、Mellanox、Barefoot 和 Innovium,均可提供 25.6T 交換芯片,其中博通的 Tomahawk5 和 Mellanox 的 Spectrum-4 速率高達 51.2Tbps。從交換機來看,思科、新華三與 Mellanox 均于 2022 年發布 800G 交換機,800G 光模塊部署勢在必行。

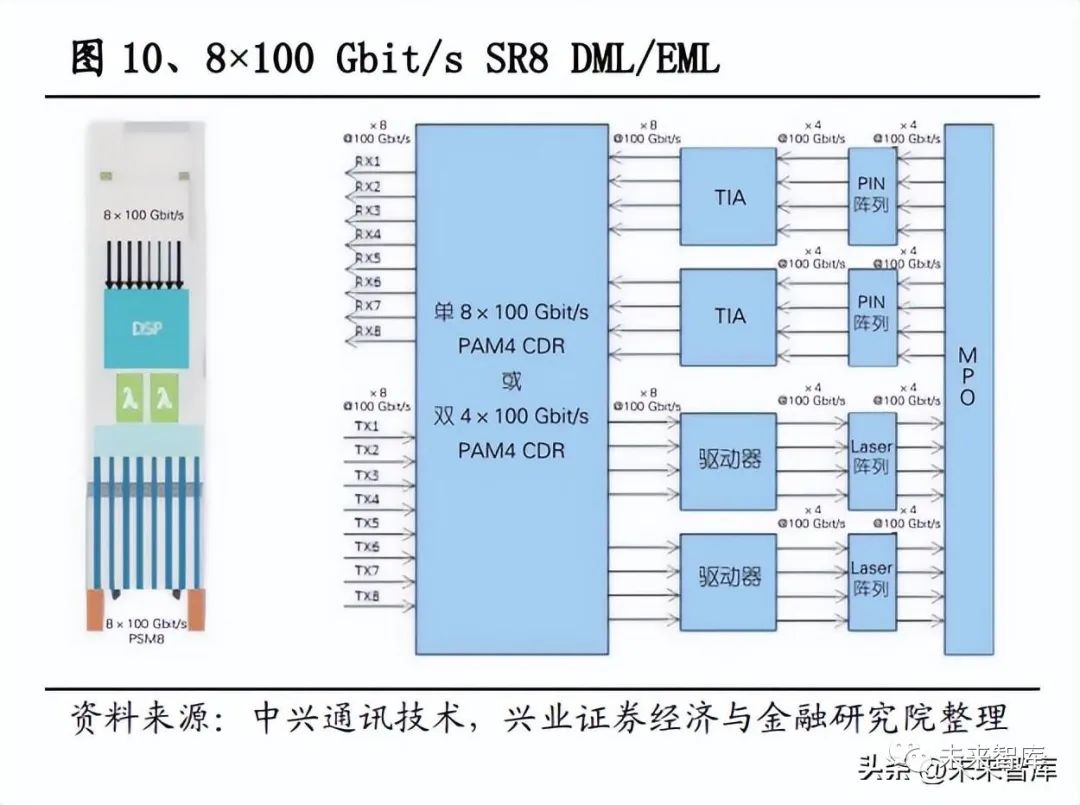

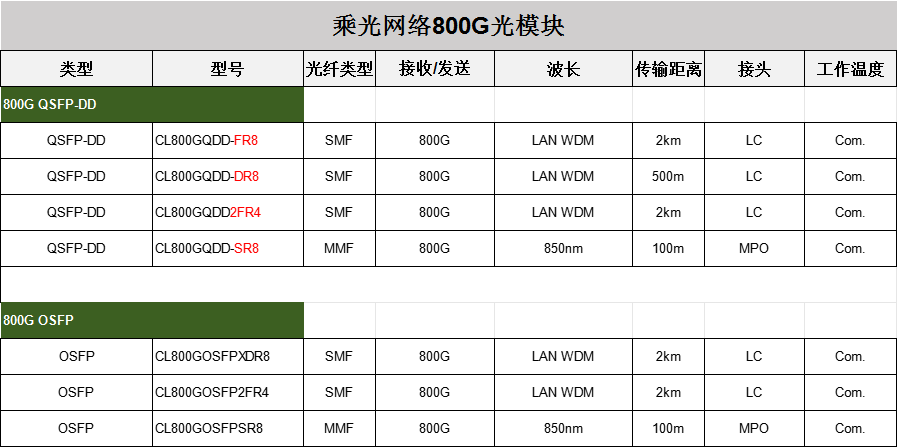

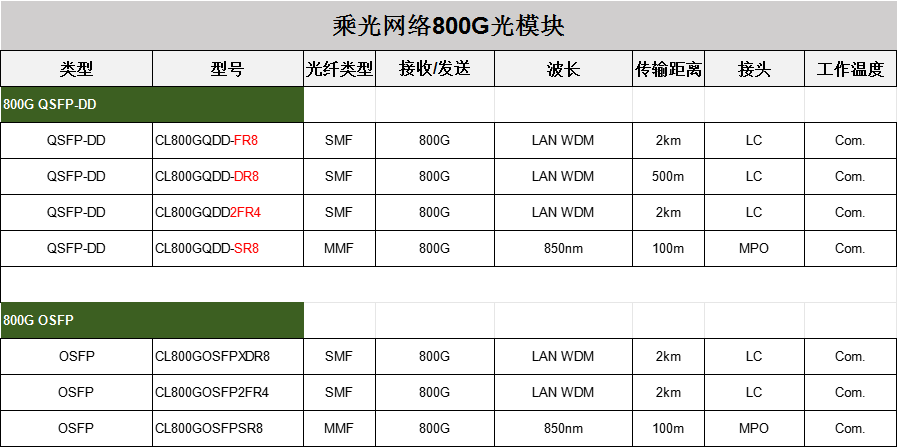

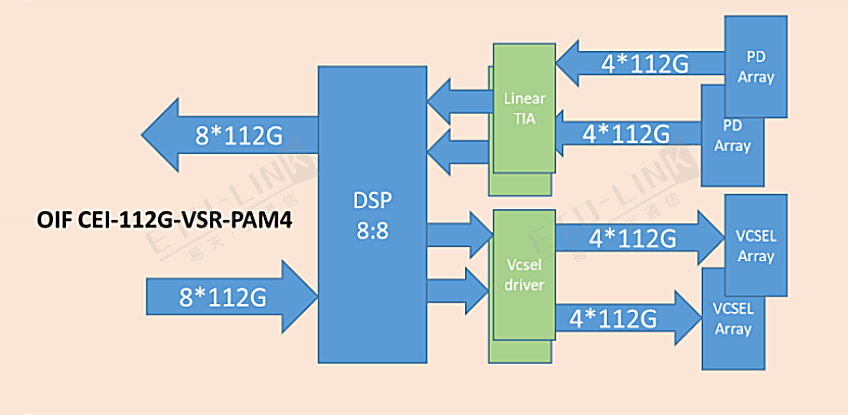

行業標準逐漸落地,主要供應商已發布樣品并具備大規模量產能力。國內外多個 標準化組織競相開展 800 Gbit/s 的標準化工作,IEEE802.3 工作組、OIF、IPEC(國 際光電委員會)等組織已對 800Gb/s 直調直檢和相干方案進行立項,啟動 800 Gbit/s 相關規范的制訂工作,對 800 Gbit/s 光模塊的應用場景、接口規格等進行了定義;800G Pluggable MSA 已先后發布面向低成本、100 m 傳輸距離需求的 8×100 Gbit/s PSM8 以及面向2 km傳輸距離需求的4×200 Gbit/s FR4規范;由Cisco、Broadcom、 Juniper、Intel 等組成的光模塊 MSA 工作組制定了第一個 800G QDFP 雙重密度可 插拔光模塊的標準,定義了 800G 光模塊的尺寸 QSFP-DD800。主要供應商已具備 800G 量產能力:2020 年,華為即發布業界首個 800G 可調超高速光模塊;中際旭 創保持行業領先,推出 800G OSFP 和 QSFP-DD800 光模塊產品線,可實現 100m – 2km 的傳輸距離,2023 年批量出貨;新易盛等廠商也具備 800G 規模量產能力。

800G 新產品周期增長彈性大(升級路徑統一)、確定性強(已批量出貨)。后 100G 時代,全球云廠商光模塊 200G/400G 升級路徑顯著分化,驅動數通市場產品周期 熨平;800G 產品升級路徑統一,部署速度有望超過 400G,光模塊市場未來具有 更強的升級彈性與更大的增長空間。根據 MSA 發布的 800G 光模塊白皮書,TORServer 層采用 200G AOC 時,上層需要部署 800G 光模塊。可用性、系統成本方 面, 800G 產品同樣優于 400G,可以在 1U 的外形尺寸中使用 25.6Tbps 的芯片, 對外 32 個 800Gbps 端口,每比特成本將優于同等的 400Gbps。根據 Dell‘Oro 預 測,800G 光模塊滲透速率有望高于 400G,到 2025 年在數據中心交換機端口中將 超過 25%。AI 需求爆發加速 800G 光模塊布局,北美大客戶已開始批量采購,新 增 AI 大客戶英偉達帶來業績新驅動,800G 升級確定性強;且行業競爭格局穩定, 頭部廠商繼續引領行業發展,光模塊龍頭中際旭創已率先拿到英偉達、谷歌等海 外客戶 800G 批量訂單,開啟量產第一年。

2、AI 算力底座,迎云需求共振

2.1、AI 浪潮催化算力需求爆發,800G 光模塊顯著受益

ChatGPT 掀起 AI 浪潮催化算力基礎設施建設,數通光模塊市場迎來新一輪行業 高景氣。2022 年 11 月 30 日,OpenAI 發布 ChatGPT,5 天內用戶突破百萬大關, 月訪問量達 2100 萬人次,截至 2023 年 1 月末,其月活用戶已經突破 1 億,遠遠 快于其他消費級應用程序。根據 Sensor Tower 的數據,TikTok 達到 1 億用戶用時 9個月,Instagram 用時30個月。World of Engineering的報告顯示,Meta(Facebook)、 Twitter、iTunes 達到 1 億用戶的時間分別為 54 個月、60 個月、78 個月。目前 AIGC 仍然以文字為主,隨著圖片、音視頻等形式的加入,將帶來流量的爆發式增長。AI 需要數字基礎設施提供算力支持進行訓練與模型優化,大模型及其應用的發展 與推廣進一步提升流量帶寬需求,雙輪驅動數通光模塊市場迎來行業高景氣。

英偉達、谷歌、微軟、亞馬遜等海外巨頭紛紛加碼 AI 建設,帶動配套高速光模塊 需求提升。隨著 ChatGPT 在全球掀起新一輪 AI 大模型浪潮,以微軟、Google、 亞馬遜為代表的科技巨頭紛紛加碼 AI 建設。①微軟:2023 年 2 月初,微軟宣布 旗下所有產品將全線整合 ChatGPT,包括 Bing 搜索引擎、Office 全家桶、Azure 云服務、Teams聊天程序等,并于3月16日發布AI辦公助手Microsoft 365 Copilot, 搭載了目前功能最強大的 AI 大模型 GPT-4 的 AI 助手將接入微軟全家桶產品。② 谷歌:由谷歌和柏林工業大學共同打造的多模態大模型 PaLM-E 目前擁有 5620 億 參數,是全球最大的視覺語言模型;谷歌旗下兩大頂級 AI 團隊谷歌大腦與 DeepMind 合二為一設立 Google DeepMind,專攻 AI 相關的戰略級技術。③亞馬 遜:推出 Bedrock 生成式人工智能服務以及自有大型語言模型泰坦。④英偉達:AI 計算領域的領導者,A100 芯片仍然是唯一能夠在云端實際執行任務的 GPU 芯 片;H100 已經全面投產,并部署在多家客戶的云計算服務中,包括微軟 Azure、 谷歌、甲骨文等客戶的數據中心,H100 配有 Transformer 引擎,可以專門用作處 理類似 ChatGPT 的 AI 大模型,由其構建的服務器效率是 A100 的十倍。

產業鏈上下游公司上調收入指引彰顯信心,800G 景氣周期再印證。由于大型云計 算公司采用 ChatGPT 等 AI 需要相關網絡基礎設備,博通預計將受益于 AI 聊天機 器人熱潮,公司用于 AI 應用的以太網設備銷售額有望從去年的 2 億美元上升到 今年的超過 8 億美元,并預測這一趨勢將繼續加速。Marvell 公布 2024 財年 Q1 財 報,一季度凈營收 13.2 億美元,高于此前市場預期的 13.0 億元;預計二季度凈營 收 13.30 億美元(±5%),再超市場預期,其中 AI 成為公司關鍵增長動力,2024 財年 AI 收入預計翻番,并認為未來幾年 AI 產業仍將帶動公司繼續快速增長。英 偉達發布 2024 財年 Q2 財務指引,營收預期達 110 億美元,較市場預期(71.8 億 美元)增加 53%,主要系生成式 AI 大語言模型驅動數據中心業務相關產品需求 激增,公司“顯著”增加相關產品供應并為下半年進行大量采購,數據中心需求 可見度較高,預計下半年業績維持高速增長。光模塊上下游公司持續高增長,再 次強化印證 AI 推動下的 800G 高景氣周期。

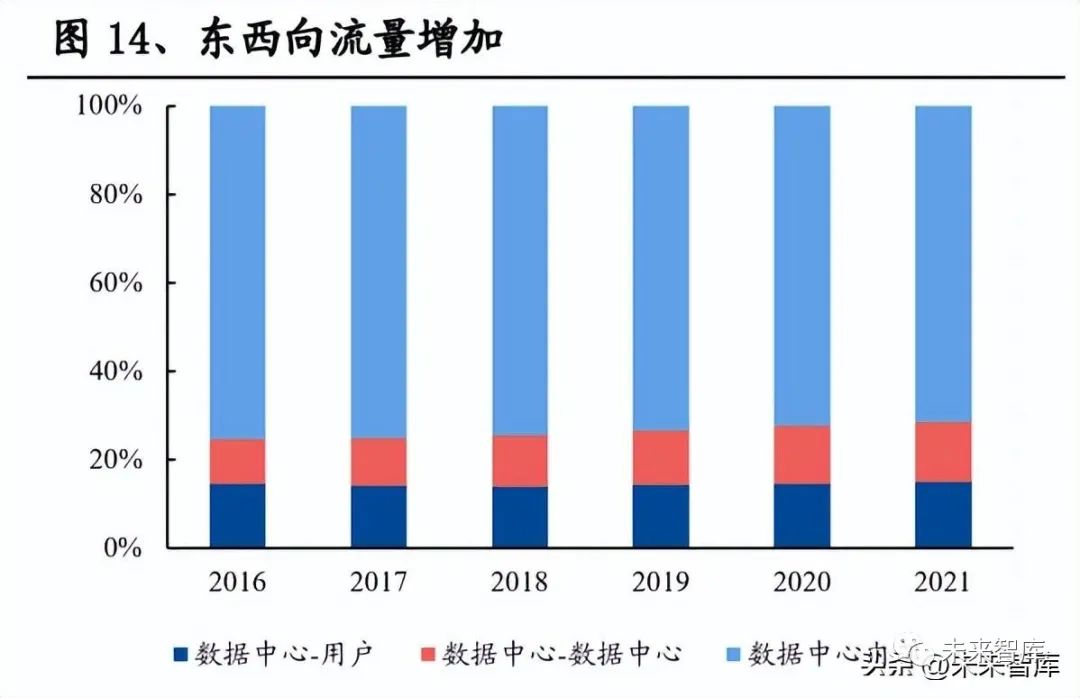

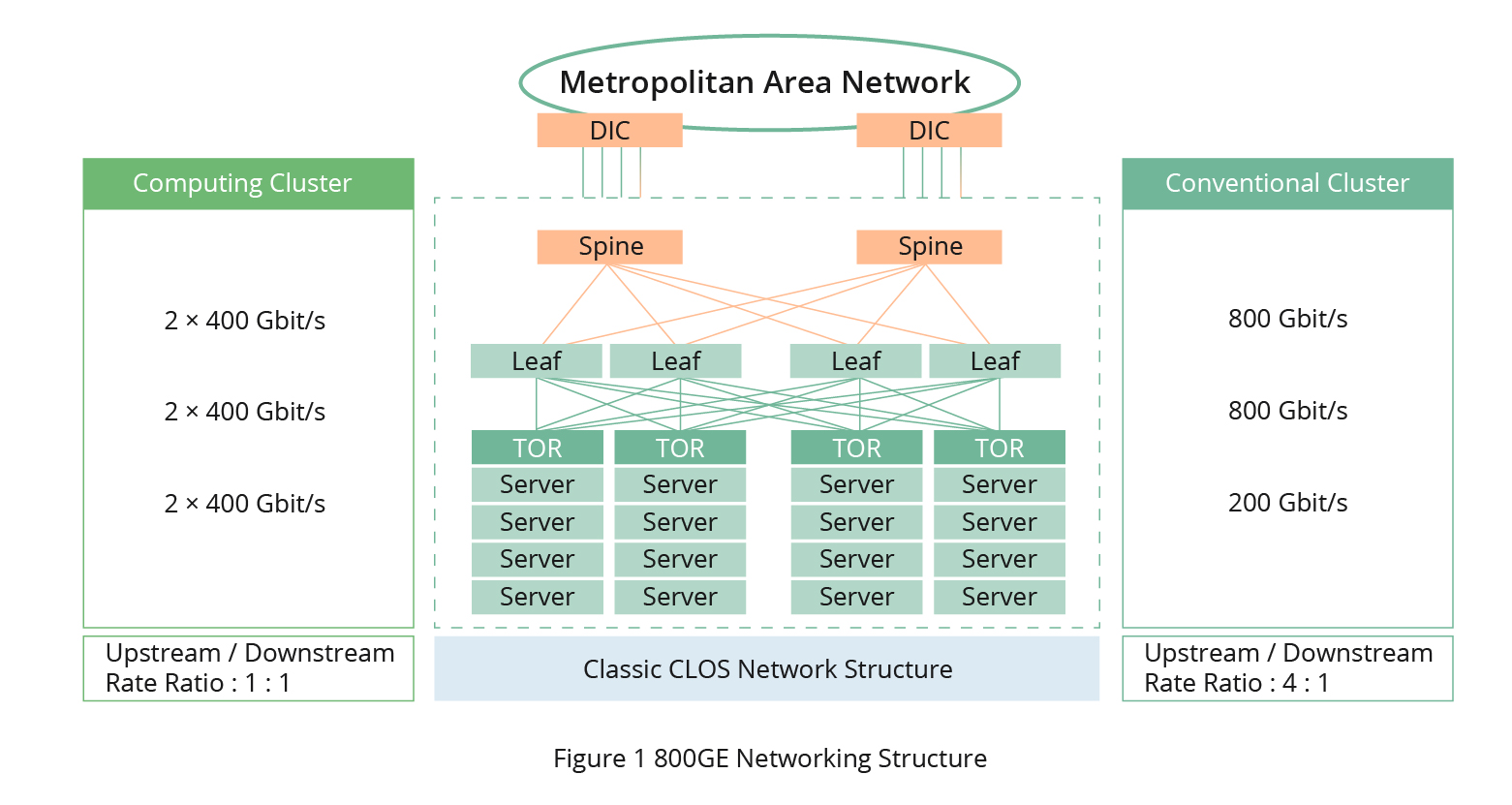

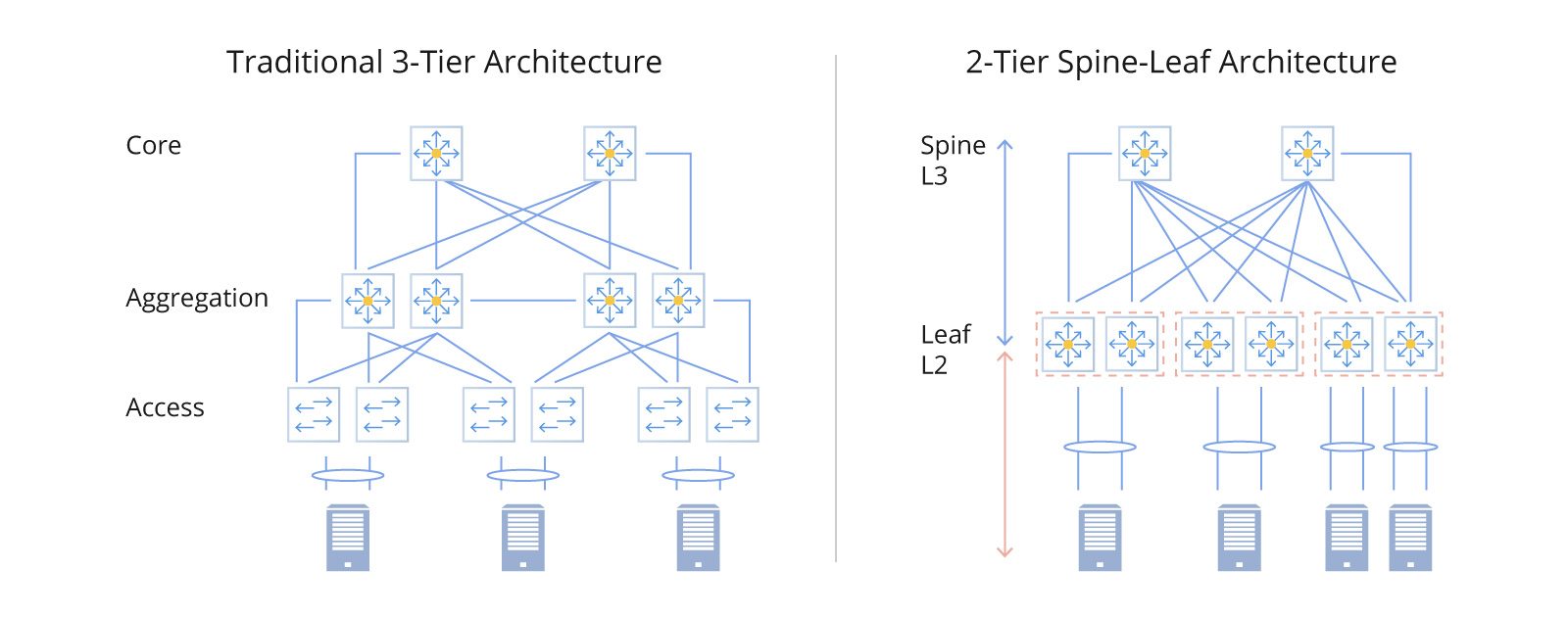

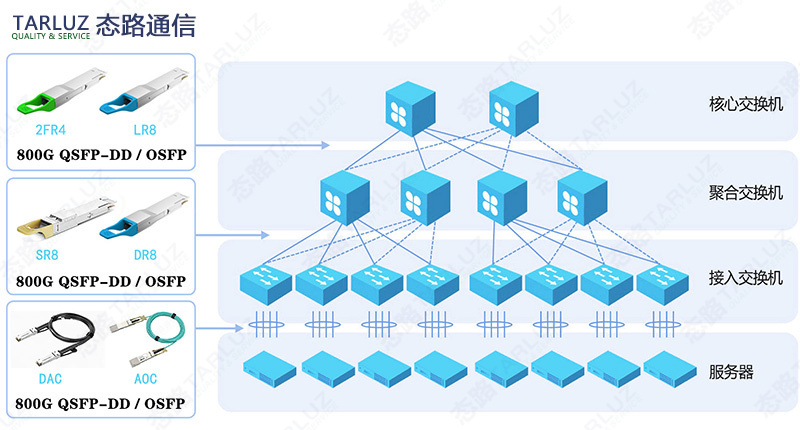

東西向流量增長驅動網絡架構向葉脊結構升級,大幅提升光模塊需求量及傳輸速 率。根據思科公司預測,2021 年東西向流量將占 85%,其中數據中心內部的流量 占 71.5%,數據中心之間的流量占 13.6%。葉脊架構以更低成本支持大規模網絡部 署,在數據中心中得到廣泛應用。從光模塊需求量來看,傳統數據中心架構所需光模塊對機柜數倍數僅 8.8 倍,葉脊架構下該倍數增長至 44/48 倍,光模塊配置需 求爆發式增長。從光模塊速率來看,扁平化的結構利于數據中心增加機柜和服務 器數量,大型化、復雜化的發展趨勢催化交換機和光模塊提升傳輸速率滿足內部 海量流量的互通。

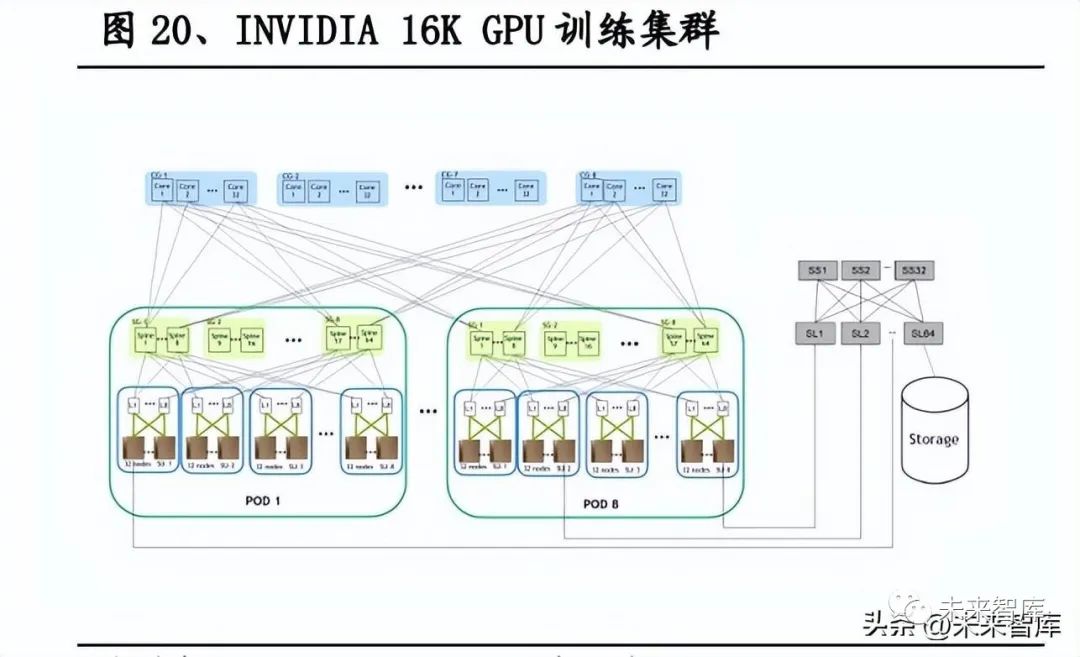

AI 高性能計算帶來算力缺口,高速率、低延時的要求推動胖樹(Fat-tree)架構 在數據中心網絡中部署,800G 光模塊作為高性能計算網絡核心部件,率先引領算 力需求爆發。AI 服務器普遍采用 CPU+GPU 的形式, GPU 的單卡核心數能達到 近千個,如配置 16 顆 NVIDIA Tesla V100 Tensor Core 32GB GPUs 的核心數可過 10240 個,計算性能高達每秒 2 千萬億次,因此對底層數據的傳輸速率和時延有較高要求。胖樹架構上下行端口一致,每個節點上行帶寬與下行帶寬相等, 帶寬 收斂比為 1:1,從而有效降低數據傳輸時延并提高計算穩定性,在超算中心大規模 部署,驅動光模塊向更高速率升級。

以英偉達 16K GPU 訓練集群為例,測算單個模型對 800G 光模塊需求彈性:服務 器到 TOR 層分 200G(A100)和 400G(H100)AOC/DAC 兩種情況,葉交換機下 行和上行均為 800G 光模塊,脊交換機下行和上行均為 800G 光模塊;且 AI 服務 器整體算力負荷高于傳統數據中心,帶寬需求高,我們以收斂比 1:1 進行測算。根據我們的詳細測算,800G 光模塊:A100 GPU 約為 1.25:1,800G 光模塊:H100 GPU 約為 2.5:1。基于下游應用角度,谷歌搜索一天訪問次數 35 億次,考 慮谷歌訪問量分布,假設 35%集中在歐洲地區晚上 8-9 點,峰值訪問量為每秒 340278 次訪問量,平均找 1000 字/次,需要約 17 萬臺服務器。假設全球范圍內有 2 個谷歌測算體量相當的大模型,使用 A100 芯片的系統對應光模塊(含 DAC) 用量約 613 萬個,傳輸距離為 500m 的 DR8 光模塊和 2km 的 FR8 光模塊(用于Leaf-Spine)用量為 340 萬;使用 H100 芯片的系統對應光模塊(含 DAC)用量約 953 萬個,傳輸距離為 500m 的 DR8 光模塊和 2km 的 FR8 光模塊(用于 LeafSpine)用量為 681 萬。伴隨視頻類交互模式出現,AI 服務器需求量較文字類交互 大幅提升,驅動配套高速光模塊需求爆發增長,800G 光模塊產業鏈企業有望顯著 受益。

2.2、北美云需求與 AI 共振,驅動數通需求高增長

從資本開支來看,北美云需求仍處于下滑期,但 800G 升級疊加 AI 算力投入帶動 云計算基礎設施產業鏈景氣度持續提升。2022Q4,海外三大云廠商、Meta 資本開 支合計 396.84 億美元,同比增長 15.83%,環比增長 4.11%,維持增長態勢但增速 有所放緩。2023 年,宏觀經濟壓力疊加前期云計算投入的提前釋放,北美云廠商 資本開支短期承壓,AI 算力缺口為云計算注入新動力,全年資本開支存在超預期 可能:Meta 全年資本開支指引下調至 300-330 億美元;谷歌預計全年資本開支和 2022 年相比略有增長;微軟預計加大支出力度,加強云數據中心建設,以滿足客 戶對新型人工智能工具的需求;亞馬遜大力投資大型語言模型和生成式人工智能, 預計將長期投資從建設新倉庫和配送中心,轉向將更多資金投入云計算業務的基 礎設施。整體看來,光模塊增速短期內承壓,隨著 800G 產品逐漸上量,有望開啟 新一輪景氣周期。

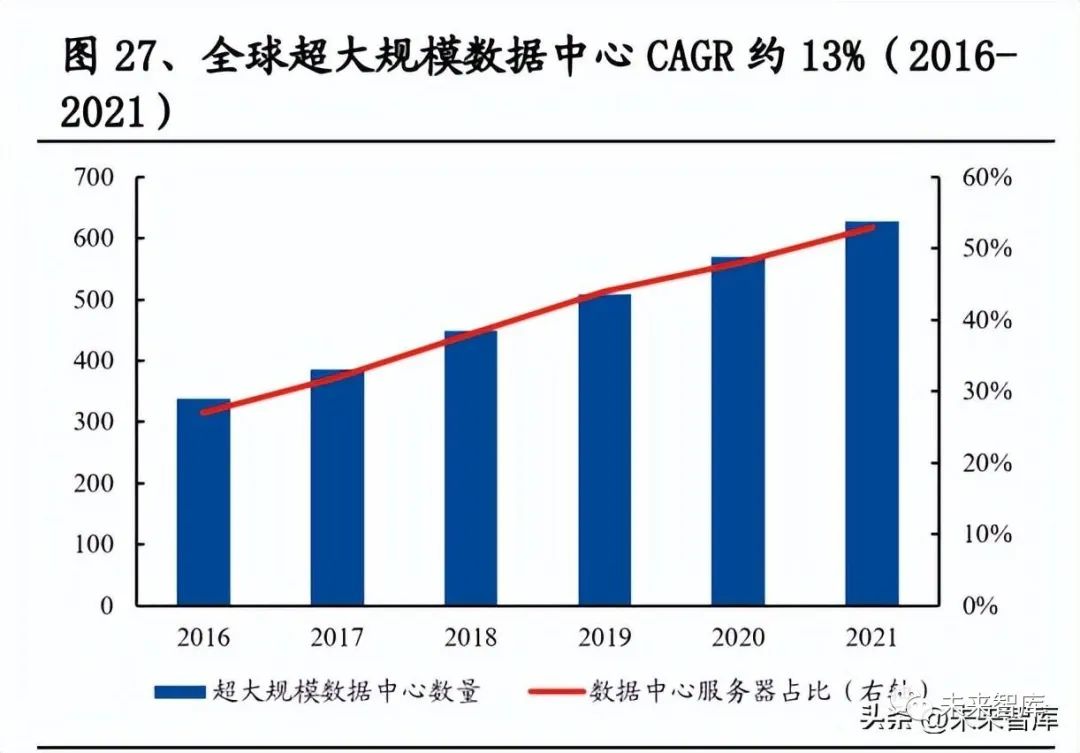

云需求與 AI 共振,算力底層基礎設施持續受益。根據 800G Pluggable MSA 組織 發布的 800G 光模塊白皮書,2017 年-2021 年,全球互聯網帶寬容量以 48%的年 復合增長率增長。思科的全球云指數預測,全球數據中心到 2021 年達到 628 個, 其中亞太地區占比最高,從 2016 年的 30%升至 39%,北美地區從 2016 年的 48% 降至 35%,位居第二。云計算是流量增長的主要驅動力,2016-2021 年,全球數據 中心 IP 流量 CAGR 為 25%,云數據中心流量 CAGR 為 27%,增速高于整體增速。

3、LPO vs CPO:更低功耗

AI 高算力背景催生低功耗、低延時光模塊需求,LPO(Linear-drive Pluggable Optics)與 CPO(Co-packaged Optics)是目前主要探討的降低功耗方案。Meta 認 為,數據中心網絡流量高速增長,尤其是數據中心內部流量顯著的增加,導致網 絡耗能占比不斷提升,并提出隨著帶寬需求擴大單帶寬耗能不斷下降的要求;微 軟數據顯示,服務器帶寬增至 800G 時數據傳輸功耗占比可達 20%。AI 高性能計 算對數據中心光模塊速率和數量提出更高要求,催化網絡功耗高速增長,“功耗墻” 挑戰凸顯,保證性能的同時降低功耗成為光模塊技術發展的重點,LPO 和 CPO 作 為降低光模塊功耗的兩種主流技術路徑受到廣泛關注。

3.1、LPO:深度契合 AI 短距互聯訴求,延續傳統可插拔光模塊優勢

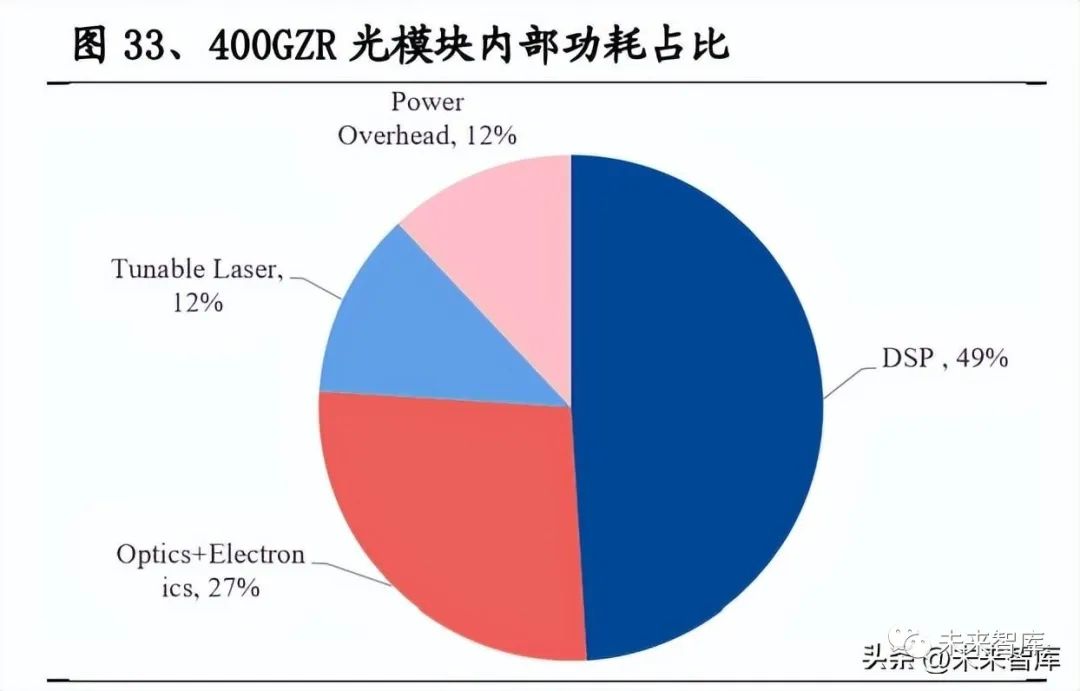

LPO 深度契合 AI 短距互聯低功耗、低延時需求,且技術更新迭代相對較小,有 望成為 800G 時代重要補充方案。傳統光模塊通過 DSP 芯片對高速信號進行信號 處理達到低誤碼率,但功耗較大,以 400G 光模塊為例,用到的 7nm DSP 功耗約 為 4W,占整個模塊功耗的 50%。LPO 將 DSP 功能集成到交換芯片中, 只留下 driver 和 TIA,并分別集成 CTLE 和 Equalization 功能,用于對高速信號進行一定 程度的補償。相較 DSP 方案,LPO 可大幅度減少系統功耗和時延,保證一定傳輸 性能的同時降低成本,并保持可插拔特性便于后續維護。

① 低功耗:Arista 針對不同光學方案進行功耗對比,采用 Linear-drive 方案后, 硅光、VCSEL、TFLN 薄膜鈮酸鋰光模塊的功耗均下降 50%左右。2023 OFC 上 MACOM 展示單通道 100G 的單模 800G DR8、多模 800G SR8 線性直驅方案,在功耗方面多模省 70%,單模省 50%;Arista 展出 800G-DR8 線性直驅方案,較 5nm DSP 方案可節省 30%功耗至 7W。②低延時:不采用 DSP 進行信號復原后系統時 延大幅降低,根據 MACOM 的方案可降低 75%。③低成本:DSP 芯片價格在光模 塊成本中占比較大,LPO 采用更復雜 Driver 和 TIA 芯片增加的成本低于 DSP 成 本,光模塊整體成本下降。④可插拔:LPO 技術沿用可插拔形式,具有便于后續 維護的優勢,催化可插拔光模塊新一輪升級周期迎來行業高景氣。

頭部光模塊廠商在 LPO 產品研發方面有望步入快車道,云廠商、設備商積極布 局線性直驅方案。從上游芯片、交換機到下游終端用戶均重視 LPO 技術發展與應 用,實現商用確定性較強:在 OFC 2023 上,Macom、Broadcom 等多家廠商展示 了 Linear-drive 方案;Arista 重點展示的 Linear 方案得到博創、NVIDIA 等多家交 換機廠家的認可;頭部光模塊公司加速 LPO 方案布局,新易盛、劍橋等公司陸續 發布相關產品。

3.2、CPO:降低功耗優勢顯著,技術尚未成熟仍待改進

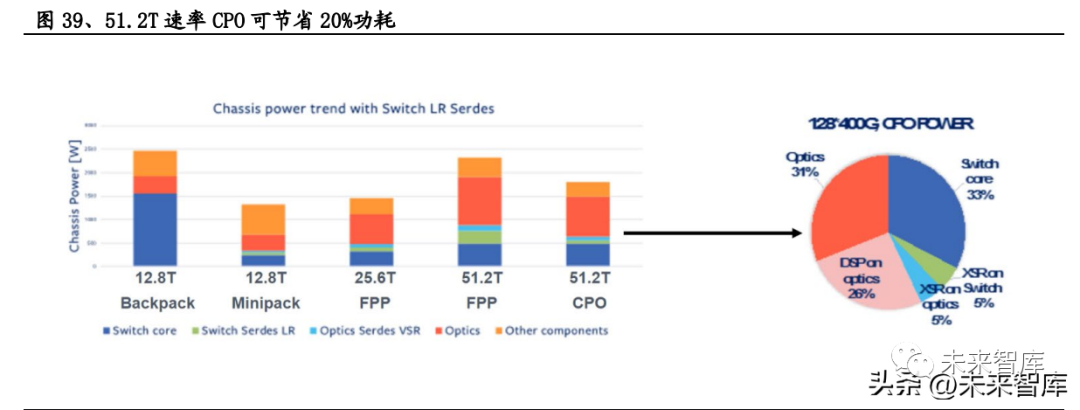

CPO 是一種全新的高速率產品形態,可有效降低系統功耗。區別于傳統可插拔光 模塊,CPO 技術將光學組件與芯片封裝在一個模塊中,將光引擎移至交換芯片附 近,降低傳輸距離、提高高速電信號傳輸質量的同時極大降低系統功耗,且集成 度高大大縮小體積,在高性能計算集群中優勢顯著,在 AI 集群和 HPC 滲透率有 望逐步提升。根據 Meta 數據,交換機芯片速率達到 51.2T 時 CPO 方案可減低 20% 功耗。

龍頭云廠商、芯片公司推進 CPO 技術不斷演進,但正式商用時間尚未明確。2020 年底,COBO 和 OIF 成立相關工作組開始制定標準;CPO 的發起者 Facebook 和 微軟在 2021 年 2 月發布其 3.2T CPO 產品需求方案;博通在 2021 年年初發布將 ASIC 電芯片和光器件合封的產品;2021 OFC, Intel 與 Ayar Labs 合作實現 8Tbps 的共封裝 FPGA,II-VI 展示了 3.2T 速率的 ROSA;2023 OFC,博通的最新交換機 產品 Tomahawk StrataXGS 5 中的 Tomahawk 5 采用光電共封技術,該交換機僅需 5.5W 的功率為 800Gbps 的流量供電;思科也演示了 CPO 技術實現的可行性具體 步驟,預計試驗部署與 51.2Tb 交換機周期同時進行,在 101.2Tb 交換機周期內更 大規模地采用;國內光模塊廠商也在 CPO 領域布局,但正式商用時間尚未明確。

CPO 技術路徑仍待成熟且需求尚未迫切,傳統可插拔方案憑借頑強生命力有望繼 續主導。①可維護性:CPO 技術非可插拔,后續可維護性較差;LPO 延續可插拔 技術方案優勢。②可靠性:因交換機尺寸受限,CPO 時代光引擎基于芯片級的硅光集成,即使是過渡方案 NPO 技術同樣基于硅光,但目前沒有硅光集成的樣機, 硅光長距傳輸問題仍未解決;交換芯片散熱影響激光器性能,光源模組外置方案 或成為主流。LPO 因去除 DSP 芯片影響信號恢復性能,但在 AI 短距互聯應用場 景下得以彌補。③商業模式挑戰:CPO 對硅光技術儲備有較高要求,且由于工藝 無法分離大概率由交換機芯片廠商主導,產業鏈變動或影響 CPO 技術應用進程推 進。LPO 依賴交換機芯片性能,但對產業格局影響較低。④緊迫性:3.2T 光模塊 時代對 CPO 產品形態訴求相對較高,1.6T 時代可插拔光模塊已有較為成熟的 8*200G 主流方案滿足行業需求。⑤確定性:2023 OFC 中際旭創、新易盛、光迅 科技等光模塊頭部廠商都已推出 1.6T 光模塊,量產時間較為確定,預計在 800G、 1.6T 時代傳統可插拔光模塊方案仍為主流,CPO 技術仍待成熟。

4、龍頭地位穩固,800G 全產業鏈受益

4.1、800G 競爭格局穩定,AI 催化全產業鏈受益

光模塊行業強者恒強,市場份額向頭部集中,國內廠商逐漸崛起。100G 時代,中 短距離應用場景(10km 以下),以中際旭創、AOI、Intel 等龍頭廠商占據主要市 場份額,長距離應用場景(10km 以上)市場中,Oclaro、Lumentum、Source,超 長距離(40km 以上)相干光模塊市場中,Acacia、Oclaro、Lumentum、華為海思 等廠商占據主要市場份額。從 2018 年開始,大部分日本和美國供應商退出市場, 以旭創為首的中國供應商排名逐漸提高。根據 LightCounting 公布的 2022 年全球 光模塊 TOP10 榜單,中國光模塊廠商共 7 家入圍,中際旭創和 Coherent(并購 Finisar)排名并列第 1,華為、光迅科技、海信寬帶、新易盛、華工正源、索爾思 光電分別位居第 4、第 5、第 6、第 7、第 8 和第 10 名。

800G 時代,可插拔仍是主導方案,技術更迭小,考慮北美大客戶高驗證壁壘,以 中際旭創為代表的行業龍頭廠商憑借諸多優勢有望維持競爭格局平穩,受益彈性 和確定性強:①技術升級迭代速度快:高帶寬壓力驅動產品以 4-5 年為周期升級, 光模塊廠商需要持續進行研發投入保證技術升級;②產品線擴充能力強:光模塊 種類繁多,單個細分產品市場空間有限,只有擴充產線才能突破增長瓶頸,然而 單個產品升級快導致光模塊廠商難以在全部細分市場占據主導地位,一定程度上 抑制市場集中度提升;③成本控制能力強:產品線的不斷擴充及產品技術迭代升 級需要較多研發投入,同時產品生命周期短,良率提升空間小,成本與費用相對 高企,成本控制能力保障公司盈利能力。④交付能力要求高:光模塊下游行業市 場集中度高,頭部企業議價能力強,行業內部競爭激烈,需要通過規模優勢、可 靠的交付能力建立相對穩定的上下游合作關系。800G 升級疊加 AI 帶來長期想象 空間,光模塊、光器件、光芯片、陶瓷外殼等 800G 產業鏈均有望顯著受益。

4.2、重點公司分析

400G 時代,光模塊產品升級周期性得到驗證,產品升級初期是投資最好階段。光 模塊升級初期,老產品增速下降,新產品尚未放量,不足以拉動整個行業的高增 長,行業進入青黃不接的階段,板塊估值和業績預期都較低,隨著新產品升級帶 來新一輪景氣周期預期來臨,板塊估值有望迎來巨大提升;產品升級中期,業績 逐漸兌現,新產品放量帶動行業爆發式增長,仍有一定上漲空間;產品升級周期 尾聲,行業進入景氣下行階段。以光模塊龍頭中際旭創為例,2019 年,400G 光模 塊開始進入升級初期,公司營收同比下降 7.73%,歸母凈利潤下降 17.59%,但市 場對 400G 新一輪升級周期的樂觀預期驅動股價有較大漲幅,光模塊板塊估值也 有大幅提升,Wind 光模塊指數 19 年上漲約 70%。

中際旭創

800G 多次加單提升行業景氣度,公司持續高份額引數通市場。公司率先拿到英偉 達、谷歌等海外客戶 800G 批量訂單,有望高份額出貨,開啟規模量產第一年;預 計明年英偉達和谷歌進一步加大需求,亞馬遜、Meta、微軟等廠商通過驗證進入 量產,公司迎來業績拐點;泰國工廠擴建夯實 800G 放量基礎,未來有望繼續引領 市場,業績拐點有望逐漸出現。AI 加大 800G 新產品需求彈性,公司前瞻布局前沿技術。光模塊數量與 GPU 成 正相關,伴隨視頻類交互模式出現,驅動配套高速光模塊需求爆發增長。在 AI 算 力中心低功耗訴求迫切背景下,LPO 線性直驅技術降低功耗與延時性能優勢突出, 公司目前已有 LPO 相關技術儲備,隨著低功耗 LPO 方案的推廣,公司有望步入 快車道。公司發布 1.6T OSFP-XD DR8+可插拔光通信模塊,提前布局 1.6T 時代。

中瓷電子

光模塊陶瓷外殼“一枝獨秀”,800G 突破頭部光模塊廠商。光模塊陶瓷外殼&底 座成本占比近 15%,僅次于光電芯片,公司高速光模塊陶瓷外殼在國內“一枝獨 秀”:400G 光模塊用陶瓷外殼已經實現批量出貨;800G 產品技術水平已與海外相 當,作為國內重要供應商,正逐步量產,客戶主要包括新易盛等國內外頭部 800G 光模塊公司,未來有望受益 AI 浪潮,加速放量。

天孚通信

800G 疊加 AI 升級周期驅動數通市場持續高景氣,公司高速光引擎項目加速放量 打造新增長極。需求方面,數通市場持續高增長驅動公司各系列無源器件需求顯 著受益,公司發布 800G 光模塊配套應用的光引擎產品和解決方案,作為高速光 引擎龍頭企業高速光引擎配套需求以及市場份額有望持續提升,搶占 800G 新周 期市場先機。隨著 AI 持續的發展,無源器件和光引擎 400G、800G 產品份額有望 持續提升。在新一輪行業高景氣背景之下,公司募投項目擴產計劃預計 2023 年開 始加快建設進程,加速海外泰國工廠選址建設,積極進行產能全球化布局,持續 擴張產能并建立產能動態調整機制以應對高漲的需求。

新易盛

公司 800G 有望逐步量產并實現大客戶突破,深度受益于新一輪升級周期。憑借 在 400G 的技術積累和產業鏈上下游的深度耕耘,公司順利突破北美大客戶,實 現 400G DR4 批量供應。公司不斷豐富高端產品線,推出多款 800G 光模塊;收購 完成參股公司 Alpine 的剩余股權,加碼硅光和相干產品技術,順利推出多款基于 自研硅光芯片的高端光模塊產品,加快全球化產業布局;推出采用單波 200bps 技 術的 1.6Tbps 光模塊,為下一次產品升級提前布局。產能方面,公司募投項目新 產線的建成夯實放量基礎。

AI 算力帶動行業需求爆發下,持續加強 LPO 等關鍵低功耗技術儲備。AI 模型網 絡架構變革催生光模塊需求,800G 光模塊 LPO 線性直驅技術低功耗優勢深度契 合 AI 訴求,公司于今年 OFC 展會期間推出多款 LPO 相關產品并與主流廠商與用 戶建立了良好合作關系;與此同時推出了基于薄膜鈮酸鋰調制器的業界最節能的 800G 光模塊,持續加強未來高新技術領域儲備,有望開辟成長“新天地”。

兆龍互連

200/400/800G DAC 稀缺供應商,AI 驅動 DAC 業務迎高增長。DAC 銅纜連接方 案憑借可靠性、低能耗、低時延等優勢成為數據中心短距互聯(一般在 5m 以內) 的主要方案,主導北美云數據中心短距互聯,并適配 AI 超算數據中心需求。AI 產 業發展推動 GPU 需求量激增,DAC 需求量與 GPU 數量強相關,對應市場規模有 望顯著增長。公司目前已能夠規模化生產應用于傳輸速率達到 400G 的 DAC 高速 傳輸組件及配套的高速傳輸電纜,同時積極布局 800G 傳輸速率的高速電纜組件, 能滿足大型乃至超級數據中心、高速通信領域的數據傳輸需求。作為國內稀缺的 優質 DAC 供應商,公司構建了強大的產品資質壁壘,高速電纜及組件產品已批量 導入國內頭部互聯網企業,突破海外市場,間接供貨北美云廠商。PCIe Cable 迎“量價齊升”,服務器內部互連業務迎增長新機遇。公司 PCIe Cable 產品配套 CPU/GPU 與顯卡、內存等設備高速連接,受益 AI 服務器規格提升,產 品迎“量價齊升”機遇,有望逐漸量產,貢獻增量。

鼎通科技

公司深度綁定全球巨頭客戶,是 800G 升級&AI 算力核心受益標的。公司提供高 速背板連接器組件和 I/O 連接器組件,主要用于數據中心、通信基站等大型數據 存儲和交換設備。憑借優異的模具設計和精密加工制造能力,公司深度綁定安費 諾、莫仕和中航光電等全球知名連接器巨頭客戶,并于 2022 年成功進入泰科通訊 業務模塊,開展 CAGE 及結構件業務合作。目前,公司和客戶著力開發 QSFP 112G 和 QSFP-D 等系列產品,未來核心受益 800G 光模塊的升級。

-

芯片

+關注

關注

453文章

50417瀏覽量

421852 -

模塊

+關注

關注

7文章

2671瀏覽量

47342 -

AI

+關注

關注

87文章

30155瀏覽量

268426 -

光模塊

+關注

關注

76文章

1240瀏覽量

58887

原文標題:通信行業專題報告:800G光模塊,AI算力底座

文章出處:【微信號:CloudBrain-TT,微信公眾號:云腦智庫】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

通信行業專題報告:800G光模塊,AI算力底座

通信行業專題報告:800G光模塊,AI算力底座

評論