導(dǎo)語:

你是否想了解分布外檢測(OOD detection)的最前沿方法及其表現(xiàn)卻迷失在在數(shù)量繁多的論文中?你是否想自己解決OOD檢測問題卻苦于沒有一個統(tǒng)一的代碼庫/測試平臺來開發(fā)和測試性能?OpenOOD 1.5版本將解決如上困惑!

一、導(dǎo)讀

對于訓(xùn)練好的圖像分類器,能讓其可靠地在開放世界中工作的一個關(guān)鍵能力便是檢測未知的、分布外的(out-of-distribution, OOD)樣本。例如我們利用一組貓狗照片訓(xùn)練出了一個貓狗分類器。對于分布內(nèi)的(in-distribution, ID)樣本,也就是這里的貓、狗圖片,我們自然期待分類器能夠準(zhǔn)確地將它們識別到相應(yīng)的類別中去。而對于分布外的OOD樣本,也就是除了貓狗之外的任何圖片(例如飛機、水果等等),我們希望模型能夠檢測出它們是未知的、新穎的物體/概念,因而無法將它們判別到分布內(nèi)的貓或狗任何一類中。這個問題便是分布外檢測(OOD detection),其近年來吸引了廣泛的關(guān)注,新工作層出不窮。然而領(lǐng)域快速擴(kuò)張的同時,追蹤、衡量領(lǐng)域的發(fā)展現(xiàn)狀卻由于種種原因成了一件難事。

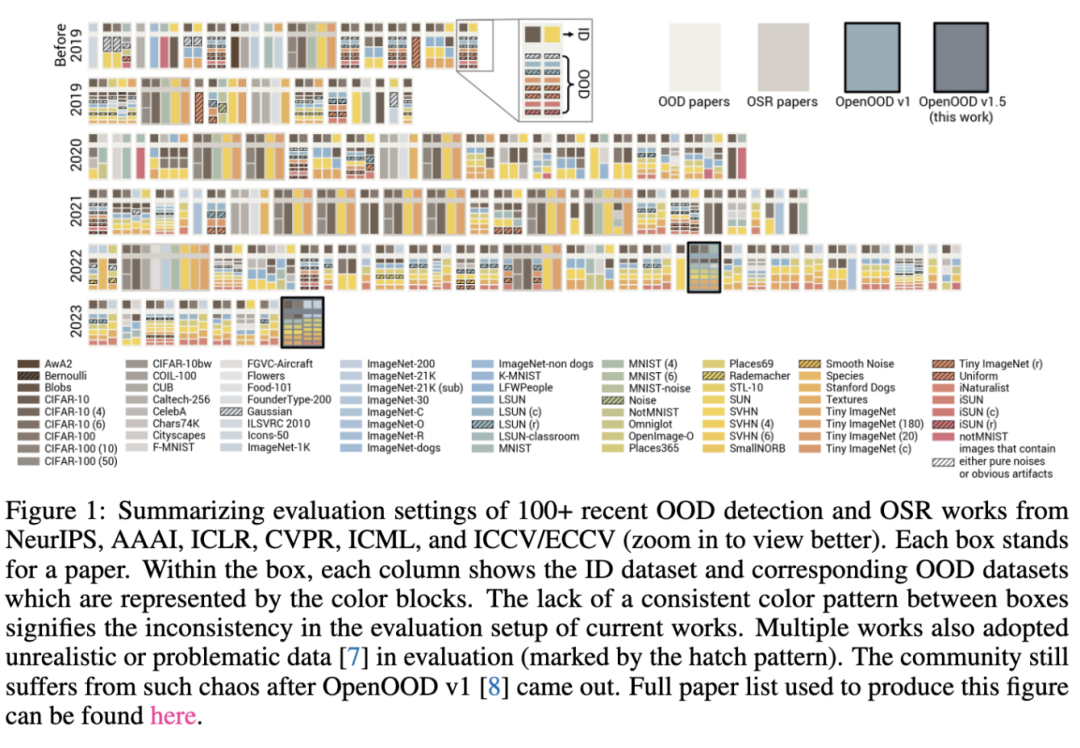

原因1:不一致的測試OOD數(shù)據(jù)集。深度學(xué)習(xí)各個任務(wù)的快速發(fā)展都離不開統(tǒng)一的測試數(shù)據(jù)集(就像圖像分類有CIFAR,ImageNet,物體檢測有PASCAL VOC,COCO)。然而不幸的是OOD檢測領(lǐng)域一直以來都缺乏統(tǒng)一的、被廣泛采用的OOD數(shù)據(jù)集。這就造成了在上圖中,當(dāng)我們回看已有工作的實驗設(shè)定時,會發(fā)現(xiàn)所用的OOD數(shù)據(jù)十分不一致(例如對于CIFAR-10是ID數(shù)據(jù)的情況,有些工作使用MNIST,SVHN作為OOD,有些工作使用CIFAR-100,Tiny ImageNet作為OOD)。在這樣的情況下,直接公平地比較全部方法面臨巨大困難。

原因2:令人困惑的術(shù)語。除了OOD檢測外,另外一些術(shù)語比如“開集識別”(Open-Set Recognition, OSR),“新類檢測”(Novelty Detection)也常常出現(xiàn)在文獻(xiàn)中。它們本質(zhì)上都在關(guān)注同一個問題,僅在一些實驗設(shè)定的細(xì)節(jié)上有著微小差別。然而不同的術(shù)語會導(dǎo)致方法之間形成不必要的分支,例如OOD檢測和OSR就曾經(jīng)被當(dāng)作是兩個獨立的任務(wù),而不同分支之間的方法(盡管在解決同一個問題)也很少被放在一起比較。

原因3:錯誤的操作。在許多工作中,研究者們往往直接使用OOD測試集中的樣本來調(diào)參甚至訓(xùn)練模型。這樣的操作會對方法的OOD檢測能力做出高估。

以上的問題顯然是對領(lǐng)域的有序發(fā)展不利的,我們迫切需要一個統(tǒng)一的基準(zhǔn)和平臺來測試評估現(xiàn)有以及未來的OOD檢測方法。OpenOOD 在這樣的挑戰(zhàn)下應(yīng)運而生。其第一版邁出了重要的一步,然而有著規(guī)模小、可用性有待提升的問題。因此在OpenOOD全新版本v1.5中,我們進(jìn)一步做了加強和升級,試圖打造一個全面、準(zhǔn)確、易用的測試平臺供廣大研究者使用。總結(jié)來看,OpenOOD有著如下重要的特性和貢獻(xiàn):

1.龐大、模塊化的代碼庫。該代碼庫將模型結(jié)構(gòu)、數(shù)據(jù)預(yù)處理、后處理器、訓(xùn)練、測試等等進(jìn)行了解藕及模塊化,方便復(fù)用以及開發(fā)。目前OpenOOD實現(xiàn)了近40種最先進(jìn)的針對圖像分類任務(wù)的OOD檢測方法。

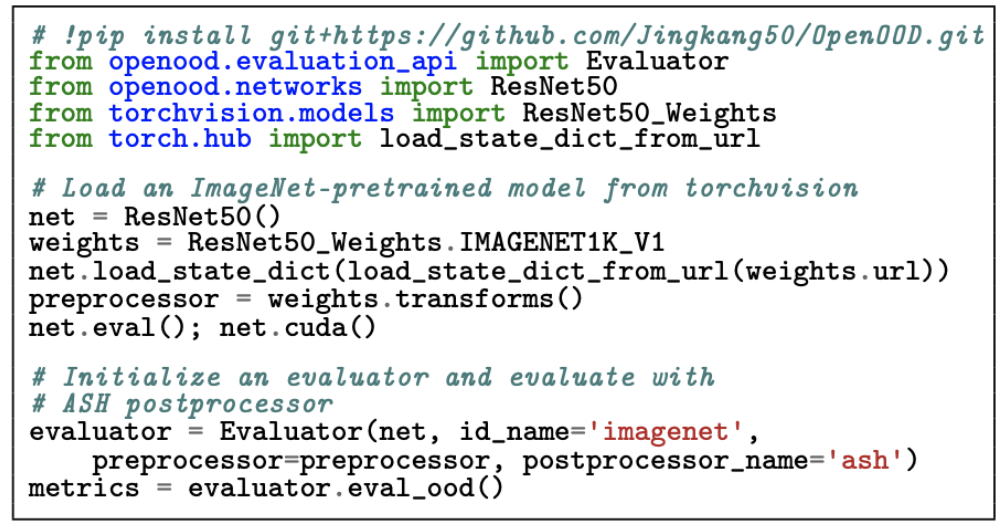

2.可一鍵測試的評估器。如上圖所示,僅用幾行代碼,OpenOOD的評估器就可以在指定的ID數(shù)據(jù)集上給出所提供的分類器、后處理器的OOD檢測測試結(jié)果。相應(yīng)的OOD數(shù)據(jù)是由評估器內(nèi)部所確定并提供的,這保證了測試的一致性和公平性。該評估器也同時支持標(biāo)準(zhǔn)OOD檢測(standard OOD detection)和全譜OOD檢測(full-spectrum OOD detection)兩種場景(后文會有更多介紹)。

3.在線排行榜。利用OpenOOD,我們在CIFAR-10,CIFAR-100, ImageNet-200,ImageNet-1K四個ID數(shù)據(jù)集上比較了近40種OOD檢測方法的性能,并將結(jié)果制作成了公開排行榜。希望能夠幫助大家隨時了解領(lǐng)域內(nèi)最有效、最有潛力的方法。

4.實驗結(jié)果中的新發(fā)現(xiàn)。根據(jù)OpenOOD全面的實驗結(jié)果,我們在論文中提供了許多新發(fā)現(xiàn)。例如,盡管看起來與OOD檢測關(guān)系不大,但數(shù)據(jù)增強(data augmentation)實際上能有效提升OOD檢測的性能,且這方面提升與具體OOD檢測手段帶來的提升是正交、互補的。另外,我們發(fā)現(xiàn)已有方法在全譜OOD檢測上的表現(xiàn)并不盡如人意,這也將是未來領(lǐng)域內(nèi)一個重要的待解決問題。

二、問題描述

這一部分會簡略、通俗地描述標(biāo)準(zhǔn)與全譜OOD檢測的目標(biāo)。對于更詳細(xì)、正式的描述,歡迎大家閱讀我們的論文。

首先討論一些背景。在我們所考慮的圖像分類場景下,分布內(nèi)(ID)數(shù)據(jù)是由相應(yīng)的分類任務(wù)所定義的。例如對于CIFAR-10分類,ID分布就對應(yīng)著它的10個語義類別。OOD的概念是相對于ID形成的:ID語義類別之外的、與ID類別不同的任何語義類別所對應(yīng)的圖片都是分布外OOD圖片。與此同時,我們需要討論如下兩種類型的分布偏移(distributional shift)。

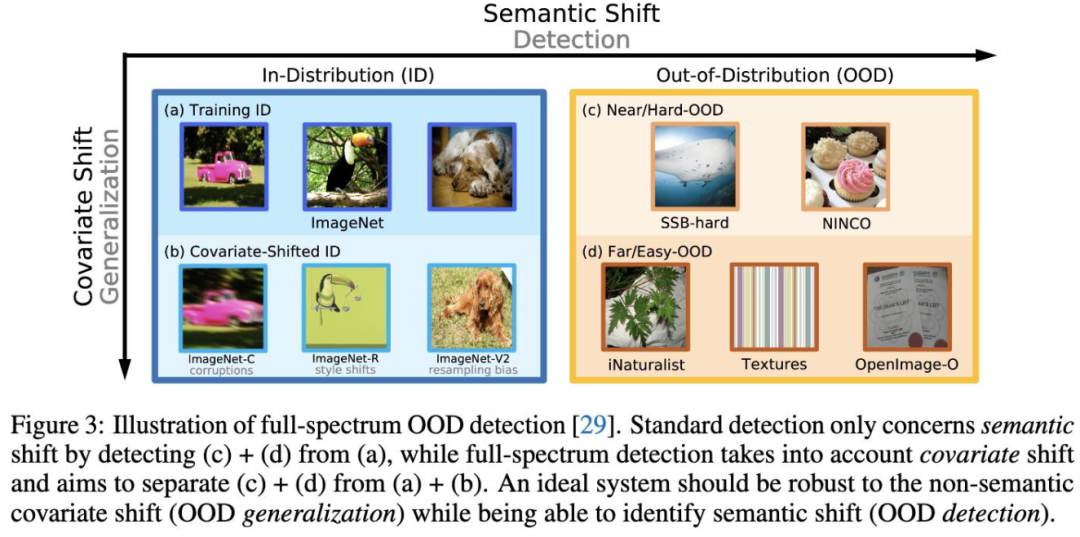

Semantic Shift:深層語義層面上的分布變化,對應(yīng)上圖橫軸。例如訓(xùn)練時語義類別是貓、狗,測試時語義類別是飛機、水果。

Covariate Shift:表層統(tǒng)計層面上的分布變化(而語義不變),對應(yīng)上圖縱軸。例如訓(xùn)練時是貓、狗的干凈自然照片,測試時是加了噪聲或手繪的貓、狗圖片。

有了上述背景,再結(jié)合上圖就可以很好理解標(biāo)準(zhǔn)以及全譜OOD檢測。

標(biāo)準(zhǔn)OOD檢測

目標(biāo)(1):在ID分布上訓(xùn)練一個分類器,使其能夠準(zhǔn)確對ID數(shù)據(jù)進(jìn)行分類。這里假設(shè)測試ID數(shù)據(jù)與訓(xùn)練ID數(shù)據(jù)不存在covariate shift。

目標(biāo)(2):基于訓(xùn)練好的分類器,設(shè)計OOD檢測方法使其能夠?qū)θ我鈽颖具M(jìn)行ID/OOD的二分類區(qū)分。在上圖中對應(yīng)的是將(a)和(c) + (d)區(qū)分開來。

全譜OOD檢測

目標(biāo)(1):與標(biāo)準(zhǔn)OOD檢測類似,但區(qū)別在于考慮了covariate shift,也就是無論測試ID圖片相比訓(xùn)練圖片是否有covariate shift,分類器都需要精準(zhǔn)分類到相應(yīng)的ID類別中(例如貓狗分類器不僅應(yīng)該準(zhǔn)確分類“干凈”貓狗圖片,還應(yīng)當(dāng)能泛化到帶噪、模糊的貓狗圖片上)。

目標(biāo)(2):同樣考慮covariate-shifted ID樣本,需要將其與正常(沒有covariate shift)的ID樣本一同與OOD樣本判別開來。對應(yīng)上圖中區(qū)分(a) + (b)和(c) + (d)。

為什么全譜OOD檢測很重要?熟悉的小伙伴可能已經(jīng)發(fā)現(xiàn),全譜OOD檢測中的目標(biāo)(1)實際上對應(yīng)著另一個很重要的研究課題——分布外泛化(OOD generalization)。需要澄清一下,OOD泛化中的OOD指的是存在covariate shift的樣本,而OOD檢測中的OOD指的是存在semantic shift的樣本。這兩種偏移(shift)都是現(xiàn)實世界中十分常見的,然而現(xiàn)有的OOD 泛化和標(biāo)準(zhǔn)OOD檢測都僅僅只考慮了其中一種而忽略了另一種。與之相反,全譜OOD檢測在同一場景下將兩種偏移自然地考慮在了一起,更準(zhǔn)確地反映了我們對于一個理想分類器在開放世界中表現(xiàn)的預(yù)期。

三、實驗結(jié)果及新發(fā)現(xiàn)

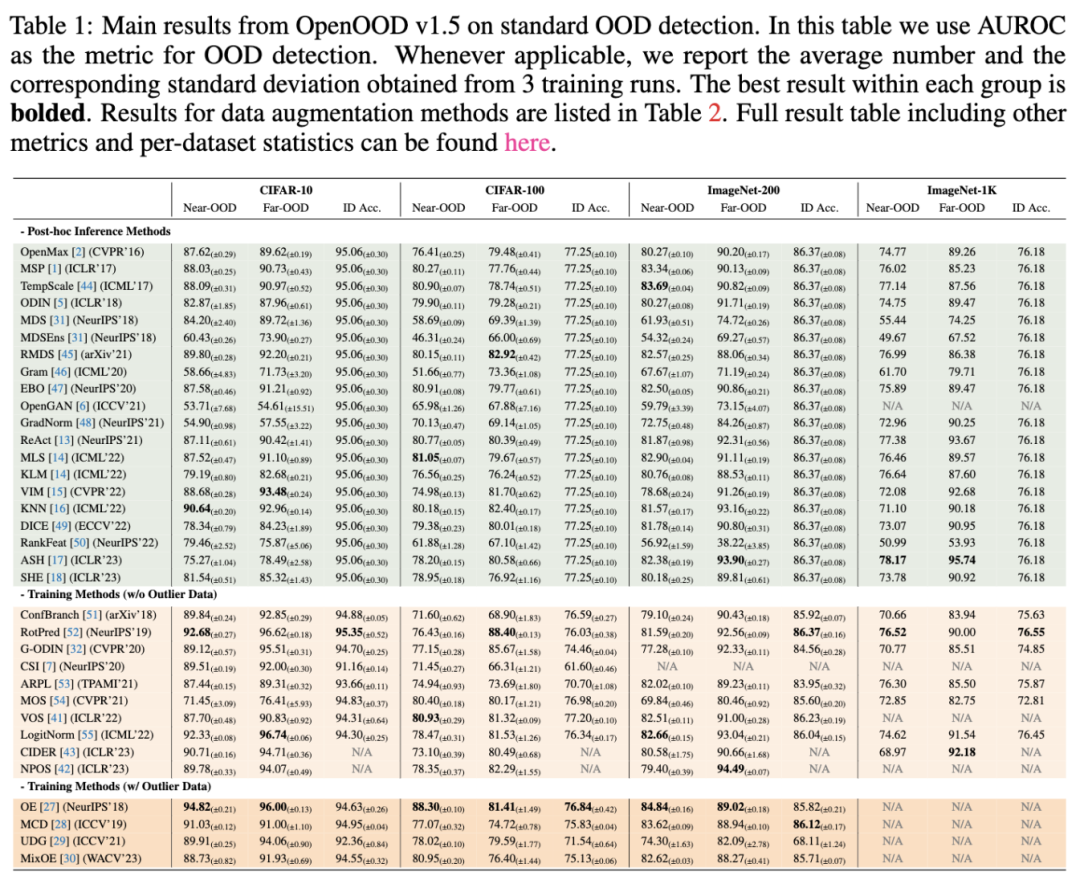

在1.5版本中,OpenOOD對近40種方法在6個基準(zhǔn)(benchmark)數(shù)據(jù)集(4個針對標(biāo)準(zhǔn)OOD檢測,2個針對全譜OOD檢測)上做了統(tǒng)一、全面的測試。論文中對所實現(xiàn)的方法及數(shù)據(jù)集都進(jìn)行了描述,歡迎大家查閱。全部實驗也都可以在OpenOOD的代碼庫中復(fù)現(xiàn)。這里我們直接討論從對比結(jié)果中得到的發(fā)現(xiàn)。

發(fā)現(xiàn)1:沒有贏家通吃(no single winner)。在上表中,不難發(fā)現(xiàn)并沒有任何一個方法能夠在全部基準(zhǔn)數(shù)據(jù)集上持續(xù)地給出突出表現(xiàn)。例如后處理的方法(post-hoc inference methods)ReAct和ASH在大數(shù)據(jù)集ImageNet上表現(xiàn)優(yōu)異,但在CIFAR上相比其他方法并沒有優(yōu)勢。與之相反,一些在訓(xùn)練中加入約束的方法(training methods),例如RotPred和LogitNorm,在小數(shù)據(jù)集上要優(yōu)于后處理方法,但在ImageNet上并不突出。

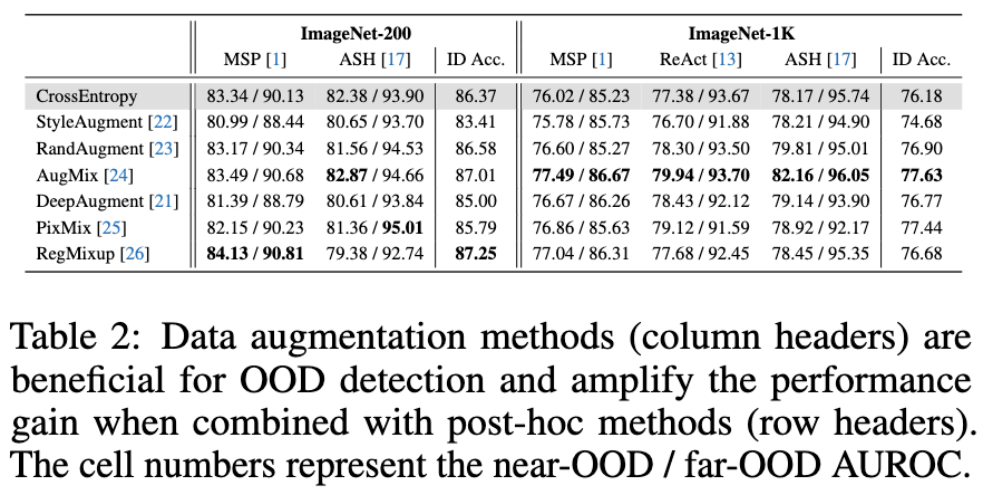

發(fā)現(xiàn)2:數(shù)據(jù)增強有效(data augmentations help)。如上表所示,盡管數(shù)據(jù)增強并不是專門為OOD檢測所設(shè)計的,但它們卻能有效提升OOD檢測的表現(xiàn)。更令人驚喜的是,數(shù)據(jù)增強帶來的提升與具體OOD后處理方法帶來的提升是互相放大的。這里以AugMix為例,當(dāng)它與最簡單的MSP后處理器結(jié)合時,在ImageNet-1K near-OOD檢測率上達(dá)到了77.49%,僅比不適用數(shù)據(jù)增強的交叉熵?fù)p失(corss-entropy loss)訓(xùn)練的檢測率77.38%高1.47%。然而當(dāng)AugMix與更先進(jìn)的ASH后處理器結(jié)合時,相應(yīng)的檢測率比交叉熵基線高了3.99%,并達(dá)到了我們測試中最高的82.16%。這樣的結(jié)果顯示了數(shù)據(jù)增強與后處理器的結(jié)合對于未來進(jìn)一步提升OOD檢測能力是非常有潛力的。

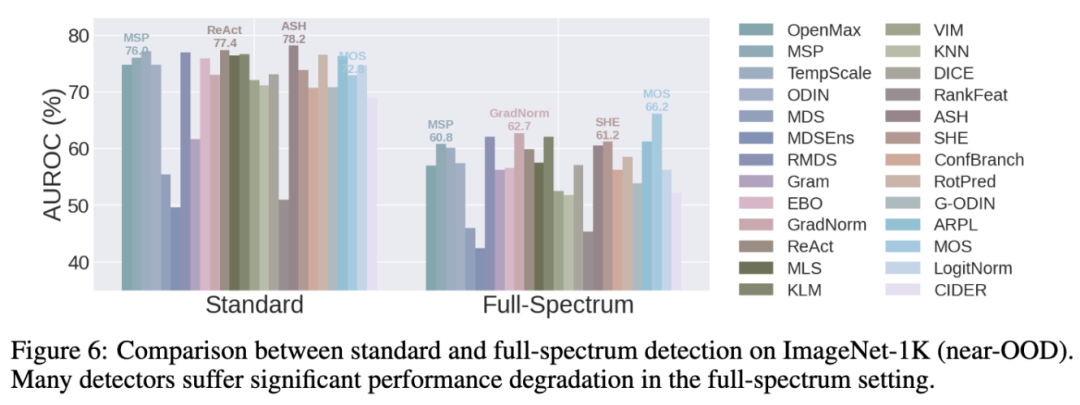

發(fā)現(xiàn)3:全譜OOD檢測對現(xiàn)有方法提出了挑戰(zhàn)(full-spectrum detection poses challenge for current detectors)。從上圖中可以清晰的看出,當(dāng)場景從標(biāo)準(zhǔn)OOD檢測切換為全譜OOD檢測時(也即在測試ID數(shù)據(jù)中加入了covariate-shifted ID圖片),絕大多數(shù)方法的性能都表現(xiàn)出了顯著的退化(大于10%的檢測率的下降)。這代表著當(dāng)前方法傾向于將實際語義未發(fā)生變化的covariate-shifted ID圖片標(biāo)記為OOD。該行為與人類的感知(同時也是全譜OOD檢測的目標(biāo))是相悖的:假設(shè)一個人類標(biāo)記員在標(biāo)記貓狗圖片,此時給他/她出示帶噪、模糊的貓狗圖片,他/她應(yīng)當(dāng)仍會識別出那是貓/狗,是分布內(nèi)ID數(shù)據(jù)而不是未知的分布外OOD數(shù)據(jù)。總的來看,目前方法無法有效地解決全譜OOD檢測,而我們相信這將是未來領(lǐng)域內(nèi)的一大重要問題。

此外還有許多發(fā)現(xiàn)沒有列在這里,例如數(shù)據(jù)增強對于全譜OOD檢測仍舊有效等等。再次歡迎大家閱讀我們的論文。

四、展望

我們希望OpenOOD的代碼庫、測試器、排行榜、基準(zhǔn)數(shù)據(jù)集以及詳實的測試結(jié)果能夠匯集各路研究人員的力量一起來推動領(lǐng)域發(fā)展。十分期待大家使用OpenOOD進(jìn)行OOD檢測的開發(fā)、測試。我們也歡迎任意形式的對OpenOOD的貢獻(xiàn),包括但不限于提出反饋,將最新的方法添加到OpenOOD代碼庫和排行榜中,擴(kuò)展未來版本OpenOOD等等。

-

圖像

+關(guān)注

關(guān)注

2文章

1083瀏覽量

40418 -

代碼

+關(guān)注

關(guān)注

30文章

4753瀏覽量

68368 -

分類器

+關(guān)注

關(guān)注

0文章

152瀏覽量

13175

原文標(biāo)題:OpenOOD v1.5:更全面、更精確的分布外檢測代碼庫及測試平臺

文章出處:【微信號:CVer,微信公眾號:CVer】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

升級到RTOS SDK v1.5版本編譯報錯如何解決?

無人機飛行電腦V1.5的資料分享

NuTiny-EVB-NUC_QFN88 V1.4,網(wǎng)站上提供的資料是v1.5的請問v1.4與v1.5的區(qū)別在哪里?

低功耗藍(lán)牙設(shè)備接入?yún)f(xié)議-血糖儀V1.5

網(wǎng)管非網(wǎng)管光纖收發(fā)器_93X_產(chǎn)品用戶手冊V1.5

蘋果iOS 13.4的App Store功能更全面

Apache NimBLE v1.5版本的BLE HCI層設(shè)計

智聯(lián)物聯(lián)調(diào)試工具分享之串口網(wǎng)絡(luò)數(shù)據(jù)調(diào)試助手V1.5

OpenOOD v1.5:更全面、更精確的分布外檢測代碼庫及測試平臺

OpenOOD v1.5:更全面、更精確的分布外檢測代碼庫及測試平臺

評論