本文選自中國工程院院刊《Engineering》2022年第11期

作者:王海峰 , 吳華 , 何中軍 , 黃亮 , Kenneth Ward Church

編者按

機器翻譯使用計算機將一種語言翻譯成另一種語言,具有低成本、高效率和高翻譯質量等優勢,在語音翻譯、同聲傳譯自動化等許多領域得到廣泛應用。隨著雙語語料庫的不斷建設和完善,基于語料庫的機器翻譯逐漸成為主流,如神經網絡機器翻譯。神經網絡機器翻譯是機器從大量數據中自動學習翻譯知識,而不依靠人類專家撰寫規則,可以顯著提升翻譯質量,但在處理語序差異大的語言翻譯時仍然面臨一些挑戰。

中國工程院院刊《Engineering》2022年第11期刊發百度集團王海峰博士研究團隊的《機器翻譯研究進展》一文。文章首先回顧了機器翻譯的發展歷程,從基于規則的機器翻譯、基于實例的機器翻譯,到統計機器翻譯。然后詳細介紹神經網絡機器翻譯技術的進展,包括基本原理和當前主流模型以及多語言翻譯;介紹了機器同聲傳譯的最新進展,探討如何在翻譯質量和時間延遲方面取得平衡;總結機器翻譯豐富的產品形式和應用。最后文章簡要討論了機器翻譯面臨的挑戰和未來的研究方向。

一、機器翻譯發展簡史

機器翻譯(MT)研究如何使用計算機將一種語言翻譯成另一種語言。第一臺計算機——電子數字積分計算機——問世一年之后,Warren Weaver于1947年首次提出了機器翻譯的設想。從那時起,機器翻譯就被認為是自然語言處理(NLP)領域中最具挑戰性的任務之一。

從方法上來看,機器翻譯技術可以分為兩大類:基于規則的方法和基于語料庫的方法。從機器翻譯設想提出到20世紀90年代,基于規則的方法一直占據主導地位。基于規則的機器翻譯(RBMT)使用雙語詞典和人工撰寫的規則將源語言文本翻譯成目標語言文本。然而,人工撰寫規則成本很高,規則維護難度大,很難從一個領域轉換到另一個領域,從一種語言轉換到另一種語言。因此,基于規則的系統很難擴展到開放領域翻譯和多語言翻譯。機器翻譯發展初期其主要被應用于軍事領域。1954年,喬治敦大學與IBM公司合作,首次使用IBM-701計算機完成了將俄語翻譯為英語的實驗,拉開了機器翻譯從夢想走向現實的序幕。之后的十多年里,機器翻譯一直是熱點研究領域。但隨著1966年美國語言自動處理咨詢委員會(ALPAC)發表關于機器翻譯的報告,這股熱潮戛然而止。該報告對機器翻譯持懷疑態度,導致機器翻譯研究經費大幅削減,相關研究變得極其困難。在機器翻譯繁榮發展的1962年,成立了當今計算語言學領域最具影響力的學術組織——國際計算語言學學會(Association for Computational Linguistics,ACL),其成立初期的名字為機器翻譯與計算語言學學會(Association for Machine Translation and Computational Linguistics,AMTCL)。然而到1968年,ALPAC報告發表后,機器翻譯發展進入蕭條期,該學會將“MT”從其名稱中刪除。即便是在機器翻譯研究遇冷的這段時間,研究人員也一直不斷嘗試各種方法以提高翻譯質量。1965年,自然語言處理領域的研究人員舉辦了第一屆國際計算語言學會議(COLING),會議重點是基于規則的句法分析和翻譯。從20世紀70年代開始,RBMT方法變得更加成熟。1978年,SYSTRAN公司推出了商業翻譯系統,這是當時基于規則的機器翻譯系統取得商業化應用的著名系統之一。谷歌在2007年之前一直使用SYSTRAN公司的機器翻譯服務。

隨著雙語語料庫的不斷建設和完善,基于語料庫的機器翻譯逐漸成為主流。其主要有三種方法:基于實例的機器翻譯(EBMT)、統計機器翻譯(SMT)和神經網絡機器翻譯(NMT)。20世紀80年代中期,研究人員提出了EBMT方法,其主要思想是通過模仿從雙語語料庫中檢索出的相似例句來實現翻譯。EBMT的翻譯效果依賴于檢索到的例句質量。檢索到的例句質量越高、與原文的匹配度越大,翻譯效果越好。然而,由于雙語語料庫難以涵蓋所有語言現象,導致EBMT方法在檢索相似例句時覆蓋率較低,進而影響翻譯質量。因此,EBMT方法通常應用于計算機輔助翻譯系統,提供相似例句作為翻譯參考。

1990年,Brown等提出了SMT方法,其主要思想是機器從大量數據中自動學習翻譯知識,而不是依靠人類專家撰寫規則。進一步地,在1993年,他們提出了5個SMT模型,形式化地刻畫翻譯過程。由于SMT方法的復雜性,以及20世紀80~90年代RBMT在商業應用中的主導地位,當時SMT方法并未被廣泛采用。然而,統計方法的出現受到學術界的重視。1996年,研究人員發起并召開了第一屆自然語言處理中的經驗方法會議(EMNLP),其目的是匯集來自一系列不同學科的經驗方法,包括語言學中基于語料庫的方法和工程學中的信息論。1999年,研究人員在約翰斯·霍普金斯大學舉辦了一場夏季研討會。研討會的成果之一是復現了Brown等提出的5個模型,并發布了一個名為“Egypt”的SMT工具包,大大降低了SMT的研究門檻。隨后,詞對齊工具GIZA和GIZA++相繼發布。2003年,基于短語的SMT方法進一步提高了機器翻譯質量。基于此方法的開源系統“Pharaoh”及其升級版本“Moses”極大地促進了SMT系統的發展。基于以上開源工具及系統,SMT方法得到廣泛研究和應用。2006年,谷歌推出了以基于短語的SMT為主要系統的互聯網翻譯服務。微軟和百度等公司也在隨后幾年推出了機器翻譯服務。需要注意的是,在實際應用中,單一模型很難解決豐富多樣的翻譯需求。因此,實際應用中通常采用集成了多種機器翻譯模型的混合方法,以提高翻譯質量。受SMT模型成功的鼓舞,研究人員提出了多種創新方法來進一步提升SMT的性能,包括引入形態學信息的因子化SMT模型、層次化SMT模型以及在源端和(或)目標端具有句法分析樹的基于句法的SMT模型。

SMT使用對數線性模型集成多個人工設計的特征,如翻譯模型、語言模型和重排序模型等,盡管能夠較顯著地提升翻譯質量,但在處理語序差異大的語言對翻譯時仍然面臨嚴重的詞語重排序問題。隨著深度學習技術在語音處理、計算機視覺等領域的快速發展,研究人員開始將深度學習技術應用于機器翻譯。2014年,Bahdanau等和Sutskever等提出了端到端神經網絡機器翻譯模型,并正式使用了“神經網絡機器翻譯”(neural machine translation,NMT)一詞。NMT的基本思路是將源語言映射成稠密向量(語義表示),然后基于注意力機制生成譯文。隨后,Dong等提出了一種基于NMT的多語言翻譯框架,這被認為是NMT多語言翻譯的突破性方法。2015年,百度部署了世界上第一個大規模NMT系統。2016年,谷歌也推出了NMT系統。此后,其他公司陸續發布了NMT系統。自2014年NMT被提出以來,僅用了大約一年的時間就實現了大規模在線部署。相比之下,SMT系統應用于在線服務花了大約16年的時間。此后,基于卷積神經網絡的翻譯模型和Transformer模型,再次顯著提高了NMT系統的翻譯質量。NMT的巨大進步甚至引發了關于機器翻譯是否可以與人工翻譯相媲美的廣泛討論。越來越多的研究圍繞NMT展開,如非自回歸模型、無監督NMT模型和NMT預訓練模型等,旨在提高多語言翻譯質量和翻譯效率。

語音處理和機器翻譯取得的巨大進步使得語音翻譯成為前沿和熱點方向。對口語翻譯或語音翻譯的探索始于1983年國際電信聯盟博覽會上展示的一個小型實驗性自動口譯系統。1988年出現的語音到語音(S2S)翻譯系統SpeechTrans,被認為是語音翻譯中的一個重要里程碑式系統。在隨后的20年中,特別是自1991年國際先進語音翻譯研究聯盟(C-STAR)成立以來,從限定領域和限定詞匯的系統到開放領域的自然語音翻譯,語音翻譯的發展令人矚目。2004年,國際口語翻譯研討會(IWSLT)首次舉辦并延續至今,進一步促進了語音翻譯的發展。

隨著神經網絡技術在機器翻譯和語音識別領域的發展,新的語音翻譯系統旨在實現同聲傳譯的自動化,即在低時間延遲(通常只有幾秒鐘)的情況下,實現與源語言語音(幾乎)同步的自動翻譯。同聲傳譯對人類來說也是極具挑戰性的,需要極高的專注力來傾聽和理解源語言,同時需要嫻熟的翻譯技巧快速地翻譯為目標語言并傳遞給聽眾。因此,全世界范圍內合格的同聲傳譯員數量十分有限。同聲傳譯員通常由兩名或更多人組成團隊,每15~30 min交替工作,以防止錯誤率呈指數增長。受短時記憶限制,同聲傳譯員通常采用合理省略源語言內容等翻譯技巧,以兼顧翻譯準確度與時間延遲。因此,迫切需要開發機器同傳技術,以減輕人類同傳譯員的負擔,降低同傳成本。作為一項早期工作,Wang等提出了一種基于神經網絡的機器同傳方法,將流式語音切分成適當的片段以提高語音翻譯質量。為了滿足機器同傳低時延要求,Ma等提出了一種簡單有效的“前綴到前綴”的機器同傳模型。該技術首次實現了可控時間延遲,重新激發了NLP領域對機器同傳的研究興趣。國際上許多公司,如谷歌、微軟、臉書、華為等,紛紛加入這一方向的研究。百度等公司的機器同傳系統在數百場會議中得到了實際應用。為了促進相關技術發展,2020年,研究人員在ACL舉辦了第一屆國際機器同傳研討會。同年,IWSLT也開設了新的語音翻譯賽道。

二、神經網絡機器翻譯

近年來,NMT發展迅速。典型的NMT模型包含兩部分:編碼器將源句子映射為向量,解碼器基于該向量生成譯文。這個過程類似于人類翻譯。NMT模型首先“讀取”整個源句子;然后,基于對句子的理解,翻譯模型逐詞生成目標句子。與RBMT和SMT等以前的方法相比,NMT不需要人工撰寫規則和設計特征。NMT是一個端到端的框架,直接從訓練語料庫中學習語義表示和翻譯知識。憑借這些優勢,NMT成為機器翻譯領域當前的主流方法。

本節首先介紹NMT模型,包括基于基本循環神經網絡(RNN)的模型及其改進,以及當前主流的NMT模型Transformer。然后,介紹多語言翻譯,并討論能夠充分利用數據的回譯技術和基于樞軸語言的翻譯技術,以及基于多任務學習的翻譯模型與多語言統一翻譯模型等。接下來,介紹語音翻譯及機器同傳最新進展,包括由語音識別(ASR)、機器翻譯和語音合成(TTS)組成的級聯模型,以及直接對語音和翻譯建模的端到端模型。

(一)神經網絡機器翻譯模型

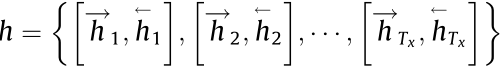

典型的NMT模型是基于標準RNN或其變體構建的。給定源句子

(其中,Tx表示的x長度),編碼器將壓縮為隱狀態 ,如下所示:

,如下所示:

式中,g(·)是激活函數;ht和xt分別是在時間的隱狀態和源語言詞向量;t表示時間步長;θ是模型參數。在基本模型中,編碼器將最后一個隱狀態 作為源句子的表示。然后,解碼器根據下式生成譯文:

作為源句子的表示。然后,解碼器根據下式生成譯文:

式中, 是目標句子;p(y|x)是翻譯概率;Ty?是的y長度;c是從隱狀態h生成的向量;?yt?是目標詞;是?

是目標句子;p(y|x)是翻譯概率;Ty?是的y長度;c是從隱狀態h生成的向量;?yt?是目標詞;是? 已經生成的目標詞。

已經生成的目標詞。

標準RNN模型的缺點之一是信息在傳遞過程中衰減很快,導致長句翻譯質量嚴重下降。為了克服這一問題,Bahdanau等提出了三種改進方案,被廣泛應用于NMT模型。接下來逐一介紹。

1. 注意力機制

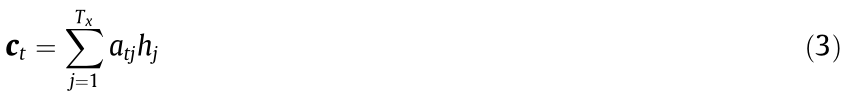

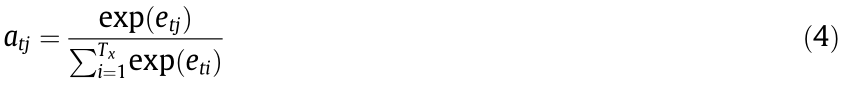

當生成目標單詞時,與上述基本模型中使用編碼器最后一個隱狀態來表示源句子不同,注意力機制計算目標單詞和所有源單詞之間的關聯,并評估關聯的強度。

式中,ct是上下文向量;hj是源單詞xj的j隱狀態;j是x的單詞索引; 是目標單詞yt和hj的關聯權重,其計算公式如下:

是目標單詞yt和hj的關聯權重,其計算公式如下:

式中,etj是由前饋神經網絡計算得到的詞對齊強度;i是x的單詞索引。

實際上,注意力機制類似于SMT中使用的詞對齊。SMT中的詞對齊是一種“硬對齊”,表示源單詞和目標單詞是否有連接。而NMT中的注意力機制是一種“軟對齊”,將目標單詞通過不同權重連接到所有源單詞。注意力機制顯著提高了翻譯質量,使NMT成為MT歷史上的一項突破性技術。

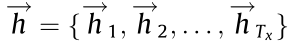

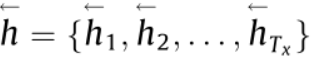

2. 雙向編碼

與單向編碼從左到右計算隱狀態不同,雙向編碼器根據從左到右和從右到左兩個方向計算隱狀態,如 和

和 。然后將隱狀態拼接為

。然后將隱狀態拼接為

。因此,對于任意一個時刻,隱狀態既包含了此時刻之前的歷史信息,也包含了此時刻之后的未來信息,這再次提高了翻譯質量。

。因此,對于任意一個時刻,隱狀態既包含了此時刻之前的歷史信息,也包含了此時刻之后的未來信息,這再次提高了翻譯質量。

3. 門控循環單元

門控循環單元(GRU)是傳統簡單激活函數的一種變體。GRU類似于長短時記憶網絡(LSTM),但效率更高。GRU和LSTM都允許網絡學習長距離依賴關系,而不會受到梯度消失問題的影響。

實驗表明,與SMT相比,NMT有顯著進步。然而,早期的NMT模型仍然存在缺點,如集外詞(OOV)問題、漏譯問題、解碼速度慢等。為了克服這些問題,He等提出將統計特征(如短語表、元語言模型和長度懲罰)引入NMT。沿著這個方向,研究人員借鑒了SMT技術,并將其融入NMT中,如詞語覆蓋度、對齊一致性、句法信息、短語表和翻譯建議等。Sennrich等使用字節對編碼(BPE)的壓縮算法進行分詞,將開放詞匯表壓縮為固定大小的子詞詞匯表。該方法簡單高效,被廣泛用于NMT以解決集外詞和低頻詞翻譯問題。

基于RNN的NMT在編解碼過程中對當前詞的處理依賴于前文信息,難以并行化。針對這一問題,研究人員提出了多種方案以提升NMT模型并行能力。例如,將計算機視覺中常用的卷積神經網絡(CNN)引入NMT ,通過卷積操作實現對句子中的長距離單詞依賴關系高效建模,顯著提升了模型的并行化能力。

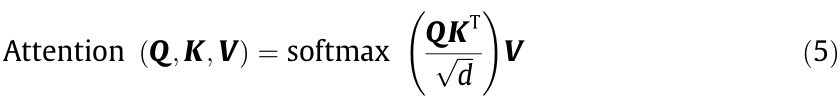

受基于CNN的NMT方法的啟發,Vaswani等提出了一個名為Transformer的新型網絡。該網絡完全基于注意力機制,沒有任何循環和卷積操作。Transformer包含三種注意力:編碼器自注意力、解碼器掩碼注意力和編碼器-解碼器注意力。研究人員提出了一種新的縮放點積方法來計算這幾種注意力。

式中,Q、K和V分別是查詢向量、鍵向量和值向量; 是縮放比例因子;KT是的K轉置。具體來說,對于每個單詞,模型通過將詞向量與不同的參數矩陣相乘來創建三個向量——查詢向量、鍵向量和值向量。注意力的作用是計算這些值的加權和,傳遞到下一層。

是縮放比例因子;KT是的K轉置。具體來說,對于每個單詞,模型通過將詞向量與不同的參數矩陣相乘來創建三個向量——查詢向量、鍵向量和值向量。注意力的作用是計算這些值的加權和,傳遞到下一層。

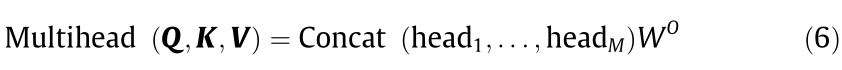

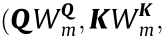

此外,研究人員還提出了一種多頭注意力機制(multi-head attention mechanism)。

式中,M是頭的個數;headm= Attention

?表示不同的注意力空間;

?表示不同的注意力空間; ??

?? ?

? 是參數矩陣。函數Concat (head1, ... , headM)將所有注意力頭拼接在一起。

是參數矩陣。函數Concat (head1, ... , headM)將所有注意力頭拼接在一起。

與循環神經網絡和卷積神經網絡相比,Transformer具有更強的并行化和表示能力。因此,它不僅在機器翻譯任務上取得了最好效果(state-of-the-art),而且在許多其他NLP任務中也有卓越表現。例如,眾所周知的雙向編碼預訓練模型BERT和知識增強預訓練模型ERNIE,均基于Transformer構建。

上述模型都是自回歸模型,在解碼時預測當前詞需要依賴于已經生成的單詞。這限制了模型在解碼期間的并行化能力。針對這一問題,Gu等提出了一種非自回歸Transformer(NAT),它可以并行化地生成目標序列。

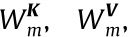

式中,T是目標句子的長度,采用條件分布pL(T|x;Φ)建立模型;Φ是模型參數。

與在生成特殊句尾標記(</s>)時停止解碼的自回歸模型不同,非自回歸模型首先使用pL(T|x;Φ)來預測目標序列的長度。盡管NAT在解碼過程中實現了顯著的加速,但翻譯質量卻受到影響。主要原因是NAT沒有對單詞依賴性進行建模,其對翻譯質量的提升非常重要。受解碼效率的鼓舞,研究人員提出了許多方法改進非自回歸模型,包括知識蒸餾、模仿學習和課程表學習等。

(二)多語言翻譯

不同的語言具有不同的形態和結構,這使得語言之間的翻譯不僅對機器翻譯來說是一項艱巨的任務,而且對人類專家而言也同樣充滿挑戰。例如,漢語和英語是主-謂-賓型語言,而日語和韓語是主-賓-謂型語言。在進行漢語和日語之間的翻譯時,通常需要進行長距離重新排序。此外,漢語是一種形態變化少的孤立型語言,而日語是一種具有豐富詞形變化的黏著型語言。語言之間的差異性增加了多語言機器翻譯的難度。

數據驅動的機器翻譯方法,無論是SMT還是NMT,從大量平行語料中自動學習翻譯知識。一般來說,增加訓練數據量能提高翻譯質量。Koehn和Knowles的實驗表明,當英語-西班牙語翻譯的訓練詞數從40萬增加到3.857億時,翻譯質量(使用自動評價指標BLEU度量)提高了約30%(絕對提升)。

遺憾的是,世界上大多數語言缺乏平行語料,這些語言也因此被稱為“資源貧乏”型語言。由于數據稀疏性問題,為這些語言構建NMT系統是一個巨大的挑戰。根據《互聯網世界統計》,全球十大語言(英語、漢語、西班牙語、阿拉伯語、葡萄牙語、印尼語/馬來語、法語、日語、俄語和德語)在互聯網上的用戶數量約占互聯網用戶總數的77%。其中,英語和漢語用戶分別占25.9%和19.4%,而所有其他語言用戶的總和僅占23.1%。對于資源豐富型語言,如漢語和英語,可以收集數十億個句對來訓練機器翻譯模型;然而,對于資源貧乏型語言對,如漢語-印地語或漢語-斯瓦希里語,只有數千個或更少的句對可用。

此外,部署多語言翻譯系統的成本也很高。如果在種語言之間部署翻譯系統,通常需要為每個翻譯方向(漢譯英和英譯漢視為兩個翻譯方向)都構建翻譯模型。N種語言互譯則需要構建N×(N–1)個翻譯模型。

隨著NMT技術發展,研究人員一直在尋求克服上述挑戰的方法。一般來說,多語言翻譯有兩種方法:充分利用數據的方法和改進NMT模型的方法。

針對資源貧乏型語言缺乏訓練數據的問題,直觀的改進方法是收集盡量多的訓練數據,并充分挖掘這些數據的潛力。與平行語料庫相比,大量單語語料庫更容易獲得。在NMT中,單語語料通常可用于數據擴充。一種廣泛使用的方法是回譯,其主要思路是首先在一個小型平行語料庫上訓練一個標準的NMT模型,然后使用該模型翻譯大量單語語料(例如,將目標語言句子翻譯為源語言句子),從而生成一個可用于重新訓練翻譯模型的“偽雙語語料庫”。在極端情況下,可能根本就沒有平行語料庫。為了解決該問題,可以使用無監督翻譯方法構建僅基于源單語語料庫和目標單語語料庫的翻譯系統。Lample等提出將不同語言的句子映射到相同的隱空間,并通過重構句子來訓練翻譯模型。Artetxe等使用改進的SMT模型來初始化無監督NMT模型,以進一步提高翻譯質量。Song等、Conneau和Lample以及Ren等提出了基于預訓練的無監督NMT模型。

多語言翻譯的另一個研究方向是充分利用資源豐富型語言來提高資源貧乏型語言的翻譯質量。該方法可以追溯到SMT時代。使用最廣泛的方法是基于樞軸語言的翻譯,即使用資源豐富型語言作為樞軸語言,在資源貧乏型語言對之間建立橋梁。以中德翻譯為例,由于有大量的中英和英德平行語料,因此可以選擇英語作為樞軸語言。最簡單的基于樞軸語言的翻譯方法是傳遞法,它使用兩個級聯翻譯系統:源語-樞軸語翻譯系統,將源語言句子翻譯成樞軸語言句子;以及樞軸語-目標語翻譯系統,將樞軸語言句子翻譯成目標語言句子。該方法易于實現,在實際系統中得到了廣泛應用。缺點是級聯系統存在誤差傳播問題。Wu和Wang以及Cohn和Lapata提出了一種三角定位法,通過從源語-樞軸語和樞軸語-目標語翻譯模型中引入源語-目標語翻譯模型來學習短語級別的翻譯知識。

此外,多語言NMT還可以使用統一建模方法,充分利用資源豐富型語言來提高資源貧乏型語言的翻譯質量。傳統的機器翻譯方法需要為每個語言對和每項任務建立單獨的翻譯模型,而NMT使得在一個統一模型中跨不同任務翻譯多種語言成為可能。一般來說,根據源端和目標端語言的數量,可以將該研究分為三類:一對多、多對一和多對多。

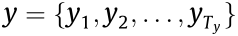

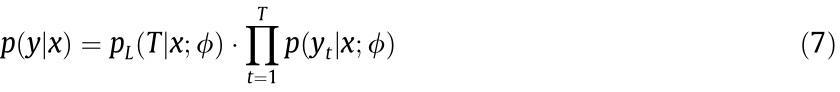

Dong等提出了一種用于多語言NMT的多任務學習方法。如圖1所示,通過共享編碼器共享源語言語義表示,該模型可以在不同語言對之間充分利用源語言語料庫。該方法為探索將一種源語言翻譯成多個目標語言的問題提供了統一的框架。為了在個語言之間部署翻譯系統,該模型只需要訓練一個編碼器和個解碼器。Luong等將該框架擴展到多任務,包括翻譯、句法分析和圖像描述。Zoph和Knight提出了一種多對一的NMT模型,該模型在目標端共享解碼器。Firat等使用具有共享注意力機制的不同編碼器和解碼器進行多對多翻譯。

圖1. 基于多任務學習的一對多NMT翻譯框架圖解。A1,A2,… ,AZ是目標語言的注意力,TY1, TY2,… ,TYz是目標語言,Z是目標語言數,stTYz(1≤ z ≤Z)是解碼端的隱狀態。

Johnson等提出了一種簡單的方法,將所有語言放在一起訓練一個統一的編碼器-解碼器模型,以執行多語言翻譯。研究人員在源語言句子開頭添加了一個特殊標記,以指示它被翻譯成哪種目標語言。該方法允許NMT模型學習多語言共享表示,并且實現簡單,無需對NMT模型結構進行修改。考慮到語言的多樣性,Tan等將語言分為幾個群組,并為每個群組訓練單獨的NMT模型。

在實際系統中,通常將上述方法結合起來,兼顧翻譯效率、部署成本等因素。得益于技術進步,當前的翻譯系統可以支持數百個語言之間的翻譯。Arivazhagan等提出了一種大規模多語言翻譯模型,該模型在超過250億個句對上訓練一個具有超過500億個參數的單一模型,支持103種語言翻譯(以英語作為源語言或者目標語言,與其他102種語言之間的翻譯)。Fan等提出了M2M-100模型,使用75億個句對進行訓練,可以支持100種語言互譯。

(三)同聲傳譯

機器同傳的目標是實現兼顧翻譯質量和翻譯效率的高質量實時翻譯。在整句翻譯(第2.1節)中,機器翻譯模型基于整個源語言句子生成目標譯文。而在機器同傳中,為了保證實時性,翻譯模型需要在未得到源語言句子完整內容的條件下進行翻譯。

目前,機器同傳的研究可以分為兩類:級聯(流水線)模型和端到端模型。

1. 級聯模型

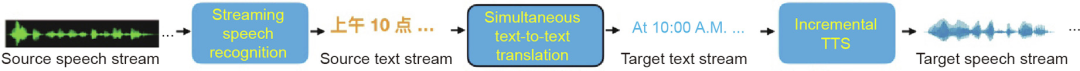

典型的級聯機器同傳系統包括將源語音轉錄為源語言文本流的ASR系統、執行從源文本到目標文本翻譯的機器翻譯系統,以及生成目標語言語音的TTS系統,具體如圖2所示。在實踐中,TTS系統是可選的,這取決于不同應用場景中目標端輸出的是文本還是語音。

圖2. 級聯機器同傳系統框架。

如前所述,機器同傳面臨的最大挑戰是實現高翻譯質量和低時間延遲。由于ASR系統輸出的文本流沒有句子邊界,而傳統的機器翻譯系統將具有明確邊界的句子作為輸入。因此,ASR的輸出與機器翻譯的輸入不匹配。如果翻譯系統在未得到充足的源語言信息之前開始翻譯,則翻譯質量會降低。反之,如果等待太多的源語言信息,則會增加時間延遲。

為了解決上述問題,需要對ASR的輸出進行切分,將切分后的結果作為機器翻譯的輸入。通常有兩種方法:固定文本長度的固定策略和根據上下文動態切分的自適應策略。

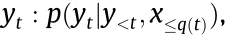

固定策略是獨立于上下文的預定義的硬策略。此類策略根據固定長度對源文本進行切分。Ma等基于“前綴到前綴”的思路提出了wait-k策略,其中,k是模型首先讀取的單詞數,此后模型邊讀入邊翻譯。也就是說,輸出總是落后于輸入k個單詞。該策略受人類同聲傳譯的啟發,他們通常在演講者開始演講幾秒鐘后開始翻譯,并在演講結束后的幾秒鐘內完成翻譯。舉例而言,如果k = 2,則使用前兩個源詞預測第一個目標詞,使用前三個源詞和生成的第一個目標詞預測第二個目標詞,依此類推。形式化描述為

即使用源語言句子前綴

即使用源語言句子前綴 而不是整個源句子來預測目標詞。是一個單調非遞減函數,表示預測時編碼器處理的源詞數。一般情況下,q(t)?可以用來表示任意長度的同傳策略,其中對于所有t,0 ≤?q(t) ≤ |x|? 。兩種特殊情況除外:①?q(t) = |x|,此時翻譯模型即是傳統的整句翻譯模型;②?q(t)?= 0,則翻譯模型退化為一個預測模型,即不依賴源語言句子的任何信息就開始翻譯。固定策略簡單易行,但由于缺乏上下文信息,通常會導致翻譯質量下降。

而不是整個源句子來預測目標詞。是一個單調非遞減函數,表示預測時編碼器處理的源詞數。一般情況下,q(t)?可以用來表示任意長度的同傳策略,其中對于所有t,0 ≤?q(t) ≤ |x|? 。兩種特殊情況除外:①?q(t) = |x|,此時翻譯模型即是傳統的整句翻譯模型;②?q(t)?= 0,則翻譯模型退化為一個預測模型,即不依賴源語言句子的任何信息就開始翻譯。固定策略簡單易行,但由于缺乏上下文信息,通常會導致翻譯質量下降。

自適應策略根據上下文信息進行動態的源文本切分。通常有兩種方式,使用獨立的模型對源語言文本流進行切分,或者在端到端框架中聯合學習切分和翻譯。自適應策略比固定策略更靈活,取得了更好的效果。受到人類同聲傳譯員翻譯方式的啟發,Zhang等提出了一種語義單元驅動的機器同傳方法,將源語言文本流動態切分為可獨立翻譯的片段,以同時滿足高質量和低時延要求。

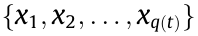

在語音翻譯中,有關增量TTS的研究不多。當前主流的TTS系統獲取完文本中的所有單詞后才開始生成語音,導致時間延遲高。在機器同傳中,為了減少延遲,需要以增量方式生成語音。傳統的增量TTS方法基于隱馬爾可夫模型,使用語言特征的完整上下文,每個特征需要單獨訓練和調參。最近的研究利用了神經網絡的優勢。Yanagita等提出了一種基于分段的TTS,一次合成一個分段。Ma等提出了一種神經增量詞級TTS。如圖3所示,該方法基于兩個前提:①單詞依賴關系是非常局部的;②音頻播放本質上是順序的,可以與音頻生成同時進行。也就是說,可以在合成后續文本時播放已經生成的上一段音頻。綜上所述,該方法在收到前兩個單詞后開始生成第一個單詞的頻譜圖;該頻譜圖被送到聲碼器以生成第一個單詞的波形,該波形會被立即播放。

圖3. 整句TTS與增量TTS。K1和K2分別是頻譜圖和聲波生成的前瞻窗口大小。

級聯模型易于實現,但是也存在問題。例如,級聯系統中的三個模塊均需滿足實時性要求。此外,ASR錯誤會在向下游任務傳播的過程中被放大,一個單詞識別錯誤可能會導致整體的翻譯結果不可接受。因此,需要增強語音翻譯系統的健壯性。

2. 端到端模型

機器同傳的最終目標是開發端到端的語音翻譯系統,以便源語言語音可以直接翻譯成目標語言,而無需像級聯方法那樣經過中間階段。端到端模型不僅可以減少級聯模型中的錯誤傳播,還可以提高效率。然而,構建高實時性的端到端語音翻譯模型是極具挑戰性的。此外,可用于訓練端到端模型的語音翻譯數據非常稀缺。目前,公開可用的機器同傳訓練數據僅包含數百小時的演講,其中大部分是日語-英語以及歐洲語言之間的數據。對于中英翻譯,百度發布了一個包含70 h演講的開放數據集,包括相應的語音轉錄和翻譯。

將語音識別和機器翻譯集成到一個統一的框架中并非易事,端到端語音翻譯是一項前沿技術。Bansal等首次驗證了端到端語音翻譯可以在不用源語言語音轉錄的情況下實現。近來有些研究基于預訓練或多任務學習來提高語音翻譯質量。例如,基于ASR數據預訓練編碼器,利用文本翻譯來改進語音翻譯等。Liu等使用知識蒸餾方法,通過從機器翻譯模型遷移知識來改進端到端語音翻譯。但是,這些方法中的不同任務之間不能相互共享信息。為了解決這個問題,研究人員提出了兩階段模型,其中第一階段執行語音識別任務,其隱狀態(而非識別結果)作為第二階段解碼器(翻譯系統)的輸入。Liu等提出一種交互式端到端語音翻譯模型,可以交互地進行語音識別和機器翻譯,從而提高了這兩項任務的性能。最近也有一些研究聚焦直接建立端到端語音翻譯模型。然而,由于訓練數據有限,以及將語音識別和機器翻譯集成到統一框架中的復雜性,目前的端到端語音翻譯系統的性能尚不能滿足實際要求。

由于級聯模型易于部署且翻譯質量比較高,因此當前大多數實用的語音翻譯系統使用該方法。Xiong等將機器同傳系統與具有3~7年經驗的人類同傳譯員進行了比較。實驗發現,同傳譯員通常會忽略不重要的信息以保持合理的時間延遲。這可能會損失譯文的完整度,但保證了實時性。與同傳譯員相比,機器同傳系統生成的譯文完整度更好。Shimizu等實驗也表明經驗較少的同傳口譯員在同傳過程中會丟失細節。這些研究表明,同聲傳譯對于人類和機器來說都是一項艱巨的任務。

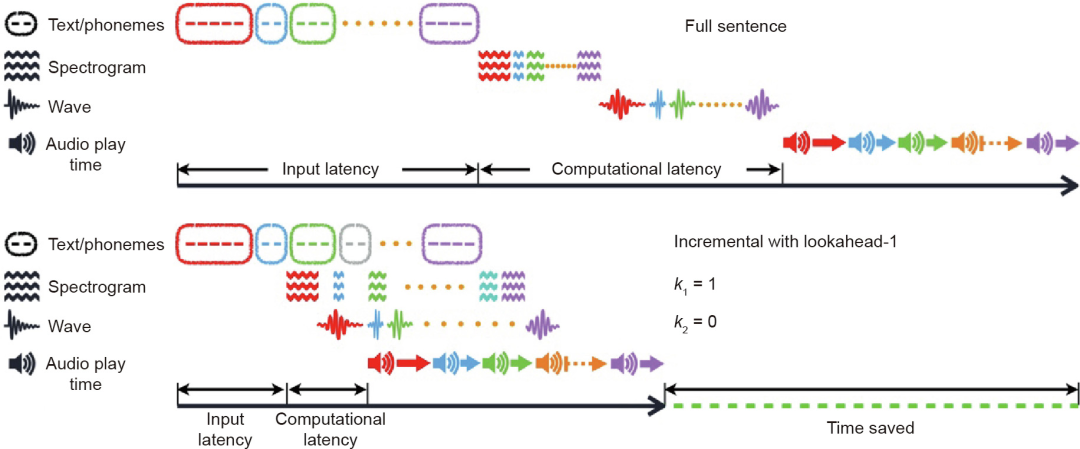

三、機器翻譯應用

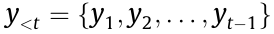

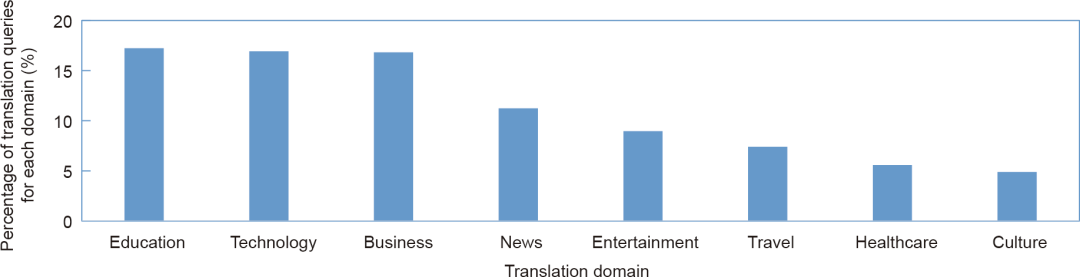

機器翻譯因其低成本、高效率和高翻譯質量而在許多領域得到廣泛應用。在中國,人工翻譯費用通常為0.1~0.5元/字不等,具體取決于翻譯人員的經驗豐富程度。而機器翻譯的價格約為0.00005元/字符。百度翻譯目前支持200多種語言互譯,每天翻譯量超過千億字符,應用領域廣泛。圖4列出了8個較大的領域分布。

圖4. 百度翻譯領域分布。

(一)文本翻譯

文本翻譯是最常見的機器翻譯應用形式。以下是文本翻譯的一些典型應用。

(1)網頁翻譯。隨著全球化的迅速發展,快速獲取外語信息的需求日益增加。聘請人工翻譯人員翻譯大量網頁既昂貴又耗時。機器翻譯提供了一種查看外語網頁的便捷方式。用戶只需復制/粘貼網頁內容或輸入網址即可以用母語閱讀頁面。

(2)科技文獻翻譯。研究人員、工程師和研究生等用戶經常使用機器翻譯系統閱讀論文和專利等科技文獻,或將他們的工作成果翻譯成其他語言。例如,為了抗擊新型冠狀病毒肺炎(COVID-19),生物醫學領域的翻譯需求迅速增長。科技文獻通常包含許多術語。借助領域自適應技術,翻譯模型首先使用大規模語料進行預訓練,然后使用少量領域內數據進行微調以進一步提升翻譯質量。此外,文檔翻譯用于翻譯格式豐富的文檔,例如,PowerPoint、Excel、Word和PDF,在生成譯文的同時保留字體大小和字體顏色等格式信息。

(3)電子商務翻譯。機器翻譯廣泛用于國際貿易。在機器翻譯系統的幫助下,賣家可以快速將網站、產品信息和服務手冊翻譯成外語,而買家可以輕松購買來自世界各地的產品。此外,機器翻譯還可以用于客戶服務,以提高服務質量和效率。

(4)語言學習。目前的機器翻譯系統通常提供豐富的功能,包括翻譯、高質量詞典、例句等。因此,用戶可以方便地查詢單詞或短語的含義并學習如何使用它。學生用戶經常輸入整個段落以幫助閱讀理解,并使用例句來輔助寫作。

除了文本翻譯,基于人工智能技術的最新進展,圖像翻譯和語音翻譯也已廣泛應用于實際場景中。

(二)圖像翻譯

圖像翻譯結合了計算機視覺和機器翻譯技術,將圖像作為輸入,然后將其翻譯成目標語言。

(1)多語言圖像描述。此類系統可以描述圖片內容并進行視覺問答,近年來得到了廣泛研究。多語言圖像描述基于NMT思想,其中,編碼器的輸入是圖像,解碼器的輸出是文本。由于模型可以為同一張圖片生成不同的語言,因此此功能對語言學習非常有幫助。

(2)光學字符識別(OCR)翻譯。此種形式的機器翻譯首先識別圖片中的字符,然后進行翻譯并使用譯文替換原文本。此功能可用于出國旅行時翻譯菜單、街道路牌、產品描述等。隨著近年來對文檔圖像布局和文本信息進行聯合建模的研究不斷進步,OCR翻譯還可用于翻譯掃描的文檔,同時保留原始格式信息。

(三)語音翻譯

語音翻譯結合了語音處理和機器翻譯技術,將源語言語音作為輸入,并以目標語言文本或語音作為輸出。

(1)機器同聲傳譯。如第2.3節所述,機器同傳最近取得較大進展,并得到廣泛應用。語音到文本(S2T)翻譯將語音識別結果和譯文以字幕形式投影到屏幕上,以方便用戶觀看。但是,屏幕上有限的空間通常只能顯示一種語言對的字幕。因此,很難將S2T擴展到多語言。語音到語音翻譯使得觀眾可以通過手機收聽目標語言聲音來解決這個問題。來自不同國家的用戶可以選擇他們的母語或他們喜歡的任何其他語言。機器同傳系統目前廣泛應用于國際會議。受新冠疫情影響,越來越多的會議以在線會議的形式舉辦。針對這類需求,機器同傳系統也已集成到在線會議系統中,提供實時翻譯。此外,用戶可以使用機器同傳插件用母語觀看外語視頻,如電影和講座等。

(2)便攜式翻譯設備。帶有語音翻譯功能的移動設備近年來受到用戶青睞。它們易于攜帶和使用,在語言學習、海外旅行和商務談判等許多場景中有廣泛應用。

此外,機器翻譯技術也可用于詩歌生成和中文對聯生成。以詩歌生成為例,機器翻譯模型將前一行生成的詩句作為“源語言句子”,將后續詩句作為“目標語言句子”,則可以逐行生成詩歌。

四、挑戰和展望

盡管當前機器翻譯取得了顯著進步,但仍有很大的提升空間。在機器翻譯研討會(WMT)等開展的機器翻譯評測中,某些基準測試集上的自動評價指標(如BLEU、WER、METEOR等)表明,機器翻譯有時比人工翻譯更好。但需要注意的是,這些指標很難全面反映譯文質量。好的翻譯至少應該具備兩個基本特點:譯文忠實于原文(忠實度),以及譯文地道流暢(流利度)。NMT方法在某些語言對或者領域翻譯中表現出較高的忠實度和流利度。然而,該方法遠非完美,在有些任務如語音翻譯上,仍面臨較大挑戰。

總體而言,機器翻譯還有許多方面有待改進。

第一,需要設計新的評價指標來衡量機器譯文不同部分的重要程度。例如,人類同傳譯員在進行同聲傳譯時不會試圖翻譯所有內容。在同傳過程中,知道哪些內容需要翻譯以及何時開始翻譯是非常重要的。同傳譯員知道何時需要加快速度,何時可以放緩節奏;知道哪些內容需要著重強調,哪些內容則可以省略不譯。但是,機器同傳系統會翻譯所有內容,并且不知道如何省略非重要內容以減少時間延遲。進一步地,機器同傳系統應該反映出演講者所強調的重點內容。最近,有些研究使用聲學特征來識別重點內容并將其翻譯成目標語言。除了語音信息外,說話者的肢體語言和韻律也可以清晰傳達說話者所強調的某一部分內容(相對于其他部分而言)。然而,將翻譯與說話者的肢體語言同步是比較困難的。此外,演講者在演講時經常會參考幻燈片。同樣地,將翻譯與幻燈片內容同步也充滿挑戰。盡管BLEU和WER之類的評價指標能夠一定程度上衡量譯文的完整性,但是不夠全面,沒有涉及延遲、強調、同步、理解等,這些也是影響翻譯的重要因素。在機器同傳中,前端ASR系統不僅需要能識別單詞,還應該能夠識別說話人所強調的重點內容,這些內容將會影響下游任務(機器翻譯、語音合成)的效果。因此,新的評價指標應該獎勵同傳系統將重要內容做出準確翻譯,同時懲罰只將非重點內容做出翻譯。

第二,機器翻譯的魯棒性需要進一步提高。有時源句子的微小改變(如詞語或標點符號的改變)可能會導致機器翻譯產生的譯文發生巨大變化。與機器相比,人類具有很強的容錯能力,能夠靈活地處理各種非標準語言現象和錯誤,有時甚至下意識地予以糾正。高魯棒性的機器翻譯系統在實際應用中至關重要。研發可解釋的機器翻譯系統是一種可能的解決方案。

第三,NMT在資源貧乏的語言對和領域中面臨著嚴重的數據稀疏問題。目前的機器翻譯系統通常使用數千萬甚至數億個句對的數據進行訓練,從而獲得較高的翻譯質量。數據稀缺會導致機器翻譯質量變差。與機器相比,人類卻能從少量樣本中學習。盡管研究者已經提出了多種數據增強方法、多任務學習方法和預訓練方法來緩解多語言翻譯面臨的數據稀疏問題,但如何提高資源貧乏型語言的翻譯質量仍任重道遠。

綜上所述,要實現高質量的機器翻譯還有很長的路要走。需要研發能夠結合符號規則、知識和神經網絡的新方法,以進一步提高翻譯質量。幸運的是,機器翻譯在實際場景中的廣泛應用可以不斷提供更多更豐富的數據,促進機器翻譯新方法的快速發展。

審核編輯:湯梓紅

-

神經網絡

+關注

關注

42文章

4762瀏覽量

100535 -

計算機

+關注

關注

19文章

7418瀏覽量

87712 -

smt

+關注

關注

40文章

2882瀏覽量

69055 -

機器翻譯

+關注

關注

0文章

139瀏覽量

14872 -

nlp

+關注

關注

1文章

487瀏覽量

22011

原文標題:機器翻譯研究進展

文章出處:【微信號:信息與電子工程前沿FITEE,微信公眾號:信息與電子工程前沿FITEE】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

薄膜鋰電池的研究進展

機器翻譯三大核心技術原理 | AI知識科普

機器翻譯三大核心技術原理 | AI知識科普 2

神經機器翻譯的方法有哪些?

從冷戰到深度學習_機器翻譯歷史不簡單

從冷戰到深度學習,機器翻譯歷史不簡單!

機器翻譯的真實水平如何,夢想與現實的距離到底有多遠?

換個角度來聊機器翻譯

機器翻譯研究進展

機器翻譯研究進展

評論