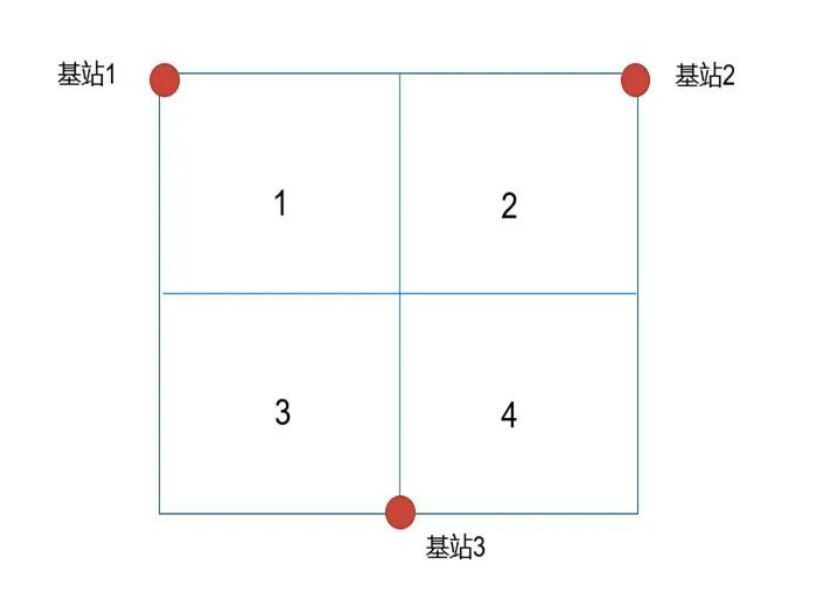

基于三個(gè)UWB錨點(diǎn)基站,采集近5萬(wàn)條數(shù)據(jù),分別采用BPNN和LSTM兩種神經(jīng)網(wǎng)絡(luò)訓(xùn)練和預(yù)測(cè)模型,實(shí)現(xiàn)目標(biāo)區(qū)域的判斷;

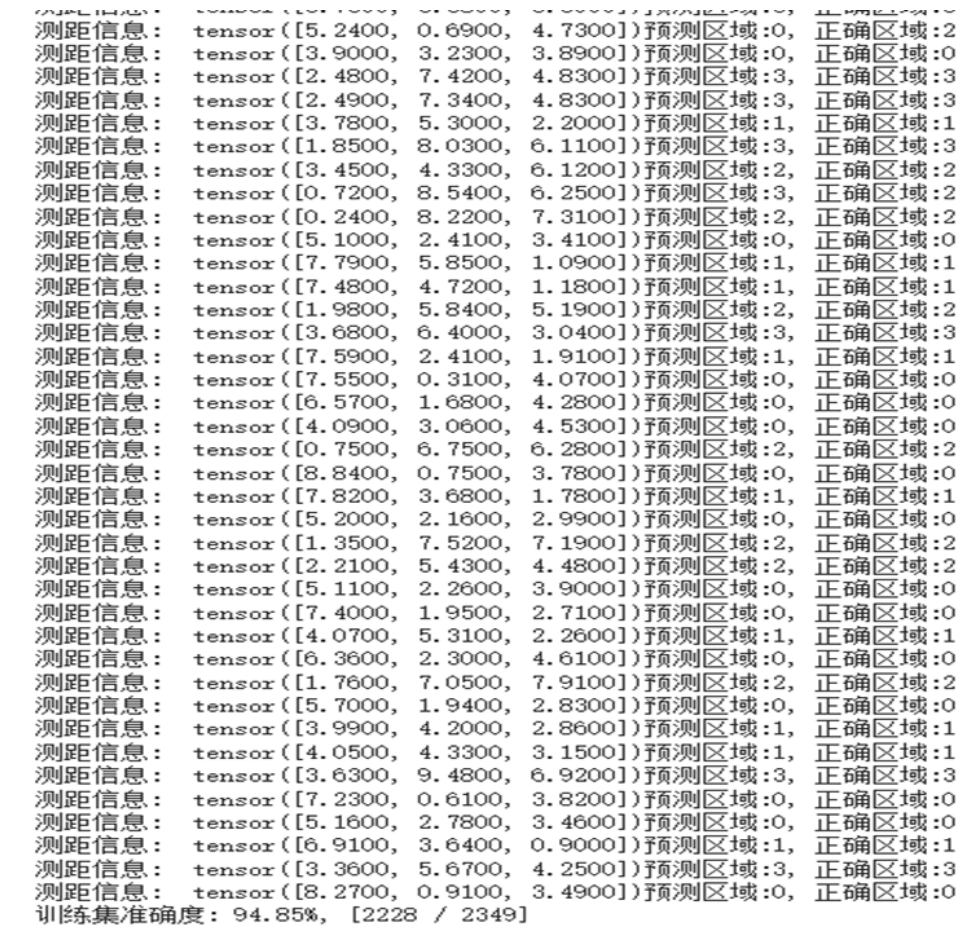

實(shí)驗(yàn)共使用了11741條數(shù)據(jù),按照8 : 2的比例劃分為訓(xùn)練集與測(cè)試集

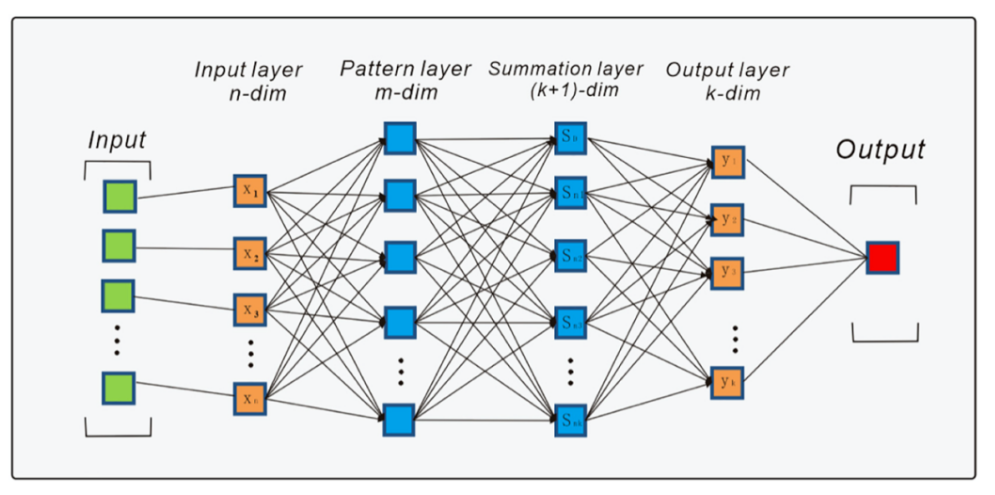

模型采用的是3層BPNN,隱含層為3,維度變化依次為3->32->16->4

損失函數(shù)使用的是交叉熵,優(yōu)化器選擇的是Adam,學(xué)習(xí)率為0.0001

訓(xùn)練輪數(shù)為100,為了提高訓(xùn)練效率和泛化能力,將32個(gè)數(shù)據(jù)作為一批,按批進(jìn)行訓(xùn)練,在100輪訓(xùn)練之后,訓(xùn)練損失逐漸收斂于0.005;

在測(cè)試集中的2349個(gè)數(shù)據(jù)中的測(cè)試準(zhǔn)確率為94.85%

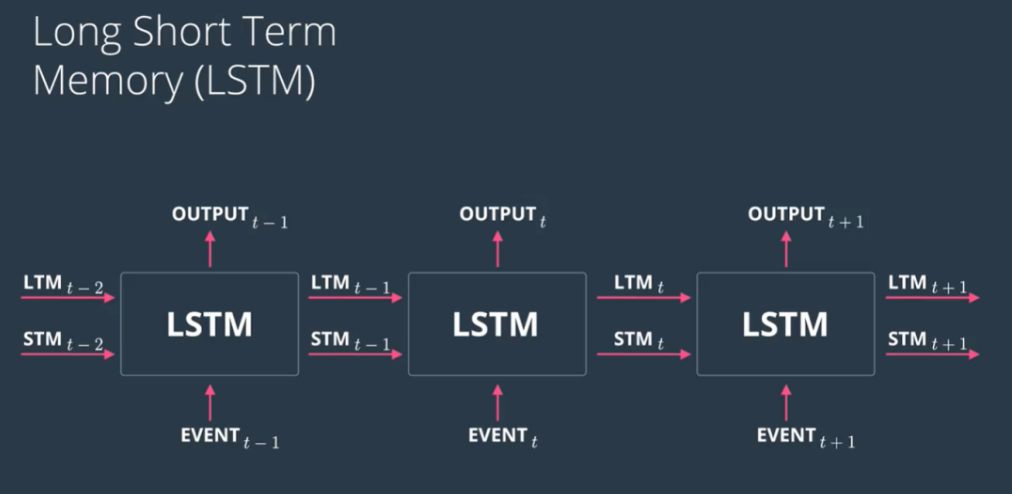

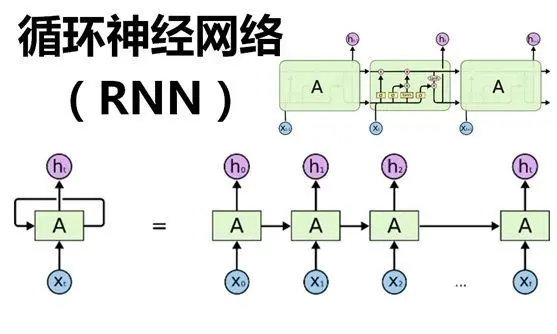

LSTM模型

數(shù)據(jù)歸一化與劃分,使用numpy的最大值函數(shù)獲取每個(gè)特征列的最大值,并將數(shù)據(jù)進(jìn)行預(yù)處理,使用最大值歸一化并將數(shù)據(jù)按照8:2的比例進(jìn)行模型的訓(xùn)練與預(yù)測(cè)。

模型的構(gòu)建:使用了Keras來(lái)創(chuàng)建模型。模型結(jié)構(gòu)包括一個(gè)LSTM層,它有32個(gè)神經(jīng)元,激活函數(shù)為Relu。Dropout層設(shè)置為20%的丟棄比率。全連接層輸出4個(gè)神經(jīng)元,使用softmax激活函數(shù)進(jìn)行多類分類。對(duì)模型進(jìn)行編譯,使用Adam優(yōu)化器和分類交叉熵?fù)p失函數(shù)。之后將模型進(jìn)行擬合,指定批量大小(batch_size)為20,訓(xùn)練次數(shù)(epochs)為100。

經(jīng)過100輪訓(xùn)練之后,模型的訓(xùn)練準(zhǔn)確率達(dá)到了95.52%,損失函數(shù)為0.1134.測(cè)試數(shù)據(jù)約3000條的測(cè)試準(zhǔn)確率為95.99%。

后續(xù)會(huì)進(jìn)一步基于兩種神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)模型,通過減少錨點(diǎn)以及增加時(shí)間序列和信號(hào)能量以及信號(hào)到達(dá)角輸入變量,觀察預(yù)測(cè)模型的準(zhǔn)確率;

審核編輯:湯梓紅

-

算法

+關(guān)注

關(guān)注

23文章

4599瀏覽量

92645 -

UWB

+關(guān)注

關(guān)注

32文章

1081瀏覽量

61019 -

模型

+關(guān)注

關(guān)注

1文章

3172瀏覽量

48715 -

深度學(xué)習(xí)

+關(guān)注

關(guān)注

73文章

5492瀏覽量

120978

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

目前主流的深度學(xué)習(xí)算法模型和應(yīng)用案例

深度學(xué)習(xí)算法聯(lián)合綜述

深度學(xué)習(xí)算法和應(yīng)用涌現(xiàn)的背后,是各種各樣的深度學(xué)習(xí)工具和框架

基于深度學(xué)習(xí)的行為識(shí)別算法及其應(yīng)用

基于遷移深度學(xué)習(xí)的雷達(dá)信號(hào)分選識(shí)別

機(jī)器學(xué)習(xí)和深度學(xué)習(xí)算法流程

什么是深度學(xué)習(xí)中優(yōu)化算法

基于UWB信號(hào)的深度學(xué)習(xí)算法

基于UWB信號(hào)的深度學(xué)習(xí)算法

評(píng)論