生成式人工智能即將到來,它將改變世界。自從 ChatGPT 席卷全球并激發(fā)了我們對人工智能可能性的想象力以來,我們看到各種各樣的公司都在爭先恐后地訓(xùn)練人工智能模型并將生成式人工智能部署到內(nèi)部工作流程或面向客戶的應(yīng)用程序中。不僅僅是大型科技公司和初創(chuàng)公司,許多財(cái)富500強(qiáng)非科技公司也在研究如何部署基于LLM的解決方案。

當(dāng)然,這需要大量的 GPU 計(jì)算。GPU 的銷量像火箭一樣猛增,而供應(yīng)鏈卻難以滿足對 GPU 的需求。公司正在爭先恐后地獲得 GPU 或云實(shí)例。

即使 OpenAI 也無法獲得足夠的 GPU,這嚴(yán)重阻礙了其近期路線圖。由于 GPU 短缺,OpenAI 無法部署其多模態(tài)模型。由于 GPU 短缺,OpenAI 無法部署更長的序列長度模型(8k 與 32k)。

與此同時(shí),中國公司不僅投資部署自己的LLM,還在美國出口管制進(jìn)一步收緊之前進(jìn)行儲(chǔ)備。例如,據(jù)新聞報(bào)道,中國公司字節(jié)跳動(dòng)據(jù)稱從 Nvidia 訂購了價(jià)值超過 10 億美元的 A800/H800。

雖然數(shù)十萬個(gè)專門用于人工智能的 GPU 有許多合法的用例,但也有很多情況是人們急于購買 GPU 來嘗試構(gòu)建他們不確定是否有合法市場的東西。在某些情況下,大型科技公司正試圖趕上 OpenAI 和谷歌,以免落后。對于沒有經(jīng)過驗(yàn)證的商業(yè)用例的初創(chuàng)公司來說,有大量的風(fēng)險(xiǎn)投資資金。我們知道有十幾家企業(yè)正在嘗試?yán)米约旱臄?shù)據(jù)訓(xùn)練自己的LLM。最后,這也適用于沙特阿拉伯和阿聯(lián)酋今年也試圖購買數(shù)億美元的 GPU 的國家。

盡管 Nvidia 試圖大幅提高產(chǎn)量,但最高端的 Nvidia GPU H100 直到明年第一季度仍將售空。Nvidia 每季度將增加 400,000 個(gè) H100 GPU 的出貨量。

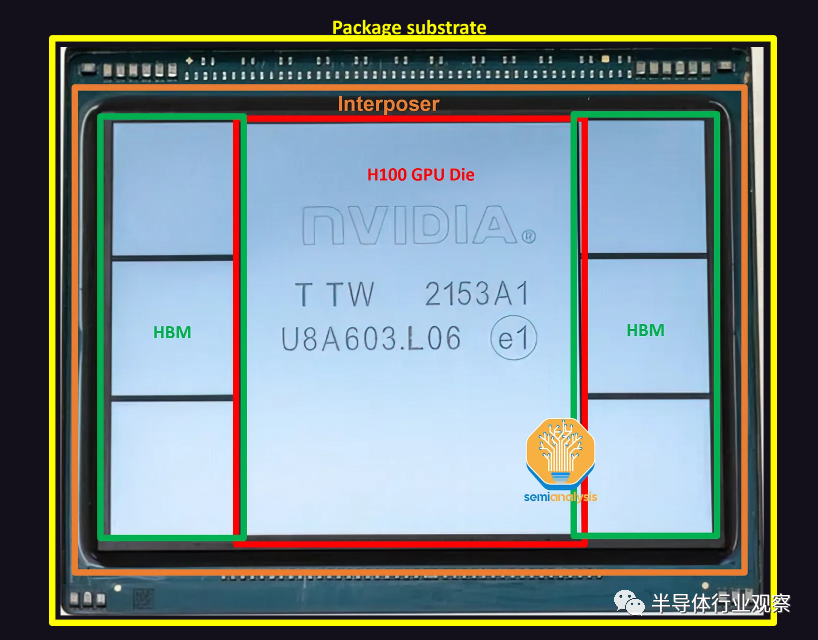

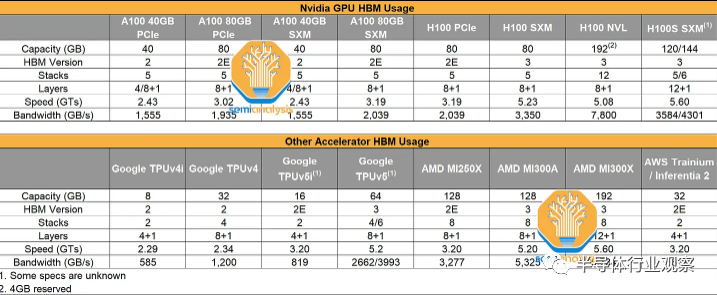

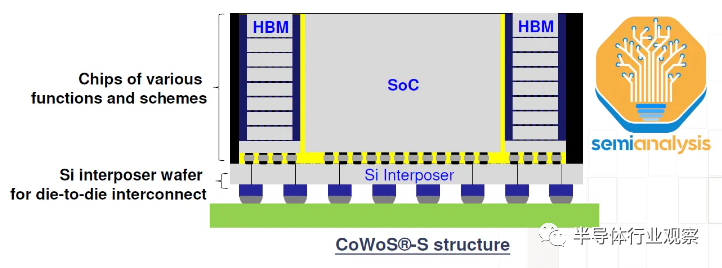

Nvidia 的 H100 采用 CoWoS-S 上的7-die封裝。中間是H100 GPU ASIC,其芯片尺寸為814mm2 ,周圍是 6 個(gè)內(nèi)存堆棧HBM。不同 SKU 之間的 HBM 配置有所不同,但 H100 SXM 版本使用 HBM3,每個(gè)堆棧為 16GB,總內(nèi)存為 80GB。H100 NVL 將具有兩個(gè)封裝,每個(gè)封裝上有 6 個(gè)活躍的 HBM 堆棧。

在只有 5 個(gè)激活 HBM 的情況下,非 HBM 芯片可以使用虛擬硅,為芯片提供結(jié)構(gòu)支撐。這些芯片位于硅中介層的頂部,該硅中介層在圖片中不清晰可見。該硅中介層位于封裝基板上,該封裝基板是 ABF 封裝基板。

GPU Die和 TSMC晶圓廠

Nvidia GPU 的主要數(shù)字處理組件是處理器芯片本身,它是在稱為“4N”的定制臺(tái)積電工藝節(jié)點(diǎn)上制造的。它是在臺(tái)積電位于臺(tái)灣臺(tái)南的 Fab 18 工廠制造的,與臺(tái)積電 N5 和 N4 工藝節(jié)點(diǎn)共享相同的設(shè)施,但這不是生產(chǎn)的限制因素。

由于 PC、智能手機(jī)和非 AI 相關(guān)數(shù)據(jù)中心芯片的嚴(yán)重疲軟,臺(tái)積電 N5 工藝節(jié)點(diǎn)的利用率降至 70% 以下。英偉達(dá)在確保額外的晶圓供應(yīng)方面沒有遇到任何問題。

事實(shí)上,Nvidia 已經(jīng)訂購了大量用于 H100 GPU 和 NVSwitch 的晶圓,這些晶圓立即開始生產(chǎn),遠(yuǎn)遠(yuǎn)早于運(yùn)送芯片所需的晶圓。這些晶圓將存放在臺(tái)積電的芯片組中,直到下游供應(yīng)鏈有足夠的產(chǎn)能將這些晶圓封裝成完整的芯片。

基本上,英偉達(dá)正在吸收臺(tái)積電的部分低利用率,并獲得一些定價(jià)優(yōu)勢,因?yàn)橛ミ_(dá)已承諾進(jìn)一步購買成品。

Wafer bank,也被稱為die bank,是半導(dǎo)體行業(yè)的一種做法,其中存儲(chǔ)部分處理或完成的晶圓,直到客戶需要它們?yōu)橹埂Ec其他一些代工廠不同的是,臺(tái)積電將通過將這些晶圓保留在自己的賬簿上幾乎完全加工來幫助他們的客戶。這種做法使臺(tái)積電及其客戶能夠保持財(cái)務(wù)靈活性。由于僅進(jìn)行了部分加工,因此晶圓庫中保存的晶圓不被視為成品,而是被歸類為 WIP。只有當(dāng)這些晶圓全部完成后,臺(tái)積電才能確認(rèn)收入并將這些晶圓的所有權(quán)轉(zhuǎn)讓給客戶。

這有助于客戶修飾他們的資產(chǎn)負(fù)債表,使庫存水平看起來處于控制之中。對于臺(tái)積電來說,好處是可以幫助保持更高的利用率,從而支撐利潤率。然后,隨著客戶需要更多的庫存,這些晶圓可以通過幾個(gè)最終加工步驟完全完成,然后以正常銷售價(jià)格甚至稍有折扣的價(jià)格交付給客戶。

HBM 在數(shù)據(jù)中心的出現(xiàn):

AMD 的創(chuàng)新如何幫助 Nvidia

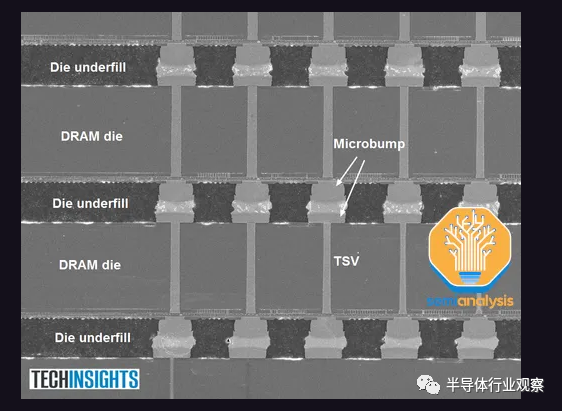

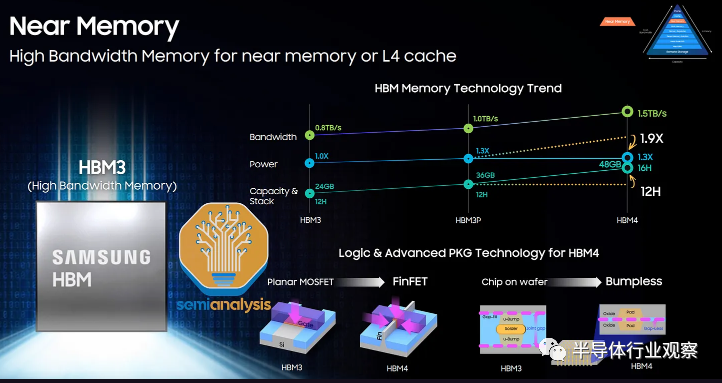

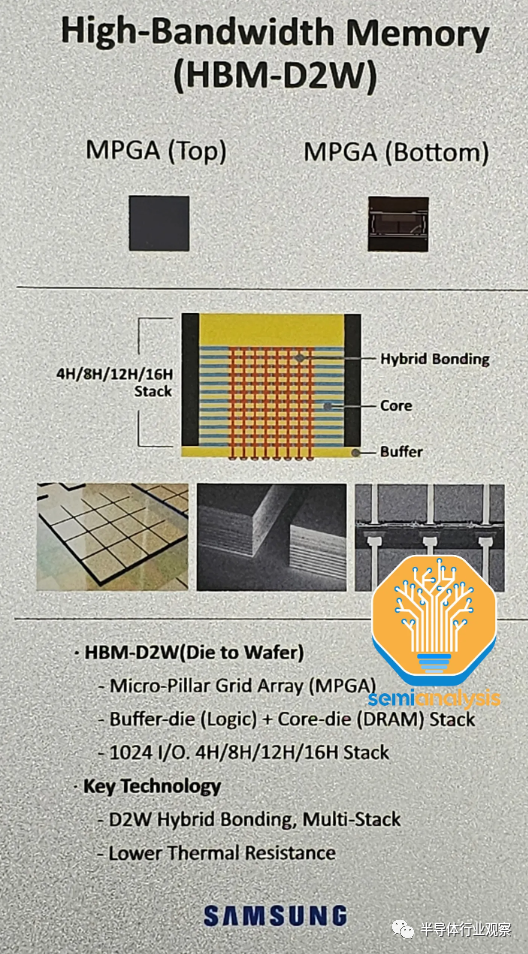

GPU 周圍的高帶寬內(nèi)存是下一個(gè)主要組件。HBM 供應(yīng)也有限,但正在增加。HBM 是垂直堆疊的 DRAM 芯片,通過硅通孔 (TSV) 連接并使用 TCB進(jìn)行鍵合(未來更高的堆疊數(shù)量將需要混合鍵合)。DRAM 裸片下方有一顆充當(dāng)控制器的基本邏輯裸片。

通常,現(xiàn)代 HBM 具有 8 層內(nèi)存和 1 個(gè)基本邏輯芯片,但我們很快就會(huì)看到具有 12+1 層 HBM 的產(chǎn)品,例如 AMD 的 MI300X 和 Nvidia 即將推出的 H100 更新。

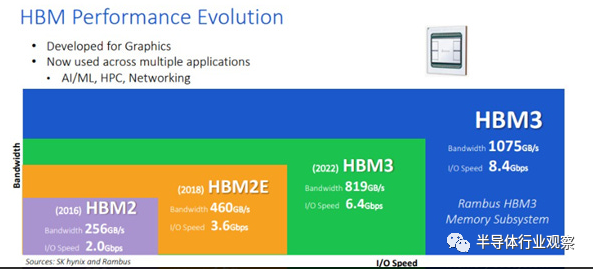

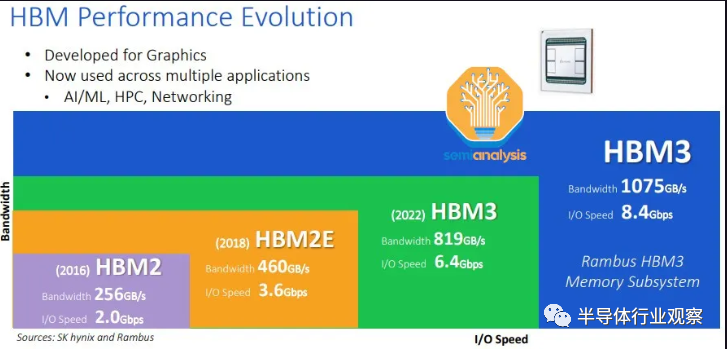

有趣的是,盡管 Nvidia 和 Google 是當(dāng)今使用量最大的用戶,但 AMD 率先推出了 HBM。2008 年,AMD 預(yù)測,為了匹配游戲 GPU 性能而不斷擴(kuò)展內(nèi)存帶寬將需要越來越多的功率,而這些功率需要從 GPU 邏輯中轉(zhuǎn)移出來,從而降低 GPU 性能。AMD 與 SK Hynix 以及供應(yīng)鏈中的其他公司(例如 Amkor)合作,尋找一種能夠以更低功耗提供高帶寬的內(nèi)存解決方案。這驅(qū)使 SK 海力士于 2013 年開發(fā)了 HBM。

SK Hynix 于 2015 年首次為 AMD Fiji 系列游戲 GPU 提供 HBM,該 GPU 由 Amkor 進(jìn)行 2.5D 封裝。隨后,他們在2017 年推出了使用 HBM2 的 Vega 系列。然而,HBM 并沒有對游戲 GPU 性能產(chǎn)生太大的改變。由于沒有明顯的性能優(yōu)勢以及更高的成本,AMD 在 Vega 之后重新在其游戲卡中使用 GDDR。如今,Nvidia 和 AMD 的頂級游戲 GPU 仍在使用更便宜的 GDDR6。

然而,AMD 的最初預(yù)測在某種程度上是正確的:擴(kuò)展內(nèi)存帶寬已被證明是 GPU 的一個(gè)問題,只是這主要是數(shù)據(jù)中心 GPU 的問題。對于消費(fèi)級游戲 GPU,Nvidia 和 AMD 已轉(zhuǎn)向使用大型緩存作為幀緩沖區(qū)(large caches for the frame buffer),使它們能夠使用帶寬低得多的 GDDR 內(nèi)存。

正如我們過去所詳述的,推理和訓(xùn)練工作負(fù)載是內(nèi)存密集型的。隨著人工智能模型中參數(shù)數(shù)量的指數(shù)級增長,僅權(quán)重的模型大小就已達(dá)到 TB 級。因此,人工智能加速器的性能受到從內(nèi)存中存儲(chǔ)和檢索訓(xùn)練和推理數(shù)據(jù)的能力的瓶頸:這個(gè)問題通常被稱為“內(nèi)存墻”。

為了解決這個(gè)問題,領(lǐng)先的數(shù)據(jù)中心 GPU 與高帶寬內(nèi)存 (HBM) 共同封裝。Nvidia 于 2016 年發(fā)布了首款 HBM GPU P100。HBM 通過在傳統(tǒng) DDR 內(nèi)存和片上緩存之間找到中間立場,以容量換取帶寬來解決內(nèi)存墻問題。通過大幅增加引腳數(shù)以達(dá)到每個(gè) HBM 堆棧 1024 位寬的內(nèi)存總線,可以實(shí)現(xiàn)更高的帶寬,這是每個(gè) DIMM 64 位寬的 DDR5 的 18 倍。同時(shí),通過大幅降低每比特傳輸能量 (pJ/bit) 來控制功耗。這是通過更短的走線長度來實(shí)現(xiàn)的,HBM 的走線長度以毫米為單位,而 GDDR 和 DDR 的走線長度以厘米為單位。

如今,許多面向HPC的芯片公司正在享受AMD努力的成果。具有諷刺意味的是,AMD 的競爭對手 Nvidia 作為 HBM 用量最大的用戶,或許會(huì)受益最多。

HBM市場:SK海力士占據(jù)主導(dǎo)地位

作為HBM的先驅(qū),SK海力士是擁有最先進(jìn)技術(shù)路線的領(lǐng)導(dǎo)者。SK 海力士于 2022 年 6 月開始生產(chǎn) HBM3,是目前唯一一家批量出貨 HBM3 的供應(yīng)商,擁有超過 95% 的市場份額,這是大多數(shù) H100 SKU 所使用的。HBM 現(xiàn)在的最大配置為 8 層 16GB HBM3 模塊。SK Hynix 正在為 AMD MI300X 和 Nvidia H100 刷新生產(chǎn)數(shù)據(jù)速率為 5.6 GT/s 的 12 層 24GB HBM3。

HBM 的主要挑戰(zhàn)是存儲(chǔ)器的封裝和堆疊,這是 SK 海力士所擅長的,他們過去在這方面積累了最強(qiáng)大的工藝流程知識。

三星緊隨 Hynix 之后,預(yù)計(jì)將在 2023 年下半年發(fā)貨 HBM3。我們相信它們是為 Nvidia 和 AMD GPU 設(shè)計(jì)的。他們目前在銷量上與 SK 海力士存在很大差距,但他們正在緊鑼密鼓地前進(jìn),并正在大力投資以追趕市場份額。三星正在投資以追趕并成為 HBM 市場份額第一,就像他們在標(biāo)準(zhǔn)內(nèi)存方面一樣。我們聽說他們正在與一些加速器公司達(dá)成優(yōu)惠協(xié)議,以試圖獲得更多份額。

他們展示了 12 層 HBM 以及未來的混合鍵合 HBM。三星 HBM-4 路線圖的一個(gè)有趣的方面是,他們希望在內(nèi)部 FinFET 節(jié)點(diǎn)上制作邏輯/外圍設(shè)備。這顯示了他們擁有內(nèi)部邏輯和 DRAM 代工廠的潛在優(yōu)勢。

美光科技在HBM方面排名墊底。

他們在混合存儲(chǔ)立方體 (HMC) 技術(shù)上投入了更多資金。這是與 HBM 競爭的技術(shù),其概念非常相似,大約在同一時(shí)間開發(fā)。然而,HMC周圍的生態(tài)系統(tǒng)是封閉的,導(dǎo)致圍繞HMC的IP很難開發(fā)。此外,還存在一些技術(shù)缺陷。HBM 的采用率要高得多,因此 HBM 勝出,成為 3D 堆疊 DRAM 的行業(yè)標(biāo)準(zhǔn)。

直到 2018 年,美光才開始從 HMC 轉(zhuǎn)向 HBM 路線圖。這就是美光科技落在最后面的原因。他們?nèi)匀煌A粼贖BM2E(SK海力士在2020年中期開始量產(chǎn))上,他們甚至無法成功制造HBM2E。

在最近的財(cái)報(bào)電話會(huì)議中,美光對其 HBM 路線圖做出了一些大膽的聲明:他們相信,他們將在 2024 年憑借 HBM3E 從落后者變?yōu)轭I(lǐng)先者。HBM3E 預(yù)計(jì)將在第三季度/第四季度開始為 Nvidia 的下一代 GPU 發(fā)貨。

“我們的 HBM3 斜坡實(shí)際上是下一代 HBM3,與當(dāng)今業(yè)界生產(chǎn)的 HBM3 相比,它具有更高水平的性能、帶寬和更低的功耗。該產(chǎn)品,即我們行業(yè)領(lǐng)先的產(chǎn)品,將從 2024 年第一季度開始銷量大幅增加,并對 24 財(cái)年的收入產(chǎn)生重大影響,并在 2025 年大幅增加,即使是在 2024 年的水平基礎(chǔ)上。我們的目標(biāo)也是在 HBM 中獲得非常強(qiáng)勁的份額,高于行業(yè)中 DRAM 的非自然供應(yīng)份額。”美光首席商務(wù)官Sumit Sadana說。

他們希望在 HBM 中擁有比一般 DRAM市場份額更高的市場份額的聲明非常大膽。鑒于他們?nèi)栽谂Υ笈可a(chǎn)頂級 HBM2E,我們很難相信美光聲稱他們將在 2024 年初推出領(lǐng)先的 HBM3,甚至成為第一個(gè) HBM3E。在我們看來,盡管Nvidia GPU 服務(wù)器的內(nèi)存容量比英特爾/AMD CPU 服務(wù)器要低得多,但美光科技似乎正在試圖改變?nèi)藗儗θ斯ぶ悄苁≌叩目捶ā?/p>

我們所有的渠道檢查都發(fā)現(xiàn) SK 海力士在新一代技術(shù)方面保持最強(qiáng),而三星則非常努力地通過大幅供應(yīng)增加、大膽的路線圖和削減交易來追趕。

真正的瓶頸 - CoWoS

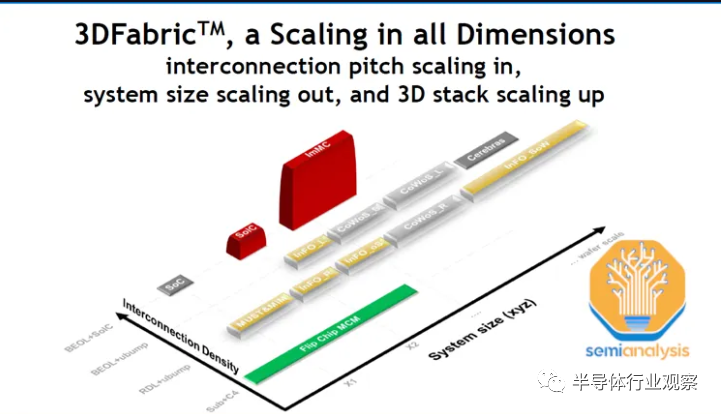

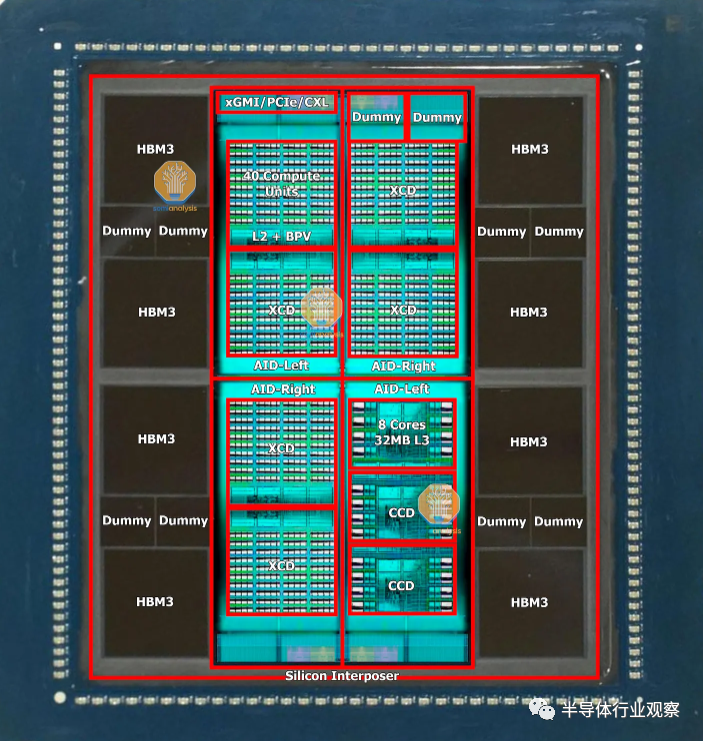

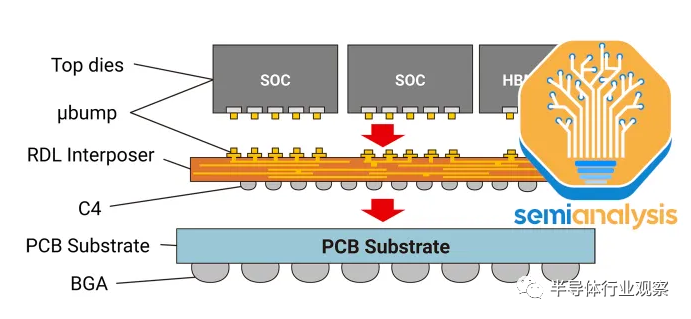

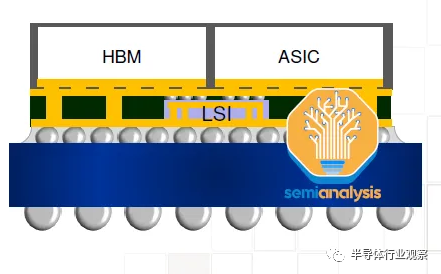

下一個(gè)瓶頸是 CoWoS 產(chǎn)能。CoWoS(Chip on Wafer on Substrate)是臺(tái)積電的一種“2.5D”封裝技術(shù),其中多個(gè)有源硅芯片(active silicon)(通常的配置是邏輯和 HBM 堆棧)集成在無源硅中介層上。中介層充當(dāng)頂部有源芯片的通信層。然后將中介層和有源硅連接到包含要放置在系統(tǒng) PCB 上的 I/O 的封裝基板。

HBM 和 CoWoS 是互補(bǔ)的。HBM 的高焊盤數(shù)(high pad count)和短走線長度要求需要 CoWoS 等 2.5D 先進(jìn)封裝技術(shù)來實(shí)現(xiàn) PCB 甚至封裝基板上無法實(shí)現(xiàn)的密集、短連接。CoWoS是主流封裝技術(shù),能夠以合理的成本提供最高的互連密度和最大的封裝尺寸。由于目前幾乎所有 HBM 系統(tǒng)都封裝在 CoWoS 上,并且所有高級 AI 加速器都使用 HBM,因此,幾乎所有領(lǐng)先的數(shù)據(jù)中心 GPU 都由臺(tái)積電在 CoWoS 上封裝。百度確實(shí)有一些先進(jìn)的加速器,三星的版本也有。

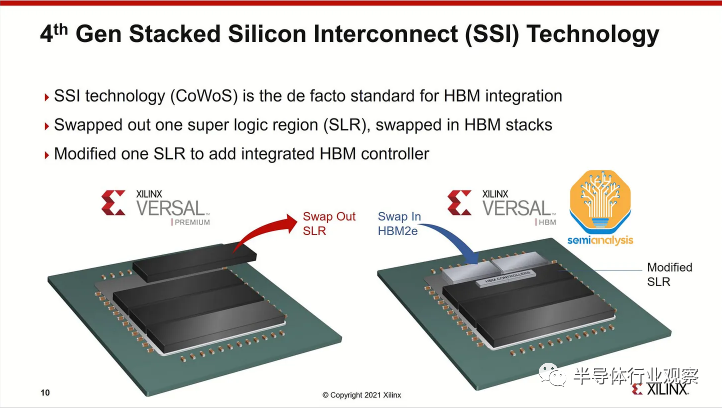

雖然臺(tái)積電 (TSMC) 的 SoIC 等 3D 封裝技術(shù)可以將芯片直接堆疊在邏輯之上,但由于散熱和成本的原因,這對于 HBM 來說沒有意義。SoIC 在互連密度方面處于不同的數(shù)量級,并且更適合通過芯片堆疊擴(kuò)展片上緩存,如 AMD 的 3D V-Cache 解決方案所示。AMD 的 Xilinx 也是多年前 CoWoS 的第一批用戶,用于將多個(gè) FPGA 小芯片組合在一起。

雖然還有一些其他應(yīng)用使用 CoWoS,例如網(wǎng)絡(luò)(其中一些用于網(wǎng)絡(luò) GPU 集群,如 Broadcom 的 Jericho3-AI )、超級計(jì)算和 FPGA,但絕大多數(shù) CoWoS 需求來自人工智能。與半導(dǎo)體供應(yīng)鏈的其他部分不同,其他主要終端市場的疲軟意味著有足夠的閑置空間來吸收 GPU 需求的巨大增長,CoWoS 和 HBM 已經(jīng)是大多數(shù)面向人工智能的技術(shù),因此所有閑置產(chǎn)能已在第一季度被吸收。隨著 GPU 需求的爆炸式增長,供應(yīng)鏈中的這些部分無法跟上并成為 GPU 供應(yīng)的瓶頸。

“就在最近這兩天,我接到一個(gè)客戶的電話,要求大幅增加后端容量,特別是在 CoWoS 中。我們?nèi)栽谠u估這一點(diǎn)。”臺(tái)積電首席執(zhí)行官C.C Wei早起那說。

臺(tái)積電一直在為更多的封裝需求做好準(zhǔn)備,但可能沒想到這一波生成式人工智能需求來得如此之快。6月,臺(tái)積電宣布在竹南開設(shè)先進(jìn)后端Fab 6。該晶圓廠占地 14.3 公頃,足以容納每年 100 萬片晶圓的 3D Fabric 產(chǎn)能。這不僅包括 CoWoS,還包括 SoIC 和 InFO 技術(shù)。有趣的是,該工廠比臺(tái)積電其他封裝工廠的總和還要大。雖然這只是潔凈室空間,遠(yuǎn)未配備齊全的工具來實(shí)際提供如此大的容量,但很明顯,臺(tái)積電正在做好準(zhǔn)備,預(yù)計(jì)對其先進(jìn)封裝解決方案的需求會(huì)增加。

稍微有幫助的是晶圓級扇出封裝產(chǎn)能(主要用于智能手機(jī) SoC)的閑置,其中一些產(chǎn)能可以在某些 CoWoS 工藝步驟中重新利用。特別是,存在一些重疊的工藝,例如沉積、電鍍、背面研磨、成型、放置和RDL形成,這將趨勢設(shè)備供應(yīng)鏈發(fā)生了有意義的轉(zhuǎn)變。

雖然市場上還有來自英特爾、三星和 OSAT (例如 ASE 的 FOEB)提供的其他 2.5D 封裝技術(shù),但CoWoS 是唯一一種大批量使用的技術(shù),因?yàn)榕_(tái)積電是迄今為止最主要的 AI 加速器代工廠。甚至Intel Habana的加速器也是由臺(tái)積電制造和封裝的。然而,一些客戶正在尋找臺(tái)積電的替代品。

CoWoS 擁有幾種變體,但原始 CoWoS-S 仍然是大批量生產(chǎn)中的唯一配置。這是如上所述的經(jīng)典配置:邏輯芯片 + HBM 芯片通過帶有 TSV 的硅基中介層連接。然后將中介層放置在有機(jī)封裝基板上。

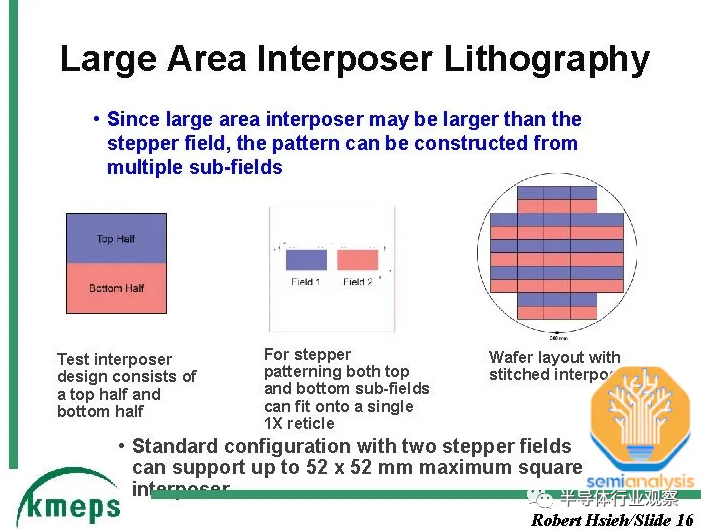

硅中介層的一項(xiàng)支持技術(shù)是一種稱為“reticle stitching”的技術(shù)。由于光刻工具slit/scan最大尺寸芯片的最大尺寸通常為26mm x 33mm 。隨著 GPU 芯片本身接近這一極限,并且還需要在其周圍安裝 HBM,中介層需要很大,并且將遠(yuǎn)遠(yuǎn)超出這一標(biāo)線極限。TSMC 通過reticle stitching解決了這個(gè)問題,這使得他們能夠?qū)⒅薪閷訄D案化為標(biāo)線限制的數(shù)倍(截至目前,AMD MI300 最高可達(dá) 3.5 倍)。

CoWoS-R 在具有重新分布層 (RDL) 的有機(jī)基板上使用,而不是硅中介層。這是一種成本較低的變體,由于使用有機(jī) RDL 而不是硅基中介層,因此犧牲了 I/O 密度。正如我們所詳述的,, AMD 的 MI300 最初是在 CoWoS-R 上設(shè)計(jì)的,但我們認(rèn)為,由于翹曲和熱穩(wěn)定性問題,AMD 必須改用 CoWoS-S。

CoWoS-L 預(yù)計(jì)將在今年晚些時(shí)候推出,并采用 RDL 中介層,但包含嵌入中介層內(nèi)部的用于芯片間互連的有源和/或無源硅橋。這是臺(tái)積電相當(dāng)于英特爾EMIB封裝技術(shù)。隨著硅中介層變得越來越難以擴(kuò)展,這將允許更大的封裝尺寸。MI300 CoWoS-S 可能接近單硅中介層的極限。

對于更大的設(shè)計(jì)來說,使用 CoWoS-L 會(huì)更加經(jīng)濟(jì)。臺(tái)積電正在開發(fā)6x reticle尺寸的 CoWoS-L 超級載具中介層。對于 CoWoS-S,他們沒有提到 4x reticle 之外的任何內(nèi)容。這是因?yàn)楣柚薪閷拥拇嗳跣浴_@種硅中介層只有 100 微米厚,并且在工藝流程中隨著中介層尺寸增大而存在分層或破裂的風(fēng)險(xiǎn)。

審核編輯:劉清

-

DRAM芯片

+關(guān)注

關(guān)注

1文章

84瀏覽量

18004 -

人工智能

+關(guān)注

關(guān)注

1791文章

46882瀏覽量

237636 -

TSV技術(shù)

+關(guān)注

關(guān)注

0文章

17瀏覽量

5668 -

OpenAI

+關(guān)注

關(guān)注

9文章

1044瀏覽量

6411 -

ChatGPT

+關(guān)注

關(guān)注

29文章

1548瀏覽量

7506

原文標(biāo)題:GPU大缺貨,背后的真正原因!

文章出處:【微信號:IC大家談,微信公眾號:IC大家談】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

電力模塊如何在數(shù)據(jù)中心建設(shè)中創(chuàng)新使用?為設(shè)計(jì)提供思路

速看!Atlassian云版與數(shù)據(jù)中心版的創(chuàng)新進(jìn)展

史上首次,AMD在數(shù)據(jù)中心市場的銷售額超過了英特爾!

AMD數(shù)據(jù)中心業(yè)務(wù)收入超越Intel

AMD數(shù)據(jù)中心業(yè)務(wù)首超英特爾,Nvidia異軍突起

NVIDIA 在 Hot Chips 大會(huì)展示提升數(shù)據(jù)中心性能和能效的創(chuàng)新技術(shù)

半導(dǎo)體存儲(chǔ)器在數(shù)據(jù)中心中的應(yīng)用

在數(shù)據(jù)中心使用智能負(fù)載組是個(gè)好主意#負(fù)載 #負(fù)載組

技術(shù)在數(shù)據(jù)中心的應(yīng)用:如何節(jié)省資源和成本

多業(yè)務(wù)光端機(jī)在數(shù)據(jù)中心的應(yīng)用:提升網(wǎng)絡(luò)效率的關(guān)鍵

集中電源控制器在數(shù)據(jù)中心的應(yīng)用

光纖KVM在數(shù)據(jù)中心的應(yīng)用與優(yōu)勢

HBM在數(shù)據(jù)中心的出現(xiàn):AMD的創(chuàng)新如何幫助Nvidia

HBM在數(shù)據(jù)中心的出現(xiàn):AMD的創(chuàng)新如何幫助Nvidia

評論