?論文標(biāo)題:Task-customized Masked Autoencoder via Mixture of Cluster-conditional Experts

?論文標(biāo)題:Task-customized Masked Autoencoder via Mixture of Cluster-conditional Experts論文鏈接:

https://openreview.net/forum?id=j8IiQUM33s

此外,團(tuán)隊(duì)還提出了一種名為混合自編碼器 (MixedAE) 的簡(jiǎn)單而有效的方法,將圖像混合應(yīng)用于 MAE 數(shù)據(jù)增強(qiáng)。MixedAE 在各種下游任務(wù)(包括圖像分類、語義分割和目標(biāo)檢測(cè))上實(shí)現(xiàn)了最先進(jìn)的遷移性能,同時(shí)保持了顯著的效率。這是第一個(gè)從任務(wù)設(shè)計(jì)的角度將圖像混合作為有效數(shù)據(jù)增強(qiáng)策略應(yīng)用于基于純自編碼器結(jié)構(gòu)的 Masked Image Modeling (MIM) 的研究。該工作已被 CVPR 2023 會(huì)議接收。

論文鏈接:

https://arxiv.org/abs/2303.17152 ?

?研究背景

在機(jī)器學(xué)習(xí)領(lǐng)域,預(yù)訓(xùn)練模型已經(jīng)成為一種流行的方法,可以提高各種下游任務(wù)的性能。然而,研究發(fā)現(xiàn),自監(jiān)督預(yù)訓(xùn)練存在的負(fù)遷移現(xiàn)象。諾亞 AI 基礎(chǔ)理論團(tuán)隊(duì)的前期工作 SDR (AAAI 2022) [1] 首次指出自監(jiān)督預(yù)訓(xùn)練的負(fù)遷移問題,并提供初步解決方案。具體來說,負(fù)遷移是指在預(yù)訓(xùn)練過程中使用的數(shù)據(jù)與下游任務(wù)的數(shù)據(jù)分布不同,導(dǎo)致預(yù)訓(xùn)練模型在下游任務(wù)上的性能下降。在自監(jiān)督學(xué)習(xí)中,模型在無標(biāo)簽數(shù)據(jù)上進(jìn)行預(yù)訓(xùn)練,學(xué)習(xí)數(shù)據(jù)的潛在特征和表示。然而,當(dāng)預(yù)訓(xùn)練數(shù)據(jù)與下游任務(wù)的數(shù)據(jù)分布存在顯著差異時(shí),模型可能學(xué)到與下游任務(wù)無關(guān)或甚至有害的特征。

?相關(guān)工作1. 自監(jiān)督預(yù)訓(xùn)練的負(fù)遷移現(xiàn)象

?相關(guān)工作1. 自監(jiān)督預(yù)訓(xùn)練的負(fù)遷移現(xiàn)象

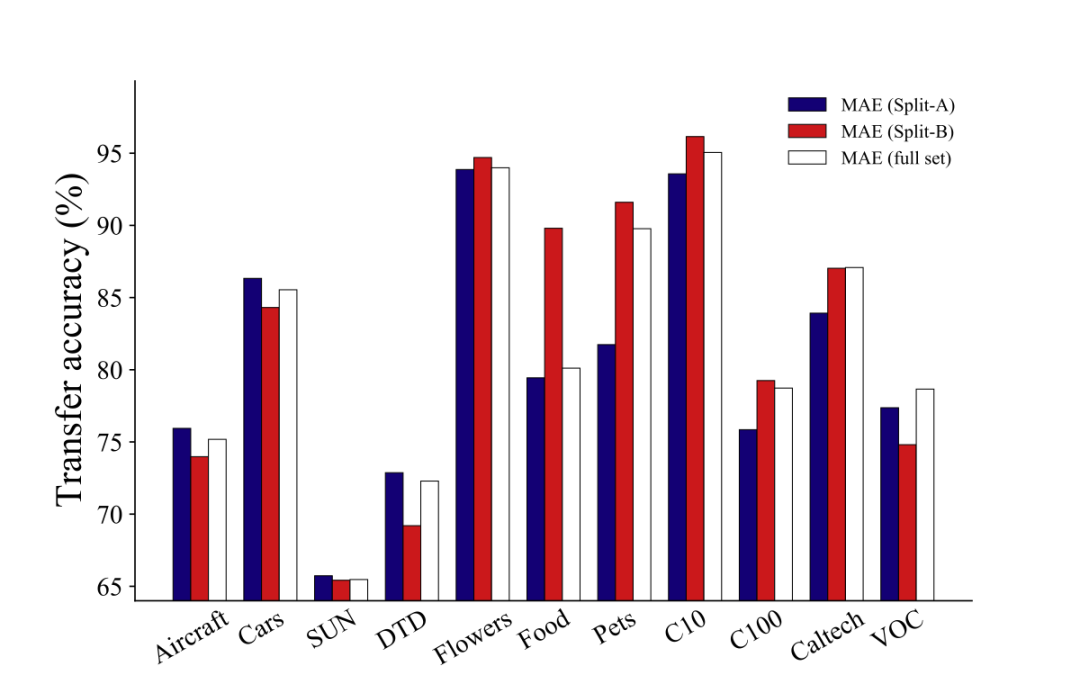

▲圖一:我們用ImageNet的兩個(gè)子集,Split-A和Split-B,訓(xùn)練兩個(gè)MAE模型,和全量數(shù)據(jù)集訓(xùn)練的模型相比較,后者僅在2個(gè)數(shù)據(jù)集上達(dá)到了最優(yōu)。這說明,增大數(shù)據(jù)量并不總是帶來更強(qiáng)的遷移效果。

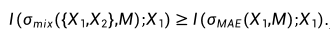

以目前較為流行的自監(jiān)督學(xué)習(xí)算法 MAE 為例,我們?cè)u(píng)估了使用不同語義數(shù)據(jù)進(jìn)行預(yù)訓(xùn)練的 MAE 模型在遷移性能上的表現(xiàn)。我們將 ImageNet 數(shù)據(jù)集分為兩個(gè)不相交的子集 Split-A 和 Split-B,根據(jù) WordNet 樹中標(biāo)簽的語義差異進(jìn)行劃分。Split-A 主要包含無生命物體(如汽車和飛機(jī)),而 Split-B 則主要涉及有機(jī)體(如植物和動(dòng)物)。接著,我們?cè)?Split-A、Split-B 和完整的 ImageNet 數(shù)據(jù)集上分別進(jìn)行了 MAE 預(yù)訓(xùn)練,并在 11 個(gè)下游任務(wù)上評(píng)估了這三個(gè)模型的性能。如圖一所示,在僅含 2 個(gè)語義豐富數(shù)據(jù)集(Caltech,VOC)的情況下,基于完整 ImageNet 訓(xùn)練的 MAE 獲得了最佳的遷移效果;在非生物下游數(shù)據(jù)集 (Aircraft,Cars,SUN,DTD) 上,Split-A 的表現(xiàn)更佳;而在包含 Flowers,F(xiàn)ood,Pets,CIFAR10,CIFAR100 等數(shù)據(jù)集上,Split-B 的表現(xiàn)更優(yōu)。這表明,當(dāng)下游任務(wù)與預(yù)訓(xùn)練數(shù)據(jù)分布不同時(shí),與任務(wù)無關(guān)的預(yù)訓(xùn)練信息可能導(dǎo)致負(fù)遷移,從而限制了 MAE 模型的可擴(kuò)展性。換言之,若一個(gè) MAE 模型的預(yù)訓(xùn)練數(shù)據(jù)去除了與下游任務(wù)數(shù)據(jù)集相似度較低的部分,則其性能可能優(yōu)于包含這些無關(guān)數(shù)據(jù)的預(yù)訓(xùn)練模型。這突顯了開發(fā)針對(duì)特定下游任務(wù)的定制化預(yù)訓(xùn)練方法以避免負(fù)遷移現(xiàn)象的重要性。2. 自監(jiān)督數(shù)據(jù)增強(qiáng)難題在自監(jiān)督預(yù)訓(xùn)練中,與依賴數(shù)據(jù)增強(qiáng)的對(duì)比學(xué)習(xí)不同,我們發(fā)現(xiàn)傳統(tǒng)數(shù)據(jù)增強(qiáng)手段可能會(huì)削弱 MAE 的模型性能。以圖像混合增強(qiáng)(Image Mixing)為例,設(shè)隨機(jī)變量 X1 和 X2 表示兩個(gè)輸入圖像,M 表示隨機(jī)生成的掩碼,我們可以證明混合輸入 σmix({X1,X2},M) 與重構(gòu)目標(biāo) X1 之間的互信息 (MI) 不小于 MAE 輸入 σmae(X1,M) 與 X1 之間的互信息(詳見論文附錄)。 因此,簡(jiǎn)單的圖像混合增強(qiáng)會(huì)提升模型輸入與重構(gòu)目標(biāo)之間的互信息。盡管這對(duì)監(jiān)督學(xué)習(xí)和對(duì)比學(xué)習(xí)有益,但它卻簡(jiǎn)化了 MAE 的圖像重構(gòu)任務(wù),因?yàn)檠诖a操作 (masking) 的根本目的恰恰是降低模型輸入和重構(gòu)目標(biāo)之間的互信息,以減少圖像信號(hào)的冗余。這表明以 MAE 為代表的掩碼圖像建模對(duì)數(shù)據(jù)增強(qiáng)具有與傳統(tǒng)判別式訓(xùn)練范式不同的偏好,進(jìn)而帶來了 MAE 自監(jiān)督學(xué)習(xí)中的數(shù)據(jù)增強(qiáng)難題。

因此,簡(jiǎn)單的圖像混合增強(qiáng)會(huì)提升模型輸入與重構(gòu)目標(biāo)之間的互信息。盡管這對(duì)監(jiān)督學(xué)習(xí)和對(duì)比學(xué)習(xí)有益,但它卻簡(jiǎn)化了 MAE 的圖像重構(gòu)任務(wù),因?yàn)檠诖a操作 (masking) 的根本目的恰恰是降低模型輸入和重構(gòu)目標(biāo)之間的互信息,以減少圖像信號(hào)的冗余。這表明以 MAE 為代表的掩碼圖像建模對(duì)數(shù)據(jù)增強(qiáng)具有與傳統(tǒng)判別式訓(xùn)練范式不同的偏好,進(jìn)而帶來了 MAE 自監(jiān)督學(xué)習(xí)中的數(shù)據(jù)增強(qiáng)難題。

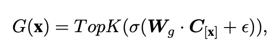

?方法1. MoCEMixture of Cluster-conditional Expert (MoCE) 通過數(shù)據(jù)聚類和顯式地使用具有相似語義的圖像來訓(xùn)練每個(gè)專家,以實(shí)現(xiàn)針對(duì)特定任務(wù)的定制自監(jiān)督預(yù)訓(xùn)練。MoCE 的過程分為三個(gè)階段,具體如下:1. 首先,我們使用預(yù)先訓(xùn)練好的 MAE 模型對(duì)整個(gè)數(shù)據(jù)集進(jìn)行聚類。每張圖片被分到不同的聚類中,并記錄每個(gè)聚類的中心點(diǎn),形成矩陣 C。2. 然后,受 Mixture-of-Experts (MoE) 多專家模型的啟發(fā),我們構(gòu)建了基于聚類先驗(yàn)的 MoCE 模型。與目前常用的視覺多專家模型將每個(gè)圖像的 token 路由到某個(gè)專家不同,MoCE 讓每個(gè)專家負(fù)責(zé)訓(xùn)練一組相似的聚類圖片,使得每個(gè)專家在不同語義數(shù)據(jù)上得到顯式訓(xùn)練。具體來說,現(xiàn)有的視覺多專家模型基于 ViT 構(gòu)建,將原先某些 Transformer Block 中的單個(gè) MLP 層擴(kuò)展為多個(gè) MLP 層,每個(gè) MLP 被稱作一個(gè)專家 (expert)。同時(shí)引入一個(gè)門控網(wǎng)絡(luò) (gate network),該門控網(wǎng)絡(luò)決定每個(gè) token 應(yīng)該去往哪個(gè)專家。MoCE 多專家層的核心改變是門控網(wǎng)絡(luò)的輸入:

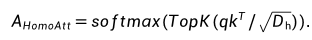

?方法1. MoCEMixture of Cluster-conditional Expert (MoCE) 通過數(shù)據(jù)聚類和顯式地使用具有相似語義的圖像來訓(xùn)練每個(gè)專家,以實(shí)現(xiàn)針對(duì)特定任務(wù)的定制自監(jiān)督預(yù)訓(xùn)練。MoCE 的過程分為三個(gè)階段,具體如下:1. 首先,我們使用預(yù)先訓(xùn)練好的 MAE 模型對(duì)整個(gè)數(shù)據(jù)集進(jìn)行聚類。每張圖片被分到不同的聚類中,并記錄每個(gè)聚類的中心點(diǎn),形成矩陣 C。2. 然后,受 Mixture-of-Experts (MoE) 多專家模型的啟發(fā),我們構(gòu)建了基于聚類先驗(yàn)的 MoCE 模型。與目前常用的視覺多專家模型將每個(gè)圖像的 token 路由到某個(gè)專家不同,MoCE 讓每個(gè)專家負(fù)責(zé)訓(xùn)練一組相似的聚類圖片,使得每個(gè)專家在不同語義數(shù)據(jù)上得到顯式訓(xùn)練。具體來說,現(xiàn)有的視覺多專家模型基于 ViT 構(gòu)建,將原先某些 Transformer Block 中的單個(gè) MLP 層擴(kuò)展為多個(gè) MLP 層,每個(gè) MLP 被稱作一個(gè)專家 (expert)。同時(shí)引入一個(gè)門控網(wǎng)絡(luò) (gate network),該門控網(wǎng)絡(luò)決定每個(gè) token 應(yīng)該去往哪個(gè)專家。MoCE 多專家層的核心改變是門控網(wǎng)絡(luò)的輸入: 這里,C[x] 表示 token x 所屬圖片所在的聚類中心(我們?cè)诘谝徊揭呀?jīng)完成了聚類),而不是原先的 token 嵌入。這樣,屬于同一個(gè)聚類的圖片的 tokens 都會(huì)被路由到同一個(gè)專家,從而顯式地區(qū)分每個(gè)專家在語義上的差異。為了穩(wěn)定訓(xùn)練并增強(qiáng)門控網(wǎng)絡(luò)的置信度,我們提出了兩個(gè)額外的正則化損失,并在實(shí)驗(yàn)中發(fā)現(xiàn)了它們的有效性。3. 當(dāng)下游任務(wù)到達(dá)時(shí),我們引入了一個(gè)搜索模塊來選擇最適合用于遷移學(xué)習(xí)的專家。具體而言,我們重復(fù)利用第一步提到的聚類模塊,找到與下游數(shù)據(jù)集最相似的聚類,然后找到該聚類所訓(xùn)練的專家,將其單獨(dú)提取出來,舍棄其他專家進(jìn)行遷移。這樣,在下游任務(wù)中,我們始終使用一個(gè)正常大小的 ViT 模型。2. MixedAEMixed Autoencoder (MixedAE) 提出輔助代理任務(wù)——同源識(shí)別(Homologous recognition),旨在顯示要求每個(gè)圖像塊識(shí)別混合圖像中的同源圖像塊以緩解圖像混合所導(dǎo)致的互信息上升,從而實(shí)現(xiàn)物體感知的自監(jiān)督預(yù)訓(xùn)練。MixedAE 的過程分為三個(gè)階段,具體如下:1. 混合階段:在給定混合系數(shù) r 的情況下,將輸入圖像隨機(jī)劃分為不同的圖像組,并根據(jù) r 對(duì)每個(gè)圖像組進(jìn)行隨機(jī)混合,生成混合圖像。2. 識(shí)別階段:鑒于 Vision Transformer 中全局自注意力的使用,在重構(gòu)過程中,各個(gè)圖像塊不可避免地與來自其他圖像的異源圖像塊發(fā)生交互,從而導(dǎo)致互信息的上升。因此我們提出同源自注意力機(jī)制 (Homologous attention),通過部署一個(gè)簡(jiǎn)單的 TopK 采樣操作,要求每個(gè)圖像塊顯示識(shí)別并僅與同源圖像塊做自注意力計(jì)算,以抑制互信息的上升。

這里,C[x] 表示 token x 所屬圖片所在的聚類中心(我們?cè)诘谝徊揭呀?jīng)完成了聚類),而不是原先的 token 嵌入。這樣,屬于同一個(gè)聚類的圖片的 tokens 都會(huì)被路由到同一個(gè)專家,從而顯式地區(qū)分每個(gè)專家在語義上的差異。為了穩(wěn)定訓(xùn)練并增強(qiáng)門控網(wǎng)絡(luò)的置信度,我們提出了兩個(gè)額外的正則化損失,并在實(shí)驗(yàn)中發(fā)現(xiàn)了它們的有效性。3. 當(dāng)下游任務(wù)到達(dá)時(shí),我們引入了一個(gè)搜索模塊來選擇最適合用于遷移學(xué)習(xí)的專家。具體而言,我們重復(fù)利用第一步提到的聚類模塊,找到與下游數(shù)據(jù)集最相似的聚類,然后找到該聚類所訓(xùn)練的專家,將其單獨(dú)提取出來,舍棄其他專家進(jìn)行遷移。這樣,在下游任務(wù)中,我們始終使用一個(gè)正常大小的 ViT 模型。2. MixedAEMixed Autoencoder (MixedAE) 提出輔助代理任務(wù)——同源識(shí)別(Homologous recognition),旨在顯示要求每個(gè)圖像塊識(shí)別混合圖像中的同源圖像塊以緩解圖像混合所導(dǎo)致的互信息上升,從而實(shí)現(xiàn)物體感知的自監(jiān)督預(yù)訓(xùn)練。MixedAE 的過程分為三個(gè)階段,具體如下:1. 混合階段:在給定混合系數(shù) r 的情況下,將輸入圖像隨機(jī)劃分為不同的圖像組,并根據(jù) r 對(duì)每個(gè)圖像組進(jìn)行隨機(jī)混合,生成混合圖像。2. 識(shí)別階段:鑒于 Vision Transformer 中全局自注意力的使用,在重構(gòu)過程中,各個(gè)圖像塊不可避免地與來自其他圖像的異源圖像塊發(fā)生交互,從而導(dǎo)致互信息的上升。因此我們提出同源自注意力機(jī)制 (Homologous attention),通過部署一個(gè)簡(jiǎn)單的 TopK 采樣操作,要求每個(gè)圖像塊顯示識(shí)別并僅與同源圖像塊做自注意力計(jì)算,以抑制互信息的上升。 3. 驗(yàn)證階段:為了驗(yàn)證同源自注意力的準(zhǔn)確性,我們提出同源對(duì)比損失 (Homologous contrasitve)。對(duì)于任意查詢圖像塊 (query patch),我們將其同源圖像塊視為正樣本,異源圖像塊作為負(fù)樣本,以促進(jìn)同源圖像塊特征的相似度,從而顯示要求圖像塊識(shí)別并僅和同源圖像塊做自注意力計(jì)算。最后,同源對(duì)比損失將和原始圖像重構(gòu)損失一起以多任務(wù)形式優(yōu)化網(wǎng)絡(luò)參數(shù)進(jìn)行自監(jiān)督預(yù)訓(xùn)練。

3. 驗(yàn)證階段:為了驗(yàn)證同源自注意力的準(zhǔn)確性,我們提出同源對(duì)比損失 (Homologous contrasitve)。對(duì)于任意查詢圖像塊 (query patch),我們將其同源圖像塊視為正樣本,異源圖像塊作為負(fù)樣本,以促進(jìn)同源圖像塊特征的相似度,從而顯示要求圖像塊識(shí)別并僅和同源圖像塊做自注意力計(jì)算。最后,同源對(duì)比損失將和原始圖像重構(gòu)損失一起以多任務(wù)形式優(yōu)化網(wǎng)絡(luò)參數(shù)進(jìn)行自監(jiān)督預(yù)訓(xùn)練。

?

?實(shí)驗(yàn)分析

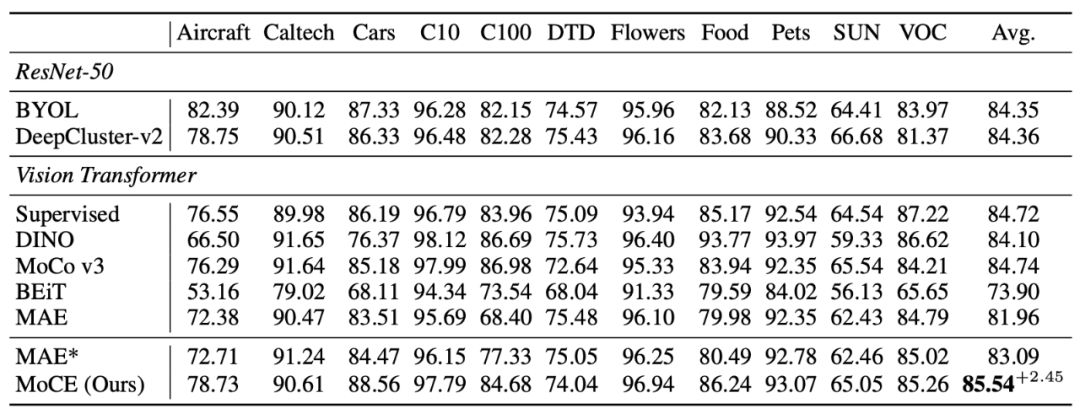

1. MoCE我們?cè)谥疤岬降?11 個(gè)下游分類數(shù)據(jù)集和檢測(cè)分割任務(wù)上做了實(shí)驗(yàn)。實(shí)驗(yàn)結(jié)果表明,MoCE 在多個(gè)下游任務(wù)中的性能超過了傳統(tǒng)的 MAE 預(yù)訓(xùn)練方法。具體而言,在圖像分類任務(wù)中,MoCE 相較于 MAE 實(shí)現(xiàn)了更高的準(zhǔn)確率。在目標(biāo)檢測(cè)和分割任務(wù)中,MoCE 也取得了更好的表現(xiàn),包括更高的 mIoU 和 AP 指標(biāo)。這些實(shí)驗(yàn)結(jié)果表明,MoCE 通過利用相似語義圖像進(jìn)行聚類并為每個(gè)專家進(jìn)行任務(wù)定制的自監(jiān)督預(yù)訓(xùn)練,能夠在各種下游任務(wù)中提高遷移性能。

▲表一:MoCE在細(xì)粒度數(shù)據(jù)集上有較大提升,在類別比較寬泛的任務(wù)上也有少量提升。2. MixedAE

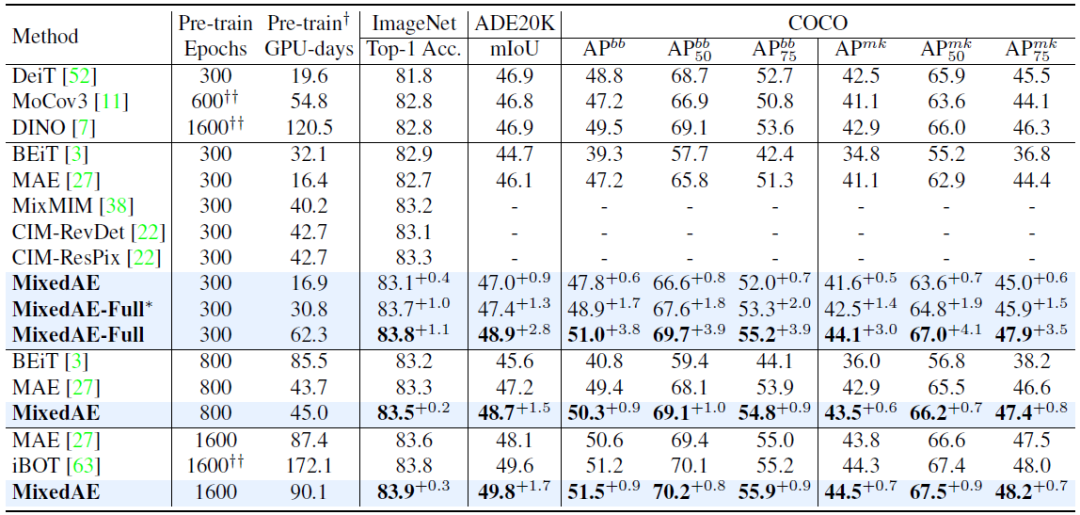

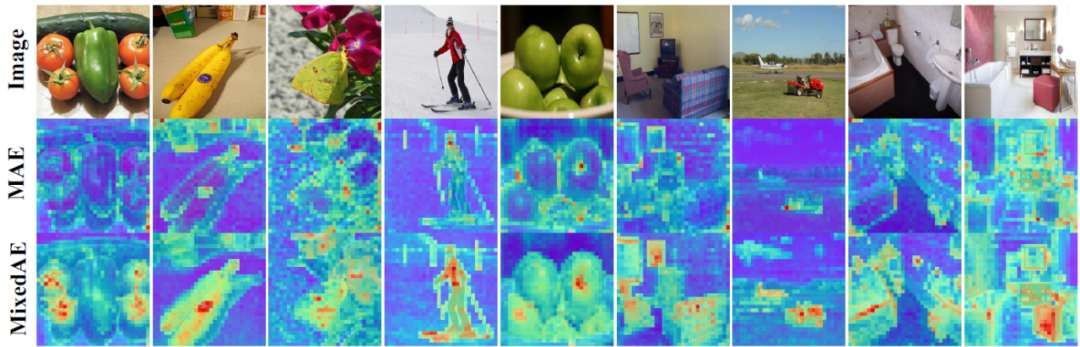

▲表一:MoCE在細(xì)粒度數(shù)據(jù)集上有較大提升,在類別比較寬泛的任務(wù)上也有少量提升。2. MixedAE在 14 個(gè)下游視覺任務(wù)(包括圖像分類、語義分割和物體檢測(cè))的評(píng)估中,MixedAE 展現(xiàn)了最優(yōu)的遷移性能和卓越的計(jì)算效率。相較于 iBOT,MixedAE 實(shí)現(xiàn)了約 2 倍預(yù)訓(xùn)練加速。得益于圖像混合所帶來的物體感知預(yù)訓(xùn)練,MixedAE 在下游密集預(yù)測(cè)任務(wù)上取得更顯著的性能提升。注意力圖可視化結(jié)果表明,MixedAE 能比 MAE 更準(zhǔn)確完整地識(shí)別圖像前景物體,從而實(shí)現(xiàn)優(yōu)異的密集預(yù)測(cè)遷移性能。

▲表二:MixedAE在不同訓(xùn)練代價(jià)下均獲得當(dāng)前最優(yōu)結(jié)果,展現(xiàn)了卓越的計(jì)算效率。

▲表二:MixedAE在不同訓(xùn)練代價(jià)下均獲得當(dāng)前最優(yōu)結(jié)果,展現(xiàn)了卓越的計(jì)算效率。

▲圖二:注意力圖可視化。得益于ImageNet的單實(shí)例假設(shè)[2]以及物體感知的自監(jiān)督預(yù)訓(xùn)練,MixedAE可以更準(zhǔn)確完整地發(fā)現(xiàn)圖像前景物體,從而實(shí)現(xiàn)更好的密集預(yù)測(cè)遷移性能。

?作者介紹結(jié)合 MoCE 和 MixedAE 的研究發(fā)現(xiàn),我們揭示了自監(jiān)督預(yù)訓(xùn)練中數(shù)據(jù)之謎:數(shù)據(jù)量不再是唯一關(guān)鍵因素,而是如何利用數(shù)據(jù)和進(jìn)行定制化預(yù)訓(xùn)練和數(shù)據(jù)增廣更為關(guān)鍵。MoCE 通過數(shù)據(jù)聚類和專家定制訓(xùn)練,顯著提高了針對(duì)特定下游任務(wù)的遷移性能。MixedAE 則通過一種簡(jiǎn)單有效的圖像混合方法,實(shí)現(xiàn)了在各種下游任務(wù)中的最先進(jìn)遷移性能。這些研究發(fā)現(xiàn)不僅為自監(jiān)督預(yù)訓(xùn)練領(lǐng)域提供了新的視角,還為開發(fā)更為高效、可擴(kuò)展和定制化的預(yù)訓(xùn)練方法提供了指導(dǎo)和啟示。我們希望這些探索是一個(gè)有效利用更多數(shù)據(jù)量的途徑,并為研究者們提供新的思路。

?作者介紹結(jié)合 MoCE 和 MixedAE 的研究發(fā)現(xiàn),我們揭示了自監(jiān)督預(yù)訓(xùn)練中數(shù)據(jù)之謎:數(shù)據(jù)量不再是唯一關(guān)鍵因素,而是如何利用數(shù)據(jù)和進(jìn)行定制化預(yù)訓(xùn)練和數(shù)據(jù)增廣更為關(guān)鍵。MoCE 通過數(shù)據(jù)聚類和專家定制訓(xùn)練,顯著提高了針對(duì)特定下游任務(wù)的遷移性能。MixedAE 則通過一種簡(jiǎn)單有效的圖像混合方法,實(shí)現(xiàn)了在各種下游任務(wù)中的最先進(jìn)遷移性能。這些研究發(fā)現(xiàn)不僅為自監(jiān)督預(yù)訓(xùn)練領(lǐng)域提供了新的視角,還為開發(fā)更為高效、可擴(kuò)展和定制化的預(yù)訓(xùn)練方法提供了指導(dǎo)和啟示。我們希望這些探索是一個(gè)有效利用更多數(shù)據(jù)量的途徑,并為研究者們提供新的思路。

參考文獻(xiàn)

?

?[1] Task-customized Self-supervised Pre-training with Scalable Dynamic Routing, AAAI 2022.

[2] MultiSiam: Self-supervised Multi-instance Siamese Representation Learning for Autonomous Driving, ICCV 2021.

·

原文標(biāo)題:基礎(chǔ)模型自監(jiān)督預(yù)訓(xùn)練的數(shù)據(jù)之謎:大量數(shù)據(jù)究竟是福還是禍?

文章出處:【微信公眾號(hào):智能感知與物聯(lián)網(wǎng)技術(shù)研究所】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

-

物聯(lián)網(wǎng)

+關(guān)注

關(guān)注

2903文章

44272瀏覽量

371234

原文標(biāo)題:基礎(chǔ)模型自監(jiān)督預(yù)訓(xùn)練的數(shù)據(jù)之謎:大量數(shù)據(jù)究竟是福還是禍?

文章出處:【微信號(hào):tyutcsplab,微信公眾號(hào):智能感知與物聯(lián)網(wǎng)技術(shù)研究所】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

PCM1861 INT腳究竟是輸出還是輸入?

AI大模型的訓(xùn)練數(shù)據(jù)來源分析

直播預(yù)約 |數(shù)據(jù)智能系列講座第4期:預(yù)訓(xùn)練的基礎(chǔ)模型下的持續(xù)學(xué)習(xí)

基礎(chǔ)模型自監(jiān)督預(yù)訓(xùn)練的數(shù)據(jù)之謎:大量數(shù)據(jù)究竟是福還是禍?

基礎(chǔ)模型自監(jiān)督預(yù)訓(xùn)練的數(shù)據(jù)之謎:大量數(shù)據(jù)究竟是福還是禍?

評(píng)論