北京2023年8月8日/美通社/ -- 冬瓜哥上次學習AI和ML,還是在2019年初。當時其實是卷積神經網絡和深度神經網絡蓬勃發展期,其主要目的是分類識別。當時冬瓜哥還做了一個4小時的視頻,那真是我見過的最小白的白也能輕松入門,理清楚最基本的名詞概念關系的視頻了,沒有之一。那時候利用AI生成一些藝術作品已經初見雛形,但是非常不成熟,基本上都是僅供娛樂。我記得曾經至少有兩部科幻電影描述過(比如《機械公敵》,《Finch》),也許做夢對于一個機器人來講,是一種超級進化的開端。

生成式AI,AI2.0

時過境遷。短短幾年內,新的不同于傳統分類器的模型Transformer,讓AI再一次革新。以往的RNN在自然語言處理訓練方面的并行度不是很好,需要太多通信,處理長句子時效率比較低。而Transformer模型從新的維度上解決了這個問題,高并行度讓GPU訓練效率大幅提升。這個過程,感覺像極了當年分布式系統興起的時候,大家也是拿著幾篇經典論文翻來覆去的研讀,然后開始用開源軟件,最后逐漸發展出自己的技術。

當AI突破了人類語言這道關卡,后續就有點一馬平川的感覺了。因為人類知識目前主要儲存在各種語言文本當中。再結合對圖片、聲音等各種信息的數字化映射和分析,讓AI能夠運行于多模態模式下,能夠更好的理解字里行間的信息,更精細化的生成對應的內容,走進了現實。

多模態生成式AI(AI Generated Content,AIGC)是指通過生成和分析多種模態的數據,如文本、圖像、音頻、視頻等,以實現更加豐富和精準的智能應用。與傳統機器學習方法相比,多模態生成式AI能夠充分利用多種數據之間的關聯性,提高模型的泛化能力和魯棒性。生產式AI是人工智能從1.0時代進入2.0時代的重要標志,其具備強大的認知智能,在搜索引擎、藝術創作、影音游戲、文本生成、語音生成、圖片生成、視頻生成、代碼生成、虛擬人生成以及金融、教育、醫療、工業等領域有著廣闊的應用前景。

Gartner預測,到2023年將有20%的內容被AIGC所創建;到2025 年人工智能生成數據占比將達到10%。據分析師預測,到2032年,生成式人工智能市場規模將達到2,000億美元,占據人工智能支出總額的約20%,顯著高出當前的5%。換言之,未來十年市場規模可能每兩年就會翻一番。

生成式AI的背后是基于行業上下游對數據進行采集、標注、訓練、推理、歸檔,其特征是數據量大、多元數據類型復雜、服務協議多樣、性能要求苛刻、要求服務持續在線。由于多模態數據具有復雜性和多樣性,因此多模態生成式AI需要具備以下特點:

跨模態數據融合:能夠將不同模態的數據進行有效的融合,以提取更豐富的信息。

跨語言理解:能夠理解不同語言之間的語義差異,提高跨語言應用的準確性。

上下文感知:能夠根據上下文信息進行智能推斷和預測,提高應用的場景適應能力。

知識表示:能夠將知識和信息進行有效的表示,以支持更高級別的認知和決策。

革新帶來的新挑戰,現有存儲系統還能不能打?

多模態生成式AI系統本身是一個大規模集群,無論是集中式存儲還是本地直連存儲,都早已無法滿足該系統對存儲性能和容量的基本需求。另外,以機械硬盤構建的任何存儲系統,也根本無法承擔生成式AI對存儲系統帶寬和時延的要求。總的來講,生成式AI在存儲方面所面臨的挑戰如下:

大型數據集:隨著數據和模型規模的增長,獨立存儲無法滿足應用需求。因此,解決這些問題的分布式存儲解決方案勢在必行。

歷史數據的完整歸檔:在某些場景下,AI集群每天都會產生大量新的數據集,必須將其歸檔為歷史數據。這在自動駕駛領域尤為重要,道路測試車輛收集的數據(例如雷達和攝像頭數據)對于公司來說是非常有價值的資產。在這些情況下,獨立存儲被證明是不夠的,因此分布式存儲成為必要的考慮因素。

小文件和非結構化數據過多:傳統分布式文件系統難以管理大量小文件,導致元數據存儲負擔過重。這對于視覺模型來說尤其成問題。為了解決這個問題,需要一個針對小文件存儲進行優化的分布式存儲系統。這樣既保證了上層訓練任務的高效進行,又保證了海量小文件的輕松管理。

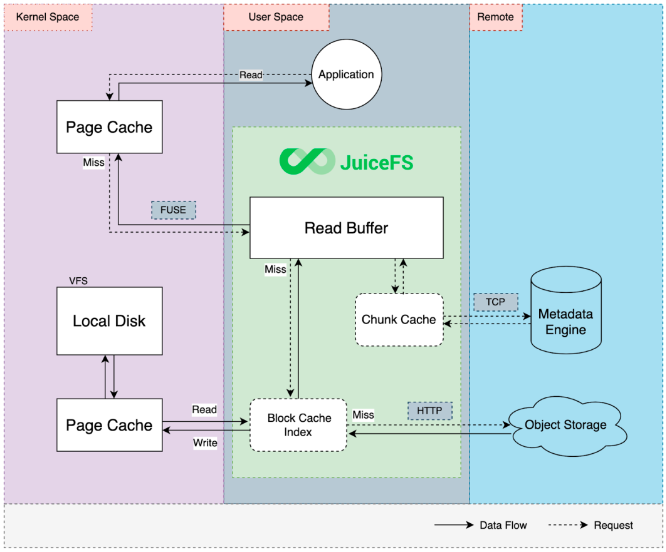

云訓練數據I/O效率低:云模型訓練往往采用對象存儲作為存儲計算分離架構的底層存儲。然而,對象存儲較差的讀寫性能可能會導致訓練過程中出現嚴重的瓶頸。

異構數據的融合:生成式AI訓練模型的數據呈現來源多、格式多的多源異構現狀,傳統存儲面向單一數據類型設計,需要以搬移數據的方式實現多協議訪問,存儲成為應用平臺的關鍵瓶頸。

持續的低延遲與高帶寬:模型訓練過程中,頻繁的從數據集取Token,每個Token一般4字節,實時高并發小IO性能需要極低的延遲;存儲模型Checkpoint時,為Checkpoint數據可快速寫入,需要高帶寬。

EB級大容量存儲需求:越多的數據投喂結果越精準的工作原理,決定了大模型訓練存在深度學習網絡層數多、連接多、參數和數據集種類復雜、數據量大的特征,隨著模型參數和數據量的快速增長,對于存儲的大容量和擴展需求也迫在眉睫。

數據存儲產業需要進行全方位的技術升級,通過在多源異構融合、數據高速傳輸、海量數據管理等方面持續創新,打造專業的生成式AI存儲產品與解決方案。

塊,文件,對象,哪種存儲方式最好?

塊存儲

傳統觀點認為,低延遲高帶寬場景,使用塊存儲是最佳方案。然而,塊存儲在可擴展性方面卻不能令人滿意。AI集群必須在數據量、數據類型、決策速度,當然還有預算方面進行平衡。AI訓練環境對實時運行的基于網絡的推薦引擎提出了不同的要求。塊存儲傳統上非常適合高吞吐量和高I/O工作負載,其中低延遲非常重要,然而,隨著現代數據分析工作負載(包括人工智能、機器學習甚至數據湖)的出現,人們發現傳統的基于塊的平臺缺乏滿足這些平臺計算方面所產生的橫向擴展需求的能力。因此,必須采用基于文件和對象的方法來支持這些現代工作負載。

文件和對象

因此,系統架構師更傾向于基于文件或對象的AI 和 ML 存儲。對象存儲在構建時考慮到了 PB 級大容量,并且是按規模構建的,還支持物聯網 (IoT) 等應用。對象存儲在性能方面落后于塊存儲系統,盡管隨著更新的高性能對象技術的出現,差距正在縮小。另外一個需要考慮的因素是,AI應用程序支持的存儲訪問接口各不相同,并非所有人工智能、機器學習或分析工具都支持 AWS 的 S3 接口(對象的事實標準)。

云儲存

云存儲主要是基于對象的,但為人工智能和機器學習項目提供了其他優勢。其中最主要的是靈活性和較低的前期成本。云存儲的主要缺點是延遲和潛在的數據傳輸成本。云存儲對于基于云的人工智能和機器學習系統來說是一個不錯的選擇,對于長期數據歸檔來說還是劃算的。

綜上,傳統觀點認為,沒有單一選項可以滿足人工智能、機器學習和分析的所有存儲需求。然而這個觀點在浪潮信息AS13000這個老牌分布式存儲系統面前就顯得有點過于武斷了。

浪潮信息生成式AI存儲解決方案

浪潮信息生成式AI存儲解決方案用一套AS13000融合存儲支撐生成式AI的全階段應用,提供全閃、混閃、帶庫、光盤四種介質,支持文件、對象、大數據、視頻、塊協議,可滿足大容量、多協議共享,百萬以上IOPS,100GB以上帶寬,冷數據的長期保存和歸檔。結合AIGC數據處理的五個階段:數據采集、數據準備、數據訓練、數據推理和數據歸檔,由同一套存儲提供端到端的數據流支持流程,滿足面向文本、音頻、圖像、視頻、代碼以及多模態和全模態的模型需求。

浪潮信息生成式AI存儲解決方案擁有極致融合、極致性能、極致節能,和熱溫冷冰四級全生命周期存儲管理四大特點,助力AIGC突破海量數據存力瓶頸,加速釋放數據的AI價值:

極致融合。為了應對不同模態的多樣性需求,浪潮信息提出協議融合設計理念,一個集群內支持多個存儲池,一個存儲池內支持文本、圖片、音頻、視頻等多種類型數據存儲,一份數據又可以被前端不同業務場景以文件、對象、大數據以及視頻的存儲方式進行并行訪問。用一套存儲實現多模態場景應用,應用間數據實現實時共享,同時節省了大量的存儲空間。

極致性能。AIGC場景數據類型多樣化,文件大小不一數量多,且讀寫頻繁,對存儲系統的100GB級帶寬、100萬級IOPS需求成了常態。浪潮信息在軟件方面,通過數控分離架構減少東西向數據量的轉發,通過GDS、RMDA技術縮短I/O路徑,通過SPDK、緩存零拷貝技術減少I/O路徑上的數據拷貝,以及基于自研NVMe SSD開發的盤控協同技術,減少I/O訪問SSD盤的次數,使存儲性能得到進一步釋放。在硬件方面,優化IO路徑通道,均衡IO路徑,最大化發揮硬件性能,全閃單節點帶寬超過50GB/s,IOPS超過50萬;創新性的引入雙控全閃節點,帶寬超過100GB/s,IOPS超過100萬,真正使系統達到了TB級帶寬、千萬級IOPS、EB級帶寬。

極致節能。浪潮信息最新發布的G7硬件平臺,存儲專用的液冷服務器涵蓋性能型和容量型,且均采用模塊化冷板組件設計模式。在系統方案層面,浪潮信息具有風液式,液液式等完善的端到端解決方案,能夠為用戶全方位打造液冷數據中心交鑰匙工程,并且完成了業界首次液冷整機柜批量交付,實現PUE<1.1。

端到端的全生命周期管理。浪潮生成式AI存儲方案采用閃存、磁盤、磁帶、光盤四種介質提供熱溫冷冰四種存儲資源,且實現了資源的互通和數據全生命周期的管理。基于數據的熱度識別,自動釋放在線存儲空間,可以將海量數據自動歸檔到光盤庫,降低長期存儲成本;實現冷數據的分鐘級快速回調,滿足0~4級應用的存儲需求。四種介質、四類存儲節點,提供熱溫冷冰自動流轉,滿足各類應用的靈活配置需求,通過性能型、均衡型、容量型、高密容量型四種機型的按需靈活配置,進一步降低整體投入。

浪潮信息自研的源大模型

目前,浪潮信息生成式AI存儲解決方案已經在全球領先的中文語言大模型"源1.0"中成功落地。"源"中文語言大模型有近2500億個模型參數,算力消耗達4000+PetaFlop/s-day,底層采用AS13000并行存儲支撐,原始數據、經過粗篩和精篩的處理后得到高質量中文數據都集中在AS13000上。

模型訓練過程中對存儲的挑戰主要有對小文件并發的性能,和訓練過程中要求快速保存Checkpoint存檔文件的高速寬寫入要求。AS13000采用最新硬件平臺,搭載全閃SSD和高速IB網絡,支撐源的訓練過程高效完成。

據測算,GPT-3使用10000塊GPU、花了30天訓練完成1750億參數,"源1.0"在2128個GPU集群上跑了16天完成了訓練,源1.0的算力效率達到44.8%,遠超MT-NLG與GPT-3等國際知名模型,其中存儲的極致性能功不可沒。

某AI獨角獸公司

該公司計劃發布5000億參數量的NLP語言類大模型,為了極致的提升計算效率,采用了計算網絡和存儲網絡分離的設計,計算網絡采用高速IB、存儲網絡選擇了RoCE,并對于存儲提出了明確要求:不小于3.5PB的高速存儲,性能要求帶寬300GB,IOPS 350萬以上。客戶從專業性、開發成本、周期及運維等方面進行全面評估后,選擇浪潮信息AS13000分布式全閃存儲集群,支持高性能RocE組網和GPU直通存儲功能,為算力集群提供高性能低延時的數據讀取保障。同時隨著業務的上線,進行了兩次在線存儲擴容,具有非常好的靈活性和容量性能線性擴展能力。

隨著AIGC時代的到來,浪潮信息作為最早布局AIGC大模型的企業之一,持續圍繞"新存儲之道"的理念,持續打造平臺型存儲產品,應對智能時代、AIGC時代的存儲挑戰。

本文作者 | 大話存儲 冬瓜哥

審核編輯 黃宇

-

AI

+關注

關注

87文章

30239瀏覽量

268479 -

存儲系統

+關注

關注

2文章

405瀏覽量

40842 -

人工智能

+關注

關注

1791文章

46896瀏覽量

237670 -

AIGC

+關注

關注

1文章

357瀏覽量

1512 -

大模型

+關注

關注

2文章

2339瀏覽量

2500 -

生成式AI

+關注

關注

0文章

489瀏覽量

460

發布評論請先 登錄

相關推薦

一種針對存儲系統設計的應用級緩存回收策略

關于騰訊的開源分布式存儲系統DCache

盤點分布式存儲系統的主流框架

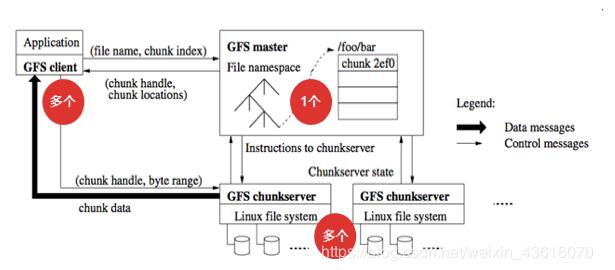

分布式文件存儲系統GFS的基礎知識

一文詳解LeoStor并行存儲系統

如何使用分布式存儲系統促進AI模型訓練

智慧有數 浪潮信息發布生成式AI存儲解決方案

存儲系統如何支持大模型生成式AI

存儲系統如何支持大模型生成式AI

存儲系統如何支持大模型生成式AI

評論