芯東西8月9日報道,作為生成式AI、圖形顯示和元宇宙基礎設施領域的“狠角色”,全球圖顯兼AI計算霸主NVIDIA(英偉達)接下來會放出哪些重磅“核彈”,已經預定了科技圈的焦點。

北京時間昨夜,在計算機圖形年會SIGGRAPH上,NVIDIA創始人兼CEO黃仁勛一如既往穿著經典的皮衣登場,并一連亮出多款硬件。

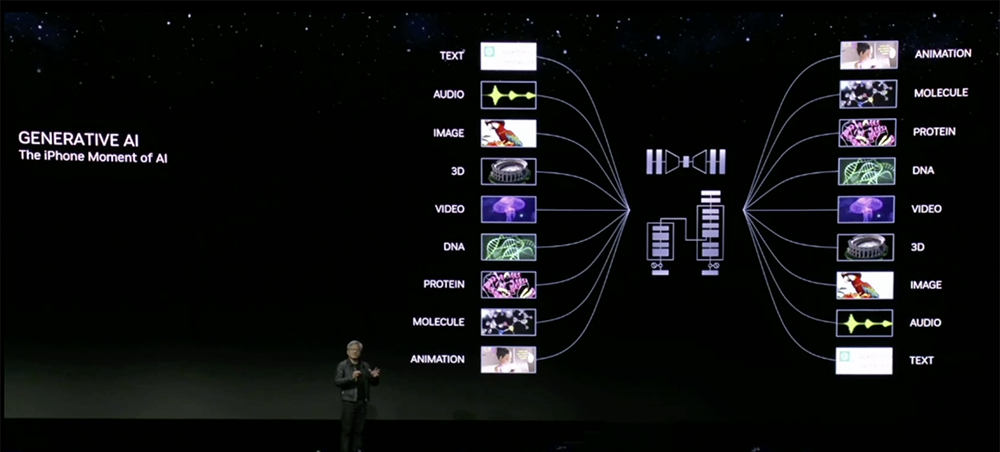

在黃仁勛眼中,生成式AI是AI的“iPhone時刻”。他談道,人類語言是新的編程語言,我們已經使計算機科學民主化,現在每個人都可以成為程序員。

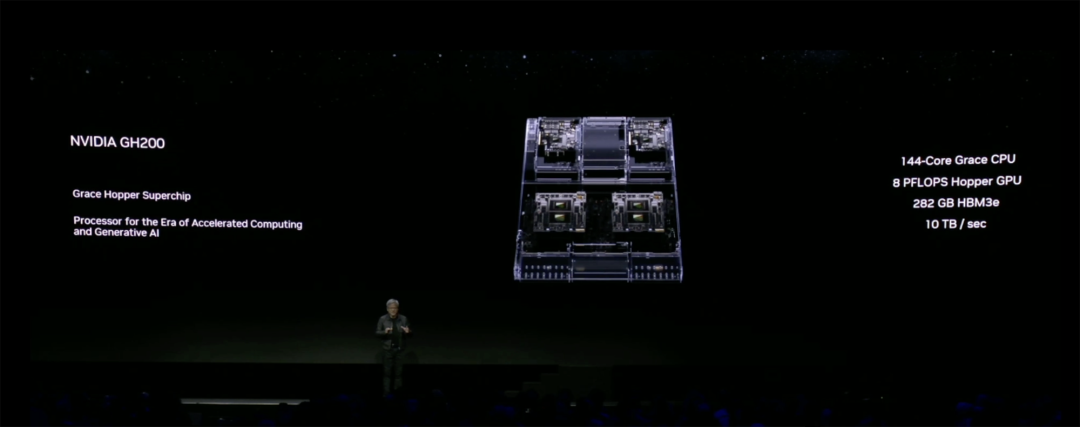

在隨后大約1小時20分鐘的演講中,黃仁勛宣布全球首發HBM3e內存——推出下一代GH200 Grace Hopper超級芯片。黃仁勛將它稱作“加速計算和生成式AI時代的處理器”。

還有5款硬件新品同期重磅發布,分別是搭載全新L40S Ada GPU的新款OVX服務器、搭載RTX 6000 Ada GPU的全新RTX工作站,以及3款高端桌面工作站GPU。

除此之外,黃仁勛還介紹了一系列軟件更新和合作進展,總體來說都是為了幫助開發人員和企業進一步提高效率,降低開發門檻。

01. 配備全球最快內存的超級芯片來了!大降大模型推理成本

首先,全球第一款HBM3e GPU終于來了!

黃仁勛宣布推出面向加速計算和生成式AI的新一代NVIDIA GH200 Grace Hopper超級芯片。

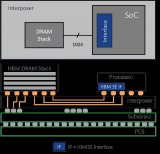

GH200由72核Grace CPU和4PFLOPS Hopper GPU組成,在全球最快內存HBM3e的“助攻”下,內存容量高達141GB,提供每秒5TB的帶寬。其每個GPU的容量達到NVIDIA H100 GPU的1.7倍,帶寬達到H100的1.55倍。

該超級芯片可以用于任何大型語言模型,降低推理成本。

與當前一代產品相比,新的雙GH200系統共有144個Grace CPU核心、8PFLOPS計算性能的GPU、282GB HBM3e內存,內存容量達3.5倍,帶寬達3倍。如果將連接到CPU的LPDDR內存包括在內,那么總共集成了1.2TB超快內存。

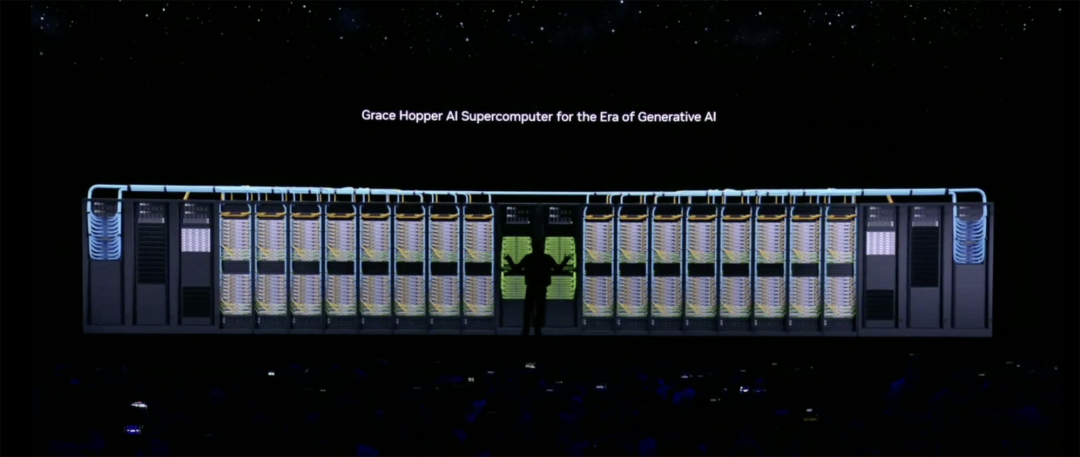

GH200將在新的服務器設計中提供,黃仁勛還放出了一段動畫視頻,展示組裝面向生成式AI時代的Grace Hopper AI超級計算機的完整過程。

首先是一塊Grace Hopper,用高速互連的CPU-GPU Link將CPU和GPU“粘”在一起,通信速率比PCIe Gen5快7倍。

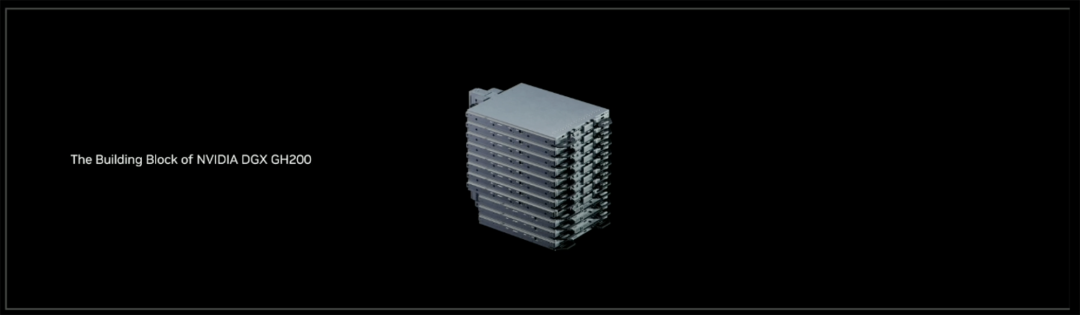

一個Grace Hopper機架裝上NVIDIA BlueField-3和ConnectX-7網卡、8通道4.6TB高速內存,用NVLink Switch實現GPU之間的高速通信,再加上NVLink Cable Cartridge,組成了NVIDA DGX GH200構建塊。

NVIDA DGX GH200由16個Grace Hopper機架,通過NVLink Switch系統連成集群,能讓256塊GPU組成的系統像一塊巨型GPU一樣工作。由256塊GH200組成的NVIDIA DGX GH200 SuperPod,擁有高達1EFLOPS的算力和144TB高速內存。

NVIDIA Quantum-2 InfiniBand Switch可用高速、低延時的網絡連接多個DGX SuperPod,進而搭建出面向生成式AI時代的Grace Hopper AI超級計算機。

這帶來的主要優勢是,實現同等算力的情況下,用更少卡、省更多電、花更少錢。

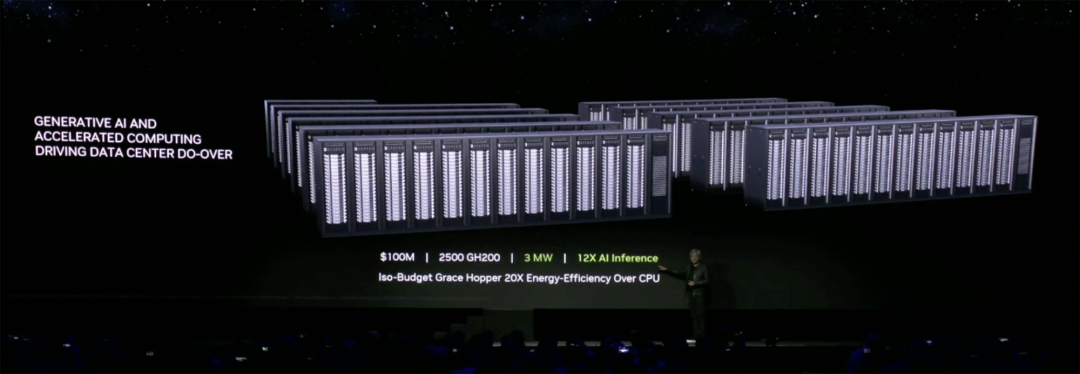

黃仁勛拋出一個問題:花1億美元能買什么?

過去,1億美元能買8800塊x86 CPU組成的數據中心,功耗是5MW。

如今,1億美元能買2500塊GH200組成的Iso-Budget數據中心,功耗是3MW,AI推理性能達到上述CPU系統的12倍,能效達20倍。

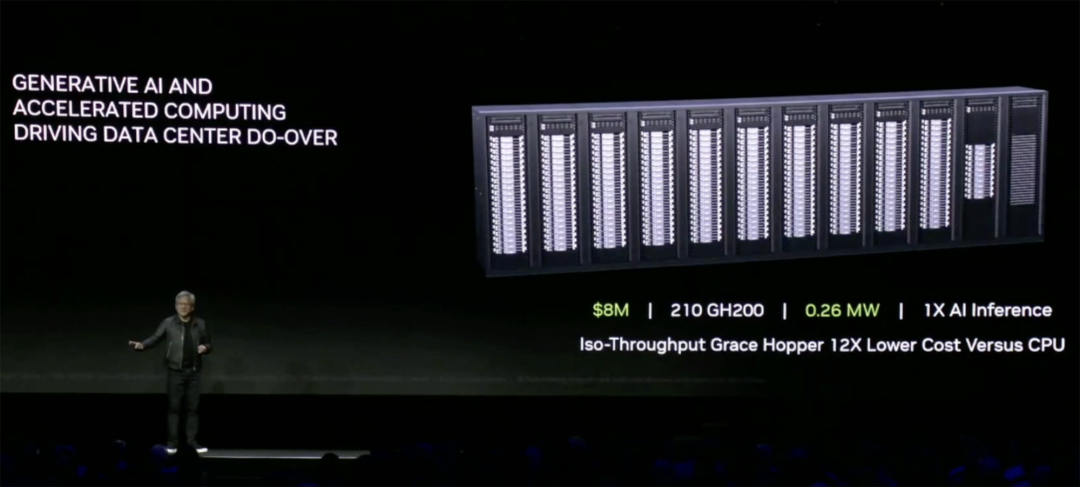

如果達到跟x86 CPU數據中心相同的AI推理性能,Iso-Troughput數據中心只需用到210塊GH200,功耗是0.26MW,成本只有CPU數據中心的1/12,僅800萬美元。

“買得越多,省得越多。”黃仁勛再度用這句講過很多遍的“導購金句”總結。

為方便GH200應用,GH200與今年早些時候在COMPUTEX上推出的NVIDIA MGX服務器規范完全兼容。因此系統制造商可以快速且經濟高效地將GH200添加到其服務器版本中。

新GH200預計將于明年第二季度投產。

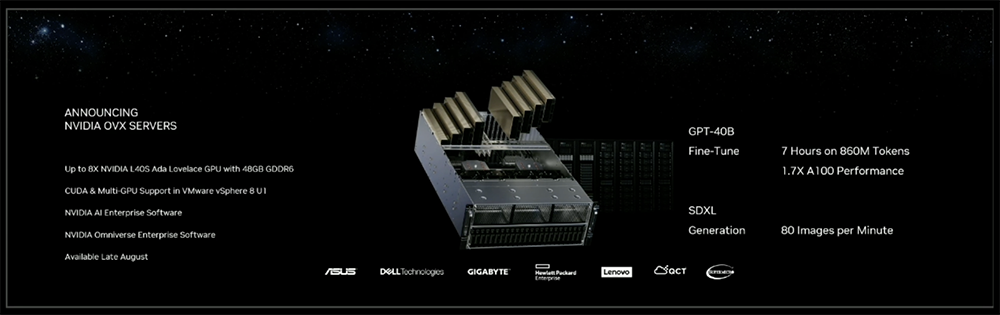

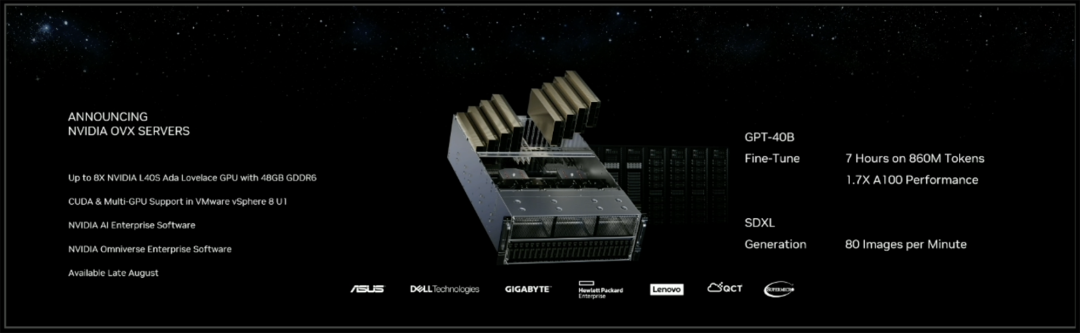

02. OVX服務器上新,采用L40S Ada GPU

面向數據中心,黃仁勛宣布推出配備全新NVIDIA L40S GPU的NVIDIA OVX服務器,可用于加速AI訓練和推理、3D設計和可視化、視頻處理和工業數字化等復雜的計算密集型應用。

NVIDIA OVX是針對服務器的參考架構,針對圖形、計算、存儲和網絡進行了優化。全新OVX系統將在每臺服務器上啟用多達8個L40S GPU,每個GPU配備48GB GDDR6超快內存。

L40S是一款功能強大的通用數據中心處理器,基于Ada架構,內置第四代Tensor Core和FP8 Transformer Engine,提供超過1.45PFLOPS的張量處理能力。

對于具有數十億參數和多種數據模式(如文本和視頻)的復雜AI工作負載,與A100 GPU相比,L40S可實現快1.2倍的AI推理性能、快1.7倍的訓練性能、快3.5倍的渲染速度,啟用DLSS3時Omniverse渲染速度更是能高到近4倍。

L40S包含18176個CUDA內核,提供近5倍于A100 GPU的單精度浮點(FP32)性能,以加速復雜的計算和數據密集型分析,支持對于工程和科學模擬等計算要求苛刻的工作流程。

為了支持實時渲染、產品設計和3D內容創建等高保真的專業可視化工作流程,L40S GPU內置有142個第三代RT核心,可提供212TFLOPS的光追性能。

L40S GPU將于今年秋季上市。NVIDIA之前投資的CoreWeave是首批提供L40S實例的云服務提供商之一。

03. 推出搭載RTX 6000的RTX工作站、三款桌面級RTX GPU

面向生成式AI和大模型開發、內容創作、數據科學,黃仁勛宣布推出搭載RTX 6000 Ada GPU的全新NVIDIA RTX工作站。

新的RTX工作站提供多達4個NVIDIA RTX 6000 Ada GPU,每個都配備48GB內存,單個桌面工作站可以提供高達5828TFLOPS的AI性能和192GB的GPU內存。

按用戶需求,系統可配置NVIDIA AI Enterprise或Omniverse Enterprise軟件,以支持各種苛刻的生成式AI和圖形密集型工作負載。

該工作站將于秋季由系統制造商開始提供。

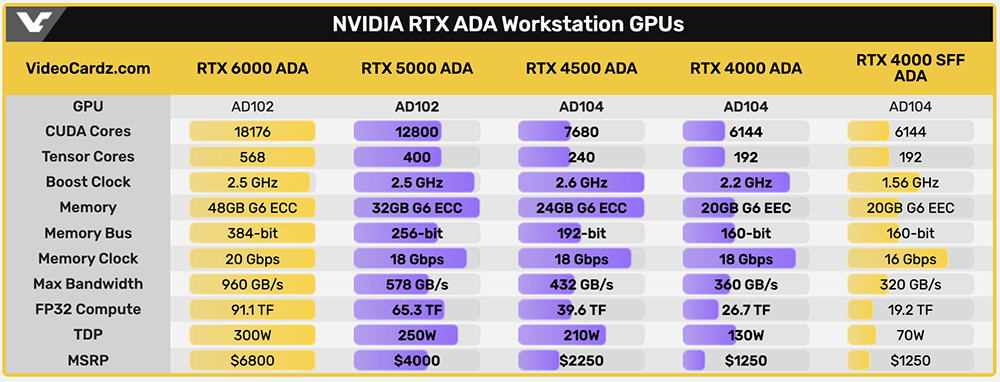

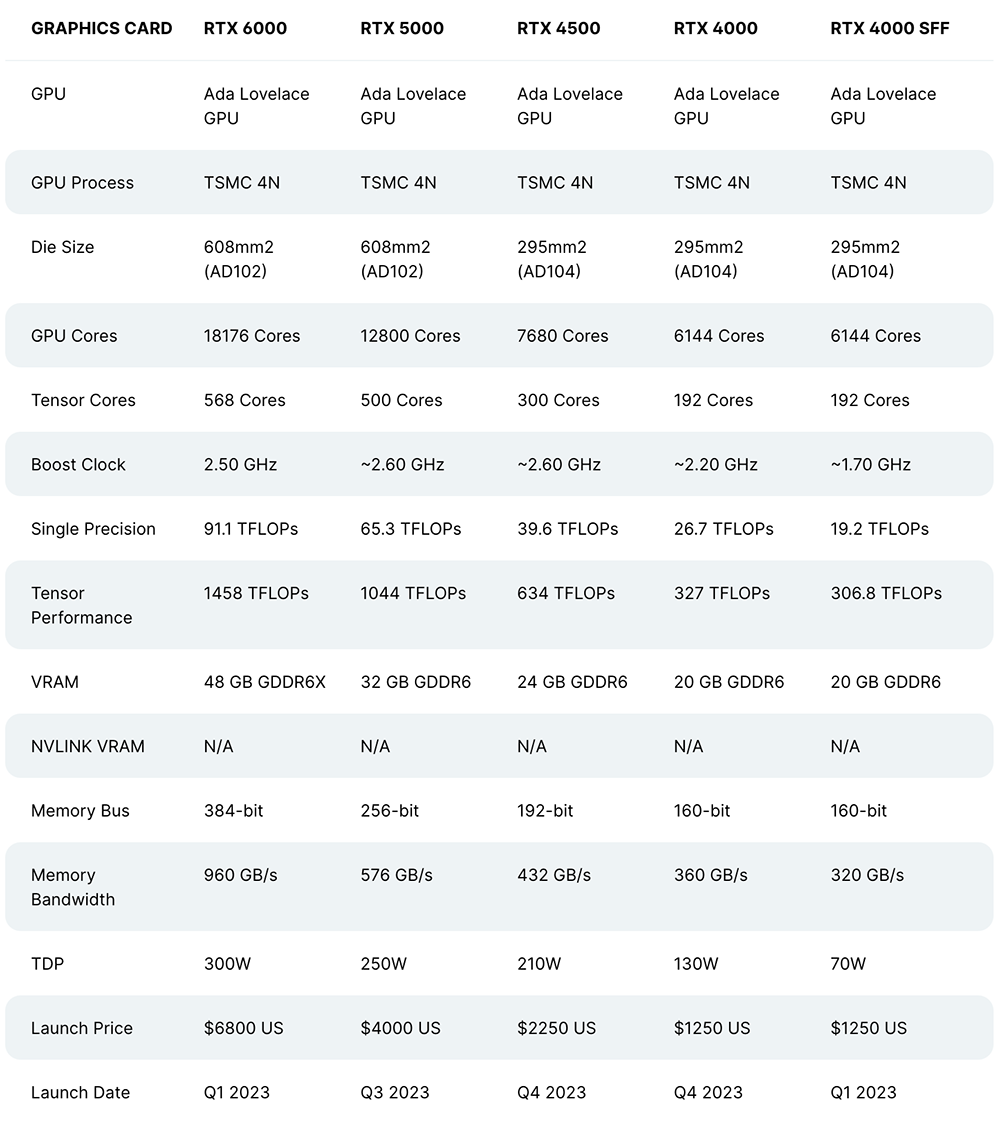

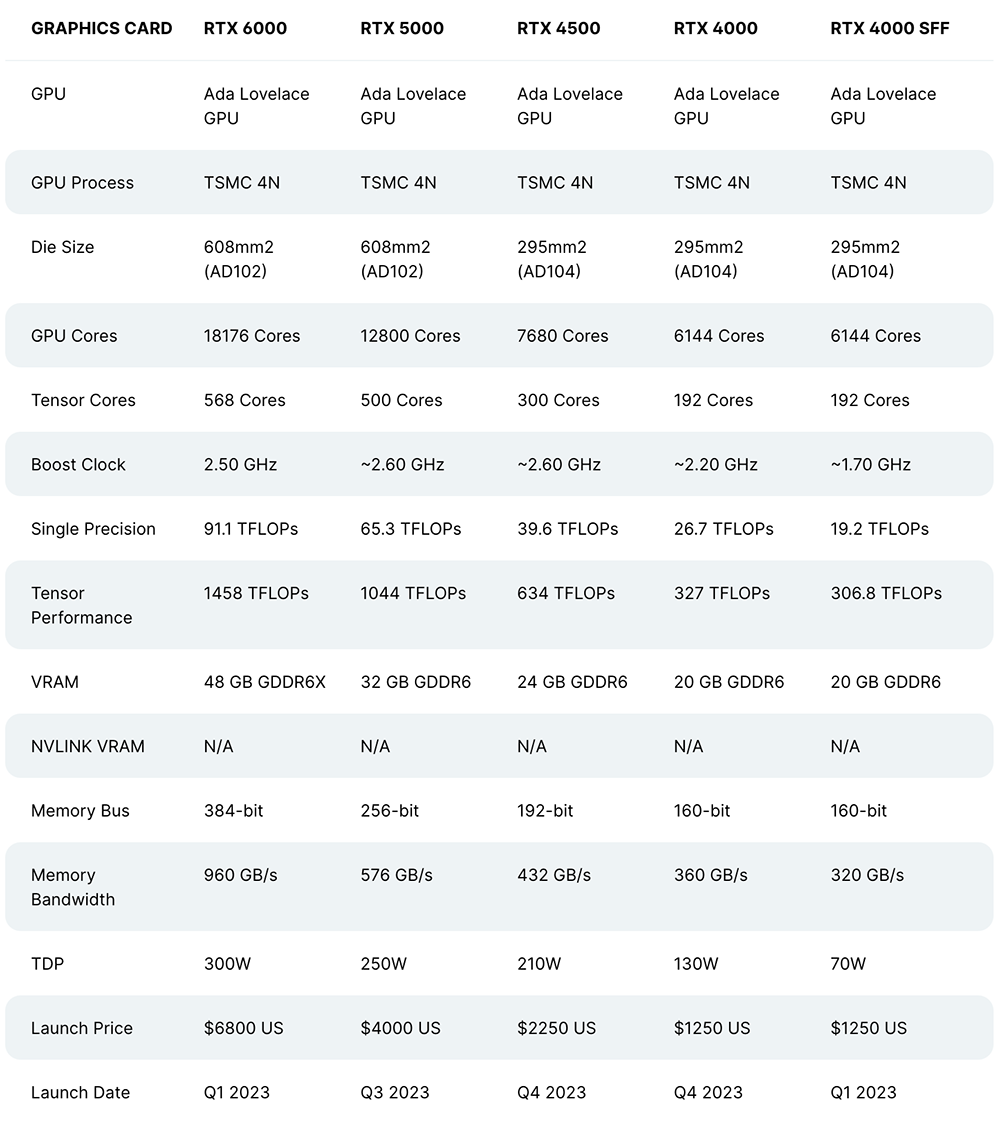

此外,NVIDIA也在SIGGRAPH期間推出三款新的桌面Ada GPU——NVIDIA RTX 5000、RTX 4500和RTX 4000,為全球專業人士提供最新的AI、圖形和實時渲染技術。

▲NVIDIA RTX Ada工作站GPU主要參數對比(圖源:VideoCardz)

三款新GPU均采用4nm定制工藝,并擁有較大的內存:RTX 4000提供20GB GDDR6內存,RTX 4500提供24GB GDDR6內存,RTX 5000提供32GB GDDR6內存。所有都支持錯誤代碼糾正,適用于大型3D模型、渲染圖像、模擬和AI數據集的無誤差計算。

同時,它們能支持高分辨率AR(增強現實)和VR(虛擬現實)設備,以提供創造AR、VR和MR(混合現實)內容所需的高性能圖形。

外媒Wccftech整理了不同RTX Ada工作站顯卡的參數對比:

RTX 5000現已上市,RTX 4500和RTX 4000 GPU將于今年秋季發售。

04. 新合作、新升級、新產品助攻生成式AI模型高效開發和部署

除了上述硬件產品外,黃仁勛分享了3個關于優化生成式AI流程的新發布,這些將有助于加速行業采用基于大型語言模型的生成式AI:

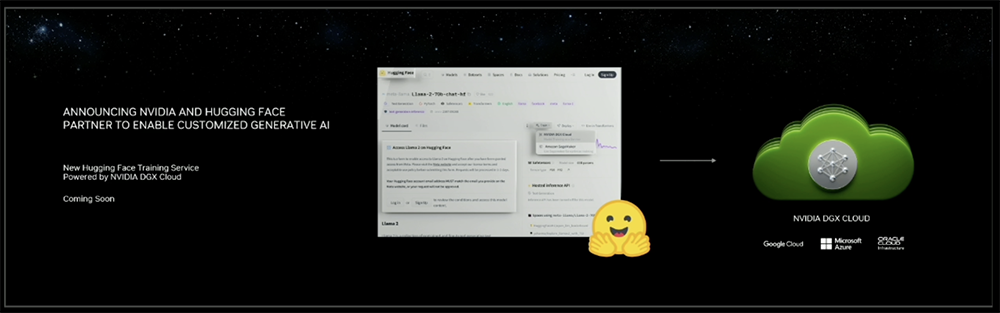

一是NVIDIA和全球最大AI開源社區Hugging Face建立合作。

二是推出NVIDIA AI Enterprise 4.0,把DGX Cloud中的所有功能放到NVIDIA AI Enterprise軟件中。

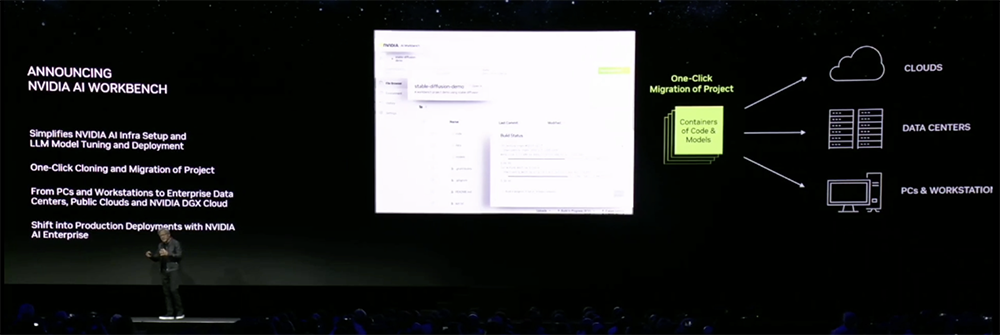

三是推出NVIDIA AI Workbench,將需要用于生成式AI工作的一切打包在一起,只用點擊一下就能將這個項目移動到任何終端設備或云端。

1、與Hugging Face合作:將數百萬開發人員連接到生成式AI超級計算

黃仁勛宣布,NVIDIA和Hugging Face建立合作伙伴關系,將為構建大型語言模型和其他高級AI應用程序的開發人員提供生成式AI超級計算。

開發人員可以訪問Hugging Face平臺內的NVIDIA DGX Cloud AI超級計算,來訓練和調優先進的AI模型。他們將有一個非常簡單的界面來推進工作,無需擔心訓練的復雜性,因為這些都會由DGX Cloud處理。

DGX Cloud的每個實例有8個NVIDIA H100或A100 80GB Tensor Core GPU,每個節點的GPU內存總計640GB。DGX Cloud包含來自NVIDIA專家的支持,可以幫助客戶優化其模型并快速解決開發挑戰。

作為合作的一部分,Hugging Face將推出一項名為“訓練集群即服務(Training Cluster as a Service)”,以簡化為企業創建新的和自定義生成式AI模型。該服務由NVIDIA DGX Cloud提供支持,將在未來幾個月內推出。

2、NVIDIA AI Workbench:在筆記本電腦上也能輕松啟動生成式AI項目

另一款新品NVIDIA AI Workbench,是一個統一、易用的工作空間,能讓開發人員隨處構建或運行自己的生成式AI模型。

開發者可以很方便地將所有必要的企業級模型、框架、SDK和庫從開源代碼庫和NVIDIA AI平臺打包到這個統一的開發者工作空間中,然后只需點擊幾下鼠標,就能將自己的AI項目從一個位置移動到另一個位置。

這樣就能在個人電腦、筆記本電腦或工作站上快速創建、測試和定制預訓練的生成式AI模型,并在需要時將其擴展到數據中心、公有云或NVIDIA DGX Cloud。

舉個例子,你可以在NVIDIA AI Workbench頁面上導入項目,比如導入SDXL-dev文生圖模型,輸入“玩偶黃仁勛在太空”,結果因為模型似乎不認識玩偶老黃,生成的圖像跟老黃的形象完全不沾邊。

接著只用幾張玩具老黃的圖像,對SDXL文生圖模型進行微調,它就能生成還不錯的效果。

總的來說,AI Workbench為跨組織團隊創建基于AI的應用程序提供了簡化的途徑,通過在本地系統上運行的簡化的界面訪問,讓開發人員能使用自定義數據從主流的代碼庫(如Hugging Face、GitHub和NVIDIA NGC)中定制模型,并能輕松跨多平臺共享。

戴爾、惠普、Lambda、聯想、超微等AI基礎設施供應商正采用AI Workbench以增強其最新一代多GPU桌面工作站、高端移動工作站和虛擬工作站的能力。

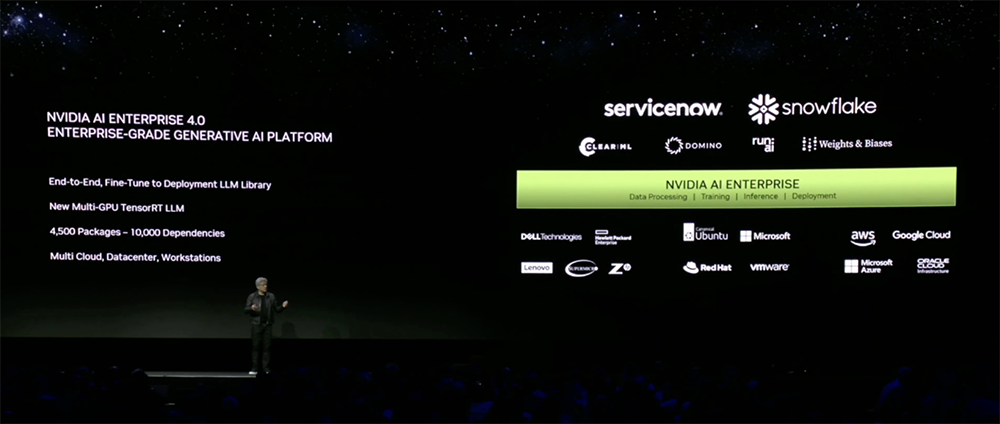

3、NVIDIA AI enterprise 4.0:提供一系列生成式AI工具

最新版的企業軟件平臺NVIDIA AI enterprise 4.0,可提供生產就緒型生成式AI工具,并提供了可靠的生產部署所需的安全性和API穩定性。

NVIDIA AI Enterprise 4.0新支持的軟件和工具有助于簡化生成式AI部署,其中一大亮點是引入用于構建、定制和部署大型語言模型的云原生框架NVIDIA NeMo。

其他工具還包括NVIDIA Triton管理服務(通過模型編排實現可擴展AI高效運行)、NVIDIA Base Command Manager Essentials集群管理軟件(幫助企業在數據中心、多云和混合云環境中最大限度提高AI服務器性能和利用率)等。

NVIDIA AI Enterprise軟件支持用戶跨云、數據中心和邊緣構建和運行支持NVIDIA AI的解決方案,經認證可在主流NVIDIA認證系統、NVIDIA DGX系統、所有主要云平臺和新發布的NVIDIA RTX上運行工作站。

最新版本的企業軟件平臺將集成到谷歌云、微軟Azure、Oracle云基礎設施等NVIDIA合作伙伴市場。

05. Ominverse升級:加持生成式AI能力,曬OpenUSD路線圖

在生成式AI加持下,構建工業元宇宙與數字孿生場景的開發更加方便高效、視覺效果更加逼真。

面向元宇宙領域,NVIDIA的主角當仁不讓是Omniverse平臺,以及該平臺的基礎——開源通用場景描述框架OpenUSD。生成式AI與Omniverse的結合也此次演講的重頭戲。

黃仁勛宣布,比亞迪和梅賽德斯·奔馳合資的豪華電動汽車品牌騰勢(DENZA)已與營銷及通信巨頭WPP合作,在NVIDIA Omniverse Cloud上構建和部署其下一代先進汽車配置器。

WPP通過USD或OpenUSD集成了來自電動汽車制造商首選的計算機輔助設計(CAD)工具的全保真設計數據,從而構建一個單一的、物理精確的、實時的騰勢N7汽車模型數字孿生體。

當想要添加一個功能時,無需任何手動返工,就能將該功能構建到騰勢汽車的數字孿生體中,并立即部署到所有營銷渠道中。

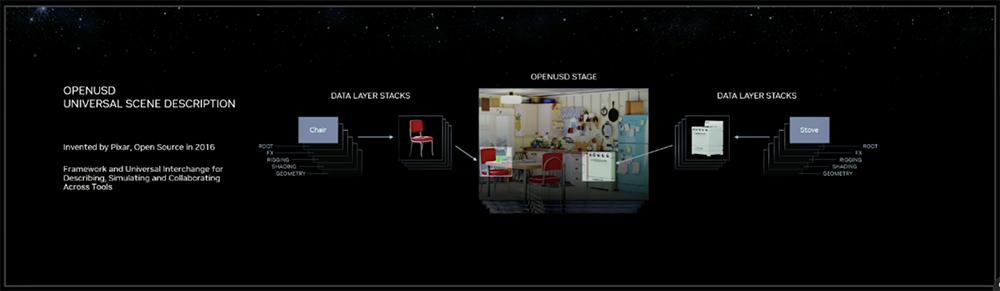

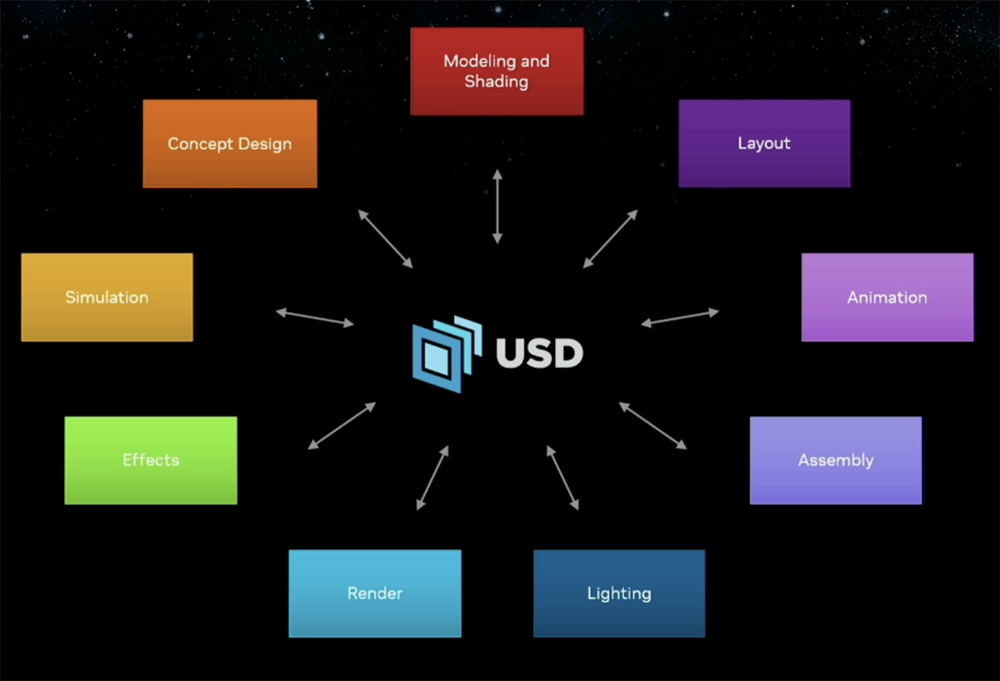

USD提供了一個高性能的通用框架來描述、組合、模擬和協作3D項目和數據。NVIDIA堅信這是3D互聯網的基礎。

“就像HTML點燃了2D互聯網的重大計算革命一樣,OpenUSD將點燃3D寫作和工業數字化的時代。”黃仁勛說,“通過開發NVIDIA Omniverse和生成式AI,NVIDIA將全力支持OpenUSD的發展和采用。”

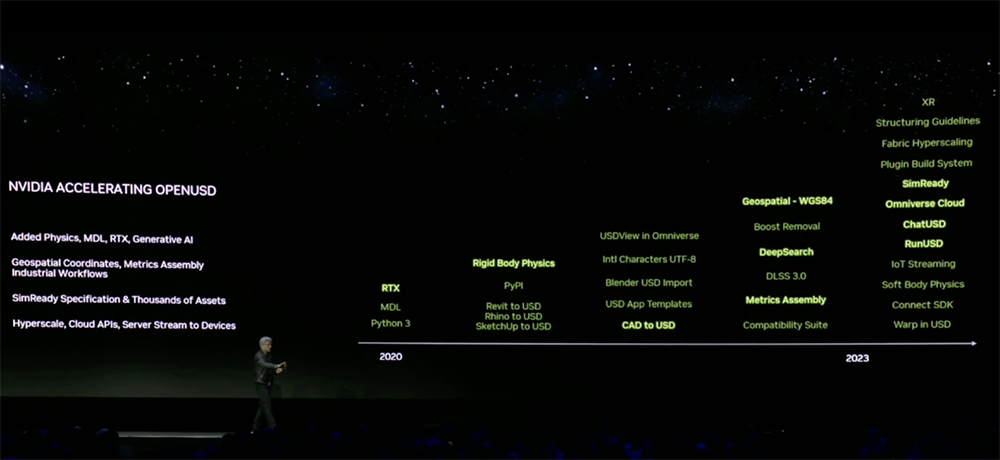

在SIGGRAPH大會上,黃仁勛展示了從2020年至2023年NVIDIA加速OpenUSD的發展路線圖。

NVIDIA正推出一個SIM Ready規范,將物理屬性應用于USD資產,以便機器人和自動駕駛汽車等AI代理可以完全在模擬世界中了解真實世界。

近期NVIDIA與皮克斯、Adobe、蘋果、Autodesk聯合成立了OpenUSD聯盟AOUSD,將為OpenUSD開發一個標準規范,以加速其在工具生態系統中的采用和軟件間的互操作性。

NVIDIA正通過NVIDIA Omniverse、新技術組合和云API以及新的NVIDIA OpenUSD開發者計劃,推進OpenUSD框架的開發。

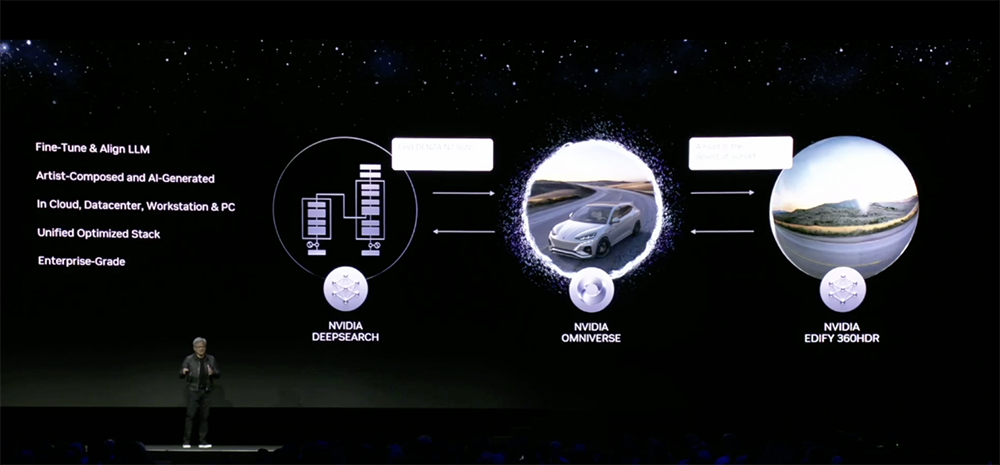

為了讓開發人員更無縫地實施和部署OpenUSD流水線和應用程序,NVIDIA將生成式AI和OpenUSD結合,推出一些Omniverse云API:

(1)ChatUSD:基于NVIDIA Nemo框架的一個大型語言模型副駕駛,可回答USD知識問題或生成Python-USD代碼腳本)。

(2)RunUSD:用于檢查上傳文件與OpenUSD版本兼容性,可生成實時的完全路徑跟蹤的交互式USD文件渲染。

(3)DeepSearch:基于大型語言模型的語義3D搜索服務,可通過文本或圖像輸入輸入,對大量未標注資產的數據庫進行快速語義搜索。

Omniverse云API將使開發人員能夠輕松地即時訪問NVIDIA及其合作伙伴的最新生成式AI和OpenUSD技術。

NVIDIA Picasso便是其中之一。它是一個基于云的代工廠,用于構建自定義的生成式AI視覺模型。Picasso使開發人員能訓練文生圖、文生視頻、文本轉3D生成等模型。

Shutterstock正在使用NVIDIA Picasso(構建的代工廠)來開發生成式AI服務,以加速3D工作流程。Shutterstock宣布了這些新服務的首款產品360 HDRi。經Picasso訓練的模型可生成逼真的8K分辨率360度高動態范圍成像(HDRi)環境地圖,從而大大加快3D場景的內容創作。

此外,Omniverse進行了一些重要的版本更新:

Omniverse RTX渲染器集成了DLSS 3技術和新的AI降噪器,AI降噪器可實現對大規模工業場景的實時4K路徑追蹤。

開發人員還可以構建基于OpenUSD的內容和體驗,并將其部署到擴展現實(XR)設備上。新的XR開發工具使用戶能在基于Omniverse應用程序中本地構建空間計算選項,靈活體驗他們喜歡的3D項目和虛擬世界。

Omniverse USD Composer可支持3D用戶組裝大規模的、基于OpenUSD的場景。

提供生成式AI API的Omniverse Audio2Face,僅從音頻文件就能創建逼真的面部動畫和手勢,現在包括多語言支持和一個新的女性基礎模型。

Omniverse Kit Extension Registry是一個用于訪問、共享和管理全方位擴展的中央存儲庫,讓開發人員能輕松地在他們的應用程序中打開和關閉功能,使構建自定義app變得更容易。

這些新的應用程序和體驗模板能讓開發人員以很少的代碼開始使用OpenUSD和Omniverse。

此外,Adobe與NVIDIA擴大了在Adobe Substance 3D、生成式AI和OpenUSD計劃方面的合作,宣布將在Omniverse中將提供其創意生成式AI模型系列Adobe Firefly的API。

最新版本的Omniverse處于測試階段,很快就會發布到Omniverse Enterprise企業版。

06. 結語:英偉達All in 生成式AI

在本屆SIGGRAPH大會上,黃仁勛集中分享了NVIDIA最新的技術、研究、OpenUSD開發和AI內容創建解決方案,并用一系列對開發者及企業極具吸引力的軟硬件新品,再度驗證NVIDIA在新時代的自定義——NVIDIA是一家平臺公司。

今年以來,NVIDIA GPU已成為支持生成式AI和大模型訓練的大算力AI芯片首選,亦當之無愧是推動生成式AI普及的核心功臣。受益于生成式AI熱潮的NVIDIA,也正積極地成為一個稱職的“生成式AI布道者”,近期一直盡心竭力地推廣生成式AI在各行各業應用的價值。

在推動高效地、經濟地、可擴展地運行生成式AI模型的道路上,NVIDIA所展示了許多軟硬件創新成果,無論是加速大型語言模型訓練和調優,還是簡化定制生成式AI模型的工作流程,抑或是持續提高圖形渲染及工業元宇宙基礎設施的性能和開發體驗,這些進展都令人印象深刻。

-

處理器

+關注

關注

68文章

19169瀏覽量

229156 -

NVIDIA

+關注

關注

14文章

4940瀏覽量

102818 -

AI

+關注

關注

87文章

30172瀏覽量

268434 -

生成式AI

+關注

關注

0文章

488瀏覽量

459 -

HBM3

+關注

關注

0文章

74瀏覽量

146 -

HBM3E

+關注

關注

0文章

78瀏覽量

232

原文標題:昨夜,黃仁勛甩出最強生成式AI處理器,全球首發HBM3e,比H100還快

文章出處:【微信號:算力基建,微信公眾號:算力基建】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

SK海力士引領未來:全球首發12層HBM3E芯片,重塑AI存儲技術格局

黃仁勛有望超越馬斯克成全球首富 最快有望在2025年前實現

黃仁勛回應中國市場問題

什么是HBM3E內存?Rambus HBM3E/3內存控制器內核

SK海力士HBM3E正式量產,鞏固AI存儲領域的領先地位

黃仁勛:競爭對手AI芯片免費,仍無法替代英偉達GPU

美光量產行業領先的HBM3E解決方案,加速人工智能發展

三星發布首款12層堆疊HBM3E DRAM

三星電子成功發布其首款12層堆疊HBM3E DRAM—HBM3E 12H

美光科技批量生產HBM3E,推動人工智能發展

美光科技啟動高帶寬存儲芯片生產 為英偉達最新AI芯片提供支持

AMD發布HBM3e AI加速器升級版,2025年推新款Instinct MI

Nvidia 正在利用迄今為止最強大的芯片 H200 推動人工智能革命

黃仁勛甩出最強生成式AI處理器,全球首發HBM3e,比H100還快

黃仁勛甩出最強生成式AI處理器,全球首發HBM3e,比H100還快

評論