科技云報道原創(chuàng)。

近日,在計算機圖形學頂會SIGGRAPH 2023現(xiàn)場,英偉達再度釋放深夜“炸彈”,大模型專用芯片迎來升級版本。

英偉達在會上發(fā)布了新一代GH200 Grace Hopper平臺,該平臺依托于搭載全球首款搭載HBM3e處理器的新型Grace Hopper超級芯片——GH200,專為處理大語言模型、推薦系統(tǒng)、矢量數(shù)據(jù)庫等全球最復雜的生成式AI工作負載而構(gòu)建。

據(jù)悉,GH200芯片將成為世界上第一個配備HBM3e(High Bandwidth Memory 3e)內(nèi)存的GPU芯片。

與當前一代產(chǎn)品相比,最新版本的GH200超級芯片內(nèi)存容量增加了3.5倍,帶寬增加了3倍;相比最熱門的H100芯片,其內(nèi)存增加1.7倍,傳輸頻寬增加1.5倍。

在當前生成式AI不斷激增的需求下,GH200超級芯片的推出,進一步吹響了AI算力之戰(zhàn)的號角。

性能更高的GH200芯片

據(jù)介紹,GH200 Grace Hopper平臺的HBM3e內(nèi)存比當前HBM3快50%,可提供總計10TB/s的帶寬。這使得新平臺能夠運行比上一版本大3.5倍的模型,同時憑借快3倍的內(nèi)存帶寬提升性能。

同時,該平臺采用雙配置,包括一個擁有144個Arm Neoverse內(nèi)核、8 petaflops的AI性能和282GB最新HBM3e內(nèi)存技術(shù)的單個服務器。

英偉達創(chuàng)始人兼首席執(zhí)行官黃仁勛表示:“為了滿足對生成式 AI不斷激增的需求,數(shù)據(jù)中心需要能夠滿足特定需求的加速計算平臺。全新GH200 Grace Hopper超級芯片平臺以出色的內(nèi)存技術(shù)和帶寬,提高了吞吐量,在不影響性能的情況下可連接多GPU以整合性能,并且具有可以輕松部署到整個數(shù)據(jù)中心的服務器設計。”

據(jù)英偉達公布信息,新平臺可以通過 NVIDIA NVLink? 與其他超級芯片連接,使它們能夠協(xié)同工作,從而部署當下大型生成式AI模型。這種高速、一致性技術(shù)使GPU可以完全訪問CPU 內(nèi)存,在雙配置中可提供總計1.2TB的快速內(nèi)存。

值得注意的是,新平臺采用的新款超級芯片GH200與此前發(fā)布的H100相比,二者使用同樣的GPU,但GH200將同時配備高達141G的內(nèi)存和72核ARM中央處理器,每秒5TB帶寬,內(nèi)存增加了1.7倍,帶寬增加了1.5倍。

新平臺和芯片的加持,也讓大模型訓練的成本得到有效降低。黃仁勛表示,一臺服務器可以同時裝載兩個GH200超級芯片,大型語言模型的推理成本將會大幅降低。

據(jù)介紹,投資800萬美元Grace Hopper,就相當于8800個價值1億美元的x86 GPU,意味著成本降低12倍,能耗降低20倍。

英偉達稱,GH200已于5月全面投產(chǎn),基于GH200 Grace Hopper平臺的新系統(tǒng)將于2024年第二季度交付。

不過一個關(guān)鍵的問題是,英偉達沒有透露超級芯片GH200的價格,這對計算成本高昂的大模型來說尤為重要,H100系列目前售價約為4萬美元。

為什么內(nèi)存對大模型重要?

事實上,GH200超級芯片本身并不是一個新產(chǎn)品,而是今年5月在中國臺北Computex展上發(fā)布的GH200芯片的更新版。

英偉達超大規(guī)模和高性能計算副總裁兼總經(jīng)理伊恩·巴克(Ian Buck)表示:“我們對這款新的GH200感到非常興奮。HBM3e不僅增加了GPU的容量和內(nèi)存量,而且速度也更快。”

但為什么GPU內(nèi)存這么重要?

這是因為隨著支撐生成式人工智能應用程序的基礎AI模型尺寸的增加,為了能夠在不連接獨立芯片和系統(tǒng)的情況下運行,大模型需要更大的內(nèi)存量,以避免性能下降。

擁有更大的內(nèi)存允許模型保留在單個GPU上,并且不需要多個系統(tǒng)或多個GPU來運行,而額外的內(nèi)存只會提高 GPU的性能。

目前即使使用英偉達最頂級的H100芯片,有些模型也必須在其他GPU中“分解”模型才能運行。

據(jù)英偉達介紹,最新版本GH200配備141GB的HBM3e內(nèi)存,旨在處理“世界上最復雜的生成式人工智能工作負載,涵蓋大型語言模型、推薦系統(tǒng)和矢量數(shù)據(jù)庫”。

對AI領域的影響

英偉達的GH200超級芯片和DGX GH200超級計算機是AI領域的重大突破,它們?yōu)榇笠?guī)模生成式AI工作負載提供了前所未有的性能和內(nèi)存空間,使得訓練千億甚至萬億參數(shù)的巨型模型成為可能。

這些模型可以在自然語言處理、計算機視覺、推薦系統(tǒng)、圖形分析等領域?qū)崿F(xiàn)更高的精度和效率,為人類解決更復雜的問題提供了強大的工具。

在多位AI從業(yè)者看來,當前大模型的訓練需求過于迫切,對性能的要求也很高,而GPU的適配和生態(tài)轉(zhuǎn)移都需要很長時間,因此目前大家都優(yōu)先選擇英偉達,和其他廠商的測試驗證也在進行中。

一場新的算力之戰(zhàn)已經(jīng)拉開帷幕,如果說算力是一個江湖,那么此刻英偉達就是一名絕世高手。

它身懷加速計算的絕技,尤其在AI戰(zhàn)場上一騎絕塵,似乎每一次都能精準地踏在浪潮的節(jié)奏上。從游戲PC市場、到深度學習的崛起、到云計算的普及、再到生成式AI的降臨,英偉達的技術(shù)所向披靡。

回頭看,英偉達早已超越了GPU本身的概念,AI成為最大的標簽,算力的絕世武功撐起了新的萬億帝國。

2022年,英偉達推出了多款重磅產(chǎn)品,分別是基于全新Hopper架構(gòu)的H100 GPU、CPU和GPU的合體Grace Hopper、兩個CPU組合的Grace CPU Superchip,CPU的產(chǎn)品在2023年上市。

其中,設計GPU新架構(gòu)Hopper時,英偉達增添了一個Transformer引擎,專門為Transformer算法做了硬件優(yōu)化,加快AI計算的效率。

一位國內(nèi)芯片從業(yè)者直言:“H100出來,其實就是一個新時代了,Grace-Hopper再一個組合,加上高配的互聯(lián),完全不給活路,英偉達贏家通吃,AMD、Intel繼續(xù)苦追。”

同時他也表示:“目前國內(nèi)一些企業(yè)還是在盯著CNN做優(yōu)化,英偉達已經(jīng)有Transformer引擎,然后AIGC火熱,恰好能做支持。這個眼光,只能佩服他們的科學家們對這個領域深刻的認識。”

一位學術(shù)界人士也分析道:“從H100上,包括專用的Transformer引擎以及對FP8格式的支持,可以看到計算硬件在向應用定制的方向前進。Grace CPU說明了整合異構(gòu)計算系統(tǒng)的重要性。單純的加速器優(yōu)化和設計已經(jīng)不能夠滿足現(xiàn)在對于計算系統(tǒng)的算力和能效比的要求,需要各個部分的協(xié)同優(yōu)化和設計。”

他還表示,Grace CPU通過提高通信帶寬和在CPU和GPU之間建立一致(coherent)的內(nèi)存模型來解決運算中的瓶頸,這也和學界(近存計算,存內(nèi)計算)與業(yè)界(CXL,CCI等等系統(tǒng)互聯(lián)協(xié)議)一直在關(guān)注的方向是一致的。

總而言之,在GPU和CPU的各種排列組合中,英偉達又將算力提升到了新高度。正如黃仁勛所言:“我們正在重新發(fā)明計算機,加速計算和人工智能標志著計算正在被重新定義。”

黃仁勛在采訪中還提到,數(shù)據(jù)中心需要用的CPU越來越少,不再是傳統(tǒng)上購買數(shù)百萬個CPU,而是轉(zhuǎn)而購買數(shù)百萬個GPU。換言之,在他看來,AI算力江湖已經(jīng)是GPU的主場。

英偉達的野心

事實上,隨著ChatGPT引發(fā)AI大模型需求熱潮,作為加速計算領導者,英偉達今年以來股價累計漲幅已超過210%,近三個月內(nèi)漲幅就達56%,過去7年股價增長超40倍,目前市值沖破1.1萬億美元。

公開數(shù)據(jù)顯示,英偉達占據(jù)全球80%以上的GPU服務器市場份額,同時擁有全球91.4%的企業(yè)GPU市場份額。

據(jù)投資者服務公司穆迪今年5月份發(fā)布的一份研究報告,英偉達在未來幾個季度將實現(xiàn)“無與倫比”的收入增長,其數(shù)據(jù)中心業(yè)務的收入將超過競爭對手英特爾和AMD的總和。

但摩根士丹利策略分析師斯坦利(Edward Stanley)在最新報告中稱,根據(jù)歷史背景,英偉達的股價飆升處于“后期”階段,摩根士丹利認為這標志著 AI 行業(yè)的“泡沫”。

GPU持續(xù)緊缺下,如今英偉達產(chǎn)品價格已同比上漲超30%,英偉達A800單卡現(xiàn)貨近13萬元一顆,eBay上H100售價高達4.5萬美元。

同時,OpenAI的GPT-4大模型需要至少2.5萬張英偉達A100 GPU芯片,而該公司目前至少已擁有1000萬顆GPU芯片。

正如黃仁勛常說的,“你GPU買得越多,你越省錢”。主要原因是新的GPU產(chǎn)品能顯著提升加速計算,比CPU性能更強、算力更大、功耗更低。

但英偉達的布局還不止于此。

一個現(xiàn)實問題是,高性能的算力也意味著高昂的價格。大模型訓練成本動輒成千上百萬美元,并不是所有公司都能承受。

而英偉達同時提出了云服務的解決方案NVIDIA AI foundations,黃仁勛表示要做“AI界的臺積電”。臺積電大大降低了芯片設計公司生產(chǎn)門檻,英偉達也要做代工廠的角色,通過和大模型廠商、云廠商合作提供高性價比的云服務。

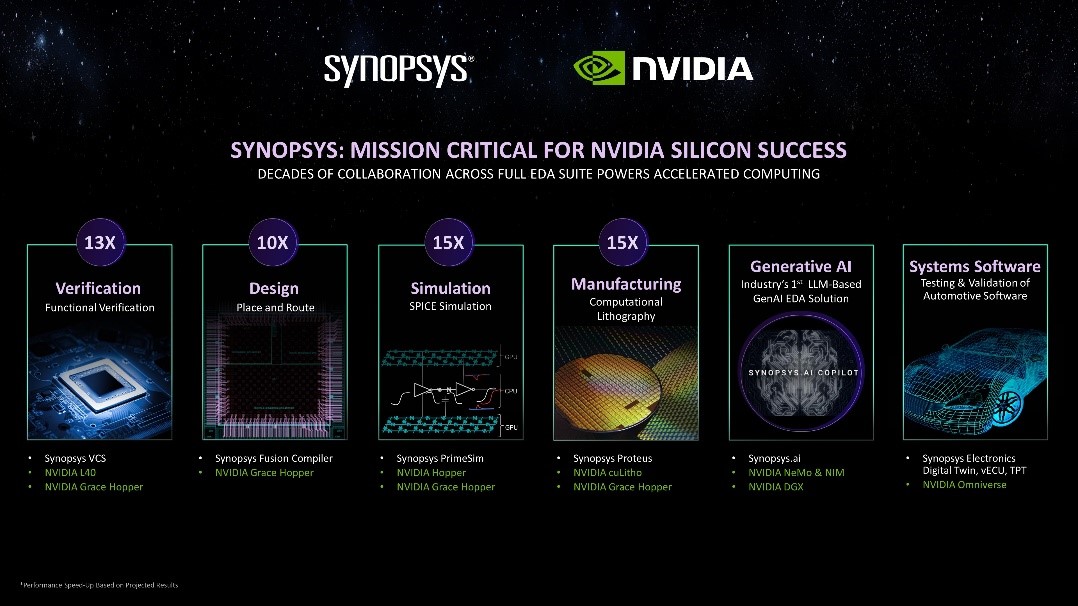

在幫助下游企業(yè)降低大模型訓練成本的同時,英偉達還在逐步參與到上游的產(chǎn)業(yè)鏈升級中。今年,英偉達牽手臺積電、ASML、新思,發(fā)布了計算光刻庫cuLitho。

計算光刻是在芯片設計和制造領域的關(guān)鍵步驟,也是最大的計算負載之一。計算光刻庫的技術(shù)突破就在于,可以通過部署有大量GPU的DGX AI計算系統(tǒng)對計算光刻進行加速,使其達到原有的基于CPU的計算速度的幾十倍,同時降低計算過程的總能耗。

這將有助于晶圓廠縮短原型周期時間、提高產(chǎn)量、減少碳排放,為2nm及更先進的工藝奠定基礎,并為曲線掩模、高數(shù)值孔徑極紫外、亞原子級光刻膠模型等新技術(shù)節(jié)點所需的新型解決方案和創(chuàng)新技術(shù)提供更多可能性。

在多位產(chǎn)業(yè)界人士看來,雖然短期內(nèi)不會影響到下游的應用方面,但是這些上游的研發(fā)和升級將長期影響產(chǎn)業(yè)的發(fā)展,累積形成代際差。

“英偉達在GPU架構(gòu)的迭代上,一直都有屬于自己的發(fā)展路徑,這幾年的發(fā)展,也讓英偉達躍居AI算力芯片領域的領導者,也因為領先,所以英偉達會思考如何做更多元的布局與行業(yè)內(nèi)的深度合作,這樣更能了解行業(yè)的需求,比方和臺積電等合作便是很好的例子”,某芯片行業(yè)專家表示。

當然,英特爾和AMD都已經(jīng)吹響反攻的號角。

7月,英特爾面向中國市場推出了AI芯片Habana Gaudi 2;6月,AMD推出AI芯片Instinct MI 300X,兩者都直接對標英偉達100系列。

目前,在數(shù)據(jù)中心市場,英偉達和Intel、AMD形成三足鼎立之勢。但隨著GH200的正式發(fā)布,Grace CPU正式登臺爭角,最應該感到如芒在背的應該是Intel、AMD。雖說大家都知道GH200遲早發(fā)布,但等真正發(fā)布了,還是有所觸動。

圍繞著算力的權(quán)力游戲還將繼續(xù)。

【關(guān)于科技云報道】

專注于原創(chuàng)的企業(yè)級內(nèi)容行家——科技云報道。成立于2015年,是前沿企業(yè)級IT領域Top10媒體。獲工信部權(quán)威認可,可信云、全球云計算大會官方指定傳播媒體之一。深入原創(chuàng)報道云計算、大數(shù)據(jù)、人工智能、區(qū)塊鏈等領域。

審核編輯 黃宇

-

芯片

+關(guān)注

關(guān)注

454文章

50458瀏覽量

421951 -

gpu

+關(guān)注

關(guān)注

28文章

4703瀏覽量

128722 -

AI

+關(guān)注

關(guān)注

87文章

30237瀏覽量

268467 -

英偉達

+關(guān)注

關(guān)注

22文章

3749瀏覽量

90853 -

算力

+關(guān)注

關(guān)注

1文章

936瀏覽量

14748

發(fā)布評論請先 登錄

相關(guān)推薦

企業(yè)AI算力租賃是什么

AMD發(fā)布英偉達競品AI芯片,預期市場規(guī)模將大幅增長

成都匯陽投資關(guān)于華為新版芯片或挑戰(zhàn)英偉達,國產(chǎn)算力值得關(guān)注?

鴻海與英偉達攜手打造超級算力中心

英偉達Blackwell芯片已投產(chǎn),預告未來AI芯片發(fā)展

研華與英偉達深化合作,成為NVIDIA AI Enterprise軟件全球分銷商

除英偉達Jetson系列外,AI邊緣計算盒子還能搭載哪些算力芯片

一圖看懂星河AI數(shù)據(jù)中心網(wǎng)絡,全面釋放AI時代算力

亮相英偉達GTC大會!德賽西威高算力智駕域控海外展出

新思科技攜手英偉達:基于加速計算、生成式AI和Omniverse釋放下一代EDA潛能

算力之戰(zhàn),英偉達再度釋放AI“炸彈”

算力之戰(zhàn),英偉達再度釋放AI“炸彈”

評論