具身智能新紀元。

*本文為稚暉君獨家供稿,「甲子光年」經智元機器人授權發布。稚暉君本名彭志輝,先后任職OPPO、華為,現為智元機器人CTO、首席架構師。

在ChatGPT之后,又一個大模型概念火了——具身智能(Embodied AI)。

在學術界,圖靈獎得主、上海期智研究院院長姚期智認為,人工智能領域下一個挑戰將是實現“具身通用人工智能”;清華大學計算機系教授張鈸院士,也在某產業智能論壇上提出,隨著基礎模型的突破,通用智能機器人(具身智能)是未來的發展方向。

在產業界,微軟、谷歌、英偉達等大廠均開展了相關研究,比如谷歌RT-2、英偉達VIMA等。英偉達創始人兼CEO黃仁勛在ITF World 2023 半導體大會上表示,AI下一個浪潮將是“具身智能”。

具身智能作為人工智能發展的一個重要分支,正在迅速嶄露頭角,成為科技界和大眾關注的熱門話題,同時在各個領域中展現出巨大的潛力和吸引力。

1. 什么是具身智能?

具身智能通過在物理世界和數字世界的學習和進化,達到理解世界、互動交互并完成任務的目標。

具身智能是由“本體”和“智能體”耦合而成且能夠在復雜環境中執行任務的智能系統。一般認為,具身智能具有如下的幾個核心要素:

第一是本體,作為實際的執行者,是在物理或者虛擬世界進行感知和任務執行的機構。

本體通常是具有物理實體的機器人,可以有多種形態。本體的能力邊界會限制智能體的能力發揮,所以,具有廣泛適應性的機器人本體是非常必要的。

隨著機器人技術的進步,本體越來越呈現多樣化和靈活性。比如,四足機器人可以具有良好的運動能力和通過性,復合機器人則把運動和操作機構整合,具有較好的任務能力;而人形機器人作為適應性更加廣泛,通用能力更強的本體形態,得到了長足的進步,已經到了可以商業化的前夕。

本體具備環境感知能力、運動能力和操作執行能力,是連接數字世界和物理世界的載體。

具身智能的第二個要素是智能體(Embodied Agents),是具身于本體之上的智能核心,負責感知、理解、決策、控制等的核心工作。

智能體可以感知復雜環境,理解環境所包含的語義信息,能夠和環境進行交互;可以理解具體任務,并且根據環境的變化和目標狀態做出決策,進而控制本體完成任務。

隨著深度學習的發展,現代智能體通常由深度網絡模型驅動,尤其是隨著大語言模型(LLM)的發展,結合視覺等多種傳感器的復雜多模態模型,已經開始成為新一代智能體的趨勢。

同時,智能體也分化為多種任務形態,處理不同層次和模態的任務。智能體要能夠從復雜的數據中學習決策和控制的范式,并且能夠持續的自我演進,進而適應更復雜的任務和環境。

智能體設計是具身智能的核心。具有通用能力的LLM和VLM等模型,賦予了通用本體強大的泛化能力,使得機器人從程序執行導向轉向任務目標導向,向通用機器人邁出了堅實的步伐。

具身智能的第三個要素是數據。“數據是泛化的關鍵,但涉及機器人的數據稀缺且昂貴。”

為了適應復雜環境和任務的泛化性,智能體規模變的越來越大,而大規模的模型對于海量數據更為渴求。現在的LLM通常需要web-scale級別的數據來驅動基礎的預訓練過程,而針對具身智能的場景則更為復雜多樣,這造成了多變的環境和任務,以及圍繞著復雜任務鏈的規劃決策控制數據。尤其是針對行業場景的高質量數據,將是未來具身智能成功應用落地的關鍵支撐。

具身智能的第四個要素是學習和進化架構。智能體通過和物理世界(虛擬的或真實的)的交互,來適應新環境、學習新知識并強化出新的解決問題方法。

采用虛擬仿真環境進行部分學習是合理的設計,比如英偉達的元宇宙開發平臺Omniverse,就是構建了物理仿真的虛擬世界,來加速智能體的演進。

但真實環境的復雜度通常超過仿真環境,如何耦合仿真和真實世界,進行高效率的遷移(Sim2Real),也是架構設計的關鍵。

2. 具身智能的科研和技術進展

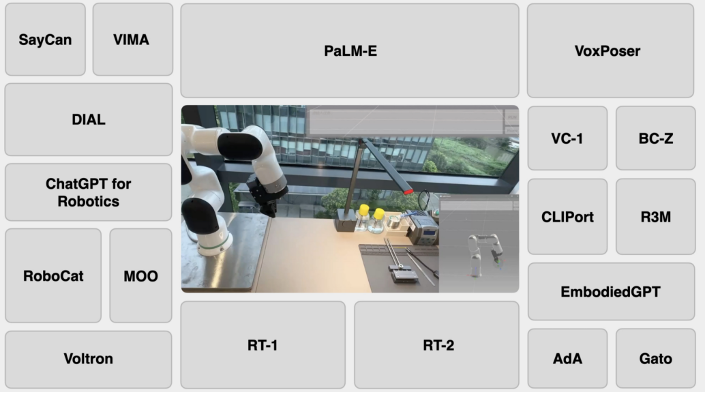

在基于Transformer的大語言模型浪潮帶領下,微軟、谷歌、英偉達等大廠,以及斯坦福、卡耐基梅隆等高等學府均開展了具身智能的相關研究。

微軟基于ChatGPT的強大自然語言理解和推理能力,生成控制機器人的相關代碼;

英偉達VIMA基于T5模型,將文本和多模態輸入交錯融合,結合歷史信息預測機器人的下一步行動動作;

斯坦福大學利用LLM的理解、推理和代碼能力,與VLM交互并生成3D value map,來規劃機械臂的運行軌跡;

谷歌具身智能路線較多,包括從PaLM衍生來的PaLM-E,從Gato迭代來的RoboCat,以及最新基于RT-1和PaLM-E升級得到的RT-2。

谷歌在具身智能的研究上更具有廣泛性和延續性。與其他大廠相比,谷歌依托旗下兩大AI科研機構,Google Brain和DeepMind(2023年4月兩大機構合并為Google DeepMind),在具身智能上研究了更多的技術路線,且各路線之間有很好的技術延續性。

其中基于RT-1研究成果,谷歌融合了VLM(PaLM-E是其中一種)和RT-1中收集的大量機器人真實動作數據,提出了視覺語言動作(VLA)模型 RT-2,在直接預測機器人動作的同時,受益于互聯網級別的訓練數據,實現了更好的泛化性和涌現性。

從RT-2的實驗結果看,一方面,面對訓練數據中沒見過的物體、背景、環境,RT-2系列模型能夠仍能實現較高的成功率,遠超基線對比模型,證明了模型有較強的泛化能力。

另一方面,對于符號理解、推理和人類識別三類不存在于機器人訓練數據中的涌現任務,RT-2系列模型也能以較高正確率完成,表明語義知識從視覺語言數據中轉移到RT-2 中,證明了模型的涌現性能。同時,思維鏈(CoT)推理能夠讓RT-2完成更復雜的任務。

任何的訓練都需要數據的支撐。目前來看,機器人數據來源通常是真實數據和合成數據。

真實數據效果更好,但需要耗費大量的人力和物力,不是一般的企業或機構能夠負擔的。谷歌憑借自己的資金和科研實力,耗費17個月時間收集了13臺機器人的13萬條機器人真實數據,為RT-1和RT-2的良好性能打下根基。

谷歌的另一項研究RoboCat,在面對新的任務和場景時,會先收集100-1000個真實的人類專家示例,再合成更多數據,用于后續訓練,是經濟性和性能的權衡。

除了數據來源問題,還有一個就是具身智能體的預測如何映射到機器人的動作,這主要取決于預測結果的層級。

以谷歌PaLM-E和微軟ChatGPT for Robotics為例,預測結果處于高級別設計層級:PaLM-E實現了對具身任務的決策方案預測,但不涉及機器人動作的實際控制,需要依賴低級別的現成策略或規劃器來將決策方案“翻譯”為機器人動作。

微軟默認提供控制機器人的低層級 API,ChatGPT 輸出是更高層級的代碼,只需調用到機器人低層級的庫或API,從而實現對機器人動作的映射和控制。

還有一種情況就是預測結果已經到了低級別動作層級。例如,RT-2輸出的一系列字符串,是可以直接對應到機器人的坐標、旋轉角等信息;VoxPoser規劃的結果直接就是機器人運行軌跡;VIMA也可以借助現有方法將預測的動作token映射到離散的機器人手臂姿勢,即不需要再經過復雜的翻譯將高層級設計映射到低層級動作。

3. 具身智能的難點剖析

具身智能作為邁向通用人工智能(AGI)的重要一步,是學術界和產業界的熱點,隨著大模型的泛化能力進一步提升,各種具身方法和智能體不斷涌現,但是要實現好的具身智能,會面臨算法、工程技術、數據、場景和復雜軟硬件等的諸多挑戰。

首先,要有強大的通用本體平臺。如何解決硬件的關鍵零部件技術突破,形成具有優秀運動能力和操作能力的平臺級通用機器人產品,將具身本體的可靠性、成本和通用能力做到平衡,是一個巨大的挑戰。

從基礎的電機、減速器、控制器到靈巧手等各部分,都需要持續進行技術突破,才能夠滿足大規模商用的落地需求。

同時,考慮到通用能力,人形機器人被認為是具身智能的終極形態。這方面的研發,也將持續成為熱點和核心挑戰。

其次,需要設計強大的智能體系統。

作為具身智能的核心,具備復雜環境感知認知能力的智能體,將需要解決諸多挑戰,包括:物理3D環境精確感知、任務編排與執行、強大的通識能力、多級語義推理能力、人機口語多輪交互能力、long-term記憶能力、個性化情感關懷能力、強大的任務泛化與自學遷移能力等。

同時,具身智能要求實時感知和決策能力,以適應復雜和變化的環境。這要求高速的數據采集、傳輸和處理,以及實時的決策反應,尤其是LLM所消耗的算力規模巨大,對于資源有限的機器人處理系統將形成巨大的數據量、AI計算能力和低延遲的挑戰。

再者,高質量的行業數據將成為巨大挑戰。

現實場景的復雜多變,使得現階段缺乏足夠的場景數據來訓練一個完全通用的大模型,進而讓智能體自我進化。

而且,耦合的本體,需要實際部署到真實環境中,才能夠采集數據,這也是和非具身智能的明顯不同。

比如,在工廠作業中,由于機器人本體并未參與到實際業務,則很多實際運行數據就無法采集,而大量的人類操作數據雖然可以彌補部分不足,但仍然需要實際業務的數據。

當然,通過大模型的涌現能力和思維鏈能力,部分任務可以零樣本學習到,但對于關鍵業務,要求成功率,則仍然需要高質量的垂域數據。同時,通過層次化的智能體設計,將不同任務限定到特定領域,則是一個解決泛化和成功率的有效嘗試。

最后,通過虛擬和真實的交互,持續學習和進化的能力,則是具身智能演進的重要技術途徑。

億萬年的生物演化過程,造就了形態豐富的生命形式。而學習新任務來適應環境的變化,則是持續改進的動力。形態適配環境合適的智能體,則可以快速的學習到解決問題能力,進而更好的適應變化。

但是,由于形態的變化空間無窮巨大,搜索所有可能的選擇在有限的計算資源情況下變的幾乎不可能。本體的自由度設計,也會物理上約束智能體的任務執行能力,進而限制了控制器的學習效果。

在復雜環境、形態演化和任務的可學習性之間,存在著未可知的隱式關系,如何快速學習到合理的規劃和決策能力,則成為具身智能的重要一環。

4. 智元機器人的實踐

8月18日,智元機器人在具身智能遠征A1的發布會提出了一種具身智腦的概念:

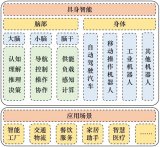

具身智腦EI-Brain(Embodied Intelligence Brain)把機器人的具身智能思維系統分為云端的超腦、端側的大腦、小腦,以及腦干這樣四層,分別對應于機器人任務級、技能級、指令級以及伺服級的能力。

?腦?于完成前?提到的語義級多段推理任務,結合上下文進行任務理解,?且如果模型的通識能?不滿?任務需求,還可以借?更強的云端超腦的互聯?能?。

小腦則負責結合各種傳感器的信息進行運動指令?成,就跟?類?樣,?家?路的時候并不會想著怎么精確地控制每塊肌?收縮,而是由?腦發出?個宏觀指令后,由?腦完成身體的平衡和各種運動學動?學的控制,運控算法都跑在這?層。

最后在硬件底層,由腦?來進?精確的伺服閉環控制每個電機?效精準地執?。

在EI-Brain的設計中,上層大模型聚焦于具體的感知決策和計劃生成,不用依賴于具體的機器人載體硬件;下層視控模型和運控算法聚焦于底層的具體場景的特定動作執行,不用決策整個任務如何完成。超腦、大腦與小腦、腦干能夠相互解耦,不用相互依賴,實現了具身智能系統的層級劃分。

智元遠征A1是為了完成重復性的通用任務而設計,設計時考慮了2個非常重要的指標,“任務泛化率”和“任務執行成功率”。

任務泛化率指的是對未見過的任務的泛化能力,是否能夠按照上述生成的指令計劃進行精準執行。這個指標主要針對是對上層的云端超腦和大腦來說,大模型是否能夠對用戶各種新說法和新的3D環境進行精確的感知決策和指令計劃生成。

任務執行成功率指的是機器人載體在實際物理環境中,執行具體任務的成功率等,這個指標主要針對下層的小腦和腦干來說,視控模型和運控算法是否能夠按照上述生成的指令計劃進行精準執行。

EI-Brain具身智能系統層級有效保證了這兩個指標參數的實現,極大地提升了機器人的智能水平和工作效率,使其在完成復雜任務、泛化任務時,更加得心應手。

類似?動駕駛L1到L5的發展過程,全場景適?的通?機器?的實現也不會是?步到位的。在技能級模型層?,智元機器人定義了?系列的元操作(Meta-Skill)庫,在元操作庫范圍限定的這些有限泛化場景內,機器?能夠?主推理決策出端到端完成任務所需要的動作編排。?且隨著元操作庫列表的不斷擴充,機器?能夠勝任的任務空間將呈指數級增?,在交互中學習進化,最終實現全場景的覆蓋,切?千?百業。

智元遠征A1本體是當前國內通用機器人領域最領先的。智元遠征A1形態與人類相似,身高175cm,重量55kg,最高步速可達7km/h,全身49個自由度,整機承重80kg,單臂最大負載5kg。

智元遠征A1全身搭載了包含諧波?體關節、?星伺服、直線驅動器、空?杯電機等在內的49個各類執?器,也就是說這?版機器?擁有49個?由度。

在硬件層面,智元自研了關節電機PowerFlow、靈巧手SkillHand、反曲膝設計等關鍵零部件,以此提升具身智能機器人的能力、同時降低成本。

在軟件層面,智元自研了AgiROS,是一套機器人運行時中間件系統,在AI感知決策與視覺控制等大模型算法方面,能夠實現自主任務編排、常識推理與規劃執行等。

未來智元將緊跟算法前沿,尤其是大模型的前沿技術,重視數據原始積累和數據平臺建設,形成數據閉環,為算法打下堅實的基礎。結合硬件自研優勢,以具身智能人形機器人為載體,構建豐富的meta-skills技能庫,快速落地相關商業垂域應用場景,在實驗室上的學術探索基礎上邁出商業落地的最為關鍵一步。

-

機器人

+關注

關注

210文章

28210瀏覽量

206543 -

人工智能

+關注

關注

1791文章

46863瀏覽量

237587 -

智能體

+關注

關注

1文章

132瀏覽量

10568 -

稚暉君

+關注

關注

5文章

35瀏覽量

5133 -

智元機器人

+關注

關注

1文章

12瀏覽量

529

原文標題:稚暉君獨家撰文:具身智能即將為通用機器人補全最后一塊拼圖|甲子光年

文章出處:【微信號:jazzyear,微信公眾號:甲子光年】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

具身智能與機器學習的關系

地瓜機器人發布一系列通用機器人套件

100T極致算力+全鏈路開發支持,地瓜機器人為具身智能造“基座”

軟通動力與智元機器人達成合作,共繪人形機器人“具身智能”新篇章

通用機器人初創公司逐際動力完成新一輪戰略融資

廣和通發布基于高通高算力芯片的具身智能機器人開發平臺Fibot

稚暉君獨家撰文:具身智能即將為通用機器人補全最后一塊拼圖

稚暉君獨家撰文:具身智能即將為通用機器人補全最后一塊拼圖

評論