當前,“百模大戰”帶來了算力需求的爆發,AI芯片產業也迎來巨大機遇,“創新架構+開源生態”正在激發多元AI算力產品百花齊放。面對新的產業機會,AI算力產業鏈亟需通過上下游協作共同把握機遇。

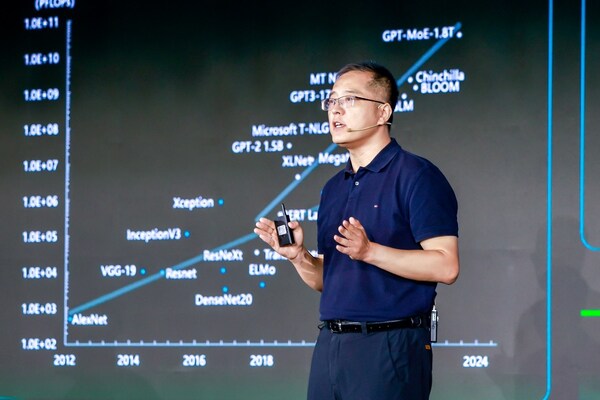

日前,在開放計算中國峰會OCP China Day 2023上,浪潮信息AI&HPC產品線高級產品經理Stephen Zhang就《開放加速規范AI服務器設計指南》進行了專題報告演講,分享了AIGC時代的算力需求趨勢與開放加速計算發展之道。他指出,從系統層面進行產業鏈協同創新成為后摩爾定律時代破解AIGC算力挑戰的必經之路。當前,開放加速計算生態已經在此方面取得了豐富有益的成果,多元的AI算力產品正在加速落地,促進AI算力產業蓬勃發展。

大模型時代的算力需求及趨勢

自ChatGPT發布以來,大家可以明顯地感受到全社會對于生成式人工智能技術的廣泛關注,ChatGPT出圈之后帶來了更多參與者,模型的數量和模型參數量不斷激增。據不完全統計,我們國家的大模型數量已經超過110個,這就帶來了對于AI算力需求的劇增。

針對大模型發展帶來的嚴峻算力挑戰,我們進行了大量的需求分析和趨勢判斷。從AI服務器算力及功耗隨時間變化的趨勢來看,要解決大模型的算力短缺問題,最直接的方式是提高單機的算力。從2016年到現在,AI服務器單機算力增長近100倍,功耗從4千瓦增長到12千瓦,下一代AI服務器的功耗繼續增長到18千瓦乃至20千瓦以上。AI服務器的系統架構供電、散熱方式,以及數據中心基礎設施建設模式,將難以滿足未來高功耗AI服務器的部署需求。

針對大模型發展帶來的嚴峻算力挑戰,我們進行了大量的需求分析和趨勢判斷。從AI服務器算力及功耗隨時間變化的趨勢來看,要解決大模型的算力短缺問題,最直接的方式是提高單機的算力。從2016年到現在,AI服務器單機算力增長近100倍,功耗從4千瓦增長到12千瓦,下一代AI服務器的功耗繼續增長到18千瓦乃至20千瓦以上。AI服務器的系統架構供電、散熱方式,以及數據中心基礎設施建設模式,將難以滿足未來高功耗AI服務器的部署需求。

其次,大模型參數量增長對GPU數量的需求也隨之增加,需要更大的顯存容量承載。2021年,一個千億規模的大模型需要3,000 GB顯存容量空間承載,換算過來需要將近40張80G的GPU才能放得下這個模型,包括權重參數、梯度數據、優化值數據和激活值數據。今天,很多大模型的參數量已經超過了萬億規模,顯存容量將會達到30,000GB,需要將近400塊80G顯存的GPU才能承載,這意味著需要更大規模的算力平臺才能進行如此規模大模型的訓練。

更大規模的平臺會帶來另外一個問題,即卡與卡之間、不同的節點之間的更多通信,大模型的訓練需要融合多種并行策略,對卡間P2P互聯帶寬以及跨節點互聯帶寬提出了更高的要求。

以2457億參數的“源1.0”大模型訓練的工程實踐為例,“源1.0”訓練共有1800億Token,顯存容量需求7.4TB,訓練過程中融合了張量并行、流水線并行、數據并行三種策略。單節點張量并行通信頻次達到每秒82.4次,節點內通信帶寬最低需求達到194GB/s。計算節點內會開展流水線并行,跨節點通信帶寬達到26.8GB/s,至少需要300Gbps通信帶寬才能滿足流水線并行訓練的帶寬需求。在訓練“源1.0”過程中,實際用到兩張200Gbps網卡進行跨節點通信,數據并行通信頻次低但數據量大,帶寬需求至少要達到8.8GB/s,單機400Gbps的帶寬可以滿足。

隨著模型參數量進一步增加以及GPU算力的成倍增加,未來需要更高的互聯帶寬才能滿足更大規模模型的訓練需求。

開放加速計算 為超大規模深度神經網絡而生

面向AIGC大模型訓練的計算系統需要具備三個主要特征,一是大算力,二是高互聯,三是強擴展,傳統的PCIe CEM形態的加速卡很難滿足三個特征需求,因此越來越多的芯片廠商都開發了非PCIe形態的加速卡。

開放計算組織OCP在2019年發布了專門面向大模型訓練的加速計算系統架構,核心是UBB和OAM標準,特點是大算力。Mezz扣卡形態的加速器具備更高的散熱和互聯能力,可以承載具有更高算力的芯片。同時,它有非常強的跨節點擴展能力,可以很輕易地擴展到千卡、萬卡級的平臺,支撐大模型的訓練。這個架構是天然適用于超大規模深度神經網絡訓練的計算架構。

但是,在OAM產業落地過程中,很多廠商所開發的加速卡依然存在硬件接口不統一、互聯協議不統一,同時軟件生態互不兼容,帶來了新型AI加速卡系統適配周期長、定制投入成本高的落地難題,導致算力供給和算力需求之間的剪刀差不斷加大,行業亟需更加開放的算力平臺,以及更加多元的算力支撐大模型的訓練。

但是,在OAM產業落地過程中,很多廠商所開發的加速卡依然存在硬件接口不統一、互聯協議不統一,同時軟件生態互不兼容,帶來了新型AI加速卡系統適配周期長、定制投入成本高的落地難題,導致算力供給和算力需求之間的剪刀差不斷加大,行業亟需更加開放的算力平臺,以及更加多元的算力支撐大模型的訓練。

對此,浪潮信息開展了大量工作,包括技術上的預研和對產業生態的貢獻。2019年開始,浪潮信息牽頭主導了OAM標準的制定,發布了首款開放加速基板UBB,同時開發了全球首款開放加速參考系統MX1,并協同業界領先的芯片廠商一起完成了OAM形態加速卡的適配,證明了這條技術路線的可行性。為了推動符合OAM開放加速規范的系統產業化落地,浪潮信息開發了第一款“ALL IN ONE” OAM服務器產品,把CPU和OAM加速卡集成到一臺19英寸機箱中,實現數據中心級的快速部署,并在眾多客戶的智算中心落地應用。

此后,OAM 芯片的算力和功耗在不斷提升,同時數據中心對于綠色節能的要求也越來越高。對此,我們開發了第一款液冷OAM服務器,可以實現8顆OAM加速器和兩顆高功耗的CPU的液冷散熱,整個液冷散熱覆蓋率超過90%,基于這款產品構建的液冷OAM智算中心解決方案,千卡平臺穩定運行狀態下PUE值小于1.1。而浪潮信息剛剛發布的新一代的OAM服務器NF5698G7,基于全PCIe Gen5鏈路,H2D互聯能力提升4倍,為新一代OAM研發提供了更加先進的部署平臺。

通過平臺架構設計和算力算法協同設計解決能耗問題

僅僅提供算力平臺是不夠的,目前數據中心面臨著巨大的能耗挑戰,尤其是面向大模型訓練的AI服務器,單機功耗輕易超過6-7千瓦。

一個公式可以快速計算訓練一個大模型所需要的整體耗電量(E):分子用6倍模型參數量和訓練過程中所用到的Token數量表征大模型訓練所需要的算力當量,分母用加速卡的數量還有單張加速卡的算力性能表征智算基礎設施所能夠提供的整體算力性能,二者相除的結果代表的是訓練大模型所需要的時間,乘以Ecluster指標(大模型訓練平臺每日耗電量)即可得到整體耗電量。那么,在選定模型并且有確定卡數和規模的情況下,只有通過優化單卡算力值,或者降低單個平臺的耗電量,才能優化大模型訓練所需的整體耗電量。

一個公式可以快速計算訓練一個大模型所需要的整體耗電量(E):分子用6倍模型參數量和訓練過程中所用到的Token數量表征大模型訓練所需要的算力當量,分母用加速卡的數量還有單張加速卡的算力性能表征智算基礎設施所能夠提供的整體算力性能,二者相除的結果代表的是訓練大模型所需要的時間,乘以Ecluster指標(大模型訓練平臺每日耗電量)即可得到整體耗電量。那么,在選定模型并且有確定卡數和規模的情況下,只有通過優化單卡算力值,或者降低單個平臺的耗電量,才能優化大模型訓練所需的整體耗電量。

針對這兩個參數的優化,我們對不同大模型訓練平臺網絡架構設計下,平臺功耗和相應的大模型訓練整體功耗進行了對比研究。以單機2張網卡(NIC)組網方案和單機8張網卡(NIC)組網方案為例,雖然不同網卡數量帶來的單機功耗影響并不顯著,然而放到整個計算平臺層面,網卡數量增加導致交換機數量增加,總功耗會有顯著差異,8網卡方案總功耗可達2000多千瓦,2網卡方案只有1600多千瓦,2張網卡方案可以節省功耗18%。

因此,面向實際應用需求,通過精細化地計算大模型訓練所需要的網絡帶寬,可以在不影響性能的前提下,顯著地優化總功耗。“源”大模型訓練過程當中,僅僅使用了兩張200G的IB卡就完成2457億參數模型的訓練,這是我們發現的第一個優化訓練平臺總功耗的技術路徑。

第二,提高單卡算力利用率以實現提效節能,也是非常重要的一個命題。經我們測試,采用算法和算力架構協同設計的方法,基于算力基礎設施的技術特點,深度優化模型的參數結構和訓練策略,可以用更短的時間完成同等規模模型的訓練。以GPT-3模型的訓練為例,模型訓練時間可以從15天優化為12天,總耗電量節省達到33%。

以上兩點可以說明,應用導向的架構設計,以及算力和算法的協同設計,能夠實現更高效的大模型訓練,最終加速節能降碳目標的實現。

綠色開放加速平臺,賦力大模型高效釋放算力

基于上述在開放計算、高效計算的技術、產品和方法的創新和研究,浪潮信息正在積極構建面向生成式AI的綠色開放加速智算平臺。

去年協同合作伙伴發布的液冷開放加速智算中心解決方案,首先具有非常高的算力性能;其次,可以實現千芯級大規模擴展,支撐超千億規模模型訓練;同時,先進液冷技術使整個平臺的PUE大幅優化。

同時,浪潮信息也在積極構建全棧開放加速智算能力,除了提供底層的AI計算平臺,上層有AI資源平臺,能夠在資源管理層通過統一接口實現對于30余種多元算力芯片的統一的調度和管理。再往上是AI算法平臺,提供開源的深度學習算法框架、大模型以及開放的數據集。在此之上是算力服務,包括算力、模型數據、交付、運維等多種服務模式。最上層是擁有4000多家合作伙伴的元腦生態,浪潮信息和生態合作伙伴共同開展開放加速計算方案的設計,并成功地推向產業落地。

基于開放加速規范的AI計算平臺目前已經適配20多種業界主流的大模型,包括大家非常熟悉的GPT系列、LLaMA、Chat GLM、“源”,同時還支持多類擴散模型適配。

“助百芯,智千模” 加速多元算力落地

在AIGC技術和產業快速發展過程中,雖然業界已經制定了開放加速計算相關規范,但產業落地還存在一些問題。比如,開放計算系統定制化程度高,規范覆蓋的領域不足,包括多元算力芯片的系統適配、管理和調度,以及深度學習環境的部署等等。

在OAM規范基礎上,日前《開放加速規范AI服務器設計指南》發布,基于當前AIGC產業背景下客戶的痛點,定義了開放加速服務器設計的原則,包括應用導向、多元開放、綠色高效、統籌設計。同時對服務器設計方法進行深化和細化,包括從節點層到平臺層的多維協同設計方案。方案充分考量適配和研發過程中遇到的問題,進一步細化了節點到平臺的設計參數,最終目的是提高多元算力芯片的開發和適配、部署效率。

由于面向AIGC訓練的服務器具有非常多的高功耗芯片以及高互聯帶寬設計,穩定性問題嚴峻,需要更加全面的測試保證系統穩定性,減少斷點的發生和對大模型訓練效率的影響。因此,《指南》提供了從結構、散熱、壓力、穩定性、軟件兼容性等全面系統的測試指導。

最后,多元算力要推向產業應用,最關鍵的是性能,包括芯片性能、互聯性能、模型性能以及虛擬化性能。《指南》基于前期積累的Benchmark調優經驗,提出了性能測評和調優標準及方法,幫助合作伙伴更快、更好地將他們最新的芯片產品推向應用落地,提高算力的可用性。最終目標是推動整個AI算力產業的創新和發展,協同產業鏈上下游合作伙伴推動整個開放加速生態,共同應對AIGC時代的算力挑戰。

審核編輯:彭菁

-

芯片

+關注

關注

453文章

50387瀏覽量

421783 -

服務器

+關注

關注

12文章

9017瀏覽量

85182 -

浪潮

+關注

關注

1文章

450瀏覽量

23814 -

AI

+關注

關注

87文章

30106瀏覽量

268399 -

大模型

+關注

關注

2文章

2322瀏覽量

2479

原文標題:開放加速規范AI服務器 解決大模型時代的多元AI算力挑戰

文章出處:【微信號:浪潮AIHPC,微信公眾號:浪潮AIHPC】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

浪潮信息AI存儲性能測試的領先之道

浪潮信息趙帥:開放計算創新 應對Scaling Law挑戰

IBM助力圖靈新智算構建全能AI平臺

浪潮信息推出AIGC存儲解決方案

畢昇大模型應用開發平臺+浪潮信息AIStation,讓大模型定制更簡單

浪潮信息發布AS13000G7-N系列分布式全閃存儲

為大模型專門優化 浪潮信息發布分布式全閃存儲AS13000G7-N系列

浪潮信息發布企業大模型開發平臺"元腦企智"EPAI,加速AI創新落地

浪潮信息發布企業大模型開發平臺“元腦企智”EPAI

潞晨科技Colossal-AI與浪潮信息AIStation完成兼容性互認證

智邦國際與KeyarchOS完成浪潮信息澎湃技術認證

2024 信心滿滿!19家元腦生態伙伴與浪潮信息簽署億元分銷協議

浪潮信息劉軍:智算力系統創新 加速生成式AI產業發展

浪潮信息積極構建面向生成式AI的綠色開放加速智算平臺

浪潮信息積極構建面向生成式AI的綠色開放加速智算平臺

評論