Google DeepMind 和 Meta 的研究人員發表論文《Language Modeling Is Compression》,他們發現 DeepMind 的大語言模型 Chinchilla 70B 在圖像和音頻的無損壓縮上超過了 PNG 和 FLAC。

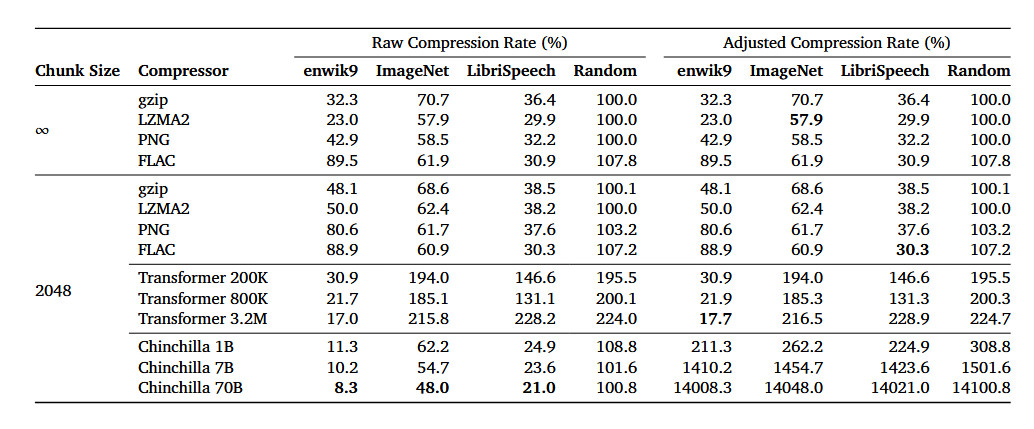

論文提到,Chinchilla 70B 能將 ImageNet 圖像數據庫中的圖像無損壓縮到原始大小 43.4%,超過了 PNG 算法的 58.5%。

Chinchilla 能將 LibriSpeech 音頻數據集中的樣本無損壓縮到原始大小 16.4%,超過 FLAC 算法的 30.3%。

據介紹,Chinchilla 70B 主要是訓練用于處理文本,但它在壓縮其它類型的數據集上的效果也表現優異,甚至優于專門的算法。

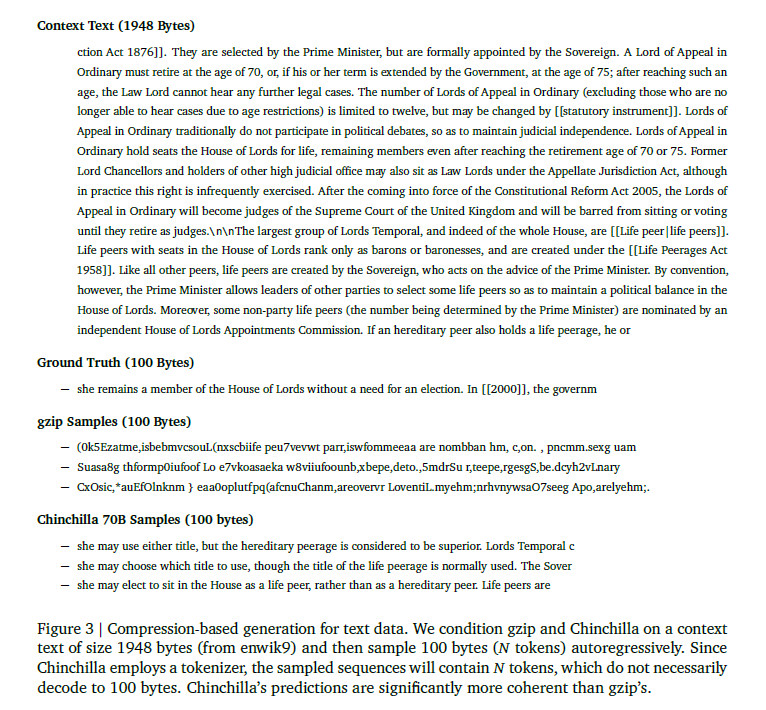

下面的例子比較了 gzip 和 Chinchilla 在示例文本上的壓縮效果。可以看到,gzip 的輸出沒有可讀性。

編輯:黃飛

-

無損壓縮

+關注

關注

0文章

12瀏覽量

8434 -

FLAC

+關注

關注

0文章

4瀏覽量

8494 -

png

+關注

關注

0文章

14瀏覽量

4409 -

大模型

+關注

關注

2文章

2328瀏覽量

2484

原文標題:大模型在無損壓縮方面超越PNG和FLAC

文章出處:【微信號:OSC開源社區,微信公眾號:OSC開源社區】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

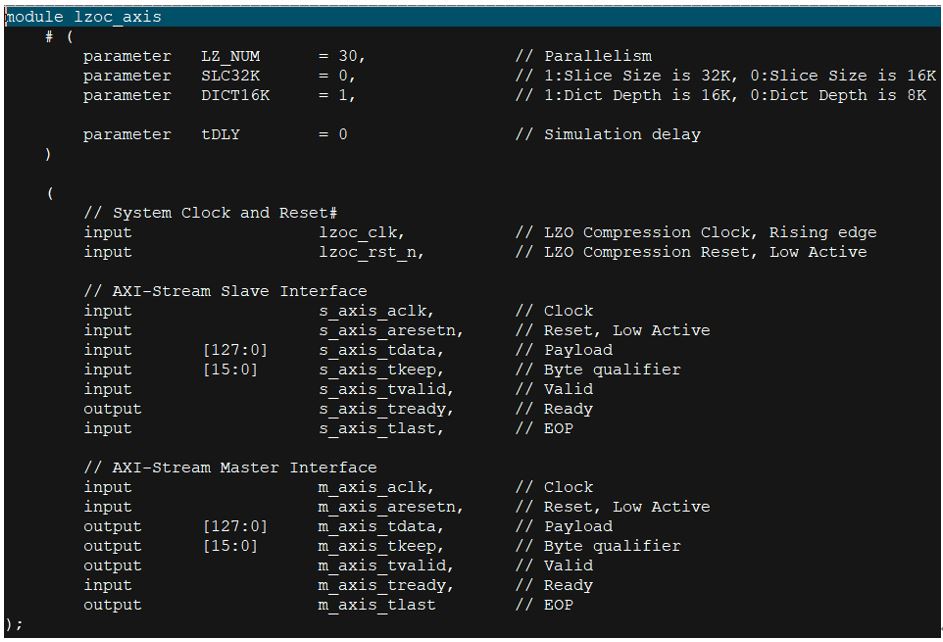

【BearPi-Pico H3863星閃開發板體驗連載】LZO壓縮算法移植

音頻信號的無損壓縮編碼是什么

【大語言模型:原理與工程實踐】大語言模型的應用

【大語言模型:原理與工程實踐】大語言模型的評測

【大語言模型:原理與工程實踐】大語言模型的基礎技術

【RTC程序設計:實時音視頻權威指南】音視頻的編解碼壓縮技術

基于門控線性網絡(GLN)的高壓縮比無損醫學圖像壓縮算法

全球最強大模型易主,GPT-4被超越

高性能無損數據解壓縮FPGA IP,LZO無損數據解壓縮IP

OpenAI視頻模型Sora的架構及應用場景

高性能無損數據壓縮FPGA IP,LZO無損數據壓縮IP

大語言模型無損壓縮方面超越PNG和FLAC

大語言模型無損壓縮方面超越PNG和FLAC

評論