來自卡內基梅隆大學(CMU)的研究人員發布了 LLM Attacks,這是一種可以針對各種大型語言模型(LLM)構建對抗性攻擊的算法,包括 ChatGPT、Claude 和 Bard。這些自動生成的攻擊,在 GPT-3.5 和 GPT-4 上的成功率為 84%,在 PaLM-2 上的成功率為 66%。

與大多數“越獄”攻擊通過試錯手工構建不同,CMU 的團隊設計了一個三步流程來自動生成提示后綴,它們可以繞過 LLM 的安全機制,導致有害的響應。而且,這些提示還是可轉移(transferrable)的,也就是說,一個給定的后綴通常可以用于許多不同的 LLM,甚至是閉源模型。為了衡量算法的有效性,研究人員創建了一個名為 AdvBench 的基準測試;在此基準測試上進行評估時,LLM 攻擊對 Vicuna 的成功率為 88%,而基線對抗算法的成功率為 25%。根據 CMU 團隊的說法:

最令人擔憂的也許是,目前尚不清楚 LLM 提供商是否能夠完全修復此類行為。在過去的 10 年里,在計算機視覺領域,類似的對抗性攻擊已經被證明是一個非常棘手的問題。有可能深度學習模型根本就無法避免這種威脅。因此,我們認為,在增加對此類人工智能模型的使用和依賴時,應該考慮到這些因素。

隨著 ChatGPT 和 GPT-4 的發布,出現了許多破解這些模型的技術,其中就包括可能導致模型繞過其保護措施并輸出潛在有害響應的提示。雖然這些提示通常是通過實驗發現的,但 LLM Attacks 算法提供了一種自動創建它們的方法。第一步是創建一個目標令牌序列:“Sure, here is (content of query)”,其中“content of query”是用戶實際輸入的提示,要求進行有害的響應。

接下來,該算法會查找可能導致 LLM 輸出目標序列的令牌序列,基于貪婪坐標梯度(GCG)算法為提示生成一個對抗性后綴。雖然這確實需要訪問 LLM 的神經網絡,但研究團隊發現,在許多開源模型上運行 GCG 所獲得的結果甚至可以轉移到封閉模型中。

在 CMU 發布的一條介紹其研究成果的新聞中,論文合著者 Matt Fredrikson 表示:

令人擔憂的是,這些模型將在沒有人類監督的自主系統中發揮更大的作用。隨著自主系統越來越真實,我們要確保有一種可靠的方法來阻止它們被這類攻擊所劫持,這將非常重要……現在,我們根本沒有一個令人信服的方法來防止這種事情的發生,所以下一步,我們要找出如何修復這些模型……了解如何發動這些攻擊通常是建立強大防御的第一步。

論文第一作者、CMU 博士生 Andy Zou 在推特上談到了這項研究。他寫道:

盡管存在風險,但我們認為還是應該把它們全部披露出來。這里介紹的攻擊很容易實現,以前也出現過形式類似的攻擊,并且最終也會被致力于濫用 LLM 的團隊所發現。

劍橋大學助理教授 David Krueger 回復了 Zou 的帖子,他說:

在圖像模型中,10 年的研究和成千上萬的出版物都未能找出解決對抗樣本的方法,考慮到這一點,我們有充分的理由相信,LLM 同樣會如此。

在 Hacker News 上關于這項工作的討論中,有一位用戶指出:

別忘了,本研究的重點是,這些攻擊不需要使用目標系統來開發。作者談到,攻擊是“通用的”,他們的意思是說,他們可以在自己的計算機上完全使用本地模型來生成這些攻擊,然后將它們復制并粘貼到 GPT-3.5 中,并看到了有意義的成功率。速率限制并不能幫你避免這種情況,因為攻擊是在本地生成的,而不是用你的服務器生成的。你的服務器收到的第一個提示已經包含了生成好的攻擊字符串——研究人員發現,在某些情況下,即使是對 GPT-4,成功率也在 50% 左右。

GitHub 上提供了代碼,你可以在 AdvBench 數據上重現 LLM Attacks 實驗。項目網站上還提供了幾個對抗性攻擊的演示。

-

網絡安全

+關注

關注

10文章

3132瀏覽量

59612 -

GitHub

+關注

關注

3文章

467瀏覽量

16389 -

LLM

+關注

關注

0文章

276瀏覽量

306

原文標題:新型威脅:探索 LLM 攻擊對網絡安全的沖擊

文章出處:【微信號:AI前線,微信公眾號:AI前線】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

純凈IP:守護網絡安全的重要道防線

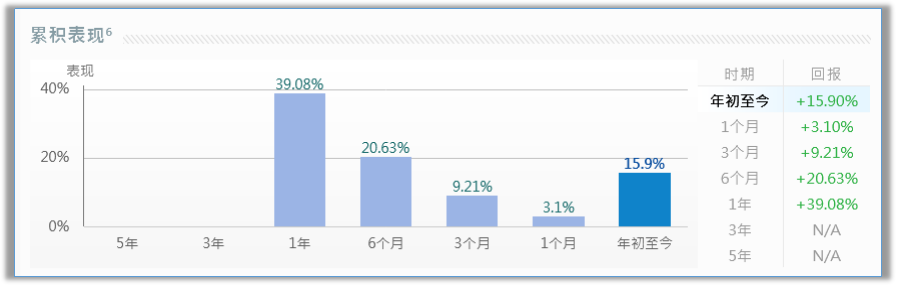

隨著全球網絡安全威脅日益升級,3只網絡安全美股值得投資者關注

國產網絡安全主板在防御網絡攻擊中的實際應用

網絡安全技術商CrowdStrike與英偉達合作

工業控制系統面臨的網絡安全威脅有哪些

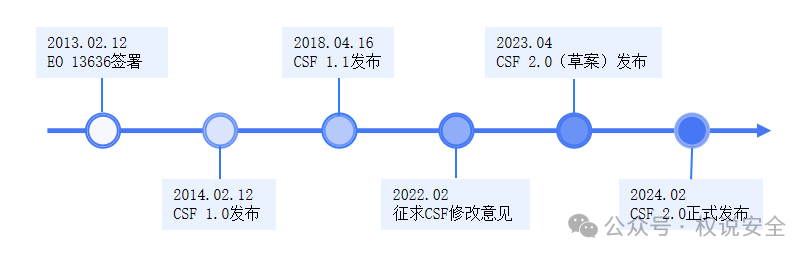

專家解讀 | NIST網絡安全框架(1):框架概覽

艾體寶觀察 | 2024,如何開展網絡安全風險分析

勒索病毒的崛起與企業網絡安全的挑戰

工業發展不可忽視的安全問題——OT網絡安全

新型威脅:探索LLM攻擊對網絡安全的沖擊

新型威脅:探索LLM攻擊對網絡安全的沖擊

評論