★深度學(xué)習(xí)、機(jī)器學(xué)習(xí)、生成式AI、人工智能、大數(shù)據(jù)、高性能計(jì)算、ASIC、大模型訓(xùn)練、盤古大模型、CPU、GPU、L40S服務(wù)器、華為、英偉達(dá)、A100、H100、A800、H800、穩(wěn)態(tài)微聚束、SSMB、清華 SSMB-EUV 光源、非線性動力學(xué)、AI芯片、ChatGPT、Transformer、自監(jiān)督訓(xùn)練、高算力芯片、高粘性 CUDA、Graphcore、Habana、Cerebras、SambaNov、寒武紀(jì)、FPGA、Grace CPU、Hopper GPU、GH200、 SIGGRAPH 、HBM3e、MI300A、MI300X、Infinity Fabric、TPU、AWS、Inferentia、Trainium、Alexa、Meta、MTIA

隨著人工智能、大數(shù)據(jù)、高性能計(jì)算、生成式AI和大語言模型的快速發(fā)展,芯片技術(shù)和服務(wù)器市場變得越來越重要。大模型需要高性能芯片支持,而芯片技術(shù)的發(fā)展又為大模型應(yīng)用和推廣提供可能。在這篇文章中,我們將探討推進(jìn)芯片快速發(fā)展的技術(shù)(穩(wěn)態(tài)微聚束加速器光源)、華為和英偉達(dá)顯卡的對比以及賦能生成式AI和LLM大模型負(fù)載L40S服務(wù)器。

在大模型下的芯片技術(shù)領(lǐng)域,GPU、CPU和ASIC等技術(shù)得到了廣泛應(yīng)用。GPU作為圖形處理器,最初是為了處理圖像和游戲等任務(wù)而設(shè)計(jì)的。然而,隨著人工智能和深度學(xué)習(xí)的發(fā)展,GPU逐漸成為大模型訓(xùn)練和推理的首選芯片。

華為和英偉達(dá)顯卡在大模型服務(wù)市場中具有重要地位。華為依托其強(qiáng)大的技術(shù)實(shí)力和品牌影響力,在顯卡市場中占據(jù)一席之地。英偉達(dá)則憑借其領(lǐng)先的GPU技術(shù)和廣泛的應(yīng)用領(lǐng)域,成為了大模型服務(wù)市場的領(lǐng)導(dǎo)者。在銷售量和市場份額方面,英偉達(dá)略勝一籌,但是華為和其它競爭對手也在不斷追趕。

GPU L40S采用先進(jìn)的芯片技術(shù),可以快速、準(zhǔn)確地處理大規(guī)模的數(shù)據(jù)。具有高度的可擴(kuò)展性,根據(jù)需要增加或減少計(jì)算資源。此外,還采用先進(jìn)的算法和模型優(yōu)化技術(shù),大大提高模型訓(xùn)練的效率和精度。

穩(wěn)態(tài)微聚束加速器光源

在芯片制造領(lǐng)域,光刻技術(shù)一直扮演著至關(guān)重要的角色。然而,傳統(tǒng)的光刻技術(shù)也存在一些明顯的局限性,這些局限性在新一代芯片制造中變得尤為明顯。傳統(tǒng)的光刻技術(shù)需要使用大型、昂貴的設(shè)備,如荷蘭ASML公司生產(chǎn)的***。這些設(shè)備的高成本使得芯片制造過程變得昂貴,不利于成本的降低。而且,傳統(tǒng)的光刻技術(shù)在追求更小的制程和更高的性能時遇到了困境,因?yàn)樗鼈兪艿搅斯庠垂β噬舷薜南拗啤_@導(dǎo)致了制程的瓶頸,制約了芯片技術(shù)的發(fā)展。

清華大學(xué)的唐教授提出的“穩(wěn)態(tài)微聚束加速器光源”為芯片制造帶來了一種全新的思路。這一方法的核心在于通過高能加速器對電子進(jìn)行加速,然后讓這些電子穿過交替變化的磁場,從而產(chǎn)生高頻率和短波長的電磁波,包括可見光和X射線。簡單來說就是將電子加速到接近光速,從而獲得更短波長的光,為芯片制造提供了全新的工具。

一、加速器光源簡介

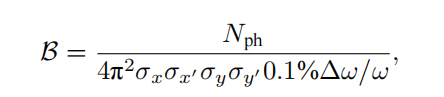

同步輻射是帶電粒子在高速運(yùn)動時產(chǎn)生的電磁輻射,其特點(diǎn)包括高亮度、寬譜帶、高準(zhǔn)直性和偏振性等。自20世紀(jì)70年代起,人們開始專門建設(shè)電子儲存環(huán)來產(chǎn)生同步輻射。一個同步輻射光源由電子注入器、電子儲存環(huán)和光束線站組成,追求高亮度和更好相干性,經(jīng)歷四代的發(fā)展。中國大陸的北京同步輻射裝置屬于第一代,合肥光源屬于第二代,上海光源屬于第三代,正在建設(shè)的高能同步輻射光源屬于第四代。同步輻射的亮度定義為單位時間、單位面積、單位發(fā)散角、0.1%帶寬內(nèi)的光子數(shù)。

同步輻射光源的相干性包括橫向和縱向兩方面。橫向相干性與光源尺寸有關(guān),縱向相干性與光源譜寬有關(guān)。為獲得更高亮度和相干性,需要提高輻射強(qiáng)度、縮小譜寬、減小電子束的發(fā)散角。同步輻射光源的發(fā)展已經(jīng)降低電子束的橫向發(fā)散角,從而獲得良好的橫向相干性,但縱向相干性仍然較弱,導(dǎo)致束長遠(yuǎn)超過相干長度,輻射功率較低。

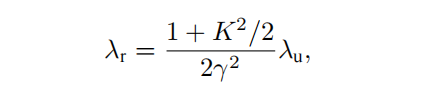

自由電子激光克服這一缺點(diǎn),利用電子束在波蕩器中自放大發(fā)射的原理,通過電子束和輻射波在波蕩器中相互作用形成微聚束,產(chǎn)生強(qiáng)相干輻射。這種正反饋過程導(dǎo)致輻射指數(shù)增長,與同步輻射相比,自由電子激光的峰值亮度提高8-10數(shù)量級,相干性更好,脈沖長度更短。其使用自由電子而不是束縛電子,輻射波長可以靈活調(diào)節(jié)。

自由電子激光的輻射波長由電子束能量、波蕩器參數(shù)和相對論因子γ決定,而在X射線波段,自由電子激光是唯一的相干光源。可分為低增益模式和高增益模式,早期主要是低增益模式,輻射在共振腔內(nèi)被多次放大,而當(dāng)前主要發(fā)展的是高增益短波長自由電子激光,即電子束單次通過波蕩器就完成從發(fā)射到飽和的過程,特別是X射線自由電子激光。

高增益短波長自由電子激光對電子束質(zhì)量的要求很高,需要電子束橫向發(fā)散度足夠小、能量散度足夠小、電流足夠大,以保證增益大于損耗。

自由電子激光裝置示意圖

高增益自由電子激光對電子束質(zhì)量要求非常高,需要高峰值電流、低發(fā)散度和低能量散度。為滿足這些要求,主要依靠直線加速器產(chǎn)生電子束。與儲存環(huán)不同,自由電子激光的重復(fù)頻率較低,為獲取高重復(fù)頻率,正在研發(fā)采用超導(dǎo)射頻直線加速器的自由電子激光。

加速器光源已成為人類探索物質(zhì)世界的最前沿工具之一,基于電子儲存環(huán)的同步輻射光源提供高重復(fù)頻率的輻射,基于直線加速器的自由電子激光提供高峰值亮度的輻射,是兩種主要類型的加速器光源。這兩類大科學(xué)裝置孕育眾多突破性基礎(chǔ)研究成果,在先進(jìn)制造與產(chǎn)業(yè)發(fā)展中的作用難以估量。

全球有超過50個同步輻射光源和7個X射線自由電子激光裝置建成或在建,最先進(jìn)的加速器光源因其光束質(zhì)量、科研支撐作用、建設(shè)投入和技術(shù)復(fù)雜程度,已成為國家綜合實(shí)力和競爭力的重要體現(xiàn)。

二、穩(wěn)態(tài)微聚束加速器光源原理

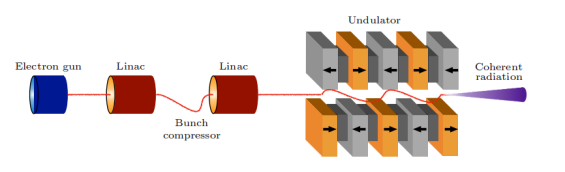

隨著加速器光源的發(fā)展,用戶需求也在不斷增長,除同步輻射和自由電子激光,人們也期待出現(xiàn)一種同時實(shí)現(xiàn)高峰值功率和高重復(fù)頻率的光源。2010年,Ratner和Chao首次提出一種新型儲存環(huán)光源——穩(wěn)態(tài)微聚束(SSMB)。

SSMB使用激光而不是射頻腔來調(diào)制儲存環(huán)中的電子束。由于激光與電子束的傳播方向垂直,因此不能有效地交換能量。為縱向聚焦調(diào)制電子束,扭擺磁鐵被采用,實(shí)現(xiàn)激光調(diào)制,類似于射頻腔調(diào)制。

與傳統(tǒng)儲存環(huán)相比,SSMB儲存環(huán)的標(biāo)志是使用激光調(diào)制器代替射頻腔。

SSMB儲存環(huán)(b)與傳統(tǒng)儲存環(huán)(a)對比

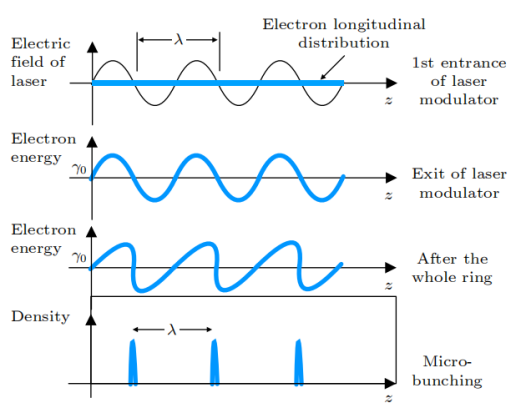

微聚束的原理示意圖

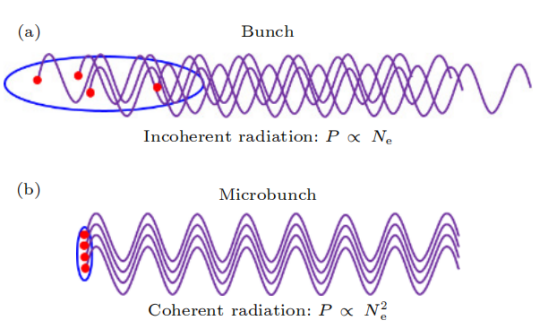

在SSMB儲存環(huán)中,由于激光波長比微波波長短了約6個數(shù)量級,通過精心設(shè)計(jì)的磁系統(tǒng),電子束團(tuán)長度可以達(dá)到亞微米至納米量級,形成微聚束。同時,束團(tuán)間隔從微波波長縮短到激光波長,使得單位長度內(nèi)的束團(tuán)數(shù)目提高了6個數(shù)量級。與傳統(tǒng)束團(tuán)相比,微聚束的特點(diǎn)是束團(tuán)內(nèi)電子縱向分布長度比輻射波長短,不同電子的輻射場保持相干并相干疊加,使得輻射強(qiáng)度與束長內(nèi)電子數(shù)平方成正比,遠(yuǎn)高于非相干輻射的線性關(guān)系。

(a)普通束團(tuán)非相干輻射及(b)微聚束相干輻射示意圖

微聚束產(chǎn)生強(qiáng)相干輻射的原因是含有N個電子的束團(tuán)輻射功率包括與N線性相關(guān)的非相干輻射和與N的平方相關(guān)的相干輻射。相干輻射顯著高于非相干輻射需要束長小于輻射波長,因此納米級束長的微聚束可產(chǎn)生短波長相干輻射。

高增益自由電子激光中的微聚束源自束內(nèi)不穩(wěn)定性,難以長期維持,而SSMB中的微聚束來自激光主動調(diào)制,是穩(wěn)定的相干輻射,可在環(huán)中重復(fù)利用。SSMB結(jié)合微聚束的強(qiáng)相干性和儲存環(huán)的高重復(fù)頻率,可提供高平均功率、窄帶寬的相干輻射,具有巨大的潛力。SSMB輻射的多項(xiàng)特性可為加速器光子科學(xué)研究和應(yīng)用帶來新機(jī)遇,如EUV光刻的光源等。

三、SSMB 原理的實(shí)驗(yàn)驗(yàn)證

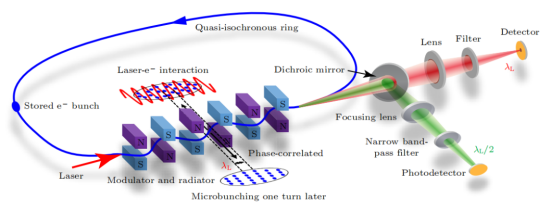

穩(wěn)態(tài)微聚束(SSMB)從概念到應(yīng)用必須進(jìn)行原理驗(yàn)證實(shí)驗(yàn)。清華大學(xué)等自2017年開始進(jìn)行SSMB原理驗(yàn)證研究,利用德國的MLS準(zhǔn)等時儲存環(huán)完成了SSMB的原理驗(yàn)證。

SSMB原理驗(yàn)證實(shí)驗(yàn)示意圖

在SSMB原理驗(yàn)證實(shí)驗(yàn)中,利用德國的MLS準(zhǔn)等時儲存環(huán),電子束被激光調(diào)制能量后,形成微米量級的調(diào)制周期密度調(diào)制,即微聚束。微聚束在波蕩器中發(fā)出強(qiáng)相干輻射,通過檢測該輻射驗(yàn)證微聚束形成。

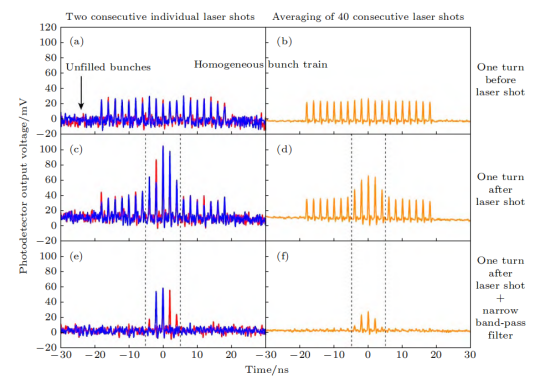

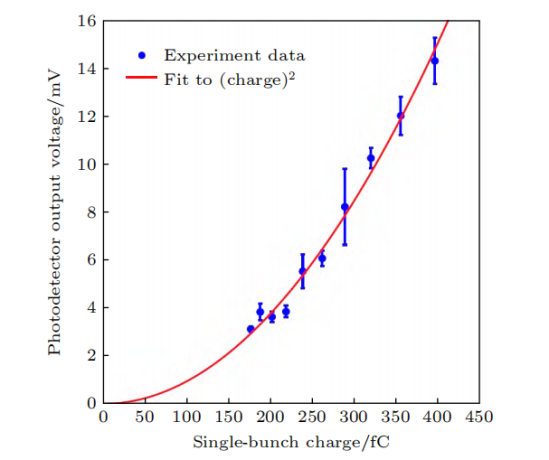

實(shí)驗(yàn)結(jié)果顯示,被激光調(diào)制的電子束輻射信號得到放大,同時窄帶濾波后的信號比寬譜輻射更大,證明了微聚束的窄帶相干輻射。此外,還研究了輻射強(qiáng)度與束流強(qiáng)度的關(guān)系。通過這一原理驗(yàn)證實(shí)驗(yàn),首次展示了激光調(diào)制可在環(huán)中產(chǎn)生微聚束并發(fā)出相干輻射的效應(yīng),完成SSMB核心概念的實(shí)驗(yàn)驗(yàn)證。

SSMB原理驗(yàn)證實(shí)驗(yàn)結(jié)果

在實(shí)驗(yàn)中,還測量了輻射功率與電荷量的依賴關(guān)系,結(jié)果顯示了與電荷量平方成正比的特點(diǎn),這正是相干輻射最重要的特征。此外,輻射呈現(xiàn)窄帶特性。這兩點(diǎn)有力地證明了微聚束的形成。最近,我們還進(jìn)一步實(shí)現(xiàn)了微聚束在儲存環(huán)中多圈穩(wěn)定存在,電子束實(shí)現(xiàn)了多圈相干發(fā)射。通過檢測輻射功率關(guān)系和頻譜特性,驗(yàn)證了微聚束形成并相干發(fā)射。進(jìn)而展示微聚束可在環(huán)中多圈穩(wěn)定,完成SSMB核心概念的多圈相干發(fā)射驗(yàn)證。

SSMB原理驗(yàn)證實(shí)驗(yàn)結(jié)果

實(shí)驗(yàn)成功實(shí)現(xiàn)微聚束的形成和多圈穩(wěn)定存在,這證明了電子縱向位置能以精確于激光波長的精度在環(huán)中關(guān)聯(lián),使電子穩(wěn)定受困于激光形成的勢場。這一實(shí)驗(yàn)與直線段上的微聚束實(shí)驗(yàn)不同,重點(diǎn)在于展示了:

1)微聚束是經(jīng)過一整圈形成的,驗(yàn)證粒子動力學(xué)的one-turn map概念;

2)微聚束基于預(yù)先儲存的電子束形成,電子束參數(shù)由儲存環(huán)決定。

該實(shí)驗(yàn)僅展示one-turn map的一次迭代形成微聚束,而SSMB需要多次迭代實(shí)現(xiàn)穩(wěn)態(tài)微聚束。這是從0到1的驗(yàn)證,標(biāo)志著SSMB發(fā)展的第一個里程碑。即使在非優(yōu)化環(huán)中,SSMB機(jī)理也展現(xiàn)出強(qiáng)大的魯棒性,這激勵我們構(gòu)建專用環(huán)進(jìn)一步完美實(shí)現(xiàn)SSMB。

四、SSMB 儲存環(huán)的核心物理問題及關(guān)鍵技術(shù)挑戰(zhàn)

SSMB原理驗(yàn)證實(shí)驗(yàn)的成功證明SSMB光源的可行性。為進(jìn)一步推進(jìn)SSMB光源的實(shí)際建設(shè),需要深入研究其核心物理并解決關(guān)鍵技術(shù)挑戰(zhàn)。相比傳統(tǒng)儲存環(huán),SSMB中的束長縮短6個數(shù)量級,為加速器物理和技術(shù)的發(fā)展帶來了新的機(jī)遇。下一步需要關(guān)注SSMB在環(huán)中的產(chǎn)生機(jī)理、SSMB的輻射特性以及技術(shù)實(shí)現(xiàn)方面的關(guān)鍵挑戰(zhàn)。

1、SSMB 在儲存環(huán)中的產(chǎn)生

1)SSMB是一個多次通過的裝置,與電子束團(tuán)單次通過的高增益FEL不同

要求超短束團(tuán)在輻射段能夠一圈接一圈地重復(fù)出現(xiàn),即超短束團(tuán)在輻射段中呈現(xiàn)的是該儲存在環(huán)中的本征態(tài)。為了實(shí)現(xiàn)在較低調(diào)制激光功率下的束團(tuán)壓縮,對于儲環(huán)的lattice設(shè)計(jì)而言,探索橫縱向耦合在每一圈中的利用方式是一個新穎且有趣的課題。

2)非線性動力學(xué)效應(yīng)在SSMB儲存環(huán)中起著重要作用

由于對束團(tuán)的操控要求精微,非線性滑相因子、非線性橫縱向耦合等都可能影響束團(tuán)動力學(xué),如六維動力學(xué)孔徑以及束流在六維相空間的分布。在傳統(tǒng)儲存環(huán)中,主要關(guān)注橫向動力學(xué)孔徑的優(yōu)化,而SSMB則需要同時關(guān)注橫向和縱向,即六維相空間的優(yōu)化。

因此,需要發(fā)展相關(guān)的理論并結(jié)合先進(jìn)的數(shù)值方法(如機(jī)器學(xué)習(xí)、遺傳算法)進(jìn)行SSMB的非線性動力學(xué)優(yōu)化。此外,集體效應(yīng)也是SSMB儲存環(huán)中需要關(guān)注的問題。由于SSMB儲存環(huán)中束團(tuán)極短,束流的峰值流強(qiáng)和平均流強(qiáng)相對較高,相干同步輻射、束內(nèi)散射以及阻抗壁尾場等都可能會對微束團(tuán)結(jié)構(gòu)的穩(wěn)態(tài)參數(shù)以及穩(wěn)定存儲產(chǎn)生影響從而限制束流能量和強(qiáng)度。此外,SSMB儲存環(huán)內(nèi)的束流分布模式不同于傳統(tǒng)儲存環(huán),微束團(tuán)的輻射可以追上其前方的一個或多個微束團(tuán),使得通常被認(rèn)為是短程的相干同步輻射在SSMB的語境下變?yōu)殚L程。這些因素要求對相干同步輻射、橫縱向耦合導(dǎo)致的束團(tuán)長度變化、三維任意耦合以及縱向強(qiáng)聚焦lattice中的IBS等進(jìn)行仔細(xì)的評估和研究。

3)誤差容忍度和噪聲分析在非線性效應(yīng)顯著的SSMB中也變得非常重要

噪聲對電子束團(tuán)的影響按頻率可分為兩部分:高頻噪聲導(dǎo)致束團(tuán)在相空間的擴(kuò)散從而引起發(fā)射度的增長,而低頻噪聲會導(dǎo)致束團(tuán)的質(zhì)心運(yùn)動。對于高頻噪聲,需要保證其對束流穩(wěn)態(tài)發(fā)射度的貢獻(xiàn)處于可接受的范圍內(nèi)以實(shí)現(xiàn)超短電子束團(tuán)的形成;對于低頻噪聲,需要保證其對束流的影響滿足絕熱條件,從而使電子束團(tuán)在質(zhì)心受噪聲影響發(fā)生移動時保證發(fā)射度不變。如果噪聲對電子束的影響超出了可接受范圍,需要采用相應(yīng)的反饋系統(tǒng)或其他阻尼機(jī)制來降低噪聲的影響。需要注意的是,由于SSMB的工作模式(如縱向強(qiáng)聚焦、強(qiáng)縱橫耦合)不同于一般儲存環(huán),其噪聲和誤差容忍度的解析分析也將相對復(fù)雜。如傳統(tǒng)射頻腔相噪分析中采用的正則微擾論在縱向強(qiáng)聚焦儲存環(huán)中就無法直接應(yīng)用因?yàn)樵搫恿ο到y(tǒng)是不可積的(混沌的)。另一方面借助于現(xiàn)有計(jì)算機(jī)的強(qiáng)大計(jì)算能力可以對噪聲的影響進(jìn)行直接的數(shù)值模擬研究。

2、SSMB 的輻射特性

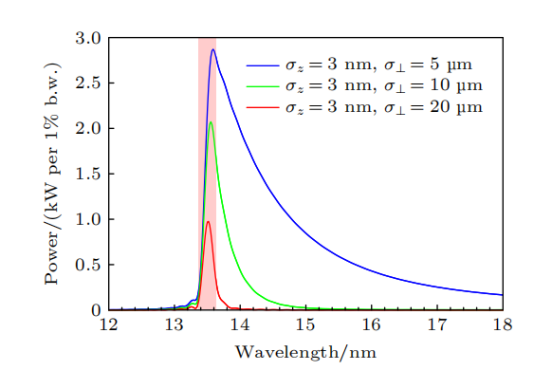

在形成穩(wěn)態(tài)微聚束后,需要研究SSMB的輻射特性。SSMB的微聚束縱向發(fā)散極小,輻射在縱向上高度相干,其束流分布模式獨(dú)特。為指導(dǎo)設(shè)計(jì)與優(yōu)化,需要研究束流在六維相空間的分布對SSMB輻射參數(shù)的影響。研究實(shí)驗(yàn)者已經(jīng)進(jìn)行相關(guān)的理論推導(dǎo)和程序開發(fā)。計(jì)算結(jié)果顯示,在適當(dāng)?shù)膮?shù)下,SSMB可以直接實(shí)現(xiàn)平均功率1kW以上的EUV輸出,這為SSMB的光源設(shè)計(jì)提供了指導(dǎo)。

SSMB-EUV光源輻射能譜樣例

3、SSMB關(guān)鍵技術(shù)挑戰(zhàn)

要實(shí)現(xiàn)SSMB光源的真正技術(shù)可行性,需要掌握幾項(xiàng)核心技術(shù)。

1)激光調(diào)制器是SSMB與傳統(tǒng)儲存環(huán)之間最重要的區(qū)別

為實(shí)現(xiàn)SSMB,需要高激光功率、相位鎖定,并采用連續(xù)波或高占空比的調(diào)制激光以提高束流占空比和輻射光的平均功率。因此,SSMB的激光調(diào)制系統(tǒng)采用了光學(xué)增益腔。

2)長脈沖注入系統(tǒng)是實(shí)現(xiàn)高輻射功率所必需

由于SSMB的平均流強(qiáng)較高,約為1A,因此需要專門設(shè)計(jì)大電荷量、長脈沖(百納秒量級)注入束流。為了減少SSMB出光過程中的功率變化,希望其工作在流強(qiáng)基本恒定不變的top-up模式,同時也可降低對單次注入束流強(qiáng)度的要求。

3)直線感應(yīng)加速器是實(shí)現(xiàn)SSMB束流能量補(bǔ)充的可行選擇之一

為了提高SSMB儲存環(huán)的束流占空比,需要采用連續(xù)激光,并對長脈沖電子束的能量補(bǔ)充提出不同于傳統(tǒng)儲存環(huán)的要求。此外,高精度磁鐵、高精度控制系統(tǒng)等也需要在現(xiàn)有的同步輻射光源的基礎(chǔ)上進(jìn)一步發(fā)展。

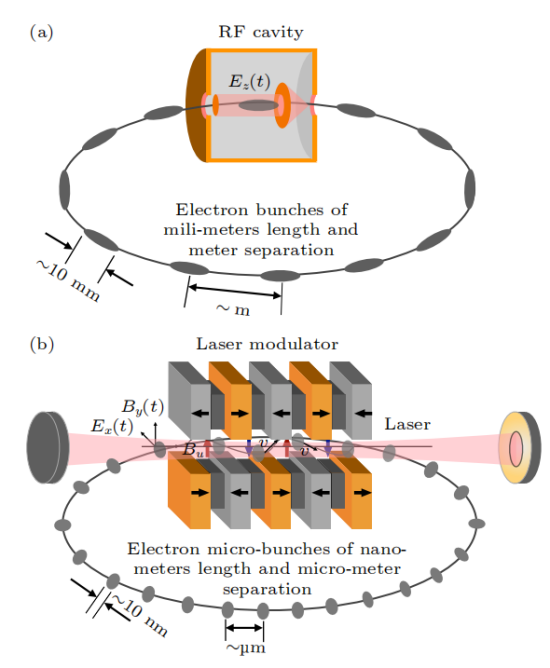

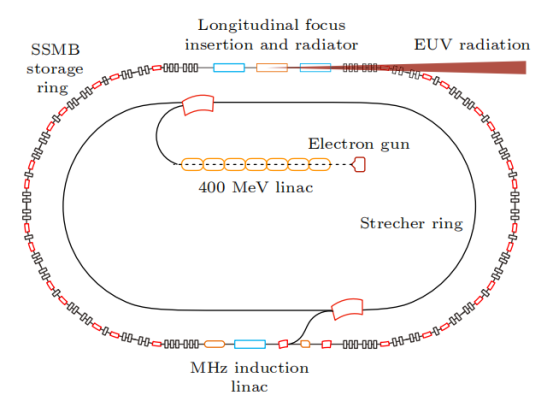

五、清華 SSMB-EUV 光源

自2017年以來,清華團(tuán)隊(duì)開始研究面向EUV光刻的大功率SSMB-EUV光源。在原理驗(yàn)證、束流動力學(xué)、物理設(shè)計(jì)和關(guān)鍵技術(shù)方面取得了重要進(jìn)展。在束流動力學(xué)研究中,團(tuán)隊(duì)解決了實(shí)現(xiàn)超短束所需關(guān)注的核心物理問題,完成了能夠穩(wěn)定儲存納米級束的儲存環(huán)設(shè)計(jì),并開展了集體效應(yīng)等方面的研究。輻射理論和數(shù)值計(jì)算表明,SSMB可以實(shí)現(xiàn)千瓦級的EUV輸出。在關(guān)鍵技術(shù)方面,團(tuán)隊(duì)搭建了光學(xué)腔平臺,研制出樣機(jī),并合作研發(fā)了MHz感應(yīng)加速單元等。

基于這些研究成果,團(tuán)隊(duì)提出了SSMB-EUV光源方案。該方案采用微波電子槍和直線加速器產(chǎn)生束流,經(jīng)展束環(huán)調(diào)整分布后注入主環(huán),在主環(huán)中激光調(diào)制形成穩(wěn)態(tài)微聚束。微聚束在輻射段被進(jìn)一步壓縮,實(shí)現(xiàn)13.5nm EUV強(qiáng)相干發(fā)射,輸出功率達(dá)到千瓦量級。這一創(chuàng)新為EUV光源技術(shù)的發(fā)展提供了新的途徑。

清華 SSMB-EUV 光源示意圖

下面簡要介紹各分系統(tǒng)的功能和實(shí)現(xiàn)方式:

1)直線注入器

直線注入器產(chǎn)生的能量約400MeV,它能在約10厘米間隔內(nèi)提供數(shù)百個等電荷量的微脈沖束團(tuán),微脈沖束團(tuán)的脈沖長度在百納秒量級,總電荷量也是百納庫量級,平均流強(qiáng)為1A。

2)展束環(huán)

多脈沖束團(tuán)被注入到展束環(huán)中,通過優(yōu)化微脈沖束團(tuán)的能散和展束環(huán)的滑相因子,使微束團(tuán)長度在展束環(huán)中被拉長,相鄰的束團(tuán)流強(qiáng)分布首尾相連相互重疊,形成近似均勻流強(qiáng)的長度百納秒量級的準(zhǔn)直流電子束,然后注入到SSMB儲存環(huán)中。

3)SSMB主環(huán)

被注入的束流被調(diào)制激光的勢阱俘獲(光學(xué) micro-bucket),經(jīng)過輻射阻尼及量子激發(fā)到達(dá)平衡,形成間隔為激光波長(約 )的微束團(tuán)。SSMB主環(huán)的設(shè)計(jì)極小化了全局及局部滑相因子,從而控制全環(huán)縱向函數(shù),使電子束實(shí)現(xiàn)極低的穩(wěn)態(tài)縱向發(fā)射度和束團(tuán)長度(十納米到數(shù)十納米)。儲存環(huán)的非線性動力學(xué)經(jīng)過仔細(xì)優(yōu)化,能實(shí)現(xiàn)足夠大的六維動力學(xué)孔徑,以保證束團(tuán)能穩(wěn)定且具有足夠壽命地儲存在光學(xué) micro-bucket 中。

4)束團(tuán)壓縮及輻射單元

對SSMB主環(huán)中的束團(tuán)進(jìn)行進(jìn)一步壓縮,在輻射段實(shí)現(xiàn)長度約為3nm的微束團(tuán),從而產(chǎn)生波長為13.5nm的強(qiáng)相干EUV光。具體的壓縮方案包括縱向強(qiáng)聚焦、橫縱向耦合(廣義縱向強(qiáng)聚焦)等。輻射元件采用優(yōu)化設(shè)計(jì)的波蕩器,能產(chǎn)生大功率窄帶寬的EUV光。

5)調(diào)制激光系統(tǒng)

采用窄線寬種子激光和高精細(xì)度光學(xué)增益腔,實(shí)現(xiàn)約1MW的平均存儲功率,滿足SSMB-EUV光源需求。

6)能量補(bǔ)充系統(tǒng)

采用MHz重頻的直線感應(yīng)加速器,補(bǔ)償平均流強(qiáng)約為1A的束流平均功率數(shù)千瓦到十千瓦的輻射損失。

六、SSMB-EUV 光源對科學(xué)研究及芯片光刻潛在的變革性影響

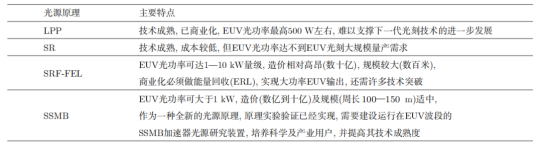

目前全球唯一的 EUV ***供應(yīng)商是荷蘭的 ASML 公司,其采用激光等離子體(LPP)的 EUV 光源。具體來說,ASML 通過一臺功率大于 20 kW 的 CO 氣體激光器轟擊液態(tài)錫形成等離子體,從而產(chǎn)生 13.5 nm 的 EUV 光。

通過不斷優(yōu)化驅(qū)動激光功率、EUV 光轉(zhuǎn)化效率、收集效率以及控制系統(tǒng),LPP-EUV 光源目前能夠在中間焦點(diǎn)處實(shí)現(xiàn) 350 W 左右的 EUV 光功率,該功率水平剛達(dá)到工業(yè)量產(chǎn)的門檻指標(biāo)。產(chǎn)業(yè)界認(rèn)為 LPP 光源未來可以達(dá)到的 EUV 功率最高為 500 W 左右,如果想要繼續(xù)將 EUV 光刻向 3 nm 以下工藝節(jié)點(diǎn)推進(jìn),LPP-EUV 光源的功率將遇到瓶頸。

由于基于等離子體輻射的 EUV 光源功率進(jìn)一步突破困難,因此基于相對論電子束的各類加速器光源逐漸進(jìn)入產(chǎn)業(yè)界的視野,如基于超導(dǎo)直線加速器技術(shù)的高重頻 FEL 以及 SSMB 等。

SSMB-EUV 光源用于 EUV 光刻具有以下特點(diǎn)和潛在優(yōu)勢:

1、高平均功率

SSMB儲存環(huán)支持安裝多條EUV光束線,可同時作為光刻大功率照明光源及掩模、光學(xué)器件的檢測光源,還可以為EUV光刻膠的研究提供支撐

2、窄帶寬與高準(zhǔn)直性

SSMB光源容易實(shí)現(xiàn)EUV光刻所需的小于2%的窄帶寬要求,并且波蕩器輻射集中于mrad的角度范圍內(nèi)。窄帶寬以及高準(zhǔn)直的特性可為基于SSMB的EUV光刻光學(xué)系統(tǒng)帶來創(chuàng)新性的設(shè)計(jì),同時可以降低EUV光學(xué)反射鏡的工藝難度

3、高穩(wěn)定性的連續(xù)波輸出

SSMB輸出的是連續(xù)波或準(zhǔn)連續(xù)波輻射,可以避免輻射功率大幅漲落而引起的對芯片的損傷。儲存環(huán)光源的穩(wěn)定性好,采用top-up運(yùn)行模式的SSMB儲存環(huán)可使光源的長時間可用性得到進(jìn)一步提升

4、輻射清潔

與LPP-EUV光源相比,波蕩器輻射的高真空環(huán)境對光刻的光學(xué)系統(tǒng)反射鏡不會產(chǎn)生污染,鏡子的使用壽命可以大大延長

5、可拓展性

SSMB原理上容易往更短波長拓展,為下一代采用波長6.x nm的Blue-X光刻技術(shù)留有可能

各類 EUV 光源特點(diǎn)

SSMB-EUV光源的成功研制將有望推動我國EUV光刻技術(shù)的跨越式進(jìn)步。與此同時,SSMB加速器光源能夠產(chǎn)生高平均功率、窄線寬的從太赫茲到軟X射線的相干輻射,并且其時間結(jié)構(gòu)可調(diào)范圍廣泛,這將對物理、化學(xué)、能源、環(huán)境等學(xué)科的基礎(chǔ)研究與應(yīng)用研究帶來全新的研究工具和手段。

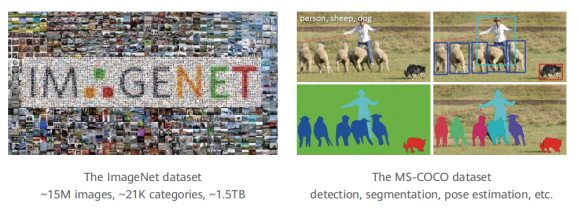

計(jì)算機(jī)視覺的目標(biāo)是設(shè)計(jì)能識別和處理視覺信號的程序,使計(jì)算機(jī)"看"得更好。典型任務(wù)有圖像分類、物體檢測、分割、追蹤和姿態(tài)估計(jì)。ImageNet數(shù)據(jù)集包含超過2萬個物體類別,用于圖像分類。MS-COCO數(shù)據(jù)集包含檢測、分割等任務(wù)。

在計(jì)算機(jī)中,視覺信號以像素密集采樣的方式來存儲光強(qiáng)度。然而,像素并不代表語義信息,因此這種存儲形式與人類理解之間存在巨大的差距

華為盤古大模型介紹

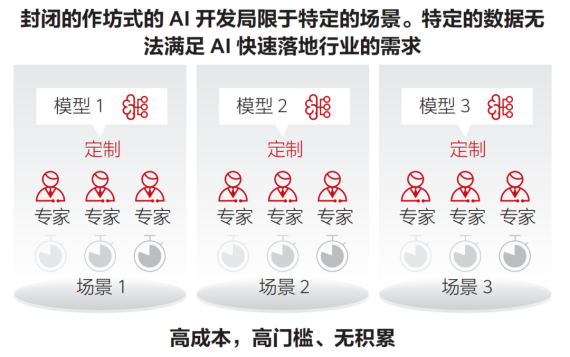

AI正在逐漸深入到企業(yè)的核心生產(chǎn)系統(tǒng)中,并發(fā)揮出更大的價值。預(yù)計(jì)到2025年,企業(yè)采用AI的比例將達(dá)到86%,而當(dāng)前這一數(shù)字僅為4%。在眾多的AI項(xiàng)目中,有600+已經(jīng)得到實(shí)踐,其中30%已經(jīng)進(jìn)入了生產(chǎn)系統(tǒng)。然而,AI在各行各業(yè)的應(yīng)用仍然面臨諸多挑戰(zhàn),如場景碎片化、作坊式開發(fā)方式導(dǎo)致規(guī)模化復(fù)制困難、行業(yè)知識與AI技術(shù)結(jié)合難度大、以及人們對AI模型安全性、隱私和潛在攻擊的擔(dān)憂。

近年來,云計(jì)算市場迅速發(fā)展,客戶需求從資源需求向智能和業(yè)務(wù)方案需求轉(zhuǎn)變。市場前景廣闊,但業(yè)務(wù)數(shù)量眾多、場景復(fù)雜也帶來挑戰(zhàn)。隨著市場的成熟,定制化解決方案相較于統(tǒng)一方案更具優(yōu)勢,中小型供應(yīng)商也具有了競爭力。然而,在保證業(yè)務(wù)規(guī)模的同時,如何控制成本、提高效率和質(zhì)量成為核心難題。

另一方面,傳統(tǒng)行業(yè)也在積極利用AI技術(shù)解決問題,這需要算法具備通用性。然而,目前AI開發(fā)主要采取的是針對每個場景獨(dú)立開發(fā)的模式,缺乏通用知識的積累。這也導(dǎo)致低水平開發(fā)者難以掌握規(guī)范流程和優(yōu)化技巧,進(jìn)而影響模型的效果。

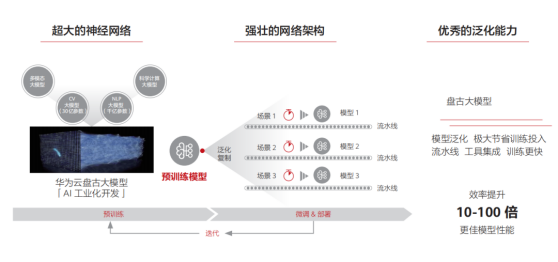

為解決AI算法落地面臨的碎片化問題,預(yù)訓(xùn)練大模型應(yīng)運(yùn)而生。這種模型通過無監(jiān)督學(xué)習(xí)從大規(guī)模數(shù)據(jù)中提取通用知識,并將其儲存在參數(shù)量巨大的模型中。在遇到具體任務(wù)時,只需要調(diào)用統(tǒng)一的流程來應(yīng)用這些知識,并結(jié)合領(lǐng)域經(jīng)驗(yàn)來解決具體問題。近年來,預(yù)訓(xùn)練模型的研究和應(yīng)用持續(xù)爆發(fā),有望在AI領(lǐng)域發(fā)揮統(tǒng)領(lǐng)作用。然而,要實(shí)現(xiàn)預(yù)訓(xùn)練模型的商業(yè)規(guī)模應(yīng)用,還有一段路要走,這需要技術(shù)和商業(yè)模式雙輪驅(qū)動。我們設(shè)想大模型可以成為AI的操作系統(tǒng),管理硬件資源,支撐算法應(yīng)用,從而使AI開發(fā)更加規(guī)范和普及。

一、大模型 是 AI 發(fā)展的必然趨勢

1、人工智能發(fā)展趨勢的總體研判

人工智能存在著邏輯演繹、歸納統(tǒng)計(jì)和類腦計(jì)算三大流派,各具優(yōu)勢并持續(xù)爭議。類腦計(jì)算目標(biāo)遠(yuǎn)大,但缺乏生命科學(xué)支撐。歸納演繹方式與人類相似,可解釋性強(qiáng),是前兩次繁榮的主角。隨著對人工智能困難性的理解,邏輯方法的局限性被放大,統(tǒng)計(jì)學(xué)習(xí)在第三次繁榮期占據(jù)主導(dǎo)地位。深度學(xué)習(xí)進(jìn)一步推崇“拋棄先驗(yàn),擁抱數(shù)據(jù)”的思想。

深度學(xué)習(xí)是當(dāng)代產(chǎn)物,得益于大數(shù)據(jù)和大算力的支持,其核心是深度神經(jīng)網(wǎng)絡(luò),通過通用骨干網(wǎng)絡(luò)與特定目的頭部網(wǎng)絡(luò)的配合,實(shí)現(xiàn)了對各個子領(lǐng)域的統(tǒng)一解決問題。然而,其本質(zhì)仍是統(tǒng)計(jì)學(xué)習(xí)的框架,缺乏人類基于知識的推斷方式,導(dǎo)致通用性受限,且開發(fā)成本高昂,難以惠及細(xì)分行業(yè)。

預(yù)訓(xùn)練大模型是深度學(xué)習(xí)時代的集大成者,分為上游(模型預(yù)訓(xùn)練)和下游(模型微調(diào))兩個階段,旨在解決上述問題。雖然預(yù)訓(xùn)練大模型不直接導(dǎo)向人工智能,但兩個重要判斷對其未來發(fā)展有著深遠(yuǎn)影響。

1)在下一個劃時代的計(jì)算模型出現(xiàn)以前,大模型將是人工智能領(lǐng)域最有效的通用范式, 并將產(chǎn)生巨大的商業(yè)價值

根據(jù)實(shí)際操作經(jīng)驗(yàn),預(yù)訓(xùn)練大模型加持下的人工智能算法(包括計(jì)算機(jī)視覺和自然語言處理等領(lǐng)域)相比于普通開發(fā)者從頭搭建的算法,精度顯著提高、數(shù)據(jù)和計(jì)算成本明顯降低,并且開發(fā)難度大大降低。以計(jì)算機(jī)視覺為例:在以前,要在100張圖像上訓(xùn)練基礎(chǔ)物體檢測算法,需要8塊GPU運(yùn)行5個小時,一名開發(fā)者需要工作1個星期才能完成。然而,有了預(yù)訓(xùn)練模型的支持,現(xiàn)在只需要1塊GPU運(yùn)行2個小時,而且?guī)缀醪恍枰肆Ω深A(yù)。綜合人力和算力開銷的考慮,上述案例的開發(fā)成本降低90%甚至99%。

2)對大模型的研究,將有可能啟發(fā)下一個通用計(jì)算模型

在2011年之前,統(tǒng)計(jì)學(xué)習(xí)方法盛行,詞袋模型的參數(shù)達(dá)到了10億量級。然而,2012年只有6000萬參數(shù)的深度網(wǎng)絡(luò)打敗了詞袋模型,推動了計(jì)算機(jī)視覺領(lǐng)域的發(fā)展。深度網(wǎng)絡(luò)相比詞袋模型,在特征提取效率上取得了突破性進(jìn)展。我們預(yù)測,隨著大模型不斷發(fā)展,結(jié)合知識后可能會出現(xiàn)新的突破,推動統(tǒng)計(jì)學(xué)習(xí)的進(jìn)化。

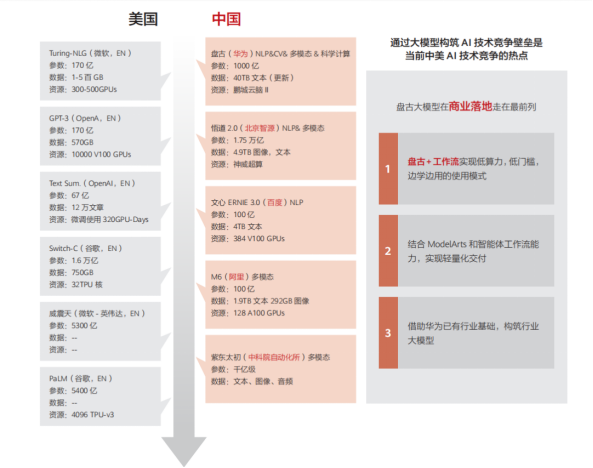

目前看來,預(yù)訓(xùn)練大模型代表了統(tǒng)計(jì)學(xué)習(xí)的最高成就,也是當(dāng)前人工智能的最強(qiáng)武器。在新技術(shù)出現(xiàn)之前,預(yù)訓(xùn)練大模型將繼續(xù)引領(lǐng)人工智能研發(fā)。中美兩國已經(jīng)在大模型的研發(fā)和應(yīng)用方面展開了競爭。

二、盤古大模型家族介紹

華為云團(tuán)隊(duì)在2020年啟動大模型研發(fā)項(xiàng)目,并于2021年4月首次公開了名為“盤古預(yù)訓(xùn)練大模型”的成果。盤古大模型集合了華為在AI領(lǐng)域的多項(xiàng)研究成果,并深度結(jié)合昇騰芯片、MindSpore語言和ModelArts平臺。下面將簡要介紹盤古大模型的組成部分,并剖析構(gòu)建大模型的關(guān)鍵技術(shù)。

1、視覺大模型

計(jì)算機(jī)視覺的目標(biāo)是設(shè)計(jì)能夠識別和處理視覺信號的程序,從而使計(jì)算機(jī)能夠更好地“看”。其典型任務(wù)包括圖像分類、物體檢測、分割、追蹤和姿態(tài)估計(jì)。ImageNet數(shù)據(jù)集包含超過2萬個物體類別,用于圖像分類任務(wù),而MS-COCO數(shù)據(jù)集則包含檢測和分割等任務(wù)。

在計(jì)算機(jī)中,視覺信號以像素密集采樣的方式來存儲光強(qiáng)度。然而,像素并不代表語義信息,因此這種存儲形式與人類理解之間存在巨大的差距,這被稱為語義鴻溝,是計(jì)算機(jī)視覺的核心問題。進(jìn)一步分析圖像信號的特點(diǎn),發(fā)現(xiàn)以下幾點(diǎn):

內(nèi)容較復(fù)雜

圖像的基本組成單元是像素,但單個像素通常不足以傳達(dá)語義。

信息密度低

圖像信號雖然能客觀地反映出事物的特征,但其中相當(dāng)一部分?jǐn)?shù)據(jù)用于表達(dá)圖像中的低頻區(qū)域(如天空)或無明確語義的高頻區(qū)域(如隨機(jī)噪聲)。

域豐富多變

圖像信號受到各種域的影響,這種影響通常具有全局性質(zhì),難以與語義區(qū)分開來。例如,同樣的語義內(nèi)容在不同的光照條件下會呈現(xiàn)出完全不同的表征。同時,相同的物體以不同的尺寸、視角和姿態(tài)出現(xiàn)時,會在像素層面產(chǎn)生巨大差異,給視覺識別算法帶來困難。

基于此使用了卷積網(wǎng)絡(luò)和Transformer等主流視覺模型架構(gòu)。自動機(jī)器學(xué)習(xí)算法支持不同規(guī)模模型,最大規(guī)模近30億參數(shù),最小僅數(shù)十萬,可適配不同任務(wù)。

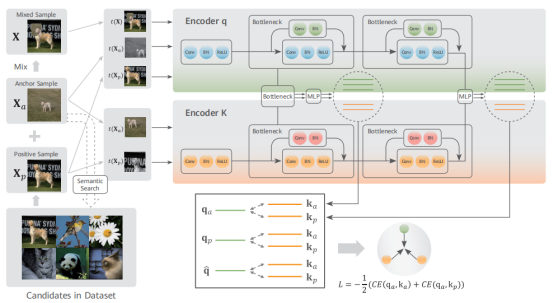

訓(xùn)練數(shù)據(jù)主要來自互聯(lián)網(wǎng),不含準(zhǔn)確語義標(biāo)簽。采用自監(jiān)督學(xué)習(xí)方法,通過設(shè)計(jì)代理任務(wù)讓模型在無標(biāo)簽數(shù)據(jù)上擬合分布。在對比學(xué)習(xí)基礎(chǔ)上改進(jìn)了自監(jiān)督算法,引入等級化語義相似度挑選更優(yōu)質(zhì)的正樣本,并使用混合數(shù)據(jù)增強(qiáng)技術(shù)減少噪聲影響。還擴(kuò)大了正樣本數(shù)目,避免負(fù)樣本對訓(xùn)練的影響。

基于等級化語義聚集的對比度自監(jiān)督學(xué)習(xí)

2、語音語義大模型

自然語言是人類存儲和交換信息的重要方式,通過文字和語音兩種形式實(shí)現(xiàn)。因此,語音語義處理分為自然語言處理和語音處理兩個領(lǐng)域,目標(biāo)都是讓機(jī)器像人類一樣理解和使用語言。自然語言處理和語音處理都包含理解和生成兩個方面,但處理的信號類型不同,一個是文本,一個是音頻。雖然文本和音頻大多數(shù)情況下高度相關(guān),但也有一些獨(dú)特的表達(dá)情況。

語音語義處理的核心是將文字和聲音轉(zhuǎn)化為機(jī)器可處理的格式。在深度學(xué)習(xí)之前,主要通過特征工程實(shí)現(xiàn),但這種方法依賴于專家知識且難以擴(kuò)展。隨著深度學(xué)習(xí)的發(fā)展,自動學(xué)習(xí)語言的向量表示逐漸成為主流。編碼器-解碼器框架被用于處理文字和音頻信號,其中編碼器將語言映射到低維向量,解碼器將低維向量映射回語言。設(shè)計(jì)合適的網(wǎng)絡(luò)結(jié)構(gòu)和學(xué)會參數(shù)是深度學(xué)習(xí)中的關(guān)鍵技術(shù)問題。在小型模型時代,CNN和RNN技術(shù)占主導(dǎo)地位,而LSTM模型因處理遠(yuǎn)距離依賴的能力而備受關(guān)注。然而,RNN的優(yōu)化不穩(wěn)定且難以并行計(jì)算,因此限制了構(gòu)建大型語言模型的規(guī)模。

2017年,自注意力Transformer模塊被提出,結(jié)合已有方法優(yōu)點(diǎn),在速度和表達(dá)能力上具有巨大優(yōu)勢,迅速在自然語言處理和語音識別領(lǐng)域得到應(yīng)用。隨著大規(guī)模語料庫的出現(xiàn)和自監(jiān)督學(xué)習(xí)方法的成熟,2018年出現(xiàn)了預(yù)訓(xùn)練模型BERT并進(jìn)入大模型時代。現(xiàn)在,預(yù)訓(xùn)練大模型憑借出色的泛化能力和基于提示的微調(diào)技術(shù),簡化各種下游任務(wù)的實(shí)現(xiàn)方式,推動自然語言處理和語音識別領(lǐng)域的巨大發(fā)展,成為語音語義處理領(lǐng)域的最佳方案。

1)數(shù)據(jù)收集

自然語言處理和語音識別類似于計(jì)算機(jī)視覺,也需要大規(guī)模數(shù)據(jù)集作為基礎(chǔ)。爬取40TB原始網(wǎng)頁數(shù)據(jù),通過解析和清洗,使用正則表達(dá)式等方法過濾噪聲、去重和規(guī)范長度,最終得到約647GB文本數(shù)據(jù)。語音部分,爬取超過7萬小時普通話音頻數(shù)據(jù),轉(zhuǎn)換為音頻文件,共計(jì)約11TB,視頻來源多樣。

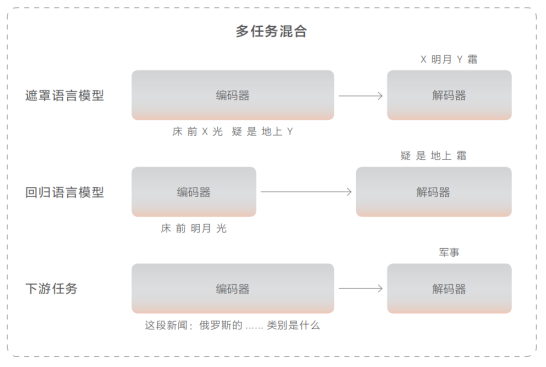

2)預(yù)訓(xùn)練方法

對于語義部分,使用基于Transformer的編碼-解碼器神經(jīng)網(wǎng)絡(luò)模型。編碼器采用雙向自注意力機(jī)制來理解文本,解碼器則通過單向自注意力逐詞生成文本。提出多任務(wù)融合策略來讓模型從海量文本數(shù)據(jù)中獲取語言知識。遮罩語言模型用于訓(xùn)練理解能力,即對原文進(jìn)行挖空并預(yù)測缺失的部分。回歸語言模型用于訓(xùn)練生成能力,給定上文,預(yù)測下文。為提高零樣本推理能力,收集了100+下游任務(wù)數(shù)據(jù)并加入預(yù)訓(xùn)練中。

對于語音部分,解碼器與文本解碼器相似,但音頻編碼器采用了卷積與Transformer結(jié)合的網(wǎng)絡(luò)結(jié)構(gòu)。底層卷積神經(jīng)網(wǎng)絡(luò)提取局部信息,上層Transfomer提取全局信息。使用對比學(xué)習(xí)策略,將音頻中的片段挖空并與隨機(jī)負(fù)例進(jìn)行比較,以找出正確的被挖掉的片段。

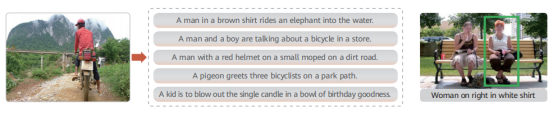

3、多模態(tài)大模型

多模態(tài)任務(wù)不同于計(jì)算機(jī)視覺或自然語言處理等單一模態(tài)任務(wù),需要在海量多模態(tài)數(shù)據(jù)上進(jìn)行預(yù)訓(xùn)練,并將預(yù)訓(xùn)練知識遷移到下游各項(xiàng)任務(wù)中,以提升下游任務(wù)的精度。典型的多模態(tài)任務(wù)包括跨模態(tài)檢索(如以文搜圖或以圖搜文)、視覺問答(通過圖像內(nèi)部信息回答問題)和視覺定位(在圖像中定位描述的對應(yīng)區(qū)域)。

1)數(shù)據(jù)收集

與視覺和語音語義大模型一樣,多模態(tài)大模型的訓(xùn)練也需要在大量高質(zhì)量數(shù)據(jù)上進(jìn)行。采用了業(yè)界常用的做法,從互聯(lián)網(wǎng)上爬取大量圖文數(shù)據(jù),通過過濾算法消除不符合要求的數(shù)據(jù),最終得到高質(zhì)量的圖文配對數(shù)據(jù),用于多模態(tài)大模型的預(yù)訓(xùn)練。具體來說,設(shè)定了大量文本關(guān)鍵字,在搜索引擎上獲取與之匹配的圖像,并將圖像對應(yīng)的文本存儲下來,形成圖文配對數(shù)據(jù)池。在去掉重復(fù)數(shù)據(jù)后,進(jìn)一步篩選出分辨率高、文本長度適中的數(shù)據(jù)。接著,使用已有的多模態(tài)預(yù)訓(xùn)練模型對配對數(shù)據(jù)的相似度進(jìn)行判斷,如果相似度太低,就丟棄文本描述并使用圖像自動描述算法來生成文本數(shù)據(jù)。經(jīng)過上述預(yù)處理過程,最終得到了約3.5億高質(zhì)量的圖文配對數(shù)據(jù),占據(jù)約60TB存儲空間。

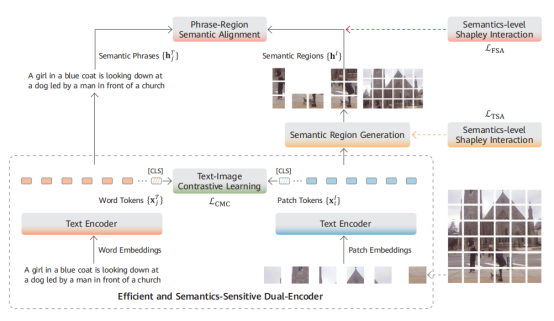

2)預(yù)訓(xùn)練方法

多模態(tài)大模型預(yù)訓(xùn)練的關(guān)鍵在于不同模態(tài)數(shù)據(jù)的高效交互和融合。當(dāng)前主流的多模態(tài)大模型架構(gòu)分為單塔架構(gòu)和雙塔架構(gòu)。單塔架構(gòu)使用一個深度神經(jīng)網(wǎng)絡(luò)(一般是 Transformer)實(shí)現(xiàn)圖像和文本之間的交互融合,屬于信息前融合方案;而雙塔架構(gòu)使用不同的神經(jīng)網(wǎng)絡(luò)來完成不同模態(tài)的信息抽取,并在最后一層進(jìn)行信息交互和融合,屬于信息后融合方案。

盤古大模型采用雙塔架構(gòu),具有模型獨(dú)立性強(qiáng)、訓(xùn)練效率高等優(yōu)勢。實(shí)現(xiàn)方式簡單,使用相應(yīng)網(wǎng)絡(luò)抽取圖像和文本特征,然后將一個批次的圖像和文本特征送入判別器,在對比損失函數(shù)的作用下,使得配對的跨模態(tài)特征聚集在一起,而不配對跨模態(tài)特征被拉遠(yuǎn)。在大數(shù)據(jù)集上充分迭代后,模型就能學(xué)會將圖像和文本對齊到同一空間。此時,圖像和文本的編碼器可以獨(dú)立用于各自下游任務(wù),或協(xié)同用于跨模態(tài)理解類下游任務(wù)。

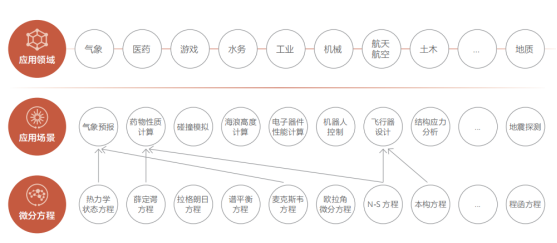

4、科學(xué)計(jì)算大模型

視覺大模型、自然語言大模型和多模態(tài)大模型主要用于解決通用的人工智能問題,如音頻分析、圖像識別和語義理解等。人類能夠標(biāo)注大規(guī)模數(shù)據(jù)集供深度神經(jīng)網(wǎng)絡(luò)學(xué)習(xí)這些問題。然而,在自然科學(xué)領(lǐng)域中,還存在許多人類無法解決的問題,比如湍流模擬、天氣預(yù)報和大形變應(yīng)力建模等。這些問題具有廣泛的應(yīng)用前景,如下所示:

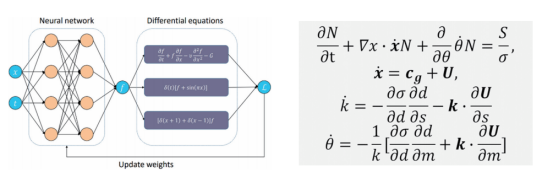

近年來,隨著人工智能技術(shù)的迅速發(fā)展,業(yè)界出現(xiàn)了AI+科學(xué)計(jì)算方法,即使用嵌入科學(xué)方程的深度神經(jīng)網(wǎng)絡(luò),直接從觀測和仿真數(shù)據(jù)中學(xué)習(xí)問題蘊(yùn)含的規(guī)律,以分析復(fù)雜的科學(xué)數(shù)據(jù)并了解科學(xué)過程的內(nèi)部機(jī)理。

從預(yù)訓(xùn)練大模型的角度看,科學(xué)計(jì)算大模型與其他大模型有許多相似之處。都依賴于大規(guī)模數(shù)據(jù)集、需要設(shè)計(jì)具有大量參數(shù)的神經(jīng)網(wǎng)絡(luò)、經(jīng)歷復(fù)雜的優(yōu)化過程,并將知識存儲在網(wǎng)絡(luò)參數(shù)中。接下來,將簡單描述科學(xué)計(jì)算的獨(dú)特之處。

1)數(shù)據(jù)收集

在AI+科學(xué)計(jì)算場景中,數(shù)據(jù)分為觀測和仿真兩類。觀測數(shù)據(jù)由工具產(chǎn)生,如游標(biāo)卡尺等,仿真數(shù)據(jù)由算法產(chǎn)生。這些數(shù)據(jù)、融合數(shù)據(jù)和機(jī)理知識都可以作為AI模型的學(xué)習(xí)對象。不同場景的觀測數(shù)據(jù)差異大,需使用專業(yè)儀器與實(shí)驗(yàn)系統(tǒng)收集,如蛋白質(zhì)結(jié)構(gòu)預(yù)測中的X射線衍射和核磁共振等。仿真數(shù)據(jù)來自算法輸出,蘊(yùn)含豐富的數(shù)學(xué)物理信息。同一個問題使用不同算法可產(chǎn)生不同仿真數(shù)據(jù),精度受限。相對于觀測數(shù)據(jù),仿真數(shù)據(jù)通常更大,可有效擴(kuò)充數(shù)據(jù)。在某些場景中,觀測和仿真數(shù)據(jù)結(jié)合機(jī)理知識生成融合數(shù)據(jù),如氣象再分析數(shù)據(jù)。

2)模型構(gòu)建

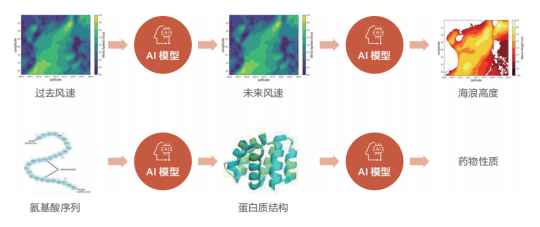

根據(jù)輸入數(shù)據(jù)的性質(zhì),算法會選擇合適的基礎(chǔ)模型進(jìn)行海浪預(yù)測等科學(xué)計(jì)算任務(wù)。對于二維球面數(shù)據(jù),適合使用二維網(wǎng)絡(luò)模型;而三維數(shù)據(jù)則需使用三維網(wǎng)絡(luò)模型。這兩種模型可借鑒計(jì)算機(jī)視覺領(lǐng)域的卷積神經(jīng)網(wǎng)絡(luò)和視覺 Transformer 模型進(jìn)行預(yù)訓(xùn)練。同時,科學(xué)計(jì)算的特點(diǎn)在于利用人類經(jīng)驗(yàn)形成約束性質(zhì)的偏微分方程組,將其嵌入神經(jīng)網(wǎng)絡(luò)中可增強(qiáng)模型的魯棒性并降低擬合難度和不穩(wěn)定。

左圖為嵌入偏微分方程的神經(jīng)網(wǎng)絡(luò)示意圖,右圖為海浪預(yù)報問題使用的偏微分方程

3)案例和效果展示

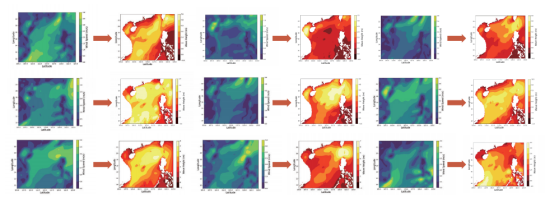

下面我們來探討一個典型的科學(xué)計(jì)算案例,即全球海浪高度預(yù)測系統(tǒng)。海浪預(yù)測的輸入和輸出都是經(jīng)緯度網(wǎng)格點(diǎn)上的氣象要素數(shù)據(jù),數(shù)據(jù)形式與視頻數(shù)據(jù)相似。但海浪數(shù)據(jù)是浮點(diǎn)數(shù),不同于視頻數(shù)據(jù)的像素值。此外,海浪數(shù)據(jù)還滿足球坐標(biāo)條件下的一系列不變性,因此需要選定滿足特定不變性的CNN或者Transformer架構(gòu)。

盤古海浪預(yù)測模型的主體是考慮了旋轉(zhuǎn)不變性的視覺Transformer架構(gòu),參數(shù)量約為五億。模型的損失函數(shù)由兩部分組成:實(shí)際數(shù)據(jù)上的預(yù)測誤差和海浪預(yù)測本身需要滿足的偏微分方程。通過使用全球近10年的實(shí)時海浪高度數(shù)據(jù)進(jìn)行訓(xùn)練,模型在驗(yàn)證集上預(yù)測的平均誤差小于5cm,與傳統(tǒng)預(yù)測方法相當(dāng),完全可以滿足實(shí)際應(yīng)用需求。更重要的是,AI算法的預(yù)測時間較傳統(tǒng)方法大幅減少:在單張華為昇騰芯片上,1s之內(nèi)即可得到全球海浪高度預(yù)測,1分鐘內(nèi)能夠完成超過100次海浪預(yù)測任務(wù),推理效率較傳統(tǒng)方法提升了4-5個數(shù)量級。

使用AI算法可以迅速得到不同可能的風(fēng)速條件下的海浪高度,進(jìn)行實(shí)時預(yù)測和未來情況模擬,對漁業(yè)養(yǎng)殖、災(zāi)害防控等場景具有極大的價值。

使用昇騰 AI 芯片,AI 模型可以在一秒內(nèi)給出成百上千組“隨機(jī)”風(fēng)速分布下的海浪分布

AI芯片:群賢畢至,花落誰家?

最近,由ChatGPT引領(lǐng)的AI熱潮再次興起,國內(nèi)外科技公司紛紛投入到大語言模型和生成式AI的研發(fā)中,展開一場對計(jì)算能力的競賽。GPT背后的核心算法是谷歌在2017年提出的Transformer,這種算法通過采用自我監(jiān)督預(yù)訓(xùn)練的方式,近乎無需人工干預(yù),因此需要大量訓(xùn)練數(shù)據(jù),再加上少量的有監(jiān)督微調(diào)和強(qiáng)化學(xué)習(xí)相結(jié)合。隨著更為復(fù)雜和多元化模型的涌現(xiàn),高算力的AI芯片將充分受益于這種發(fā)展趨勢。然而,如果這些技術(shù)在消費(fèi)端的應(yīng)用僅僅停留在表面,那么其意義并不大。

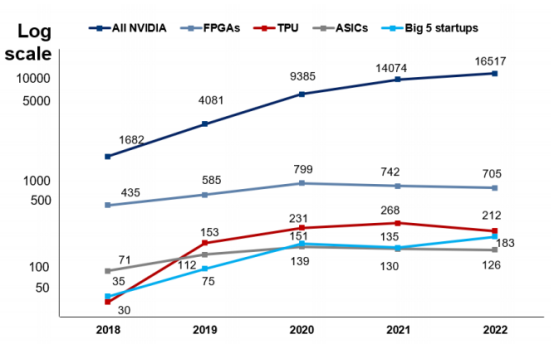

一、英偉達(dá)的兩大護(hù)城河:高算力芯片和高粘性 CUDA 軟件生態(tài)

根據(jù)AI論文中不同芯片的引用數(shù)據(jù),英偉達(dá)的芯片在AI研究領(lǐng)域廣受歡迎。其產(chǎn)品的使用率是ASIC的131倍,高出Graphcore、Habana、Cerebras、SambaNova和寒武紀(jì)五家公司總和的90倍,是谷歌TPU的78倍,是FPGA的23倍。通常,在人工智能領(lǐng)域,新模型的推出都會在相關(guān)論文中進(jìn)行發(fā)表,以便于信息交流與學(xué)術(shù)合作。英偉達(dá)在人工智能相關(guān)論文中的引用數(shù)量遙遙領(lǐng)先,這反映新算法需要采用英偉達(dá)GPU的必要性,以及其在學(xué)術(shù)界長期以來的重要地位和影響力。

英偉達(dá)芯片在 AI 論文中的引用數(shù)量遙遙領(lǐng)先

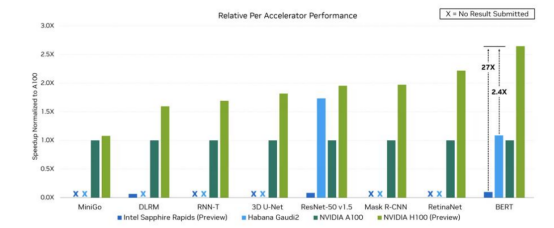

英偉達(dá)一直致力于開發(fā)高性能計(jì)算芯片的迭代,不斷在產(chǎn)品工藝、計(jì)算能力和存儲帶寬等方面進(jìn)行創(chuàng)新。針對高性能計(jì)算和深度學(xué)習(xí)應(yīng)用場景,英偉達(dá)基于其芯片架構(gòu),推出一系列GPU產(chǎn)品,以提升張量核心和稀疏矩陣計(jì)算等功能。2023年,英偉達(dá)不滿足于單GPU的更新?lián)Q代,推出結(jié)合Grace CPU與Hopper GPU的GH200超級芯片,實(shí)現(xiàn)高達(dá)900GB/s的總帶寬,加速大規(guī)模AI和HPC應(yīng)用計(jì)算。在SIGGRAPH上,英偉達(dá)的AI芯片再次迎來升級,推出全球首次采用HBM3e內(nèi)存的GH200超級芯片。該芯片的帶寬高達(dá)每秒5TB,并提供141GB的內(nèi)存容量,適用于復(fù)雜的生成式人工智能工作負(fù)載,如大型語言模型、推薦系統(tǒng)和矢量數(shù)據(jù)庫等。

英偉達(dá) H100 與部分同業(yè)產(chǎn)品在運(yùn)行不同 AI 負(fù)載時表現(xiàn)

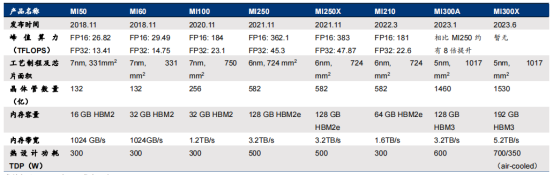

二、MI300A 和 GH200:CPU+GPU AI 芯片架構(gòu)仿生人腦結(jié)構(gòu)

MI300系列是AMD旗下的GPU產(chǎn)品,包括兩款產(chǎn)品:MI300X和MI300A。MI300X是一款純GPU產(chǎn)品,由12個chiplets(8個GPU+4個IO+Cache)組成,與英偉達(dá)的GPU H100相媲美。而MI300A是一款CPU+GPU產(chǎn)品,由13個chiplets(6個GPU+3個CPU+4個IO+Cache)組成,采用APU架構(gòu)(Zen 4 CPU + CNDA 3 GPU),與英偉達(dá)的異構(gòu)CPU+GPU芯片GH200競爭。

在參數(shù)上,MI300系列有許多值得關(guān)注的亮點(diǎn)。首先,MI300X的192GB HBM3內(nèi)存領(lǐng)先于英偉達(dá)H100雙卡NVL的188GB HBM3,更遠(yuǎn)超過H100 PCIe和SMX的80GB HBM3,而MI300A的128GB HBM3內(nèi)存也具有競爭力。其次,MI300X的晶體管數(shù)量為1530億,MI300A的晶體管數(shù)量為1460億,與H100的800億相比具有明顯優(yōu)勢。此外,內(nèi)存帶寬5.2TB/s與英偉達(dá)H100的2-7.2TB/s相近,Infinity Fabric互聯(lián)帶寬的896GB/s與NVLink的900GB/s相差無幾,但比H100高2.4X的HBM密度以及1.6X HBM帶寬則展示了AMD在GPU技術(shù)方面的優(yōu)勢。AMD在2023 CES大會上首次推出CPU+GPU的MI300,后改稱MI300A。作為MI系列的第一款CPU+GPU異構(gòu)產(chǎn)品,CPU+GPU架構(gòu)已成為AI芯片的趨勢。

在AI應(yīng)用中,GPU算力較高,適用于并行計(jì)算,在視頻處理、圖像渲染等方面具有優(yōu)勢,但并不是所有工作負(fù)載都只需要單純的GPU處理,還需要由CPU進(jìn)行控制調(diào)用,發(fā)布指令。因此,在CPU+GPU架構(gòu)中,CPU可以負(fù)責(zé)控制和發(fā)出指令,指示GPU處理數(shù)據(jù)和完成運(yùn)算(如矩陣運(yùn)算)。值得一提的是,MI300A中的CPU采用的是x86架構(gòu),而GH200中的CPU采用的是ARM架構(gòu)。兩種架構(gòu)各有優(yōu)勢,一般來說,ARM架構(gòu)主要應(yīng)用于移動端,因此相比x86能耗較低,這一點(diǎn)在AI和數(shù)據(jù)中心的應(yīng)用中都會受到青睞。

AMD Instinct MI 系列 GPU 發(fā)展歷程

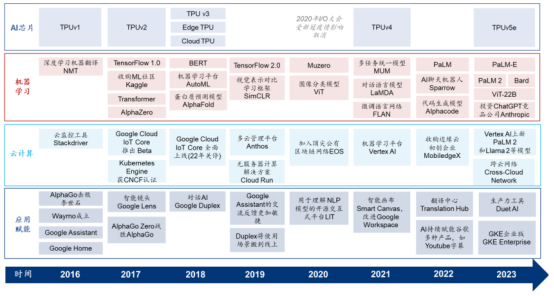

三、谷歌 TPU:少數(shù)能與英偉達(dá)高算力 GPU 匹敵的 AI 芯片

谷歌的TPU(Tensor Processing Unit)是云廠商自研AI芯片的典型例子之一,從2017年開始已具備訓(xùn)練和推理能力。谷歌TPU是少數(shù)能夠與英偉達(dá)高算力GPU相匹敵的AI芯片。在架構(gòu)與性能參數(shù)上不斷迭代,第一代TPU從2015年開始被使用于谷歌云計(jì)算數(shù)據(jù)中心的機(jī)器學(xué)習(xí)應(yīng)用中,當(dāng)時僅面向推理端,但從2017年推出第二代開始,TPU已同時擁有訓(xùn)練和推理能力。第三代TPU于2018年發(fā)布,旨在提高性能和能效以滿足不斷增長的機(jī)器學(xué)習(xí)任務(wù)需求。第四代TPU于2021年發(fā)布,而專為中大規(guī)模訓(xùn)練和推理而構(gòu)建的TPUv5e于2023年發(fā)布。與TPUv4相比,TPUv5e可為大語言模型提供高達(dá)2倍的訓(xùn)練性能和2.5倍的推理性能,并能節(jié)約一半以上的成本。谷歌目前僅通過谷歌云服務(wù)平臺向外部客戶提供TPU的算力租賃服務(wù),而未有將其作為硬件產(chǎn)品出售。

2016 年至今谷歌云計(jì)算、AI 芯片、機(jī)器學(xué)習(xí)及 AI 應(yīng)用賦能進(jìn)程梳理

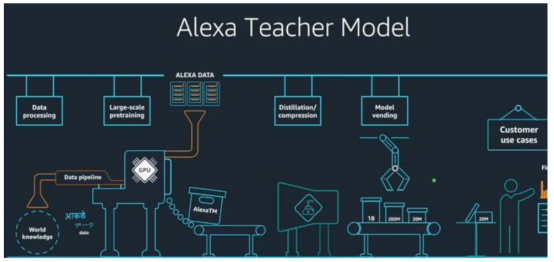

四、亞馬遜 AWS:Trainium & Inferentia,訓(xùn)練推理雙管齊下

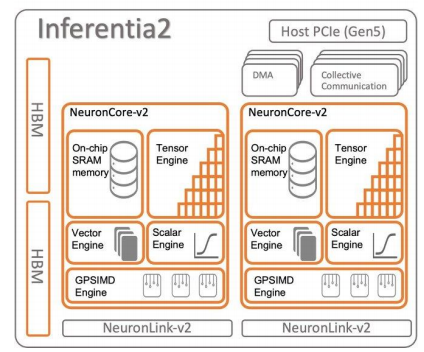

AWS于2018年和2020年分別發(fā)布AI推理芯片Inferentia和訓(xùn)練芯片Trainium,隨后在2023年推出第二代Inferentia,并在AWS云上提供給客戶使用。亞馬遜在2015年收購以色列芯片設(shè)計(jì)公司AnnapumaLabs,從而開始自研AI芯片的旅程,而第一代Inferentia正是源自該公司的技術(shù)。AWS的AI芯片搭配AWSNeuron開發(fā)軟件包,其中包含可用于兼容TensorFlow和PyTorch的編譯器。2023年5月,亞馬遜表示計(jì)劃將其自研的大語言模型“AlexaTeacherModel”(AlexaTM)接入智能語音助手Alexa。Alexa此前已經(jīng)接入亞馬遜Echo智能音箱等智能硬件設(shè)備,并使用Inferentia進(jìn)行推理。

AWS Inferentia2 芯片架構(gòu)

Trainium是一款在云端進(jìn)行訓(xùn)練的AI芯片,其表現(xiàn)相較于A100更為優(yōu)秀,同時也具有更高的性價比。Trainium是AWS專為超過1000億參數(shù)規(guī)模的大模型打造的AI芯片,于2020年發(fā)布,目前仍處于第一代。每個Trainium配備了容量為32GB、帶寬為820GB/s的HBM2e,提供了FP16算力190TFLOPS(英偉達(dá)A100的FP16算力為624TFLOPS)和FP32算力47.5TFLOPS,并支持包括可配置的FP8在內(nèi)的多種數(shù)據(jù)精度。Trainium使用的互聯(lián)技術(shù)是AWS的NeuronLink(超高速非阻塞互連技術(shù),v2代),互聯(lián)速度達(dá)到了768GB/s,相比之下,NVLink4.0的互聯(lián)速度為900GB/s。根據(jù)AWS官網(wǎng)的信息,Trainium實(shí)例的內(nèi)存容量比英偉達(dá)A100實(shí)例高出60%,互聯(lián)帶寬高出2倍。使用130個Trainium實(shí)例訓(xùn)練GPT-3只需要2周,而根據(jù)英偉達(dá)與微軟的論文《Efficient Large-Scale Language Model Training on GPU Clusters Using Megatron-LM》,使用1024顆A100進(jìn)行訓(xùn)練需要34天。2022年,AWS推出的Trn1AI平臺可以部署最多16個Trainium,在AWS云上進(jìn)行AI模型訓(xùn)練。相較于同類型的AmazonEC2實(shí)例,以Trainium為支撐的Trn1實(shí)例可以節(jié)約50%的訓(xùn)練成本,而在亞馬遜廣告模型訓(xùn)練中,這一成本節(jié)約甚至高達(dá)70%。

AWS 的 in-house 大語言模型 Alexa Teacher Model

Inferentia 推理卡已經(jīng)迭代兩代,并被用于亞馬遜硬件終端的 AI 服務(wù)。2018 年推出的第一代 Inferentia 配備了 8 GB 帶寬為 50GB/s 的 DDR4 內(nèi)存,而 2023 年 4 月正式推出的第二代 Inferentia 2 則配備了 32 GB 帶寬為 820GB/s 的 HBM2e 內(nèi)存,F(xiàn)P16 算力達(dá)到 190 TFLOPS,相比一代 Inferentia(64 TFLOPS)提高2 倍,主要針對高性能深度學(xué)習(xí)推理應(yīng)用程序進(jìn)行設(shè)計(jì)。

根據(jù)亞馬遜官網(wǎng)的信息,相比第一代 Inferentia,第二代的延遲降低十分之一,吞吐量提高四倍。由于大規(guī)模終端設(shè)備 AI 模型對云端推理能力要求較高,而自研 AI 芯片等信息基礎(chǔ)設(shè)施和自身應(yīng)用可以進(jìn)行針對性的相互適配與優(yōu)化,Amazon 人工智能助手 Alexa 使用以 Inferentia 為支撐的 Inf 實(shí)例進(jìn)行推理負(fù)載。

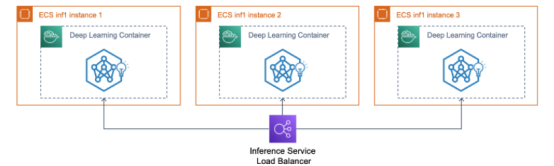

除與 AWS 生態(tài)捆綁外,客戶還可以通過開發(fā)工具包 AWS Neuron,以及使用 Amazon Sagemaker(AWS 機(jī)器學(xué)習(xí)平臺)、Amazon Elastic Container Service(ECS,AWS 容器托管方案)、Amazon Elastic Kubernetes Service(EKS)等服務(wù)來快速開始使用 Inf 和 Trn 實(shí)例,并分別使用底層 Inferentia 和 Trainium 芯片能力。目前 AWS 上使用 Inferentia 承擔(dān)推理工作負(fù)載的客戶包括 Airbnb(愛彼迎,房屋租賃平臺)、Snap(圖片類社交媒體平臺)、Sprinklr(SCRM 社交媒體營銷公司)、Money Forward(金融科技公司)和 Finch Computing(AI 初創(chuàng)公司)等;而使用 Inferentia2 的客戶則包括 Hugging Face(機(jī)器學(xué)習(xí)公司)、Qualtrics(自動化管理軟件公司)和 Finch Computing(亦為 Inf1 客戶)等。

使用 inf1 實(shí)例將推理服務(wù)部署到 AWS ECS 容器托管集群

五、Meta:首個自研推理端芯片 MTIA 將于 2025 年問世

Meta 在 2023 年 5 月發(fā)布自主研發(fā)的 AI 芯片 MTIA,該芯片主要針對推理工作,從 2020 年開始設(shè)計(jì),預(yù)計(jì)于 2025 年正式推出,采用臺積電 7nm 制程。MTIAv1 是針對推理端的產(chǎn)品,使用最高 128GB 的 LPDDR5 內(nèi)存,采用 RISC-V 架構(gòu),并配合基于 PyTorch 的軟件包。與其他云廠商自主研發(fā)的 AI 芯片類似,MTIA 是針對公司內(nèi)部應(yīng)用和模型量身定制的 ASIC,尤其是針對 Meta 旗下產(chǎn)品所需的 feed(例如 Instagram 的用戶瀏覽界面)貼文推薦算法進(jìn)行了優(yōu)化。與通用芯片相比,MTIA 可以實(shí)現(xiàn)降本增效。

Meta 的超級計(jì)算機(jī)由約 16,000 片英偉達(dá) A100 GPU 構(gòu)成,已被用于訓(xùn)練 LLaMA 模型。目前,Meta 沒有推出專用于訓(xùn)練階段的芯片,而是使用基于英偉達(dá) A100 GPU 的內(nèi)部生產(chǎn)集群進(jìn)行訓(xùn)練。Meta 的 AI 超級計(jì)算機(jī) RSC(Research Super Cluster)由約 16,000 片英偉達(dá) A100 GPU 構(gòu)成(2000 臺英偉達(dá) DGX A100),通過 NVIDIA Quantum InfiniBand 16 Tb/s 網(wǎng)絡(luò)結(jié)構(gòu)進(jìn)行連接。Meta 表示,其使用 RSC(除此外還包括由 A100 GPU 組成的內(nèi)部生產(chǎn)集群)來訓(xùn)練其在 2023 年 2 月發(fā)布的 70-650 億參數(shù)的開源大模型 LLaMA。其中,650 億參數(shù)的 LLaMA 模型在 2048 片英偉達(dá) A100 GPU 上花費(fèi) 21 天完成預(yù)訓(xùn)練。2023 年 7 月,Meta 發(fā)布了免費(fèi)可商用的 LLaMA2 版本,與第一代相比,LLaMA2 作為升級版本包括 70 億、130 億和 700 億三個參數(shù)版本,使用了 1.4 倍容量的數(shù)據(jù)集,并采用了分組查詢注意力機(jī)制,同樣使用 RSC 工作負(fù)載進(jìn)行預(yù)訓(xùn)練。據(jù) Meta 評估,多項(xiàng)測評結(jié)果顯示 LLaMA 2 在推理、精通性、編碼和知識測試等諸多外部基準(zhǔn)測試中均優(yōu)于其他開源語言模型。

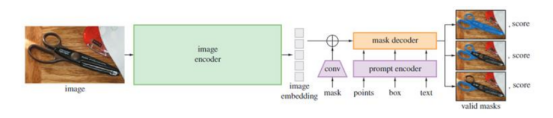

SAM 模型總覽示意圖

英偉達(dá)顯卡與華為對比

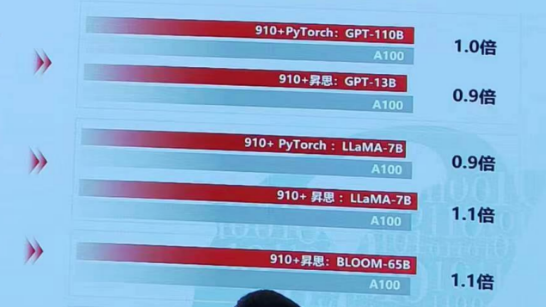

當(dāng)談到千卡集群GPT3模型訓(xùn)練性能時,華為當(dāng)代Atlas集群以其卓越的表現(xiàn)領(lǐng)先于NV DGXA800集群1.2倍。華為當(dāng)代Atlas集群作為一種先進(jìn)的計(jì)算平臺,以其出色的計(jì)算能力和高效的數(shù)據(jù)處理能力而聞名,為大規(guī)模深度學(xué)習(xí)模型的訓(xùn)練任務(wù)提供了有力的支持。

華為當(dāng)代Atlas集群的卓越性能源于其先進(jìn)的硬件設(shè)計(jì)和優(yōu)化的軟件架構(gòu)。該集群采用了高性能的GPU加速器和高速互聯(lián)網(wǎng)絡(luò),這使得數(shù)據(jù)傳輸和計(jì)算速度得以顯著提升。這種卓越的硬件設(shè)計(jì)與華為自主研發(fā)的優(yōu)化算法和分布式訓(xùn)練框架相結(jié)合,進(jìn)一步提升了模型訓(xùn)練的效率。

與NV DGXA800集群相比,華為當(dāng)代Atlas集群在千卡集群GPT3模型訓(xùn)練性能上具有明顯的優(yōu)勢。使用華為當(dāng)代Atlas集群進(jìn)行訓(xùn)練任務(wù),能夠以更快的速度完成模型訓(xùn)練,從而提高工作效率。這種領(lǐng)先性能的差距不僅體現(xiàn)在訓(xùn)練時間上,還可以在模型的收斂速度和訓(xùn)練結(jié)果的質(zhì)量上得到體現(xiàn)。

華為當(dāng)代Atlas集群的領(lǐng)先性能使其成為深度學(xué)習(xí)研究人員和工程師的首選。無論是進(jìn)行大規(guī)模數(shù)據(jù)訓(xùn)練還是進(jìn)行復(fù)雜模型的訓(xùn)練任務(wù),華為當(dāng)代Atlas集群都能夠提供卓越的性能和可靠的支持,幫助用戶更快地實(shí)現(xiàn)預(yù)期的訓(xùn)練目標(biāo)。

藍(lán)海大腦大模型訓(xùn)練平臺

藍(lán)海大腦大模型訓(xùn)練平臺提供強(qiáng)大的算力支持,包括基于開放加速模組高速互聯(lián)的AI加速器。配置高速內(nèi)存且支持全互聯(lián)拓?fù)洌瑵M足大模型訓(xùn)練中張量并行的通信需求。支持高性能I/O擴(kuò)展,同時可以擴(kuò)展至萬卡AI集群,滿足大模型流水線和數(shù)據(jù)并行的通信需求。強(qiáng)大的液冷系統(tǒng)熱插拔及智能電源管理技術(shù),當(dāng)BMC收到PSU故障或錯誤警告(如斷電、電涌,過熱),自動強(qiáng)制系統(tǒng)的CPU進(jìn)入ULFM(超低頻模式,以實(shí)現(xiàn)最低功耗)。致力于通過“低碳節(jié)能”為客戶提供環(huán)保綠色的高性能計(jì)算解決方案。主要應(yīng)用于深度學(xué)習(xí)、學(xué)術(shù)教育、生物醫(yī)藥、地球勘探、氣象海洋、超算中心、AI及大數(shù)據(jù)等領(lǐng)域。

一、為什么需要大模型?

1、模型效果更優(yōu)

大模型在各場景上的效果均優(yōu)于普通模型

2、創(chuàng)造能力更強(qiáng)

大模型能夠進(jìn)行內(nèi)容生成(AIGC),助力內(nèi)容規(guī)模化生產(chǎn)

3、靈活定制場景

通過舉例子的方式,定制大模型海量的應(yīng)用場景

4、標(biāo)注數(shù)據(jù)更少

通過學(xué)習(xí)少量行業(yè)數(shù)據(jù),大模型就能夠應(yīng)對特定業(yè)務(wù)場景的需求

二、平臺特點(diǎn)

1、異構(gòu)計(jì)算資源調(diào)度

一種基于通用服務(wù)器和專用硬件的綜合解決方案,用于調(diào)度和管理多種異構(gòu)計(jì)算資源,包括CPU、GPU等。通過強(qiáng)大的虛擬化管理功能,能夠輕松部署底層計(jì)算資源,并高效運(yùn)行各種模型。同時充分發(fā)揮不同異構(gòu)資源的硬件加速能力,以加快模型的運(yùn)行速度和生成速度。

2、穩(wěn)定可靠的數(shù)據(jù)存儲

支持多存儲類型協(xié)議,包括塊、文件和對象存儲服務(wù)。將存儲資源池化實(shí)現(xiàn)模型和生成數(shù)據(jù)的自由流通,提高數(shù)據(jù)的利用率。同時采用多副本、多級故障域和故障自恢復(fù)等數(shù)據(jù)保護(hù)機(jī)制,確保模型和數(shù)據(jù)的安全穩(wěn)定運(yùn)行。

3、高性能分布式網(wǎng)絡(luò)

提供算力資源的網(wǎng)絡(luò)和存儲,并通過分布式網(wǎng)絡(luò)機(jī)制進(jìn)行轉(zhuǎn)發(fā),透傳物理網(wǎng)絡(luò)性能,顯著提高模型算力的效率和性能。

4、全方位安全保障

在模型托管方面,采用嚴(yán)格的權(quán)限管理機(jī)制,確保模型倉庫的安全性。在數(shù)據(jù)存儲方面,提供私有化部署和數(shù)據(jù)磁盤加密等措施,保證數(shù)據(jù)的安全可控性。同時,在模型分發(fā)和運(yùn)行過程中,提供全面的賬號認(rèn)證和日志審計(jì)功能,全方位保障模型和數(shù)據(jù)的安全性。

三、常用配置

1、處理器CPU:

Intel Xeon Gold 8358P 32C/64T 2.6GHz 48MB,DDR4 3200,Turbo,HT 240W

Intel Xeon Platinum 8350C 32C/64T 2.6GHz 48MB,DDR4 3200,Turbo,HT 240W

Intel Xeon Platinum 8458P 28C/56T 2.7GHz 38.5MB,DDR4 2933,Turbo,HT 205W

Intel Xeon Platinum 8468 Processor 48C/64T 2.1GHz 105M Cache 350W

AMD EPYC? 7742 64C/128T,2.25GHz to 3.4GHz,256MB,DDR4 3200MT/s,225W

AMD EPYC? 9654 96C/192T,2.4GHz to 3.55GHz to 3.7GHz,384MB,DDR5 4800MT/s,360W

2、顯卡GPU:

NVIDIA L40S GPU 48GB

NVIDIA NVLink-A100-SXM640GB

NVIDIA HGX A800 80GB

NVIDIA Tesla H800 80GB HBM2

NVIDIA A800-80GB-400Wx8-NvlinkSW

審核編輯 黃宇

-

芯片

+關(guān)注

關(guān)注

453文章

50387瀏覽量

421783 -

amd

+關(guān)注

關(guān)注

25文章

5441瀏覽量

133933 -

華為

+關(guān)注

關(guān)注

215文章

34294瀏覽量

251183 -

NVIDIA

+關(guān)注

關(guān)注

14文章

4935瀏覽量

102806 -

AI

+關(guān)注

關(guān)注

87文章

30106瀏覽量

268399

發(fā)布評論請先 登錄

相關(guān)推薦

英偉達(dá)加速Rubin平臺AI芯片推出,SK海力士提前交付HBM4存儲器

AMD發(fā)布英偉達(dá)競品AI芯片,預(yù)期市場規(guī)模將大幅增長

英偉達(dá)AI芯片需求激增,封測廠訂單量或翻倍

英偉達(dá)推出AI模型推理服務(wù)NVIDIA NIM

美國限制英偉達(dá)和AMD向中東銷售AI芯片

英偉達(dá):NVIDIA目標(biāo)不是AI芯片,而是AI工廠

大模型AI芯片 群雄逐鹿,誰主沉浮?英偉達(dá)NVIDIA?AMD?華為?

大模型AI芯片 群雄逐鹿,誰主沉浮?英偉達(dá)NVIDIA?AMD?華為?

評論