引言

昆侖芯科技公眾號全新欄目“用芯指南”重磅推出!面向AI行業(yè)技術從業(yè)者,系列好文將提供手把手的昆侖芯產品使用指南。第一期圍繞昆侖芯自研效能工具——昆侖芯Anyinfer展開,這是一款基于昆侖芯AI加速卡的高效模型推理部署框架。種種行業(yè)痛點,昆侖芯Anyinfer輕松搞定。

當下,AI技術蓬勃發(fā)展,AI算法應用需求井噴。行業(yè)技術從業(yè)者在項目的不同階段面臨種種現實問題,這些問題無疑也增加了項目的復雜性和不確定性:

算法選型:

技術從業(yè)者極有可能遇到不同框架格式的算法模型;即便是同一個開源算法的實現,也可能是經過不同訓練框架導出,因此模型的保存格式也會有所不同。

算法驗證:

想在AI加速卡上評估算法的推理效果,就要針對不同推理框架的接口構造上百行代碼的推理程序;如果效果不達預期,可能還需要更換其他框架的模型,這就需要重新構造一份不同的推理程序......

真正到了算法部署階段,則將迎來更加嚴峻的挑戰(zhàn)。

以上種種業(yè)內痛點,是否也在困擾您?看完這篇,基于昆侖芯AI加速卡的高效模型推理部署框架——昆侖芯Anyinfer,幫您一鍵全搞定!

1昆侖芯Anyinfer

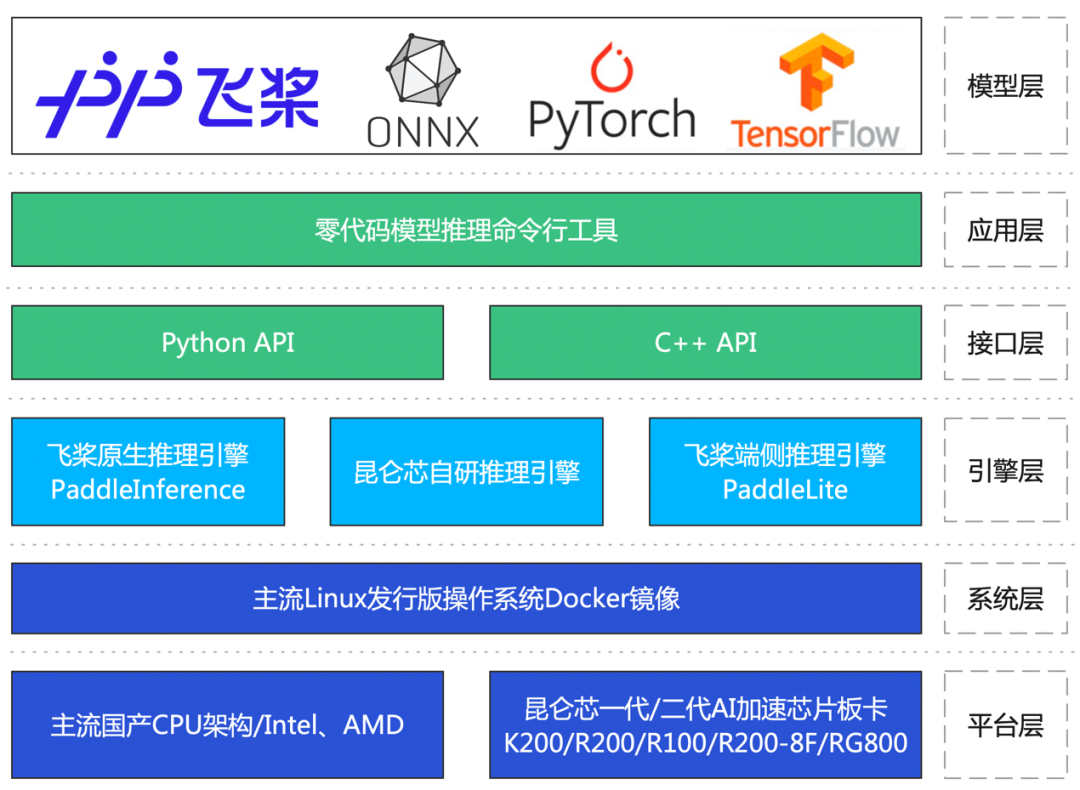

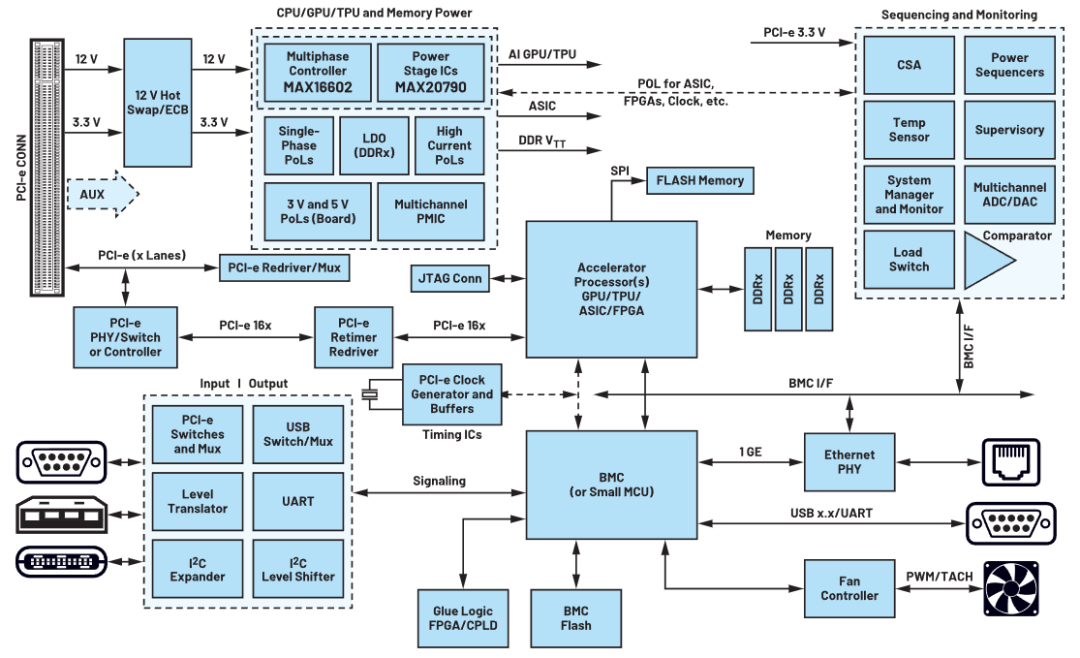

1.昆侖芯Anyinfer架構圖

2.昆侖芯Anyinfer核心優(yōu)勢

A強兼容性

在多個平臺上支持零代碼推理PaddlePaddle、PyTorch、ONNX、TensorFlow等多個主流框架格式的眾多領域模型。

B高人效

內置多款推理引擎,針對不同領域,用戶無需學習特定框架編程接口,更不用編寫多份推理程序,零代碼驗證模型在不同框架中的效果。

C零代碼

只需一行命令,即可完成模型驗證評估,無需依據模型構建輸入數據,也無需撰寫模型轉換、前后處理及推理腳本代碼。

D部署友好

支持C++與Python兩套接口邏輯統(tǒng)一的API,用戶在生產環(huán)境中部署模型更方便。

2運行演示

1. 快速完成算法模型驗證評估

一行命令,即可輕松驗證模型精度、一鍵評估模型的推理性能等關鍵指標。

AONNX、PyTorch和TensorFlow模型在昆侖芯AI加速卡和CPU上的計算精度對比

BPaddlePaddle模型在昆侖芯AI加速卡上的推理性能統(tǒng)計

2.獲取模型性能分析報告,為下一步模型優(yōu)化做足準備

在初步完成算法模型的驗證評估后,可利用昆侖芯Anyinfer深入研究模型中各個層面的性能,包括推理框架層面和算子執(zhí)行層面等,助力進一步調優(yōu)模型的推理性能。

一鍵開啟昆侖芯自研推理引擎的性能分析模式,統(tǒng)計框架層和算子層面的計算耗時

一鍵開啟Paddle inference的性能分析模式,統(tǒng)計框架層和算子層面的耗時

3. 模型的基礎性能調優(yōu)

完成對模型的性能評估后,可以使用基礎的調優(yōu)方法來提高模型的推理性能。昆侖芯Anyinfer提供了一項非常便捷的功能:最佳QPS搜索。此功能將以往需要修改多個參數并多次執(zhí)行的操作化繁為簡,快速確定最適合項目需求的配置,提高用戶體驗。

搜索最佳QPS

4. 模型的高性能部署

完成算法模型的驗證后,最關鍵的一步來了!昆侖芯Anyinfer可輕松應對生產環(huán)境部署這一挑戰(zhàn)。僅需三個統(tǒng)一的C++接口,即可順利將驗證后的模型部署至生產環(huán)境中。

此外,昆侖芯Anyinfer還提供了方便的調試功能,例如算子的自動精度對比、模型轉換等。同時,也提供了豐富的使用示例,包括多輸入、多線程、多進程、多流推理等。種種行業(yè)痛點,昆侖芯Anyinfer輕松搞定。簡潔而強大的解決方案,幫您把模型推理部署變得簡單、高效。

目前,昆侖芯Anyinfer已在多個行業(yè)客戶中投入使用,切實降低了行業(yè)客戶人力成本,提高了項目交付效率,助力客戶在行業(yè)競爭中取得領先優(yōu)勢。

審核編輯:湯梓紅

-

算法

+關注

關注

23文章

4599瀏覽量

92638 -

AI

+關注

關注

87文章

30106瀏覽量

268399 -

模型

+關注

關注

1文章

3171瀏覽量

48711 -

昆侖芯科技

+關注

關注

0文章

27瀏覽量

604

原文標題:一鍵搞定!昆侖芯Anyinfer助您零代碼實現昆侖芯AI加速卡模型推理

文章出處:【微信號:昆侖芯科技,微信公眾號:昆侖芯科技】歡迎添加關注!文章轉載請注明出處。

發(fā)布評論請先 登錄

相關推薦

大模型向邊端側部署,AI加速卡朝高算力、小體積發(fā)展

EdgeBoard FZ5 邊緣AI計算盒及計算卡

Dllite_micro (輕量級的 AI 推理框架)

MLU220-M.2邊緣端智能加速卡支持相關資料介紹

壓縮模型會加速推理嗎?

LCD轉VGA視頻加速卡

基于NVIDIA Triton的AI模型高效部署實踐

昆侖芯2代AI芯片為開發(fā)者提供靈活便捷的部署方案

昆侖芯新品R100正式發(fā)布,強大算力賦能邊緣推理場景

昆侖芯完成OpenCloudOS社區(qū)首個兼容性認證,軟硬協同加速AI技術落地

瞬變對AI加速卡供電的影響

介紹一款基于昆侖芯AI加速卡的高效模型推理部署框架

介紹一款基于昆侖芯AI加速卡的高效模型推理部署框架

評論