本文內(nèi)容來自“AI產(chǎn)業(yè)熱潮帶動服務(wù)器、交換機、光模塊及相關(guān)芯片行業(yè)蓬勃發(fā)展”,重點分析國外大模型廠商產(chǎn)品、國內(nèi)主要大模型產(chǎn)品,以及AI熱潮給服務(wù)器、交換機、光模塊及芯片產(chǎn)業(yè)帶來的發(fā)展機會。

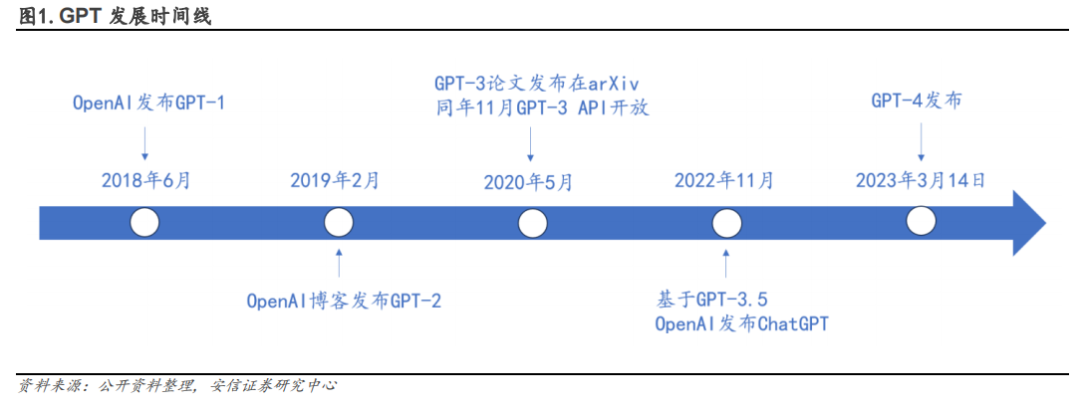

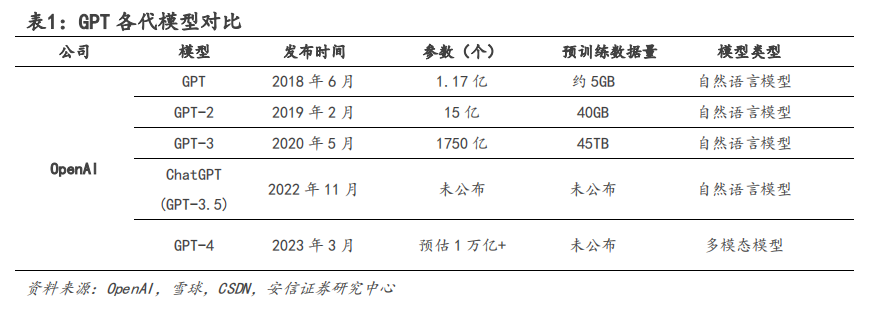

2022年 11 月,美國 OpenAI 公司在 GPT-3.5 的基礎(chǔ)上推出聊天機器人 ChatGPT。相比于之前的主流 AI 模型,ChatGPT 通過采用 Transformer 算法以進行自然語言處理。

2023 年 3 月,OpenAI 公司應(yīng)勢推出新的 GPT-4。GPT-4 是對ChatGPT 的重大升級迭代,不僅具備更加強大的語言理解能力,還能夠處理圖像內(nèi)容。GPT-4可以生成更長、更復(fù)雜、更準確、更多樣化的文本字符串,并在人們輸入圖像時做出響應(yīng),可以更好地避免 GPT-3.5 在處理某些問題時可能出現(xiàn)的錯誤,保證問題解決過程的規(guī)范和準確。

截至目前,GPT 經(jīng)歷了從 GPT-1 發(fā)展至 GPT-4 的迭代升級。

自 ChatGPT 推出以來,國內(nèi)外各企業(yè)紛紛入局,大模型發(fā)展如火如荼。目前市面主流的 AI 服務(wù)器配備 Nvidia Ampere 架構(gòu)的計算卡 A100。

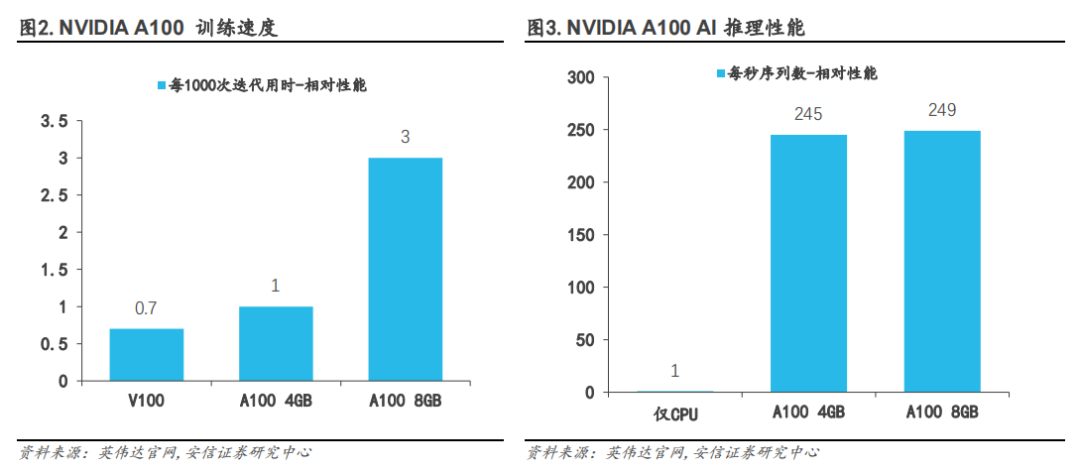

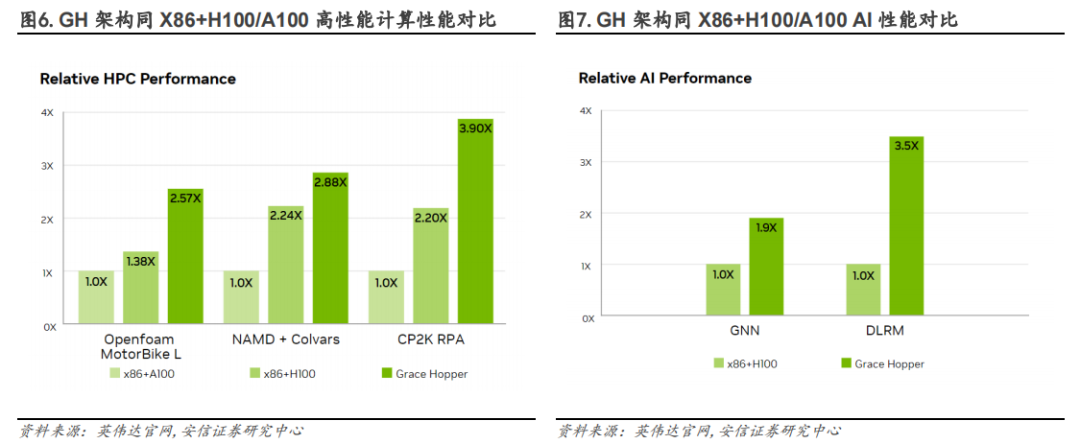

A100 的性能比上一代產(chǎn)品 V100 提升高達 20 倍,可劃分為七個 GPU 實例,根據(jù)變化的需求進行動態(tài)調(diào)整。A100 的單精度浮點計算能力峰值可達 19.5TFLOPS,雙精度浮點算力可達9.7TFLOPS。相比 V100,A100 80GB 可針對大型模型提供高達三倍的 AI 訓(xùn)練速度;相比 CPU,A100 80GB 可提供高達 249 倍的 AI 推理性能。OpenAI 公司在推出 GPT-3 和 ChatGPT 時即使用英偉達的 NVIDIA A100 GPU 來訓(xùn)練和運行。

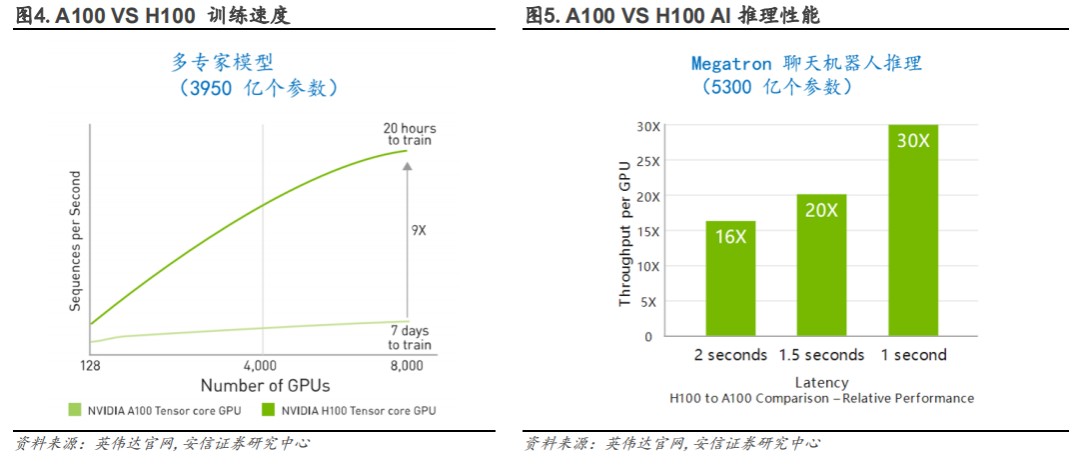

針對算力需求巨大的 ChatGPT 及其他大模型,英偉達推出 NVIDIA H100 NVL。NVIDIA H100NVL 是具有 94GB 內(nèi)存和加速 Transformer 引擎的大語言模型(LLM)專用解決方案。H100 的單精度浮點計算能力峰值可達 34 TFLOPS,雙精度浮點算力可達 67 TFLOPS。與 NVIDIA A100GPU 相比,NVIDIA H100 在大型語言模型上具有高達 9 倍的訓(xùn)練速度和 30 倍的 AI 推理性能,進一步鞏固英偉達在 AI 芯片市場的領(lǐng)先地位。

1、海外巨頭爭奪 AI 領(lǐng)域主動權(quán)

3 月 16 日微軟推出 AI 版 Office“全家桶”:Microsoft 365 Copilot。2023 年 7 月 18 日,微軟于 Inspire 合作伙伴大會上宣布,面向 Office 365 E3、E5、商業(yè)標準版和商業(yè)進階版的訂閱商戶,Microsoft 365 Copilot的定價為每個用戶每月 30 美元。

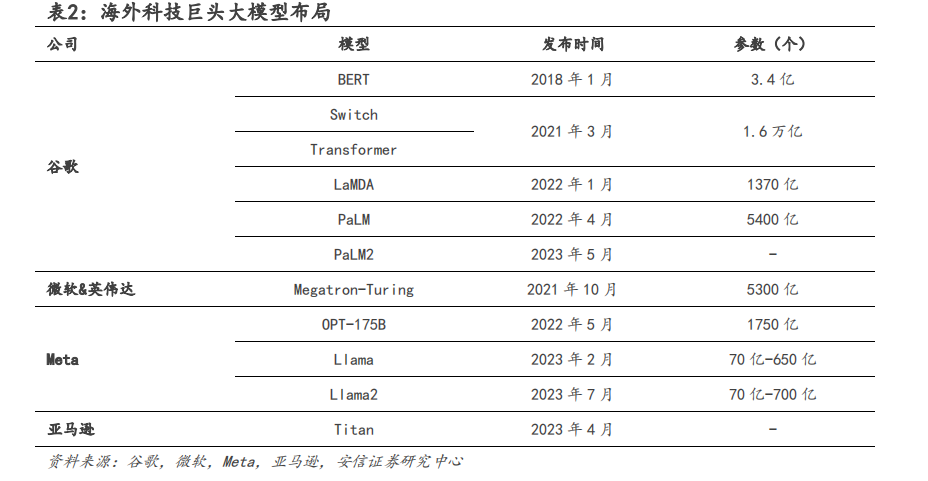

2022 年,谷歌推出了 5400 億參數(shù)大模型 PaLM,而 2023 年 5 月 10 日,谷歌又發(fā)布了 PaLM2,部分能力已經(jīng)超越了 GPT-4。谷歌推出基于 LaMDA 的 Bard 用來對標 ChatGPT。Bard 的 LaMDA模型訓(xùn)練參數(shù)達 1370 億個。在 2023 年 3 月 21 日,谷歌宣布開放 Bard 公測,并于 2023 年 4月 10 日改用更強大的 PaLM 大型語言模型以增加其運算能力。隨著全球 AI 接入潮興起,谷歌也將 Bard 應(yīng)用到谷歌搜索和辦公軟件中。DuetAI 是應(yīng)用于 GoogleWorkspace 的辦公類 AI工具,用來對標微軟 Copilot,可以自動生成文檔、表格和圖片。

2022 年 5 月,MetaAI 發(fā)布了基于 1750 億參數(shù)的超大模型 OPT-175B。2023 年 2 月,Meta 宣布將推出針對研究社區(qū)的“Meta 人工智能大型語言模型”系統(tǒng)“LlaMA”。2023 年 7 月,MetaAI 發(fā)布了第二代語言大模型 Llama2,模型開源且可免費用于商業(yè)用途。依照測試結(jié)果,700億參數(shù)的結(jié)果同常見的閉源模型 GPT-3.5 在 MMLU 和 GSM8K 水平上較為接近,但在生成代碼的能力上存在較大差距。微軟在隨后的 Inspire 合作伙伴大會上同時宣布在 Azure 云計算平臺上相應(yīng)深度整合 Llama2 模型框架。亞馬遜的 AWS 云也加入和 Meta 的合作中。

2023 年 4 月 13 日,亞馬遜云服務(wù)部門宣布推出自有大型語言模型泰坦,模型初始可分為兩種,第一類名為 Titan Text,為生成式 LLM,可用于總結(jié)、文字生成等。第二類名為 TitanEmbedding,專注于將文字輸入轉(zhuǎn)換為參數(shù)化的表達,相應(yīng)的技術(shù)已被用于亞馬遜商品的推薦算法中。

2、國內(nèi)大廠加速布局大模型

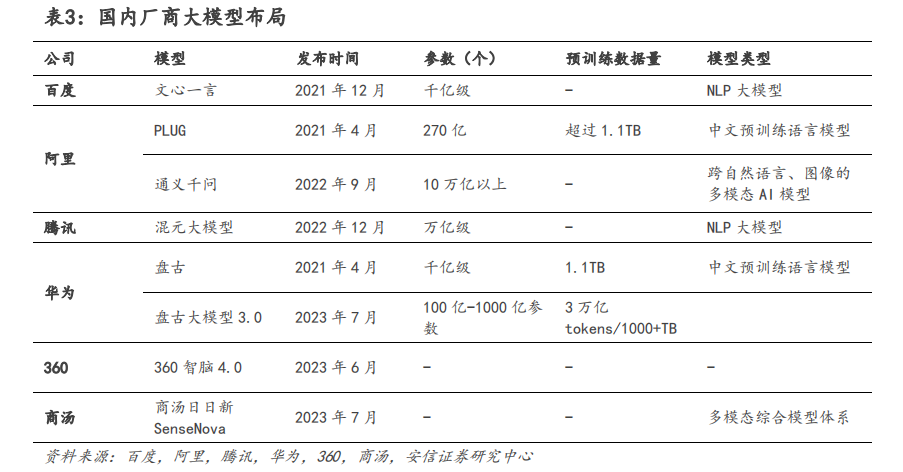

國內(nèi)廠商也在加速研發(fā)大模型,各大互聯(lián)網(wǎng)巨頭紛紛入局 AI 大模型。

百度最早于 2019 年推出預(yù)訓(xùn)練模型 ERNIE 1.0,歷經(jīng)多次迭代,百度文心大模型形成了基礎(chǔ)大模型、任務(wù)大模型、行業(yè)大模型三級體系。框架層面上,百度提供了中國首個開源的產(chǎn)業(yè)級深度學(xué)習(xí)框架-飛槳PaddlePaddle,百度構(gòu)建了文心大模型+飛槳深度學(xué)習(xí)平臺的商業(yè)模式,落地應(yīng)用方向廣泛,涵蓋金融、能源、電力、航天、互聯(lián)網(wǎng)等領(lǐng)域。

2022 年 9 月,阿里發(fā)布通義大模型系列。通義大模型分為統(tǒng)一模型底層、通用模型層和專業(yè)模型層。目前,阿里通義大模型已落地應(yīng)用于電商、醫(yī)療、娛樂、設(shè)計、金融等行業(yè),服務(wù)超過 200 個場景。2023 年 4 月 11 日,阿里正式推出大語言模型通義千問。此外,阿里還推出了用戶共建 AI 模型服務(wù)型平臺“魔搭社區(qū)”,目前社區(qū)內(nèi)已集聚了 180 多萬 AI 開發(fā)者和900 多個優(yōu)質(zhì) AI 模型。2023 年 7 月 7 日上海世界人工智能大會上公司 CTO 表示,阿里云將向大模型創(chuàng)業(yè)公司提供全方位的服務(wù),包括最強大的算力和開發(fā)工具。

華為云團隊 2020 年開始發(fā)展 AI 大模型,2021 年 4 月發(fā)布盤古大模型。2023 年 7 月 7 日,華為于公司開發(fā)者大會 2023 上正式發(fā)布 AI 大模型華為盤古大模型 3.0。模型提供 100 億參數(shù)、380 億參數(shù)、710 億參數(shù)和 1000 億參數(shù)的系列化基礎(chǔ)大模型。此外,華為一站式 AI 開發(fā)平臺 ModelArts 為盤古大模型的訓(xùn)練、推理迭代發(fā)展持續(xù)提供優(yōu)化支持。目前,盤古大模型已在 100 多個行業(yè)場景完成驗證,涵蓋能源、零售、金融、工業(yè)、醫(yī)療、環(huán)境、物流等。

騰訊于 2022 年 12 月推出了萬億中文 NLP 預(yù)訓(xùn)練模型混元 AI 大模型。目前,騰訊混元大模型涵蓋 NLP 大模型、CV 大模型、多模態(tài)大模型和眾多行業(yè)模型。騰訊也打造了一站式機器學(xué)習(xí)生態(tài)服務(wù)平臺——太極機器學(xué)習(xí)平臺,為混元大模型提供底層支持。受益于騰訊自身業(yè)務(wù)廣泛,混元大模型在騰訊內(nèi)部已與騰訊廣告、微信、QQ、游戲等產(chǎn)品結(jié)合,在廣告提效層面效果顯著。同時,混元大模型還通過騰訊云實現(xiàn)對外的商業(yè)化。

2023 年 4 月 18 日,字節(jié)跳動旗下火山引擎發(fā)布自研 DPU 等系列云產(chǎn)品,并推出升級版的機器學(xué)習(xí)平臺,支持萬卡級大模型訓(xùn)練。2023 年 6 月 28 日,字節(jié)跳動公布了公司在大模型業(yè)務(wù)的最新進展,并發(fā)布了大模型服務(wù)平臺“火山方舟”,提供模型的訓(xùn)練、推理、評測、精調(diào)等功能服務(wù)。目前集成了百川智能、出門問問、復(fù)旦大學(xué) MOSS、IDEA 研究院、瀾舟科技、MiniMax、智譜 AI 等多家公司及團隊的大模型。

科大訊飛于 2023 年 5 月推出星火認知大模型,目前已在教育、辦公、汽車、數(shù)字員工等行業(yè)中落地應(yīng)用。在發(fā)布會上,董事長劉慶峰表示未來科大訊飛將在保護倫理和安全的前提下發(fā)展認知大模型,同時聯(lián)合開發(fā)者推動認知大模型應(yīng)用落地,共建人工智能“星火”生態(tài)。2023年 6 月 13 日,360 集團發(fā)布認知型通用大模型“360 智腦 4.0”,并宣布 360 智腦已接入 360旗下產(chǎn)品,如搜索引擎、瀏覽器和安全衛(wèi)士中。同時,借助 360 長期在互聯(lián)網(wǎng)安全方面的積累,公司建立了“安全大腦”大模型,以監(jiān)管大模型中的不當(dāng)行為。

2023 年 7 月 7 日,商湯推出大模型體系“商湯日日新 SenseNova”的多方位全面升級及體系下一系列大模型產(chǎn)品的落地成果,其中包括金融領(lǐng)域的客服、投研分析降本增效;醫(yī)療場景內(nèi)輔助導(dǎo)診問診、輔助決策;移動終端內(nèi)智能交互、內(nèi)容交互;線下場景的故障識別、缺陷判斷;線上直播短視頻平臺的數(shù)字人應(yīng)用及營銷工具;智能汽車領(lǐng)域的集安全效率為一體的智能座艙體驗等。

3、人工智能行業(yè)加速服務(wù)器、AI 芯片、交換機、光模塊產(chǎn)業(yè)

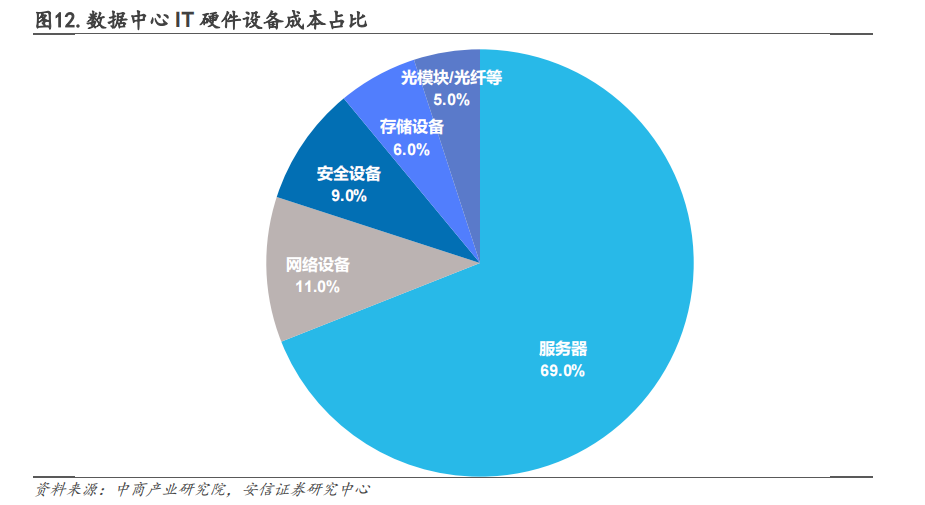

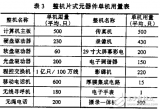

人工智能的快速發(fā)展推動數(shù)據(jù)使用量的飆升,推動數(shù)據(jù)中心基礎(chǔ)設(shè)施建設(shè)的快速增長。數(shù)據(jù)中心基礎(chǔ)設(shè)施主要包括 IT 設(shè)備、非 IT 設(shè)備、軟件及建設(shè)工程。在 IT 設(shè)備采購成本中,服務(wù)器占比最大達 69%。網(wǎng)絡(luò)設(shè)備(即交換機和路由器)、安全設(shè)備、存儲設(shè)備和光模塊/光纖等分別占數(shù)據(jù)中心設(shè)備采購成本的 11%、9%、6%和 5%,不同方案成本占比略有不同,但總體上服務(wù)器成本占 IDC 硬件成本70%左右。

到 2023 年中旬,AI 服務(wù)器市場出貨量接近 60 萬臺,相比上年同期增長約 39%。根據(jù)TrendForce 預(yù)估,2023 年全球 AI 服務(wù)器出貨量將接近 120 萬臺,同比增長 38.4%,占整體服務(wù)器出貨量的比重約 9%。到 2025 年將增長至近 190 萬臺,2022-2025 年期間年平均增長率達 41.2%。預(yù)計 2030 年全球算力規(guī)模達到 56 ZFlops,平均年增速達到 65%。

從全球市場份額占比來看,2021 年浪潮信息市占率達 20.9%,位列行業(yè)第一。其次為戴爾、HPE、聯(lián)想、IBM,占比分別為 13.0%、9.2、5.8%、4.1%。

-

芯片

+關(guān)注

關(guān)注

454文章

50460瀏覽量

421971 -

服務(wù)器

+關(guān)注

關(guān)注

12文章

9029瀏覽量

85207 -

交換機

+關(guān)注

關(guān)注

21文章

2624瀏覽量

99287

原文標題:AI熱潮帶動服務(wù)器、交換機、光模塊及芯片蓬勃發(fā)展

文章出處:【微信號:AI_Architect,微信公眾號:智能計算芯世界】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

[分享]常見網(wǎng)絡(luò)交換機故障及應(yīng)用問答

基礎(chǔ)知識:理解網(wǎng)絡(luò)交換機的原理

新手教程:萬兆SFP+光模塊和光纖交換機最簡單的連接方案

沙龍活動:蓬勃發(fā)展的RISC-V生態(tài)

增強型服務(wù)器取代交換機你覺得靠譜嗎

AI熱潮帶動服務(wù)器、交換機、光模塊及芯片蓬勃發(fā)展

AI熱潮帶動服務(wù)器、交換機、光模塊及芯片蓬勃發(fā)展

評論