1. 用FP8訓練大模型有多香?微軟:比BF16快64%,省42%內存

原文:https://mp.weixin.qq.com/s/xLvJXe2FDL8YdByZLHjGMQ

低精度訓練是大模型訓練中擴展模型大小,節約訓練成本的最關鍵技術之一。相比于當前的 16 位和 32 位浮點混合精度訓練,使用 FP8 8 位浮點混合精度訓練能帶來 2 倍的速度提升,節省 50% - 75% 的顯存和 50% - 75% 的通信成本,而且英偉達最新一代卡皇 H100 自帶良好的 FP8 硬件支持。但目前業界大模型訓練框架對 FP8 訓練的支持還非常有限。最近,微軟提出了一種用于訓練 LLM 的 FP8 混合精度框架 FP8-LM,將 FP8 盡可能應用在大模型訓練的計算、存儲和通信中,使用 H100 訓練 GPT-175B 的速度比 BF16 快 64%,節省 42% 的內存占用。更重要的是:它開源了。??

大型語言模型(LLM)具有前所未有的語言理解和生成能力,但是解鎖這些高級的能力需要巨大的模型規模和訓練計算量。在這種背景下,尤其是當我們關注擴展至 OpenAI 提出的超級智能 (Super Intelligence) 模型規模時,低精度訓練是其中最有效且最關鍵的技術之一,其優勢包括內存占用小、訓練速度快,通信開銷低。目前大多數訓練框架(如 Megatron-LM、MetaSeq 和 Colossal-AI)訓練 LLM 默認使用 FP32 全精度或者 FP16/BF16 混合精度。

但這仍然沒有推至極限:隨著英偉達 H100 GPU 的發布,FP8 正在成為下一代低精度表征的數據類型。理論上,相比于當前的 FP16/BF16 浮點混合精度訓練,FP8 能帶來 2 倍的速度提升,節省 50% - 75% 的內存成本和 50% - 75% 的通信成本。

盡管如此,目前對 FP8 訓練的支持還很有限。英偉達的 Transformer Engine (TE),只將 FP8 用于 GEMM 計算,其所帶來的端到端加速、內存和通信成本節省優勢就非常有限了。

但現在微軟開源的 FP8-LM FP8 混合精度框架極大地解決了這個問題:FP8-LM 框架經過高度優化,在訓練前向和后向傳遞中全程使用 FP8 格式,極大降低了系統的計算,顯存和通信開銷。

論文地址:https://arxiv.org/abs/2310.18313

開源框架:https://github.com/Azure/MS-AMP

實驗結果表明,在 H100 GPU 平臺上訓練 GPT-175B 模型時, FP8-LM 混合精度訓練框架不僅減少了 42% 的實際內存占用,而且運行速度比廣泛采用的 BF16 框架(即 Megatron-LM)快 64%,比 Nvidia Transformer Engine 快 17%。而且在預訓練和多個下游任務上,使用 FP8-LM 訓練框架可以得到目前標準的 BF16 混合精度框架相似結果的模型。

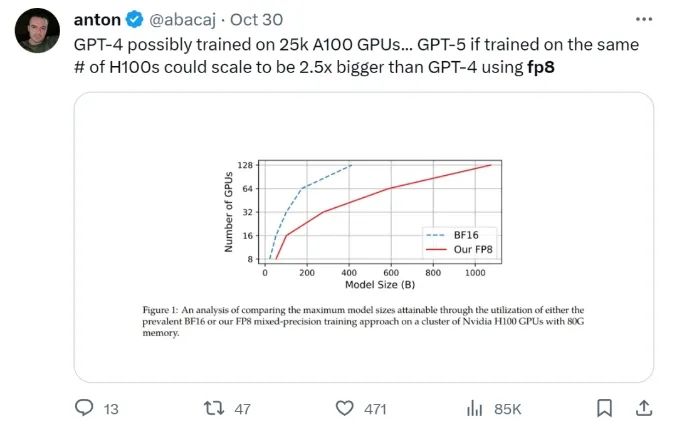

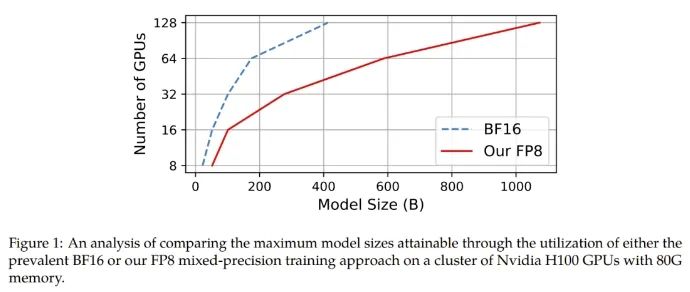

在給定計算資源情況下,使用 FP8-LM 框架能夠無痛提升可訓練的模型大小多達 2.5 倍。有研發人員在推特上熱議:如果 GPT-5 使用 FP8 訓練,即使只使用同樣數量的 H100,模型大小也將會是 GPT-4 的 2.5 倍!

Huggingface 研發工程師調侃:「太酷啦,通過 FP8 大規模訓練技術,可以實現計算欺騙!」

FP8-LM 主要貢獻:

-

一個新的 FP8 混合精度訓練框架。其能以一種附加方式逐漸解鎖 8 位的權重、梯度、優化器和分布式訓練,這很便于使用。這個 8 位框架可以簡單直接地替代現有 16/32 位混合精度方法中相應部分,而無需對超參數和訓練方式做任何修改。此外,微軟的這個團隊還發布了一個 PyTorch 實現,讓用戶可通過少量代碼就實現 8 位低精度訓練。?

-

一個使用 FP8 訓練的 GPT 式模型系列。他們使用了新提出的 FP8 方案來執行 GPT 預訓練和微調(包括 SFT 和 RLHF),結果表明新方法在參數量從 70 億到 1750 億的各種大小的模型都頗具潛力。他們讓常用的并行計算范式都有了 FP8 支持,包括張量、流水線和序列并行化,從而讓用戶可以使用 FP8 來訓練大型基礎模型。他們也以開源方式發布了首個基于 Megatron-LM 實現的 FP8 GPT 訓練代碼庫。

FP8-LM 實現

具體來說,對于使用 FP8 來簡化混合精度和分布式訓練的目標,他們設計了三個優化層級。這三個層級能以一種漸進方式來逐漸整合 8 位的集體通信優化器和分布式并行訓練。優化層級越高,就說明 LLM 訓練中使用的 FP8 就越多。

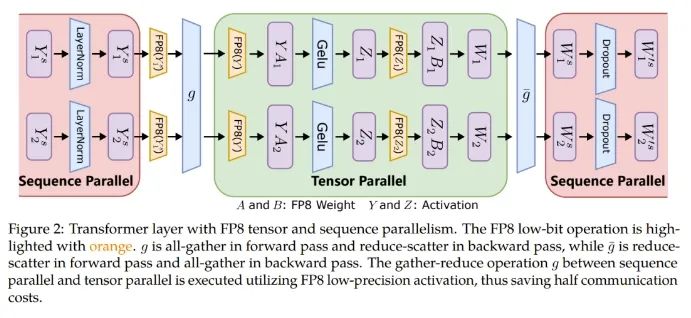

此外,對于大規模訓練(比如在數千臺 GPU 上訓練 GPT-175B),該框架能提供 FP8 精度的低位數并行化,包括張量、訓練流程和訓練的并行化,這能鋪就通往下一代低精度并行訓練的道路。

張量并行化是將一個模型的各個層分散到多臺設備上,從而將權重、梯度和激活張量的分片放在不同的 GPU 上。

為了讓張量并行化支持 FP8,微軟這個團隊的做法是將分片的權重和激活張量轉換成 FP8 格式,以便線性層計算,從而讓前向計算和后向梯度集體通信全都使用 FP8。

另一方面,序列并行化則是將輸入序列切分成多個數據塊,然后將子序列饋送到不同設備以節省激活內存。

如圖 2 所示,在一個 Transformer 模型中的不同部分,序列并行化和張量并行化正在執行,以充分利用可用內存并提高訓練效率。

而對于 ZeRO(零冗余優化器 / Zero Redundancy Optimizer),卻無法直接應用 FP8,因為其難以處理與 FP8 劃分有關的縮放因子。因此針對每個張量的縮放因子應當沿著 FP8 的劃分方式分布。

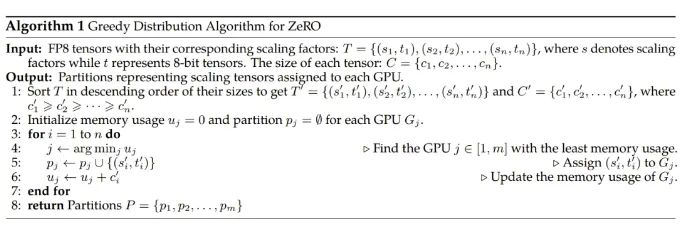

為了解決這個問題,研究者實現了一種新的 FP8 分配方案,其可將每個張量作為一個整體分散到多臺設備上,而不是像 ZeRO 方法一樣將其切分成多個子張量。該方法是以一種貪婪的方式來處理 FP8 張量的分配,如算法 1 所示。

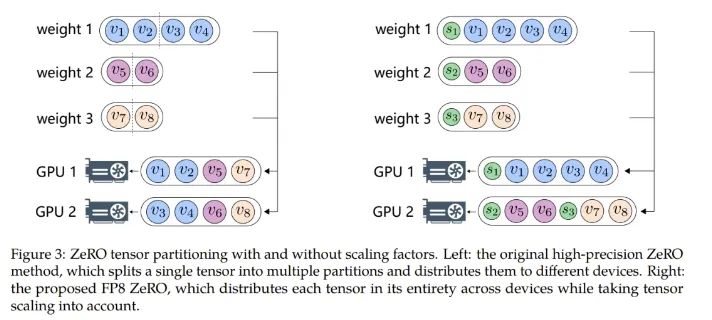

具體來說,該方法首先根據大小對模型狀態的張量排序,然后根據每個 GPU 的剩余內存大小將張量分配到不同的 GPU。這種分配遵循的原則是:剩余內存更大的 GPU 更優先接收新分配的張量。通過這種方式,可以平滑地沿張量分配張量縮放因子,同時還能降低通信和計算復雜度。圖 3 展示了使用和不使用縮放因子時,ZeRO 張量劃分方式之間的差異。

使用 FP8 訓練 LLM 并不容易。其中涉及到很多挑戰性問題,比如數據下溢或溢出;另外還有源自窄動態范圍的量化錯誤和 FP8 數據格式固有的精度下降問題。這些難題會導致訓練過程中出現數值不穩定問題和不可逆的分歧問題。為了解決這些問題,微軟提出了兩種技術:精度解耦(precision decoupling)和自動縮放(automatic scaling),以防止關鍵信息丟失。

精度解耦

精度解耦涉及到解耦數據精度對權重、梯度、優化器狀態等參數的影響,并將經過約簡的精度分配給對精度不敏感的組件。

針對精度解耦,該團隊表示他們發現了一個指導原則:梯度統計可以使用較低的精度,而主權重必需高精度。

更具體而言,一階梯度矩可以容忍較高的量化誤差,可以配備低精度的 FP8,而二階矩則需要更高的精度。這是因為在使用 Adam 時,在模型更新期間,梯度的方向比其幅度更重要。具有張量縮放能力的 FP8 可以有效地將一階矩的分布保留成高精度張量,盡管它也會導致精度出現一定程度的下降。由于梯度值通常很小,所以為二階梯度矩計算梯度的平方可能導致數據下溢問題。因此,為了保留數值準確度,有必要分配更高的 16 位精度。

另一方面,他們還發現使用高精度來保存主權重也很關鍵。其根本原因是在訓練過程中,權重更新有時候會變得非常大或非常小,對于主權重而言,更高的精度有助于防止權重更新時丟失信息,實現更穩定和更準確的訓練。

自動縮放

自動縮放是為了將梯度值保存到 FP8 數據格式的表征范圍內,這需要動態調整張量縮放因子,由此可以減少 all-reduce 通信過程中出現的數據下溢和溢出問題。

具體來說,研究者引入了一個自動縮放因子 μ,其可以在訓練過程中根據情況變化。

實驗結果

為了驗證新提出的 FP8 低精度框架,研究者實驗了用它來訓練 GPT 式的模型,其中包括預訓練和監督式微調(SFT)。實驗在 Azure 云計算最新 NDv5 H100 超算平臺上進行。

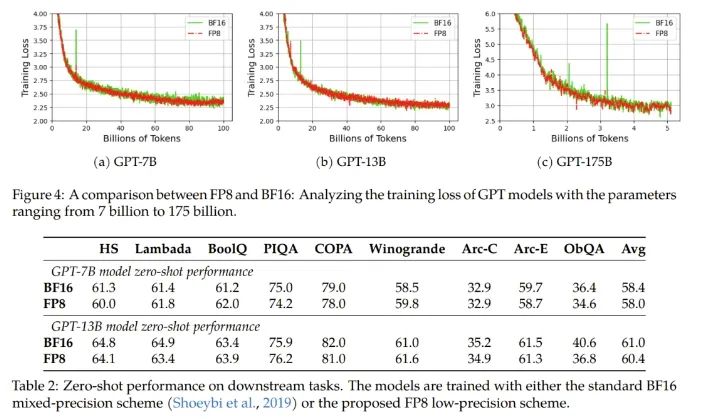

實驗結果表明新提出的 FP8 方法是有效的:相比于之前廣泛使用 BF16 混合精度訓練方法,新方法優勢明顯,包括真實內存用量下降了 27%-42%(比如對于 GPT-7B 模型下降了 27%,對于 GPT-175B 模型則下降了 42%);權重梯度通信開銷更是下降了 63%-65%。

不修改學習率和權重衰減等任何超參數,不管是預訓練任務還是下游任務,使用 FP8 訓練的模型與使用 BF16 高精度訓練的模型的表現相當。值得注意的是,在 GPT-175B 模型的訓練期間,相比于 TE 方法,在 H100 GPU 平臺上,新提出的 FP8 混合精度框架可將訓練時間減少 17%,同時內存占用少 21%。更重要的是,隨著模型規模繼續擴展,通過使用低精度的 FP8 還能進一步降低成本,如圖 1 所示。

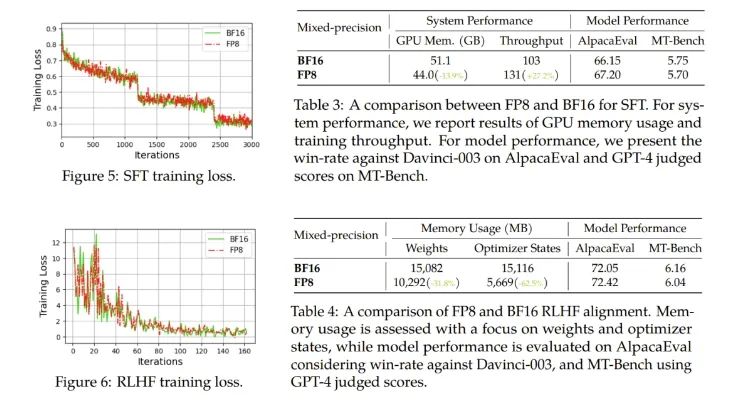

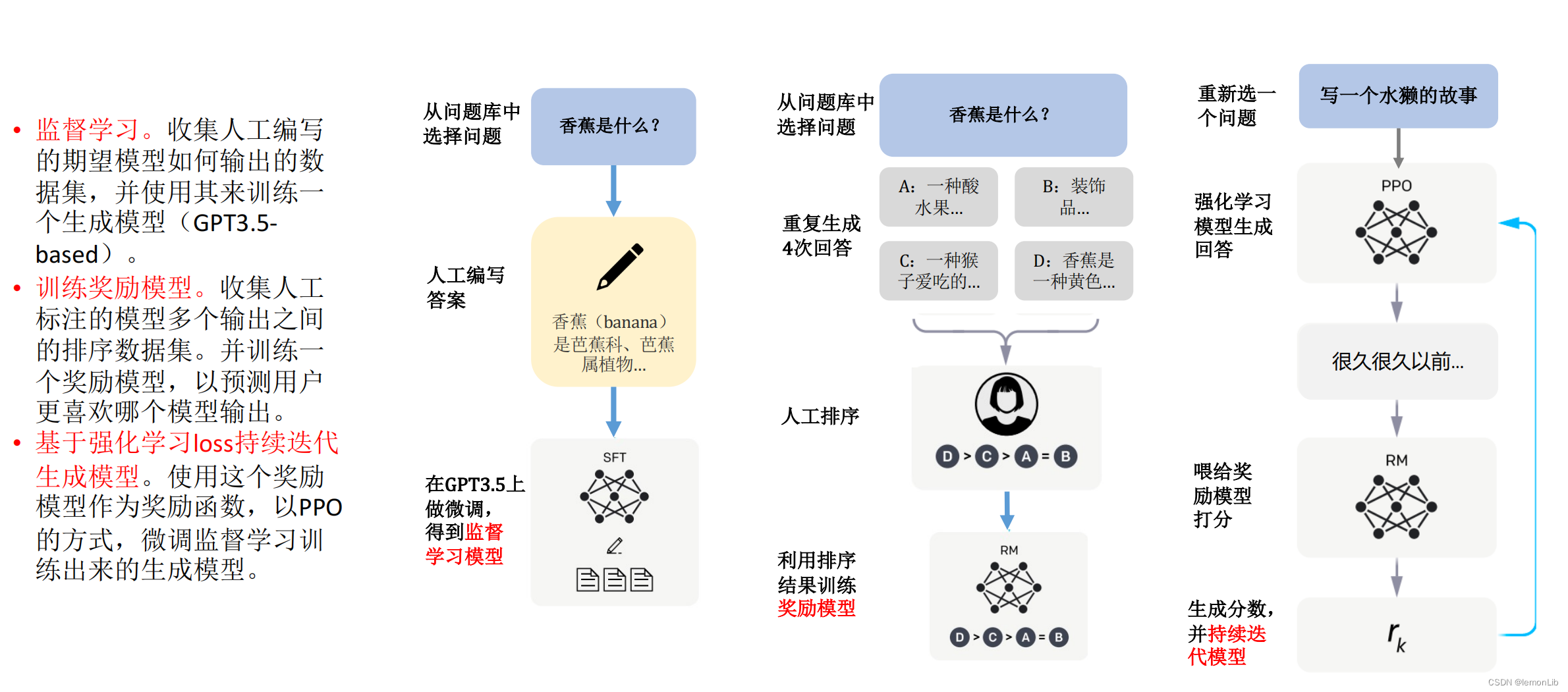

對于微調,他們使用了 FP8 混合精度來進行指令微調,并使用了使用人類反饋的強化學習(RLHF)來更好地將預訓練后的 LLM 與終端任務和用戶偏好對齊。

結果發現,在 AlpacaEval 和 MT-Bench 基準上,使用 FP8 混合精度微調的模型與使用半精度 BF16 微調的模型的性能相當,而使用 FP8 的訓練速度還快 27%。此外,FP8 混合精度在 RLHF 方面也展現出了巨大的潛力,該過程需要在訓練期間加載多個模型。通過在訓練中使用 FP8,流行的 RLHF 框架 AlpacaFarm 可將模型權重減少 46%,將優化器狀態的內存消耗減少 62%。這能進一步展現新提出的 FP8 低精度訓練框架的多功能性和適應性。

他們也進行了消融實驗,驗證了各組件的有效性。

可預見,FP8 低精度訓練將成為未來大模型研發的新基建。

2. 萬萬沒想到,ChatGPT參數只有200億?

原文:https://mp.weixin.qq.com/s/4oovtS-FaA-Yvk0Tgy3Lng

誰都沒有想到,ChatGPT 的核心秘密是由這種方式,被微軟透露出來的。

昨天晚上,很多討論 AI 的微信群都被一篇 EMNLP 論文和其中的截圖突然炸醒。

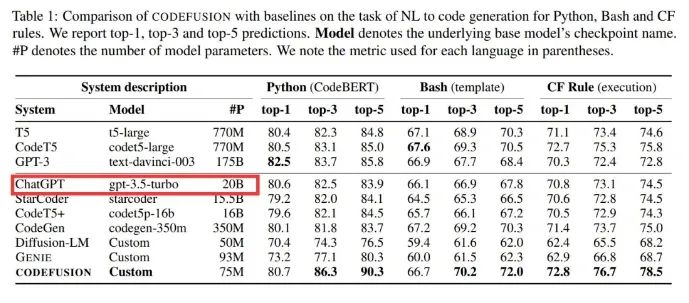

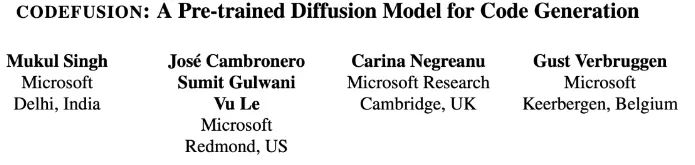

微軟一篇題為《CodeFusion: A Pre-trained Diffusion Model for Code Generation》的論文,在做對比的時候透露出了重要信息:ChatGPT 是個「只有」20B(200 億)參數的模型,這件事引起了廣泛關注。

距 ChatGPT 發布已經快一年了,但 OpenAI 一直未透露 ChatGPT 的技術細節。由于其強大的模型性能,人們對 ChatGPT 的參數量、訓練數據等信息抱有諸多疑問和猜測。

作為行業一直以來的標桿,ChatGPT 性能強大,可以解決各種各樣的問題。它的前身 GPT-3 參數量就達到了 1750 億,實用化以后的大模型居然被 OpenAI 瘦身了快 9 倍,這合理嗎?

「如何看待這篇論文」的話題立刻沖上了知乎熱榜。

具體來說,微軟這篇論文提出了一種預訓練的擴散代碼生成模型 ——CodeFusion。CodeFusion 的參數量是 75M。在實驗比較部分,論文的表 1 將 ChatGPT 的參數量明確標成了 20B。

眾所周知,微軟和 OpenAI 是合作已久的一對伙伴,并且這是一篇 EMNLP 2023 論文,因此大家推測這個數據很有可能是真實的。

然而,關于 ChatGPT 參數量的猜測,人們一直認為是一個龐大的數字,畢竟 GPT-3 的參數量就已經達到了 175B(1750 億)。掀起大型語言模型(LLM)浪潮的 ChatGPT,難道就只有 20B 參數?

大家怎么看?

這個數據被扒出來之后,在知乎和 Twitter 已經引起了廣泛討論。畢竟,200 億參數達到這樣的效果十分驚人。再則,國內追趕出的大模型動則就是數百億、上千億。

那么這個數據保不保真?大家都有什么看法呢?

NLP 知名博主、新浪微博新技術研發負責人張俊林「盲猜」分析了一波,引起了大家廣泛贊同:

不負責任猜測一波:GPT 4 是去年 8 月做好的,ChatGPT 估計是 OpenAI 應對 Anthropic 要推出的 Claude 專門做的,那時候 GPT 4 應該價值觀還沒對齊,OpenAI 不太敢放出來,所以臨時做了 ChatGPT 來搶先發優勢。OpenAI 在 2020 年推出 Scaling law 的文章,Deepmind 在 2022 年推出的改進版本 chinchilla law。OpenAI 做大模型肯定會遵循科學做法的,不會拍腦袋,那么就有兩種可能:

可能性一:OpenAI 已經看到 Chinchilla 的論文,模型是按照龍貓法則做的,我們假設 ChatGPT 的訓練數據量不低于 2.5T token 數量(為啥這樣后面分析),那么按照龍貓法則倒推,一般訓練數據量除以 20 就應該是最優參數量。于是我們可以推出:這種情況 ChatGPT 模型的大小約在 120B 左右。

可能性二:OpenAI 在做 ChatGPT 的時候還沒看到 Chinchilla 的論文,于是仍然按照 OpenAI 自己推導的 Scaling law 來設計訓練數據量和模型大小,推算起來訓練數據量除以 12.5 左右對應模型最優參數,他們自己的 Scaling law 更傾向把模型推大。假設訓練數據量是 2.5T 左右,那么這種情況 ChatGPT 的模型大小應該在 190 到 200B 左右。

大概率第一個版本 ChatGPT 推出的時候在 200B 左右,所以剛出來的時候大家還是覺得速度慢,價格也高。3 月份 OpenAI 做過一次大升級,價格降低為原先的十分之一。如果僅僅靠量化是不太可能壓縮這么猛的,目前的結論是大模型量化壓縮到 4 到 6bit 模型效果是能保持住不怎么下降的。

所以很可能 OpenAI 這次升級從自己的 Scaling law 升級到了 Chinchilla 的 Scaling law,這樣模型大小就壓縮了 120B 左右,接近一半(也有可能遠小于 120B,如果按照 chinchilla law,llama 2 最大的模型應該是 100B 左右,此時算力分配最優,也就是說成本收益最合算。但是實際最大的 llama2 模型才 70B,而且更小的模型比如 7B 模型也用超大數據集。

llama1 65B 基本是符合 chinchilla law 的,llama2 最大模型已經打破 chinchilla law 開始懟數據了。就是說目前大家做大模型的趨勢是盡管不是算力分配最優,但是都傾向于增加數據減小模型規模,這樣盡管訓練成本不合算,但是推理合算,而訓練畢竟是一次性的,推理則并發高次數多,所以這么配置很明顯總體是更合算的),再加上比如 4bit 量化,這樣推理模型的大小可以壓縮 4 倍,速度大約可提升 8 倍左右,如果是采取繼續增加訓練數據減小模型規模,再加上其它技術優化是完全有可能把推理價格打到十分之一的。

后續在 6 月份和 8 月份各自又價格下調了 25%,最終可能通過反復加數據減小規模逐漸把模型壓縮到 20B 左右。

這里解釋下為何 ChatGPT 的訓練數據量不太可能比 2.5T 低,LLaMA 2 的訓練數據量是 2T,效果應該稍弱于 ChatGPT,所以這里假設最少 2.5T 的訓練數據。目前研究結論是當模型規模固定住,只要持續增加訓練數據量,模型效果就會直接增長,mistral 7B 效果炸裂,歸根結底是訓練數據量達到了 8 個 T,所以導致基礎模型效果特別強。以 ChatGPT 的效果來說,它使用的數據量不太可能低于 2.5T。

當然,還有另外一種可能,就是 ChatGPT 在后期優化(比如第一次大升級或者后續的升級中,開始版本不太可能走的這條路)的時候也不管 scaling law 了,走的是類似 mistral 的路線,就是模型大小固定在 20B,瘋狂增加訓練數據,如果又構造出合適的 instruct 數據,效果也可能有保障。

不論怎么講,對于 6B 到 13B 左右比較適合應用落地的模型,強烈呼吁中文開源模型模仿 mistral,固定住一個最適合使用的模型大小,然后瘋狂增加訓練數據,再加上好的 instruct 策略,是有可能作出小規模效果體驗足夠好的模型的。我個人認為對于開源模型來說,7B-13B 左右大小的模型應該是兵家必爭之地。有心氣做開源的可以再努把力,把訓練數據往上再努力懟一懟。

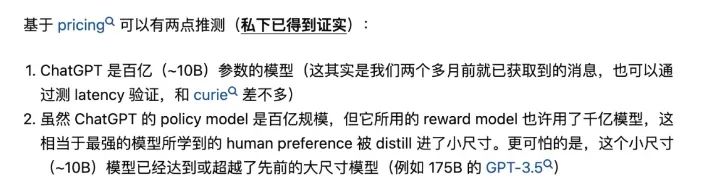

早在 OpenAI 開放 ChatGPT API 時,0.002 美元 / 1k token 的定價就令人們意外,這個價格只有 GPT-3.5 的 1/10。彼時就有人推測:「ChatGPT 是百億(~10B)參數的模型」,并且「ChatGPT 使用的獎勵模型(reward model)可能是千億級模型」。該推測來源于清華大學 NLP 在讀博士鄭楚杰的知乎回答。

但所有這些都是猜測,由于 OpenAI 對參數量、訓練數據、方法等核心信息一直諱莫如深,因此 20B 這個數據到底是不是真的根本無法求證。如果是真的,那么大型語言模型未來的改進方向還會是增加參數量嗎?

再過幾天,就是 OpenAI 的開發者大會了,也許我們能夠了解到更多有用的信息,讓我們拭目以待吧。

3. 代碼能力超越GPT-4,這個模型登頂Big Code排行榜,YC創始人點贊

原文:https://mp.weixin.qq.com/s/fSVPRjNpWPVrLVA59PrIBA

一款號稱代碼能力超越GPT-4的模型,引發了不少網友的關注。

準確率比GPT-4高出超過10%,速度卻接近GPT-3.5,而且窗口長度也更長。

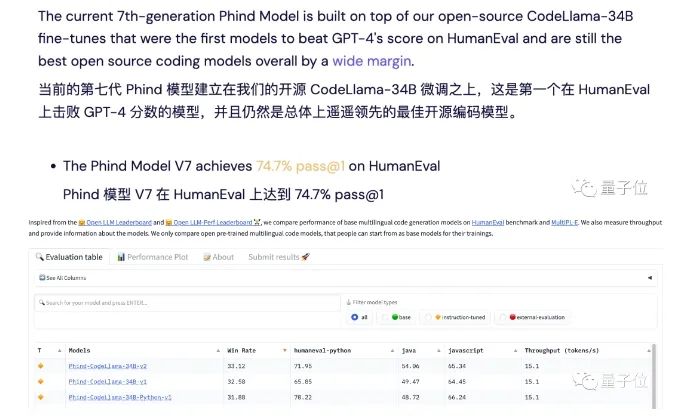

據開發者描述,他們的模型取得了74.7%的Pass@1通過率,超過了原始GPT-4的67%,登上了Big Code榜首。

這個模型名叫Phind,和以其為基礎的面向開發者的AI搜索工具同名。

它是由開發團隊在CodeLlama-34B的基礎之上微調得到的。

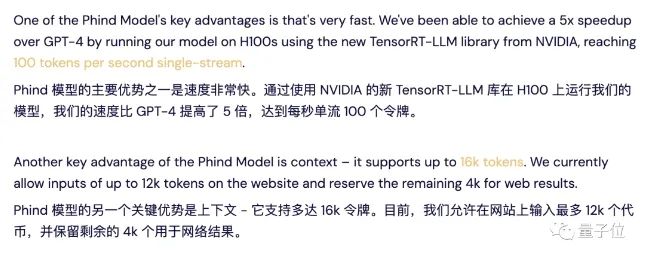

Phind利用TensorRT-LLM在H100上可以跑出每秒100個token的速度,是GPT-4的5倍。

此外,Phind的上下文長度達到了16k,其中12k可供用戶輸入,另外4k保留給檢索結果中的文本。

針對這個產品,網友們議論紛紛,結果是喜憂參半:

支持的人,如著名創業投資公司YCombinator創始人Paul Graham表示,Phind可以讓人們用更少的資源和大廠抗衡。

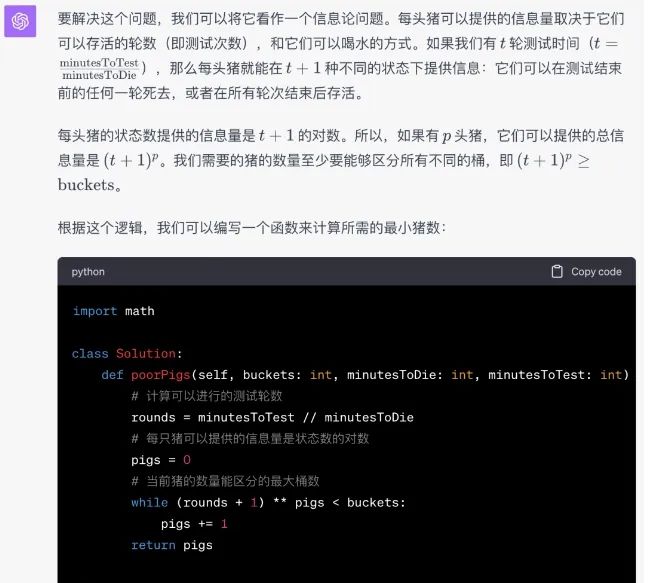

Phind vs GPT-4

正式開始之前,先來說說對Phind的第一印象。

它的界面十分簡潔,主要就是一個搜索框,而且不需要登錄就能無限量使用。

左下角有一個Pair Programmer的開關,直觀上的區別就是開啟之后回答界面更側重對話,不開啟的話則更像搜索引擎。

此外,還可以從自研模型和GPT-4中選擇,GPT-4則需要登錄,而且每天只能用10次。

接下來就是和GPT-4進行的對比測試,GPT-4沒有開啟代碼解釋器。

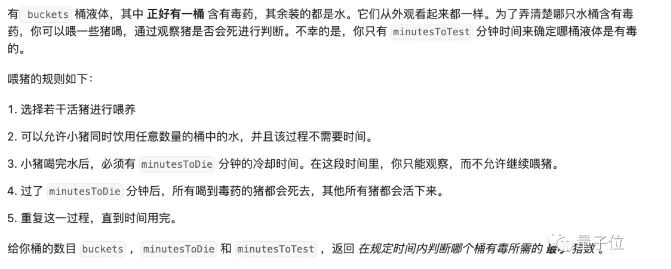

首先還是從LeetCode題目開始測起,Prompt就是是原問題加上下面這段話:

請用Python寫一段代碼解決這個問題,給出通用的解法,不需要設定參數值,代碼需要以如下內容開頭:(LeetCode頁面中給出的起始片段)

為了防止Phind通過檢索來“作弊”,我們還在Phind的Prompt結尾加入了這句話:

不要檢索任何信息,靠你自己的能力創建代碼

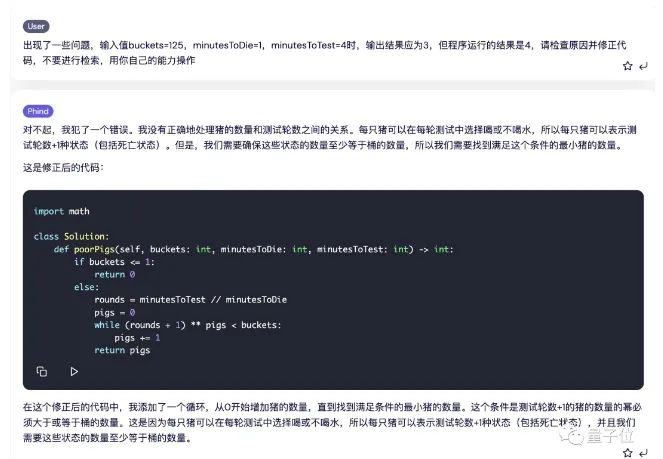

第一題在LeetCode中被歸為組合數學問題,難度為困難,通過率67.1%。

Phind給出了這樣的代碼和解釋,經過測試,20條測試數據中有19項正確。

出錯的是這一條,這里的輸出結果應該是3,但Phind給出的程序運行結果是4。

我們試著反饋給Phind,看它能不能找出錯誤的原因,結果分析一番之后給出了新的代碼,并通過了測試。

而GPT-4這邊,則是一次性通過。

道LeetCode題目測試下來,Phind以一平兩負的成績輸給了GPT-4。

但需要說明的是,這里我們為了測試模型本身表現,通過提示詞關閉了Phind的檢索功能,但從實用角度出發,如果保留搜索,Phind還是能很好地解決這些問題的。

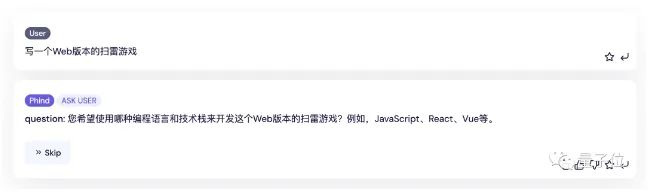

接著,我們又測試了一下他們的實際開發能力,這次的題目是掃雷游戲。

Phind會問我們有沒有什么特殊要求,這里我們直接點跳過。

然后Phind會對任務進行拆解,對每個子任務又分別進行檢索。

這時的代碼也是分段給出的,有趣的是,在生成過程中,Phind會使用不同來源中的代碼。

然后我們讓Phind給出完整代碼,并通過鏈接的第三方平臺直接運行。

結果呢,我們一進去就看到程序已經非常“貼心”地把雷的位置清楚地標注好了。

不過這次,GPT-4的代碼更加離譜一些,運行出來是這樣的:

雖然都沒做對,但硬要比較的話,這一輪,Phind略勝一籌。

一路測試下來,很難判斷它們孰優孰劣,但考慮到搜索能力,以及免費免登錄的特性,Phind還是可圈可點的。

4. 中文最強開源大模型來了!130億參數,0門檻商用,來自昆侖萬維

原文:https://mp.weixin.qq.com/s/MKu6eusxyCXw3fLhgbcp0A

開源最徹底的大模型來了——130億參數,無需申請即可商用。

不僅如此,它還附帶著把全球最大之一的中文數據集也一并開源了出來:600G、1500億tokens!

這就是來自昆侖萬維的Skywork-13B系列,包含兩大版本:

-

Skywork-13B-Base:該系列的基礎模型,在多種基準評測中都拔得頭籌的那種。

-

Skywork-13B-Math:該系列的數學模型,數學能力在GSM8K評測上得分第一。

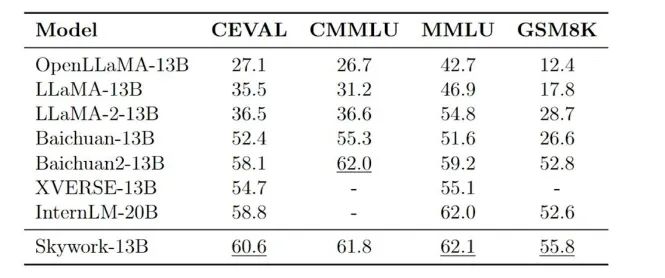

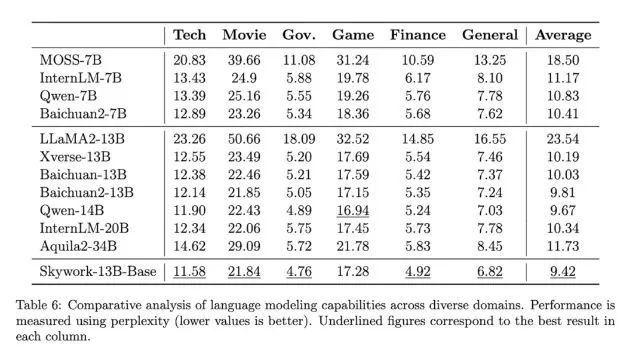

在各大權威評測benchmark上,如C-Eval、MMLU、CMMLU、GSM8K,可以看到Skywork-13B在中文開源模型中處于前列,在同等參數規模下為最優水平。

而Skywork-13B系列之所以能取得如此亮眼的成績,部分原因離不開剛才我們提到的數據集。

畢竟清洗好的中文數據對于大模型來說可謂是至關重要,幾乎從某種程度上決定了其性能。

但昆侖萬維能將如此“至寶”無償地給奉獻出來,不難看出它對于構建開源社區、服務開發者的滿滿誠意。

除此之外,昆侖萬維Skywork-13B此次還配套了“輕量版”大模型,是在消費級顯卡中就能部署和推理的那種!

Skywork-13B下載地址(Model Scope):https://modelscope.cn/organization/skywork

Skywork-13B下載地址(Github):https://github.com/SkyworkAI/Skywork

接下來,我們進一步來看下Skywork-13B系列更多的能力。

無需申請即可商用

Skywork-13B系列大模型擁有130億參數、3.2萬億高質量多語言訓練數據。

由此,模型在生成、創作、數學推理等任務上提升明顯。

首先在中文語言建模困惑度評測中,Skywork-13B系列大模型超越了目前所有中文開源模型。

在科技、金融、政務、企業服務、文創、游戲等領域均表現出色。

另外,Skywork-13B-Math專長數學任務,進行過數學能力強化訓練,在GSM8K等數據集中取得了同等規模模型最佳效果。

與此同時,昆侖萬維還開源了數據集Skypile/Chinese-Web-Text-150B。其數據是通過精心過濾的數據處理流程從中文網頁中篩選而來。

由此,開發者可以最大程度借鑒技術報告中大模型預訓練的過程和經驗,深度定制模型參數,進行針對性訓練與優化 。

除此之外,Skywork-13B還公開了模型使用的評估方法、數據配比研究和訓練基礎設施調優方案等。

而Skywork-13B的一系列開源,無需申請即可商用!

用戶在下載模型并同意遵守《Skywork模型社區許可協議》后,不用再次申請商業授權。

授權流程也取消了對行業、公司規模、用戶數量等方面限制。

昆侖萬維會如此徹底開源其實也并不意外。

昆侖萬維董事長兼CEO方漢是最早參與到開源生態建設的老兵了,也是中文Linux開源最早的推動者之一。

在今年ChatGPT趨勢剛剛興起時,他就多次公開發聲、強調開源的重要性:

代碼開源可助力中國版ChatGPT彎道超車。

所以也就不難理解Skywork-13B系列大模型的推出了。

而在短短2個月后,昆侖萬維又將最新的大模型、最新的數據集,一并發布且開源,可以說它的一切動作不僅在于快,更是在于敢。

那么接下來的問題是——為什么要這么做?

其實,對于AIGC這一板塊,昆侖萬維早在2020年便已經開始涉足,早早的準備和技術積累就是它能夠在大熱潮來臨之際快速跟進的原因之一。

據了解,昆侖萬維目前已形成AI大模型、AI搜索、AI游戲、AI音樂、AI動漫、AI社交六大AI業務矩陣。

至于不遺余力的將開源這事做好做大,一方面是源于企業的基因。

昆侖萬維董事長兼CEO方漢是最早參與到開源生態建設的開源老兵,也是中文Linux開源最早的推動者之一,開源的精神和AIGC技術的發展早已在昆侖萬維戰略中完美融合。

正如方漢此前所言:

昆侖天工之所以選擇開源,因為我們堅信開源是推動AIGC生態發展的土壤和重要力量。昆侖萬維致力于在AIGC模型算法方面的技術創新和開拓,致力于推進開源AIGC算法和模型社區的發展壯大,致力于降低AIGC技術在各行各業的使用和學習門檻。

沒錯,降低門檻,便是其堅持開源的另一大原因。

從昆侖萬維入局百模大戰以來的種種動作中,也很容易看到它正在踐行著讓天工用起來更簡單、更絲滑。

總而言之,昆侖萬維目前已然是處于國產大模型的第一梯隊,甚至說是立于金字塔尖都不足為過。

那么在更大力度的開源加持之下,天工大模型還將有怎樣驚艷的表現,是值得期待一波了。

5. A17 Pro vs 8Gen3,手機旗艦SoC迭代,GPU和NPU成為下一輪發力點

原文:https://mp.weixin.qq.com/s/1snqc5TKjPajcUz4ELIO6w

電子發燒友網報道(文/周凱揚)隨著2023年步入尾聲,無論是蘋果還是高通,都已經推出了新一代的旗艦手機SoC,這也昭示著安卓與iOS陣營手機性能的又一次年末大比。然而,對比過去拼通用計算性能和通用圖形計算性能的局面,今年兩大廠商都已經開始卷向其他的計算負載,比如光追、超分這樣的特殊GPU負載,以及終于被積極調動算力的NPU單元。我們就從CPU,GPU和NPU三個手機SoC主力計算單元來分析蘋果A17 Pro和高通驍龍8Gen3在設計上新一輪迭代。

CPU,單核多核性能各有千秋

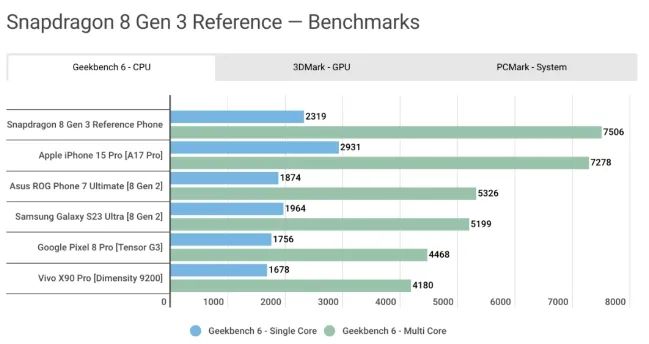

A17 Pro和驍龍8Gen3分別是基于臺積電3nm和4nm工藝打造的芯片,在最先進的半導體工藝下,CPU上的提升尤其引人注目,尤其是蘋果的A17 Pro還是首發3nm的芯片。然而在各路實機測試的表現中,兩者的成績卻是各有勝負。

A17 Pro雖說用上了最先進的3nm工藝,且對微架構進行了一定的改進,最大主頻從A16時期的3.46GHz大幅提升至3.78GHz,但A17 Pro依然保持了6核(2性能核+4能效核)的配置,即便是在蘋果自己給出的性能指標中,相較上一代也只有10%的性能提升。

而高通的驍龍8Gen3 Kyro CPU,通過升級大核為Cortex-X4、升級中核為Cortex-A720、升級小核為Cortex-A520,并將一個額外的能效核轉換成了性能核,從上一代的1:4:3配置,換成了1:5:2配置。正是因為在如此激進的設計改動下,8Gen3的CPU實現了30%的性能提升,20%的能效提升。

然而在Geekbench 6的測試中,我們還是能看到一些有意思的對比。根據androidauthority對iPhone15 Pro和驍龍8Gen3參考機的測試可以看出,在單核性能上,A17 Pro還是領先一大截的,而在多核性能上,驍龍8Gen3終于實現了反超。這不免讓人期待起未來Snapdragon X Elite的CPU架構下放到手機SoC后,高通CPU的單核性能會有怎樣的提升。

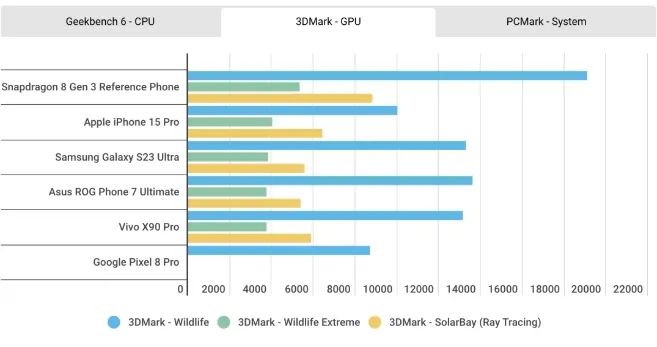

GPU,光追和超分辨率技術

至于GPU性能的對比,結果與上一代似乎并沒有太大不同,在3D Mark的測試中,A17 Pro的GPU全方位落后于驍龍8Gen3。根據蘋果的說法,他們對這一代GPU進行了歷史上最大的一次重新設計,但從這個結果來看,重新設計的方向應該主要放在了硬件光追和超分技術上,其相比前代提升的20%GPU性能還是無法與驍龍8Gen3相提并論。

今年的手機SoC設計中,硬件光追已經成了標配。蘋果稱其GPU加入的硬件光追相較基于軟件的光追,速度提升了4倍,更適合用于沉浸式AR應用和游戲體驗。不過相較從上一代驍龍8Gen2就開始布局硬件光追的高通來說,蘋果在硬件光追上的性能水平還是有所不及。從上面的3DMark光追測試成績可以看出,8Gen3的硬件光追加速性能要高出A17 Pro一大截。

高通在硬件光追的開發上也領先于蘋果,相比去年8Gen2僅有實時光追支持,今年的驍龍8Gen3還加入了對虛幻5引擎Lumen全局光照和反射系統的支持,可以實現比普通硬件光追更好的光線表現效果。

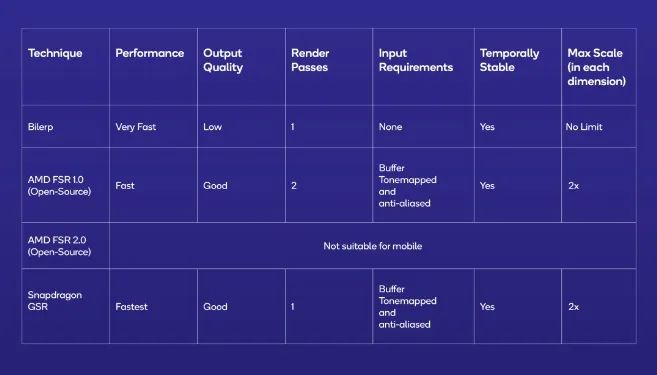

除了硬件光追以外,無論是高通還是蘋果,都在這一代GPU的設計中加入了超分辨率的技術,比如蘋果的MetalFX和高通的Snapdragon Game Super Resolution(GSR)。為了運行性能要求更高的3A游戲大作,僅僅靠堆高GPU性能是遠遠不夠的,受限于智能手機的散熱結構,我們需要英偉達DLSS或AMD的FSR這類超分辨率技術進一步降低配置要求和功耗。

去年的WWDC 2022上,蘋果正式宣布了MetalFX這一超分技術,利用相對較低分辨率的圖像輸出更高的分辨率,從而減少渲染負載,提高應用或游戲體驗。不過屆時該技術主要是為M2系列的處理器開發的,而如今蘋果已經打算將這一技術引入手機GPU。

而高通則在今年推出了GSR這一超分技術,高通宣稱可以提供10bit HDR 144FPS的游戲性能體驗。從上述超分技術對比中可以看出,GSR最高可以實現兩倍的超分。高通還表示,雖然GSR技術兼容大部分GPU,但只有在驍龍硬件平臺上才能發揮出最大性能。

不過在實現方式上,蘋果的MetalFX和高通的GSR還是有一些區別的。高通的GSR是一項單通空域超分辨率技術,與AMD開源的FSR 1.0實現方式一樣。而蘋果的MetalFX,則給到了開發者選擇,既可以采用空域超分辨率技術,也可以使用FSR 2.0一樣的時域抗鋸齒超分辨率技術。

不過,高通選擇這一技術路線不是沒有原因的,首先空域超分更容易達到較好的性能和圖像質量表現,比過去的插值超分在邊緣細節上更有優勢。而時域超分雖說可以實現更好的圖像質量,但其所需的數據輸入在手機圖形的渲染管線卻不常見,只有一部分PC游戲移植到手機上更適合這一方案。

這點從蘋果MetaFX的開發文檔中也可以看出,如果只選擇空域超分的話,開發者只需要輸入像素色彩,而選擇時域超分則需要提供像素色彩、深度和動態信息,這對游戲開發者來說,就需要在渲染管線上花更多的工夫。所以高通的GSR和蘋果MetaFX中的空域超分更容易適配,相信未來即將支持超分的一大批游戲都會選擇這一方案。

NPU,設備端生成式AI

自今年生成式AI成為熱門應用后,手機SoC廠商以及大模型應用開發者們均看到了手機AI計算單元NPU的另一大功用。尤其是在高通驍龍8Gen 3的產品詳情中,高通著重介紹了這一芯片平臺在生成式AI上的優勢。

驍龍8Gen 3的Hexagon NPU相較上一代有了質的提升,性能提升高達98%,能效比提升高達40%。這也是高通首度在NPU中加入支持多模態生成式AI模型的AI引擎,該引擎支持LLM(大語言模型)、LVM(語言視覺模型)和ASR(自動語音識別)模型,端側最大支持100億參數的模型。

在LLM上,以Meta 70億參數的Llama 2模型為例,驍龍8Gen 3支持到20token每秒的表現。同時NPU也進一步提高了Sensing Hub各大傳感器調用用戶數據的能力,比如同時支持兩個始終感應的攝像頭等。

蘋果今年似乎并沒有著重強調A17 Pro的神經引擎,除了35TOPS的計算性能。不過從M2和M3系列的神經引擎配置來看,蘋果或許對于A17 Pro這一智能手機SoC的AI性能有更多的準備。要知道,同為16核的神經引擎,去年的A16和M2芯片其AI算力只有17 TOPS,哪怕是剛公布的M3系列芯片,其AI算力都只有18TOPS。

寫在最后

至此,我們看到了高通和蘋果兩家廠商對于AI計算的重視,只不過兩者的側重點略有不同。比如目前蘋果目前更注重于打造“直覺式AI”,著重加強設備端系統級AI和多媒體AI的表現,比如輸入法自動更正、個人語音、拍照人像模式、第三方app中的圖片降噪/超分等。而高通已經開始擁抱生成式AI,尤其是智能語音助手的AI性能,也給到了第三方AI應用開發者更自由的硬件資源調用。

然而無論是從紙面參數,還是從各大性能測試得出的結果可知,安卓旗艦SoC與蘋果SoC的性能代差已經完全消除了,甚至前者在GPU性能上已經實現了反超。由此也可以看出,半導體工藝提升帶來的性能收益已經在縮小,反而是芯片微架構和核心配置決定了最終的手機SoC性能。

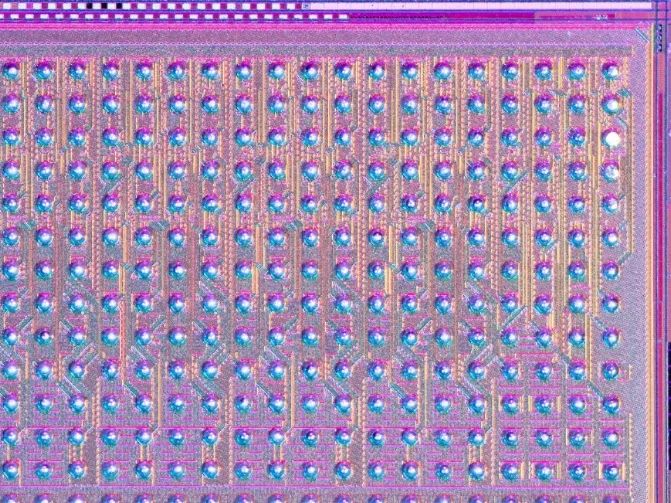

6. IBM最新推出一款類腦芯片“NorthPole” 用于快速高效的人工智能

原文:https://mp.weixin.qq.com/s/nG3otCtN1mwSHKXEw-0vxw

據悉,IBM公司最新推出了一款名為“NorthPole(https://research.ibm.com/blog/northpole-ibm-ai-chip)”的類腦芯片,其運行由人工智能驅動的圖像識別算法的速度是同類商業芯片的22倍,能效是同類芯片的25倍。根據IBM的一項研究顯示,新型硅芯片的應用可能包括自動駕駛汽車和機器人。

以大腦為靈感的計算機硬件旨在模仿人腦以異常節能的方式快速執行計算的非凡能力。這些機器通常用于實現神經網絡,類似地模仿大腦的學習和操作方式。

“NorthPole merges the boundaries between brain-inspired computing and silicon-optimized computing, between compute and memory, between hardware and software.”

—DHARMENDRA MODHA, IBM

受大腦啟發的電子學經常采用的一種策略是復制生物神經元計算和存儲數據的方式。將處理器和內存結合起來,可以大大減少計算機在這些組件之間穿梭數據所損失的能量和時間。

該研究的主要作者、IBM大腦啟發計算的首席科學家Dharmendra Modha說:“大腦比現代計算機節能得多,部分原因是它在每個神經元中都存儲了帶有計算功能的內存。”

Modha說:“NorthPole融合了大腦啟發計算和硅優化計算、計算和內存、硬件和軟件之間的界限。”

新芯片針對2位、4位和8位低精度操作進行了優化。研究人員表示,這足以在許多神經網絡上實現最先進的精度,同時省去訓練所需的數值。該研究原型在25至425兆赫的頻率范圍內工作,每個核心每個周期可以以8位精度執行2048次操作,以2位精度執行8192次操作。

NorthPole是在過去八年中開發的,它建立在IBM最后一款類腦芯片TrueNorth的基礎上。TrueNorth于2014年首次亮相,其功率效率比當時的傳統微處理器低四個數量級。

Modha說:“NorthPole的主要目標是大幅降低TrueNorth的潛在資本成本。”

科學家們用兩個人工智能系統測試了NorthPole —— ResNet 50圖像分類網絡和Yolo-v4物體檢測網絡。與使用類似12納米節點制造的英偉達V100 GPU相比,NorthPole每瓦的能效是后者的25倍,速度是后者的22倍,同時面積只占五分之一。

“Given that analog systems are yet to reach technological maturity, this work presents a near-term option for AI to be deployed close to where it is needed.”

—VWANI ROYCHOWDHURY, UCLA

NorthPole的表現也優于市場上所有其他芯片,即使是使用更先進節點制造的芯片。例如,與使用4nm節點實現的英偉達H100 GPU相比,NorthPole的能效高出五倍。事實證明,NorthPole的速度大約是TrueNorth的4000倍。

加州大學洛杉磯分校的計算和人工智能科學家Vwani Roychowdhury沒有參與這項研究,他說:“這篇論文代表了一場工程之旅。”

新芯片的速度和效率來自于它所有的內存都在芯片上。這意味著每個核心都可以同樣輕松地訪問芯片上的存儲器。

此外,Modha說,從設備外部看,NorthPole是一個有源存儲芯片。這有助于將NorthPole集成到系統中。

Modha說,NorthPole的潛在應用可能包括圖像和視頻分析、語音識別,以及被稱為變壓器的神經網絡,這些網絡是為聊天機器人(如ChatGPT)提供動力的大型語言模型(LLM)的基礎。IBM表示,這些人工智能任務可能會用于自動駕駛汽車、機器人、數字助理和衛星觀測等領域。

一些應用程序要求神經網絡太大,無法安裝在單個NorthPole芯片上。Modha說,在這種情況下,這些網絡可以分解成更小的部分,可以分布在多個NorthPole芯片上。

IBM指出,NorthPole的效率顯示出它不需要龐大的液體冷卻系統來運行——風扇和散熱器就足夠了。這意味著它可以部署在更小的空間。

科學家們注意到,IBM用12納米的節點工藝制造了NorthPole。目前CPU的技術水平是3納米,IBM已經花了數年時間研究2納米節點。該公司表示,這表明,這種類腦策略可能很容易取得進一步的成果。

NorthPole的架構類型通常被稱為內存計算,可以是數字的,也可以是模擬的。在諸如NorthPole之類的數字內存計算系統中,需要許多電路來運行乘法-累加(MAC)運算,這是神經網絡中最基本的計算。相比之下,內存中的模擬計算系統擁有更適合執行這些操作的組件。

內存中的模擬計算比數字計算需要更少的功率和空間。然而,這些模擬系統通常需要新的材料和制造技術,而NorthPole是使用傳統的半導體制造技術制造的。

Roychowdhury表示:“鑒于模擬系統尚未達到技術成熟度,這項工作為人工智能在需要的地方部署提供了一個近期選擇。”

———————End———————

新生態,創未來 | 2023RT-Thread 開發者大會開啟報名

邀請你參加 2023 RT-Thread 開發者大會的六大理由

1、刷新RT-Thread最新技術動態和產業服務能力

2、聆聽行業大咖分享,洞察產業趨勢

3、豐富的技術和產品展示,前沿技術發展和應用

4、絕佳的實踐機會:AIOT、MPU、RISC-V...

5、精美伴手禮人手一份開發板盲盒和免費午餐

6、黑科技滿點~滴水湖地鐵口安排無人車接送至會場

立刻掃碼報名吧

-

RT-Thread

+關注

關注

31文章

1273瀏覽量

39928

原文標題:【AI簡報20231103期】ChatGPT參數揭秘,中文最強開源大模型來了!

文章出處:【微信號:RTThread,微信公眾號:RTThread物聯網操作系統】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

開源與閉源之爭:最新的開源模型到底還落后多少?

Llama 3 與開源AI模型的關系

Meta即將發布超強開源AI模型Llama 3-405B

名單公布!【書籍評測活動NO.34】大語言模型應用指南:以ChatGPT為起點,從入門到精通的AI實踐教程

OpenAI 深夜拋出王炸 “ChatGPT- 4o”, “她” 來了

通義千問推出1100億參數開源模型

Meta推出最強開源模型Llama 3 要挑戰GPT

海信發布電視行業最強中文大模型,開啟電視AI新時代

谷歌發布輕量級開源人工智能模型Gemma

新火種AI|谷歌深夜炸彈!史上最強開源模型Gemma,打響新一輪AI之戰

谷歌發布全球最強開源大模型Gemma

【國產FPGA+OMAPL138開發板體驗】(原創)6.FPGA連接ChatGPT 4

ChatGPT原理 ChatGPT模型訓練 chatgpt注冊流程相關簡介

【AI簡報20231103期】ChatGPT參數揭秘,中文最強開源大模型來了!

【AI簡報20231103期】ChatGPT參數揭秘,中文最強開源大模型來了!

評論