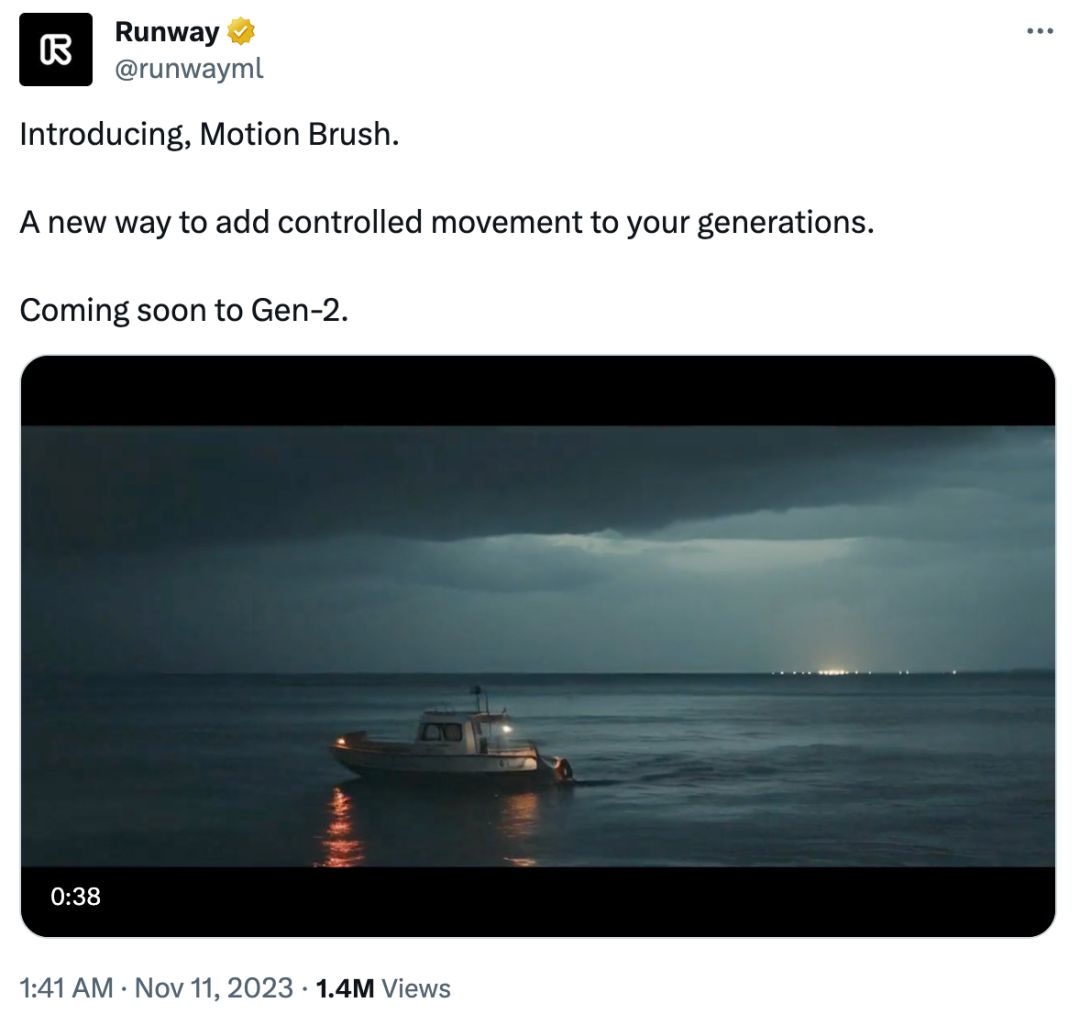

一段五十秒的預告視頻,再次讓 AI 圈沸騰了。

昨日 Runway 宣布,即將在視頻生成工具 Gen-2 中上線「Motion Brush」(運動筆刷)功能,一種可控制生成內容移動的新方法。

這次的玩法,甚至不需要輸入文字,只要有手就夠了。

任選一張圖片,畫筆涂抹到哪里,哪里就立刻動起來:

不管是水流、云彩、火焰、煙霧還是人物,都能高度還原其動態(tài)。這就是傳說中的「點石成金」嗎?

網友看完表示:我都不敢想象一年后的視頻技術會有多先進……

畢竟在 2023 年初,從文本生成視頻還是一件相當困難的事情。

Runway 曾在今年 2 月推出了 Gen-1,功能非常豐富,包括風格化、故事版、蒙版、渲染、自定義等等。看起來,這是一個專注于「編輯」視頻的工具。

但今年 3 月,Gen-2 的面世改變了一切,它新增了文字、圖片生成視頻功能。用戶僅需輸入文字、圖像或文字加圖像的描述,Gen-2 即可在很短的時間內生成相關視頻。

這是市場上第一個公開可用的文本到視頻模型。比如輸入一段純文字「午后的陽光透過紐約閣樓的窗戶照進來」,Gen-2 會直接「腦補」出視頻:

現在,只需幾個 prompt 和手勢,我們就能生成像樣的視頻并進一步編輯,復雜的視頻編輯軟件和冗長的制作流程一去不復返。

如果將文生圖神器 Midjourney 與文生視頻神器 Gen-2 結合起來使用,用戶完全可以不動筆,直出大片。

當然,Gen-2 也是有競爭對手的,就是 Pika Labs,特別是后者還是免費的。

以上畫面由 Pika Labs 生成。

對于這種瘋狂卷的態(tài)勢,一部分用戶是非常期待的:「2024 年,Pika Labs 和 Runway 之間的拉扯一定很有意思。」

傳聞中,OpenAI 也有視頻生成相關的技術。有網友表示:「這讓我不禁好奇,OpenAI 的 any-to-any 模型在生成視頻方面究竟有多出色,因為這家公司通常都走在別人前面。」

未來的視頻和電影制作行業(yè),會因此而顛覆嗎?

-

物聯網

+關注

關注

2904文章

44306瀏覽量

371464

原文標題:Runway新功能「運動筆刷」再次驚艷AI圈:隨手一涂,圖片就動起來了

文章出處:【微信號:tyutcsplab,微信公眾號:智能感知與物聯網技術研究所】歡迎添加關注!文章轉載請注明出處。

發(fā)布評論請先 登錄

相關推薦

首批Apple Intelligence功能驚艷亮相,12月新功能值得期待

是否可以通過I2C在Android 8.1的嵌入式設備上將PCM1864EVM驅動起來?

e絡盟互動社區(qū)發(fā)起“動起來”設計大賽

Anthropic發(fā)布最新AI模型Claude 3.5,引入Artifacts新功能

Runway發(fā)布Gen-3 Alpha:AI視頻領域的新里程碑

Runway發(fā)布Gen-3 Alpha視頻生成模型

亞馬遜云科技推出多項安全服務新功能

百度搜索重磅推出AI圖片助手

STM32FOC電機慣性啟動,電機會卡住一下然后在轉動是什么原因引起的?

讓PMSM簡單的動起來的話,需要調用哪些頭文件?

基于5.3.3庫做的有感FOC控制PMSM電機啟動不了是什么原因導致的?

步進電機如何讓動起來?步進電機轉動原理

Runway新功能「運動筆刷」再次驚艷AI圈:隨手一涂,圖片就動起來了

Runway新功能「運動筆刷」再次驚艷AI圈:隨手一涂,圖片就動起來了

評論