作為本年度人工智能領(lǐng)域最重要的突破之一,大語(yǔ)言模型相關(guān)研究始終是各大相關(guān)領(lǐng)域的關(guān)注焦點(diǎn)。

近日,來(lái)自清華大學(xué)、中國(guó)科學(xué)院、MIT的科研人員對(duì)于大語(yǔ)言模型在人機(jī)交互領(lǐng)域中的應(yīng)用進(jìn)行了研究,設(shè)計(jì)了一種名為Co-Pilot的人機(jī)交互框架,使用提示引導(dǎo)ChatGPT(gpt3.5)在考慮人主觀意圖的同時(shí)完成簡(jiǎn)單的自動(dòng)駕駛任務(wù)。

論文標(biāo)題:

ChatGPT as Your Vehicle Co-Pilot: An Initial Attempt

論文鏈接:

https://www.researchgate.net/publication/374800815_ChatGPT_as_Your_Vehicle_Co-Pilot_An_Initial_Attempt

該研究作為最早一批使用原生語(yǔ)言大模型直接介入自動(dòng)駕駛?cè)蝿?wù)的嘗試,揭示了大語(yǔ)言模型在自動(dòng)駕駛領(lǐng)域進(jìn)一步深入應(yīng)用的可能性,也為后續(xù)相關(guān)研究指明了方向 [1]。

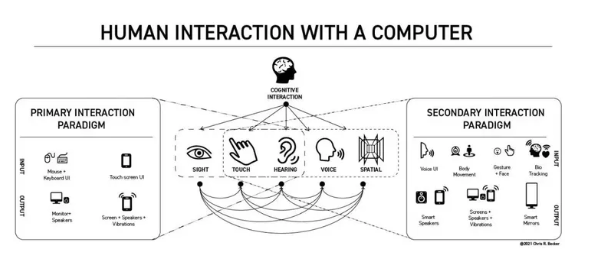

研究背景:為什么使用大語(yǔ)言模型?

人車(chē)交互作為智能汽車(chē)發(fā)展的重要功能之一,對(duì)降低司機(jī)駕駛負(fù)擔(dān)、提升乘客出行體驗(yàn)有很大幫助,相關(guān)功能也成為了消費(fèi)者在選擇時(shí)的重要標(biāo)準(zhǔn)。 盡管現(xiàn)有人機(jī)交互系統(tǒng)已經(jīng)可以實(shí)現(xiàn)語(yǔ)音識(shí)別、指令執(zhí)行等功能,但大多數(shù)情況下系統(tǒng)僅能根據(jù)既定指令的訓(xùn)練在有限范圍內(nèi)給出回答或響應(yīng),存在一定的局限性。 相比之下,大語(yǔ)言模型在此類(lèi)能力上具有更好的表現(xiàn): 1. 可以理解人的意圖:大語(yǔ)言模型具有推理能力,其可以從文字中理解說(shuō)話者的真正意圖,并給出相應(yīng)的回應(yīng); 2. 擁有常識(shí):得益于大量的訓(xùn)練數(shù)據(jù)中包含的知識(shí),大預(yù)言模型具有一定的常識(shí),并掌握許多特定領(lǐng)域的基礎(chǔ)知識(shí)與能力; 3. 對(duì)于不同任務(wù)的高度適應(yīng)性:通過(guò)調(diào)整提示詞,大語(yǔ)言模型對(duì)于不同任務(wù)具有很好的適應(yīng)性,可快速適配不同種類(lèi)的任務(wù),極大提升了應(yīng)用與落地的效率。 基于此,大語(yǔ)言模型為解決人機(jī)共駕問(wèn)題提供了一種新的思路。 為了探索大語(yǔ)言模型在自動(dòng)駕駛?cè)藱C(jī)交互領(lǐng)域的應(yīng)用,研究人員提出了「Co-Pilot」架構(gòu),用于實(shí)現(xiàn)乘客、大語(yǔ)言模型以及車(chē)輛之間的交互。 為了驗(yàn)證方案的可行性,研究人員設(shè)計(jì)了兩個(gè)不同種類(lèi)的任務(wù)對(duì)其進(jìn)行測(cè)試,實(shí)驗(yàn)效果達(dá)到了預(yù)期。

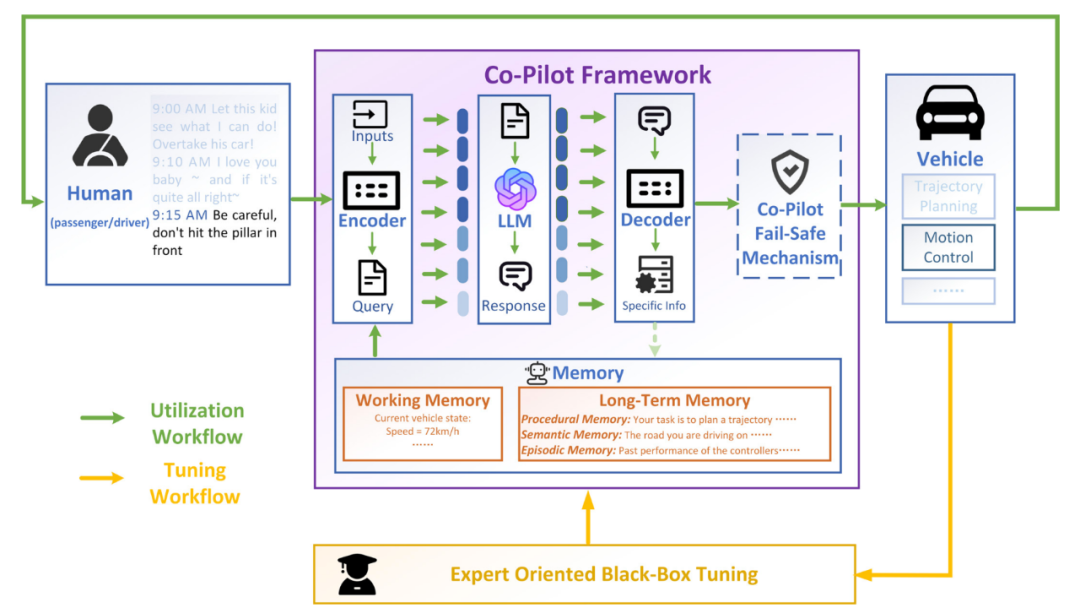

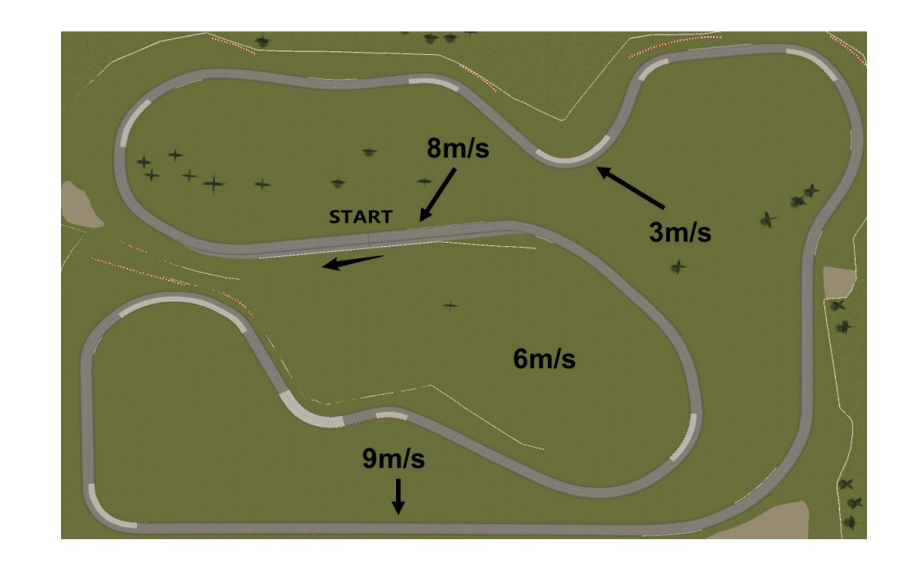

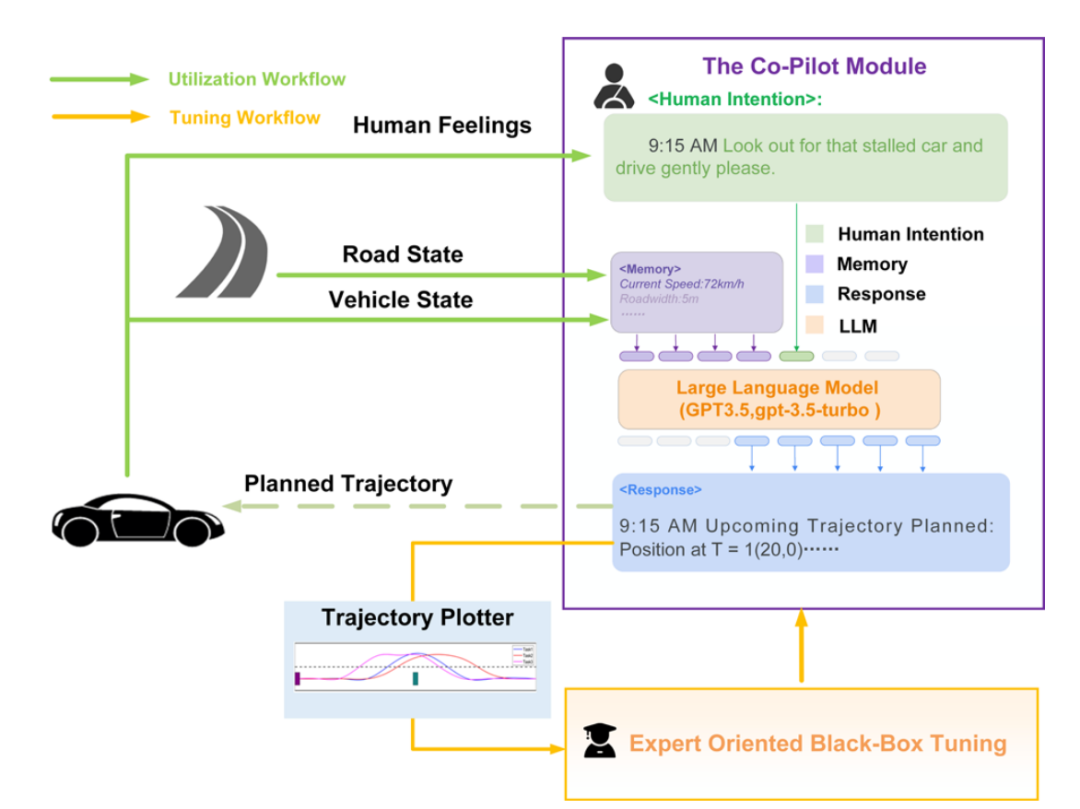

Co-Pilot主體機(jī)構(gòu)包含了以下模塊:

1. 編碼器:將必要的信息組成提示,通過(guò)專用API發(fā)送至大語(yǔ)言模型。

2. LLM:大語(yǔ)言模型,本工作使用ChatGPT(GPT3.5-turbo-0301)。

3. 解碼器:將自然語(yǔ)言回應(yīng)解析為指令或數(shù)據(jù),用于車(chē)輛的交互與控制。

4. 保險(xiǎn)機(jī)制:考慮到大語(yǔ)言模型作為概率模型的本質(zhì),現(xiàn)階段難以杜絕其在回答中出錯(cuò),故預(yù)留該保險(xiǎn)機(jī)制防止存在明顯錯(cuò)誤的指令影響車(chē)輛運(yùn)行。

5. 記憶機(jī)制:保存Co-Pilot完成任務(wù)所必須的數(shù)據(jù)及其他信息,作為輸入的重要組成部分,可在工作過(guò)程中被實(shí)時(shí)更新。Co-Pilot主要擁有兩種工作流程:

1. 實(shí)現(xiàn)流程:Co-pilot依據(jù)不同任務(wù)完成一次工作周期的流程。

2. 調(diào)優(yōu)流程:車(chē)輛專家依據(jù)不同任務(wù)調(diào)整記憶機(jī)制的前置優(yōu)化流程。

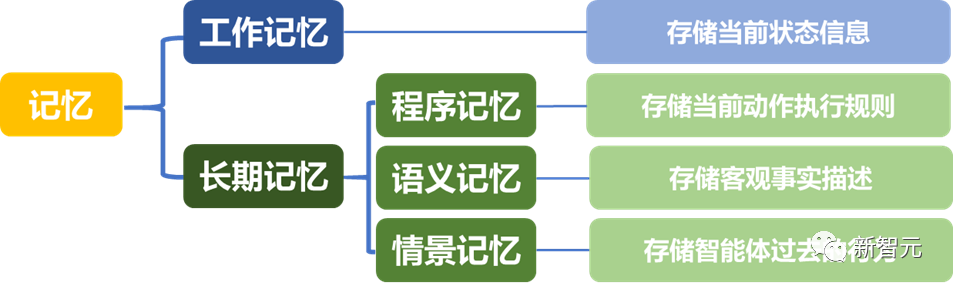

記憶機(jī)制 本文按照人類(lèi)認(rèn)知心理學(xué)對(duì)大語(yǔ)言模型內(nèi)部的知識(shí)儲(chǔ)存進(jìn)行模擬[2],提出了記憶機(jī)制用來(lái)劃分自動(dòng)駕駛場(chǎng)景中可能涉及到的信息,旨在全面提升Co-Pilot信息利用效率。

專家主導(dǎo)的黑箱優(yōu)化 該方法利用黑箱優(yōu)化中在低維空間進(jìn)行無(wú)梯度優(yōu)化的思想,利用專家的主觀標(biāo)注來(lái)評(píng)估任務(wù)完成效果,從而更新記憶中的內(nèi)容來(lái)增強(qiáng)提示詞,使得LLM進(jìn)行少樣本學(xué)習(xí)。

仿真實(shí)驗(yàn)

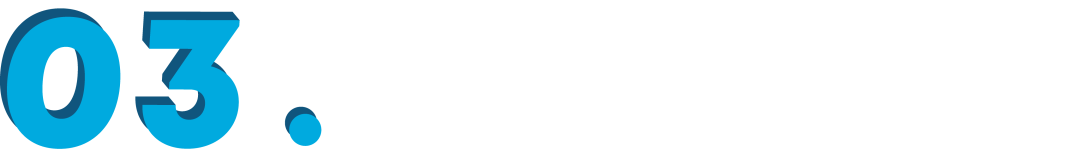

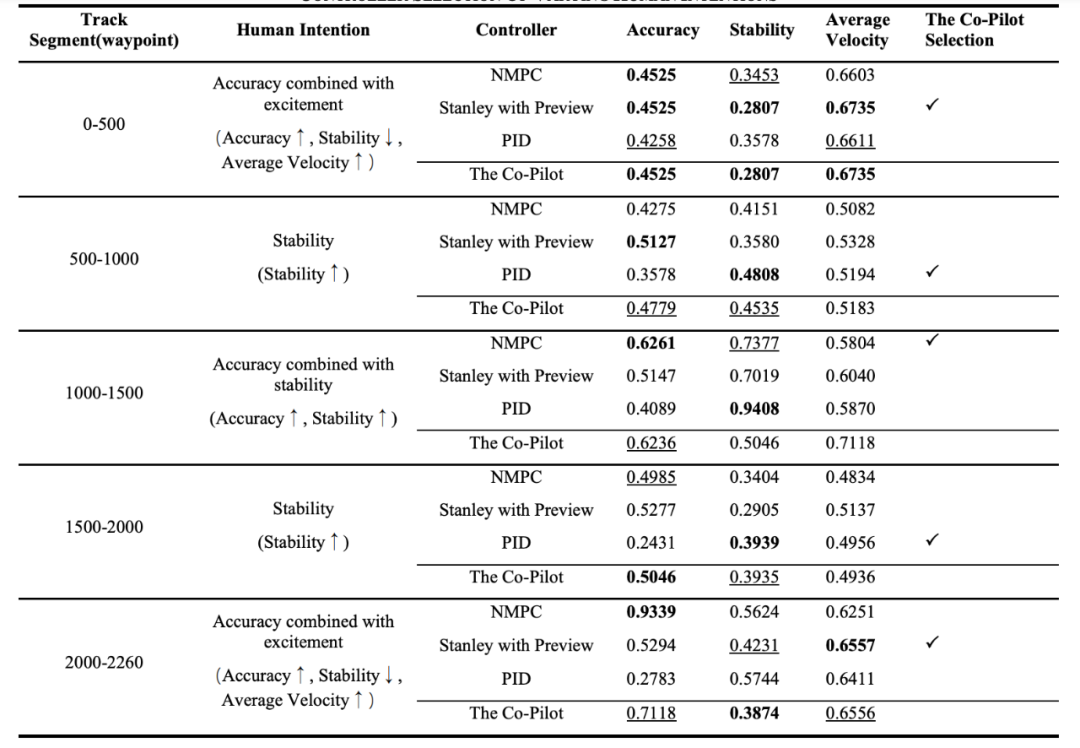

為了驗(yàn)證Co-Pilot架構(gòu)的可靠性,本文設(shè)計(jì)了兩個(gè)任務(wù),在以MATLAB/Simulink為基礎(chǔ)的仿真平臺(tái)中開(kāi)展。 實(shí)驗(yàn)一:軌跡跟隨控制器選擇 在該實(shí)驗(yàn)中,假設(shè)有一輛自動(dòng)控制的汽車(chē)在預(yù)設(shè)路徑上行駛,研究人員給定Co-Pilot當(dāng)前車(chē)輛狀態(tài)、路段情況等信息,要求其選擇最符合當(dāng)前乘客意圖(如保證速度、緊隨軌跡、體驗(yàn)舒適)的運(yùn)動(dòng)控制器。 運(yùn)動(dòng)控制器為已有預(yù)設(shè)模塊,分別為NMPC控制器、Stanley + Preview控制器、PID控制器。 ▲賽道總覽

▲賽道總覽

▲實(shí)驗(yàn)一的Co-Pilot具體結(jié)構(gòu)

在調(diào)優(yōu)環(huán)節(jié)中,研究人員分別對(duì)語(yǔ)義記憶與情景記憶進(jìn)行了更新,其中語(yǔ)義記憶僅能提供對(duì)控制器的種類(lèi)(A1)或定性描述(A2),而情景記憶可以提供對(duì)控制器在過(guò)去相似場(chǎng)景下的具體表現(xiàn)(A3)。 賽道被分為五個(gè)區(qū)段,研究人員根據(jù)Co-Pilot是否在各區(qū)段選出了最符合當(dāng)前乘客意圖的控制器進(jìn)行打分(每個(gè)區(qū)段最優(yōu)1分,次優(yōu)0.5分,最差0分,賽道總分最高為5分),分析不同記憶對(duì)于Co-Pilot表現(xiàn)的影響,研究人員在「精確跟蹤」與「保持穩(wěn)定」兩種意圖下分別測(cè)試,測(cè)試結(jié)果顯示,A1僅取得3分,Co-Pilot在所有區(qū)段均選擇了NMPC控制器。 由于此時(shí)提供的信息有限,其只能根據(jù)訓(xùn)練中積攢的常識(shí)「NMPC的控制效果很好」做出判斷。A2取得了7.5分,而A3取得了8.5分,證明情景記憶在相似任務(wù)中對(duì)Co-Pilot的推理最有幫助,使其可結(jié)合人類(lèi)意圖給出合理的反應(yīng)。 接著,研究人員使用了調(diào)優(yōu)后的A3提示模式開(kāi)展了更復(fù)雜的實(shí)驗(yàn)。在此實(shí)驗(yàn)中,五個(gè)區(qū)段的人類(lèi)意圖不再保持一致且引入了更口語(yǔ)化表達(dá)的新意圖「刺激」。 實(shí)驗(yàn)結(jié)果如下圖所示,Co-Pilot在每個(gè)區(qū)段都能選出最符合乘客意圖的控制器(由于控制器在切換時(shí)受到上一區(qū)段的車(chē)輛狀態(tài)影響,導(dǎo)致被選控制器的效果與預(yù)期可能存在細(xì)微差異)。

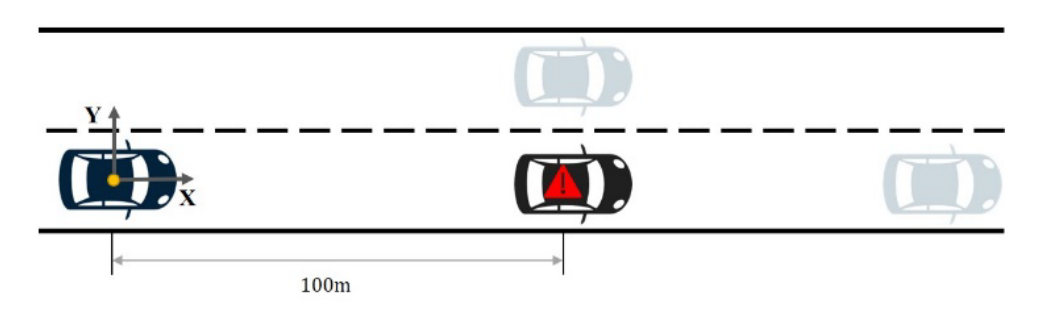

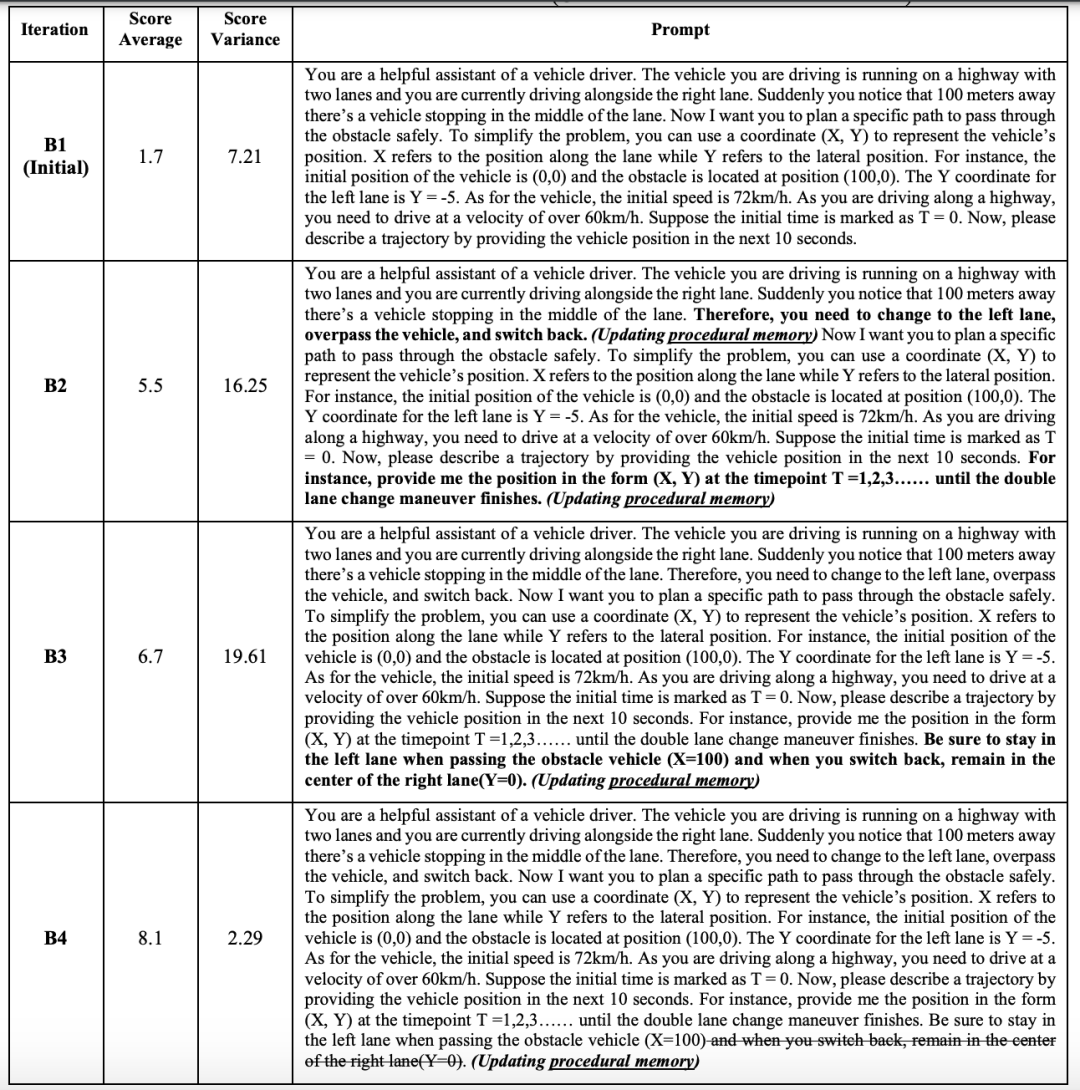

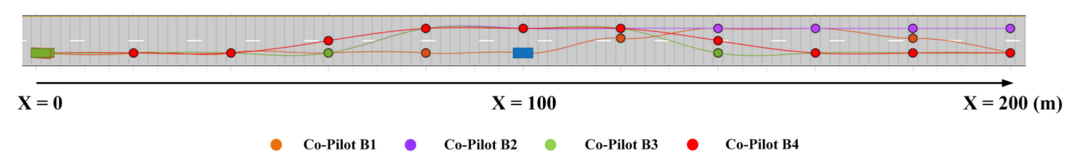

實(shí)驗(yàn)二:雙移線避障軌跡規(guī)劃 在本實(shí)驗(yàn)中,研究人員將重點(diǎn)轉(zhuǎn)移到規(guī)劃類(lèi)任務(wù),向Co-Pilot描述當(dāng)前路況,并要求其給出未來(lái)10s內(nèi)的路徑。

在調(diào)優(yōu)環(huán)節(jié)中,研究人員更加側(cè)重對(duì)于程序記憶的組織與優(yōu)化,語(yǔ)義記憶與情景記憶中包含的信息基本不存在差異。在此的前提下,不同提示帶來(lái)的顯著結(jié)果差異更加值得深入探究。

▲四種提示的區(qū)別以及十次測(cè)試的平均得分情況(打分依據(jù):合理性滿分5分、完成度滿分3分、正確性滿分2分)

▲四種提示下的代表軌跡

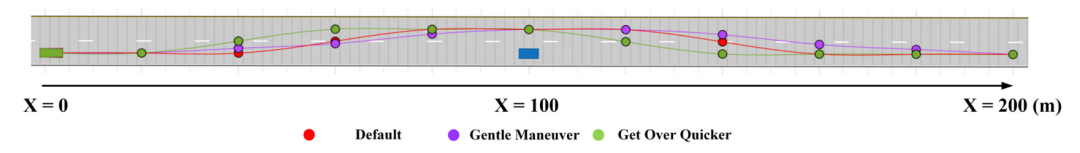

在使用B4提示的前提下,進(jìn)一步引入不同種類(lèi)的乘客意圖,得到的代表性軌跡如下,可以看出在給出正確避讓軌跡的基礎(chǔ)上,Co-Pilot可以進(jìn)一步調(diào)整軌跡使其符合乘客意圖。

▲四種提示下的代表軌跡

在使用B4提示的前提下,進(jìn)一步引入不同種類(lèi)的乘客意圖,得到的代表性軌跡如下,可以看出在給出正確避讓軌跡的基礎(chǔ)上,Co-Pilot可以進(jìn)一步調(diào)整軌跡使其符合乘客意圖。

▲不同乘客意圖的代表軌跡,均符合乘客意圖

未來(lái)展望與挑戰(zhàn)

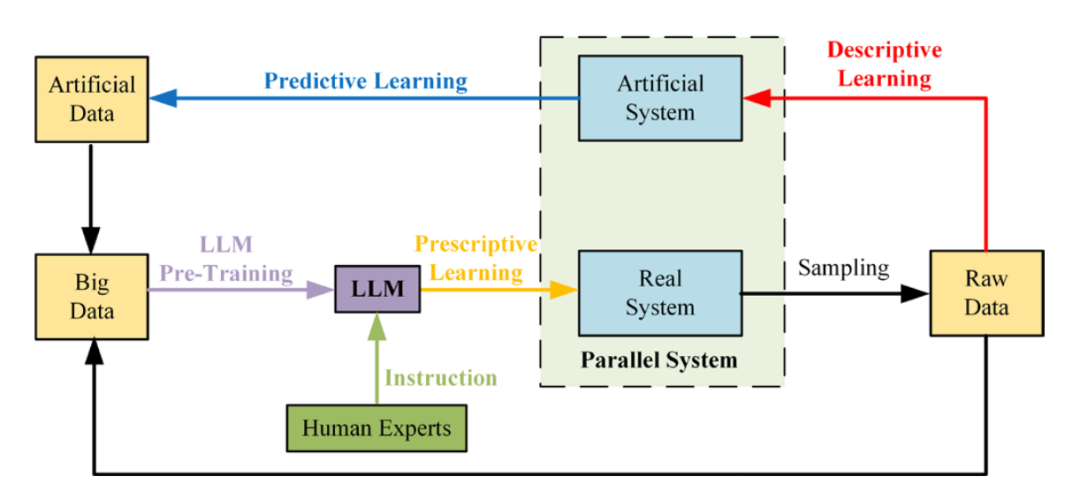

Co-Pilot是一種創(chuàng)新的嘗試,它將LLM應(yīng)用于人機(jī)混合智能[3]。LLM大大提高了人機(jī)通信的效率,使人類(lèi)和機(jī)器更好地理解彼此。

人類(lèi)專家對(duì)Co-Pilot進(jìn)行調(diào)優(yōu)的過(guò)程可以被視為系統(tǒng)的自適應(yīng)學(xué)習(xí)。這使得深入的人機(jī)合作成為可能,并且在測(cè)試和調(diào)整人工智能系統(tǒng)方面具有巨大潛力。

未來(lái)展望與挑戰(zhàn)

Co-Pilot是一種創(chuàng)新的嘗試,它將LLM應(yīng)用于人機(jī)混合智能[3]。LLM大大提高了人機(jī)通信的效率,使人類(lèi)和機(jī)器更好地理解彼此。

人類(lèi)專家對(duì)Co-Pilot進(jìn)行調(diào)優(yōu)的過(guò)程可以被視為系統(tǒng)的自適應(yīng)學(xué)習(xí)。這使得深入的人機(jī)合作成為可能,并且在測(cè)試和調(diào)整人工智能系統(tǒng)方面具有巨大潛力。

▲LLM與現(xiàn)有平行學(xué)習(xí)架構(gòu)[4]相結(jié)合,可進(jìn)一步提升機(jī)器學(xué)習(xí)的效率

另一方面,正如本文實(shí)驗(yàn)中展示的,大語(yǔ)言模型通過(guò)海量數(shù)據(jù)訓(xùn)練得到的常識(shí)能在其工作中發(fā)揮重要作用。 后續(xù)在此基礎(chǔ)上,多模態(tài)混合大模型(如視覺(jué)+語(yǔ)言模態(tài))能夠進(jìn)一步打通「感知-規(guī)劃-執(zhí)行」的流程,使得此類(lèi)大模型可勝任自動(dòng)駕駛、機(jī)器人等需要與現(xiàn)實(shí)世界交互的復(fù)雜任務(wù)[5]。 當(dāng)然,研究過(guò)程中涌現(xiàn)出的許多潛在挑戰(zhàn)也值得關(guān)注:例如,怎樣進(jìn)一步提升LLM的性能?如何保證LLM表現(xiàn)得一致性、穩(wěn)定性?在面對(duì)更復(fù)雜的動(dòng)態(tài)場(chǎng)景時(shí),如何保證LLM正確完成任務(wù)? 總結(jié)

本工作提出了一種將大語(yǔ)言模型直接用于人機(jī)共駕任務(wù)的Co-Pilot架構(gòu),并設(shè)計(jì)對(duì)應(yīng)實(shí)驗(yàn)初步證明了架構(gòu)的可靠性以及大語(yǔ)言模型在自動(dòng)駕駛類(lèi)任務(wù)中的可適用性,討論了相關(guān)領(lǐng)域研究的潛在機(jī)遇及挑戰(zhàn)。

該項(xiàng)工作已于近日發(fā)表于IEEE Transactions on Intelligent Vehicles,來(lái)自清華大學(xué)深圳國(guó)際研究生院的王詩(shī)漪以及來(lái)自清華大學(xué)自動(dòng)化系的朱宇軒為本文共同第一作者,通訊作者為清華大學(xué)自動(dòng)化系李力教授。其他合著者為清華大學(xué)李志恒副教授,中科院自動(dòng)化研究所王雨桐助理研究員,以及麻省理工學(xué)院賀正冰高級(jí)研究員。

總結(jié)

本工作提出了一種將大語(yǔ)言模型直接用于人機(jī)共駕任務(wù)的Co-Pilot架構(gòu),并設(shè)計(jì)對(duì)應(yīng)實(shí)驗(yàn)初步證明了架構(gòu)的可靠性以及大語(yǔ)言模型在自動(dòng)駕駛類(lèi)任務(wù)中的可適用性,討論了相關(guān)領(lǐng)域研究的潛在機(jī)遇及挑戰(zhàn)。

該項(xiàng)工作已于近日發(fā)表于IEEE Transactions on Intelligent Vehicles,來(lái)自清華大學(xué)深圳國(guó)際研究生院的王詩(shī)漪以及來(lái)自清華大學(xué)自動(dòng)化系的朱宇軒為本文共同第一作者,通訊作者為清華大學(xué)自動(dòng)化系李力教授。其他合著者為清華大學(xué)李志恒副教授,中科院自動(dòng)化研究所王雨桐助理研究員,以及麻省理工學(xué)院賀正冰高級(jí)研究員。

參考文獻(xiàn)

原文標(biāo)題:把ChatGPT塞進(jìn)副駕駛!清華、中科院、MIT聯(lián)合提出Co-Pilot人機(jī)交互框架

文章出處:【微信公眾號(hào):智能感知與物聯(lián)網(wǎng)技術(shù)研究所】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

-

物聯(lián)網(wǎng)

+關(guān)注

關(guān)注

2903文章

44275瀏覽量

371273

原文標(biāo)題:把ChatGPT塞進(jìn)副駕駛!清華、中科院、MIT聯(lián)合提出Co-Pilot人機(jī)交互框架

文章出處:【微信號(hào):tyutcsplab,微信公眾號(hào):智能感知與物聯(lián)網(wǎng)技術(shù)研究所】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

新的人機(jī)交互入口?大模型加持、AI眼鏡賽道開(kāi)啟百鏡大戰(zhàn)

具身智能對(duì)人機(jī)交互的影響

字節(jié)跳動(dòng)與清華AIR成立聯(lián)合研究中心

聚徽-工控一體機(jī)是如何實(shí)現(xiàn)人機(jī)交互的

基于傳感器的人機(jī)交互技術(shù)

人機(jī)界面交互方式的介紹

人機(jī)交互界面是什么_人機(jī)交互界面的功能

工業(yè)平板電腦在人機(jī)交互中的應(yīng)用

人機(jī)交互與人機(jī)界面的區(qū)別與聯(lián)系

芯海科技“壓容二合一SoC”系列芯片打造極致人機(jī)交互體驗(yàn)

人機(jī)交互的三個(gè)階段 人機(jī)交互的常用方式

人機(jī)交互系統(tǒng)的發(fā)展史及過(guò)程步驟

龍芯中科與中科信息簽訂合作框架協(xié)議

人機(jī)交互技術(shù)有哪幾種 人機(jī)交互技術(shù)的發(fā)展趨勢(shì)

基于人機(jī)交互界面的石墨烯傳感器研究進(jìn)展

把ChatGPT塞進(jìn)副駕駛!清華、中科院、MIT聯(lián)合提出Co-Pilot人機(jī)交互框架

把ChatGPT塞進(jìn)副駕駛!清華、中科院、MIT聯(lián)合提出Co-Pilot人機(jī)交互框架

評(píng)論