大模型等 AI 技術(shù),正在像水、電等基礎(chǔ)設(shè)施能力一樣,在醫(yī)療機(jī)構(gòu)的未來(lái)醫(yī)療服務(wù)體系中具有無(wú)可替代的價(jià)值。為幫助醫(yī)療機(jī)構(gòu)應(yīng)對(duì)在大模型私有化部署中面臨的成本高、落地難等難題,我們與英特爾展開(kāi)合作,在第四代英特爾 至強(qiáng) 可擴(kuò)展處理器的基礎(chǔ)上,以 BigDL-LLM 庫(kù)和 OpenVINO 工具套件作為推理優(yōu)化方案的左右手,雙管齊下,打造高質(zhì)量、低成本的醫(yī)療 AI 應(yīng)用并獲得了預(yù)期推廣成果。

王實(shí)

CTO

"

人工智能 (Artificial Intelligence,AI) 在醫(yī)療領(lǐng)域的落地,正為醫(yī)療行業(yè)的信息化、數(shù)字化進(jìn)程帶來(lái)新一輪質(zhì)變,它可以通過(guò)優(yōu)化診療效率,改善患者體驗(yàn),提升全民健康服務(wù)水平。近年來(lái)引人矚目的大語(yǔ)言模型 (Large Language Model,LLM,以下簡(jiǎn)稱(chēng)“大模型”) 技術(shù),以其更強(qiáng)的學(xué)習(xí)性能和更優(yōu)的模型擬合效果,更是為 AI 在醫(yī)療領(lǐng)域中的應(yīng)用注入了新動(dòng)力。

領(lǐng)先的醫(yī)療人工智能解決方案提供商北京惠每云科技有限公司 (以下簡(jiǎn)稱(chēng)“惠每科技”) 以其臨床決策支持系統(tǒng) (Clinical Decision Support System,CDSS) 產(chǎn)品和海量醫(yī)療數(shù)據(jù)為基礎(chǔ),積極引入大模型技術(shù)來(lái)為醫(yī)療機(jī)構(gòu)打造更高品質(zhì)的醫(yī)療 AI 應(yīng)用。但這并非易事,醫(yī)療機(jī)構(gòu)對(duì)數(shù)據(jù)安全的顧慮,以及昂貴的 AI 專(zhuān)用芯片部署和應(yīng)用成本是阻礙這一進(jìn)程的兩大“攔路虎”。

為幫助醫(yī)療機(jī)構(gòu)在其廣泛應(yīng)用的 IT 平臺(tái)上實(shí)現(xiàn)高質(zhì)量、低成本的大模型私有化部署,惠每科技與英特爾展開(kāi)技術(shù)合作,對(duì)醫(yī)療大模型在英特爾 至強(qiáng) 平臺(tái)上的推理性能實(shí)施優(yōu)化。雙方在以第四代英特爾 至強(qiáng) 可擴(kuò)展處理器為核心的硬件基礎(chǔ)設(shè)施上,采用 BigDL-LLM 大模型開(kāi)源庫(kù)與 OpenVINO 工具套件打造了兩種大模型優(yōu)化方案。實(shí)際部署后的測(cè)試結(jié)果表明:在保證精準(zhǔn)度以及不增加成本的前提下,優(yōu)化后的方案可有效提升鑒別診斷、出院記錄等醫(yī)療 AI 應(yīng)用的處理效率,并獲得了醫(yī)生的認(rèn)可。

大模型技術(shù)正成為醫(yī)療 AI 發(fā)展新動(dòng)力

得益于強(qiáng)勁算力與海量數(shù)據(jù)的加持,高速發(fā)展的大模型技術(shù)正以一系列極具震撼力的應(yīng)用場(chǎng)景,成為 AI 領(lǐng)域令人矚目的焦點(diǎn)。與傳統(tǒng) AI 技術(shù)相比,參數(shù)規(guī)模龐大 (動(dòng)輒數(shù)百乃至上千億參數(shù)量級(jí)) 的大模型不僅具備更強(qiáng)的學(xué)習(xí)性能和更優(yōu)的模型擬合效果,還擁有高效的遷移學(xué)習(xí)能力,這能讓用戶(hù)在一個(gè)通用模型上完成不同類(lèi)型的任務(wù)。此外,對(duì)思維鏈 (Chain of Thought,CoT) 的良好支持,也使大模型應(yīng)用補(bǔ)齊了傳統(tǒng) AI 在邏輯推理能力上的短板。

上述優(yōu)勢(shì)不僅讓大模型技術(shù)與應(yīng)用成為了各大科技巨頭爭(zhēng)先探索的藍(lán)海,也推動(dòng)了其在社交、金融、電商以及醫(yī)療等垂直領(lǐng)域的迅速落地,并顯現(xiàn)出巨大的市場(chǎng)潛力。有相關(guān)預(yù)測(cè)數(shù)據(jù)表明,大模型市場(chǎng)在未來(lái)數(shù)年都將保持 21.4% 的年復(fù)合增長(zhǎng)率 (Compound Annual Growth Rate, CAGR),到 2029 年或達(dá) 408 億美元的市場(chǎng)規(guī)模1。

在醫(yī)療行業(yè),無(wú)論是面向大眾提供普惠醫(yī)療服務(wù)的智能問(wèn)答與家庭醫(yī)療助手,還是有助于醫(yī)護(hù)人員提升效率的 AI 導(dǎo)診和臨床輔助診療應(yīng)用,或是加速醫(yī)療影像處理效能,提高大病、惡疾早期發(fā)現(xiàn)率的 AI 閱片等,眾多醫(yī)療 AI 企業(yè)正在借助大模型來(lái)提升這些應(yīng)用的性能,幫助醫(yī)療機(jī)構(gòu)在診療服務(wù)全流程中實(shí)現(xiàn)更全面且優(yōu)質(zhì)的服務(wù)能力、更精準(zhǔn)的結(jié)果輸出以及更廣泛的運(yùn)用范圍。而其中,深耕醫(yī)療信息化多年,具有出色醫(yī)療 AI 應(yīng)用研發(fā)能力和頭部?jī)?yōu)勢(shì)的惠每科技,也在這一趨勢(shì)中將大模型作為其技術(shù)再突破、服務(wù)再提升的重要抓手。

一直以來(lái),惠每科技的 CDSS 產(chǎn)品 (如醫(yī)院端核心應(yīng)用 Dr.Mayson、臨床科研平臺(tái) Darwin 等),都是通過(guò)實(shí)時(shí)數(shù)據(jù)分析與事中智能提示等核心能力的打造,助力醫(yī)療機(jī)構(gòu)在臨床診療決策、病案與病歷管理、診療風(fēng)險(xiǎn)預(yù)警以及醫(yī)保費(fèi)用管理等環(huán)節(jié)中提升服務(wù)質(zhì)量、診療效率和管理效能。

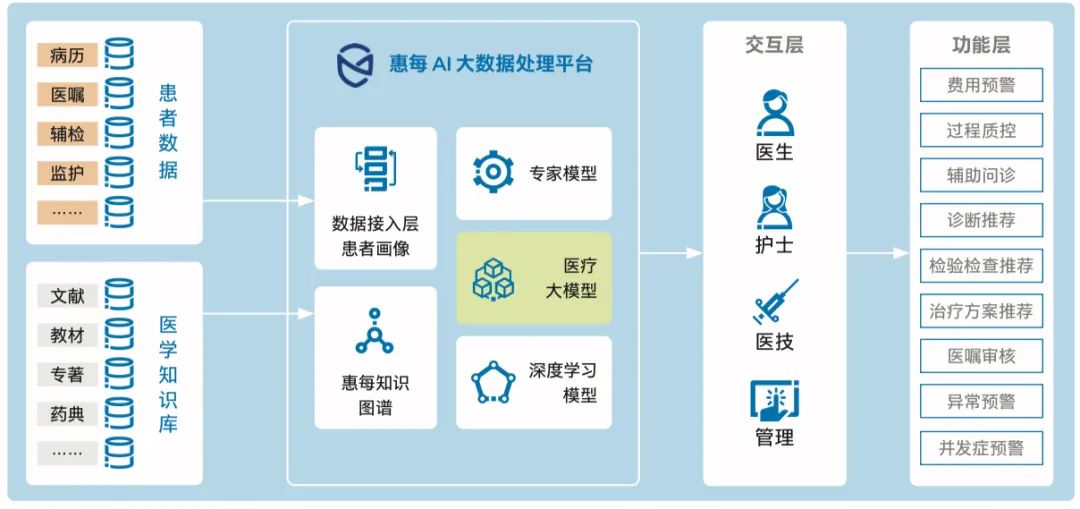

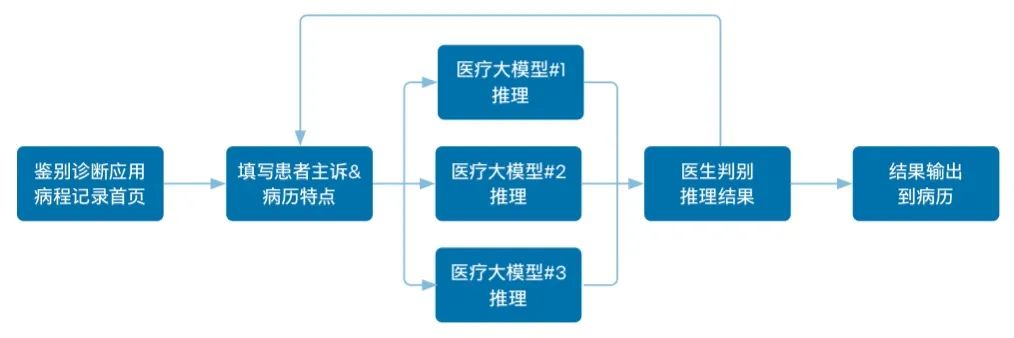

而這些場(chǎng)景對(duì)自然語(yǔ)言處理 (Natural Language Processing, NLP)、計(jì)算機(jī)視覺(jué) (Computer Vision, CV) 等 AI 能力的需求,正好讓大模型有了用武之地。如圖 1 所示,在惠每科技最新發(fā)布的 CDSS 3.0 架構(gòu)中,新一代 AI 大數(shù)據(jù)處理平臺(tái)已集成了醫(yī)療大模型。這些醫(yī)療大模型是通過(guò)海量數(shù)據(jù)在一系列大模型上重新訓(xùn)練而成的,不僅融合了惠每科技在醫(yī)學(xué)知識(shí)庫(kù)、專(zhuān)家系統(tǒng)上的雄厚知識(shí)積累,也凝集了其落地于 600 余家醫(yī)療機(jī)構(gòu)所獲得的豐富實(shí)戰(zhàn)經(jīng)驗(yàn),已在病歷生成等場(chǎng)景中獲得了成功運(yùn)用。

圖 1 集成大模型的惠每新一代 AI 大數(shù)據(jù)處理平臺(tái)架構(gòu)

推動(dòng)高質(zhì)量、低成本的私有化部署,是醫(yī)療大模型落地的主要挑戰(zhàn)

然而在推進(jìn)醫(yī)療大模型落地的過(guò)程中,惠每科技面臨著嚴(yán)峻挑戰(zhàn),其中主要的是如何幫助醫(yī)療機(jī)構(gòu)實(shí)現(xiàn)高質(zhì)量、低成本的私有化部署:

降低建設(shè)成本:傳統(tǒng)上的大模型訓(xùn)練和推理工作通常需要借助專(zhuān)用加速芯片來(lái)完成,但這類(lèi)芯片昂貴的價(jià)格往往讓醫(yī)療機(jī)構(gòu)望而卻步,同時(shí)其普遍缺貨或供貨周期較長(zhǎng)的問(wèn)題也會(huì)大幅拉長(zhǎng)方案的建設(shè)周期。 保障數(shù)據(jù)安全:行業(yè)的特殊性使醫(yī)療機(jī)構(gòu)對(duì)數(shù)據(jù)安全、隱私保護(hù)極為重視,任何醫(yī)療數(shù)據(jù)都不能離開(kāi)安全可控的內(nèi)網(wǎng)環(huán)境,所以醫(yī)療大模型需要進(jìn)行私有化部署。

這些因素都阻礙著醫(yī)療大模型在醫(yī)療機(jī)構(gòu)的落地與普及。

為應(yīng)對(duì)這一挑戰(zhàn),惠每科技攜手英特爾,采用 BigDL-LLM 大模型開(kāi)源庫(kù)和 OpenVINO 工具套件,在基于第四代英特爾 至強(qiáng) 可擴(kuò)展處理器的基礎(chǔ)設(shè)施上打造了大模型推理加速方案。

基于 BigDL-LLM,打造醫(yī)療大模型量化優(yōu)化方案

數(shù)百上千億計(jì)的參數(shù)規(guī)模在給醫(yī)療大模型帶來(lái)更優(yōu)學(xué)習(xí)效果、更精準(zhǔn)輔助診療結(jié)果的同時(shí),也對(duì)承載平臺(tái)的資源,包括算力、內(nèi)存等提出了更嚴(yán)苛的要求。這不僅會(huì)影響 AI 應(yīng)用的最終運(yùn)行效率,影響醫(yī)護(hù)、患者、管理者以及科研人員的使用體驗(yàn),更會(huì)限制更大參數(shù)規(guī)模、更優(yōu)性能的大模型在醫(yī)療機(jī)構(gòu)的普及。模型量化則是應(yīng)對(duì)這一問(wèn)題的重要優(yōu)化手段之一。

對(duì) AI 模型的量化,是指將訓(xùn)練好的模型的權(quán)值、激活值等從高精度數(shù)據(jù)格式 (如 FP32 等) 轉(zhuǎn)化為低精度數(shù)據(jù)格式 (如 INT4 /INT8 等),這不僅可以降低推理過(guò)程中對(duì)內(nèi)存等資源的需求,從而讓平臺(tái)可以容納更大參數(shù)規(guī)模的大模型,也能大幅 提升推理速度,使醫(yī)療 AI 應(yīng)用的運(yùn)行更為迅捷。在惠每科技與英特爾的合作中,雙方基于第四代英特爾 至強(qiáng) 可擴(kuò)展處理器內(nèi)置的指令集,借助由英特爾開(kāi)發(fā)和開(kāi)源的 BigDL-LLM 大模型庫(kù)來(lái)實(shí)現(xiàn)推理加速量化方案。

BigDL-LLM 是一個(gè)為英特爾架構(gòu) XPU 打造的輕量級(jí)大語(yǔ)言模型加速庫(kù),在英特爾架構(gòu)平臺(tái)上具有廣泛的模型支持,能實(shí)現(xiàn)更低的時(shí)延和更小的內(nèi)存占用。作為英特爾開(kāi)源 AI 框架 BigDL 的一部分,BigDL-LLM 不僅提供了對(duì)各種低精度數(shù)據(jù)格式的支持和優(yōu)化,還可基于不同處理器內(nèi)置指令集 (如英特爾AVX - 512_VNNI、英特爾AMX 等) 及相配套的軟件實(shí)施推理加速,使大模型在英特爾架構(gòu)平臺(tái)上實(shí)現(xiàn)更高的推理效率。在本次合作中,惠每科技就使用英特爾AVX - 512_VNNI 指令集顯著加速了其醫(yī)療大模型在 INT4 低精度數(shù)據(jù)格式上的推理。

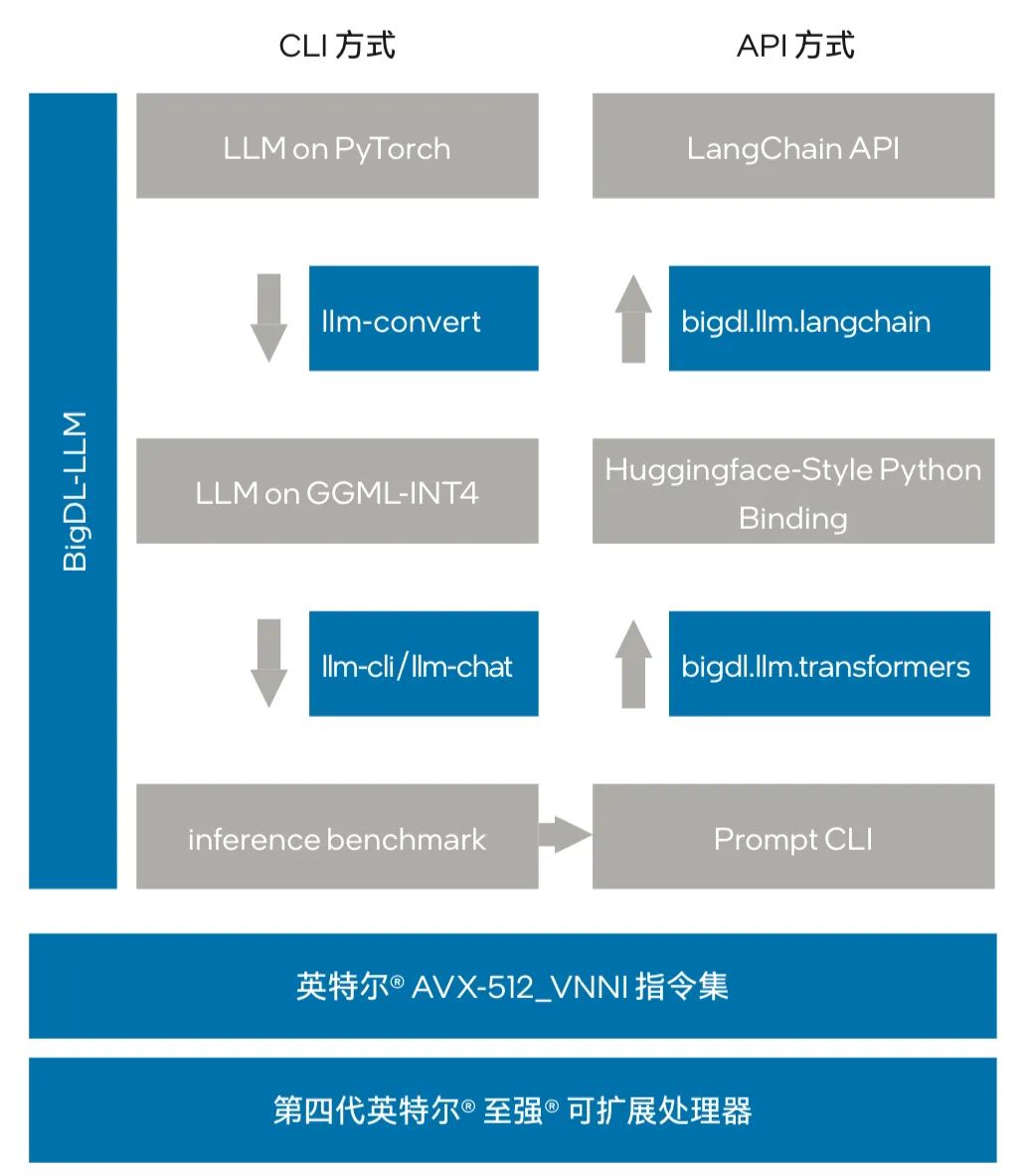

如圖 2 所示,方案中 BigDL-LLM 為醫(yī)療大模型提供了兩種使用方法:便捷命令 (Command Line Interface, CLI) 方法和編程接口 (Application Programming Interface, API) 方法。通過(guò) CLI 方法,惠每科技可方便地完成模型量化并評(píng)估量化后的推理效果,由此判斷該量化方案是否適用于當(dāng)前這個(gè)模型。這些 CLI 命令包括使用 llm-convert 來(lái)對(duì)模型的量化精度快速轉(zhuǎn)換用于預(yù)覽,或者使用 llm-cli/llm-chat 來(lái)運(yùn)行并快速測(cè)試量化后的模型。

圖 2 BigDL-LLM 為醫(yī)療大模型提供推理加速

另一方面,借助 BigDL-LLM 所提供的面向 HuggingFace 和 LangChain 的 API 編程接口,惠每科技能夠快速地將 LLM 量化方案整合進(jìn) HuggingFace 或 LangChain 的項(xiàng)目代碼,進(jìn)而便捷地完成模型部署。作為熱門(mén)的 Transformers 開(kāi)源庫(kù)之一,HuggingFace 上的 Transformers 模型一直是各類(lèi)大模型的重要組成部分,而導(dǎo)入 BigDL-LLM 的優(yōu)勢(shì)在于能讓惠每科技等用戶(hù)只需修改少許代碼 (更改 import,并在 from_ pretrained 參數(shù)中設(shè)置 load_in_4bit=True) 即可快速加載模型。在使用 bigdl.llm.transformers 后,BigDL-LLM 會(huì)在模型加載過(guò)程中對(duì)模型進(jìn)行 INT4 的低精度量化,由此實(shí)現(xiàn)對(duì)基于 HuggingFace Transformers 的模型進(jìn)行加速。

與此同時(shí),LangChain 也是近年來(lái)大模型領(lǐng)域流行的開(kāi)源框架之一,包括惠每科技在內(nèi)的許多用戶(hù)都在使用 LangChain 來(lái)開(kāi)發(fā)不同的大模型應(yīng)用。BigDL-LLM 同樣也通過(guò) API 編程接口 bigdl.llm.langchain 提供了便于使用的 LangChain 集成能力,讓開(kāi)發(fā)者能輕松借助 BigDL-LLM 來(lái)開(kāi)發(fā)新模型或遷移基于 HuggingFace Transformers 優(yōu)化的 INT4 模型,或是其它原生 INT4 模型。

基于 OpenVINO 工具套件,構(gòu)建醫(yī)療大模型非量化優(yōu)化方案

在量化優(yōu)化方案之外,英特爾還借助 OpenVINO 工具套件為惠每科技打造了非量化優(yōu)化方案。作為一款面向 AI 推理及部署優(yōu)化的軟件工具套件,OpenVINO 自推出以來(lái),在幫助 AI 開(kāi)發(fā)者和最終用戶(hù)縮短開(kāi)發(fā)、部署時(shí)間,以及充分釋放豐富的英特爾 硬件性能優(yōu)勢(shì)方面,始終發(fā)揮著重要作用。在最新的 OpenVINO 2023.11 版本中,其通過(guò)一系列新功能的加入,實(shí)現(xiàn)了面向大模型的功能增強(qiáng)。

在幫助惠每科技使用 OpenVINO 工具套件的 Pipeline 構(gòu)建醫(yī)療大模型的高效推理服務(wù)部署之余,英特爾還借助該工具套件來(lái)助力優(yōu)化模型推理流水線,通過(guò)消減模型輸入和輸出之間的內(nèi)存副本來(lái)降低資源消耗,提升推理效率,并通過(guò)執(zhí)行圖的重新設(shè)計(jì)來(lái)優(yōu)化模型中的組件。

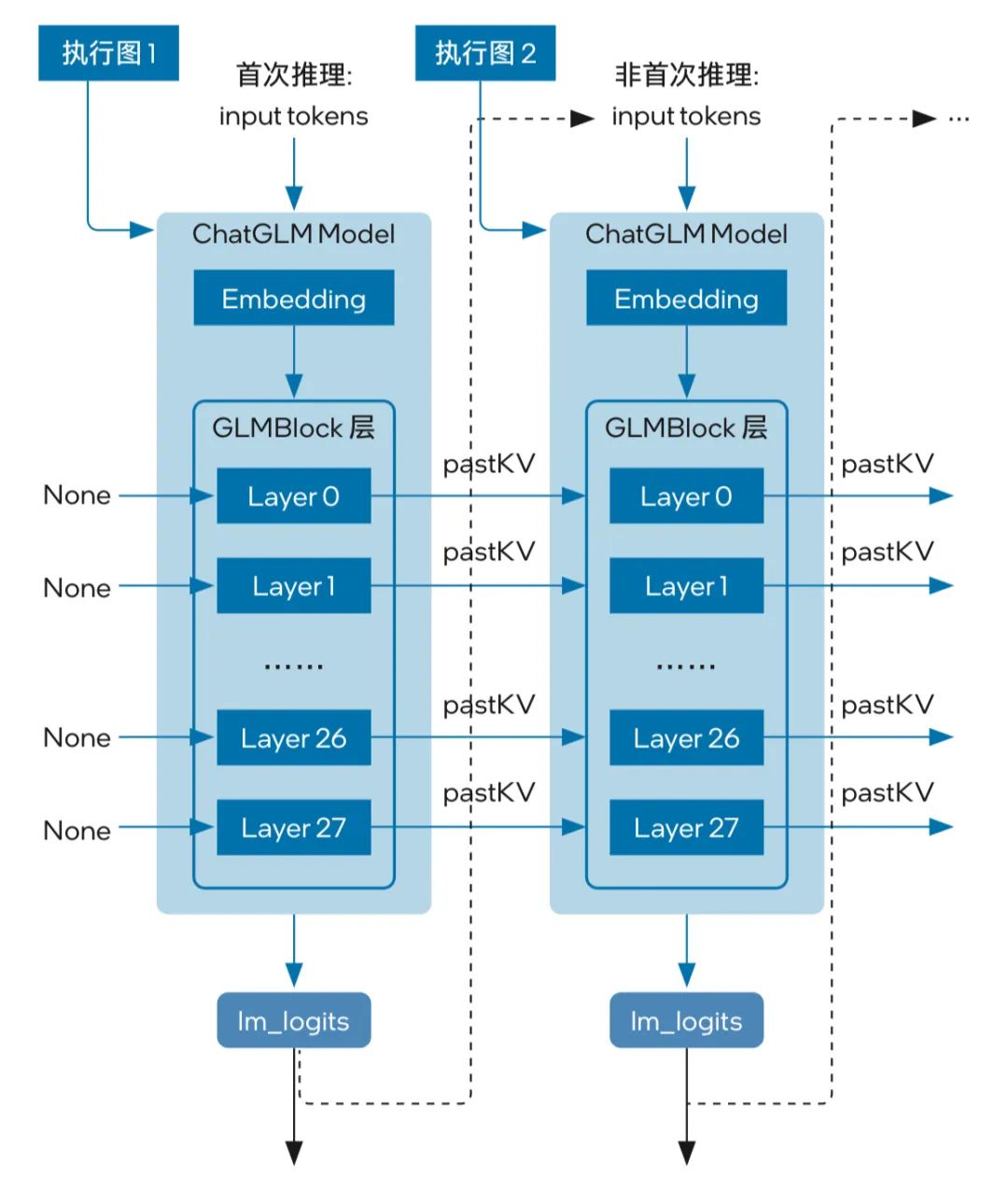

以惠每科技使用的大模型 ChatGLM6b 為例,該模型的結(jié)構(gòu)如圖 3 所示,其流水線回路主要包含 3 個(gè)主要模塊,即 Embedding、GLMBlock 層和 lm_logits。模型的流水線中有兩類(lèi)不同的執(zhí)行圖,首次推理時(shí)不需要 KV 緩存作為 GLMBlock 層的輸入;從第二次迭代開(kāi)始,QKV 注意力機(jī)制的上一次結(jié)果 (pastKV) 將成為當(dāng)前一輪模型推理的輸入。

圖 3 ChatGLM 的模型結(jié)構(gòu)

可以看到,隨著所生成 tokens 長(zhǎng)度不斷增加,在流水線推理過(guò)程中,模型輸入和輸出之間將存留海量的大型內(nèi)存副本 (內(nèi)存拷貝開(kāi)銷(xiāo)由模型的參數(shù) hidden_size 以及迭代的次數(shù)決定),不僅將占據(jù)大量的內(nèi)存空間,龐大的內(nèi)存拷貝開(kāi)銷(xiāo)也會(huì)使推理的執(zhí)行效率遭遇挑戰(zhàn)。

為應(yīng)對(duì)上述挑戰(zhàn),基于 OpenVINO 工具套件的非量化優(yōu)化方案執(zhí)行了三個(gè)方面的優(yōu)化。

優(yōu)化一

利用零拷貝 (Zero-Copy) 視圖來(lái)傳遞預(yù)分配的 KV 所需的內(nèi)存副本空間。由于傳統(tǒng)的內(nèi)存拷貝需要耗費(fèi)大量的處理器資源和內(nèi)存帶寬,因此當(dāng)內(nèi)存副本規(guī)模大幅增加時(shí),會(huì)成為大模型推理效率的瓶頸。而零拷貝技術(shù)的引入,能避免數(shù)據(jù)的多次拷貝,有效實(shí)現(xiàn) KV 緩存加速。

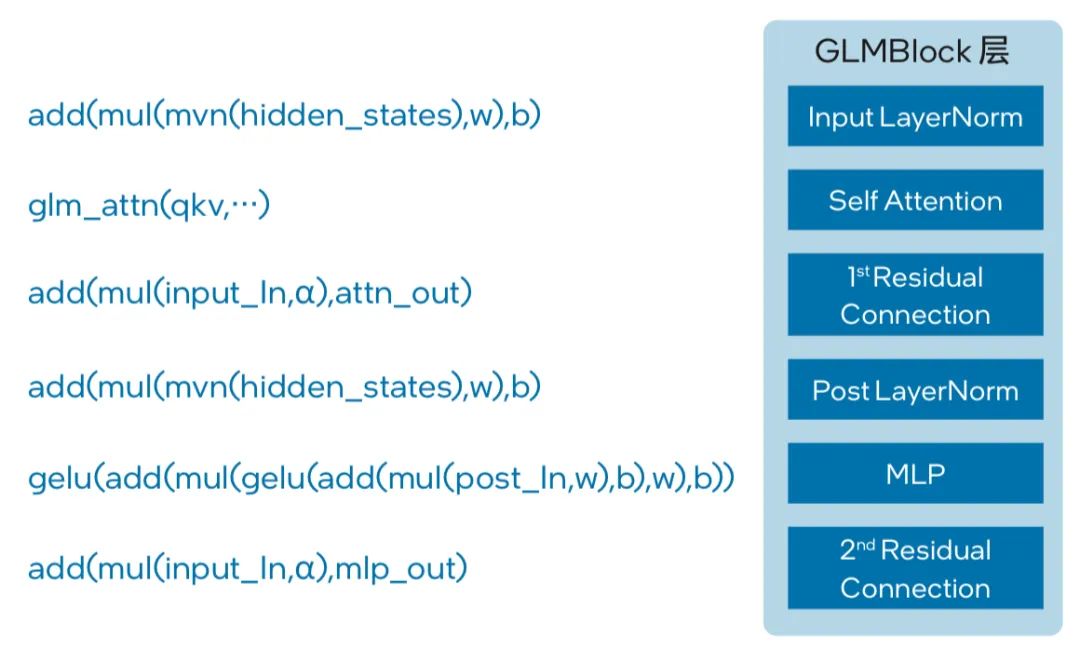

優(yōu)化二使用 OpenVINO opset 來(lái)重構(gòu) ChatGLM 的模型架構(gòu),從而幫助模型中的節(jié)點(diǎn)利用英特爾 AMX 指令集內(nèi)聯(lián)和多頭注意力 (Multi-Head Attention, MHA) 融合來(lái)實(shí)現(xiàn)推理優(yōu)化。如圖 4 所示,優(yōu)化方案構(gòu)建的 OpenVINO stateful 模型在 GLMBlock 層重新封裝了一個(gè)類(lèi),并按圖中工作流來(lái)調(diào)用 OpenVINO opset,然后再將圖形數(shù)據(jù)序列化為中間表示 (Intermediate Representation, IR) 模型 (如 .xml、.bin)。

圖 4 構(gòu)建 OpenVINO stateful 模型

該優(yōu)化方案一方面構(gòu)建了全局的上下文結(jié)構(gòu)體,用于在模型內(nèi)部追加并保存每一輪迭代后的 pastKV 結(jié)果,減少相應(yīng)的內(nèi)存拷貝開(kāi)銷(xiāo)。另一方面,則通過(guò)采用內(nèi)聯(lián)優(yōu)化 (Intrinsic Optimization) 的方式,實(shí)現(xiàn)了 Rotary Embedding 和 MHA 融合。

第四代英特爾 至強(qiáng) 可擴(kuò)展處理器內(nèi)置英特爾 AMX 指令集的引入,也能幫助 ChatGLM 等醫(yī)療大模型提升 BF16 或 INT8 精度數(shù)據(jù)格式下的模型推理速度。英特爾 AMX 指令集提供的內(nèi)聯(lián)指令能更快速地處理 BF16 或 INT8 精度數(shù)據(jù)格式的矩陣乘加運(yùn)算,實(shí)現(xiàn)對(duì) ChatGLM 模型中 Attention 和 Rotary Embedding 等算子的融合,從而在保證精度的同時(shí)提高運(yùn)算效率、加速推理。

優(yōu)化三引入 OpenVINO 工具套件在 HuggingFace 上的 Optimum 接口。Optimum 是 Huggingface Transformers 庫(kù)提供的一個(gè)擴(kuò)展包,可用來(lái)提升模型在特定硬件基礎(chǔ)設(shè)施上的訓(xùn)練和推理性能。基于 OpenVINO 工具套件提供的 Optimum 接口,惠每科技能在提高性能之余,將模型更便捷地?cái)U(kuò)展到更多醫(yī)療大模型推理應(yīng)用中去。

這種優(yōu)化方法在其它任務(wù),包括 token-classification、question-answering、audio-classification 以及 image-classification 等中也同樣適用。

效果評(píng)估

通過(guò)惠每科技與英特爾的協(xié)同優(yōu)化,基于惠每科技醫(yī)療大模型構(gòu)建的醫(yī)療 AI 應(yīng)用無(wú)論是在應(yīng)用效率還是在準(zhǔn)確性等方面都獲得了提升,并很快表現(xiàn)出了顯著的臨床應(yīng)用優(yōu)勢(shì)與價(jià)值,包括:

提升醫(yī)療輔助診療準(zhǔn)確性:通過(guò)對(duì)大量醫(yī)療數(shù)據(jù)的有效學(xué)習(xí), 醫(yī)療大模型能持續(xù)學(xué)習(xí)各種疾病特征,并借助優(yōu)化方案更快、 更精準(zhǔn)地做出判斷。結(jié)合惠每科技醫(yī)療知識(shí)庫(kù),為醫(yī)護(hù)人員提供更加科學(xué)和準(zhǔn)確的輔助診療方案和建議,優(yōu)化診療決策; 提升醫(yī)護(hù)與管理人員效率:借助基于醫(yī)療大模型構(gòu)建的各類(lèi)醫(yī)療 AI 應(yīng)用,醫(yī)護(hù)人員可以更高效地獲取患者的輔助診療結(jié)果和病情 / 病歷分析,從而能將更多時(shí)間和精力專(zhuān)注于患者的治療和康復(fù)。同時(shí)醫(yī)療機(jī)構(gòu)管理人員也能在診療風(fēng)險(xiǎn)預(yù)警、醫(yī)保費(fèi)用管理等環(huán)節(jié)上實(shí)現(xiàn)更為直觀和高效的管控。

為評(píng)估優(yōu)化后的醫(yī)療大模型的實(shí)用效果,惠每科技參加了由中國(guó)健康信息處理大會(huì) (China Health Information Processing Conference, CHIP) 組織的中文臨床醫(yī)療信息處理權(quán)威評(píng)測(cè)。這一評(píng)測(cè)全部使用中文真實(shí)醫(yī)療數(shù)據(jù),覆蓋諸如醫(yī)療術(shù)語(yǔ)識(shí)別和醫(yī)療知識(shí)問(wèn)答等多個(gè)常見(jiàn)醫(yī)療 AI 應(yīng)用場(chǎng)景,并采用量化的 F1 值進(jìn)行排名。同時(shí)在大模型評(píng)測(cè)中,必須使用一個(gè)大模型同時(shí)完成 16 個(gè)任務(wù)的考驗(yàn),非常具有挑戰(zhàn)性。最終惠每科技從 396 支參賽隊(duì)伍中脫穎而出,榮獲“CHIP2023 -PromptCBLUE 醫(yī)療大模型評(píng)測(cè)”參數(shù)高效微調(diào)賽道第一名。2

圖 5 基于惠每科技醫(yī)療大模型構(gòu)建的鑒別診斷應(yīng)用工作流程

目前,基于優(yōu)化后的惠每科技醫(yī)療大模型所構(gòu)建的醫(yī)療 AI 產(chǎn)品與應(yīng)用,已在多個(gè)合作醫(yī)療機(jī)構(gòu)中得到了部署與運(yùn)行,并取得了不錯(cuò)的效果。首先,以基于大模型的鑒別診斷應(yīng)用為例,這一輔助診療應(yīng)用能體現(xiàn)臨床醫(yī)生的診斷思維鏈,而非簡(jiǎn)單的記錄。如圖 5 所示,醫(yī)生在應(yīng)用中打開(kāi)病程記錄首頁(yè)并填寫(xiě)患者主訴及病歷特點(diǎn)后,后臺(tái)的 3 個(gè)不同醫(yī)療大模型就會(huì)迅速執(zhí)行推理,在數(shù)秒后即可生成鑒別診斷。醫(yī)生可以點(diǎn)擊查看不同大模型生成的結(jié)果,再根據(jù)自身的專(zhuān)業(yè)意見(jiàn)選擇最優(yōu)結(jié)果,選擇【一鍵回填】或復(fù)制粘貼到病歷相應(yīng)的位置。

在此過(guò)程中,醫(yī)生可對(duì)病歷生成的結(jié)果進(jìn)行【點(diǎn)贊】/【點(diǎn)踩】,也可在系統(tǒng)中反饋錯(cuò)誤或問(wèn)題,或返回病程記錄頁(yè)繼續(xù)修改患者主訴或病歷特點(diǎn),之后再次通過(guò)醫(yī)療大模型進(jìn)行計(jì)算和執(zhí)行新的鑒別診斷推理。這些設(shè)計(jì)能有效收集醫(yī)生反饋,實(shí)現(xiàn)大模型的增強(qiáng)學(xué)習(xí)。

其次,出院記錄的自動(dòng)生成是在合作醫(yī)療機(jī)構(gòu)落地的另一項(xiàng)重要應(yīng)用。傳統(tǒng)上,諸如出院記錄一類(lèi)的流程,需要醫(yī)院多個(gè)部門(mén)對(duì)多類(lèi)數(shù)據(jù)進(jìn)行總結(jié)并形成摘要,過(guò)程繁瑣且容易出現(xiàn)差錯(cuò)。借助醫(yī)療大模型的技術(shù)優(yōu)勢(shì),醫(yī)生打開(kāi)或保存【出院記錄】時(shí),會(huì)立即觸發(fā)大模型后臺(tái)計(jì)算。在數(shù)秒內(nèi)得到結(jié)果后,醫(yī)生即可查看包含出院診斷、入院情況、診療經(jīng)過(guò)、出院情況和出院醫(yī)囑等內(nèi)容的結(jié)果。醫(yī)生可【一鍵回填】或復(fù)制粘貼到病歷相應(yīng)的位置,并對(duì)病歷生成的結(jié)果進(jìn)行【點(diǎn)贊】/【點(diǎn)踩】,也可點(diǎn)【識(shí)別錯(cuò)誤】反饋相應(yīng)問(wèn)題。

上述基于醫(yī)療大模型的應(yīng)用,都能與惠每科技 CDSS 系統(tǒng)實(shí)現(xiàn)無(wú)縫銜接,并可部署到既有的英特爾 架構(gòu)處理器平臺(tái)。這讓醫(yī)療機(jī)構(gòu)無(wú)需購(gòu)置專(zhuān)用的加速芯片或加速服務(wù)器,從而有效降低大模型部署的成本壓力。來(lái)自惠每科技的數(shù)據(jù)統(tǒng)計(jì)表明, 在某合作醫(yī)院的某科室上線 1 個(gè)月后,鑒別診斷應(yīng)用的使用率已達(dá) 23% 以上,出院記錄自動(dòng)生成應(yīng)用的使用率達(dá)到 15% 以上,說(shuō)明基于醫(yī)療大模型構(gòu)建的 AI 應(yīng)用能力已獲得醫(yī)生的初步認(rèn)可。3

展望

隨著 AI、大數(shù)據(jù)等新技術(shù)、新能力在醫(yī)療領(lǐng)域贏得越來(lái)越多的實(shí)用化落地,更多醫(yī)療機(jī)構(gòu)也正通過(guò)這些前沿 IT 技術(shù)的引入來(lái)加速智慧醫(yī)療的進(jìn)程,而惠每科技開(kāi)展醫(yī)療大模型技術(shù)探索并基于此推出一系列醫(yī)療 AI 應(yīng)用,正是這一進(jìn)程的最新注腳。這些醫(yī)療 AI 應(yīng)用將與惠每科技優(yōu)勢(shì)的 CDSS 產(chǎn)品一起,助力數(shù)以百計(jì)的醫(yī)療機(jī)構(gòu)用戶(hù)進(jìn)一步提升醫(yī)療服務(wù)質(zhì)量。

在此過(guò)程中,惠每科技與英特爾攜手面向基于英特爾架構(gòu)處理器 (第四代英特爾至強(qiáng)可擴(kuò)展處理器的優(yōu)化) 的平臺(tái)展開(kāi)了一系列大模型優(yōu)化。無(wú)論是量化優(yōu)化,還是非量化優(yōu)化方案,都能在保證精度的前提下有效提升醫(yī)療大模型的推理速度,同時(shí)基于英特爾架構(gòu)處理器的部署方案也能幫助醫(yī)療機(jī)構(gòu)有效地節(jié)約成本。面向未來(lái),惠每科技還將與英特爾一起,共同對(duì)大模型技術(shù)在醫(yī)療領(lǐng)域中更廣泛和更深入的應(yīng)用開(kāi)展 更多探索,例如利用大模型開(kāi)展病歷內(nèi)涵質(zhì)控等,進(jìn)而推動(dòng)醫(yī)療全流程的 AI 技術(shù)加持或智能化,讓智慧醫(yī)療惠及更多醫(yī)與患,從而普惠大眾。

參考資料:

1 數(shù)據(jù)援引自 Marketwatch 相關(guān)報(bào)告:https://www.marketwatch.com/press-release/large-language-model-llm-market-size-to-grow-usd-40-8-billion-by-2029-at-a-cagr-of-21-4-valuates-reports-7bbc5419

2 數(shù)據(jù)援引自天池官網(wǎng):https://tianchi.aliyun.com/competition/entrance/532132/rankingList。

3 數(shù)字援引自惠每科技數(shù)字醫(yī)學(xué)云講壇第141期,詳細(xì)信息請(qǐng)?jiān)L問(wèn):https://www.e-chinc.com/#/ResourcesDetailVideo?id=1704682818727731202&packId=1614869950189219841

實(shí)際性能受使用情況、配置和其他因素的差異影響。更多信息請(qǐng)見(jiàn)www.Intel.com/PerformanceIndex。

性能測(cè)試結(jié)果基于配置信息中顯示的日期進(jìn)行測(cè)試,且可能并未反映所有公開(kāi)可用的安全更新。詳情請(qǐng)參閱配置信息披露。沒(méi)有任何產(chǎn)品或組件是絕對(duì)安全的。

具體成本和結(jié)果可能不同。

英特爾技術(shù)可能需要啟用硬件、軟件或激活服務(wù)。

英特爾未做出任何明示和默示的保證,包括但不限于,關(guān)于適銷(xiāo)性、適合特定目的及不侵權(quán)的默示保證,以及在履約過(guò)程、交易過(guò)程或貿(mào)易慣例中引起的任何保證。

英特爾并不控制或?qū)徲?jì)第三方數(shù)據(jù)。請(qǐng)您審查該內(nèi)容,咨詢(xún)其他來(lái)源,并確認(rèn)提及數(shù)據(jù)是否準(zhǔn)確。

-

英特爾

+關(guān)注

關(guān)注

60文章

9888瀏覽量

171533 -

cpu

+關(guān)注

關(guān)注

68文章

10826瀏覽量

211160

原文標(biāo)題:英特爾助惠每醫(yī)療大模型方案在至強(qiáng)? 平臺(tái)上實(shí)現(xiàn)雙維優(yōu)化

文章出處:【微信號(hào):英特爾中國(guó),微信公眾號(hào):英特爾中國(guó)】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

英特爾助力百度智能云千帆大模型平臺(tái)加速LLM推理

使用PyTorch在英特爾獨(dú)立顯卡上訓(xùn)練模型

英特爾至強(qiáng)品牌新戰(zhàn)略發(fā)布

英特爾發(fā)布至強(qiáng)6處理器產(chǎn)品

開(kāi)箱即用,AISBench測(cè)試展示英特爾至強(qiáng)處理器的卓越推理性能

采用144核,能效提升66%!英特爾至強(qiáng)6處理器震撼上市,加速數(shù)據(jù)中心升級(jí)

英特爾首款至強(qiáng)6處理器上市

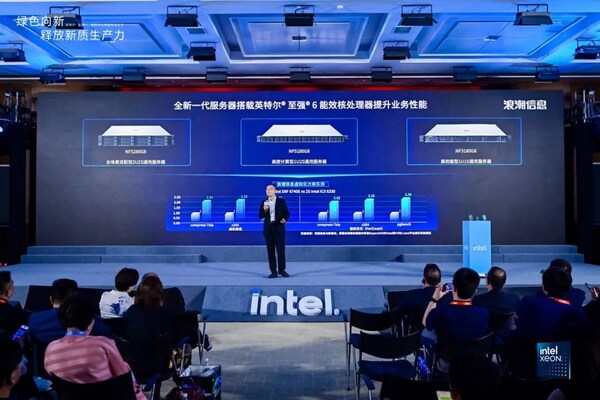

浪潮信息元腦?服務(wù)器率先支持英特爾?至強(qiáng)?6處理器

已有超過(guò)500款A(yù)I模型在英特爾酷睿Ultra處理器上得以優(yōu)化運(yùn)行

英特爾酷睿Ultra處理器突破500個(gè)AI模型優(yōu)化

基于英特爾?至強(qiáng)?CPU Max系列的金證K-GPT產(chǎn)品方案推動(dòng)投行技術(shù)創(chuàng)新

英特爾至強(qiáng)處理器優(yōu)化升級(jí),助力打造未來(lái)高能效數(shù)據(jù)中心

寶德服務(wù)器全面升級(jí)到第五代英特爾?至強(qiáng)?平臺(tái)

AI 無(wú)處不在,英特爾酷睿Ultra 和第五代英特爾至強(qiáng)可擴(kuò)展處理器正式發(fā)布

英特爾助惠每醫(yī)療大模型方案在至強(qiáng)? 平臺(tái)上實(shí)現(xiàn)雙維優(yōu)化

英特爾助惠每醫(yī)療大模型方案在至強(qiáng)? 平臺(tái)上實(shí)現(xiàn)雙維優(yōu)化

評(píng)論