本文主要介紹了一個名為CoderEval的代碼生成大模型評估基準(zhǔn),并對三個代碼生成模型(CodeGen、PanGu-Coder和ChatGPT)在該基準(zhǔn)上的表現(xiàn)進(jìn)行了評估和比較。研究人員從真實的開源項目中的選取了代碼生成任務(wù)來構(gòu)建CoderEval,并根據(jù)對外部依賴的程度為標(biāo)準(zhǔn)將這些任務(wù)分為6個等級、根據(jù)生成的目標(biāo)分為3類生成任務(wù),以更多維地評估不同大模型在不同上下文場景中的生成效果。

實驗結(jié)果表明,這三個模型在生成自包含函數(shù)方面的效果明顯優(yōu)于其他任務(wù),但實際項目中的函數(shù)大部分依賴不同程度的上下文信息,因此提高模型對上下文信息的考慮和利用能力對于代碼生成技術(shù)的實際可用性非常重要。該工作由北京大學(xué)和華為云Paas技術(shù)創(chuàng)新LAB合作完成,論文已經(jīng)被軟件工程頂會ICSE 2024錄用。

一.從HumanEval到CoderEval

就像ImageNet之于圖像識別,Defects4J之于缺陷檢測,在以工具和方法為主要貢獻(xiàn)的研究領(lǐng)域中,一個被廣泛接受和采用的評估數(shù)據(jù)集及其配套的基準(zhǔn)指標(biāo),對該領(lǐng)域的研究和發(fā)展至關(guān)重要。一方面,評估方式作為度量尺,可以在同一維度上起到橫向?qū)Ρ雀黝惙椒ǖ乃剑⒐烙嬀嚯x成熟實用的差距;另一方面,評估方式作為風(fēng)向標(biāo),直接指導(dǎo)著各種方法共同的優(yōu)化和迭代目標(biāo),決定了研究者們前進(jìn)的方向。

在代碼生成領(lǐng)域,當(dāng)前最廣泛被使用的是OpenAI在Codex論文中開源的HumanEval,該基準(zhǔn)測試集由164道由OpenAI工程師手動編寫的編程任務(wù)組成,以一定程度上確保與訓(xùn)練集的不重疊性。初版的HumanEval僅支持Python語言,每個編程任務(wù)包括了任務(wù)描述、參考代碼、若干測試樣例等。近期有部分研究者將HumanEval擴展到多種編程語言,例如:清華大學(xué)CodeGeex團隊基于HumanEval開源了HumanEval-X,將HumanEval擴展到C++、Java、JavaScript、Go等語言;于2022年8月19日發(fā)布在arXiv上發(fā)布的一篇論文提出了MultiPL-E,將HumanEval擴展到了18種語言。

然而,HumanEval本身存在一些問題,這些問題使得它并不適合成為代碼生成任務(wù)的一個評估平臺,特別是對于以實際開發(fā)為目標(biāo)的代碼生成研究和工具。基于HumanEval進(jìn)行擴展的一類工作僅僅是將HumanEval中的任務(wù)描述、參考代碼、測試樣例以及執(zhí)行環(huán)境等翻譯或適配到了其他語言,實質(zhì)上并未解決HumanEval自身存在的一些問題。那么,這些問題有哪些呢?經(jīng)過對HumanEval中的任務(wù)和測試樣例、以及多個模型生成結(jié)果的人工檢視,我們主要歸納出以下問題:

1.領(lǐng)域單一,僅覆蓋了語言本身基礎(chǔ)的編程知識,如數(shù)據(jù)結(jié)構(gòu)操作、簡單算法等;

2.任務(wù)本身過于簡單,參考代碼均為自包含的單一函數(shù),并未考慮復(fù)雜類型、自定義類型、三方庫、跨過程調(diào)用等情況;

根據(jù)我們對GitHub倉庫數(shù)據(jù)的統(tǒng)計,HumanEval所對應(yīng)的自包含單一函數(shù)在Top 100的Python項目中只占11.2%,在Top 100的Java項目中只占21.3%,因此,HumanEval可能實際上無法準(zhǔn)確反映代碼生成模型在實際項目級開發(fā)中的表現(xiàn)。

針對HumanEval的限制和不足,我們提出了CoderEval,一個面向真實場景和實際用戶的代碼生成模型可用性評測系統(tǒng)。CoderEval在一定程度上解決了當(dāng)前被廣泛使用的評測基準(zhǔn)的問題,主要體現(xiàn)在以下幾點:

1.直接來源于真實的開源項目,覆蓋多個領(lǐng)域,從而可以全面評估代碼生成在不同領(lǐng)域中的表現(xiàn);

2. 考慮了復(fù)雜數(shù)據(jù)類型或項目代碼中開發(fā)者自定義的類型,支持面向?qū)ο筇匦院涂邕^程調(diào)用;

3. 盡量保證覆蓋率和完備性,從而在一定程度上降低測試誤報率。

綜上所述,相比于HumanEval,CoderEval與實際開發(fā)場景中的生成任務(wù)更加對齊,在基于大模型的代碼生成工具逐步落地并商業(yè)化的背景下,可能更加真實地反映并比較不同模型在實際落地為工具之后的開發(fā)者體驗。接下來,我們將簡要介紹CoderEval的組成部分、構(gòu)建過程以及使用方法。

CoderEval論文目前已被ICSE2024接收:

https://arxiv.org/abs/2302.00288

CoderEval-GitHub目前已開源:

https://github.com/CoderEval/CoderEval

二. CoderEval:面向?qū)嶋H開發(fā)場景的代碼生成模型評估

CoderEval組成部分

整體而言,CoderEval主要由三部分組成:

1.生成任務(wù):以函數(shù)/方法為基本單位的代碼生成任務(wù),包括任務(wù)描述(即自然語言注釋)、函數(shù)簽名、參考代碼(即原始代碼實現(xiàn))、所在文件所有上下文代碼、所在項目其他文件內(nèi)容等;

2. 測試代碼:針對某一編程任務(wù)的單元測試,一個編程任務(wù)可能對應(yīng)一到多個測試文件、一到多個測試方法,以及附加的測試數(shù)據(jù)(如操作文件的編程任務(wù)中的文件等);

3. 測試環(huán)境:由于CoderEval中的函數(shù)/方法允許使用自定義類型、調(diào)用語言標(biāo)準(zhǔn)庫或三方庫、調(diào)用項目中其他方法等,因此需要在配置好所在項目的環(huán)境中執(zhí)行。為此,CoderEval基于Docker構(gòu)建了沙箱測試環(huán)境,其中包含了所有被測項目及其依賴,并且附有單一入口的自動化執(zhí)行程序。此測試環(huán)境預(yù)計將以線上服務(wù)的形式提供。

CoderEval構(gòu)建過程

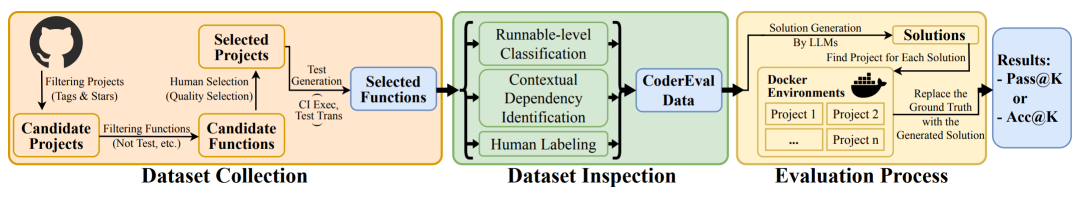

圖1 CoderEval的構(gòu)建過程

圖1展示了針對某一種編程語言(目標(biāo)語言)構(gòu)建CoderEval的一般性的過程,主要分為三個部分:

1.目標(biāo)選取:從GitHub或CodeHub選擇目標(biāo)語言為主的項目中的高質(zhì)量目標(biāo)函數(shù)/方法,作為測試任務(wù)

2. 數(shù)據(jù)收集:針對每個候選測試任務(wù),分析和收集目標(biāo)函數(shù)/方法的元信息、自身信息、測試信息等

3. 環(huán)境構(gòu)建:準(zhǔn)備目標(biāo)項目和依賴,為測試代碼提供執(zhí)行環(huán)境,并通過執(zhí)行測試驗證測試代碼和目標(biāo)代碼的正確性

作為第一個版本,CoderEval首先支持了兩大語言:

? CoderEval4Python:包含來自43個項目的230個生成任務(wù)

? CoderEval4Java:包含來自10個項目的230個生成任務(wù)

為了真實反映代碼生成模型在實際項目開發(fā)中的效果和價值,我們需要從真實、多元的開源項目中選取高質(zhì)量的生成任務(wù),并配備盡可能完善的測試。為此,我們首先爬取了GitHub上Python和Java項目的所有標(biāo)簽,根據(jù)最頻繁的14個標(biāo)簽和標(biāo)星數(shù)篩選出若干項目,然后抽取出項目中所有的測試代碼以及被測函數(shù)/方法,僅保留符合以下全部條件的部分:

?并非以測試為目的的、deprecated的、接口形式的函數(shù)/方法

?包含一段英文自然語言描述作為函數(shù)/方法級注釋

?可以在測試環(huán)境中正確執(zhí)行并通過原始測試

經(jīng)過這些篩選保留下來的函數(shù)/方法,再經(jīng)過人工篩選和程序分析,構(gòu)成了CoderEval中的代碼生成任務(wù),每個生成任務(wù)提供的信息有:

?元信息(Meta):所在項目地址、文件路徑、行號范圍等

?自身信息(Native):該函數(shù)/方法的原始注釋、簽名、代碼等

?上下文信息(Context,可選):所在文件內(nèi)容、可訪問上下文信息、所使用上下文信息、運行級別分類等

?測試信息(Test):人工標(biāo)注的自然語言描述、在原始代碼上的若干測試樣例等

CoderEval使用方法

CoderEval支持函數(shù)/方法塊級生成(Block Generation):根據(jù)注釋形式的任務(wù)描述和/或函數(shù)簽名,生成實現(xiàn)對應(yīng)功能的完整函數(shù)體。

CoderEval支持的指標(biāo):基于運行的指標(biāo)(Comparison-based Metrics)。與HumanEval一致,我們同樣采取了Pass@k作為測試指標(biāo),從而評估所生成代碼實際的運行效果,允許模型生成不同版本的實現(xiàn)。

CoderEval支持更細(xì)粒度的評估:

1. 上下文感知能力評估:我們在研究中發(fā)現(xiàn),對于非自包含函數(shù)/方法,其代碼實現(xiàn)中的外部依賴信息對于其功能和行為非常關(guān)鍵。因此,模型的上下文感知能力(Context-awareness,即正確生成外部依賴信息的能力)是另一個重要指標(biāo)。CoderEval提供了生成任務(wù)所在項目以及文件內(nèi)容可作為輸入,原始代碼中實際用到的上下文信息作為期望輸出,因此,可以分析并計算生成代碼中上下文信息的準(zhǔn)確率以及召回率,作為上下文感知能力的評估指標(biāo)。

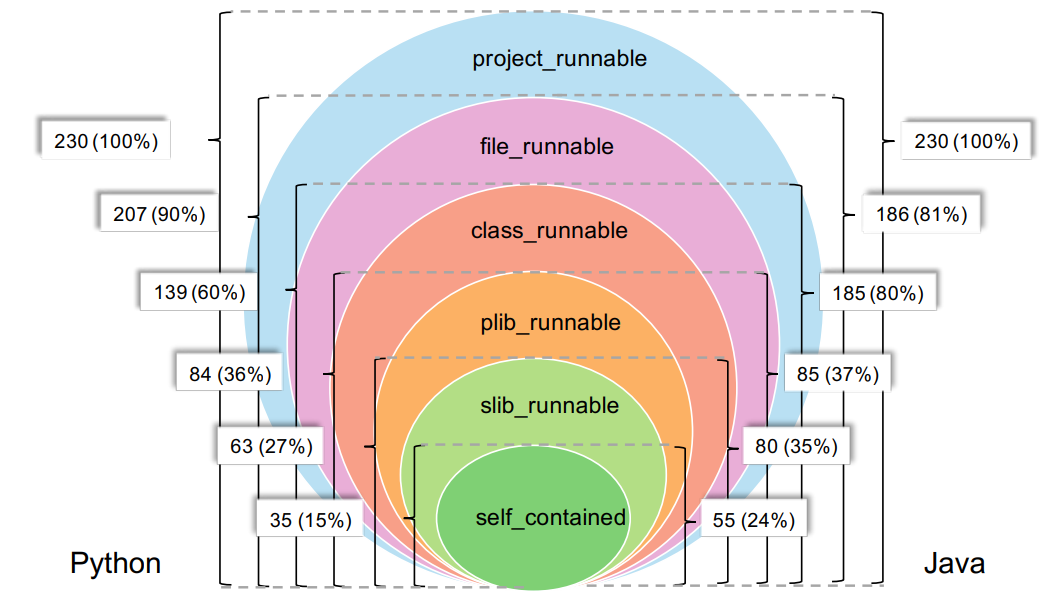

2. 分級評估:如圖2所示,依據(jù)所依賴的上下文信息,CoderEval進(jìn)一步將生成任務(wù)分成了6個級別(self_contained、slib_runnable、plib_runnable、class_runnable、project_runnable),代表所對應(yīng)代碼可執(zhí)行的環(huán)境(標(biāo)準(zhǔn)庫、第三方庫、當(dāng)前文件、當(dāng)前項目等)。CoderEval支持更細(xì)粒度地測試和分析模型在每個級別上的生成能力,從而可以全面地分析當(dāng)前模型的不足和待優(yōu)化的方向(如引入課程學(xué)習(xí)、針對性微調(diào)、上下文可感知度的針對性提升等)。

圖2 CoderEval中按依賴級別的數(shù)據(jù)分布

3. Prompt評估:CoderEval同時提供了原始注釋和開發(fā)者另外標(biāo)注的代碼功能描述,從而研究模型記憶效應(yīng)、Prompt形式、Prompt質(zhì)量對不同模型的影響。

由于CoderEval源于實際的開源項目,并且我們無法精確獲得或控制各個模型訓(xùn)練數(shù)據(jù),因此可能無法避免存在因模型的記憶效應(yīng)和復(fù)制機制產(chǎn)生的誤差。CoderEval緩解此類誤差的主要措施包括:

1.為所有任務(wù)補充了人工改寫的注釋替代原注釋,該部分可確保不存在于訓(xùn)練集中。為此,我們同時會測試。

2. 可增大采樣次數(shù)并綜合基于運行的指標(biāo)和基于比較的指標(biāo)進(jìn)行分析,從而分析模型是否能實現(xiàn)與原代碼不同、但又可通過測試的方案。

CoderEval實測結(jié)果

我們測試了工業(yè)界為主提出的、具有代表性的三個模型在CoderEval上的表現(xiàn),被測模型包括:

1.CodeGen(Salesforce):采用GPT-2架構(gòu),在自然語言上先進(jìn)行預(yù)訓(xùn)練,再在多種編程語言混合語料上繼續(xù)訓(xùn)練,最后在單一編程語言上進(jìn)行微調(diào)。

2. PanGuCoder(Huawei):基于PanGu-alpha架構(gòu),采用<自然語言描述, 程序語言代碼>對的形式和多階段預(yù)訓(xùn)練方法,專注于Text2Code任務(wù),對中文支持較好。

3. ChatGPT(OpenAI):基于GPT-3.5系列模型使用人類反饋進(jìn)行微調(diào),可以根據(jù)用戶的指令或問題來生成代碼。

部分實驗結(jié)果如下:

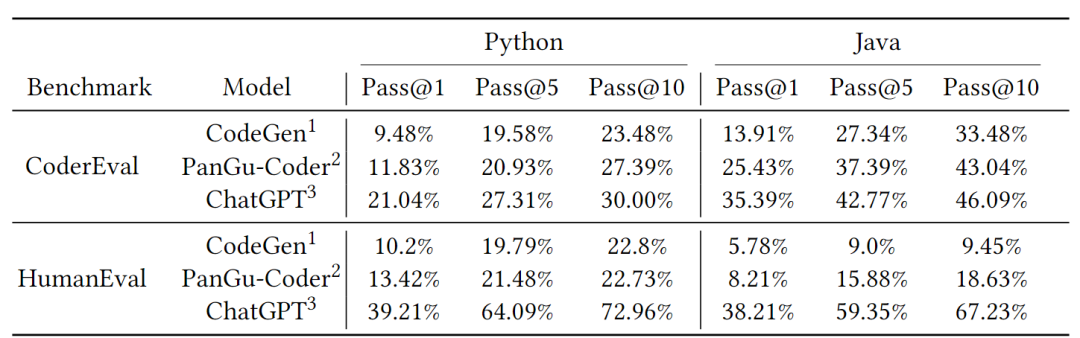

1. 如表1所示,在CoderEval和HumanEval上,ChatGPT的效果都大幅超出其他兩個模型,原因可能來自于更大的模型規(guī)模、更充分的訓(xùn)練度、更優(yōu)的超參數(shù)等方面。

表1 三個模型在CoderEval上和HumanEval上的

總體效果對比

2. 如表1所示,在HumanEval上,ChatGPT的效果更是大幅超過其他模型,幅度要遠(yuǎn)大于在CoderEval上三個模型的差距。考慮到HumanEval的局限性,這一結(jié)果從側(cè)面表明HumanEval可能已經(jīng)不適合作為單一的代碼生成Benchmark。

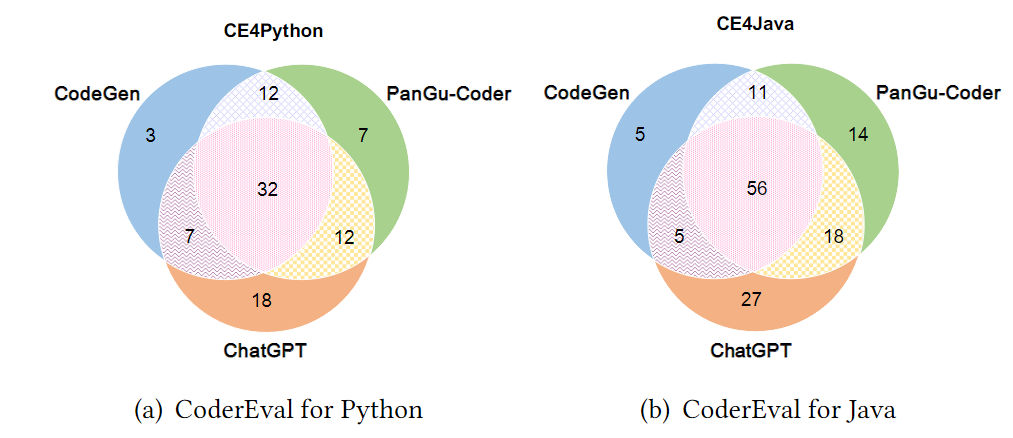

3. 如圖3所示,在CoderEval上,三個模型正確生成的任務(wù)存在較大的交集(Python:32,Java:56),說明三個模型在解決部分任務(wù)上有共性能力;同時,對于僅有一個模型能正確生成、而其他兩個模型未正確生成的任務(wù)而言,ChatGPT在Python和Java上都是最多的(Python:18,Java:27),說明ChatGPT在解決這部分任務(wù)上的能力具有顯著優(yōu)勢;最后,三個模型一共解決的任務(wù)數(shù)仍僅占CoderEval所有任務(wù)數(shù)的約40%(Python:91/230)和59%(Java:136/230),說明三個模型的能力具有一定的互補性,且各自仍有較大提升空間。

圖3 三個模型在CoderEval上和HumanEval上

正確生成的題目數(shù)對比

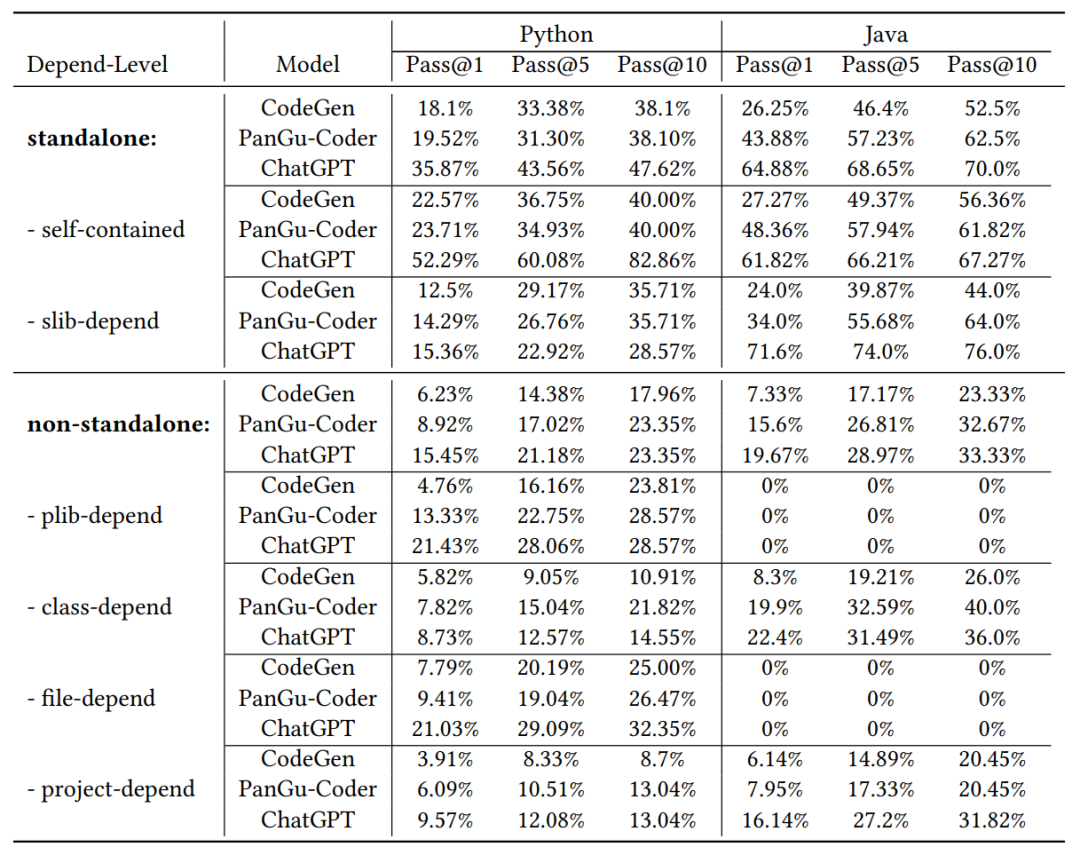

4. 如表2所示,在CoderEval的standalone子集上,三個模型的表現(xiàn)與HumanEval上基本接近,ChatGPT的表現(xiàn)大幅超過另外兩個模型;但是,在其他依賴于上下文信息的生成任務(wù)上(占實際情況的60%以上),三個模型的表現(xiàn)都有較大下降,即使是最強大的ChatGPT的表現(xiàn)也有很大波動,甚至在部分級別上三個模型生成10次的結(jié)果均錯誤,這一定程度上說明了依賴上下文的代碼生成任務(wù)是大模型代碼生成下一步優(yōu)化的重點方向。

表2 三個模型在CoderEval的兩類子集上的表現(xiàn)對比

更多的實驗數(shù)據(jù)以及分析過程,請見CoderEval論文。

三.總結(jié)

CoderEval論文目前已發(fā)表在ICSE2024(https://arxiv.org/abs/2302.00288 ),其開源項目版可在GitHub獲得(https://github.com/CoderEval/CoderEval ),歡迎大家關(guān)注并一鍵Follow+Star。我們致力于將CoderEval打造為一個客觀、公正、全面的Benchmark,不過,盡量我們已努力完善,但它仍然不可避免地存在一些限制和錯誤。因此,我們希望借助代碼生成研究者社區(qū)的力量,持續(xù)迭代和更新CoderEval的版本,以擴展和完善其語言支持、數(shù)據(jù)集、測試方式等方面,從而持續(xù)推動代碼智能社區(qū)的研究與落地。

PaaS技術(shù)創(chuàng)新Lab隸屬于華為云,致力于綜合利用軟件分析、數(shù)據(jù)挖掘、機器學(xué)習(xí)等技術(shù),為軟件研發(fā)人員提供下一代智能研發(fā)工具服務(wù)的核心引擎和智慧大腦。我們將聚焦軟件工程領(lǐng)域硬核能力,不斷構(gòu)筑研發(fā)利器,持續(xù)交付高價值商業(yè)特性!加入我們,一起開創(chuàng)研發(fā)新“境界”!(詳情歡迎聯(lián)系:

bianpan@huawei.com;mayuchi1@huawei.com)

原文標(biāo)題:從HumanEval到CoderEval: 你的代碼生成模型真的work嗎?

文章出處:【微信公眾號:華為DevCloud】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

-

華為

+關(guān)注

關(guān)注

216文章

34327瀏覽量

251222

原文標(biāo)題:從HumanEval到CoderEval: 你的代碼生成模型真的work嗎?

文章出處:【微信號:華為DevCloud,微信公眾號:華為DevCloud】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

阿里云開源Qwen2.5-Coder代碼模型系列

探索設(shè)計稿自動生成Flutter代碼的技術(shù)方案

新的 MathWorks 硬件支持包支持從 MATLAB 和 Simulink 模型到高通 Hexagon 神經(jīng)處理單元架構(gòu)的自動化代碼生成

GAP!你對AI大模型到底了解多少?

NVIDIA AI Foundry 為全球企業(yè)打造自定義 Llama 3.1 生成式 AI 模型

如何用C++創(chuàng)建簡單的生成式AI模型

大模型應(yīng)用之路:從提示詞到通用人工智能(AGI)

降價潮背后:大模型落地門檻真的降了嗎?

ISEDA首發(fā)!大語言模型生成的代碼到底好不好使

生成式 AI 進(jìn)入模型驅(qū)動時代

從HumanEval到CoderEval: 你的代碼生成模型真的work嗎?

從HumanEval到CoderEval: 你的代碼生成模型真的work嗎?

評論