2023過去,當我們回顧這一年的最受產業(yè)關注的芯片,相信大多數(shù)人會將票投向GPU。2023年中,我們總能聽到“GPU緊缺”、“英偉達狂飆”、“黃仁勛分享成功秘訣”。

無可否認,2023年生成式AI的熱潮無邊無際,全球高科技公司都涌入了AI的軍備競賽。隨之帶來的是算力告急、全球瘋搶GPU。

01 全球最火的GPU

2023年層出不窮地傳出,人工智能AI大模型的消息。OpenAI、百度、谷歌、騰訊都在搭建屬于自己的大模型。對于這些五花八門的大模型,我們不多贅述,但大模型的搭建,最需要的就是GPU,而2023年需求量最大的GPU不外乎:A100/H100。

首當其沖的就是A100GPU。OpenAI使用的是3,617臺HGXA100服務器,包含近3萬塊英偉達GPU。國內云計算相關專家認為,做好AI大模型的算力最低門檻是1萬枚英偉達A100芯片。

TrendForce研究則顯示,以A100的算力為基礎,GPT-3.5大模型需要高達2萬枚GPU,未來商業(yè)化后可能需要超過3萬枚。

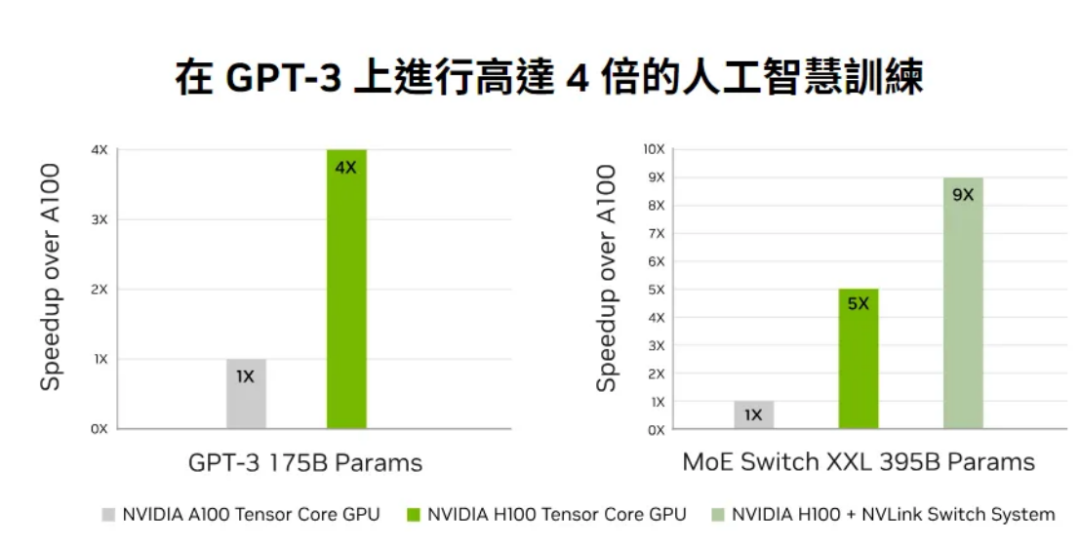

H100也是業(yè)內追求的對象。H100于去年9月量產,由臺積電4N工藝代工。相較于前任A100,H100單卡在推理速度上提升3.5倍,在訓練速度上提升2.3倍;如果用服務器集群運算的方式,訓練速度更是能提高到9倍,原本一個星期的工作量,現(xiàn)在只需要20個小時。

考慮到整體系統(tǒng)成本,H100每美元產生的性能比A100還要高4到5倍之多。與A100相比,H100的單卡價格更貴,但是由于其訓練、推理效率增加,成為了最具性價比的產品。

正因如此,科技大廠各個都搶著要買英偉達H100GPU,或者更準確地說,是英偉達的8-GPU HGX H100SXM服務器。

英偉達成為了最受關注的賣鏟人。針對中國市場,還按照A800操作模式(A100芯片的降維版本),推出了完全符合出口規(guī)定的H100的降維版本芯片。

02 熱情的買家

“GPU就是新時代的比特幣。”O(jiān)penAI首席科學家IlyaSutskever將這句話寫在他個人的X賬號上。在算力激增的背景下,英偉達的GPU成為了“硬通貨”。

夸張的是,甚至有海外初創(chuàng)企業(yè)開始利用GPU進行抵押融資,一家硅谷的創(chuàng)業(yè)公司使用H100拿到了23億美元的債務融資。

購買H100和A100的公司有三種。第一種,是需要超過1000張的公司,包括訓練LLM的創(chuàng)業(yè)公司,如OpenAI、Anthropic;云服務提供商,如谷歌云、AWS、騰訊云;其他大公司,如特斯拉。第二種,是需要超過100張的公司,也就是對開源模型進行大量微調的初創(chuàng)公司。第三種,需要10張的公司,就是大部分創(chuàng)業(yè)公司和開源勢力,熱衷使用大模型的輸出微調小模型。

這些買家需要多少GPU呢?OpenAI可能需要5萬張、Inflection要2.2萬張、Meta需要2.5萬張、大型云廠商(Azure、GoogleCloud、AWS、Oracle),每家可能需要3萬張,Lambda和CoreWeave以及其他私有云可能總共需要10萬張,Anthropic、Helsing、Mistral、Character,每家可能要1萬張。

僅僅這幾家公司,就已經(jīng)需要43.2萬張H100,如果以每塊約3.5萬美元計算,GPU的價值約為150億美元。而這還沒有包括字節(jié)、百度、騰訊等國內公司。

在AI大模型競爭上,榜上有名的幾個國家:中國、美國、沙特阿拉伯、阿聯(lián)酋,都是英偉達的座上賓。

沙特阿拉伯已通過公共研究機構阿卜杜拉國王科技大學(Kaust)購買了至少3000塊英偉達的H100芯片。這些芯片將于2023年底全部交付,總價值約為1.2億美元,用于訓練AI大模型。

阿聯(lián)酋也獲得了數(shù)千顆英偉達芯片的使用權,并已推出自己的開源大語言模型“Falcon40B”,“Falcon40B”使用了384個A100芯片進行訓練。

03 GPU的出貨量

英偉達H100的出貨量也備受關注。研究機構Omdia披露,英偉達在2023年第二季度的H100出貨量為900噸。按照單片H100GPU的重量約為3千克,那么英偉達在二季度售出了約30萬片H100。

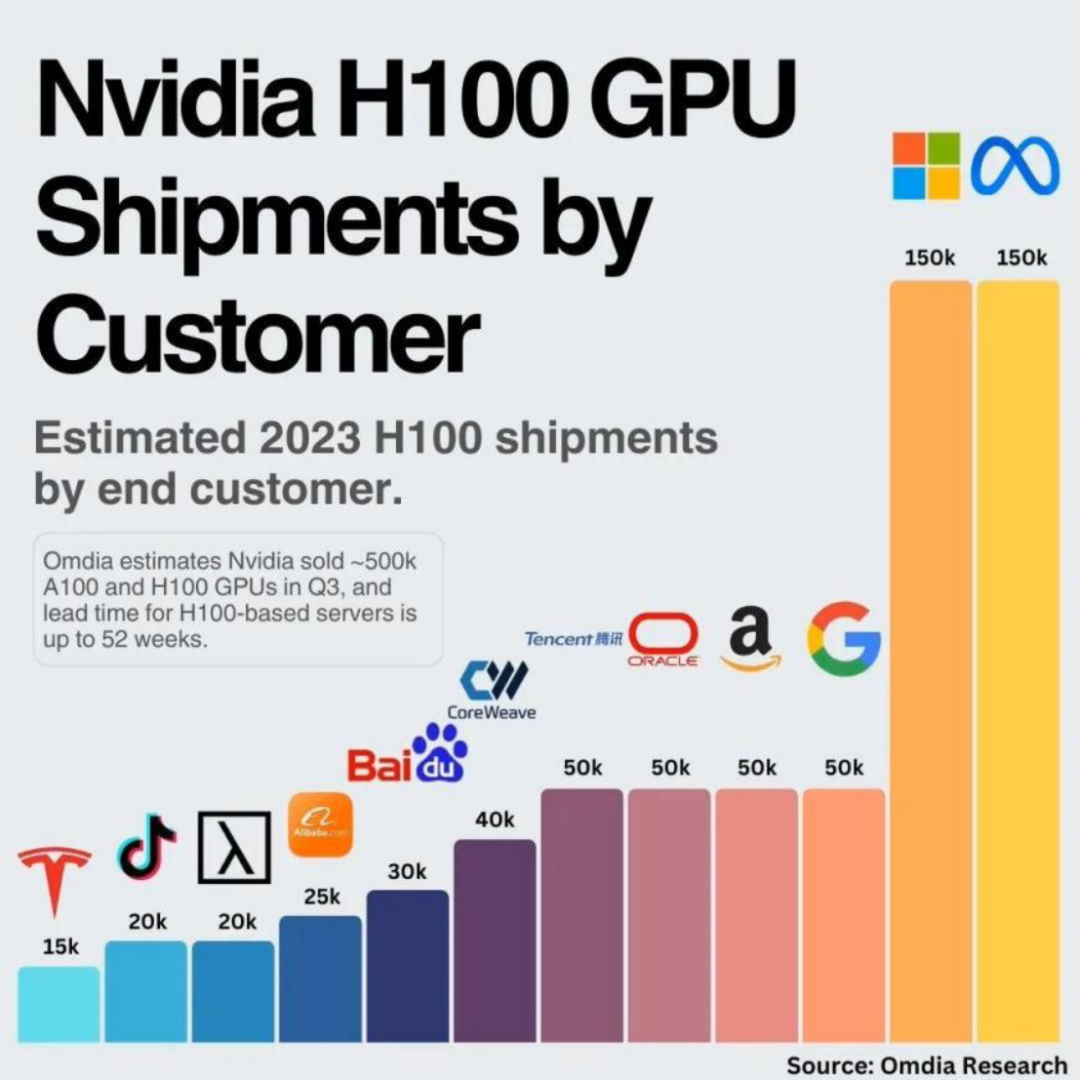

到了三季度,英偉達大約賣出了50萬臺H100和A100 GPU。每家能夠分到的GPU數(shù)量有限,Meta和微軟各自采購了15萬個H100GPU,谷歌、亞馬遜、甲骨文和騰訊則各采購了5萬片。

如此龐大的GPU需求量,導致基于H100的服務器需要36~52周的時間才能交付。按照英偉達官方的說法,2024年一季度之前的GPU芯片早已全部售罄。

業(yè)內預估,明年英偉達的出貨量將達到150萬-200萬顆。

04 2024,GPU能降價嗎?

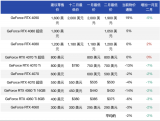

GPU能否降價,還要看明年的供需情況。上圖是GPUUtils列出的目前對GPU市場供需變化最有直接影響的科技公司,包括了:開發(fā)出Chat-GPT的OpenAI、臺積電、微軟、Meta以及成立僅僅一年便募得13億美元資金的AI新創(chuàng)Inflection。

買方

有的人不想買。谷歌、Meta都覺得英偉達的GPU太貴了。

Meta最近已經(jīng)宣布構建了自己的DLRM推理芯片,并且得到廣泛部署。Meta大大方方承認,自己即將發(fā)布的AI芯片并不能直接替代英偉達的芯片,但是自研芯片可以降低成本。

就算在谷歌I/O開發(fā)者大會兩個小時的演講中,谷歌方面一直在贊賞英偉達的H100GPU芯片。這也不妨礙,谷歌開始“騎驢找馬”,谷歌的云服務器上已經(jīng)用上了自家TPU。

Google TPU v5e于2023年8月發(fā)布,成為人工智能硬件領域的強大力量,專為大型語言模型和生成式人工智能量身定制。與前代產品相比,TPUv5e的每美元訓練性能顯著提高2倍,每美元推理性能顯著提高2.5倍,可大幅節(jié)省成本。其突破性的多片架構可實現(xiàn)數(shù)萬個芯片的無縫連接,突破了以往的限制,為處理海量人工智能任務開辟了途徑。

有的人不能買。中國是英偉達的第三大市場,占據(jù)其收入的1/5以上。隨著美國政府宣布進一步禁止中國銷售英偉達H800和A800芯片,賣不出去的GPU,必然會對英偉達產生負面影響。

此外,明年AI或許迎來退潮。2023年的AI熱潮,除了大模型震驚業(yè)界外,炒作的因素也不在少數(shù)。毫無疑問,ChatGPT是2023年的世界頂流。因為它,OpenAI網(wǎng)站的流量在4月份就超過了18億,進入了全球流量排名前20。然而,網(wǎng)絡分析公司Similarweb公布的數(shù)據(jù)顯示,在狂飆半年后,ChatGPT的訪問量首次出現(xiàn)負增長,6月份的訪問量環(huán)比下滑9.7%。

在大模型創(chuàng)業(yè)狂飆200多天后,探索者們的心態(tài),從理想亢奮來到現(xiàn)實落地。大模型的維護依賴大量的高性能芯片,而單要建構、維護生成式AI工具的成本就非常巨大。這對于大公司而言還好,但是對于許多組織與創(chuàng)作者而言,這卻是一筆難以負擔的支出。

對于生產式AI,2024年還會再次迎來大眾的檢驗。行業(yè)分析師認為,2023年關于生成式人工智能的炒作非常大,AI被過度吹捧,因為相關技術需要克服許多障礙才能將其推向市場。

退潮之后,能夠剩下的高性能GPU需求還能有多少?

賣方

我們先來看看英偉達這個最大的賣家。優(yōu)先關注兩個方面:能不能供應足夠的GPU,明年是否有新品刺激市場需求。

第一個供貨方面,眾所周知,英偉達只與臺積電合作生產H100,臺積電一共有4個生產節(jié)點是為5nm芯片提供產能:N5、N5P、N4、N4P。而H100只在N5或者是N5P的中的4N節(jié)點上生產,這是一個5nm芯片的增強型節(jié)點,同時英偉達還必須與蘋果、AMD和高通共享這個節(jié)點的產能,至于A100顯卡則是在臺積電的N7生產線制作的。從短期的情況看,三星和英特爾都因為制程技術的問題,無法替英偉達緩解供應緊張的問題。因此,預計明年市場,英偉達的GPU供應仍會緊缺。

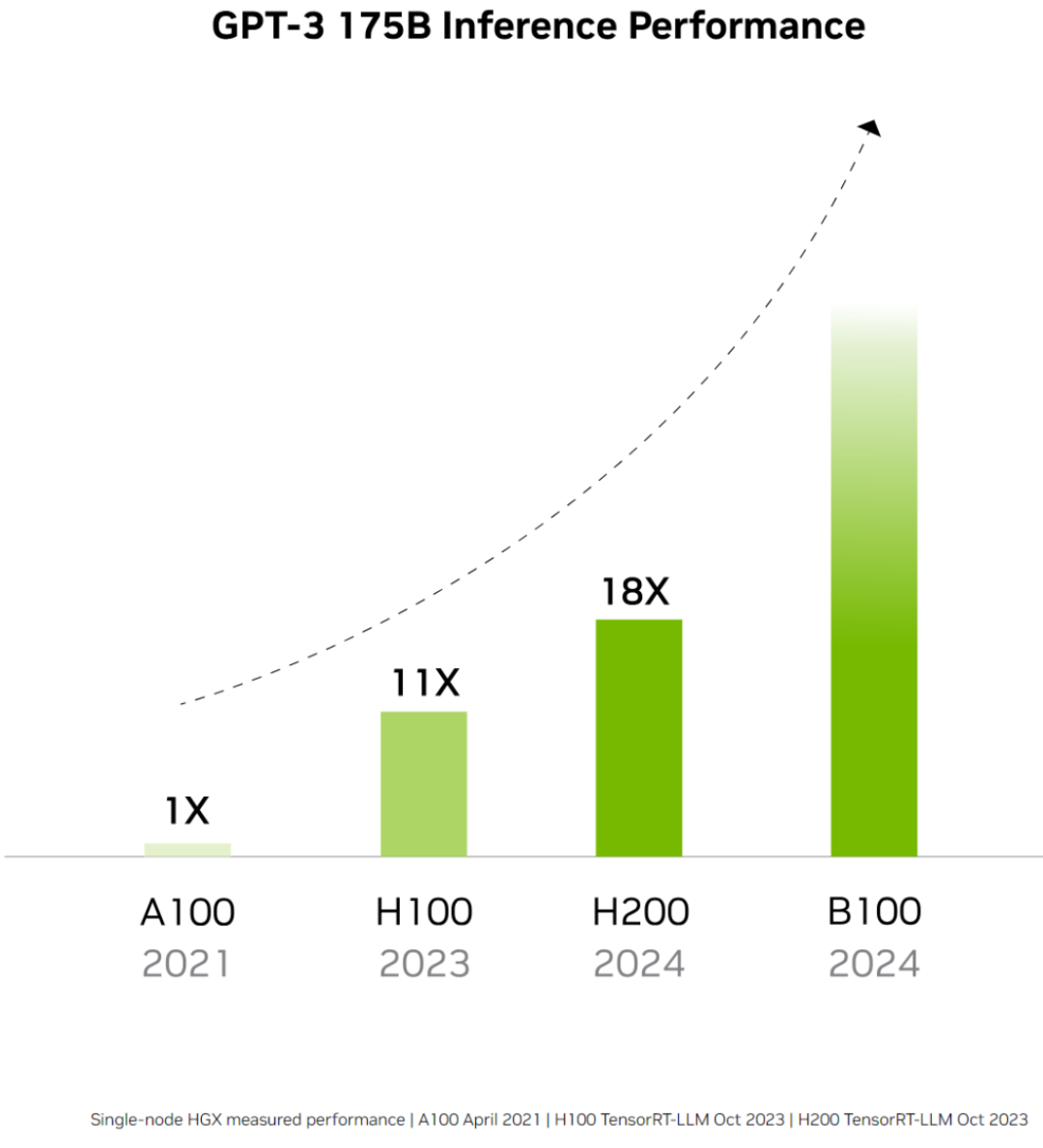

第二個新品方面,英偉達在2023年11月底時,發(fā)布了H100的下一代繼承者——H200。表示在處理Llama2等LLM時,H200的推理速度比H100GPU提高了近2倍。從2024年開始,亞馬遜網(wǎng)絡服務、谷歌云、微軟Azure和甲骨文云基礎設施將成為首批部署基于H200實例的云服務提供商。盡管還沒有公布H200的價格,但一定比H100目前每臺2.5萬美元至4萬美元的價格更加昂貴。

從兩個方面看,英偉達的GPU供需還存在較大的不確定性。不過。賣家市場,會有更多廠商加入。

明年GPU的另一大賣家,就是回過神來的AMD。

從最近的財報來看,AMD預計四季度GPU收入將達到4億美元,到2024年底將超過10億美元。其CEO蘇姿豐對明年充滿期待:“MI300將成為自2020年后,銷售額達到10億美元最快的產品。”

2023年11月,AMD正式發(fā)布了對標H100的產品——MI300。據(jù)AMD展示,由8塊MI300X組成的服務器在大模型推理方面的表現(xiàn),要比同樣規(guī)模的H100速度最高提升1.6倍之多。對于AMD來說,這種直接對標,實屬罕見。

有意思的是,Meta、微軟和OpenAI公司在AMD投資者活動上表態(tài),未來他們將會使用AMD最新的人工智能(AI)芯片InstinctMI300X。

不過,英偉達對AMD的對標也態(tài)度強硬,官方發(fā)布博客,駁斥AMD的評測不客觀。英偉達表示,如果H100GPU使用了優(yōu)化過的軟件進行正確的基準測試,它的性能將大大超過MI300X。

由于MI300還未正式應用,對于我們對于AMD和英偉達之間的“官司”很難分說,但不論如何,AMD已經(jīng)走到了高性能GPU的起跑線。

總而言之,2024年的GPU還充滿變數(shù)。在AI大模型冷靜后、在買家不想當冤大頭后、在賣家越來越多后,GPU還會維持天價嗎?相信各位看官心中自有答案。從市場的角度看,無論是當下多先進的技術,到最后終將會越來越普世。就看GPU玩家們,在2024年如何進攻戰(zhàn)場了。

-

gpu

+關注

關注

28文章

4700瀏覽量

128697 -

人工智能

+關注

關注

1791文章

46853瀏覽量

237544 -

OpenAI

+關注

關注

9文章

1042瀏覽量

6406 -

大模型

+關注

關注

2文章

2324瀏覽量

2480

原文標題:2024年,GPU能降價嗎?

文章出處:【微信號:ICViews,微信公眾號:半導體產業(yè)縱橫】歡迎添加關注!文章轉載請注明出處。

發(fā)布評論請先 登錄

相關推薦

預計2024年全球GPU市場銷售額將超985億美元

2020-2022-2024年TI杯全國大學生電子設計競賽官方推薦芯片對比分析比較

節(jié)能降碳 | 超聲波流量測量技術:供熱系統(tǒng)的綠色“數(shù)智”先鋒

全球PC GPU 2024年一季度出貨量增28%

彭博預測2024年NVIDIA將繼續(xù)領跑AI GPU市場

英偉達2024年GTC人工智能大會看點,黃仁勛發(fā)布最炸裂的B200 GPU,講述人工智能奇跡

阿里云為什么能降價?釋放了什么信號?

#新開端、新起點,2024一起加油#

2024年工業(yè)行業(yè)轉型展望

2024年,GPU還會維持天價嗎?

特斯拉降價,24年電車價格戰(zhàn)持續(xù)

2024年大型數(shù)據(jù)中心芯片盤點

2024年,GPU能降價嗎?

2024年,GPU能降價嗎?

評論