人工智能是指讓計算機或機器具有類似于人類智能的能力,如學習、推理、解決問題和使用語言、常識、創造力、情感和道德等。近年來,以大型語言模型(Large language models,LLMs)為基礎的人工智能技術和產品取得了驚人的進步,大語言模型和人工智能炙手可熱。其實,人工智能并非一個新鮮概念,而是一門有歷史有內涵的學科。歷史上,它既有過樂觀和期待,也有過失望和低迷。所謂,以史為鑒,可以知興替,歷史不僅是過去的記憶,更是現在的啟示和未來的指引。當我們熱烈地期盼能夠預知人工智能的未來將如何時,我們可以回顧一下人工智能的歷史,照見其興衰與更替,也期盼從歷史經驗中汲取經驗與教訓,在更加復雜的技術變革之中,在面臨人工智能帶來的機遇與挑戰之時,能夠更明晰地看清方向,為腳踏實地地前行提供思想根基。

啟蒙時期

人類(Human)在生物分類學上就是“智人(Homo sapiens)”,這很能說明人類自身作為物種時,智力或智能是多么重要的一個因素!幾千年來,我們一直試圖了解人類是如何思考的,這包括了如何感知、理解、預測(決策)和操縱(行動)一個比我們自身大得多、復雜得多的世界。也因此,從幾千年前,人類就開始向往制造智能的機器,這體現在許多的文學作品中。

在古希臘的神話中,赫菲斯托斯創造了塔羅斯和機械獵犬,其任務是保護克里特島,這是神話中的智能機器人。同樣的,中國三國時期的史料《三國志》和演義小說《三國演義》都提及,諸葛亮制造木牛流馬來自動運輸糧草,這也是一種對自動機器的期盼。艾薩克·阿西莫夫在 1945 年出版了《機器人》一書,機器人作為科幻中的角色,真正普及到普羅大眾之中,“機器人三大定律”——不傷害人類、服從命令和保護自己——也聞名于世。而更現代的作品,像日本動畫《天空之城》、美國影視《西部世界》、中國科幻大片《流浪地球》等,都在幻想著人造的能媲美人類甚至超越人類自身的智能體。

當然,作為嚴肅的學科,其誕生過程也非常漫長。從思想上,可以追溯到歐幾里得的《幾何原本》所開啟的形式思維的結構化方法和形式推理。1700 年前后,戈特弗里德·萊布尼茨提出,人類的理性可以歸結為數學計算,從哲學上開啟了人類智能的探討。1930 年,庫爾特·哥德爾提出了不完備性定理,表明了演繹所能做的事情是有限的。1937 年,一階謂詞邏輯被提出,成為后來符號主義人工智能很長一段時間的主要研究對象。

1943 年,計算神經科學家皮茨和麥卡洛克發表的關于神經元的數學模型的論文“A logical calculus of the ideas immanent in nervous activity”(《神經活動中固有的邏輯演算》)是神經網絡的開端,也是聯結主義人工智能的開端,今天,它以“深度學習”的名義廣為人知。1948 年應用數學家維納(Norbert Wiener)出版了控制論領域的奠基性著作“Cybernetics: Or Control and Communication in the Animal and the Machine”(《控制論:或關于在動物和機器中控制和通信的科學》),開啟了行為主義人工智能,在今天,其代表性技術是強化學習。

1949 年 7 月,數學家香農(Claude Elwood Shannon)與韋弗(Warren Weaver)發表了一份關于機器翻譯的備忘錄,這開啟了人工智能的另一門子學科——自然語言處理。1950 年,圖靈(Alan Turing)在論文“Computing Machinery and Intelligence”(《計算機器與智能》)中提出圖靈測試,這是一種用來判斷機器是否具有智能的思想實驗。從此,討論機器智能無法繞開圖靈測試,而圖靈獎也成為了計算機學科的最高獎項。1951 年計算機科學家斯特雷奇(Christopher Strachey)編寫了西洋跳棋程序,被認為是符號主義人工智能的第一個程序。至此,人工智能三大范式和圖靈測試皆已就位,人工智能成為一門學科也可謂只欠東風。

在人工智能誕生之前,技術和理論繼續發展。1951 年,明斯基(Marvin Lee Minsky)和埃德蒙茲(Dean S. Edmonds)開發了具有 40 個神經元的隨機神經模擬強化計算器(Stochastic Neural Analog Reinforcement Calculator,SNARC)。SNARC 模擬了一只老鼠在迷宮中奔跑并尋找目標的行為,是最早的復雜神經網絡,也是最早的強化學習思想的應用。

1954 年,貝爾曼(Richard Bellman)把動態規劃和價值函數引入到最優控制理論中,形成了現在稱為貝爾曼方程的方法。早期人工智能最著名的“系統邏輯理論家(Logic Theorist)”,也開始于 1954 年。這是一個被后來許多人認為是人類歷史上第一個真正的人工智能程序。邏輯理論家由紐厄爾(Allen Newell)、西蒙(Herbert A. Simon)和肖(Cliff Shaw)共同開發,并于 1955 年 12 月完成,最終證明了經典數學書籍Principia Mathematica(《數學原理》)中前 52 個定理中的 38 個。同時,它還為其中一些定理找到了新的、更優雅、更簡潔的證明。這項工作的論文于 1956 年 6 月 15 日完成(見圖 1),1956 年 8 月在達特茅斯會議上進行了程序演示,1957 年論文正式發表在IRE Transactions on information theory上。

圖 1 邏輯理論機器論文

誕生

人類的嬰兒懷胎十月之后呱呱墜地,人工智能學科也一樣,許多技術在學科誕生之前都已具備,就等待一個呱呱墜地的時刻。這個時刻就是 1956 年的達特茅斯會議。人工智能學科的誕生,不僅意味著人類知識的進步和社會的發展,也是我們了解人類自身為何智能的新機遇。

1955 年,麥卡錫(John McCarthy)、明斯基、羅切斯特(Nathaniel Rochester)和香農四個人提交了達特茅斯會議的建議書“A Proposal for the Dartmouth Summer Research Project on Artificial Intelligence”(《達特茅斯夏季人工智能研究項目建議書》),申請了來年舉辦達特茅斯人工智能會議的預算 13500 美元。該建議書已經明確使用了“人工智能(Artificial Intelligence)”一詞,并在建議書中提及了相關的議題:

模擬人類大腦高階功能的自動化計算機;

如何編寫計算機程序來使用自然語言;

神經元網絡;

計算量的規模理論;

自我改進;

抽象;

隨機性和創造性等。

這些議題至今仍是熱門的研究主題。會議擬邀請近 50 位當時在計算機、數學、神經科學等領域的專家學者。

1956 年 6 月 18 日至 8 月 17 日,達特茅斯人工智能會議如期舉辦,雖然大部分擬邀請的人都沒去,但會議至少包含 10 名與會者,包括 4 位發起人,以及阿瑟·塞繆爾、特雷徹·摩爾、雷·索爾馬諾夫、奧利弗·塞爾弗里奇、艾倫·紐厄爾和赫伯特·西蒙。當然,由于每個人的研究方向各不一樣,會議本身并沒有任何值得一說的重大突破。但通過這次會議,人工智能領域的奠基性人物彼此認識,“人工智能”被與會者一致認可。自此,人工智能這門學科呱呱墜地。也因此,1956 年被業內公認為人工智能元年。

第一波浪潮

從 1956 年開始,人工智能開啟了第一波高速發展的浪潮。1956 年語義網絡(Semantic Networks)這個概念在機器翻譯的研究中被提出來,這個概念經過 40 多年的演化,形成了現在的知識圖譜。1957 年,人工智能三大范式皆有突破。聯結主義流派提出了感知機(Perceptron),一臺通過硬件來實現更新權重的計算機器;符號主義流派發明了 IPL (Information Processing Language),一種方便進行啟發式搜索和列表處理的編程語言;行為主義流派提出了馬爾可夫決策過程(MDP)的框架,一種最優控制問題的離散隨機版本。此后,人工智能發展可謂一日千里。1958 年麥卡錫對 IPL 進行大幅改進, 推出了 LISP 編程語言,于 1960 年發布。1958 - 1959 年,幾何定理證明器(Geometry Theorem Machine)和通用問題求解器(General Problem Solver,GPS)相繼出現,這是接近于人類求解問題思維過程的人工智能程序。1960 - 1962 年,MDP 的策略迭代方法和 POMDP(Partially Observable Markov Decision Processes)模型被提出。

接下來是三個第一波浪潮中的典型代表系統。首先是塞繆爾開發的西洋跳棋程序在 1962 年 6 月 12 日挑戰當時的西洋跳棋冠軍尼雷(Robert Nealey)并獲勝。其次是 1964 - 1967 年第一個聊天機器人 ELIZA 發布,它給用戶一種具備理解人類語言能力的感覺,這讓當時的許多用戶認為 ELIZA 具備真正的智能和理解力,甚至具備感情屬性。第三個是 1965 年開始開發的專家系統 DENDRAL(Dendritic Algorithm),這是一個模擬有機化學家決策過程和問題解決行為的化學分析專家系統,能夠確定有機分子的結構。專家系統將在第二波浪潮中大顯神通。

西洋跳棋程序、ELIZA、以及 DENDRAL 等眾多人工智能程序及應用一方面繁榮了人工智能學科,同時也將整個社會的帶入一種樂觀的狀態,許多人認為,十至二十年的時間內,真正的人造智能機器將會誕生。明斯基就曾說到“我相信,在一代人的時間內,機器將涵蓋幾乎所有方面的人類智能”——創造“人工智能”的問題將得到實質性的解決。1970 年 11 月 20 日的《生活》雜志刊登了一篇文章,標題是“遇見 Shaky,第一個電子人(Meet Shaky,the first electronic person)”。該文表達了對人工智能的極大樂觀,甚至認為機器將取代人類。圖 3 是文章的截圖,巨大的文字表達“如果我們幸運的話,它們或許會決定將我們珍視如寵物。(If we are lucky, they might decide to keep us as pets.)”。彼時彼刻,是否恰如此時此刻?

然而,樂觀的情緒沒有持續多久,就迎來了人工智能的第一個冬天。在二十世紀 60 年代末到 70 年代初,人工智能面臨著許多問題無法解決,比如兩個典型的難題是機器翻譯和非線性的異或(XOR)問題。這些問題引起了人們對人工智能的沮喪,并使得政府大幅減少甚至停止了人工智能研究項目的資助。自 1969 年開始大約 10 年的時間,被稱為人工智能的第一個冬天。

第二波浪潮

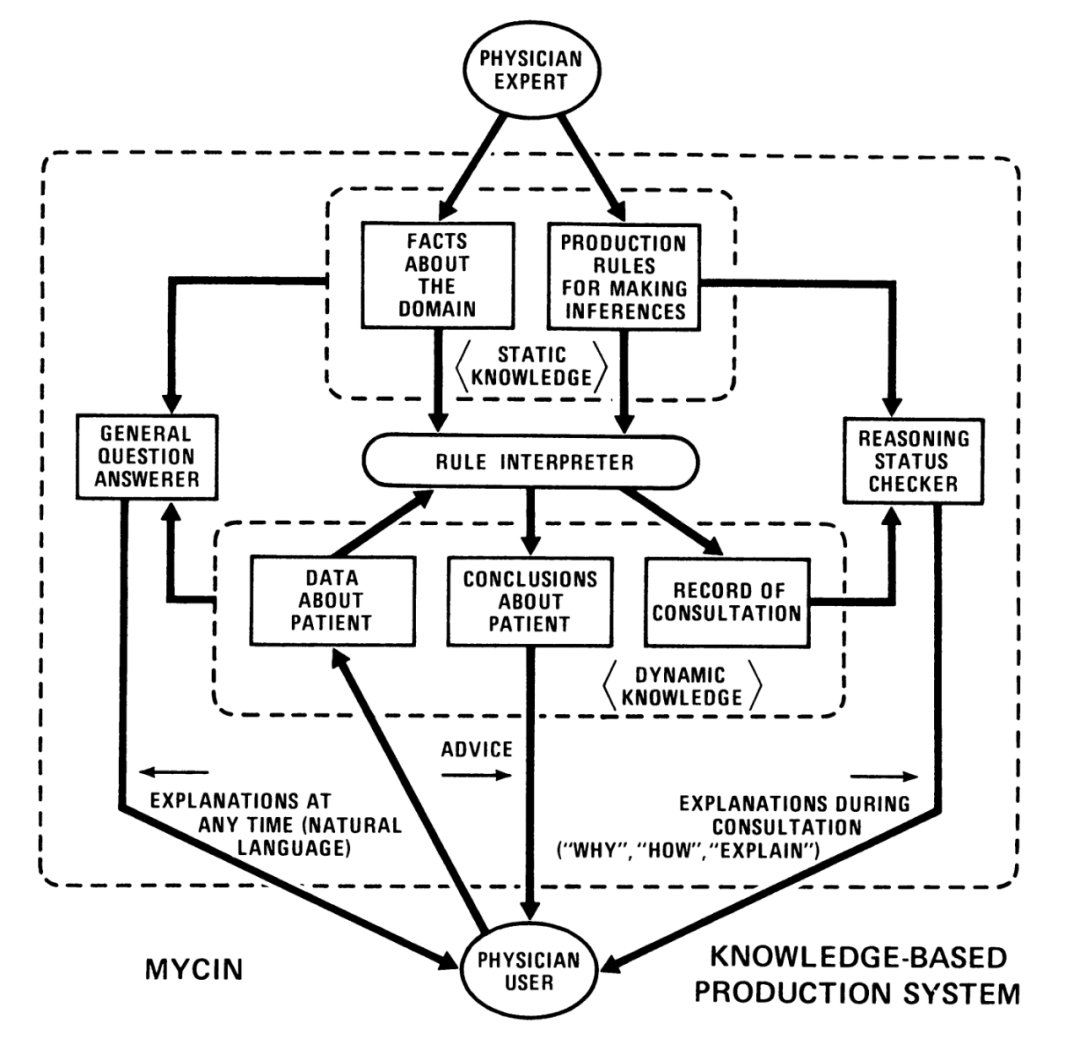

每一個冬天,都預示著下一個春天的來臨和精彩。第一個人工智能的冬天,也不例外。在 1969 - 1979 年間,是專家系統默默吸收養分、擴展根基、積蓄力量的時間,并最終在 80 年代變得非常流行,應用到千行百業。專家系統是一種基于知識和模擬人類專家決策能力的計算機系統。自 DENDRAL 發布之后,許多專家系統在這期間被開發。比如,1972 年,著名的用于診斷血源性傳染病的專家系統 MYCIN(見圖 4)和用于內科診斷的臨床專家系統 INTERNIST-I 開始開發和發布;1976 年,地質領域的用于勘探礦產資源的專家系統 PROSPECTOR 開始開發。

圖 4 MYCIN 專家系統

事實上,在整個 1970 年代,專家系統就像肥沃土壤中的種子一樣不斷地吸收養分,并在許多狹窄的領域已經成功應用,只待時機一到,破土而出,拔節而長,蓬勃發展。而即將到來的 1980 年代,正是專家系統繁榮和收獲的季節。

進入 1980 年代,專家系統的繁榮,使得人工智能成為一個新興產業。其核心緣由之一是專家系統從非常狹窄的領域逐漸發展為通用化,并在千行百業上應用。典型的例子是 DEC 公司。DEC 公司從 1980 年開始持續多年開發了用于配置計算機的專家系統 R1(內部代號為 XCON)。截止 1986 年,R1 為 DEC 公司處理了 80000 個訂單,平均每年節省了約 2500 萬美元,其中 1986 年節省了 4000 萬美元。到 1987 年初,R1 系統有 6200 條專家規則,以及 2 萬個零部件的描述。此外,DEC 還開發了銷售 XSEL 銷售助手專家系統,該系統可以和 R1 進行交互,輔助銷售人員銷售計算機系統。另一個典型的例子是杜邦公司,到 1988 年已經建立了 100 個專家系統,每年為公司節省了估計的 1000 萬美元,并有另外 500 個系統正在開發中。下表列出了一些 1980 - 1990 年代典型的專家系統,管中窺豹,可見一斑。

表 1 代表性的專家系統列表

如此大量的專家系統在各行各業應用,得益于面向構建專家系統的引擎、邏輯編程語言和知識庫的出現和繁榮。在引擎方面,EMYCIN、ARBY、KEE 等是典型的代表。在編程語言方面,LISP、ROSIE 和 Prolog 是典型代表。特別是 Prolog,它以一階邏輯為基礎,用接近于自然語言的方式來編寫邏輯與規則,是構建專家系統最好的編程語言。Prolog 的程序由兩個主要部分組成:事實和規則,事實是被認為是真實的陳述,規則是描述不同事實之間關系的邏輯語句。

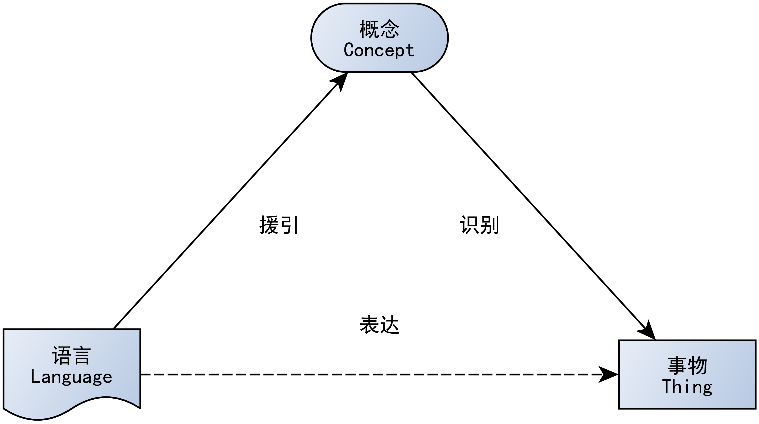

Prolog 等邏輯編程語言和引擎的流行使得構建專家系統愈加容易。在知識庫方面則出現了本體,這是由麥卡錫在 1980 年從哲學中引入到人工智能學科的。關于本體,在《知識圖譜:認知智能理論與實戰》一書中,將本體總結為“‘存在’和‘現實’就是能夠被表示的事物,本體被用于對事物進行描述,定義為‘概念化的規范’(specification of a conceptualization),用于表示存在的事物(the things that exist),即現實中的對象、屬性、事件、過程和關系的種類和結構等等。自此,專家系統往往會“列出所有存在的事物,并構建一個本體描述我們的世界”(參見圖 5),而這所列出來的,也往往被稱為知識庫。這些本體庫或知識庫,典型代表有 CYC、WordNet 等。

圖 5 專家系統邏輯

專家系統的繁榮,將人工智能第二波浪潮推向巔峰,其標志是許多大學開設了專家系統的課程,世界財富 1000 強公司中有三分之二以上都在使用專家系統來處理日常的業務活動,涵蓋了農業、商業、化學工業、通信、計算機系統、教育領域等,幾乎包括人類生產生活的方方面面。《哈佛商業評論》在 1988 年的一篇文章認為“基于專家和知識的系統正在商業環境中迅速出現。我們調查的每家大公司都預計到 1989 年底將至少擁有一個使用該技術的生產系統”。

在第二波浪潮中,以專家系統為代表的符號主義人工智能是絕對的統治者。但在火熱的專家系統之下,聯結主義和行為主義人工智能也有著重大發展。1973 年 Tsetlin 自動學習機器和遺傳算法被提出。1970 年代末到 1980 年代初,基于時間差分(Temporal Difference,TD)學習的各類條件反射心理模型被廣泛研究。同一時期,聯結主義的學者們則對神經網絡的持續研究和演進,梯度下降和導數的鏈式法則相結合的反向傳播終于被用到了多層神經網絡的訓練上。在網絡結構方面,1980 年卷積神經網絡的雛形 Neocogitron 已經出現。1982 年,論文“Neural networks and physical systems with emergent collective computational abilities”(《具有涌現集體計算能力的神經網絡和物理系統》)提出了 Hopfield 網絡。這篇論文的名字很有意思,是不是看到了一個很熟悉的名詞,對,就是“涌現”!1985 年,玻爾茲曼機(Boltzmann Machine)被提出,其作者是后來獲得圖靈獎的辛頓(Hinton)。1983 年,強化學習中的經典算法 Actor-Critic 方法將顯式地表示獨立于價值函數的策略,Actor 即用于選擇行動的策略,而“Critic”(批評家)則是對行動評估的價值函數。1986 年,限制玻爾茲曼機(Restricted Boltzmann Machine)出現,1987 年,AutoEncoder 模型被提出。1988 年,經典的強化學習模型 TD(λ) 被提出,旨在從延遲獎勵中建立準確的獎勵預測。1989 年,圖靈獎獲得者楊立昆(Yann LeCun)提出了 LeNet,這是一個 5 層的卷積神經網絡。同年,Q 學習(Q-Learning)算法被提出,它是一種無模型強化學習算法,可直接學習最優控制的方法馬爾可夫決策過程的轉移概率或預期獎勵。1991 年,循環神經網絡(Recurrent Neural Network,RNN)出現。1992 年 Q 學習的收斂性被證明。1997 年,長短期記憶網絡(Long Short-Term Memory,LSTM)被提出。

接下來,是第二波浪潮中的兩個標志性事件。其一是聯結主義和行為主義相結合的 TD-Gammon。TD-Gammon 是 IBM 利用 TD(λ) 方法訓練神經網絡而開發出的西洋雙陸棋程序,發布于 1992 年。其游戲水平略低于當時人類頂級雙陸棋玩家的水平。其二是 IBM 的深藍(Deep Blue)打敗了國際國際象棋世界冠軍卡斯巴羅夫(Гарри Кимович Каспаров)。深藍開始于卡耐基梅隆大學于 1985 年建造的國際象棋機器深思(Deep Thought)。1996 年 2 月 10 日,深藍首次挑戰國際象棋世界冠軍卡斯巴羅夫,但以 2-4 落敗。1997 年 5 月再度挑戰卡斯巴羅夫,以 3.5:2.5 戰勝了卡斯巴羅夫,成為首個在標準比賽時限內擊敗國際象棋世界冠軍的計算機系統。賽后,卡斯帕羅夫勉強地說“計算機比任何人想象的都要強大得多。”

巔峰之后,人工智能開始變冷,人工智能研究的資金和興趣都有所減少,相應的一段時間被稱之為人工智能的第二個冬天。但另一方面,從現在來看,1990 年代,深度學習和強化學習的理論與實踐已經非常成熟了,只待時機一到,就會再次爆發。《呂氏春秋·不茍論》有語“全則必缺,極則必反,盈則必虧”,人工智能的發展也如此。同樣的,否極終將泰來,持續積蓄能量的人工智能,終究爆發出第三波浪潮。

第三波浪潮

在人工智能的第二個冬天中,明星的光環照耀在互聯網浪潮之上,大量的資金投入到 Web,互聯網大發展。這個過程中,專家系統和互聯網相結合,萬維網聯盟 W3C 推動符號主義人工智能的發展。典型的代表性技術有資源描述框架(Resource Description Framework,RDF),RDFS(RDF Schema,RDFS, RDF-S 或 RDF/S)和語義網(Semantic Web),網絡本體語言(Web Ontology Language,OWL),鏈接數據(Linked Data)。同樣的,在這段時間中,許多實際和商業模式識別應用主要由非神經網絡的方法主導,如支持向量機(SVM)等方法。然而,自 1990 年代起,多層神經網絡已經成熟,只不過受限于算力太小,數據不足,而沒有廣泛應用。大約在 2006 年,多層神經網絡以深度學習的名義開始火熱起來,開啟了人工智能的第三波浪潮。

2000 年,圖靈獎獲得者 Bengio 提出了用神經網絡對語言建模的神經概率語言模型,圖神經網絡(Graph Neural Network,GNN)則在 2004 年被提出。2006 年,深度信念網絡(Deep Belief Networks,DBN)、堆疊自編碼器(Stacked Autoencoder)和 CTC(Connectionist temporal classification)相繼被提出,深度卷積網絡(LeNet-5)通過反向傳播被訓練出來,而且,第一個使用 GPU 來訓練深度卷積網絡也出現了,神經網絡和 GPU 開始聯姻。

這么多第一次,使得很大一部分人認為 2006 年是深度學習元年。此后,深度學習開始了轟轟烈烈的發展。2007 年 Nvidia 發布 CUDA,2008 年,去噪自編碼器(Denoising Autoencoder)和循環時態 RBM 網絡相繼出現。2009 年語義哈希(Semantic hashing)概念被提出,這為后來的 Word2vec 以及大語言模型打下了基礎。同年,華人深度學習的代表性人物李飛飛開始構建 ImageNet 數據集并從次年開始連續 8 年組織了計算機視覺競賽。2010 年,堆疊了 9 層的 MLP 被訓練出來。2011 年,在 IJCNN 2011 德國交通標志識別比賽中,深度卷積神經網絡模型實現了 99.15% 的識別率,超越了人類的 98.98% 識別率。這是人造模型第一次超越了人類視覺的模式識別。此后,越來越多的視覺模式匹配任務中,人類都開始落后。2012 年,深度卷積網絡在 ImageNet 的 2 萬個類別的分類任務、ICPR2012 乳腺癌組織圖像有絲分裂目標檢測競賽和電子顯微鏡(EM)層疊中的神經結構分割挑戰賽等都超越了人類水平。深度學習在 2012 年首次贏得了 1994 年以來每兩年進行一次的全球范圍內的蛋白質結構預測競賽中,這是神經網絡在這個領域第一次露出頭角,幾年之后,AlphaFold 將會徹底解決這個問題。同年“谷歌貓”帶著深度學習破圈而出,和大眾見“面”!

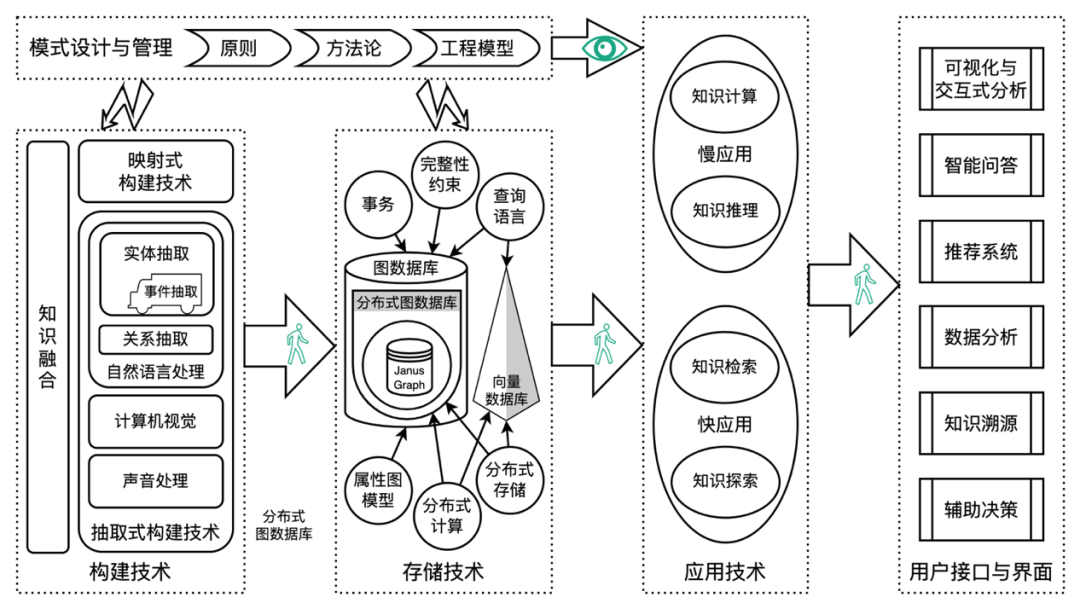

在深度學習浪潮之下,語言和知識的發展也絲毫沒有落后。大量的本體庫在這期間被構建,典型的有基因本體 GO、SUMO、DOLCE、COSMO、DBpedia、Freebase、FIBO、YAGO、NELL,Schema.org、WikiData。然而,本體庫中知識與邏輯互相交織,復雜程度高,導致不能與深度學習的研究成果相融合。2012 年 Google 將知識從本體庫中分離出來,提出了知識圖譜概念,并逐漸發展出一整套完整的體系,到十年后我創作的珠峰書《知識圖譜:認知智能理論與實戰》出版之時,該體系最終成熟(如圖 6 所示),隨后微軟、百度、搜狗等也相繼推出知識圖譜。

圖 6? 知識圖譜技術體系

圖 6? 知識圖譜技術體系

2013 年的重磅技術無疑是 Word2vec。2014 年,除了生成對抗網絡(Generative adversarial network,GAN)外,最重磅的當屬深度神經網絡在人臉識別的準確率上超越人類。這個成績先是由 Facebook 的 DeepFace 模型實現了首次接近人類表現。隨后,湯曉鷗老師帶領的團隊連續發表三篇論文,不僅超越了人類的準確率,還持續刷新成級(在此特別紀念湯曉鷗老師)。人臉識別在當時不僅迅速出圈,比如在演唱會抓逃犯的吸引眼球的新聞。同時人臉識別也迅速成為廣泛使用的身份認證的工具,比如用于火車站或者機場的身份認證等等。2016 年,經典書籍Deep Learning《深度學習》出版,語音識別的準確率開始超越人類。

然而,這幾年,最受關注的,當屬 DeepMind 開發的圍棋 AI 程序 AlphaGo,其思想與 20 多年前的 TD-Gammon 相似,融合使用了神經網絡和強化學習的方法。2015 年 AlphaGO 戰勝了職業選手樊麾,這是人工智能程序第一次戰勝圍棋職業選手。此后的 AlphaGo 加速進化,于次年(2016 年)以 4:1 的成績戰勝了曾獲得世界冠軍的職業選手李世石。2017 年,更強版本的 AlphaGo Master 以 3:0 的成績完勝當時排名世界第一的職業圍棋選手柯潔。隨后,DeepMind 在 Nature 上發表論文,推出了 AlphaGo Zero,這是一個號稱能夠以 100:0 擊敗其前任的圍棋 AI 程序。當時許多人都想起了 20 年前,IBM 深藍擊敗國家象棋世界冠軍之后,人工智能轉冷。AlphaGO 是否意味著又一次人工智能的冬天即將來臨?這是不少人的想法。

大模型浪潮

這個轉冷并沒有發生,反倒迎來了新的突破,預訓練大語言模型的出現以及其所展示出來的高度智能水平。大模型浪潮發端于 2017 年,這一年,Google 提出了變換器網絡 Transformer 和 MoE(Mixture of Expert)架構,OpenAI 和 Google 聯合提出了通過強化學習來對齊人類偏好的 RLHF 方法,以及 OpenAI 提出了用于強化學習的近端策略優化算法(Proximal Policy Optimization Algorithms PPO)。變換器網絡、MoE 架構和 RLHF 將在 2023 年大展身手,讓人們無限期待通用人工智能 AGI 的到來。

2018 年,圖靈獎頒布給在人工智能深度學習方面的杰出貢獻者 Yoshua Bengio、Geoffrey Hinton 和 Yann LeCun,這是人類對深度學習的認可,也說明了人工智能在社會方方面面所起的作用。同年,更令人興奮的則是 BERT 的出現,這是第一次在閱讀理解上超越了人類專家水平的人工智能模型。語言一直都被認為是人類智能的標志性能力,而 BERT 的語言理解能力則被認為是人工智能的一次重大突破。BERT 的另一層啟示則是證明了模型越大,能力越強,從此掀起了“規模戰爭”。同樣出現在 2018 年的還有 GPT、Mesh-TensorFlow 模型和獎勵建模(Reward Modeling)的方法。當然,它們在 BERT 的光耀之下黯然無色。

2019 年,GPT-2、ERNIE、RoBERTa、Megatron、T5 等眾多大語言模型出現。同年,強化學習和深度學習的結合使得人工智能在開放復雜的實時戰略游戲中嶄露頭角,這包括 DeepMind 的 AlphaStar 和 OpenAI 的 Five。在科學研究方面,FermiNet 用來求解近似計算薛定諤方程,在精度和準確性上都達到科研標準。2020 年,Google 提出了 Never Give Up 策略,用來求解復雜的探索博弈;微軟則發布了 Suphx 麻將 AI,接近了人類頂尖麻將玩家的水平,這是人工智能在不完全信息博弈領域的突破。

2020 年出現了非常多的大語言模型,比如 Turing-NLG、ELECTRA、CPM 等,當然,大語言模型的明星當屬 GPT-3,這是當時最大的預訓練語言模型,具備零樣本學習的能力。ViT 架構也出現于 2020 年首次將變換器網絡用于視覺任務。從此,變換器網絡開始一統深度學習領域。

2020 年最重磅的顯然是 AlphaFold,這是一個用于解決蛋白質折疊問題的人工智能系統。2021 年改進版 AlphaFold2 被認為已經解決了蛋白質折疊問題,是“令人震驚的” 和“變革性的”。2023 年最新版的 AlphaFold 不僅可以對蛋白質數據庫(PDB)中的幾乎所有分子進行預測,并能夠達到原子精度,而且還能夠預測蛋白質折疊之外的其他生物分子的精確結構,如配體(小分子)、蛋白質、核酸等。

2021 年,從圖像到文本的 CLIP 和 Forzen 等模型,從文本到圖像的擴散模型和 DALL-E 等模型,以及 V-MoE(視覺 MOE)架構等相繼出現,跨模態模型成為了新的熱點。GLaM 則是第一個參數規模高達 1T(一萬億)的模型。OpenAI 則使用 GitHub 上的大量代碼訓練了專門用于生成程序的 Codex 模型,開啟了代碼大模型的研究。更為重要的是,2021 年 6 月 29 日基于 Codex 的 GitHub Copilot 發布,這是一款跨時代的產品,極大地提升了程序員的工作效率。

時間來到了 2022 年。首先是 OpenAI 推出了 InstructGPT,這是在無監督預訓練語言模型 GPT-3 之上,使用有監督微調、獎勵模型、人類反饋的強化學習 RLHF 等多種方法加以優化的模型,也被稱之為 GPT-3.5。在 GPT-3.5 之上,OpenAI 于 2022 年 11 月 30 日推出的 ChatGPT,它是一個被許多人認為是能夠通過圖靈測試的聊天機器人。ChatGPT 的推出迅速出圈,發布僅兩個月就有 1 億用戶參與狂歡,成為有史以來用戶增長最快的產品。

2022 年還有幾個關鍵的成果,這包括 MoE 架構中的 Expert Choice Routing 方法,在 Chinchilla 中國年探討的規模法則,即大模型的參數規模、訓練語料的規模以及計算量之間的關系,對齊了語言和視覺的 Flamingo 多模態大模型等。另外,一篇“Emergent Abilities of Large Language Models”(《大語言模型的涌現能力》)發布,讓圈內外的人大談“涌現”。還記得 1982 年的那個“涌現”么?2023 年,好風(ChatGPT)憑借力,全球范圍內開始了百模大戰。OpenAI 升級了 ChatGPT,推出了 GPT-4、GPT-4v 和 ChatGPT-4,并圍繞著 ChatGPT 推出了 ChatGPT Plugins、Code Interpreter、GPT Store、GPT Team 等。同時,微軟基于 OpenAI 的 GPT-4,推出了 Bing Chat(后來改名為 Bing Copilot)、Office Copilot 等產品。Google 則推出了 Bard、Gemini,Meta 推出了 LLaMA、LLaMA2 等,Twitter 推出了 X.ai 和 Grok。國內的百模大戰更是激烈,截止 2024 年 1 月,國產大模型超過 200 個。典型的國產大模型有百度的文心一言、智譜華章的清言、阿里云的通義千問、上海人工智能實驗的書生、達觀數據的曹植,深度求索的 Deepseek Coder、科大訊飛的星火、抖音的豆包等。在產品方面,字節跳動也推出了 Coze,這是類似 GPT Store 一樣的產品。除了大模型之外,Google 在 2024 年初提出的 AlphaGeometry 極大地提升了數學領域的推理能力,這是一個才用了神經符號學的方法,是聯結主義和符號主義相融合的模型。

通用人工智能的到來?

1951 年,圖靈發表的一個演講“Intelligent Machinery, A Heretical Theory”(《智能機器:一種異端理論》)中提到“一旦機器思考的方法啟動,它很快就會超越我們脆弱的能力。機器不會死亡,他們能夠相互交互來提升彼此的智慧。因此,就跟我們預期的一樣,機器將會掌控一切。”但真如同圖靈預期的那樣了么?70 多年過去了,圖靈所預期的那個機器掌控一切的時代仍未到來。

2022 年底,ChatGPT 再一次掀起了人們對人工智能的極大范圍的討論,而這一次,人工智能將會走向何處?顯然,人們觀點并不一致,就連圖靈獎獲得者辛頓和楊立昆的立場也完全相反。辛頓認為通用人工智能將會很快到來,他致力于通用人工智能向善、通用人工智能與人類的和平共處。而楊立昆則相反,認為大模型固然能力很強大,但大模型的原理決定了它無法產生通用人工智能。而我認為大模型給通用人工智能帶來了曙光,但這條路真的能實現通用人工智能么?我也沒有答案。我曾經對符號主義人工智能的歷史進行了深度的研究,這一次我仍然相信“以史為鑒,可以知興替”。于是乎,我轉向歷史,去尋找蛛絲馬跡,尋找能夠指引未來的那道亮光,而這篇文章算是一個總結。

當然,現在我仍然沒有答案。但我發現,在前面兩波人工智能浪潮中,樂觀者跟辛頓所代表的樂觀者一樣,人們多次預期機器智能超越人類,但隨后并未實現。我也發現,每一波人工智能浪潮,都在前一波浪潮的基礎之上,應用面更為廣泛,影響更為深遠。

但是有一點,單純依靠大模型是無法實現通用人工智能的。從前面所介紹的歷史來看,符號主義、行為主義和聯結主義,都是智能的一部分在人工智能學科上的體現。也就是說,人工智能三大范式的融合,是實現通用人工智能的基礎。這點與我一直在普及的“大模型+知識圖譜+強化學習”的理念是一致的。另一方面作為實干家、實踐者,我認為,不管通用人工智能是否能到來,至少在應用上,現階段的人工智能是一個新的起點。未來 10 年,人工智能在全社會全人類的應用上具有無限的可能、無限的機遇。大家可以想象一下,千行百業都在大模型、知識圖譜等人工智能技術的幫助下,生產力成倍地提升,社會價值和經濟價值是多么巨大!

當然,現階段,有許多問題在不斷地被討論。但事實上,這些問題在前兩波浪潮中同樣被不斷討論。比如人工智能是否會取代某些職業(比如醫生等),事實上是絕大多數職業至今并未消失,而是在人工智能產品的幫助下更好地服務人類,制造出更高級的產品等。又比如,這種強大的產品危害人類的問題,但危害人類的并非這些產品,而是一部分人類利用這些產品對另一部分進行傷害。對此,我覺得,既要以史為鑒,但也不能刻舟求劍。同時,我一邊期待一邊呼吁,科技向善,人工智能向善!

當然,還有很多很多關于智能的未解之謎有待我們去探索。知識從何而來?人類為何而智能?心智是如何從物理大腦中產生的?智能是否可以計算?人類是否能夠在并不了解自身智能的原理下制造出真正智能的機器?人類智能真的和現在這些人工智能算法相似么?人工智能如何幫助我們更好地理解人類自身?至今我仍然未能看到答案。這或許是進化論最偉大的奧秘。

審核編輯:劉清

-

神經網絡

+關注

關注

42文章

4765瀏覽量

100566 -

人工智能

+關注

關注

1791文章

46896瀏覽量

237669 -

神經元

+關注

關注

1文章

363瀏覽量

18441 -

OpenAI

+關注

關注

9文章

1045瀏覽量

6411

原文標題:“單純靠大模型無法實現 AGI”!萬字長文看人工智能演進 | 新程序員

文章出處:【微信號:AI科技大本營,微信公眾號:AI科技大本營】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

單日獲客成本超20萬,國產大模型開卷200萬字以上的長文本處理

嵌入式和人工智能究竟是什么關系?

《AI for Science:人工智能驅動科學創新》第一章人工智能驅動的科學創新學習心得

人工智能ai4s試讀申請

名單公布!【書籍評測活動NO.44】AI for Science:人工智能驅動科學創新

FPGA在人工智能中的應用有哪些?

人工智能模型有哪些

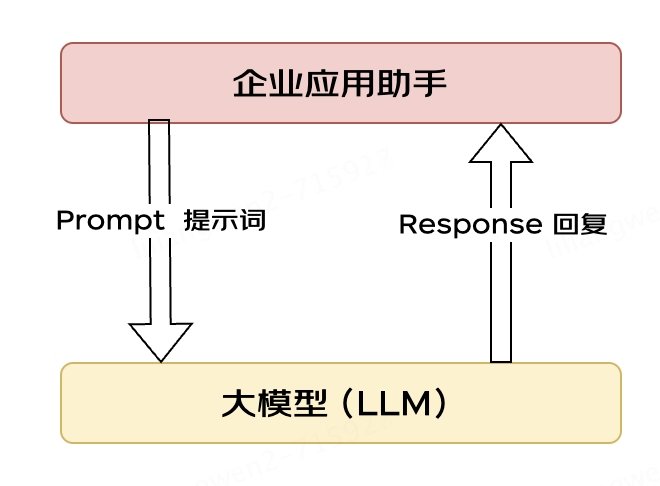

大模型應用之路:從提示詞到通用人工智能(AGI)

“單純靠大模型無法實現 AGI”!萬字長文看人工智能演進

“單純靠大模型無法實現 AGI”!萬字長文看人工智能演進

評論