AIGC的這把火,燃起來的可不只是百模大戰的熱度和雨后春筍般的各式AI應用。

更是由于算力與通信需求的爆發式增長,使得底層的專用加速芯片、以及配備這些芯片的AI加速服務器再次被拉到了大眾的聚光燈下。

據統計,2023年全球范圍內的AI服務器市場規模已經達到了211億美元,并且IDC還發布預測說:

預計2025年達317.9億美元,2023-2025年CAGR為22.7%。

AIGC大模型的訓練和推理需要大量的高性能算力支持,對AI服務器需求還將提升。

而且AI加速服務器不同于普通服務器,在架構上一般采用異構的方式,且GPU的數量更是能配多少就配多少,這也就是造成目前GPU千金難求的因素之一。

但你知道嗎?即使在大模型時代GPU或各式AI加速芯片的光芒變得更加耀眼,但對于AI基礎設施來說,CPU依然是必不可少的存在——至少一臺高端的AI加速服務器中每8個GPU就需得搭配2個CPU。

不僅如此,由于AI加速服務器異構的特點,市場上除了CPU+GPU的組合方式之外,還有其它多種多樣的架構,例如:

CPU+FPGA CPU+TPU CPU+ASIC CPU+多種加速卡

不難看出,即使AI加速服務器架構的組合方式萬般變化,唯獨不能變的就是CPU,而且往往還得是搭配高端的那種。

那么為什么會這樣呢?

AI加速服務器中的CPU

首先,CPU對于AI加速服務器來說相當于人的大腦。

它可以負責整個服務器的運算與控制,是直接影響到服務器整體性能的核心部件。

CPU處理操作系統的指令,協調各個硬件組件的工作,包括內存管理、數據流控制和I/O操作。

即使在AI服務器中,GPU或其他加速器負責執行大部分計算密集型任務,CPU仍然是不可或缺的,因為它確保了整個系統的穩定運行、各組件的高效通信協作,最終推進任務的順利執行。

其次,CPU還具備靈活性和通用性。

CPU的設計一般為通用處理器,能夠執行各種類型的計算任務。

雖然GPU在并行處理方面更為高效,但CPU在處理序列化任務、執行復雜邏輯和運行通用應用程序方面更為靈活。

真正完整的AI應用平臺其實需要處理一系列密切相關又特色各異的任務,包括數據預處理、模型訓練、推理和后處理等,這些任務也可能甚至特別需要CPU的通用處理能力。

不僅如此,CPU還是系統啟動和維護的關鍵點。

因為服務器的啟動過程、系統監控、故障診斷和維護操作都需要CPU來執行;沒有CPU,這些關鍵的系統級任務將無法進行。

而且CPU在軟件兼容性方面更是有積累多年的優勢。

市面上大多數軟件和應用程序都是為CPU設計的,包括操作系統、數據庫管理系統和開發工具。AI加速服務器需要運行這些軟件來支持AI應用的開發和部署。

也正如我們剛才所說,現在AI加速服務器均是采用異構的形式,CPU在此過程中可以作為控制節點,管理GPU或其他加速器的計算任務,以此來實現高效的資源分配和任務調度。

最后,便是成本的問題。

雖然GPU在AI計算中非常高效,但CPU或其他專用加速芯片仍然是成本效益較高的選擇,特別是在處理不適合GPU或加速器的任務時。CPU和它們的組合可以提供更佳的性能和成本平衡。

這也就不難理解為什么AI加速服務器里唯獨不能缺少CPU了。

那么接下來的一個問題便是,主流的服務器廠商都在用什么樣的CPU。

我們以國內AI加速服務器市場份額排第一的浪潮為例,從最新消息來看,其NE5260G7服務器便已經適配了老牌芯片巨頭英特爾最新發布的第五代英特爾 至強 可擴展處理器。

而之所以浪潮要適配最新的高端CPU,可以理解為“高端的游戲需要搭配高端GPU和CPU”,AI服務器要想在性能上取得新突破,同樣也是要適配高端的硬件。

具體而言,與前一代相比,第五代英特爾 至強 可擴展處理器在處理人工智能工作負載方面表現出色,其性能提升了21%,特別是在AI推理任務上,性能增幅更是達到了42%。

此外,它的內存帶寬也增加了16%;在執行一般計算任務時,第五代至強 可擴展處理器能夠將整體性能提高至多21%,并且在多個客戶實際工作負載中實現了每瓦特功耗性能提升高達36%。

也正因“內核”如此強悍,才使得浪潮的服務器在性能上實現了平均21%的提升。

不過有一說一,畢竟AI也不完全就是單純的模型或大模型的加速,因此上述的CPU優勢也還僅是能力的一隅,在各個細分的應用場景中,它還有更大的作為。

AI不完全是大模型

即使在配備了GPU或專用加速器的AI服務器中,CPU的角色也遠不止于主控或為加速器提供服務。

而是在AI系統的整個生命周期中扮演著多樣化的角色,貫穿從數據采集、預處理、訓練、推理、應用等全流程。

先說最關鍵的AI模型,尤其是模型推理這一環節。

不論是現在占據最強話題熱度的大語言模型,還是傳統的深度學習模型,抑或是科學計算與人工智能交融形成的AI for Science應用,CPU,特別是內置AI加速能力的英特爾 至強 可擴展處理器,都在推理應用中有不俗戰績。

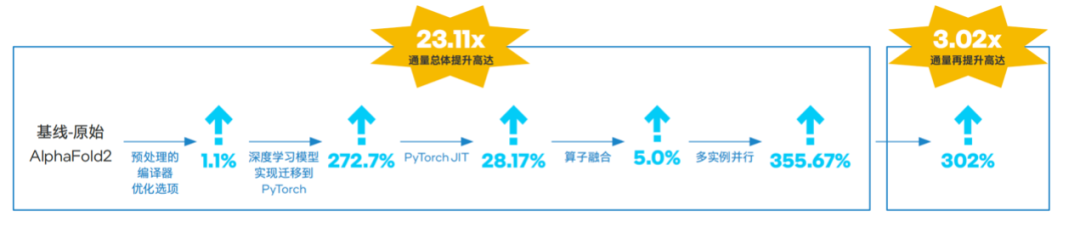

例如在AlphaFold2掀起的蛋白質折疊預測熱潮之中,借助第三代和第四代至強 可擴展處理器不斷優化端到端通量能力,就能實現比GPU更具性價比的加速方案,直接拉低AI for Science的入場門檻。

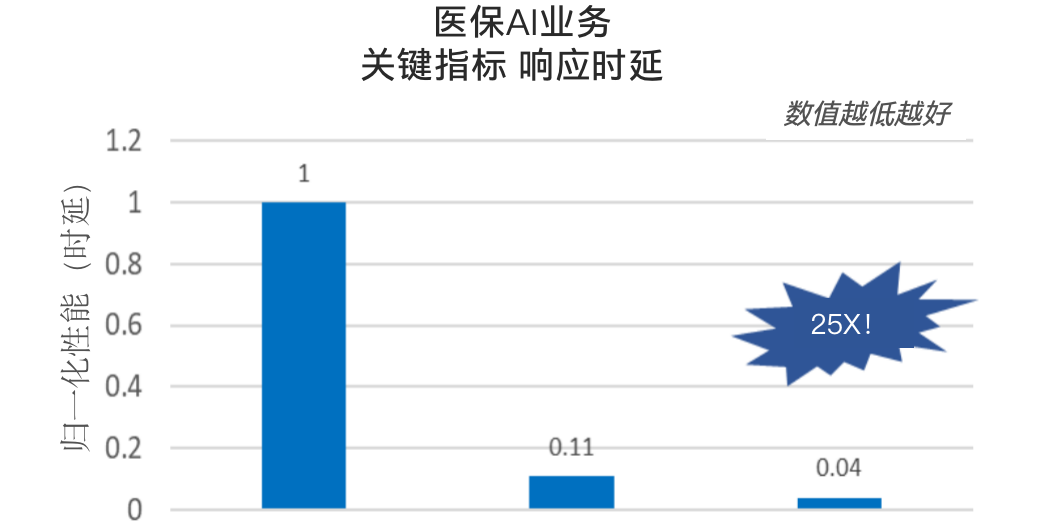

再例如OCR技術應用,也隨著至強 可擴展處理器在內置AI加速技術上的演進,被賦予了新的“靈魂”,不但準確率飆升、響應延遲也進一步降低。

更別提以ChatGLM為代表的通用大模型,以及衛寧、惠每等行業軟件或解決方案提供商輸出的行業特定場景的大模型應用,它們都提供了有力的實踐佐證,能驗證至強 在大模型推理上的實力,以及相比加速器芯片更優的成本,以及更易獲取,更易部署、優化和使用的優勢。

不信你就瞧瞧我們的最“In”AI專區 ,來刷新一下認知。

再說AI全流程中大量涉及數據處理的環節。

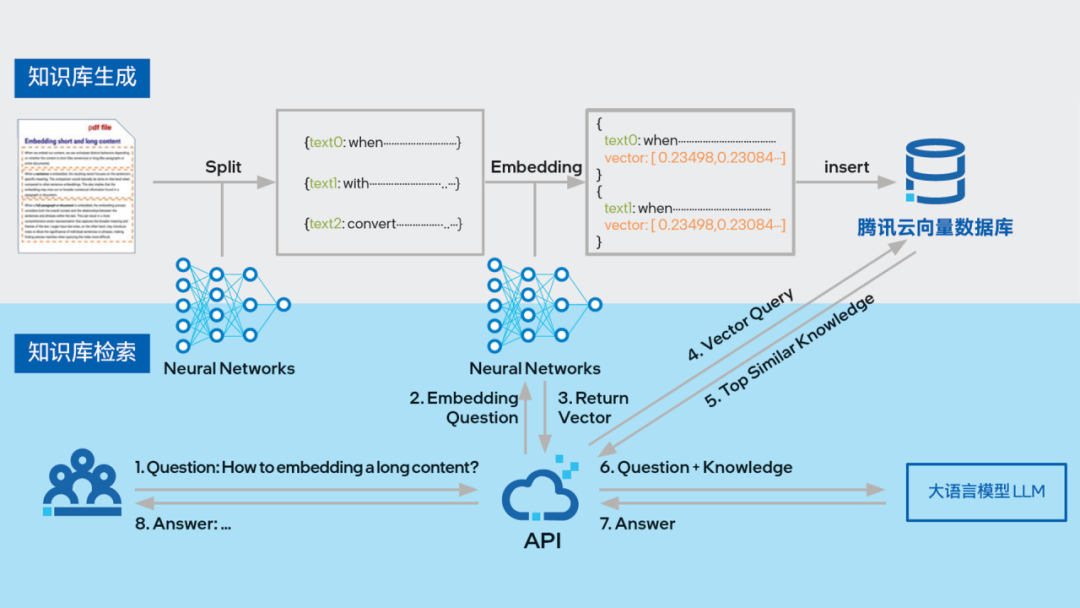

實際業務中的AI應用,背后往往需要包含大量數據的知識庫作為支撐。

這些數據通過將海量文本語料壓縮成密集向量的形式存儲,并通過高效的相似度搜索迅速找到與查詢最相關的信息,也就是大家所熟知的向量數據庫了。

在這方面,專門針對向量和矩陣計算優化的英特爾 AVX-512指令集和英特爾 AMX加速技術有了用武之地,可應對海量、多維向量數據的高并發和實時計算等挑戰。

業界知名的向量數據庫開發商如騰訊云和星環科技等,底層都選擇第五代英特爾 至強 可擴展處理器作為承載和加速的平臺。

騰訊云VectorDB與英特爾合作,在第五代至強 平臺經軟硬件雙方面優化后,在提升向量數據庫的向量檢索效率方面相比基準組提升了約2.3倍,在使用英特爾 AMX 加速數據格式為INT8的測試場景中再次性能提升達約5.8倍。

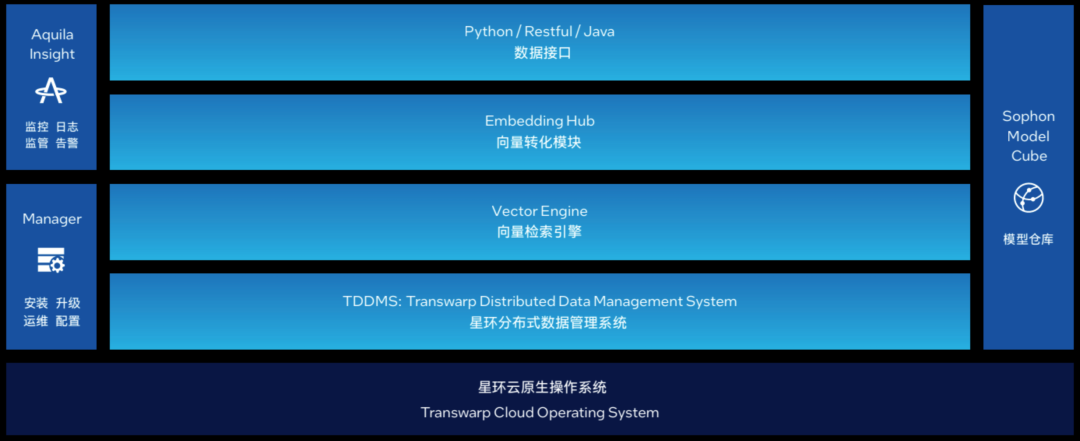

星環科技則基于第五代至強 可擴展處理器推出了Transwarp Hippo 分布式向量數據庫解決方案,實現了約2倍的代際性能提升,可有效滿足大模型時代海量、高維向量的存儲和計算需求。

△ 圖:星環科技分布向量數據庫Transwarp Hippo產品架構

AI全流程中與數據相關的環節,不止包含可用作大模型外部知識庫的向量數據庫這一種。還涉及模型訓練前數據預處理,訓練中的數據調度,模型上線后的持續優化和維護、異常數據的發現和處理等。

眾所周知,數據是AI三要素之一,相當于AI的血液和原料,沒有優質的數據,再先進的算法和模型也是空中樓閣。但原始數據往往參差不齊,需要通過數據清洗、轉換、特征工程等一系列流程,最終才能為AI系統所用。

這些數據處理任務涉及海量邏輯運算,以及同樣、甚至更大量級的內存操作,如存取、傳輸,對處理速度和時延要求都非常高,因此通常也是由最離系統內存最近、更擅長通用計算的CPU來承擔。

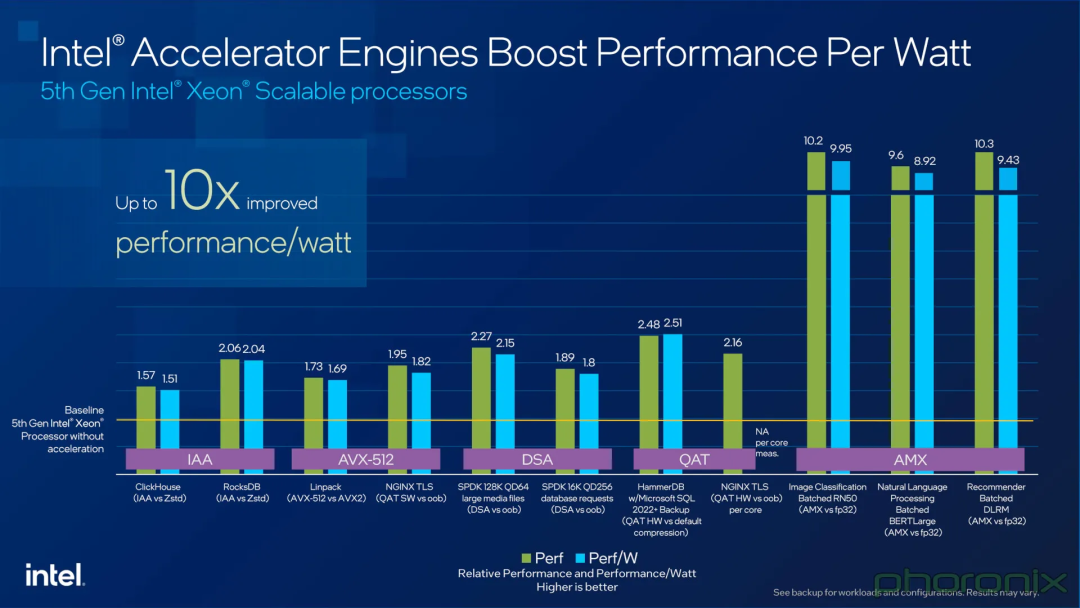

第五代英特爾 至強 可擴展處理器充分考慮到這些需求,內置多款加速器來為數據處理提供支持,如:

DSA數據流加速器(Data Streaming Accelerator):負責優化數據復制和轉換操作,提高網絡和存儲性能。 IAA存內分析加速器 (In-Memory Analytics Accelerator):提高分析性能,同時卸載CPU內核任務以加速數據庫查詢吞吐量等工作負載。 QAT數據保護與壓縮加速技術(QuickAssist Technology):可顯著加速數據壓縮、對稱和非對稱數據加密解密,提高CPU效率和整體系統性能。 DLB動態負載均衡器(Dynamic Load Balancer),幫助防止性能瓶頸并實現低時延控制平面工作負載。

在第五代至強 可擴展處理器的不同細分型號中,對上述加速器有靈活的配置或支持方案,并且還支持通過Intel On Demand按需啟用,可以適應不同工作負載的需求。

最后,還特別要提到的對數據隱私、模型和應用安全的更優防護,畢竟所有AI場景都不能以犧牲安全為代價,更是有些AI應用場景對此格外在意,如在金融、醫療行業。

對這些行業場景來說,能用上基于CPU實現的硬件級可信執行環境(TEE)技術來保護敏感數據和代碼免受攻擊可是非常關鍵的。

如平安科技,就曾使用英特爾 Software Guard Extensions(英特爾 SGX)構建聯邦學習解決方案。

平安科技通過英特爾 SGX的“飛地”內存區域,在本地安全地執行模型訓練,而無需共享原始數據。同時SGX支持安全的多方計算協議,如同態加密、安全聚合等,從而在聯邦學習中實現了更優的隱私保護。

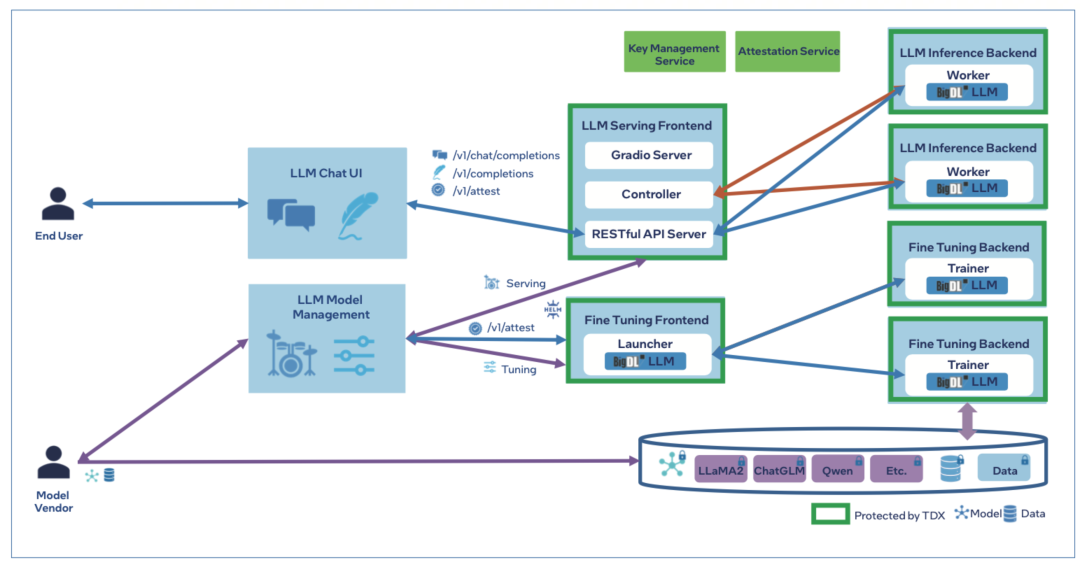

阿里云則基于最新第五代英特爾 至強 可擴展處理器推出了BigDL-LLM 隱私保護方案。

它在這款全新處理器內置的英特爾 Trust Domain Extension (英特爾 TDX)技術的加持下實現了對分布式節點或 AI管道的更優防護,從而能讓客戶在不犧牲數據隱私的前提下將更多數據運用到 AI 應用中,有效挖掘數據價值,為客戶構建更為高效的隱私保護機器學習方案,助力大模型的廣泛應用。

△ 圖:采用英特爾 TDX的BigDL-LLM服務和調優架構

要知道,基于 TEE 的聯邦學習或隱私保護機器學習技術,可是未來AI在大規模實踐中打通和共享多機構數據的一大基座。

通過這種技術,不同機構之間才能在保證數據安全和隱私的前提下,實現數據的共享和聯合分析,才能為 AI 的持續發展演進提供更加豐富和全面的數據支持。

搞好AI全流程加速

CPU不能是短板

所以,讓我們從單純的模型加速,將眼界擴展到更全面、多維、流水線化的AI平臺應用,不難預見,隨著這種平臺級應用的成熟與走向實戰,我們對小到AI加速服務器,大到AI基礎設施的期望也在不斷拓展和升級。

僅僅關注AI模型本身以及GPU、專用加速器的性能,會越來越像一個單點化的思維。

未來大家必須更重視整個AI平臺中多種硬件與軟件的搭配及協同工作,這其中CPU作為主控、加速、輔助的多面手,對于補齊整個平臺的短板,提升整個平臺的質量至關重要。

這或許就是在如今的技術浪潮下,以第五代英特爾 至強 可擴展處理器為代表的高端CPU,依然會在AI服務器或基礎設施市場中贏得一席之地的根因。

畢竟,高端CPU的作用不僅是直接上手加速AI推理,還關系到整個AI平臺或系統整體性能的提升,更是提供更加穩定和安全的運行環境來拓展AI的邊界,只有這幾個環節都照顧到,才能推動AI Everywhere愿景進一步走向現實。

或者簡言之,AI如果要真正走向更多的實用場景,又怎么能少得了更強大、更可靠、更全面多能的CPU呢?

文章轉載自:量子位

作者:金磊 夢晨

審核編輯:劉清

-

處理器

+關注

關注

68文章

19168瀏覽量

229153 -

人工智能

+關注

關注

1791文章

46872瀏覽量

237593 -

GPU芯片

+關注

關注

1文章

303瀏覽量

5781 -

AI加速器

+關注

關注

1文章

68瀏覽量

8629

原文標題:最“in”AI | 為什么說GPU再火,AI平臺也少不了強力的CPU

文章出處:【微信號:英特爾中國,微信公眾號:英特爾中國】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

CPU\GPU引領,國產AI PC進階

【「算力芯片 | 高性能 CPU/GPU/NPU 微架構分析」閱讀體驗】--全書概覽

Arm發布針對旗艦智能手機的新一代CPU和GPU IP

CPU渲染和GPU渲染優劣分析

為什么說GPU再火,AI平臺也少不了強力的CPU?

為什么說GPU再火,AI平臺也少不了強力的CPU?

評論