人工智能正在影響幾乎所有可以想象的應用領域,但它越來越多地從數據中心data center轉移到邊緣edge,在那里需要比過去更快地處理大量數據。

這要求在更接近數據源的地方大幅提高性能,但仍然只能使用非常少的功耗,并且價格便宜。雖然訓練將繼續在云中進行,但長距離移動大量數據的成本很高,所以邊緣AI計算的價值很大。本地處理的數據越多,成本就越低,獲得結果的時間就越快。

實現這些好處并不容易,需要更深入地了解正在處理的數據類型,這在過去五年中只在大型數據中心中考慮,谷歌、特斯拉、Meta 等公司為這個考慮的特定需求設計定制芯片。

在邊緣,才剛剛開始關注AI需求并定義滿足這些需求的必要功能。

在邊緣添加功能以滿足其他潛在AI市場是很誘人的,但這通常會導致面積、功耗和復雜性增加,從而損害芯片主要應用的性能。對于邊緣計算,需要嚴苛地看待所有功能,以判斷它們是否真的需要出現在芯片中。

每個新功能都會影響 PPA,因此保持對目標市場和場景的關注是首要考慮的事情。

在邊緣處理的最大好處是低延遲。當某一天必須實時(或快速)需要AI計算做出決定時,邊緣AI計算真的會大放異彩。

盡管邊緣和AI都有很大的前景,但是組合起來的應用場景和現在的主流有很大差異,在設計過程中有更多的Tradeoffs。需要考慮芯片的供電方式、熱限制、是否需要支持訓練或推理、精度要求、芯片部署的環境以及支持的數字格式。例如:

1、支持更多的功能集意味著增加面積和功耗,并在不使用功能時增加門控功能的復雜性。由于數據移動會影響性能并消耗大量功耗。

2、設計人員需要充分了解需要移動多少數據,以開發能夠最大限度地減少邊緣數據移動的架構。

做出正確的選擇

不同的應用場景將會有不同的Tradeoffs,需要圍繞傳遞給邊緣人工智能處理器的數據的數量和類型做出一系列決策。

芯片是只接收推理數據,還是包括模型更新?芯片是否需要根據看到的特定數據進行訓練或微調?該處理器還與哪些其他芯片和系統通信,頻率如何?芯片是否會長時間處于非活動狀態,在此期間進入深度power-down模式,還是大部分時間都處于開啟狀態?這些問題的答案將推動對計算引擎架構、片上SRAM存儲以及是否使用外部DRAM(以及類型和容量)的決策。

人工智能處理一般只在發生某些事件發生時進行推理,兩個最重要的技術是動態電壓和頻率調節(dynamic voltage and frequency scaling(DVFS)) 和low-leakage library 。DVFS 在需要時提供高性能,然后在不需要時降低電源電壓和工作頻率。low-leakage library,特別是嵌入式SRAM,需要占據很大比例的系統功耗。這兩者是相互作用的。DVFS受限于其電源電壓降低的水平。這幾乎總是由SRAM工作的最小電壓決定的,或者在待機狀態下,SRAM仍將保留數據但不讀取或寫入的最小電壓(稱為Vmin)。由于功耗與電壓的平方成正比,因此將Vmin從0.7V降低到0.5V將使SRAM功率減半。

另一個問題是,人工智能是一項快速變化的領域,因此除了在功耗、性能和面積/成本之間取得適當的Tradeoff外,還需要在設計中內置靈活性。

一方面,早已存在像CPU這樣通用的東西,它為你提供了最大的編程靈活性,但可能具有最大的面積和最差的能效。另一方面,也存在有固定功能的硬件加速器,它們具有最佳的面積和功耗組合,但幾乎沒有設計后調整的靈活性。如果在設計流片后規格或工作負載要求發生變化,則在不進行重新流片的情況下,幾乎沒有辦法修改。

從靈活性到效率,從CPU到GPU,再到DSP、NPU,最后是ASIC。實際的選擇也取決于市場的成熟度和要求,對應的場景是否需要考慮靈活性,考慮什么維度的靈活性?這是一個問題?

自動駕駛和手機終端發展速度很快,一直在增加新的需求,因此使用NPU或NPU+DSP是靈活性、性能和能源效率的最佳組合。

工藝技術也是一個重要的因素,可以進行功耗、性能、面積/成本 (PPA/C) 的權衡。

獲得更好的PPA的最簡單方法是通過使用最先進的工藝節點。但是有很多問題。它通常非常昂貴,并且缺乏嵌入式非易失性存儲器,而這通常是物聯網設備的必備。

審核編輯:黃飛

-

cpu

+關注

關注

68文章

10824瀏覽量

211131 -

sram

+關注

關注

6文章

763瀏覽量

114631 -

AI

+關注

關注

87文章

30106瀏覽量

268399 -

人工智能

+關注

關注

1791文章

46845瀏覽量

237535 -

ChatGPT

+關注

關注

29文章

1548瀏覽量

7487

原文標題:邊緣設備上的chatGPT

文章出處:【微信號:數字芯片實驗室,微信公眾號:數字芯片實驗室】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

探索ChatGPT的信息抽取能力

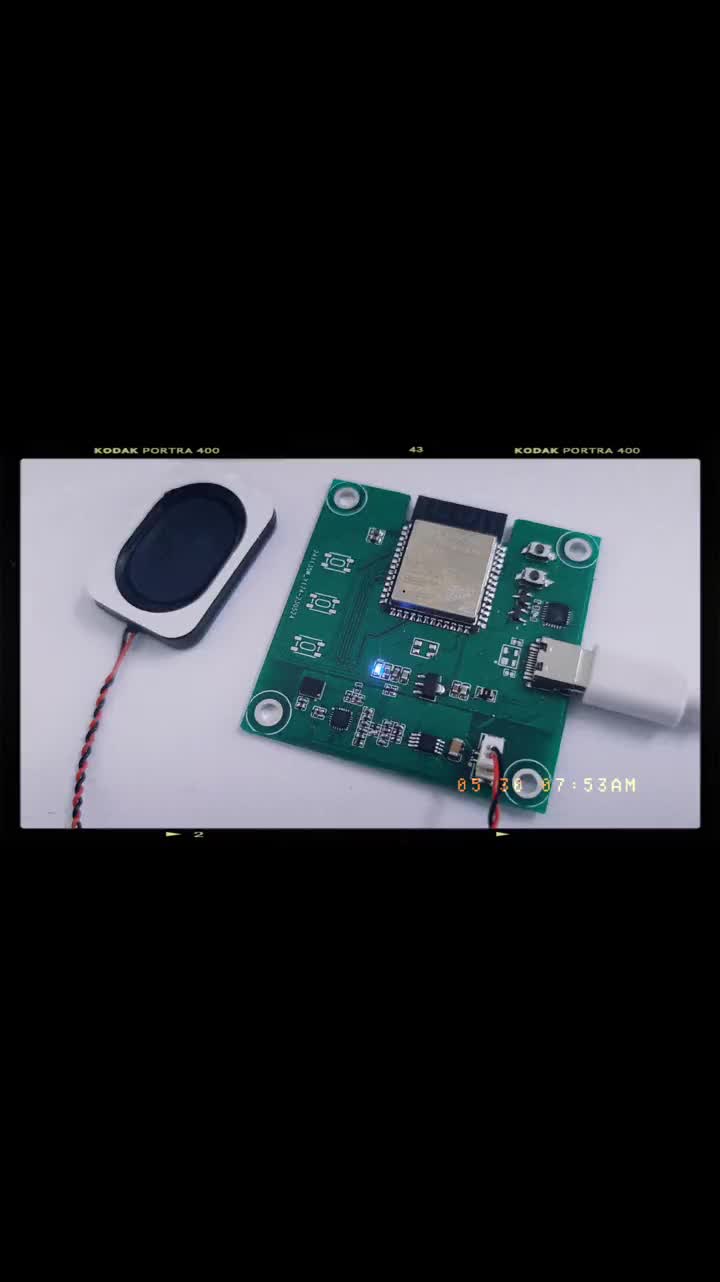

部署在邊緣設備上的輕量級模型

【國產FPGA+OMAPL138開發板體驗】(原創)6.FPGA連接ChatGPT 4

在FPGA設計中是否可以應用ChatGPT生成想要的程序呢

OpenAI 深夜拋出王炸 “ChatGPT- 4o”, “她” 來了

在IC設計/驗證中怎么應用ChatGPT呢?

科技大廠競逐AIGC,中國的ChatGPT在哪?

如何選擇邊緣AI設備

10分鐘教你如何ChatGPT最詳細注冊教程

ChatGPT在智能投顧領域的應用

在Python里使用ChatGPT

PyCoach 對ChatGPT的探索分析

ChatGPT Plus怎么支付 開通ChatGPT plus有什么功能?

ChatGPT在邊緣設備的應用探索

ChatGPT在邊緣設備的應用探索

評論