佐思汽研發布《2024年端到端自動駕駛研究報告》。

1

國內端到端方案現狀

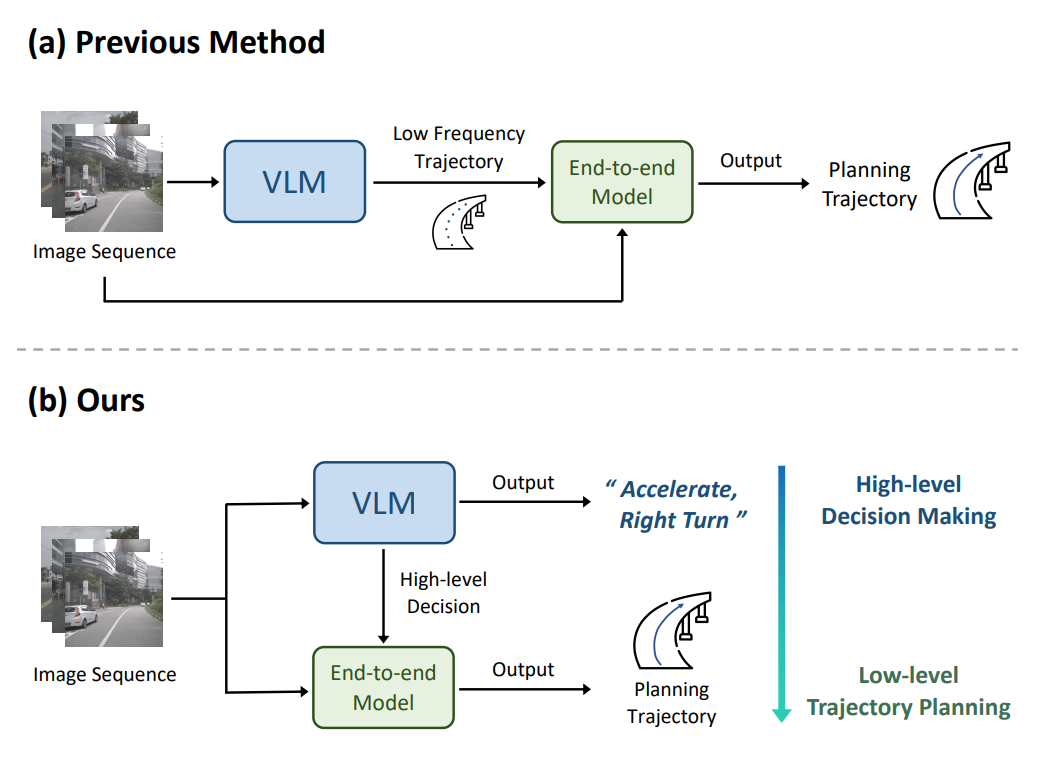

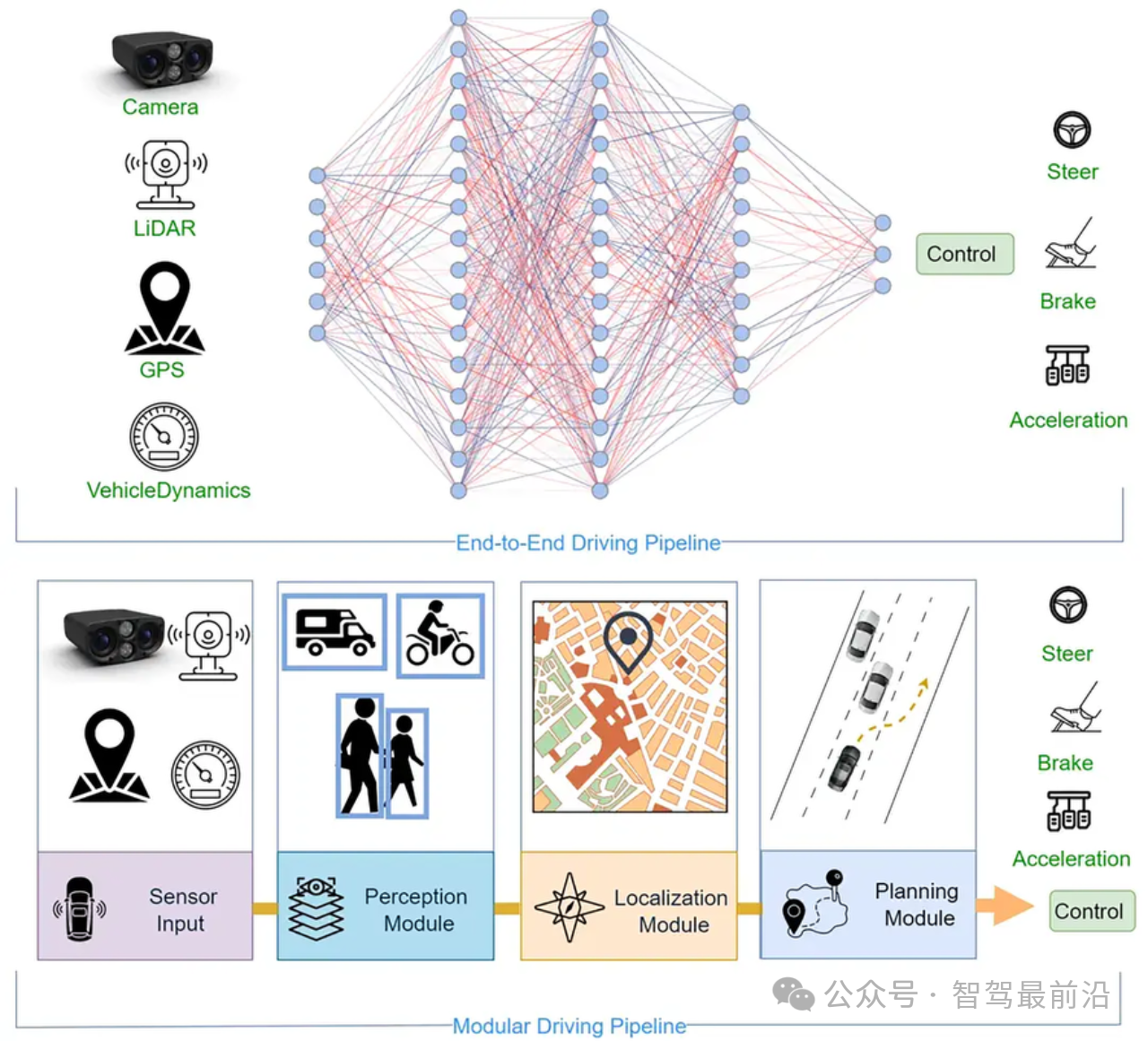

端到端自動駕駛是直接從傳感器信息輸入(如攝像頭圖像、LiDAR等)到控制命令輸出(如轉向、加減速等)映射的一套系統,最早出現在1988年的ALVINN項目,通過相機和激光測距儀進行輸入和一個簡單的神經網絡生成的轉向進行輸出。

2024年初,特斯拉FSD V12.3版本發布,智駕水平讓人驚艷,端到端自動駕駛方案受到國內主機廠和自動駕駛方案企業的廣泛關注。

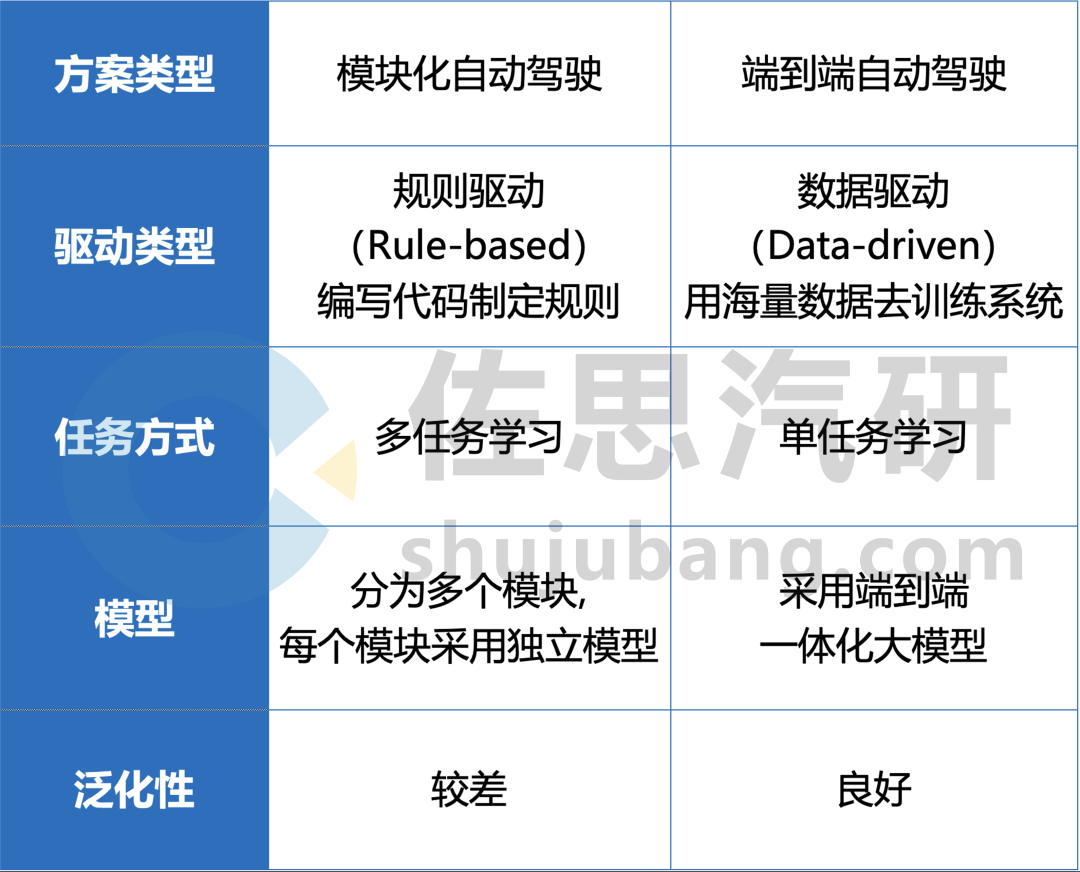

與傳統的多模塊方案相比,端到端自動駕駛方案將感知、預測和規劃整合到單一模型中,簡化了方案結構,可模擬人類駕駛員直接從視覺輸入做出駕駛決策,以數據和算力為主導,能夠有效解決模塊化方案的長尾場景,提升模型的訓練效率和性能上限。

傳統多模塊方案與端到端方案的對比(部分)

來源:佐思汽研《2024年端到端自動駕駛研究報告》

FSD V12.3版本實測圖

來源:公開渠道

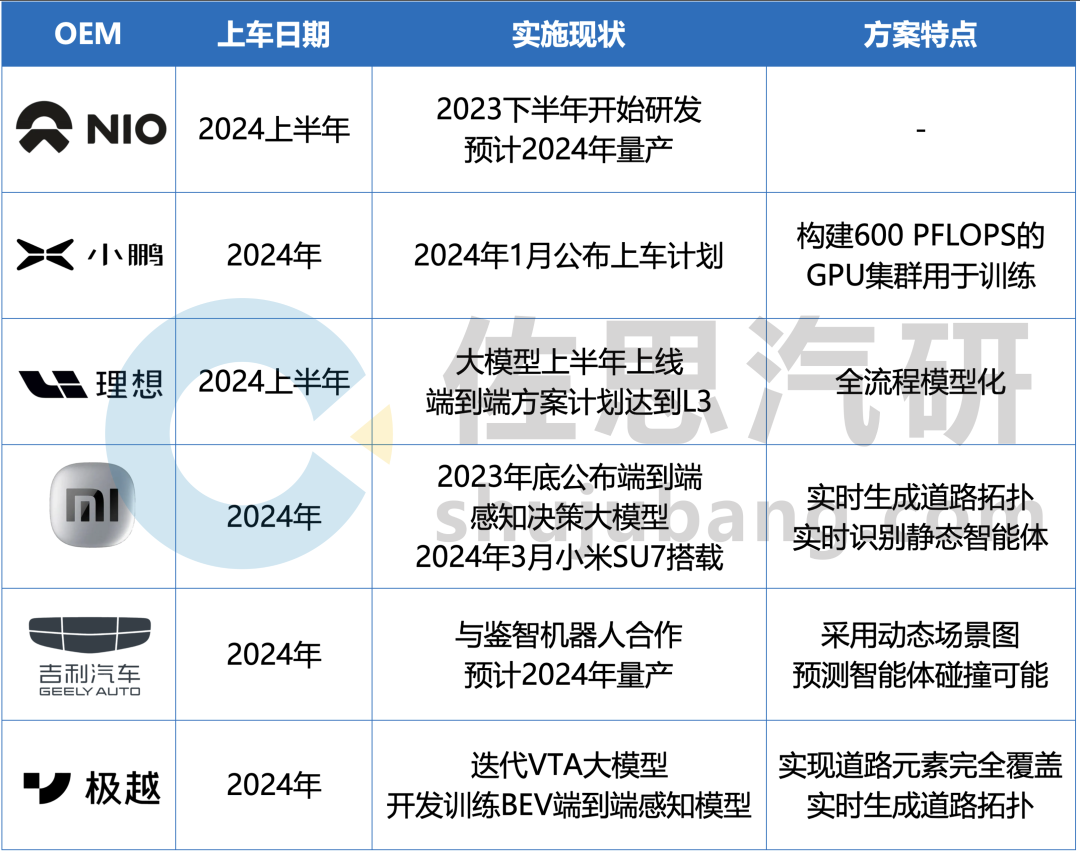

部分主機廠對端到端方案落地量產的規劃

來源:佐思汽研《2024年端到端自動駕駛研究報告》

理想端到端方案

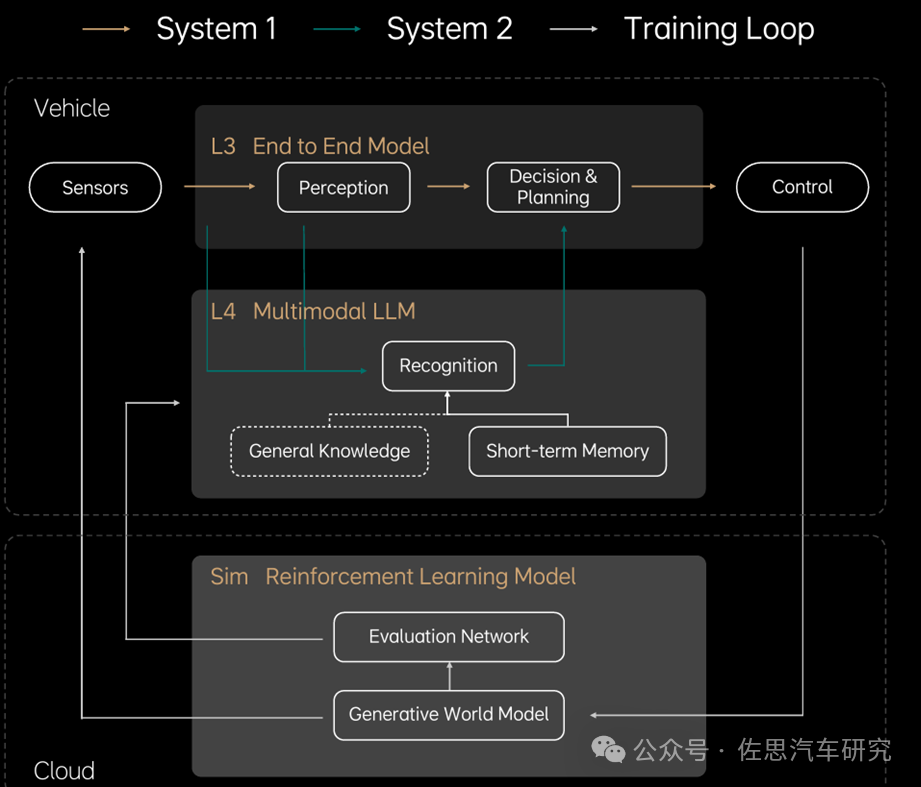

理想認為,完整的端到端需要完成感知、跟蹤、預測、決策、規劃整個過程的模型化,是實現L3級別自動駕駛的最佳方案。2023年,理想推送AD Max3.0,其整體框架已經具備端到端的理念,但距離完整的端到端尚有一定差距,2024年理想預計以此為基礎,推進該系統成為一個徹底的端到端方案。

理想構建的自動駕駛框架如下圖,分為兩個系統:

快系統:System1,感知周圍環境后直接執行,為理想現行的端到端方案。

慢系統:System2,多模態大語言模型,針對未知環境進行邏輯思考與探索,以解決L4未知場景下的問題。

理想自動駕駛框架

來源:理想汽車

在端到端方案推進的過程中,理想計劃把規劃/預測模型與感知模型進行統一,并在原基礎上完成Temporal Planner的端到端,實現泊車/行車一體化。

2

數據成為端到端落地的關鍵

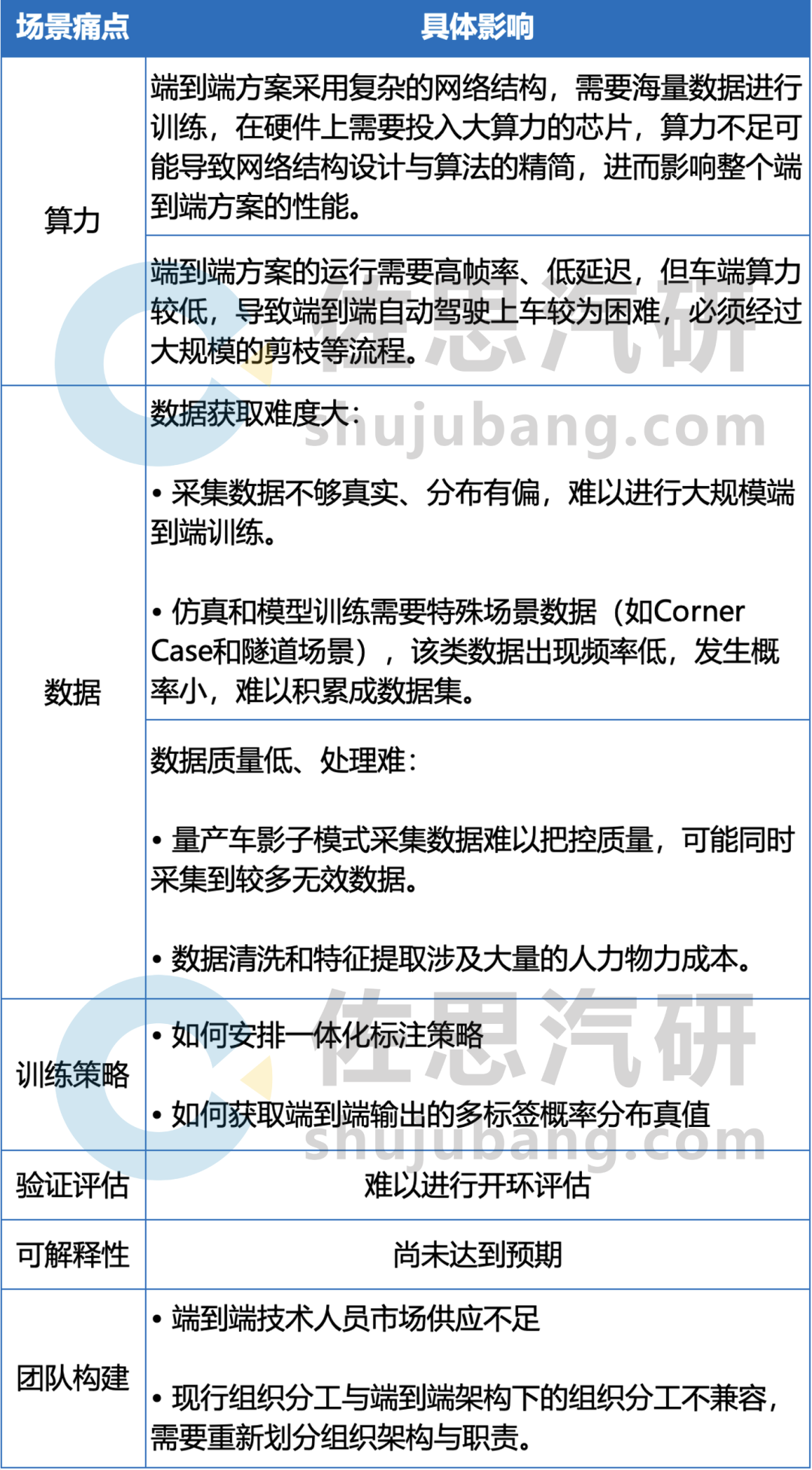

端到端方案的落地需要經歷構建研發團隊、配置硬件設施、數據收集處理、算法訓練與策略定制、驗證評估、推廣量產等流程,部分場景痛點如表中所示:

端到端方案的部分場景痛點

來源:佐思汽研《2024年端到端自動駕駛研究報告》

其中,端到端自動駕駛方案中的一體化訓練需要大量的數據,因此其面臨的難點之一在于數據的收集和處理。

首先,數據的收集需要大量的時間和渠道,數據類型除了駕駛數據外還包括各種不同的道路、天氣和交通情況等場景數據,其中在實際駕駛中駕駛員前方視野的駕駛數據相對便于收集,周圍方位的信息收集則難以保證。

再次,數據處理時需要設計數據提取維度、從海量的視頻片段中提取有效的特征、統計數據分布等,以支持大規模的數據訓練。

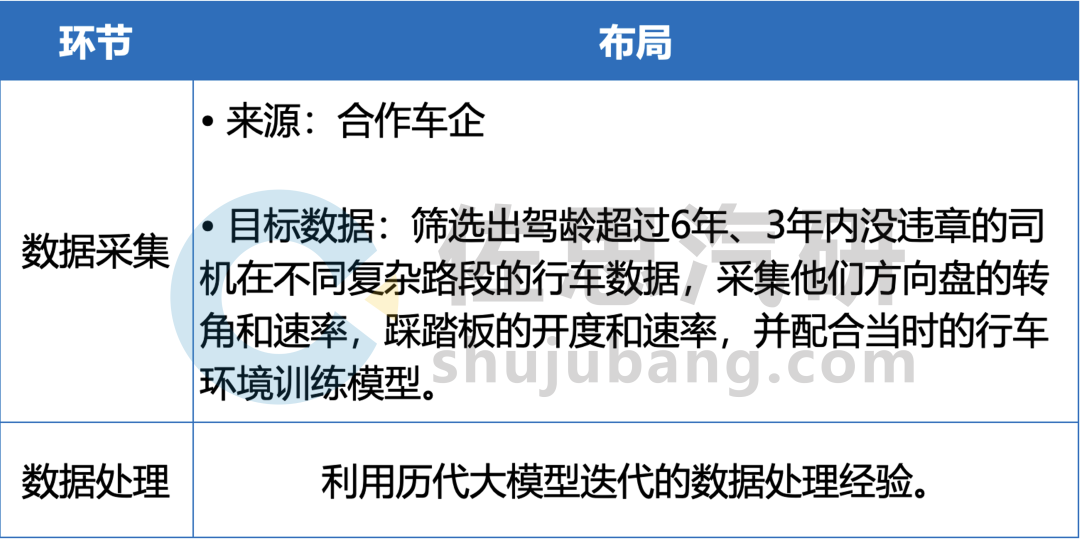

元戎啟行

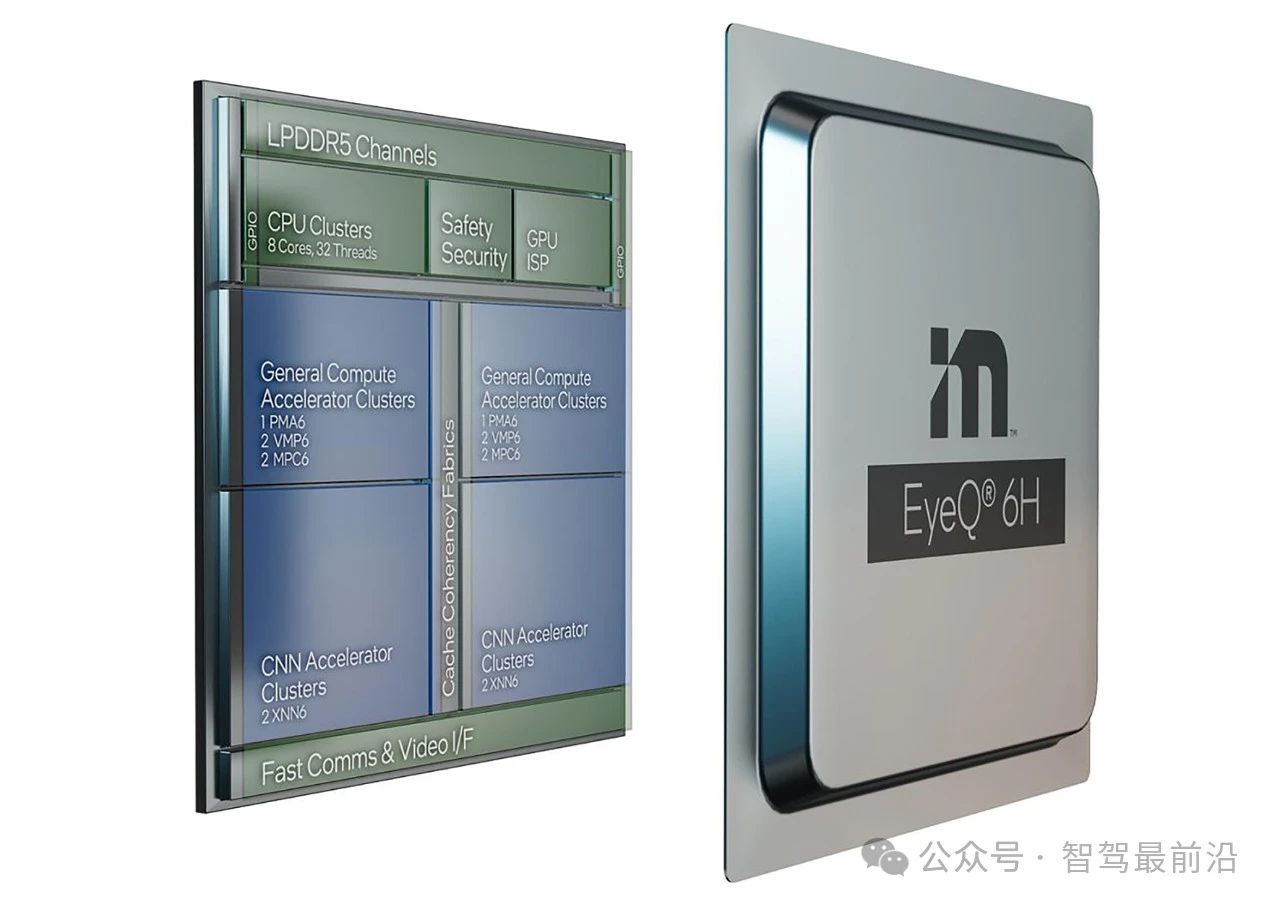

截至2024年3月,元戎啟行端到端自動駕駛方案已經獲得長城汽車的定點項目,并與英偉達開展合作,預計2025年適配英偉達Thor芯片;在元戎啟行的規劃中,從傳統方案過渡到“端到端”自動駕駛方案,經歷傳感器前融合、去高精度地圖、感知決策控制三個模型一體化等環節。

元戎啟行在數據環節的布局

來源:佐思汽研《2024年端到端自動駕駛研究報告》

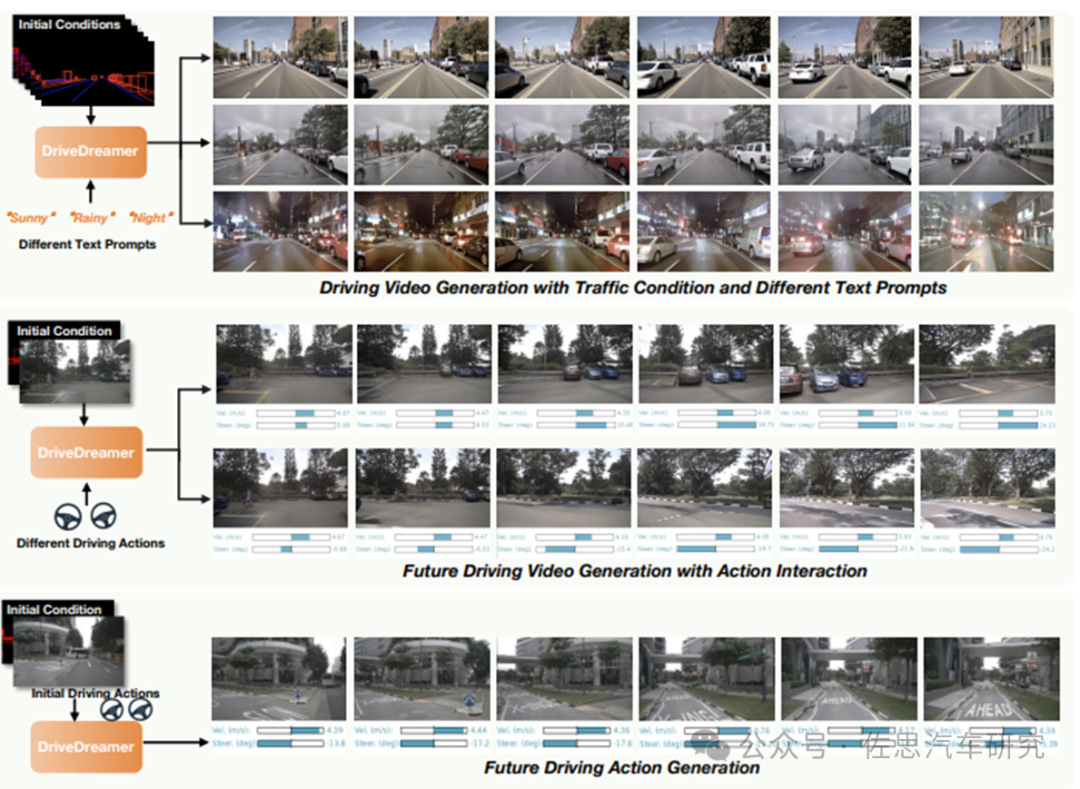

極佳科技

極佳科技的自動駕駛世界模型DriveDreamer,具備場景生成、數據生成、駕駛動作預測等功能;在場景/數據生成上,分為兩個步驟:

涉及單幀結構化條件,引導DriveDreamer生成駕駛場景圖像,便于其理解結構交通約束。

將其理解擴展到視頻生成。利用連續的交通結構條件,DriveDreamer輸出駕駛場景視頻,進一步增強其對運動轉換的理解。

DriveDreamer的功能包括可連續駕駛視頻生成、與文本提示和結構化交通限制無縫對齊

來源:極佳科技

3

端到端方案加快具身機器人落地

除了自動駕駛汽車,具身機器人是端到端方案另一個主流場景。從端到端自動駕駛到機器人,需要構建更加通用的世界模型,來適應更加復雜、多元的現實使用場景,主流AGI(通用人工智能)發展的框架分為兩個階段:

階段一:基礎大模型理解和生成實現統一,進一步與具身智能結合,形成統一世界模型;

階段二:世界模型+復雜任務的規控能力和抽象概念的歸納能力,逐步演化進入交互AGI 1.0時代。

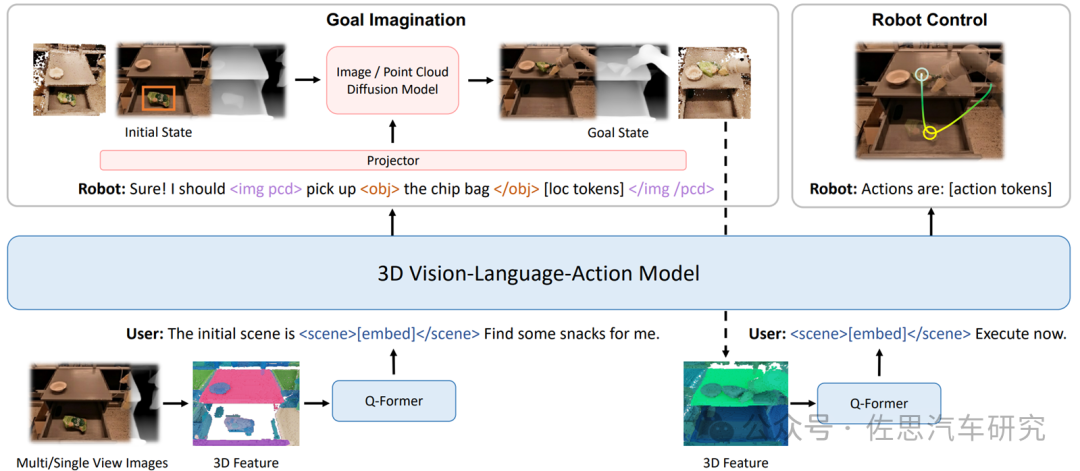

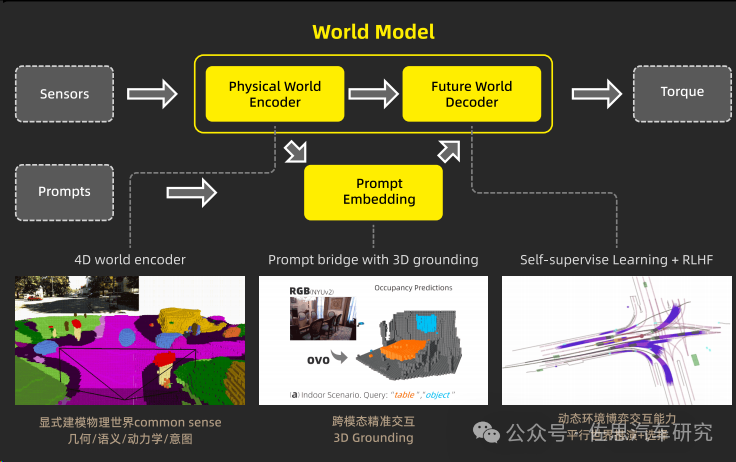

在世界模型落地的過程中,構建端到端的VLA(Vision-Language-Action) 自主系統成為關鍵一環。VLA作為具身智能基礎大模型,能夠將3D感知、推理和行動無縫鏈接起來,形成一個生成式世界模型,并建立在基于3D的大型語言模型(LLM)之上,引入一組交互標記以與環境進行互動。

3D-VLA解決方案

來源:University of Massachusetts Amherst、MIT-IBM Watson AI Lab等機構

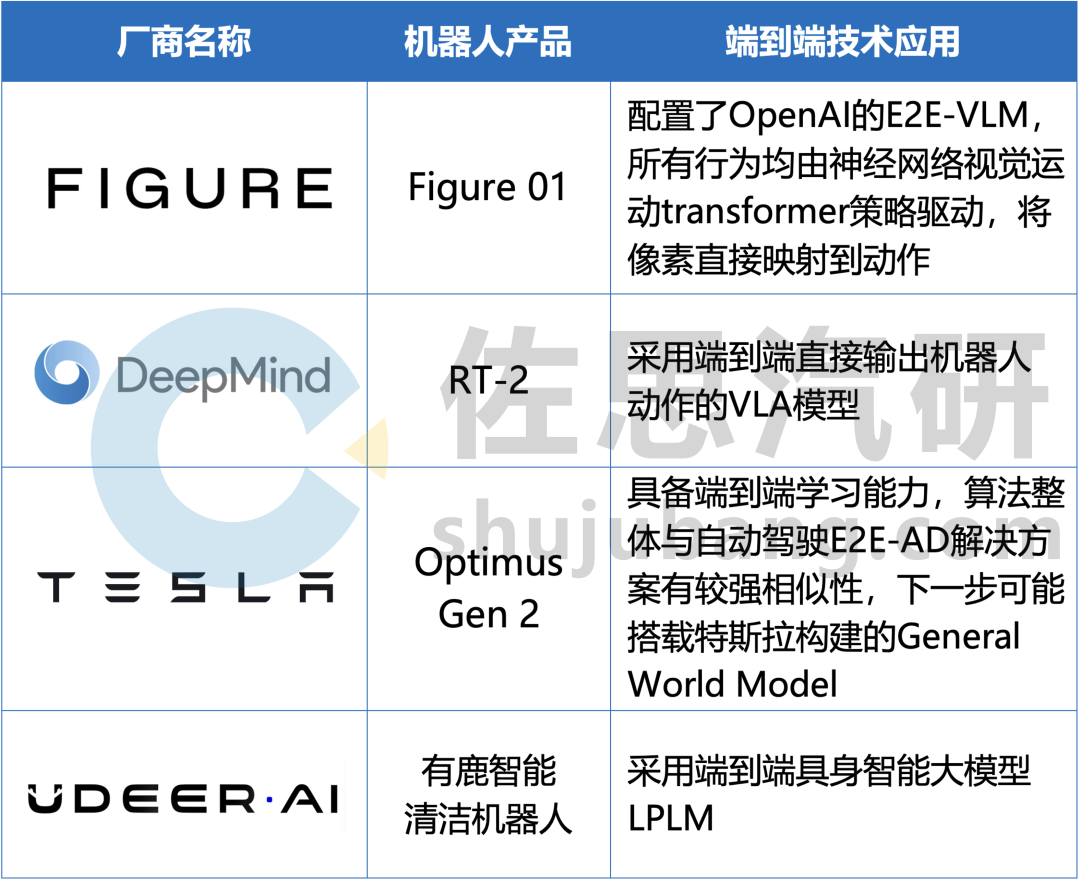

截至2024年4月,部分采用端到端方案的具身機器人廠商如下:

部分具身機器人如何應用端到端方案

來源:佐思汽研《2024年端到端自動駕駛研究報告》

以有鹿機器人為例,其具身智能大模型LPLM(Large Physical Language Model)為端到端的具身智能解決方案,通過自我標注機制提升模型從未標注數據中的學習效率和質量,從而加深對世界的理解,進而加強機器人的泛化能力與跨模態、跨場景、跨行業場景下的環境適應性。

LPLM模型架構

來源:有鹿機器人

LPLM 將物理世界抽象化,確保該類信息與 LLM 里特征的抽象等級對齊,將物理世界中每一個所指的實體顯式建模為 token,編碼幾何、語義、運動學與意圖信息。

此外,LPLM 在自然語言指令的編碼中加入了 3D grounding,一定程度上彌補了自然語言不夠精確的缺陷;其解碼器能夠通過不斷預測未來的方式去學習,從而加強了模型從海量無標簽數據中學習的能力。

審核編輯:劉清

-

傳感器

+關注

關注

2548文章

50664瀏覽量

751941 -

神經網絡

+關注

關注

42文章

4762瀏覽量

100535 -

攝像頭

+關注

關注

59文章

4807瀏覽量

95419 -

英偉達

+關注

關注

22文章

3743瀏覽量

90830 -

自動駕駛

+關注

關注

783文章

13682瀏覽量

166139

原文標題:端到端智駕研究:E2E自動駕駛發展現狀

文章出處:【微信號:zuosiqiche,微信公眾號:佐思汽車研究】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

從車企實踐看自動駕駛端到端解決方案

Waymo利用谷歌Gemini大模型,研發端到端自動駕駛系統

Mobileye端到端自動駕駛解決方案的深度解析

佐思汽研發布《2024年端到端自動駕駛研究報告》

佐思汽研發布《2024年端到端自動駕駛研究報告》

評論