這家初創公司通過共享加速計算基礎設施促進 AI 工作負載高效集群的資源利用。

為了幫助客戶更加高效地利用其 AI 計算資源,NVIDIA 宣布與基于 Kubernetes 的工作負載管理和編排軟件提供商 Run:ai 達成最終收購協議。

客戶的 AI 部署正變得更加復雜,其工作負載分布在各個云、邊緣和本地數據中心基礎設施上。

生成式 AI、推薦系統、搜索引擎等工作負載的管理和編排需要精密復雜的調度,才能優化系統級別和底層基礎設施的性能。

無論是在本地、云端還是在混合環境中,Run:ai 都可以幫助企業客戶管理并優化其計算基礎設施。

Run:ai 在 Kubernetes(現代 AI 和云基礎設施編排層)上建立了一個開放平臺。該平臺支持所有熱門的 Kubernetes 變體,并與第三方 AI 工具和框架集成。

Run:ai 的客戶中有來自多個行業的全球超大型企業,他們使用 Run:ai 平臺管理數據中心規模的 GPU 集群。

Run:ai 聯合創始人兼首席執行官 Omri Geller 表示:

Run:ai 從 2020 年開始一直與 NVIDIA 開展密切合作。我們都熱衷于幫助客戶充分發揮他們基礎設施的作用。Run:ai 十分高興能夠加入 NVIDIA 并期待繼續雙方的合作。

Run:ai 平臺為 AI 開發者及其團隊提供以下功能:

用于管理共享計算基礎設施的集中式界面,能夠使復雜 AI 工作負載的訪問變得更加簡單、快速。

提供添加用戶、在團隊下管理用戶、提供對集群資源的訪問、控制配額、優先級別和池,以及監控和報告資源使用情況的功能。

針對不同的任務能夠將 GPU 池化并共享算力——從 GPU 分塊到多個 GPU 或者在不同集群上運行的多個 GPU 節點。

高效利用 GPU 集群資源,使客戶能夠從算力投資中獲得更大回報。

在不久的將來,NVIDIA 將繼續以相同的商業模式提供 Run:ai 產品。同時將繼續投資 Run:ai 產品路線圖,將其納入到 NVIDIA DGX Cloud 中。NVIDIA DGX Cloud 是一個與領先的云服務提供商共同設計的針對企業開發人員的 AI 平臺,它能夠為生成式 AI 提供綜合全面的全棧優化服務。

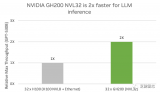

NVIDIA DGX 和 DGX Cloud 客戶將獲得 Run:ai 為其 AI 工作負載(尤其是大語言模型部署)所提供的功能。Run:ai 的解決方案已經與 NVIDIA DGX、NVIDIA DGX SuperPOD、NVIDIA Base Command、NGC 容器和 NVIDIA AI Enterprise 軟件等產品集成。

NVIDIA 加速計算平臺和 Run:ai 平臺將繼續支持廣大第三方解決方案生態系統,為客戶提供選擇和靈活性。

通過與 Run:ai 的合作,NVIDIA 將為客戶提供一個可在任何位置訪問 GPU 解決方案的單一架構。客戶有望受益于更高的 GPU 利用率、更好的 GPU 基礎設施管理以及開放式架構所帶來的更大靈活性。

審核編輯:劉清

-

NVIDIA

+關注

關注

14文章

4936瀏覽量

102812 -

gpu

+關注

關注

28文章

4700瀏覽量

128697 -

大模型

+關注

關注

2文章

2324瀏覽量

2480

原文標題:NVIDIA 收購 GPU 編排軟件提供商 Run:ai

文章出處:【微信號:NVIDIA_China,微信公眾號:NVIDIA英偉達】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

亞馬遜達成收購協議,擬整合芯片制造商與AI模型壓縮專家Perceive

NVIDIA 通過 Holoscan 為 NVIDIA IGX 提供企業軟件支持

NVIDIA 通過 Holoscan 為 NVIDIA IGX 提供企業軟件支持,實現邊緣實時醫療、工業和科學 AI 應用

印孚瑟斯收購工程研發服務提供商in-tech

英偉達戰略收購Run:ai,推進產品戰略,整合資源至Nvidia DGX C

英偉達洽談收購以色列人工智能公司Run:ai

英偉達擬收購以色列人工智能初創公司Run:AI

Qorvo?近日宣布已就收購Anokiwave達成最終協議

Infosys將收購領先的半導體設計服務提供商英世米

AWS成為第一個提供NVIDIA GH200 Grace Hopper超級芯片的提供商

NVIDIA宣布與GPU編排軟件提供商Run:ai達成最終收購協議

NVIDIA宣布與GPU編排軟件提供商Run:ai達成最終收購協議

評論