轉(zhuǎn)自:量子位 | 公眾號(hào) QbitAI

不開(kāi)玩笑,電影《她》真的來(lái)了。

OpenAI最新旗艦大模型GPT-4o,不僅免費(fèi)可用,能力更是橫跨聽(tīng)、看、說(shuō),絲滑流暢毫無(wú)延遲,就像在打一個(gè)視頻電話。

現(xiàn)場(chǎng)直播的效果更是炸裂:

它能感受到你的呼吸節(jié)奏,也能用比以前更豐富的語(yǔ)氣實(shí)時(shí)回復(fù),甚至可以做到隨時(shí)打斷。

GPT-4o里的“o”是Omni的縮寫(xiě),也就是“全能”的意思,接受文本、音頻和圖像的任意組合作為輸入,并生成文本、音頻和圖像輸出。

它可以在短至232毫秒、平均320毫秒的時(shí)間內(nèi)響應(yīng)音頻輸入,與人類在對(duì)話中的反應(yīng)速度一致。

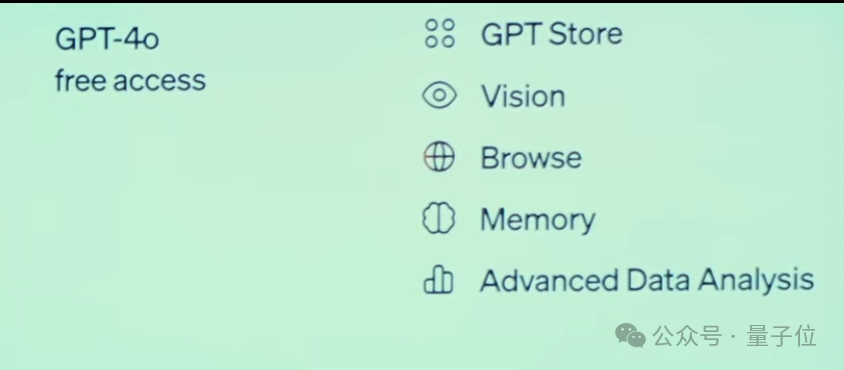

這還是一份給所有人的大禮,GPT4-o與ChatGPT Plus會(huì)員版所有的能力,包括視覺(jué)、聯(lián)網(wǎng)、記憶、執(zhí)行代碼、GPT Store……

將對(duì)所有用戶免費(fèi)開(kāi)放!

(新語(yǔ)音模式幾周內(nèi)先對(duì)Plus用戶開(kāi)放)在直播現(xiàn)場(chǎng),CTO Murati穆姐說(shuō):這是把GPT-4級(jí)別的模型開(kāi)放出去,其實(shí)她還謙虛了。

在場(chǎng)外,研究員William Fedus揭秘,GPT-4o就是之前在大模型競(jìng)技場(chǎng)搞A/B測(cè)試的模型之一,im-also-a-good-gpt2-chatbot。

無(wú)論從網(wǎng)友上手體驗(yàn)還是競(jìng)技場(chǎng)排位來(lái)看,都是高于GPT-4-Turbo級(jí)別的模型了,ELO分?jǐn)?shù)一騎絕塵。

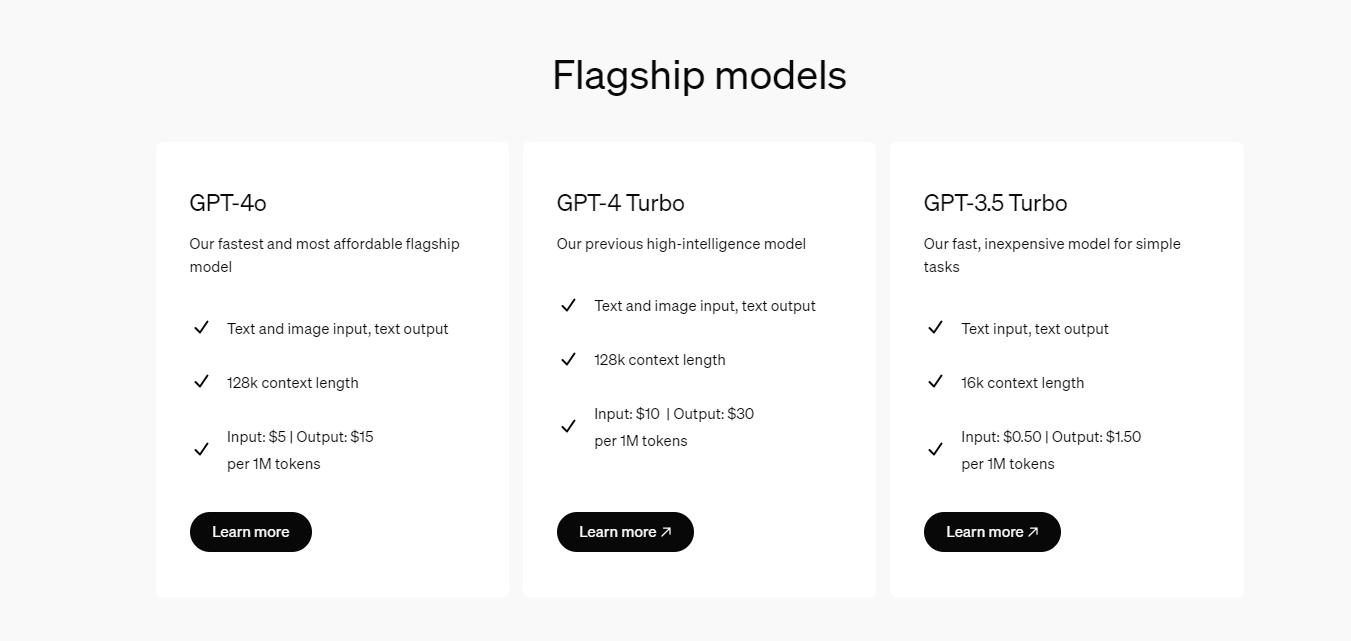

而這樣的超強(qiáng)模型也將提供API,價(jià)格打5折,速度提高一倍,單位時(shí)間調(diào)用次數(shù)足足是原來(lái)的5倍!

追直播的網(wǎng)友已經(jīng)在設(shè)想可能的應(yīng)用,可以替代盲人看世界了。以及確實(shí)感覺(jué)比之前的語(yǔ)音模式體驗(yàn)上強(qiáng)上不少。

鑒于之前不少人就已經(jīng)和ChatGPT語(yǔ)音模式“談戀愛(ài)”了,有大膽想法的朋友,可以把你們的想法發(fā)在評(píng)論區(qū)了。

總裁Brockman在線演示

知道OpenAI發(fā)布會(huì)為什么定在谷歌I/O前一天了——打臉,狠狠打臉。

谷歌Gemini發(fā)布會(huì)需要靠剪輯視頻和切換提示詞達(dá)成的偽實(shí)時(shí)對(duì)話效果,OpenAI現(xiàn)場(chǎng)全都直播演示了。

比如讓ChatGPT在語(yǔ)言不通的兩個(gè)人之間充當(dāng)翻譯機(jī),聽(tīng)到英語(yǔ)就翻譯成意大利語(yǔ),聽(tīng)到意大利語(yǔ)就翻譯成英語(yǔ)。

發(fā)布會(huì)直播之外,總裁哥Brockman還發(fā)布了額外的5分鐘詳細(xì)演示。而且是讓兩個(gè)ChatGPT互相對(duì)話,最后還唱起來(lái)了,戲劇感直接拉滿。這兩個(gè)ChatGPT,一個(gè)是舊版APP,只知道對(duì)話,另一個(gè)則是新版網(wǎng)頁(yè),具備視覺(jué)等新能力。(我們不妨取Old和New的首字母,分別叫TA們小O和小N) Brockman首先向小O介紹了大致情況,告訴她要和一個(gè)擁有視覺(jué)能力的AI對(duì)話,她表示很酷并欣然接受。接著,Brockman讓她稍作休息,并向小N也介紹情況,還順帶展示了小N的視覺(jué)能力。只見(jiàn)打完招呼后,小N準(zhǔn)確地說(shuō)出了Brockman的衣著打扮和房間環(huán)境。而對(duì)于要和小O對(duì)話這件事,小N也感到很有趣。

Brockman首先向小O介紹了大致情況,告訴她要和一個(gè)擁有視覺(jué)能力的AI對(duì)話,她表示很酷并欣然接受。接著,Brockman讓她稍作休息,并向小N也介紹情況,還順帶展示了小N的視覺(jué)能力。只見(jiàn)打完招呼后,小N準(zhǔn)確地說(shuō)出了Brockman的衣著打扮和房間環(huán)境。而對(duì)于要和小O對(duì)話這件事,小N也感到很有趣。

接下來(lái)就是小O和小N相互對(duì)白的時(shí)間了,TA們依然是從Brockman的衣著開(kāi)始聊起,小O不斷提出新的問(wèn)題,小N都一一解答。接著,他們又談?wù)摿朔块g的風(fēng)格、布置和光線,甚至小N還意識(shí)到了Brockman正站在上帝視角凝視著TA們。

如果你看了這段視頻就會(huì)發(fā)現(xiàn),畫(huà)面中出現(xiàn)了一個(gè)女人在Brockman身后做了些惡搞的手勢(shì)。這可不是亂入,是Brockman和女人串通好,專門(mén)給小N設(shè)計(jì)的一道“考題”。

就在小O和小N聊的正開(kāi)心的時(shí)候,Brockman選擇加入,直接問(wèn)有沒(méi)有看到什么不正常的地方。結(jié)果是小N直接識(shí)破了Brockman的小伎倆,直接復(fù)述出了女人在他身后做小動(dòng)作的場(chǎng)景,小O聽(tīng)了之后直接感嘆原來(lái)在這里享受樂(lè)趣的不只有我們兩個(gè)。Brockman把這句話當(dāng)成了夸贊,并對(duì)小O表示了感謝,還愉快地加入了TA們的對(duì)話。之后是最后也是最精彩的部分,在Brockman的指揮下,小O和小N根據(jù)剛才聊天的內(nèi)容,直接開(kāi)啟了對(duì)唱模式。只過(guò)了簡(jiǎn)單幾輪,銜接地就十分密切,而且旋律悠揚(yáng),音色也是和真人毫無(wú)二致。

最后視頻以Brockman唱出的一句Thank you結(jié)束,在視頻外的推文中他還透露新的語(yǔ)音對(duì)話功能將在數(shù)周內(nèi)向Plus用戶開(kāi)放。

端到端訓(xùn)練,一個(gè)神經(jīng)網(wǎng)絡(luò)搞定語(yǔ)音文本圖像

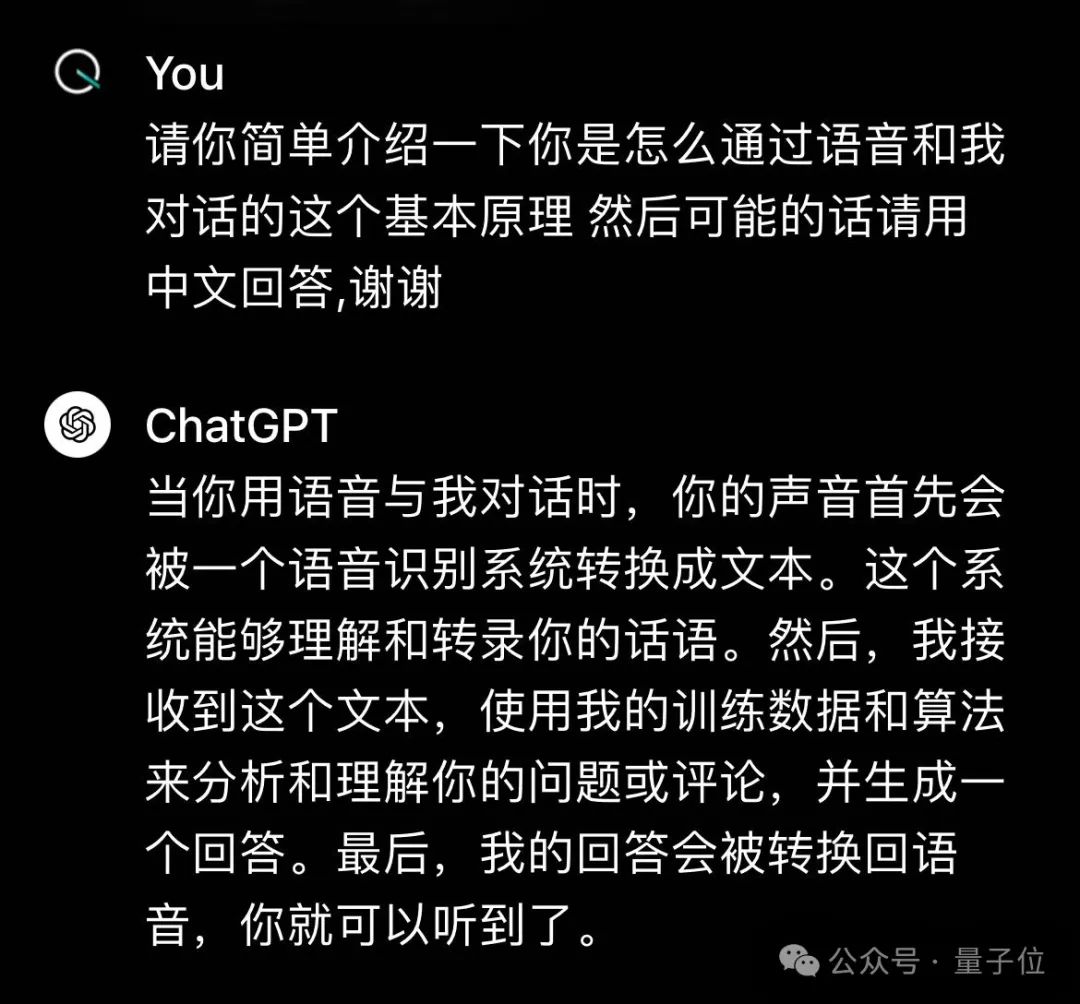

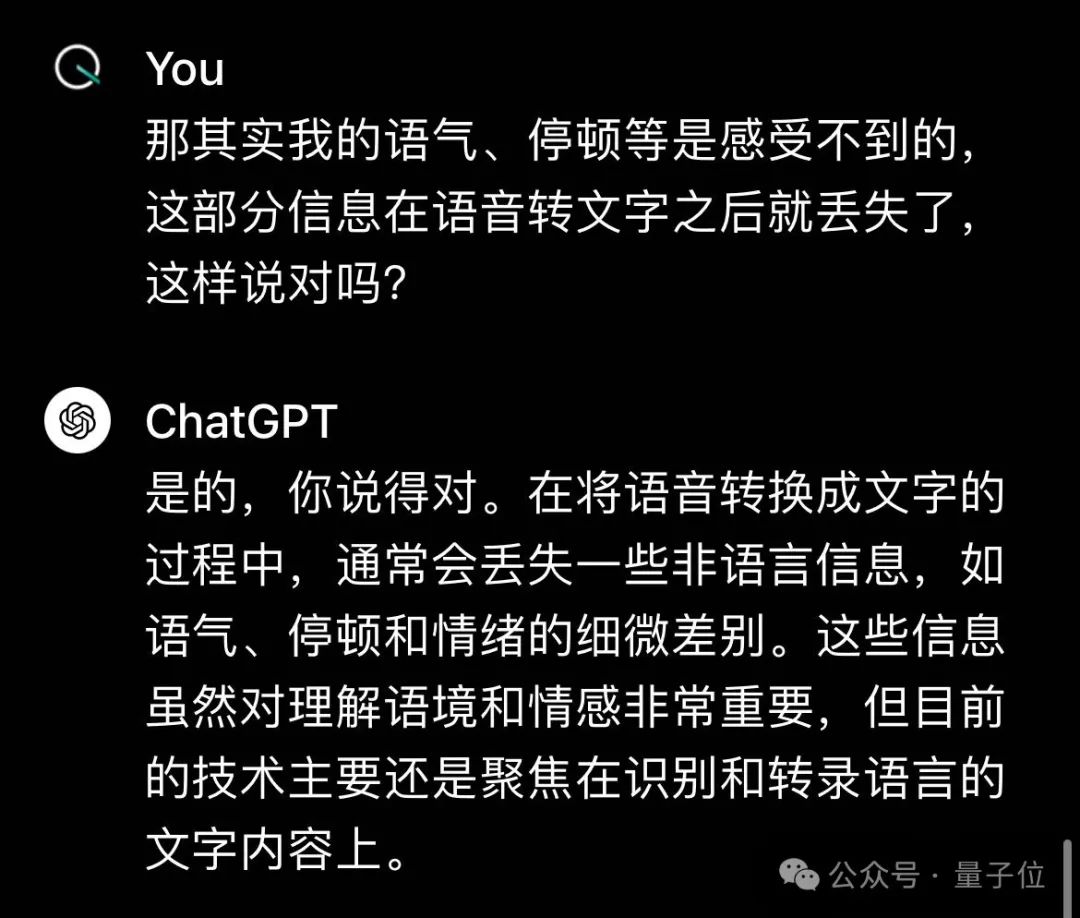

正如奧特曼在發(fā)布會(huì)前所說(shuō),GPT-4o讓人感覺(jué)像魔法一樣,那么它是如何做到的呢?非常抱歉,這次非但沒(méi)有論文,連技術(shù)報(bào)告也不發(fā)了,只在官網(wǎng)Blog里有一段簡(jiǎn)短的說(shuō)明。在GPT-4o之前,ChatGPT語(yǔ)音模式由三個(gè)獨(dú)立模型組成,語(yǔ)音轉(zhuǎn)文本→GPT3.5/GPT-4→文本轉(zhuǎn)語(yǔ)音。我們也可以讓舊版ChatGPT語(yǔ)音模式自己講一下具體是怎么個(gè)流程。 這樣一來(lái),整個(gè)系統(tǒng)的延遲足足有2.8秒(GPT-3.5)和5.4秒(GPT-4),而且丟失了大量的信息,它無(wú)法直接感受音調(diào)、多個(gè)說(shuō)話者或背景噪音,也無(wú)法輸出笑聲、唱歌聲,或表達(dá)情感。

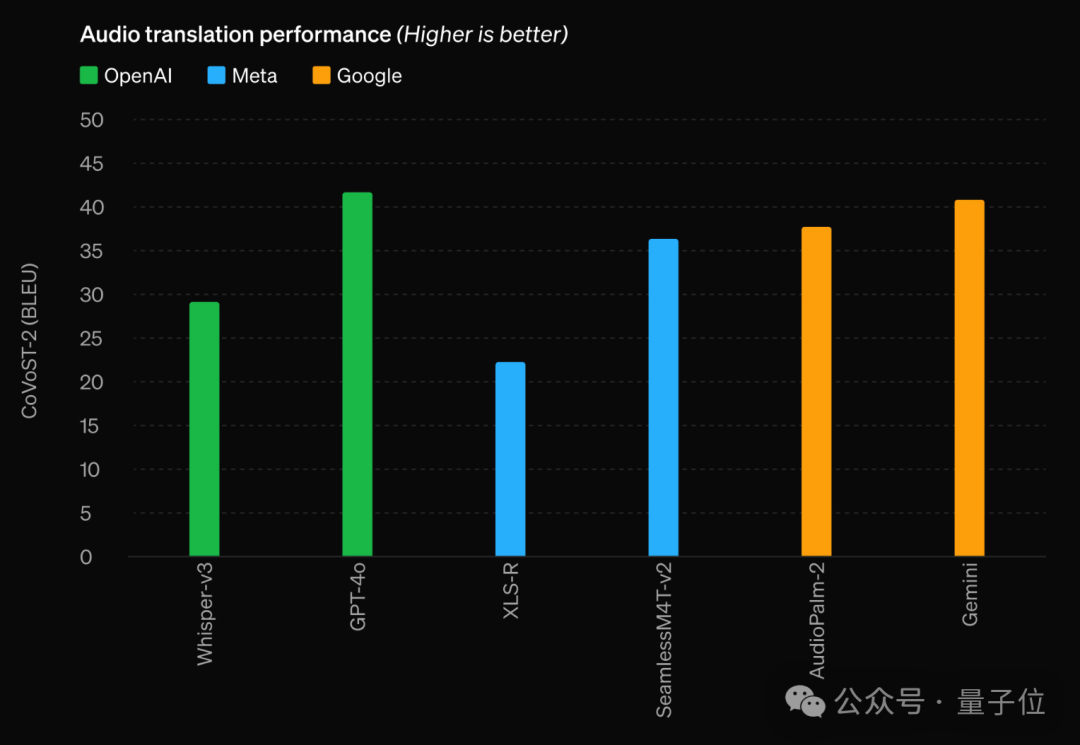

這樣一來(lái),整個(gè)系統(tǒng)的延遲足足有2.8秒(GPT-3.5)和5.4秒(GPT-4),而且丟失了大量的信息,它無(wú)法直接感受音調(diào)、多個(gè)說(shuō)話者或背景噪音,也無(wú)法輸出笑聲、唱歌聲,或表達(dá)情感。 GPT-4o則是跨文本、視覺(jué)和音頻端到端訓(xùn)練的新模型,這意味著所有輸入和輸出都由同一個(gè)神經(jīng)網(wǎng)絡(luò)處理。在語(yǔ)音翻譯任務(wù)上,強(qiáng)于OpenAI專門(mén)的語(yǔ)音模型Whisper-V3以及谷歌和Meta的語(yǔ)音模型。

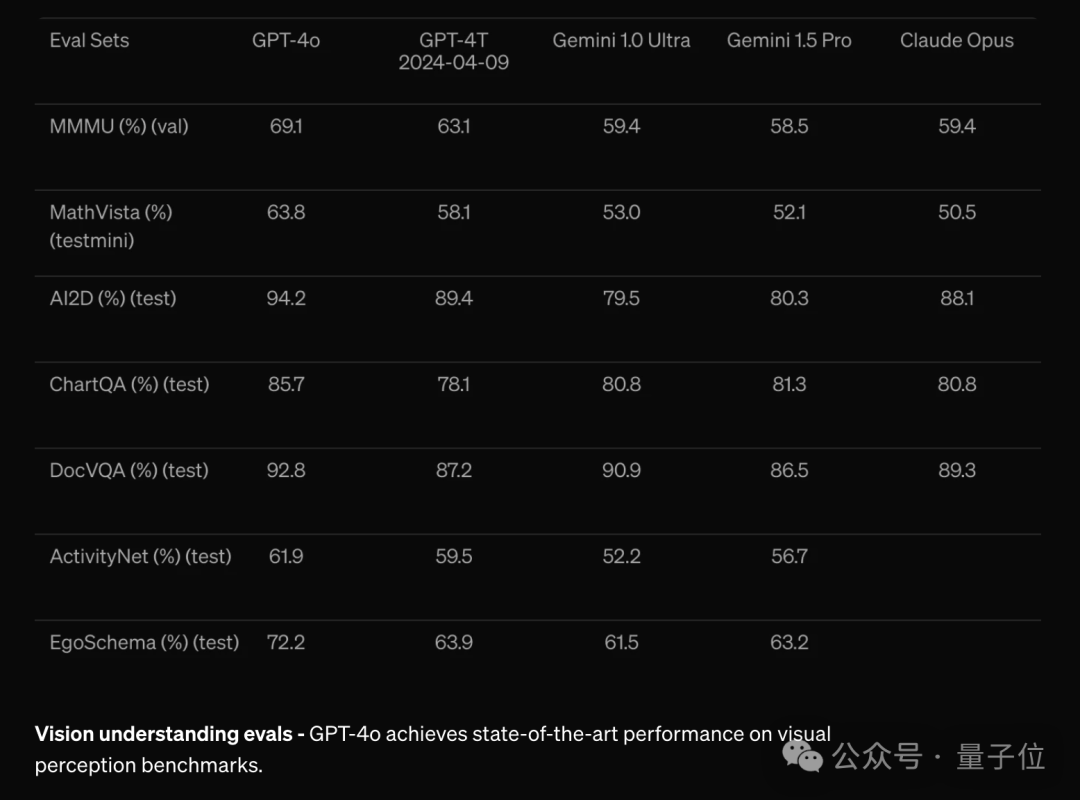

GPT-4o則是跨文本、視覺(jué)和音頻端到端訓(xùn)練的新模型,這意味著所有輸入和輸出都由同一個(gè)神經(jīng)網(wǎng)絡(luò)處理。在語(yǔ)音翻譯任務(wù)上,強(qiáng)于OpenAI專門(mén)的語(yǔ)音模型Whisper-V3以及谷歌和Meta的語(yǔ)音模型。 在視覺(jué)理解上,也再次反超Gemini 1.0 Ultra與對(duì)家Claude Opus

在視覺(jué)理解上,也再次反超Gemini 1.0 Ultra與對(duì)家Claude Opus

雖然技術(shù)方面這次透露的消息就這么多了,不過(guò)也有學(xué)者評(píng)價(jià)。

一個(gè)成功的演示相當(dāng)于1000篇論文。

One More Thing

除了OpenAI帶來(lái)的精彩內(nèi)容之外,也別忘了北京時(shí)間5月15日凌晨,谷歌將召開(kāi)I/O大會(huì)。到時(shí)量子位將繼續(xù)第一時(shí)間帶來(lái)最新消息。另外根據(jù)網(wǎng)友推測(cè),GPT-4o這么強(qiáng),全都免費(fèi)開(kāi)放了,這是勸大家不續(xù)訂ChatGPT Plus了的意思嗎?那肯定不是啊~ 鑒于OpenAI春節(jié)期間在谷歌發(fā)布Gemini 1.5 Pro后半小時(shí)左右用Sora狙擊了一把,明天OpenAI還有新活也說(shuō)不定呢?直播回放

鑒于OpenAI春節(jié)期間在谷歌發(fā)布Gemini 1.5 Pro后半小時(shí)左右用Sora狙擊了一把,明天OpenAI還有新活也說(shuō)不定呢?直播回放

-

AI

+關(guān)注

關(guān)注

87文章

30239瀏覽量

268475 -

人工智能

+關(guān)注

關(guān)注

1791文章

46896瀏覽量

237669 -

GPT

+關(guān)注

關(guān)注

0文章

352瀏覽量

15318

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

解鎖 GPT-4o!2024 ChatGPT Plus 代升級(jí)全攻略(附國(guó)內(nèi)支付方法)

OpenAI解鎖GPT-4o定制功能,助力企業(yè)精準(zhǔn)優(yōu)化AI應(yīng)用

OpenAI提前解鎖GPT-4o語(yǔ)音模式,引領(lǐng)對(duì)話新紀(jì)元

OpenAI 推出 GPT-4o mini 取代GPT 3.5 性能超越GPT 4 而且更快 API KEY更便宜

國(guó)內(nèi)直聯(lián)使用ChatGPT 4.0 API Key使用和多模態(tài)GPT4o API調(diào)用開(kāi)發(fā)教程!

開(kāi)發(fā)者如何調(diào)用OpenAI的GPT-4o API以及價(jià)格詳情指南

OpenAI 深夜拋出王炸 “ChatGPT- 4o”, “她” 來(lái)了

Azure AI Studio現(xiàn)已支持提供GPT-4o API

GPT-4o更像“人”,AI“疾步”走向商業(yè)化應(yīng)用

GPT-4o深夜炸場(chǎng)!AI實(shí)時(shí)視頻通話絲滑如人類,Plus功能免費(fèi)可用

GPT-4o深夜炸場(chǎng)!AI實(shí)時(shí)視頻通話絲滑如人類,Plus功能免費(fèi)可用

評(píng)論