電子發燒友網報道(文/李彎彎)大模型在端側部署是指將大型神經網絡模型部署在移動終端設備上,使這些設備能夠直接運行這些模型,從而執行各種人工智能任務,如圖像識別、語音識別、自然語言處理等。隨著大模型小型化、場景化需求的增加,推理逐步從云端擴展向端側。這種趨勢在PC和手機等終端產品上尤為明顯。

大模型在端側部署加速

大模型在端側部署的過程通常包括幾個階段,首先是模型訓練階段,在這個階段,使用大量的標注數據訓練出對應的模型文件。訓練時需要考慮模型的大小和計算量,以便適應端側設備的硬件條件。

接著是模型壓縮,為了降低模型在端側設備上的存儲和運行壓力,通常需要對模型進行壓縮。這可以通過剪枝、量化等手段來實現,以減小模型的大小和降低計算復雜度。

再就是模型部署,在這個階段,將壓縮后的模型部署到端側設備上。這包括將模型文件傳輸到設備上,在設備上安裝必要的推理引擎和運行時環境等步驟。

最后,在模型部署完成后,端側設備就可以使用這些模型進行推理計算了。這通常包括加載模型、輸入數據預處理、模型計算、結果輸出等步驟。

在大模型端側部署過程中,需要考慮一些技術挑戰和限制。例如,端側設備的硬件條件通常比云端服務器要差很多,因此需要在模型設計和壓縮階段充分考慮這些因素。此外,端側設備的網絡帶寬和延遲也可能對模型推理的實時性和準確性產生影響。

為了克服這些挑戰和限制,一些技術工具和平臺被開發出來,如MLflow、Ray Serve、Kubeflow、Seldon Core、BentoML和ONNX Runtime等。這些工具可以幫助用戶更方便地構建、部署和管理機器學習模型,從而提高模型在端側設備上的性能和可用性。

現如今,大模型在端側的部署正在加速。在PC領域,繼英特爾推出首個AI PC處理器后,聯想集團、惠普、宏碁等廠商相繼發布多款AI PC新品。據報道,已有超過10款筆記本可以本地運行AI大模型,并且還有一批新品將陸續上市。

在手機領域,從2023年下半年開始,小米、OPPO、vivo等手機廠商紛紛在新系統中增加大模型能力。到2024年1月,中國手機市場Top5中,除蘋果之外,已經全數發布自有端側大模型產品。

大模型在端側部署的優勢也日益凸顯。一方面,端側部署可以降低數據傳輸延遲和帶寬限制,提高實時性和響應速度。另一方面,端側部署可以更好地保護用戶隱私和數據安全,因為數據可以在本地進行處理,而無需傳輸到云端。

國內外廠商推出支持大模型端側部署芯片

大模型要在端側部署離不開芯片的支持,英特爾、高通、聯發科等都推出了針對大模型在PC、手機等移動端部署所需的芯片。英特爾推出了首款基于Intel 4制程的酷睿Ultra系列處理器第一代產品Meteor Lake,這款處理器首次在客戶端CPU中采用了Chiplet(芯粒)設計和自家的Foveros先進封裝技術,集成了NPU(神經網絡處理單元),可以本地運行200億參數大模型,無需聯網即可秒級生成高質量多模態數據。

高通發布的第三代驍龍8移動平臺,是其首個專為生成式AI打造的移動平臺。該平臺支持在終端側運行100億參數的模型,并面向70億參數大預言模型每秒生成高達20個token,且能夠在終端側通過Stable Diffusion生成圖片。

此外,高通還推出了AI Hub,這是一個為開發者提供的AI模型庫,包括傳統AI模型和生成式AI模型,能夠支持在驍龍和高通平臺上進行部署。這個模型庫支持超過75個AI模型,如Whisper、ControlNet、Stable Diffusion和Baichuan-7B等,開發者可以輕松地獲取這些模型并將其集成到應用程序中。

聯發科與阿里云展開深度合作,在天璣9300和天璣8300移動平臺上實現了通義千問大模型的端側部署。聯發科的天璣系列移動芯片,如天璣9300和天璣8300,都是高性能、高能效的移動計算平臺。這些芯片不僅具有強大的處理能力,還支持先進的5G技術和生成式AI技術,為端側大模型部署提供了堅實的基礎。

另外,國內的愛芯元智、芯動力科技等公司也針對大模型在端側的部署優化產品。愛芯元智的AX650N芯片在大模型端側部署方面就展現出了顯著的優勢。

具體來說,AX650N在部署Swin Transformer這類大型視覺模型時,能夠保持高精度和高效率。由于大部分端側AI芯片在架構上對于MHA(Multi-Head Attention)結構沒有過多優化,因此部署大型模型時往往需要進行網絡結構的修改,這可能導致精度下降和重訓的麻煩。然而,AX650N通過其獨特的架構和優化,能夠直接支持原版Swin Transformer的部署,從測試板到demo復現只需要5分鐘,私有模型在私有環境中運行也僅需1小時。

此外,AX650N還具備32路視頻解碼/視頻結構化處理、被動散熱、支持低延時編解碼、HDMI輸出和USB 3.0等特性,這些特性使得它非常適合用于各種視覺感知和邊緣計算的應用場景。在大模型端側部署方面,AX650N不僅提供了強大的計算能力,還通過其易部署和低功耗的特點,為實際應用落地提供了更多的可能性。

芯動力科技是一家清華系的AI芯片創企,他們面向大模型推出了AzureBlade L系列M.2加速卡。這款加速卡具有強大的性能,能夠順利運行大模型系統,并且其大小僅為80mm(長)x22mm(寬),非常適合在PC等端側設備上部署。

AzureBlade L系列M.2加速卡已經實現了與Llama 2、Stable Diffusion等模型的適配,成為助推大模型在端側設備上部署的加速器。這種具備體積小、性能強,且有通用接口的M.2加速卡,能夠突破端側設備有限的計算和存儲能力,為大模型在端側的落地提供了機會。

寫在最后

大模型在端側部署是一個復雜的過程,需要考慮多種因素和技術挑戰。但是通過合理的模型設計、壓縮和優化以及使用適當的工具和平臺,就可以讓端側設備具備更強的人工智能能力。如今,在產業鏈各環節的努力下,大模型在端側部署的現狀呈現出加速的趨勢,預計,未來隨著技術的不斷進步和優化,大模型在端側部署的應用將會越來越廣泛。

-

神經網絡

+關注

關注

42文章

4765瀏覽量

100561 -

大模型

+關注

關注

2文章

2339瀏覽量

2499

發布評論請先 登錄

相關推薦

高通與智譜推動多模態生成式AI體驗的終端側部署

大模型向邊端側部署,AI加速卡朝高算力、小體積發展

后摩智能引領AI芯片革命,推出邊端大模型AI芯片M30

支持大模型部署和運行的邊緣計算SoC芯片

小鵬汽車發布端到端大模型

聯發科旗艦芯片部署阿里云大模型

牽手NVIDIA 元戎啟行端到端模型將搭載 DRIVE Thor芯片

使用CUBEAI部署tflite模型到STM32F0中,模型創建失敗怎么解決?

人工智能十大趨勢預測:更多多模態、大模型端側部署加速!智能化應用呈爆發式增長

Meta計劃今年部署自研定制芯片,以加速AI研發

邊緣側部署大模型優勢多!模型量化解決邊緣設備資源限制問題

AI大模型在端側加速落地已成必然趨勢,芯片廠商提前布局!

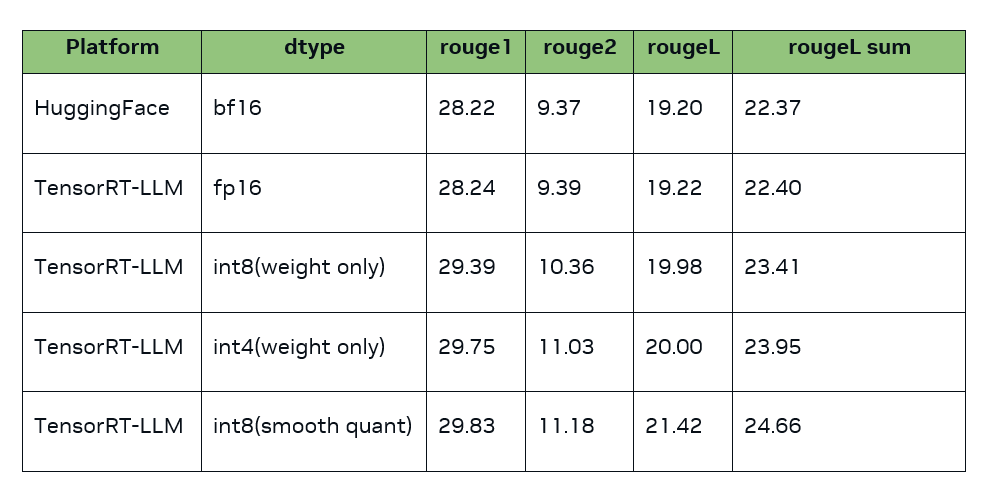

如何在 NVIDIA TensorRT-LLM 中支持 Qwen 模型

大模型端側部署加速,都有哪些芯片可支持?

大模型端側部署加速,都有哪些芯片可支持?

評論