“基于第五代英特爾至強可擴展處理器的寧暢B5000 G5多節點服務器,可以在滿足大量AI推理場景在吞吐量、時延、容量、并發能力等方面的需求,而且與專用的GPU服務器相比,在靈活性方面更具優勢。我們希望能夠與英特爾進行更加深度的合作,持續優化該方案的AI推理性能,助力用戶加速擁抱大模型。”

“大模型已經成為行業用戶進行業務變革的重要驅動力,這帶來了規模巨大且仍在快速提升的算力需求。英特爾提供了面向大模型應用的全棧方案,第五代英特爾 至強 可擴展處理器則憑借較高的性能與靈活性,非常適合運行特定域專用模型或長尾模型。通過與寧暢合作,我們希望能夠滿足更多用戶對于大模型推理的性能需求,加速業務轉型。”

挑 戰

大語言模型等AI模型的快速發展凸顯了模型推理的算力瓶頸,給服務器帶來了多方面的挑戰:

在性能層面,模型的規模不斷增長,對于算力的需求不斷提升。除了硬件層面的提升之外,通過將模型數據格式轉化為較低精度的數據、調用矢量神經網絡指令(VNNI)等方式,也有助于提升模型的性能表現。

在靈活性層面,專用的AI推理服務器具有較高的性能表現,但是在應用場景方面有著較為嚴格的限制,無法高效、靈活地應對多種工作負載的運行需求。對于模型推理需求變化頻繁、規模相對較小的用戶而言,需要更加靈活的推理服務器,以在不同的工作負載間進行靈活切換。

在成本方面,服務器的算力密度越高,就越有利于節約數據中心空間以及數據中心能耗、設備等方面的成本。同時,通過優化AI推理性能表現,能夠進一步節約成本。

解決方案概述

大語言模型(LLM)作為人工智能(AI)應用的一個重要分支,可以處理多種自然語言任務,如文本分類、問答、對話等,在互聯網、金融、醫療、教育等行業有著廣泛的應用,并被普遍認為是實現通用人工智能的重要方式。近年來,大語言模型實現了“井噴”式的發展,在展現人工智能的革命性價值的同時,也帶來了算力層面的巨大挑戰。統計數據顯示,從2017年到2022年,模型的規模增長了15,000倍,典型的大模型參數規模已經達到了千億甚至萬億級別。當大模型落地到實際場景之后,模型推理帶來了龐大的算力消耗,用戶需要應對大模型推理所帶來的算力、總體擁有成本(TCO)、靈活性等挑戰。

寧暢B5000 G5多節點服務器作為高密度的服務器,能夠為大語言模型等AI應用提供強大的算力支撐。寧暢B5000 G5多節點服務器實現了對于第五代英特爾 至強 可擴展處理器的支持,能夠借助第五代英特爾 至強 可擴展處理器的強大算力,以及處理器內置的英特爾 高級矩陣擴展(英特爾 AMX),實現大模型推理等AI應用的加速,在靈活性方面較專用的AI服務器更具優勢。此外,寧暢B5000 G5多節點服務器還能夠借助RDMA (Remote Direct Memory Access) 技術以及英特爾 以太網控制器E810,提供高速的跨節點通信。

寧暢B5000 G5多節點服務器

寧暢B5000 G5多節點服務器是一款基于英特爾 至強 可擴展處理器自主開發的高密度產品,在4U的空間可最大支持到8個雙路節點,單節點已全面支持最新的第五代英特爾 至強 可擴展處理器。整個服務器的8個雙路節點間互相獨立,互不干擾。B5000 G5多節點服務器可支持更多的計算核心,兼備卓越的計算性能和靈活的IO擴展能力。B5000 G5可實現數據中心的高密部署、提供強大計算性能,也可以滿足用戶業務多樣性與靈活性的需求。

該服務器具備如下優勢:

全新升級極致性能:支持第五代英特爾 至強 可擴展處理器,計算性能強勁,總線帶寬高達16GT/s;支持DDR5 5600MHz內存頻率,內存帶寬相比較上一代提升50%;全面支持PCIe 5.0,傳輸速率提升100%。

多節點計算靈活配置:4U8節點高密度架構,支持8個雙路計算節點;機箱模塊化設計,配置交換和管理集管理模塊;整機最大支持4個NDR/HDR Multi Host模塊或8個HDR 200G直通模塊;單節點支持2個2.5寸硬盤,兼容U.2 NVMe SSD。

多重監控綠色節能:機箱搭配多級管理,包含統一的CMM管理和整機業務交換管理,整機管理支持前后維護模式,同時可完成整機所有節點IP的管理,實時監控整機狀態,提供關鍵部件健康狀態的監控和上報功能,全面保障健康運行;機箱采用模塊化設計,貫徹綠色節能的設計理念,整機采用集中供電和散熱,搭載高效的智能調速策略,根據環境和整機工作負載實時調速,達到靜音運行的效果。

采用第五代英特爾至強可擴展處理器為AI推理提供強大算力支持

寧暢B5000 G5多節點服務器支持第五代英特爾 至強 可擴展處理器,進一步提升了算力密度,并提升了能效,能夠為計算、存儲、網絡等多種類型的應用構建強大的性能基礎。

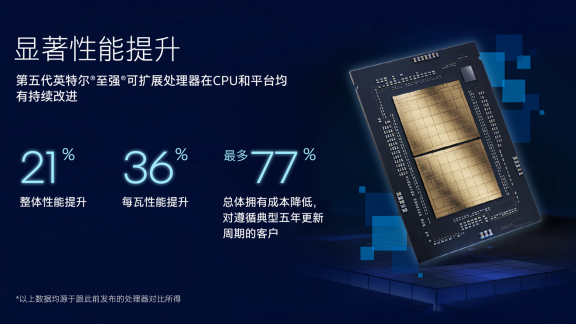

第五代英特爾 至強 可擴展處理器為拓展HPC與AI應用提供了強大的性能基礎。新一代處理器擁有更可靠的性能,更出色的能效。它在運行各種工作負載時均可實現顯著的每瓦性能增益,在AI、數據中心、網絡和科學計算的性能和總體擁有成本(TCO)方面亦有更出色的表現。相較上一代產品,第五代英特爾 至強可擴展處理器可在相同功耗范圍內提供更高的算力和更快的內存。此外,它與一代產品的軟件和平臺兼容,因此部署新系統時可大大減少測試和驗證工作。

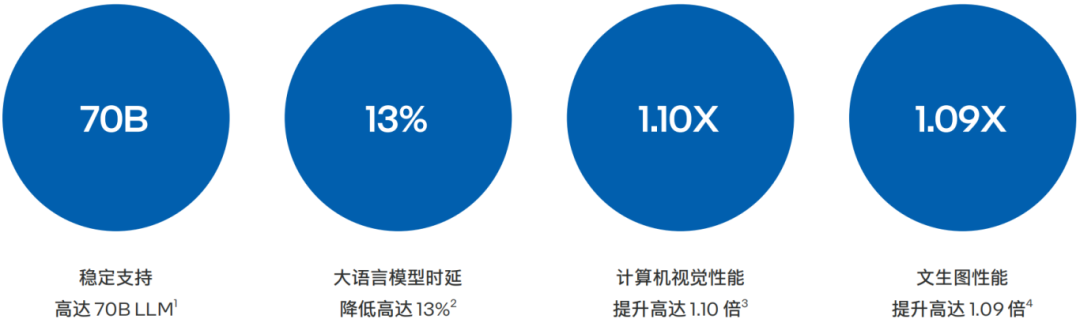

圖2. 第五代英特爾 至強 可擴展處理器具備更強大性能

除了利用第五代英特爾 至強 可擴展處理器帶來的基礎性能的提升之外,寧暢B5000 G5多節點服務器還重點利用了處理器提供的AI加速能力。

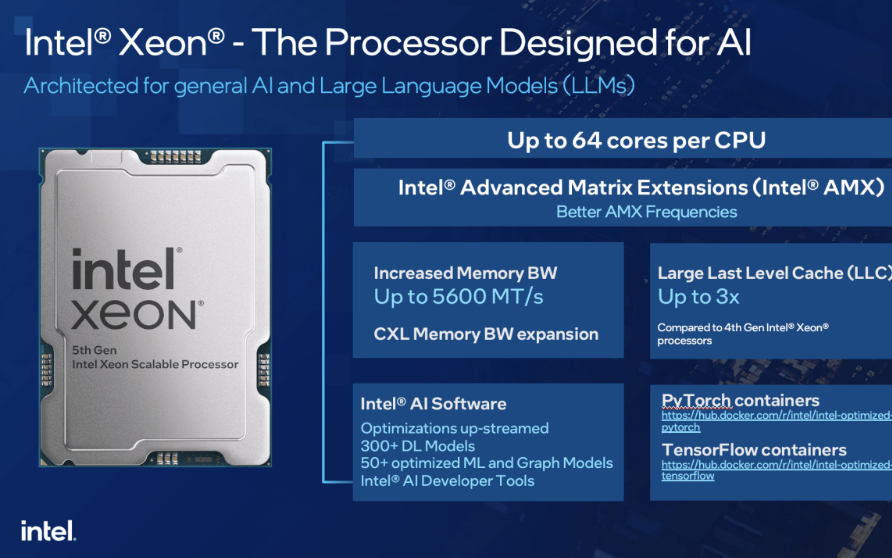

該處理器內置了創新的英特爾 AMX加速引擎。英特爾 AMX針對廣泛的硬件和軟件優化,它進一步增強了前代技術 — 矢量神經網絡指令(VNNI)和BF16,從一維向量發展為二維矩陣,以便最大限度地利用計算資源,提高高速緩存利用率,以及避免潛在的帶寬瓶頸,顯著增加了人工智能應用程序的每時鐘指令數(IPC),可為AI工作負載中的訓練和推理提供性能提升,可對參數量多達200億的模型進行推理和調優10。

為了進一步增強AI推理性能表現,寧暢B5000 G5多節點服務器還能夠英特爾 以太網控制器E810中的RDMA (Remote Direct Memory Access) 功能,降低網路數據傳輸過程中的時延,提供高速的跨節點通信,化解大規模AI推理任務在集群通信中的網絡瓶頸。

寧暢測試了基于第五代英特爾 至強 可擴展處理器的B5000 G5多節點服務器在多種AI推理工作負載中的性能表現。

大語言模型 (LLM):高密度、多并發、支持高達70B

LLaMa2是Meta發布的免費可商用版本的大模型,LLaMa2模型系列包含70億、130億和700億三種參數變體。LLaMa2相比第一代在預訓練語料庫大小上增加了40%,LLaMa2接受了2萬億個Token的訓練,精調Chat模型在100萬人類標記數據上訓練,上下文長度是第一代的兩倍,并采用了分組查詢注意力機制等優化結構。

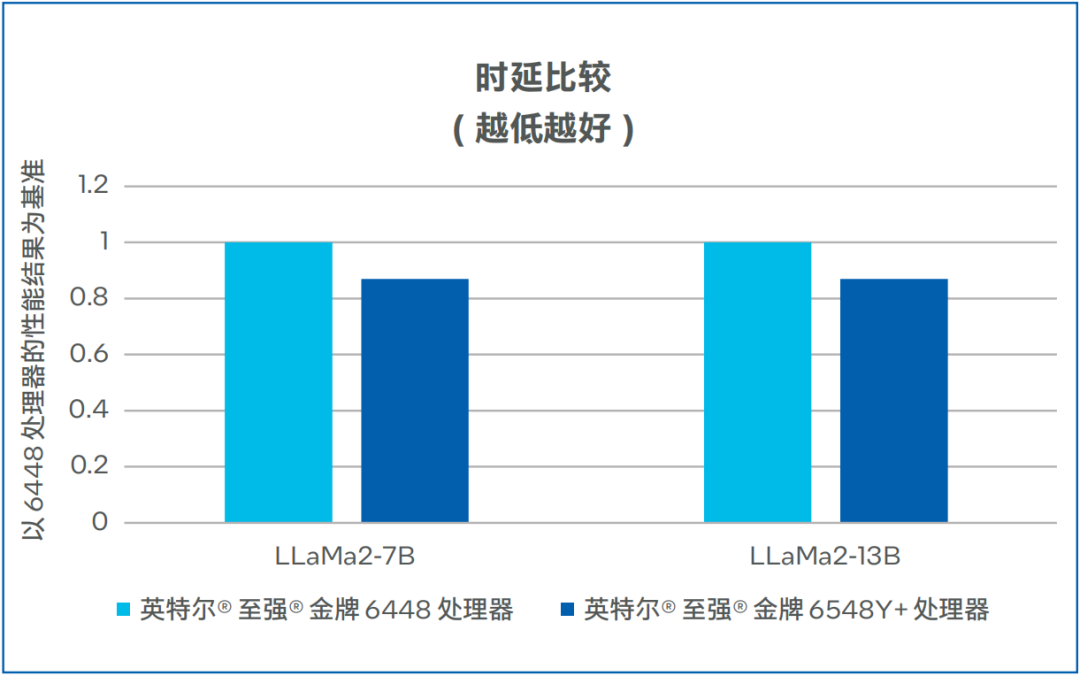

第四代/第五代英特爾 至強 可擴展處理器的代際時延數據對比如圖3所示,在LLaMa2-7B和LLaMa2-13B模式中,時延均有13%的下降11。

此外,第五代英特爾 至強 可擴展平臺可支持多通道大容量的內存,使用64G內存時,單節點(Node)至少可以擴展到1024GB內存,這樣可支持LLM模型的并發。其中,70B-4Node可同時支持28個LLM模型并發,13B-1Node可同時支持40個LLM模型并發,7B-1Node可同時支持72個LLM模型并發。 在第二次token時,時延可低至63.5毫秒。除了在模型并發上有卓越表現外,模型之間的切換也在10毫秒之內,幾乎無感,模型駐留數最高可達到576個12。

圖3. LLaMa2-7B和LLaMa2-13B時延比較

Resnet 50

ResNet50是一種非常流行的卷積神經網絡模型,ResNet50的主要特點是引入了“殘差塊”(Residual + Block)。在傳統的神經網絡中,每一層都是在前一層的基礎上添加新的變換,而在ResNet中,每一層都是在前一層的基礎上添加新的變換,同時還保留了前一層的原始輸入,這種設計使得網絡可以更好地學習輸入和輸出之間的差異,而不是直接學習輸出,這有助于提高模型的性能。

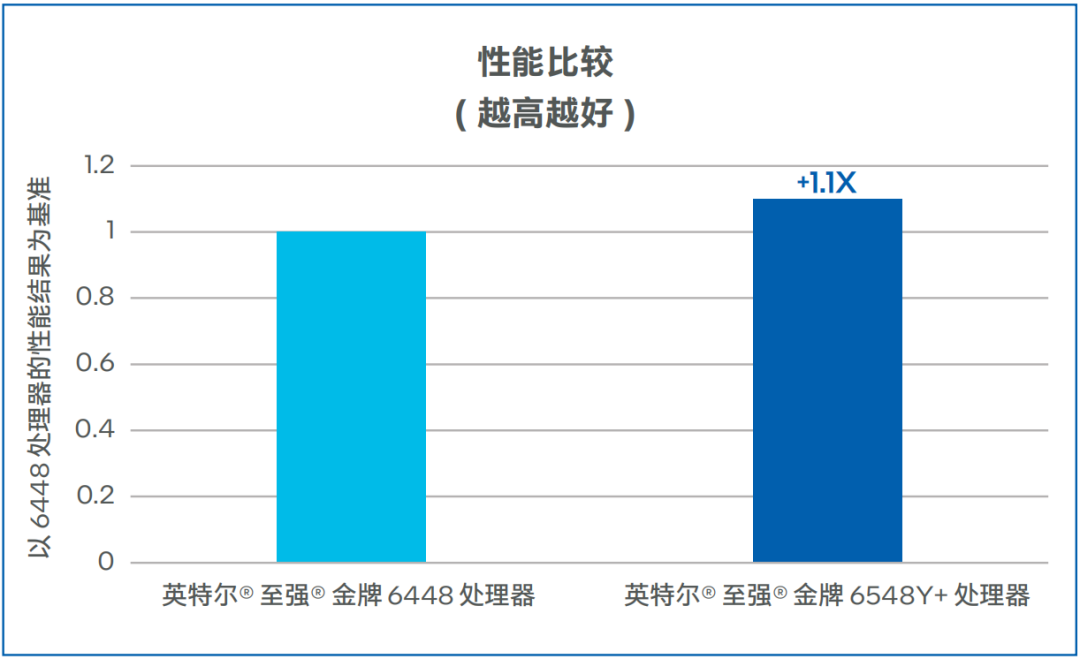

寧暢的測試數據如圖4所示,相較第四代英特爾 至強 可擴展處理器,基于第五代英特爾 至強 可擴展處理器的寧暢B5000 G5多節點服務器,將ResNet50推理性能提升了10%13。

圖4. ResNet50性能比較(越高越好)

文本生成圖像

(Stable Diffusion)

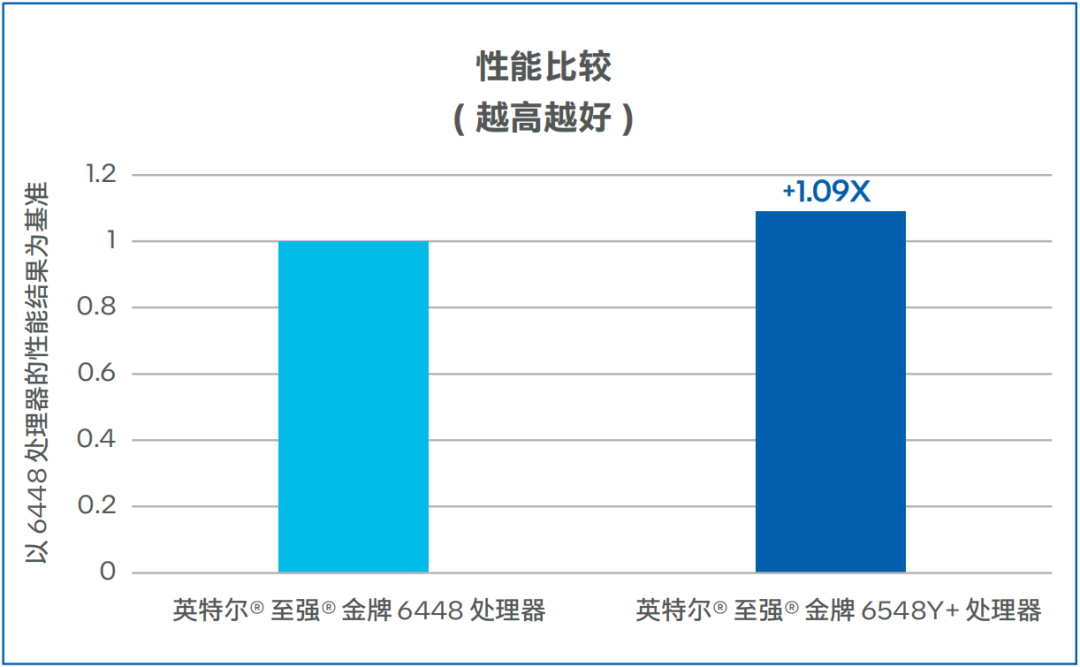

Stable Diffusion是一種基于潛在擴散模型(Latent Diffusion Models) 的文本到圖像生成模型,能夠根據任意文本輸入生成高質量圖像,同時還保留了圖像的語義結構。Stable-Diffusion一般需要數秒完成圖片生成,生成的圖像具有較高的逼真度和細節表現力。寧暢的測試數據如圖5所示,相較第四代英特爾 至強 可擴展處理器,基于第五代英特爾 至強 可擴展處理器的寧暢B5000 G5多節點服務器,將Stable Diffusion推理性能提升了9%14。

圖5. Stable Diffusion性能比較

上述測試主要基于單節點配置環境完成,用戶還可通過部署更多節點,來獲得更高的性能表現。

收 益

基于第五代英特爾 至強 可擴展處理器的寧暢B5000 G5多節點服務器為用戶的AI推理任務帶來了如下收益:

在保證特定精度的前提下,模型推理的吞吐量、時延等性能指標方面能夠比肩常規GPU,滿足大語言模型等AI模型的推理需求。

可以在4U8節點上同時執行多個AI推理任務,在特定的服務質量(SLA)要求下,實現較高的并發量,有助于提升資源的利用率,降低AI推理的總體擁有成本(TCO)。

無需增加專門的硬件便可以支持高效的AI推理,有助于提升服務器的靈活性,敏捷地滿足多種應用工作負載的支撐需求。

展 望

大模型應用已經進入到爆發期,《中國人工智能大模型地圖研究報告》顯示,2023 年,全球發布的大模型數量已經超過200個,其中中國發布的大模型已經達到了79個15。面對百億、千億乃至萬億規模的大模型數據處理、訓練、調優及推理需求,用戶迫切希望構建符合自身業務特點和需求的AI算力平臺,進行計算資源的合理配置。基于第五代英特爾 至強 可擴展處理器的寧暢B5000 G5多節點服務器憑借在性能、靈活性等方面的優勢,有望成為用戶推動大模型推理的重要基礎設施。

除了模型推理之外,基于第五代英特爾 至強 可擴展處理器的寧暢B5000 G5多節點服務器還在更多場景中,提供了卓越的性能、擴展性與敏捷性。雙方將在技術探索、產品升級、應用推廣等多個層面深度協作,建設從云到邊緣的基礎設施,推動數字資源平等,打破數字鴻溝,以澎湃的算力賦能數字經濟的高速發展。

審核編輯:劉清

-

處理器

+關注

關注

68文章

19159瀏覽量

229112 -

英特爾

+關注

關注

60文章

9880瀏覽量

171480 -

人工智能

+關注

關注

1791文章

46845瀏覽量

237533 -

大模型

+關注

關注

2文章

2322瀏覽量

2479

原文標題:寧暢B5000 G5多節點服務器采用第五代英特爾? 至強? 可擴展處理器,提供卓越、高靈活度的AI推理算力

文章出處:【微信號:英特爾中國,微信公眾號:英特爾中國】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

開箱即用,AISBench測試展示英特爾至強處理器的卓越推理性能

浪潮信息NE5260G7服務器適配第五代英特爾至強處理器

英特爾至強處理器優化升級,助力打造未來高能效數據中心

英特爾專家為您揭秘第五代英特爾? 至強? 可擴展處理器如何為AI加速

64核+高內存帶寬!英特爾發布第五代至強服務器,加速AI原生應用落地

第五代英特爾至強可擴展處理器 AI 性能大幅提升,英特爾加注推動人工智能無處不在

第五代英特爾至強可擴展處理器,為AI加速而生

寧暢B5000 G5多節點服務器采用第五代英特爾至強可擴展處理器

寧暢B5000 G5多節點服務器采用第五代英特爾至強可擴展處理器

評論