自計算機問世以來,運算效能與能耗消耗兩大議題始終困擾著計算產業。在人工智能崛起的背景下,全球各地科研機構及相關公司積極探索提高處理器算力的新方法,神經擬態處理器即是一種創新嘗試。

如何模仿大腦思維?

神經擬態計算,即模擬和探索人腦神經網絡及其運作規律的領域,我們將之稱為類腦計算或神經形態計算。數十年來,科學家們致力于復刻生物神經元的多功能運算模式,以期研發出高效能且低功耗的機器學習系統。

歷經多年探索,業界已形成三種神經擬態處理器的實現路徑。一為數字CMOS型,通過邏輯門電路模擬生物單元行為;二為數模混合的CMOS型,借助亞閾值模擬電路呈現生物神經元特性;前兩者均基于硅基晶體管。第三種則是研發新型器件,如憶阻器、相變存儲器、鐵電器件、磁隧道結、離子柵控晶體管等,并采用非硅基材料。

然而,目前大部分研究尚未實現商業化生產。英特爾作為眾多研究機構中的佼佼者,選擇了第一種實現方式——用晶體管模擬人類神經元功能。其中,如何讓處理器達到類似人腦的節能效果,便是他們的重要研究課題。

德國海德堡大學物理學家卡爾海因茨·邁耶(Karlheinz Meier)指出,相比計算機,人腦具有三大優勢:低能耗,僅需約20瓦特的能量。

今年四月,英特爾推出神經擬態系統Hala Point。據稱,該系統在處理AI推理負載和優化問題方面,速度較常規CPU和GPU架構快50倍,而能耗卻降低了100倍。近日,英特爾中國研究院院長宋繼強向中國電子報記者詳解了該系統模擬人腦節能的實現原理。他首先解釋了市場上常見芯片系統的頻率特征:通常提及的CPU主頻,如5GHz,代表同步時鐘的頻率,即芯片內所有邏輯門、存儲均以此頻率運行,或在此基礎上進行降級。例如,總線頻率可能低于CPU主頻,I/O接口頻率更低,但總體來看,同一芯片內所有組件均受同步時鐘驅動,從而實現同時工作。因此,各部件能耗也同步進行。

宋繼強表示,英特爾的神經擬態計算無需同步時鐘,取代之的是“時間步”概念——每當任務結束,“神經元”便依據預定順序逐步推進。每個時間步里,信號均由一個神經元傳至下一個,以此方式進行傳播和擴散。盡管神經擬態計算要求系統在時間步級別保持同步,但并非所有神經元需在所有工作序列中完全同步,允許有些任務快速處理,有些則緩慢處理。這與人類大腦類似,部分神經元負責處理嗅覺信息,同時另一部分則處理視覺信息。因此,在神經擬態計算系統中,有任務執行的路徑會消耗電力,其余路徑則處于休眠狀態。即使是大規模的神經擬態集群,其運行時神經元也僅進行少量并行運算。

該計算系統另一節能策略在于其存算一體的結構。當前市場上計算系統的能源消耗主要集中于計算和數據傳輸兩個方面,而神經擬態計算系統通過實現存算一體,成功規避了傳統核內外架構在處理大量數據傳輸時產生的能量損失。

節能與否,取決于具體情境

低能耗被視為神經擬態處理器的天然架構優勢。早在2020年,宋繼強就曾公開宣稱:神經擬態計算在算法及芯片設計上,可以千分之一以內的功耗完成同等效果的模型訓練。浙江大學的唐華錦教授亦認同神經擬態芯片為環保型芯片,因其體積小、功耗低,符合生物進化的根本優勢。

然而,根據Hala Point最新實踐成果,該架構處理器的節能效果與其使用情境密切相關。宋繼強指出,現階段發現該系統在處理物流調度數據中心的大規模優化任務時能效表現最佳,相較于CPU+GPU組合方案節能高達3000倍。

“但這并非指數據中心所有工作負載,僅針對個別項目。”他補充道,“我們正努力尋找該系統適用的場景,若賦予其不適宜的任務,能耗或高于原有處理系統。”

至于HalaPoint能否解決當前大模型訓練中的高能耗問題,宋繼強回應稱:該系統設計初衷并非專為大模型服務,故不適合大規模數據輸入。

ResNet50網絡(殘差網絡的一種)是驗證Hala Point節能效果的典型場景之一。在此類應用中,經優化的Hala Point在達到相同性能前提下,能耗可降至原有方案的百分之一以下。對于某些特定深度的神經網絡,如視覺識別類應用,通過在脈沖神經網絡上進行適當調整,結合硬件層面的適配,同樣有助于降低能耗。

總的來說,該系統在稀疏性局部并發型應用中表現更為出色。目前,市面上大部分神經擬態處理器主要應用于機器人、無人機等領域。宋繼強透露,HalaPoint約有一半的應用涉及機器人、操控、多模態視覺等方面。

-

處理器

+關注

關注

68文章

19165瀏覽量

229130 -

英特爾

+關注

關注

60文章

9886瀏覽量

171525 -

神經

+關注

關注

0文章

45瀏覽量

12514

發布評論請先 登錄

相關推薦

卷積神經網絡的基本原理與算法

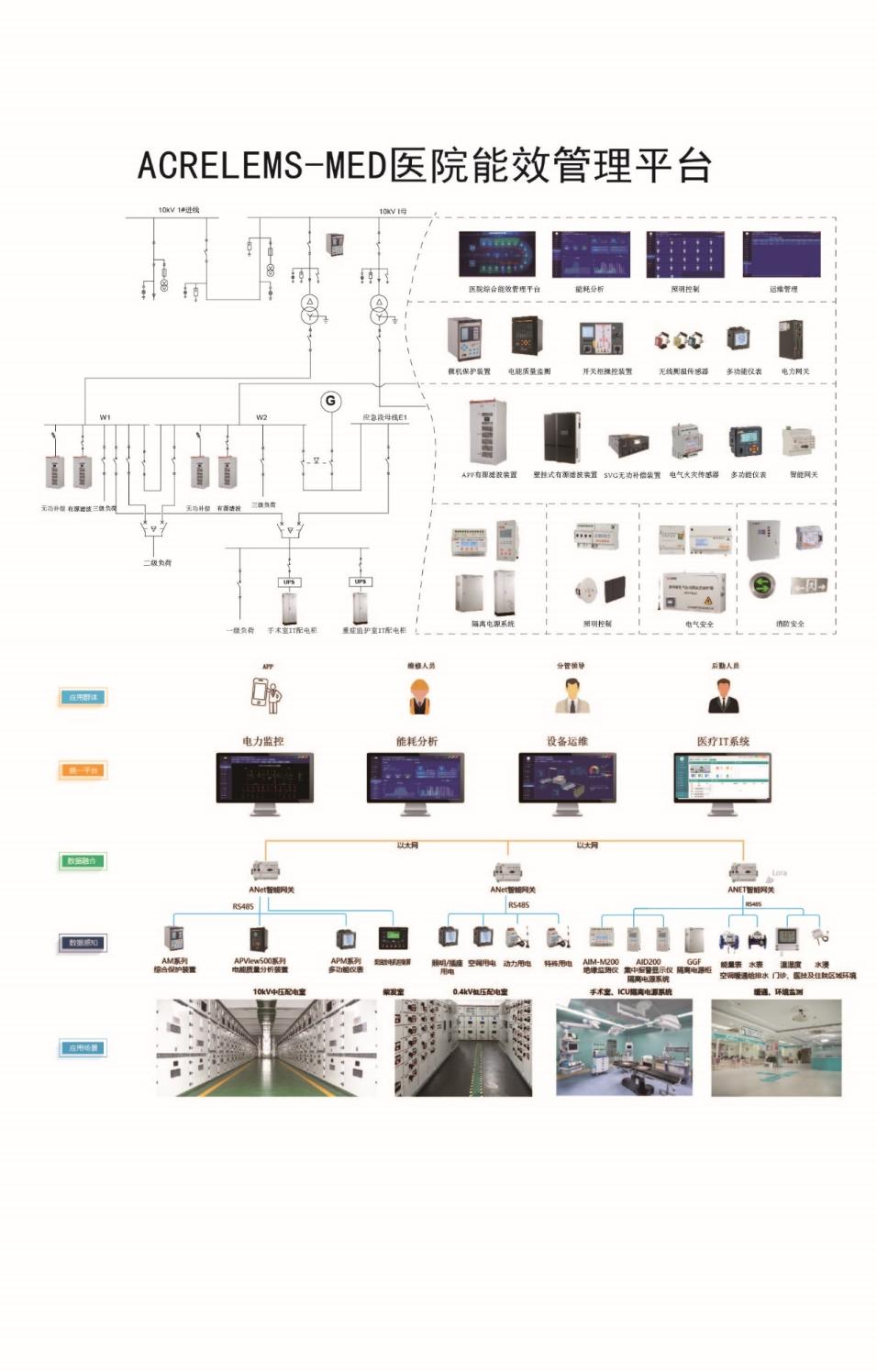

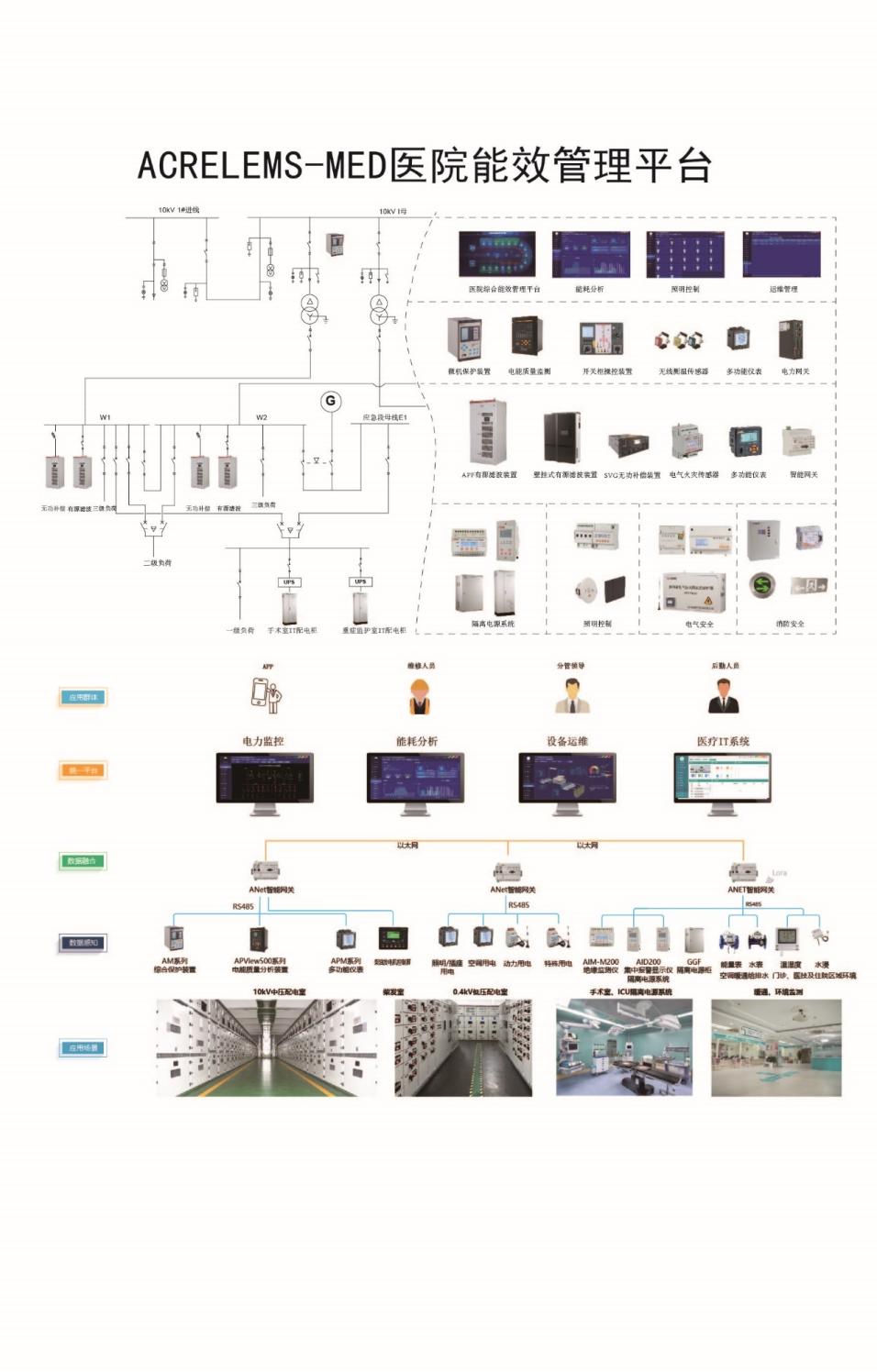

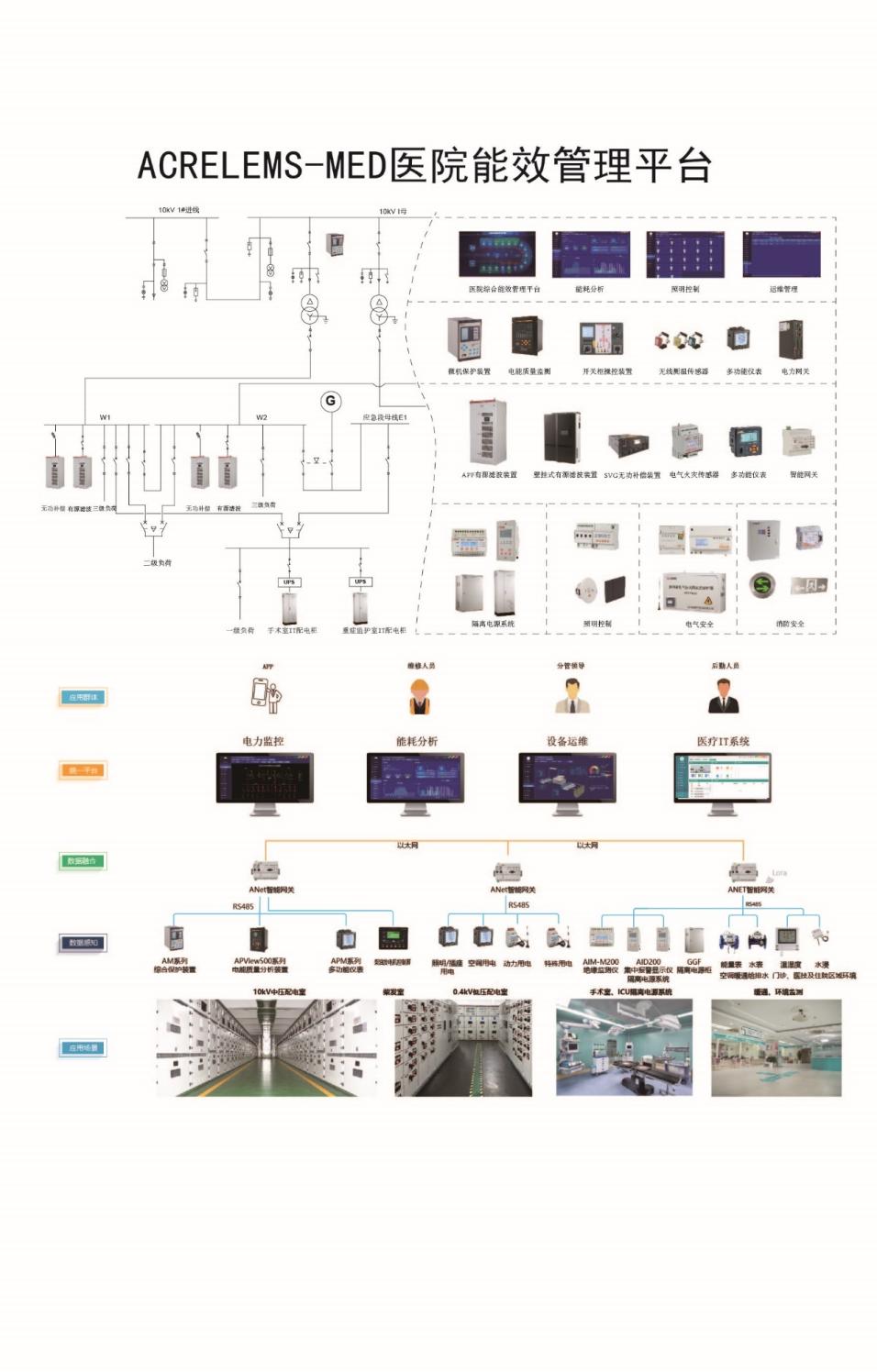

淺析醫院節能降耗的意義和應采取的措施

醫院節能降耗的意義和應采取的對策措施

醫院節能降耗意義淺析與對策措施探索

LMV7219電特性表里面的失調電壓和內部滯環的計算是帶符號計算嗎?

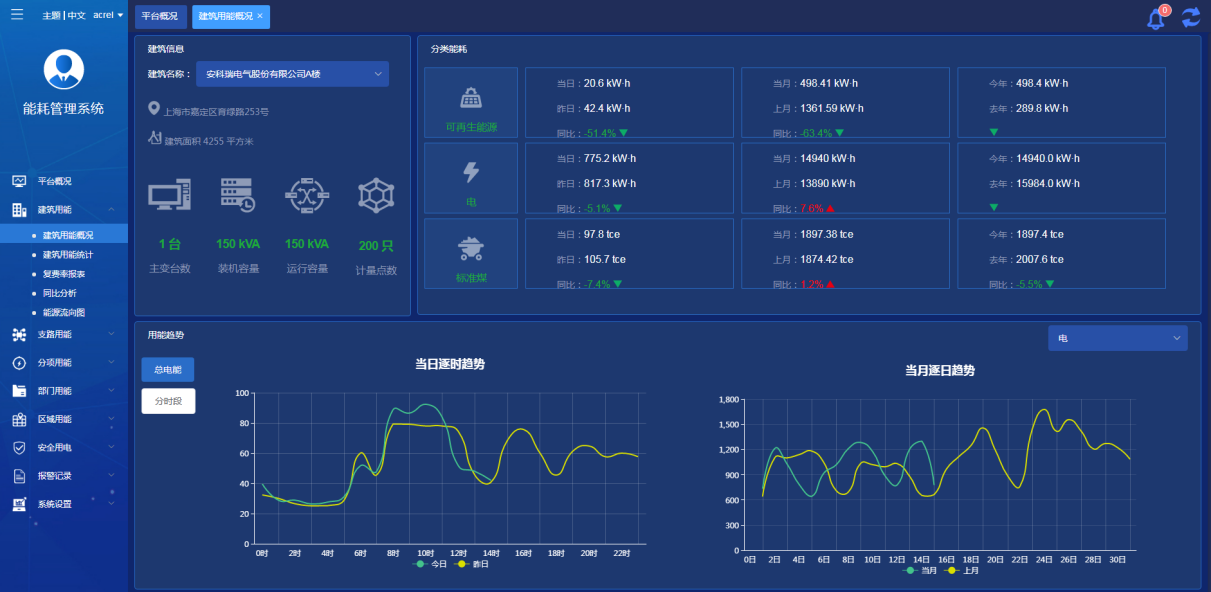

探討水電節能降耗監測平臺的應用價值

簡述遞歸神經網絡的計算過程

卷積神經網絡計算過程和步驟

邊緣計算是什么意思?邊緣計算的應用

存內計算WTM2101編譯工具鏈 資料

英特爾發布新一代神經擬態系統Hala Point,11.5億神經元,12倍性能提升

淺談能耗系統在節能降耗的應用

神經擬態計算是如何降耗的

神經擬態計算是如何降耗的

評論