電子發燒友網報道(文/周凱揚)近日,一家由哈佛輟學生成立的初創公司Etched,宣布了他們在打造的一款“專用”AI芯片Sohu。據其聲稱該芯片的速度將是英偉達H100的20倍,但只能跑transformer架構的模型。

Sohu,比H100快上20倍

之所以打算Sohu這一自研ASIC AI芯片,是因為Etched認為GPU在性能升級上的速度太慢了。如果以H100的單位面積算力和交期作為參考,那么從2022年到2025年,英偉達的H100迭代至B200,2.5年的時間內性能只有15%的提升。所以要想有效提高性能的方式,只有走特化的ASIC芯片一途。

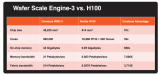

現在發布的任何AI芯片,在提到性能時,無疑都會把英偉達的H100作為對比參照,Etched的Sohu也不例外。根據Etched提供的數據,單個Sohu服務器運行Llama 70B時可以做到50萬Tokens每秒,這一速度是單個H100服務器的20倍以上,也是單個B200服務器的10倍以上。

在服務器的配置上,Sohu服務器和H100服務器均采用的8卡的配置,所以Etched強調一個8xSohu的服務器就可以替換掉至少160個H100,大大降低成本的同時,也不會有性能損失。

由于Sohu僅支持一種算法,所以絕大多數的控制流模塊都可以被剔除,芯片可以集成更多的數學計算單元,在算力利用率上可以達到90%以上,而GPU卻只能做到30%。這也是因為在GPU的電路設計上,用于矩陣乘法的晶體管數量甚至沒有占到10%。不過Etched對于英偉達的設計還是相當佩服的,指出如果同時想支持CNN、LSTM、SSM等其他模型,確實很難做得比英偉達更好。

當然了,這里的測試條件也必須做一個說明,測試標準為FP8精度的Llama 70B,無稀疏,其中H100是基于最新版本的TensorRT-LLM測試的,而B200由于還未交付,所以其性能是預估的。

為何專攻Transformer模型

市面上的AI芯片和GPU產品為了覆蓋更靈活的客戶需求,盡管不少都采用了ASIC的設計方案,但支持的模型卻不會局限在一類。Etched也在其官網列出了市面上一些競品方案,包括英偉達的GPU、谷歌的TPU、亞馬遜的Trainium、Graphcore的IPU、Tenstorrent的Grayskull和英特爾的Gaudi等等,這些方案無一不對廣泛的AI模型提供了支持。

但我們從市面上頭部的模型來看,幾乎占據主導地位的都是transformer架構的模型,比如GPT、Sora、Gemini和Stable Diffusion。Etched很大方地表示,如果哪一天transformer被SSM、RWKV或其他新的架構替代了,他們的芯片將變得一無是處,對于千變萬化的AI市場而言,絕大多數廠商都不敢沒法做出這樣的預測。

而Etched從2022年底,就賭transformer模型將會統治整個市場。這在當時還沒有ChatGPT的年代,是一個大膽的預測,畢竟當時圖像生成還有基于CNN的U-Net,不少自動駕駛的視覺處理也還在廣泛使用CNN。而且對于一個規模不算大的設計團隊而言,維護單一架構的軟件棧明顯壓力更小一些,他們只需要為transformer編寫驅動、內核即可。

寫在最后

至于Etched的這場豪賭是否能成功,還得看芯片的成品表現如何。雖然他們嘗試的這條路線沒人走過,但財力和研發能力均在他們之上的廠商也沒能打造出超過英偉達GPU的競品,硅谷的VC們能否造出新神,依然不能過早下定論。

-

Transformer

+關注

關注

0文章

141瀏覽量

5981 -

AI芯片

+關注

關注

17文章

1859瀏覽量

34908

發布評論請先 登錄

相關推薦

2024年全球AI芯片收入將達712.52億美元

安霸發布兩款用于車隊遠程監控及信息處理系統的最新一代AI芯片

risc-v多核芯片在AI方面的應用

最強AI芯片發布,Cerebras推出性能翻倍的WSE-3 AI芯片

蘋果M3芯片MacBook Air被譽為全球最佳消費級AI產品

把Transformer大模型部署在端側,IPC SoC正在普惠AI

只能跑Transformer的AI芯片,卻號稱全球最快?

只能跑Transformer的AI芯片,卻號稱全球最快?

評論