在深度學習領域,卷積神經網絡(Convolutional Neural Network, CNN)以其卓越的圖像處理和計算機視覺能力而廣受歡迎。CNN由多個層組成,其中包括卷積層、池化層、全連接層等。其中,池化層(Pooling Layer)作為CNN的重要組成部分,在降低模型復雜度、提高計算效率以及增強模型的不變性和魯棒性方面發揮著關鍵作用。本文將從多個方面深入探討池化層的作用,力求全面解析其在CNN中的核心地位。

一、池化層的基本概念

池化層是CNN中用于減少特征圖空間尺寸的一種層,其通過對輸入特征圖進行下采樣操作,降低數據的維度,從而減少模型的計算量和參數數量。池化層通常緊跟在卷積層之后,利用某種池化函數對特征圖進行聚合,提取出主要特征,同時保持特征的空間結構。常見的池化操作包括最大池化(Max Pooling)和平均池化(Average Pooling)。

二、池化層的主要作用

1. 降維與減少計算量

池化層最直接的作用是降低特征圖的空間尺寸,即進行降維處理。在CNN中,隨著卷積層的逐層深入,特征圖的尺寸會逐漸增大,同時包含的參數和計算量也會急劇增加。如果不加以控制,這將導致模型訓練變得非常耗時且難以優化。池化層通過下采樣操作,有效減少了特征圖的尺寸,進而減少了后續層的參數數量和計算量,使得模型訓練更加高效。

例如,在最大池化中,池化窗口會遍歷整個特征圖,并在每個窗口內選擇最大值作為輸出。這樣,一個2x2的池化窗口可以將特征圖的尺寸減半,同時保留了窗口內最重要的特征信息。這種操作不僅減少了數據維度,還減少了模型的計算復雜度,使得模型能夠在保持性能的同時,更快地收斂。

2. 特征不變性

池化層還具有提取特征不變性的能力。在圖像處理中,圖像的目標物體可能會因為平移、旋轉或尺度變化而呈現不同的形態。然而,這些變化通常不會改變目標的本質特征。池化層通過其下采樣操作,使得模型對輸入數據的輕微變化具有一定的魯棒性。

具體來說,最大池化能夠保留局部區域內最顯著的特征,即使目標物體在圖像中發生小范圍的平移或變形,池化層仍然能夠識別出相同的特征。這種特性有助于提高模型的泛化能力,使得模型能夠在不同的數據集和場景下保持良好的性能。

3. 防止過擬合

過擬合是機器學習中一個常見的問題,尤其是在訓練復雜模型時更容易發生。過擬合指的是模型在訓練集上表現良好,但在測試集上性能急劇下降的現象。這通常是因為模型過于復雜,以至于學習了訓練數據中的噪聲和細節信息。

池化層通過減少特征圖的尺寸和參數數量,有助于降低模型的復雜度,從而在一定程度上防止過擬合。此外,池化操作還具有一定的正則化效果,能夠減少模型對訓練數據的依賴,提高模型的泛化能力。

4. 擴大感知野

感知野是指模型在輸入數據上能夠看到的區域大小。在CNN中,隨著卷積層的深入,每個神經元的感知野會逐漸增大,從而能夠捕捉到更廣泛的上下文信息。然而,單純的卷積操作會導致感知野的增大速度較慢,尤其是在網絡較淺時。

池化層通過其下采樣操作,能夠在不增加模型復雜度的前提下,有效地擴大神經元的感知野。這是因為池化操作將多個相鄰的像素值聚合為一個輸出值,從而使得后續層的神經元能夠看到更廣泛的區域。這種特性有助于模型更好地捕捉全局信息,提高分類和識別任務的準確性。

三、池化操作的類型

1. 最大池化(Max Pooling)

最大池化是最常用的池化方法之一。在最大池化中,池化窗口會遍歷整個特征圖,并在每個窗口內選擇最大值作為輸出。這種操作能夠保留局部區域內最顯著的特征信息,同時去除冗余信息。最大池化具有計算簡單、效果顯著的優點,廣泛應用于各種CNN模型中。

然而,最大池化也存在一些缺點。由于它只保留每個區域內的最大值而丟棄其他信息,因此可能會丟失一些細節信息。在某些情況下,這可能會導致信息損失和性能下降。

2. 平均池化(Average Pooling)

平均池化是另一種常用的池化方法。在平均池化中,池化窗口會計算窗口內所有值的平均值作為輸出。這種操作能夠保留更多的信息細節和背景特征,使得模型在處理復雜圖像時更加魯棒。然而,平均池化也可能導致特征圖的模糊化問題,因為平均值可能會模糊掉一些重要的邊緣和紋理信息。

池化操作的類型(續)

3. 隨機池化(Stochastic Pooling)

隨機池化是一種介于最大池化和平均池化之間的方法。在隨機池化中,池化窗口內的每個元素會根據其值的大小被賦予一個概率,然后按照這些概率隨機選擇一個元素作為輸出。這種方法結合了最大池化和平均池化的優點,既能夠保留重要的特征信息,又能夠引入一定的隨機性,有助于防止過擬合。然而,隨機池化的計算復雜度相對較高,且在實際應用中可能不如最大池化和平均池化穩定。

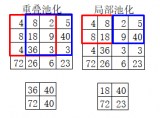

4. 重疊池化(Overlapping Pooling)

在傳統的池化操作中,池化窗口通常是不重疊的,即窗口在滑動時每次移動的步長等于窗口的大小。然而,重疊池化允許池化窗口在滑動時有一定的重疊區域。這種方法可以增加特征圖的冗余度,使得模型在訓練過程中更加穩定,同時也有助于提高模型的性能。然而,重疊池化也會增加計算量和模型復雜度,需要在實際應用中權衡其利弊。

5. 空間金字塔池化(Spatial Pyramid Pooling, SPP)

空間金字塔池化是一種特殊的池化方法,它能夠在不同尺度上對特征圖進行池化操作,從而提取出多尺度的特征信息。SPP層可以接受任意尺寸的特征圖作為輸入,并將其劃分為多個不同尺度的網格,然后在每個網格內進行池化操作。這種方法使得模型能夠適應不同尺寸的輸入圖像,同時提取出更加豐富的特征信息。SPP層在目標檢測、圖像分類等任務中得到了廣泛應用,并取得了顯著的性能提升。

四、池化層在CNN中的應用實例

池化層在CNN中的應用非常廣泛,幾乎所有的主流CNN模型都包含了池化層。以下是一些典型的CNN模型及其池化層的應用實例:

1. LeNet-5

LeNet-5是最早的CNN模型之一,由Yann LeCun等人于1998年提出。該模型包含兩個卷積層、兩個池化層以及兩個全連接層。在LeNet-5中,池化層采用了平均池化操作,用于降低特征圖的尺寸和減少計算量。這種結構使得LeNet-5在手寫數字識別等任務中取得了優異的性能。

2. AlexNet

AlexNet是2012年ImageNet競賽的冠軍模型,由Alex Krizhevsky等人提出。該模型包含了五個卷積層、三個最大池化層以及三個全連接層。AlexNet中的池化層采用了最大池化操作,有效地保留了局部區域內的顯著特征信息,并提高了模型的魯棒性和泛化能力。

3. VGGNet

VGGNet是由牛津大學的Visual Geometry Group提出的一系列CNN模型,其特點在于使用了多個小尺寸的卷積核和多個池化層來構建深層的網絡結構。VGGNet中的池化層同樣采用了最大池化操作,并且具有固定的池化窗口大小和步長。這種結構使得VGGNet在圖像分類、目標檢測等任務中取得了卓越的性能。

4. ResNet

ResNet(殘差網絡)是近年來提出的一種深度CNN模型,通過引入殘差學習機制解決了深層網絡難以訓練的問題。ResNet中的池化層同樣采用了最大池化或平均池化操作,但相比于其他模型,ResNet更加注重于通過殘差連接來保持信息的流通和梯度的回傳。這種設計使得ResNet能夠構建出極深的網絡結構,并在多個計算機視覺任務中取得了領先的結果。

五、結論與展望

池化層作為CNN中的重要組成部分,在降低模型復雜度、提高計算效率、增強模型不變性和魯棒性等方面發揮著關鍵作用。通過不同類型的池化操作,池化層能夠提取出豐富的特征信息,并幫助模型更好地適應不同的任務和數據集。隨著深度學習技術的不斷發展,未來池化層的設計和應用也將不斷創新和完善,為計算機視覺和自然語言處理等領域帶來更多的突破和進展。

然而,值得注意的是,隨著CNN模型的不斷加深和復雜化,池化層的作用也在逐漸發生變化。在一些最新的研究中,研究者開始探索無池化層的CNN模型(如全卷積網絡),并發現這些模型在某些任務上也能取得優異的性能。這表明,在未來的發展中,池化層可能不再是CNN模型的必要組成部分,而是需要根據具體任務和數據集來靈活選擇和調整。因此,對于CNN從業者而言,持續關注和學習最新的研究成果和技術趨勢至關重要。

-

深度學習

+關注

關注

73文章

5493瀏覽量

121000 -

cnn

+關注

關注

3文章

351瀏覽量

22178 -

卷積神經網絡

+關注

關注

4文章

366瀏覽量

11853

發布評論請先 登錄

相關推薦

卷積神經網絡中池化層的作用

卷積神經網絡中池化層的作用

評論