人工神經(jīng)網(wǎng)絡(luò)(Artificial Neural Networks, ANNs)是一種受生物神經(jīng)網(wǎng)絡(luò)啟發(fā)的計(jì)算模型,廣泛應(yīng)用于各種領(lǐng)域。本文將介紹不同類型的人工神經(jīng)網(wǎng)絡(luò)模型及其作用。

- 前饋神經(jīng)網(wǎng)絡(luò)(Feedforward Neural Networks, FNNs)

前饋神經(jīng)網(wǎng)絡(luò)是一種最基本的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu),其信息流動(dòng)是單向的,從輸入層到隱藏層,最后到輸出層。FNNs主要用于解決分類和回歸問(wèn)題。

1.1 單層感知器(Single-Layer Perceptron, SLP)

單層感知器是最簡(jiǎn)單的FNNs,只有一個(gè)神經(jīng)元。SLP主要用于線性可分問(wèn)題,如邏輯門(mén)和簡(jiǎn)單的分類任務(wù)。

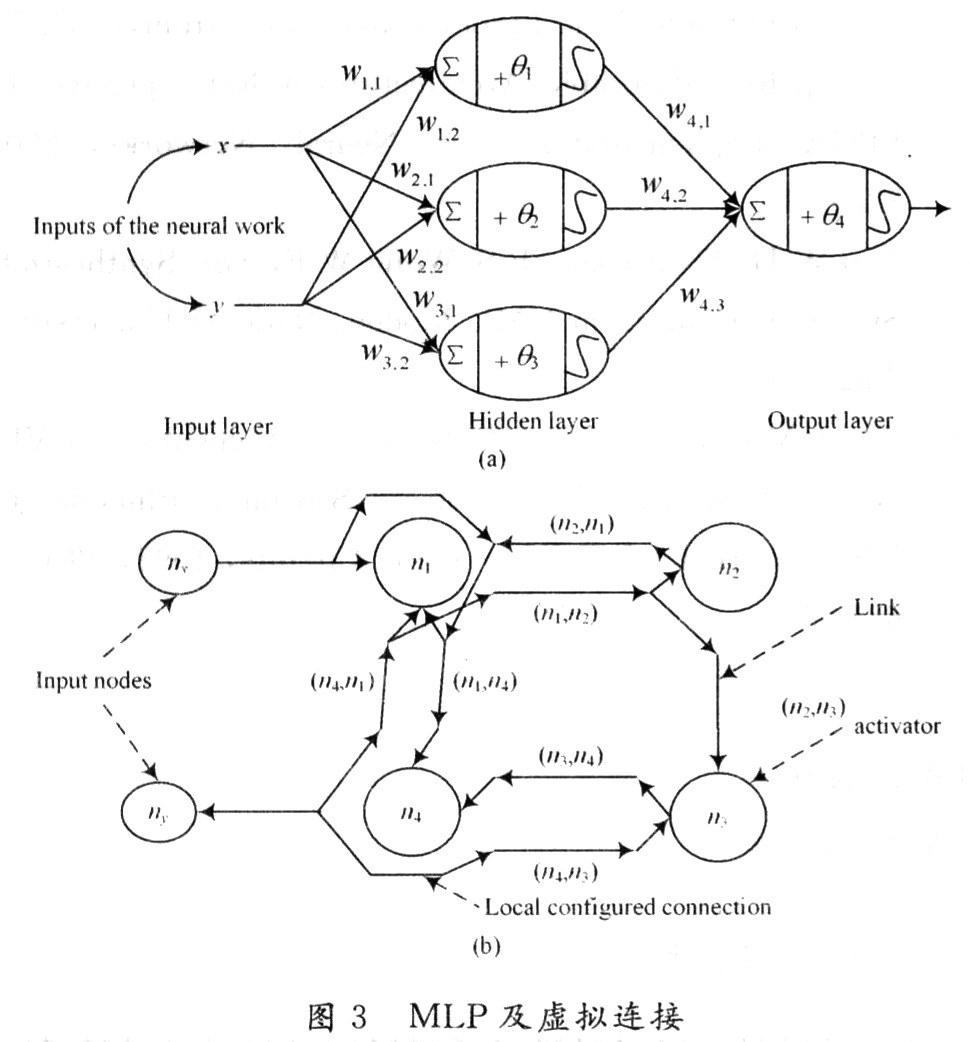

1.2 多層感知器(Multi-Layer Perceptron, MLP)

多層感知器在SLP的基礎(chǔ)上增加了一個(gè)或多個(gè)隱藏層,使其能夠解決非線性問(wèn)題。MLP廣泛應(yīng)用于語(yǔ)音識(shí)別、圖像識(shí)別和自然語(yǔ)言處理等領(lǐng)域。

- 卷積神經(jīng)網(wǎng)絡(luò)(Convolutional Neural Networks, CNNs)

卷積神經(jīng)網(wǎng)絡(luò)是一種特殊的FNNs,主要用于處理具有網(wǎng)格結(jié)構(gòu)的數(shù)據(jù),如圖像。CNNs通過(guò)卷積層和池化層提取特征,然后使用全連接層進(jìn)行分類。

2.1 基本卷積神經(jīng)網(wǎng)絡(luò)

基本卷積神經(jīng)網(wǎng)絡(luò)包括卷積層、激活函數(shù)、池化層和全連接層。卷積層用于提取局部特征,激活函數(shù)引入非線性,池化層降低特征維度,全連接層進(jìn)行分類。

2.2 深度卷積神經(jīng)網(wǎng)絡(luò)

深度卷積神經(jīng)網(wǎng)絡(luò)在基本CNNs的基礎(chǔ)上增加了更多的卷積層和池化層,以提取更高層次的特征。深度CNNs在圖像識(shí)別、視頻分析和自然語(yǔ)言處理等領(lǐng)域取得了顯著的成果。

- 循環(huán)神經(jīng)網(wǎng)絡(luò)(Recurrent Neural Networks, RNNs)

循環(huán)神經(jīng)網(wǎng)絡(luò)是一種具有反饋連接的神經(jīng)網(wǎng)絡(luò),能夠處理序列數(shù)據(jù)。RNNs通過(guò)在時(shí)間上展開(kāi)網(wǎng)絡(luò)結(jié)構(gòu),將前一個(gè)時(shí)間步的輸出作為下一個(gè)時(shí)間步的輸入,實(shí)現(xiàn)對(duì)序列數(shù)據(jù)的建模。

3.1 基本循環(huán)神經(jīng)網(wǎng)絡(luò)

基本循環(huán)神經(jīng)網(wǎng)絡(luò)包括輸入層、隱藏層和輸出層。隱藏層的神經(jīng)元具有反饋連接,使其能夠存儲(chǔ)和傳遞信息。

3.2 長(zhǎng)短時(shí)記憶網(wǎng)絡(luò)(Long Short-Term Memory, LSTM)

長(zhǎng)短時(shí)記憶網(wǎng)絡(luò)是一種特殊的RNNs,通過(guò)引入門(mén)控機(jī)制解決了傳統(tǒng)RNNs的梯度消失問(wèn)題。LSTM在序列預(yù)測(cè)、文本生成和語(yǔ)音識(shí)別等領(lǐng)域取得了顯著的成果。

3.3 門(mén)控循環(huán)單元(Gated Recurrent Unit, GRU)

門(mén)控循環(huán)單元是另一種特殊的RNNs,與LSTM類似,也通過(guò)引入門(mén)控機(jī)制解決了梯度消失問(wèn)題。GRU在文本生成、語(yǔ)音識(shí)別和機(jī)器翻譯等領(lǐng)域有廣泛應(yīng)用。

- 生成對(duì)抗網(wǎng)絡(luò)(Generative Adversarial Networks, GANs)

生成對(duì)抗網(wǎng)絡(luò)是一種由兩個(gè)神經(jīng)網(wǎng)絡(luò)組成的模型,包括生成器和判別器。生成器負(fù)責(zé)生成數(shù)據(jù),判別器負(fù)責(zé)區(qū)分生成的數(shù)據(jù)和真實(shí)數(shù)據(jù)。通過(guò)對(duì)抗訓(xùn)練,生成器能夠生成高質(zhì)量的數(shù)據(jù)。

4.1 基本生成對(duì)抗網(wǎng)絡(luò)

基本生成對(duì)抗網(wǎng)絡(luò)包括一個(gè)生成器和一個(gè)判別器。生成器從隨機(jī)噪聲中生成數(shù)據(jù),判別器對(duì)生成的數(shù)據(jù)和真實(shí)數(shù)據(jù)進(jìn)行分類。

4.2 條件生成對(duì)抗網(wǎng)絡(luò)(Conditional Generative Adversarial Networks, CGANs)

條件生成對(duì)抗網(wǎng)絡(luò)在基本GANs的基礎(chǔ)上引入了條件信息,使生成的數(shù)據(jù)具有特定的屬性。CGANs在圖像生成、文本到圖像生成和風(fēng)格遷移等領(lǐng)域有廣泛應(yīng)用。

自編碼器是一種無(wú)監(jiān)督學(xué)習(xí)的神經(jīng)網(wǎng)絡(luò),用于數(shù)據(jù)壓縮和去噪。自編碼器通過(guò)編碼器將輸入數(shù)據(jù)壓縮成低維表示,然后通過(guò)解碼器將低維表示重構(gòu)為原始數(shù)據(jù)。

5.1 基本自編碼器

基本自編碼器包括編碼器和解碼器兩個(gè)部分。編碼器將輸入數(shù)據(jù)壓縮成低維表示,解碼器將低維表示重構(gòu)為原始數(shù)據(jù)。

5.2 變分自編碼器(Variational Autoencoders, VAEs)

變分自編碼器是一種生成模型,通過(guò)引入概率分布來(lái)優(yōu)化自編碼器的性能。VAEs在生成新數(shù)據(jù)、數(shù)據(jù)去噪和特征學(xué)習(xí)等領(lǐng)域有廣泛應(yīng)用。

- 強(qiáng)化學(xué)習(xí)(Reinforcement Learning, RL)

強(qiáng)化學(xué)習(xí)是一種通過(guò)與環(huán)境交互來(lái)學(xué)習(xí)最優(yōu)策略的機(jī)器學(xué)習(xí)方法。強(qiáng)化學(xué)習(xí)中的智能體通過(guò)試錯(cuò)來(lái)學(xué)習(xí)如何在給定環(huán)境中實(shí)現(xiàn)目標(biāo)。

6.1 深度強(qiáng)化學(xué)習(xí)(Deep Reinforcement Learning, DRL)

深度強(qiáng)化學(xué)習(xí)結(jié)合了強(qiáng)化學(xué)習(xí)和深度學(xué)習(xí),通過(guò)使用神經(jīng)網(wǎng)絡(luò)來(lái)近似策略和價(jià)值函數(shù)。DRL在游戲、機(jī)器人控制和自動(dòng)駕駛等領(lǐng)域取得了顯著的成果。

-

非線性

+關(guān)注

關(guān)注

1文章

209瀏覽量

23064 -

人工神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

1文章

119瀏覽量

14602 -

函數(shù)

+關(guān)注

關(guān)注

3文章

4308瀏覽量

62445 -

模型

+關(guān)注

關(guān)注

1文章

3178瀏覽量

48731 -

計(jì)算模型

+關(guān)注

關(guān)注

0文章

29瀏覽量

9824

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

人工神經(jīng)網(wǎng)絡(luò)原理及下載

應(yīng)用人工神經(jīng)網(wǎng)絡(luò)模擬污水生物處理

神經(jīng)網(wǎng)絡(luò)教程(李亞非)

人工神經(jīng)網(wǎng)絡(luò)算法的學(xué)習(xí)方法與應(yīng)用實(shí)例(pdf彩版)

人工神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)方法有哪些?

【AI學(xué)習(xí)】第3篇--人工神經(jīng)網(wǎng)絡(luò)

怎么解決人工神經(jīng)網(wǎng)絡(luò)并行數(shù)據(jù)處理的問(wèn)題

嵌入式中的人工神經(jīng)網(wǎng)絡(luò)的相關(guān)資料分享

卷積神經(jīng)網(wǎng)絡(luò)模型發(fā)展及應(yīng)用

基于FPGA的人工神經(jīng)網(wǎng)絡(luò)實(shí)現(xiàn)方法的研究

不同的人工神經(jīng)網(wǎng)絡(luò)模型各有什么作用?

不同的人工神經(jīng)網(wǎng)絡(luò)模型各有什么作用?

評(píng)論