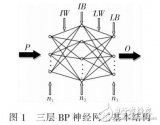

BP神經(jīng)網(wǎng)絡(luò)(Backpropagation Neural Network)是一種多層前饋神經(jīng)網(wǎng)絡(luò),其核心思想是通過(guò)反向傳播算法來(lái)調(diào)整網(wǎng)絡(luò)中的權(quán)重和偏置,從而實(shí)現(xiàn)對(duì)輸入數(shù)據(jù)的預(yù)測(cè)或分類。本文將詳細(xì)介紹BP神經(jīng)網(wǎng)絡(luò)預(yù)測(cè)模型的建模步驟。

- 數(shù)據(jù)預(yù)處理

數(shù)據(jù)預(yù)處理是構(gòu)建BP神經(jīng)網(wǎng)絡(luò)預(yù)測(cè)模型的第一步,主要包括以下幾個(gè)方面:

1.1 數(shù)據(jù)收集

首先需要收集足夠的數(shù)據(jù),這些數(shù)據(jù)可以是歷史數(shù)據(jù)、實(shí)驗(yàn)數(shù)據(jù)或模擬數(shù)據(jù)等。數(shù)據(jù)的質(zhì)量和數(shù)量直接影響模型的預(yù)測(cè)性能。

1.2 數(shù)據(jù)清洗

數(shù)據(jù)清洗是去除數(shù)據(jù)中的噪聲、異常值和缺失值等,以保證數(shù)據(jù)的質(zhì)量和準(zhǔn)確性。常見(jiàn)的數(shù)據(jù)清洗方法包括填充缺失值、去除異常值、數(shù)據(jù)標(biāo)準(zhǔn)化等。

1.3 特征選擇

特征選擇是從原始數(shù)據(jù)中選擇對(duì)預(yù)測(cè)目標(biāo)有貢獻(xiàn)的特征,以減少模型的復(fù)雜度和提高預(yù)測(cè)性能。常見(jiàn)的特征選擇方法包括相關(guān)性分析、主成分分析(PCA)等。

1.4 數(shù)據(jù)劃分

將數(shù)據(jù)集劃分為訓(xùn)練集、驗(yàn)證集和測(cè)試集。訓(xùn)練集用于訓(xùn)練模型,驗(yàn)證集用于調(diào)整模型參數(shù),測(cè)試集用于評(píng)估模型的預(yù)測(cè)性能。通常,訓(xùn)練集占總數(shù)據(jù)的70%-80%,驗(yàn)證集占10%-15%,測(cè)試集占10%-15%。

- 網(wǎng)絡(luò)結(jié)構(gòu)設(shè)計(jì)

2.1 確定輸入層節(jié)點(diǎn)數(shù)

輸入層節(jié)點(diǎn)數(shù)應(yīng)與特征選擇后的特征數(shù)量相等。

2.2 確定隱藏層結(jié)構(gòu)

隱藏層結(jié)構(gòu)包括隱藏層的層數(shù)和每層的節(jié)點(diǎn)數(shù)。隱藏層的層數(shù)和節(jié)點(diǎn)數(shù)對(duì)模型的預(yù)測(cè)性能有很大影響,需要根據(jù)具體問(wèn)題進(jìn)行調(diào)整。一般來(lái)說(shuō),隱藏層的層數(shù)越多,模型的預(yù)測(cè)能力越強(qiáng),但同時(shí)模型的復(fù)雜度和訓(xùn)練時(shí)間也會(huì)增加。

2.3 確定輸出層節(jié)點(diǎn)數(shù)

輸出層節(jié)點(diǎn)數(shù)應(yīng)與預(yù)測(cè)目標(biāo)的數(shù)量相等。例如,如果預(yù)測(cè)目標(biāo)是一個(gè)連續(xù)值,則輸出層節(jié)點(diǎn)數(shù)為1;如果預(yù)測(cè)目標(biāo)是一個(gè)分類問(wèn)題,輸出層節(jié)點(diǎn)數(shù)應(yīng)等于類別數(shù)。

2.4 確定激活函數(shù)

激活函數(shù)用于引入非線性,使神經(jīng)網(wǎng)絡(luò)能夠擬合復(fù)雜的函數(shù)。常見(jiàn)的激活函數(shù)包括Sigmoid函數(shù)、Tanh函數(shù)、ReLU函數(shù)等。不同的激活函數(shù)對(duì)模型的預(yù)測(cè)性能和收斂速度有不同的影響,需要根據(jù)具體問(wèn)題進(jìn)行選擇。

- 訓(xùn)練與測(cè)試

3.1 初始化參數(shù)

在訓(xùn)練模型之前,需要初始化網(wǎng)絡(luò)中的權(quán)重和偏置。權(quán)重和偏置的初始值對(duì)模型的收斂速度和預(yù)測(cè)性能有很大影響。常見(jiàn)的初始化方法包括隨機(jī)初始化、Xavier初始化和He初始化等。

3.2 選擇損失函數(shù)

損失函數(shù)用于衡量模型預(yù)測(cè)值與實(shí)際值之間的差距。常見(jiàn)的損失函數(shù)包括均方誤差(MSE)、交叉熵?fù)p失等。損失函數(shù)的選擇取決于預(yù)測(cè)問(wèn)題的性質(zhì)。

3.3 選擇優(yōu)化算法

優(yōu)化算法用于調(diào)整網(wǎng)絡(luò)中的權(quán)重和偏置,以最小化損失函數(shù)。常見(jiàn)的優(yōu)化算法包括梯度下降法、隨機(jī)梯度下降法(SGD)、Adam優(yōu)化算法等。優(yōu)化算法的選擇取決于模型的規(guī)模和訓(xùn)練數(shù)據(jù)的特點(diǎn)。

3.4 訓(xùn)練模型

使用訓(xùn)練集數(shù)據(jù)對(duì)模型進(jìn)行訓(xùn)練。在訓(xùn)練過(guò)程中,需要不斷更新權(quán)重和偏置,以最小化損失函數(shù)。訓(xùn)練過(guò)程中需要設(shè)置迭代次數(shù)、學(xué)習(xí)率等參數(shù)。

3.5 驗(yàn)證模型

使用驗(yàn)證集數(shù)據(jù)對(duì)模型進(jìn)行驗(yàn)證。驗(yàn)證過(guò)程中,可以調(diào)整模型參數(shù),如學(xué)習(xí)率、正則化系數(shù)等,以提高模型的預(yù)測(cè)性能。

3.6 測(cè)試模型

使用測(cè)試集數(shù)據(jù)對(duì)模型進(jìn)行測(cè)試,評(píng)估模型的預(yù)測(cè)性能。測(cè)試過(guò)程中,可以計(jì)算模型的準(zhǔn)確率、召回率、F1分?jǐn)?shù)等指標(biāo)。

- 模型評(píng)估與優(yōu)化

4.1 評(píng)估指標(biāo)

評(píng)估模型的預(yù)測(cè)性能,常用的評(píng)估指標(biāo)包括均方誤差(MSE)、平均絕對(duì)誤差(MAE)、R平方(R2)等。根據(jù)預(yù)測(cè)問(wèn)題的性質(zhì),選擇合適的評(píng)估指標(biāo)。

4.2 模型解釋

模型解釋是對(duì)模型的預(yù)測(cè)結(jié)果進(jìn)行解釋,以了解模型的工作原理和預(yù)測(cè)依據(jù)。常見(jiàn)的模型解釋方法包括特征重要性分析、部分依賴圖(PDP)等。

4.3 模型優(yōu)化

根據(jù)模型評(píng)估結(jié)果,對(duì)模型進(jìn)行優(yōu)化,以提高預(yù)測(cè)性能。常見(jiàn)的優(yōu)化方法包括調(diào)整網(wǎng)絡(luò)結(jié)構(gòu)、調(diào)整超參數(shù)、使用正則化技術(shù)等。

4.4 模型泛化能力

評(píng)估模型的泛化能力,即模型在未知數(shù)據(jù)上的預(yù)測(cè)性能。可以通過(guò)交叉驗(yàn)證、引入新的數(shù)據(jù)集等方法來(lái)評(píng)估模型的泛化能力。

-

建模

+關(guān)注

關(guān)注

1文章

300瀏覽量

60740 -

BP神經(jīng)網(wǎng)絡(luò)

+關(guān)注

關(guān)注

2文章

115瀏覽量

30536 -

函數(shù)

+關(guān)注

關(guān)注

3文章

4308瀏覽量

62444 -

預(yù)測(cè)模型

+關(guān)注

關(guān)注

0文章

26瀏覽量

8663

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

用matlab編程進(jìn)行BP神經(jīng)網(wǎng)絡(luò)預(yù)測(cè)時(shí)如何確定最合適的,BP模型

關(guān)于BP神經(jīng)網(wǎng)絡(luò)預(yù)測(cè)模型的確定!!

BP神經(jīng)網(wǎng)絡(luò)PID控制電機(jī)模型仿真

基于BP神經(jīng)網(wǎng)絡(luò)的PID控制

卷積神經(jīng)網(wǎng)絡(luò)模型發(fā)展及應(yīng)用

變壓器局放監(jiān)測(cè)與改進(jìn)BP神經(jīng)網(wǎng)絡(luò)預(yù)測(cè)模型研究_高立慧

BP神經(jīng)網(wǎng)絡(luò)模型與學(xué)習(xí)算法

BP神經(jīng)網(wǎng)絡(luò)風(fēng)速預(yù)測(cè)方法

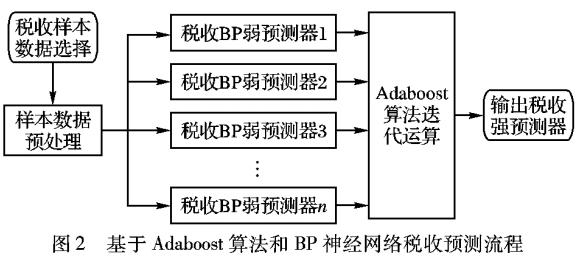

BP神經(jīng)網(wǎng)絡(luò)的稅收預(yù)測(cè)

bp神經(jīng)網(wǎng)絡(luò)預(yù)測(cè)模型建模步驟

bp神經(jīng)網(wǎng)絡(luò)預(yù)測(cè)模型建模步驟

評(píng)論