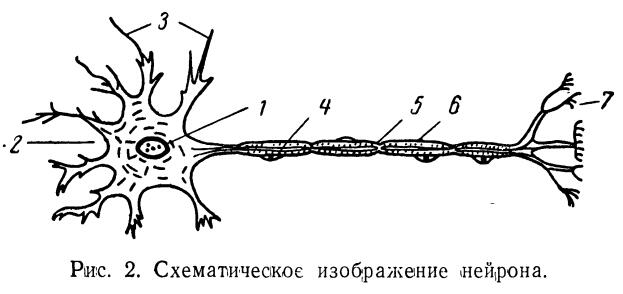

人工神經元模型是人工智能領域中的一個重要概念,它模仿了生物神經元的工作方式,為機器學習和深度學習提供了基礎。本文將介紹人工神經元模型的基本構成要素。

- 神經元的基本概念

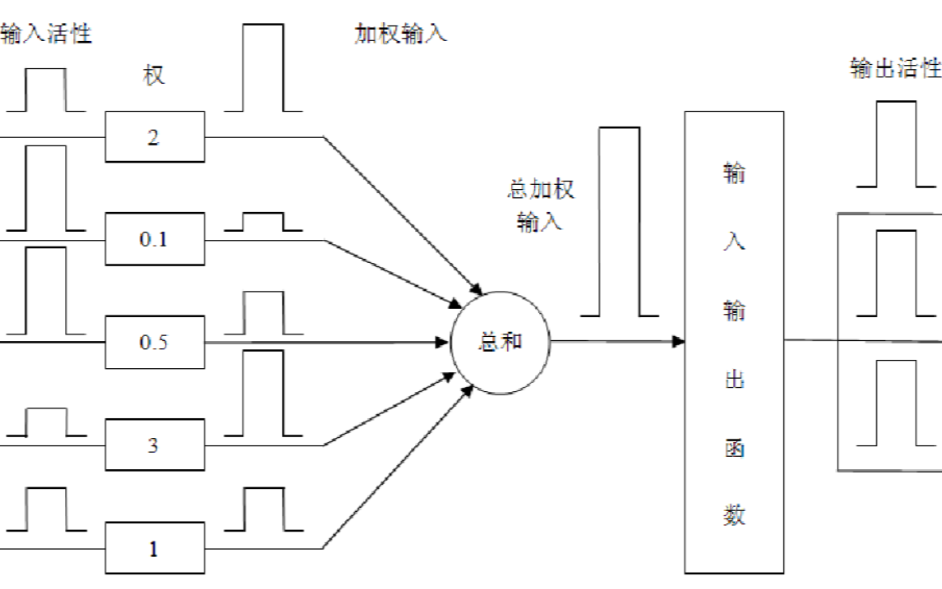

神經元是神經系統的基本單元,它能夠接收、處理和傳遞信息。在人工神經元模型中,神經元的基本結構包括輸入、輸出和激活函數。

1.1 輸入

神經元的輸入是一組數值,通常用向量表示。這些數值可以是特征值、像素值等,它們代表了神經元接收到的信息。

1.2 輸出

神經元的輸出是一個數值,它是輸入經過處理后的結果。輸出可以是連續值,也可以是離散值,取決于激活函數的類型。

1.3 激活函數

激活函數是神經元的核心部分,它決定了神經元如何處理輸入并生成輸出。激活函數的選擇對神經網絡的性能有很大的影響。

- 激活函數

激活函數是神經元中用于引入非線性的關鍵部分。以下是一些常用的激活函數:

2.1 Sigmoid函數

Sigmoid函數是一種常見的激活函數,它的數學表達式為:

f(x) = 1 / (1 + exp(-x))

Sigmoid函數的輸出范圍在0到1之間,它可以將輸入壓縮到這個范圍內。Sigmoid函數在二分類問題中非常常用。

2.2 Tanh函數

Tanh函數是Sigmoid函數的變體,它的數學表達式為:

f(x) = (exp(x) - exp(-x)) / (exp(x) + exp(-x))

Tanh函數的輸出范圍在-1到1之間,它比Sigmoid函數具有更好的數值穩定性。

2.3 ReLU函數

ReLU(Rectified Linear Unit)函數是一種簡單的激活函數,它的數學表達式為:

f(x) = max(0, x)

ReLU函數在正數部分是線性的,在負數部分則為0。它在訓練深度神經網絡時具有很好的性能。

2.4 Leaky ReLU函數

Leaky ReLU函數是ReLU函數的改進版本,它的數學表達式為:

f(x) = max(alpha * x, x)

其中alpha是一個小于1的常數。Leaky ReLU函數在負數部分引入了一個小的斜率,這有助于避免神經元的死亡。

2.5 Softmax函數

Softmax函數常用于多分類問題中,它的數學表達式為:

f(x_i) = exp(x_i) / sum(exp(x_j))

其中x_i是輸入向量的第i個元素,x_j是輸入向量的其他元素。Softmax函數將輸入向量轉換為概率分布。

- 權重

權重是神經元中用于調整輸入值的參數。權重的大小決定了輸入對輸出的影響程度。在訓練過程中,權重會不斷更新,以使神經網絡的預測結果更接近真實值。

3.1 權重初始化

權重初始化是神經網絡訓練的第一步。合適的權重初始化方法可以加速訓練過程并提高模型性能。常見的權重初始化方法有:

- 零初始化:將所有權重初始化為0。

- 隨機初始化:將權重隨機初始化為一個小的正數或負數。

- Xavier初始化:根據輸入和輸出的維度自動調整權重的初始值。

- He初始化:適用于ReLU激活函數,根據輸入的維度自動調整權重的初始值。

3.2 權重更新

權重更新是訓練過程中的關鍵步驟。權重更新的目的是減小預測值和真實值之間的差距。權重更新的方法有:

- 梯度下降法:通過計算損失函數關于權重的梯度,然后更新權重。

- 隨機梯度下降法:使用一個訓練樣本來更新權重,可以加快訓練速度。

- 小批量梯度下降法:使用一個小批量的訓練樣本來更新權重,可以在訓練速度和模型性能之間取得平衡。

- 偏置

偏置是神經元中的另一個參數,它用于調整輸出的偏移量。偏置可以幫助模型更好地擬合數據。

4.1 偏置初始化

偏置初始化通常使用較小的隨機值或0。合適的偏置初始化可以提高模型的收斂速度。

4.2 偏置更新

偏置更新與權重更新類似,通過計算損失函數關于偏置的梯度,然后更新偏置。

- 損失函數

損失函數是衡量模型預測值與真實值之間差距的函數。選擇合適的損失函數對于模型的性能至關重要。

5.1 均方誤差損失函數

均方誤差損失函數是最常用的損失函數之一,它的數學表達式為:

L = (1/n) * sum((y_i - y_hat_i)^2)

其中y_i是真實值,y_hat_i是預測值,n是樣本數量。

-

人工智能

+關注

關注

1791文章

46896瀏覽量

237666 -

函數

+關注

關注

3文章

4308瀏覽量

62444 -

模型

+關注

關注

1文章

3178瀏覽量

48730 -

人工神經元

+關注

關注

0文章

11瀏覽量

6277

發布評論請先 登錄

相關推薦

基于非聯合型學習機制的學習神經元模型

神經網絡與神經網絡控制的學習課件免費下載

一種具有高度柔性與可塑性的超香腸覆蓋式神經元模型

人工神經元模型的基本構成要素

人工神經元模型的基本構成要素

評論