來源:SDNLAB

隨著人工智能(AI)的迅速發展和廣泛應用,數據中心作為AI技術的基石,也面臨著前所未有的挑戰和機遇。為了滿足AI的高性能和低延遲要求,數據中心基礎設施必須進行相應的改變和升級。

01、基礎設施的升級需求數十年來,企業一直在不斷改變和升級基礎設施,以適應新的應用程序和工作負載。人工智能工作負載通常需要專門的基礎設施,隨著人工智能的普及,這一過程依然持續。

最近發布的IDC全球半年度人工智能跟蹤報告進一步證實:硬件支出在整個人工智能領域(包括服務和軟件)中占比最小,但有望實現巨大增長。

與傳統應用程序和工作負載相比,人工智能工作負載對計算和網絡資源提出了全新的、獨特的需求,涉及處理器、核心網絡元素、功耗等多個方面的變革。當然,企業也曾通過升級計算基礎設施,遷移到更快的處理器、更高性能的存儲和更高速的互連技術來適應類似的變化。然而,當前情況與先前的升級有兩個關鍵不同:首先,主體范圍更廣。過去為了運行更復雜應用程序而升級基礎設施的公司主要是領先的大型企業。但大多數公司未受到直接影響,無需改變其基礎設施。而在人工智能時代,各種規模的公司都積極嘗試利用人工智能來優化運營、提升客戶體驗、增加收入等。其次,升級的必要性更強烈。當下,許多人工智能應用程序都是基于對來自不同內外部數據源的大量數據進行收集和分析。在大多數情況下,一旦企業缺乏適當的基礎設施,就無法有效地將大量數據傳輸到其計算設施中。

多年來,企業一直通過采用更快的處理器、更高效的存儲和更快速的互連技術來升級計算基礎設施。例如,使用GPU和協同處理器來加速工作負載,采用并行分布式文件系統以提高存儲性能,以及利用無限波段網絡來加速存儲和計算系統之間的數據傳輸等等。總體而言,采用新技術以滿足日益增長的工作負載需求的趨勢一直在演變,而隨著人工智能的普及,這一趨勢也在持續發展。

02、數據中心如何支持人工智能人工智能工作負載通常是數據和計算密集型的,數據中心提供安全、可擴展且可靠的基礎設施,用于存儲、處理和分析人工智能應用生成的大量數據。數據中心通過高性能計算 (HPC)、托管專用硬件、數據存儲和網絡來支持人工智能。高性能計算(HPC)AI的計算需求巨大,這主要是因為AI模型的訓練和推理工作負載所需。為了滿足這種需求,數據中心采用了高性能計算(HPC)集群來支撐AI應用和任務。這些HPC集群由一系列通過高速網絡連接的服務器組成,使其能夠實現并行處理和加速訓練過程。在數據中心環境中,HPC系統通常都是按照標準的19英寸寬度設計的四柱機架形式。這種設計不僅適合各種服務器類型(如1U服務器、刀片服務器和存儲設備),還具備了模塊化和可擴展的特性,這使得它可以根據AI任務的需求進行靈活的擴展和升級。

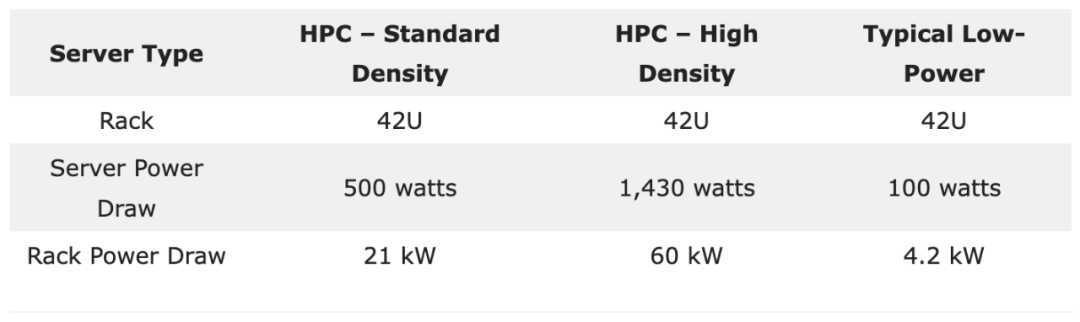

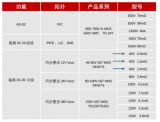

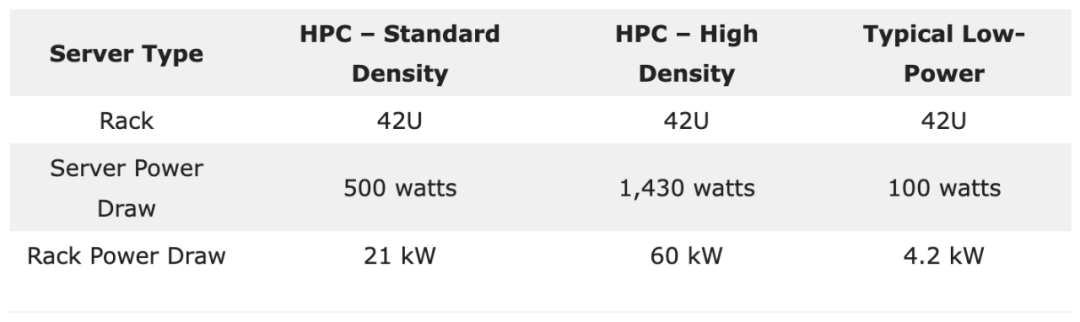

考慮到機架的功率處理能力,它們的功率密度可以在20 kW至60 kW的范圍內變化。以一個42U機架為例,如果每臺1U服務器的功耗是500瓦,那么機架的總功率會達到21 kW。但如果這些服務器的功耗增加到1,430瓦,那么機架的總功率將增加到60 kW。相對地,某些低功耗服務器可能只需100瓦,這意味著42U機架上所有服務器的總功率只有4.2 kW。

假設在一個擁有400個機架的數據中心中,部署了“標準”和“高”密度的HPC系統。這意味著整個數據中心的電力需求范圍在8.4兆瓦(MW)到24.0兆瓦(MW)之間。對于那些具有非常高功率需求的場景,我們可以利用專用的高性能計算(HPC)環境,這樣的環境專門針對大規模的、計算密集型的人工智能任務設計。HPC系統中使用的專用硬件

HPC系統通過整合高性能處理器(CPU)、高速內存和GPU等專用硬件,有效處理大量數據并支持AI工作負載。這些高端處理器具備迅速高效執行復雜計算和數據分析的能力。采用這類處理器可確保HPC系統在處理苛刻工作負載,如數據挖掘、科學模擬、高級分析和機器學習(ML)任務時,能夠以快速處理速度和最小延遲的方式運行。

深度學習(DL)模型和實時人工智能需要專門的計算加速器來實現深度學習算法。最初,這種計算依賴于廣泛使用的圖形處理單元(GPU)。然而,一些云服務提供商后來開發了自己的定制芯片,如谷歌的TPU,一種專用集成電路(ASIC),以及微軟的Project Catapult,它使用現場可編程門陣列(FPGA),以滿足不斷增長的人工智能工作負載需求。

GPU、ASIC和FPGA等專用硬件能夠加速機器學習算法,已經成為現代HPC系統的重要組成部分。這些專用處理器旨在執行矩陣計算,特別適用于需要并行處理大量數據的機器學習任務。通過充分利用這些專用處理器,HPC系統能夠顯著提高對AI工作負載的處理速度。數據存儲AI模型在進行訓練和推理時需要大量數據,而數據中心提供了必要的存儲容量,以容納這些數據集。此外,人工智能應用會執行大量輸入/輸出(I/O)操作,例如從存儲設備讀取或寫入數據,以及通過通信網絡在設備之間交換信息。對于機器學習、深度學習和數據處理等人工智能工作負載而言,高速存儲訪問至關重要。這些工作負載需要存儲系統具有快速的數據訪問和傳輸速率。這種快速訪問使得人工智能模型能夠實時或接近實時地高效讀取、寫入和處理數據,從而提高訓練、推理和數據分析等任務的性能并減少延遲。

數據中心通常使用硬盤驅動器(HDD)、固態驅動器(SSD)和網絡附加存儲(NAS)等大容量存儲設備來存儲和管理龐大的人工智能數據集。云服務提供商(CSP)如AWS、Microsoft Azure和Google Cloud提供低延遲和高吞吐量的存儲解決方案。例如,Amazon FSx for Lustre是一種專為計算密集型工作負載設計的高性能文件系統,包括機器學習、高性能計算(HPC)和大數據處理。

網絡

AI工作負載涉及大量的矩陣計算,這些計算分散在多個處理器上,如CPU、GPU、DPU等。為了有效地支持這些工作負載,我們需要一個高容量、可擴展且高可靠性的網絡。隨著人工智能集群等應用的普及,對網絡帶寬和容量的需求也在不斷增長,這進一步挑戰了網絡的性能和可靠性。

在AI工作負載中,高性能網絡的關鍵特性包括:

# 吞吐量

在運行大型AI應用時,網絡的帶寬對數據中心的整體性能至關重要。以GPU集群為例,它們通常需要比傳統計算網絡多出約3倍的帶寬。

# Disaggregated AI應用

在該場景下,高性能網絡的重要性進一步提升,由于AI應用的各個組件分布在數據中心內的多個硬件和軟件資源上,它們需要快速而可靠地進行通信。這些組件之間需要無縫的通信,只有通過強大的網絡基礎設施才能實現,例如NVIDIA Mellanox 400G InfiniBand,其網絡容量為每秒400吉比特(Gbps)。

# 效率

人工智能基礎設施的效率與其網絡性能直接相關。緩慢的網絡可能會在整個基礎設施中造成瓶頸,從而降低AI應用的運行效率。因此,為了確保AI工作負載的高效運行,一個完備的網絡結構,包括擁塞控制和帶寬管理等功能,是至關重要的。

03、AI數據中心散熱AI應用和工作負載對IT設備提出了高功率密度的要求,這導致了大量的熱量產生,從而增加了服務器的冷卻需求。數據中心因此面臨更多的冷卻挑戰,通常需要進行重新設計以確保維持適當的溫度。低效的冷卻不僅可能縮短設備的使用壽命和降低計算性能,還會增加冷卻系統的負擔。

為了應對這些冷卻挑戰,液體冷卻和浸入式冷卻成為了兩種主要的解決方案。尤其在每個機架功率超過30 kW的高密度環境中,熱點問題變得尤為明顯,這時可能需要采用特殊的策略(如液冷)。當功率密度達到每機架60 kW至80 kW時,直接芯片液體冷卻變得更加常見。

液冷液體冷卻是一種涉及通過與 CPU 或 GPU 等電子組件直接接觸的冷板循環冷卻劑(例如水或 3M Novec 或 Fluorinert 等專用液體)的方法。在這個過程中,熱量被液體冷卻劑吸收,然后通過熱交換器或散熱器傳輸到空氣中。冷卻后的液體重新循環使用。

液體冷卻在管理高密度人工智能工作負載方面特別有效,因為相比傳統的空氣冷卻系統,它更有效地散熱。值得注意的是,每單位體積液體的散熱效率比空氣高數千倍,因此內部硬件電子設備中往往采用循環液冷,液體循環可以有效地處理小空間中產生的大量熱量,并將其傳遞到硬件外部的介質,比如空氣。

總體而言,液冷系統在高功率密度環境中表現理想。然而,需要注意的是,液體冷卻通常僅用于冷卻CPU或GPU,而在房間中會產生一些余熱,可能需要額外的空調來冷卻其他組件。

浸沒式冷卻浸入式冷卻是一種將電子元件浸入非導電液體冷卻劑(如3M Novec或Fluorinert)中的方法。在這個過程中,冷卻劑吸收部件產生的熱量,通過循環送至熱交換器進行冷卻,然后再循環。浸入式冷卻因其在運行HPC環境的數據中心中提供更高功率密度和更低電源使用效率(PUE)而備受關注。浸入式冷卻不僅可以冷卻CPU,還能夠冷卻印刷電路板(PCB)或主板上的其他組件。

案例研究 – Meta Platforms 的AI數據中心Meta Platforms,原名Facebook,是一家主要提供社交媒體和社交網絡服務的科技巨頭。為了滿足其業務需求,Meta 在全球范圍內擁有和運營了21個數據中心園區,總面積超過5000萬平方英尺,并且還從其他第三方提供商那里租用了多個數據中心。截至2023年,該公司計劃將超過300億美元的資本支出中的大部分用于增強其人工智能(AI)能力,主要通過對GPU、服務器和數據中心的投資來實現。Meta 正在興建專門支持下一代人工智能硬件的新數據中心。該公司的人工智能投資和產能將為各種產品和服務提供支持,包括廣告、Feed、Reels和Metaverse。到目前為止,Meta 通過使用大規模GPU集群已經取得了一些成果,通過GPU協同工作可以更高效、更有效地處理復雜的人工智能工作負載。

基于Grand Teton GPU的硬件平臺相比其前身Zion有多項性能提升,包括4倍的主機到GPU帶寬、2倍的計算和數據網絡帶寬以及2倍的功率包絡。Grand Teton的設計具有更高的計算能力,能更有效地支持內存帶寬限制的工作負載,例如Meta的深度學習推薦模型(DLRM)。

總體而言,Meta的戰略目標是在其所有的數據中心中實現標準化設計,以適應高功率密度的AI工作負載,其功率范圍從每機架25 kW到每機架40 kW不等。為此,Meta目前正與能夠構建經濟高效、高功率密度AI基礎設施的數據中心運營商進行合作。

Meta Platforms的液體冷卻

為了支持其高功率密度的人工智能工作負載,Meta采用了液冷技術來確保服務器始終處于最佳的運行溫度。具體來說,Meta使用空氣輔助液體冷卻(AALC)技術,結合閉環系統和后門熱交換器,從而無需借助高架地板或外部管道就能實現服務器的冷卻。這一技術的采納是Meta向更為健壯的數據中心設計轉型的一個關鍵步驟,進而推動了液體冷卻技術的廣泛應用。

05、AI時代的數據中心設計思考AI應用和工作負載使用高功率密度的機架,這些機架可以部署在各種設施類型中,包括大型的超大規模/云數據中心到小型的邊緣數據中心。在超大規模/云數據中心方面,像AWS、Microsoft Azure和Google Cloud等云服務提供商提供了專門用于構建和部署AI模型的服務。由于這些設施規模宏大,它們特別適用于處理機器學習和深度學習訓練、大數據分析、自然語言處理(NLP)和計算機視覺等人工智能應用程序和工作負載。至于邊緣數據中心,這些設施相對較小而分散,位于更靠近數據生成和使用的地方,提供計算和存儲服務。邊緣數據中心的設計旨在滿足對低延遲的快速響應時間要求的人工智能應用,例如實時視頻分析、增強現實(AR)和虛擬現實(VR)、自動駕駛汽車以及無人機等。值得注意的是,由于不同的人工智能應用和系統對數據中心的要求各異,不是所有的數據中心都可以針對單一用例進行優化。例如,深度學習和人工智能系統需要較高數量的CPU或GPU處理器核心來縮短訓練時間,而用于人工智能推理的引擎則可以利用較少的處理器核心來完成其任務。

-

數據中心

+關注

關注

16文章

4700瀏覽量

71970 -

AI

+關注

關注

87文章

30239瀏覽量

268475 -

人工智能

+關注

關注

1791文章

46896瀏覽量

237666

發布評論請先 登錄

相關推薦

全球視野 算領未來,施耐德電氣助力數據中心把握智算機遇

人工智能對數據中心的挑戰

當今數據中心新技術趨勢

安森美引領數據中心能效革命

AI時代,我們需要怎樣的數據中心?AI重新定義數據中心

數據中心的AI時代轉型:挑戰與機遇

數據中心的AI時代轉型:挑戰與機遇

評論