今日,在 PerfXCloud 重磅更新支持 llama 3.1 之后,其平臺再度實現重大升級!目前,已順利接入被譽為全球最強的 MOE 大模型DeepSeek-V2,已在 PerfXCloud(澎峰云)官網的體驗中心對平臺用戶免費開放體驗。

DeepSeek-V2

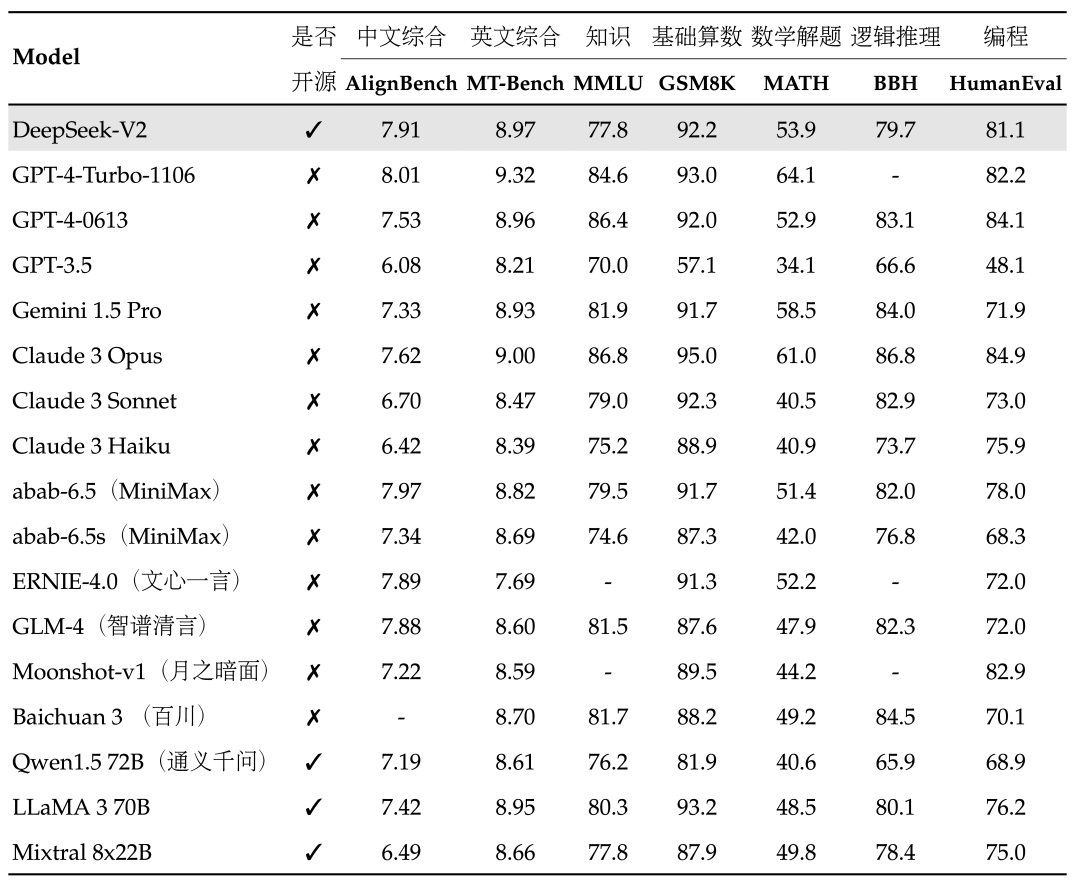

DeepSeek-V2是強大的專家混合(MOE)語言模型,在目前大模型主流榜單中,DeepSeek-V2 綜合能力表現出色:

中文綜合能力(AlignBench)開源模型中最強,與GPT-4-Turbo,文心4.0等閉源模型在評測中處于同一梯隊

英文綜合能力(MT-Bench)與最強的開源模型LLaMA3-70B同處第一梯隊,超過最強MOE開源模型Mixtral 8x22B

知識、數學、推理、編程等榜單結果也位居前列

支持128K上下文窗口

PerfXCloud

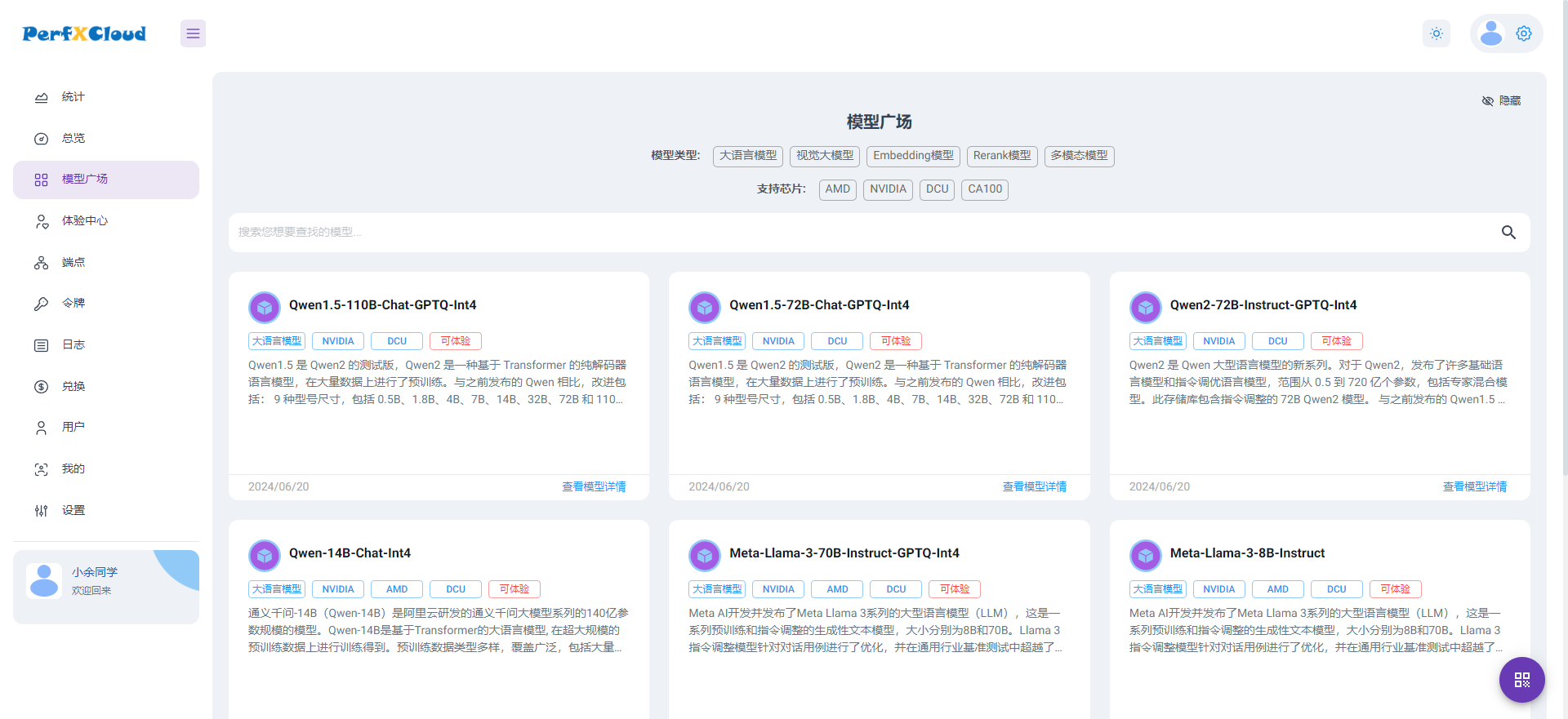

PerfXCloud是澎峰科技為開發者和企業量身打造的AI開發和部署平臺。它專注于滿足大模型的微調和推理需求,為用戶提供極致便捷的一鍵部署體驗。

PerfXCloud為算力中心提供大模型AI科學與工程計算的整體運營解決方案,助力算力中心升級成為“AI超級工廠”

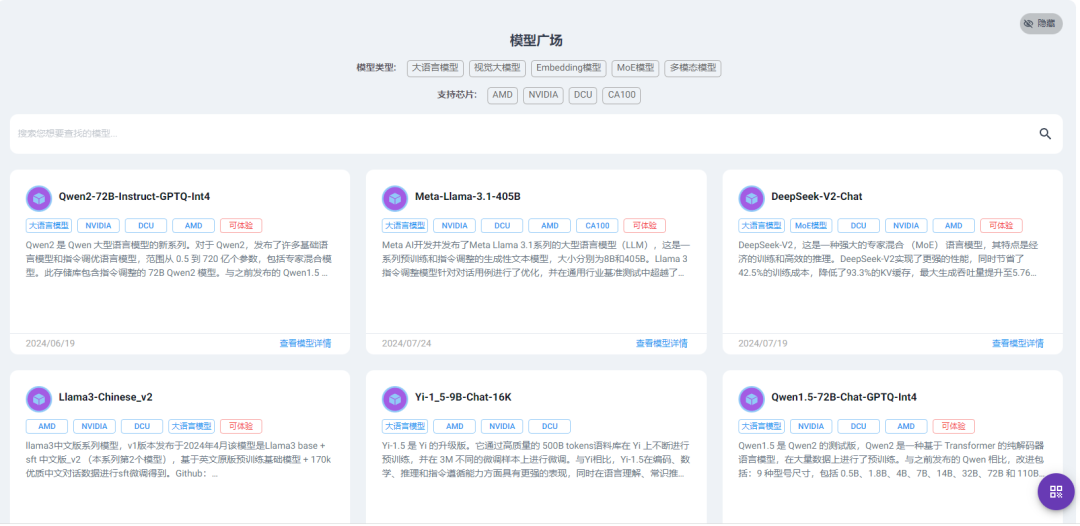

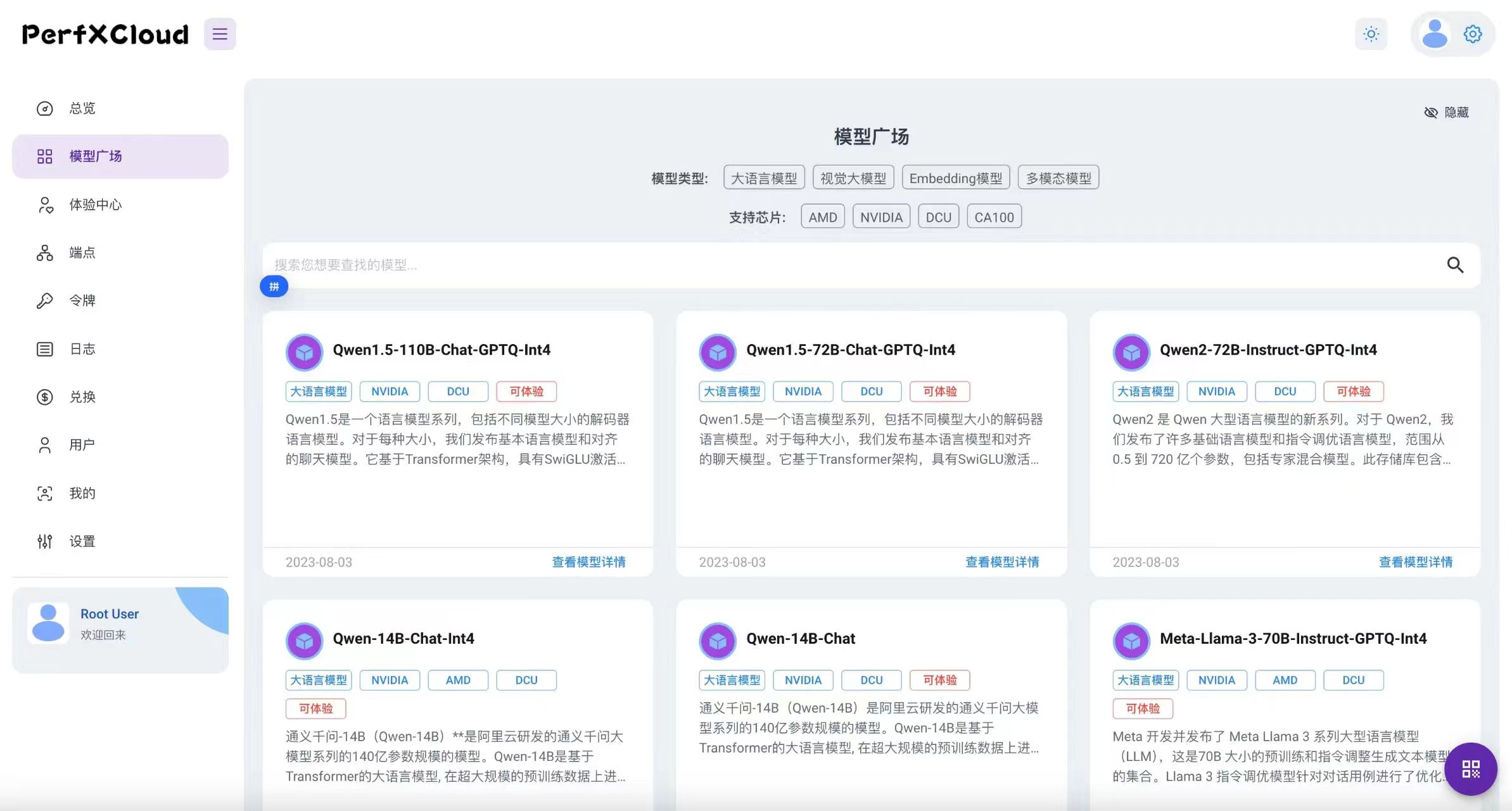

PerfXCloud模型廣場

PerfXCloud介紹 目前,PerfXCloud(澎峰云)已面向基石用戶免費開放DeepSeek-V2236B的API調用接口。趕快注冊申請成為基石用戶來體驗吧!

-

開源

+關注

關注

3文章

3099瀏覽量

41983 -

語言模型

+關注

關注

0文章

482瀏覽量

10188 -

大模型

+關注

關注

2文章

2053瀏覽量

1776

原文標題:PerfXCloud 再度升級,免費開放體驗全球頂尖 MOE 大模型 DeepSeek-V2 236B!

文章出處:【微信號:perfxlab,微信公眾號:perfxlab】歡迎添加關注!文章轉載請注明出處。

發布評論請先 登錄

相關推薦

【附實操視頻】聆思CSK6大模型開發板接入國內主流大模型(星火大模型、文心一言、豆包、kimi、智譜glm、通義千問)

PerfXCloud平臺成功接入Meta Llama3.1

PerfXCloud大模型人工智能生態技術大會圓滿落幕

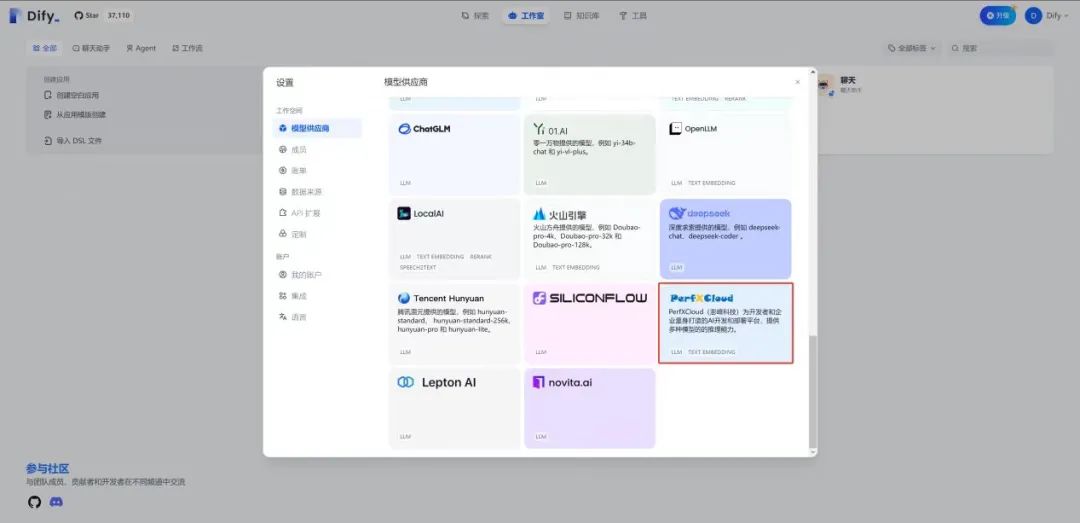

在Dify中使用PerfXCloud大模型推理服務

PerfXCloud大模型開發與部署平臺開放注冊

昆侖萬維開源2千億稀疏大模型Skywork-MoE

騰訊云大模型價格調整:混元-lite、混元-standard免費,混元-pro降價

基于NVIDIA Megatron Core的MOE LLM實現和訓練優化

湯姆貓正在推進申請接入OpenAI的Sora模型

昆侖萬維發布新版MoE大語言模型天工2.0

對標OpenAI GPT-4,MiniMax國內首個MoE大語言模型全量上線

混合專家模型 (MoE)核心組件和訓練方法介紹

PerfXCloud順利接入MOE大模型DeepSeek-V2

PerfXCloud順利接入MOE大模型DeepSeek-V2

評論