由 NVIDIA RTX 和 GeForce RTX 技術(shù)驅(qū)動的 AI PC 時代已經(jīng)到來。在這一背景下,一種評估 AI 加速性能的新方法應(yīng)運(yùn)而生,同時還帶來了一套新術(shù)語,這套術(shù)語成了用戶選擇臺式電腦和筆記本電腦的參考標(biāo)準(zhǔn)。

雖然 PC 游戲玩家了解每秒幀數(shù)(FPS)及類似的統(tǒng)計數(shù)據(jù),但衡量 AI 性能需要新的指標(biāo)。

TOPS 脫穎而出

TOPS,即每秒萬億次運(yùn)算是首要的基準(zhǔn)指標(biāo)。“萬億”是這里的關(guān)鍵詞:生成式 AI 任務(wù)背后的處理運(yùn)算量是巨大的。您可以將 TOPS 視為原始性能指標(biāo),類似于發(fā)動機(jī)的額定功率。這個數(shù)值自然是越大越好。

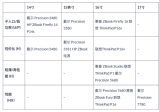

例如,比較一下微軟最近發(fā)布的 Windows 11 AI PC,其中就包含每秒至少可執(zhí)行 40 萬億次運(yùn)算的神經(jīng)處理單元(NPU)。40 TOPS 的算力足以勝任一些輕量級 AI 輔助任務(wù),例如詢問本地聊天機(jī)器人昨天的筆記在哪里。

但許多生成式 AI 的算力需求遠(yuǎn)不止于此。NVIDIA RTX 和 GeForce RTX GPU 可在所有生成式任務(wù)中提供卓越的性能,其中 GeForce RTX 4090 GPU 的算力可達(dá) 1177 TOPS。這就是處理 AI 輔助數(shù)字內(nèi)容創(chuàng)作(DCC)、PC 游戲 AI 超分辨率、根據(jù)文本或視頻生成圖像、與本地大語言模型(LLM)交互等任務(wù)所需的算力。

以 Token 衡量性能

TOPS 只是一項基礎(chǔ)衡量指標(biāo)。LLM 的性能以模型生成的 Token 數(shù)量來衡量。

Token 是 LLM 的輸出,它可以是句子中的一個詞,甚至可以是標(biāo)點符號或空格這類更小的片段。AI 加速任務(wù)的性能可以用“每秒 Token 數(shù)”來衡量。

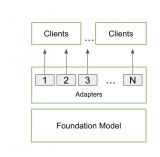

另一個重要因素則是 batch size,也就是在一次推理過程中可同時處理的輸入數(shù)量。由于大語言模型(LLM)是許多現(xiàn)代 AI 系統(tǒng)的核心,處理多個輸入(例如來自單個應(yīng)用或跨多個應(yīng)用)的能力將成為關(guān)鍵的差異化因素。雖然較大的 batch size 可以提升并發(fā)輸入的性能,但也需要占用更多的內(nèi)存,尤其是運(yùn)行較大的模型時。

RTX GPU 非常適合 LLM,因為它們擁有大量專用的顯存(VRAM)、Tensor Core 和 TensorRT-LLM 軟件。

GeForce RTX GPU 最多可提供 24GB 的高速 VRAM,而 NVIDIA RTX GPU 最多可提供 48GB 的高速 VRAM,可支持更大的模型和更大的 batch size。RTX GPU 還可利用 Tensor Core,這是一種專用的 AI 加速器,可顯著加速深度學(xué)習(xí)和生成式 AI 模型中的計算密集型運(yùn)算。應(yīng)用在使用 NVIDIA TensorRT 軟件開發(fā)套件(SDK)的情況下可輕松實現(xiàn)超高性能。該套件可在超過 1 億臺由 RTX GPU 驅(qū)動的 Windows PC 和工作站上解鎖超高性能生成式 AI。

結(jié)合了大顯存、專用 AI 加速器和優(yōu)化的軟件,RTX GPU 的吞吐量得到了巨大提升,尤其是在 batch size 增加的情況下。

文本生圖像,速度超以往

測量圖像生成速度是評估性能的另一種方法。最直接的一個方法是使用 Stable Diffusion,這是一種基于圖像的熱門 AI 模型,可讓用戶輕松地將文本描述轉(zhuǎn)換為復(fù)雜的視覺畫面。

借由 Stable Diffusion,用戶可以通過輸入關(guān)鍵詞快速獲得想要的圖像相比于 CPU 或 NPU,使用 RTX GPU 運(yùn)行 AI 模型時可以更快生成所需結(jié)果。

在熱門的 Automatic1111 界面使用 TensorRT 擴(kuò)展程序時,相應(yīng)性能表現(xiàn)甚至?xí)谩=柚?SDXL 模型,RTX 用戶通過提示生成圖像的速度至多可提升至原來的 2 倍,這可大幅簡化 Stable Diffusion 工作流。

另一個熱門的 Stable Diffusion 用戶界面 ComfyUI 在上周也支持了 TensorRT 加速。現(xiàn)在,RTX 用戶文生圖的速度可提升多達(dá) 60%。RTX 用戶還可使用 Stable Video Diffusion 將這些圖像轉(zhuǎn)換為視頻,在 TensorRT 的助力下,轉(zhuǎn)換速度甚至可提升多達(dá) 70%。

全新的 UL Procyon AI 圖像生成基準(zhǔn)測試現(xiàn)已支持 TensorRT 加速。與最快的非 TensorRT 加速狀態(tài)相比,TensorRT 加速可在 GeForce RTX 4080 SUPER GPU 上帶來 50% 的速度提升。

適用于 Stable Diffusion 3 的 TensorRT 加速近期發(fā)布,前者是 Stability AI 備受期待的全新文本轉(zhuǎn)圖像模型。此外,全新的 TensorRT-Model Optimizer 可進(jìn)一步提升性能。與非 TensorRT 加速狀態(tài)相比,它可帶來顯著的速度提升,同時減少顯存消耗。

當(dāng)然,眼見方能為實。真正的考驗來自于不斷迭代提示詞這種真實場景。在 RTX GPU 上,用戶通過改進(jìn)提示詞來優(yōu)化圖像的速度可得到顯著提升,每次迭代只需數(shù)秒即可完成。而在 Macbook Pro M3 Max 上,完成相同的迭代需要耗費(fèi)數(shù)分鐘。此外,如果在由 RTX 驅(qū)動的 PC 或工作站上本地運(yùn)行,用戶可以同時享受到速度和安全性方面的優(yōu)勢,并讓所有內(nèi)容保持私密。

測試結(jié)果出爐,相關(guān)技術(shù)開源

不過,且不要僅聽我們的一面之詞。開源的 Jan.ai 背后的 AI 研究人員和工程師團(tuán)隊最近將 TensorRT-LLM 集成到了其本地聊天機(jī)器人應(yīng)用中,然后親自測試了這些優(yōu)化效果。

研究人員在社區(qū)使用的各種 GPU 和 CPU 上,以開源的 llama.cpp 推理引擎為對照,測試了 TensorRT-LLM 的實際表現(xiàn)。他們發(fā)現(xiàn) TensorRT“在相同硬件上比 llama.cpp 快 30-70%”,并且在進(jìn)行連續(xù)處理時效率更高。該團(tuán)隊還提供了測試方法,邀請其他人親自測試生成式 AI 的性能。

無論是游戲還是生成式 AI,速度才是其致勝法寶。在確定性能冠軍時,TOPS、每秒 Token 數(shù)和 batch size 均需納入考量。

-

NVIDIA

+關(guān)注

關(guān)注

14文章

4949瀏覽量

102825 -

PC

+關(guān)注

關(guān)注

9文章

2067瀏覽量

154042 -

內(nèi)存

+關(guān)注

關(guān)注

8文章

3004瀏覽量

73900 -

AI

+關(guān)注

關(guān)注

87文章

30239瀏覽量

268474

原文標(biāo)題:解碼 RTX AI PC 和工作站上的 AI 性能

文章出處:【微信號:NVIDIA_China,微信公眾號:NVIDIA英偉達(dá)】歡迎添加關(guān)注!文章轉(zhuǎn)載請注明出處。

發(fā)布評論請先 登錄

相關(guān)推薦

NVIDIA NIM在搭載RTX技術(shù)的AI工作站上的應(yīng)用

NVIDIA RTX AI套件簡化AI驅(qū)動的應(yīng)用開發(fā)

寧暢推出自驅(qū)式相變液冷AI工作站

AMD Radeon PRO W7900雙槽工作站顯卡發(fā)布上市

技嘉推出全新AMD Radeon PRO W7000系列工作站顯卡

AI PC:真正的AI PC,敢于下場

寧暢推出首款專業(yè)級AI桌面工作站W350 G50

技嘉科技與英偉達(dá)攜手打造全新高階RTX AI PC體驗

NVIDIA推出用于支持在全新GeForce RTX AI筆記本電腦上運(yùn)行的AI助手及數(shù)字人

惠普推出多款商用AI PC新品

全新NVIDIA RTX A400和A1000 GPU全面加強(qiáng)AI設(shè)計與生產(chǎn)力工作流

惠普推出新一代AI游戲本,并計劃推出首個AI PC本地AI解決方案

全面解析CPU和工作站的大比拼

AI PC是什么?如何變革PC產(chǎn)業(yè)(2023)

RTX AI PC和工作站提供強(qiáng)大AI性能

RTX AI PC和工作站提供強(qiáng)大AI性能

評論