來源:半導體行業觀察 翻譯自Timothy Prickett Morgan

如今,眾所周知的是,用于連接分布式系統的交換機并不是網絡中最昂貴的部分,而光收發器和光纖電纜才是成本的主要部分。由于這一點,以及光學元件運行時溫度高且經常發生故障,人們除非必要,否則不會使用光學元件。

因此,我們有了銅纜,越來越多地直接從交換機 ASIC 及其連接的設備驅動,用于短距離傳輸,以及光纜用于長距離傳輸,這些設備是為 AI 和 HPC 系統提供 1000、10000 或 100000 臺設備所必需的。早在 5 月份,當Broadcom 推出其“Thor 2”網絡接口卡芯片時,以及在 Nvidia 于 3 月份推出GB200 NVL72 機架式系統之后,我們就曾打趣過這個問題,在可以的時候使用銅纜,在必須的時候使用光纜。Broadcom 和 Nvidia 都會告訴你,機器的經濟性和可靠性取決于這種方法。

GB200 NVL72 系統將這一原則發揮到了極致。該系統使用 5184 條大銅纜將 72 個“Blackwell”GPU 捆綁在一起,形成一個全對全共享內存配置,NVL72 系統核心的九臺 NVLink Switch 4 交換機中的 200 Gb/秒 SerDes 可以通過銅線直接驅動每個 Blackwell GPU 上的 1.8 TB/秒 NVLink 5 端口,無需重定時器,當然也不需要長途數據中心網絡中使用的光收發器。

據 Nvidia 聯合創始人兼首席執行官黃仁勛介紹,與使用光收發器和重定時器相比,這種方法非常有效,可節省約 20 千瓦的電力,將機架功耗從原來的 120 千瓦降至 100 千瓦。(黃仁勛最初給出的規格說明稱,NVL72 的功率為 120 千瓦,但現在的規格表顯示,如果使用全銅互連,機架級節點的功率為 100 千瓦。我們認為,他在講話時未使用光學器件,因此節省了 20 千瓦的功率。)

無論如何,這張 NVL72 節點的圖片足以讓您想在商品市場上購買銅:

Ayar Labs 的聯合創始人兼首席執行官馬克·韋德 (Mark Wade) 卻不相信這些,該公司發明了名為 TeraPHY 的光學 I/O 芯片以及用于驅動該芯片的名為 SuperNova 的外部激光光源。

“我認為銅纜已經不起作用了,”韋德在本周的人工智能硬件峰會上發表主題演講之前向The Next Platform解釋道。“目前沒有一家公司在應用層面真正實現了顯著的經濟產出。問題不在于銅纜何時失效,光學器件何時成本持平并變得可靠。銅纜已經無法以經濟的方式支持人工智能工作負載。是的,投資者資助的淘金熱已經持續了兩年,這確實推動了玩家硬件的所有利潤。但銅纜已經無法支持高效、經濟、高性能的人工智能工作負載系統。該行業實際上正在努力擺脫技術已經失敗的困境,硬件制造商需要大幅提高這些系統的成本效益吞吐量。否則,我們都將走向互聯網式的危機。”

顯然,這些話非常有說服力,尤其是考慮到 Nvidia、AMD、臺灣半導體制造公司、SK 海力士、三星、美光科技等 GPU 加速器供應鏈各部分的訂單量和實力。但請聽聽韋德的說法,因為他將提出一個有趣的案例。

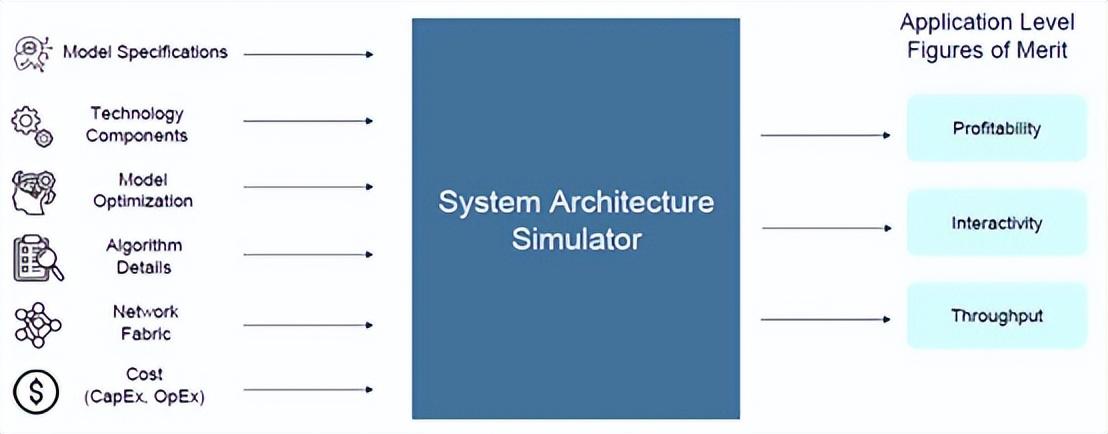

Ayar Labs 顯然有既得利益,可以迫使公司轉向封裝在 GPU 上的光學 I/O 以及將它們互連的交換機,為了證明這一點,該公司構建了一個系統架構模擬器,該模擬器不僅關注各種技術的進給和速度,還關注它們在 chewing on和 generating tokens方面的盈利能力。

現在,Wade 承認,這個用 Python 編寫且尚未命名的模擬器并不是“周期精確的 RTL 模擬器”(cycle accurate RTL simulator),但表示它的設計旨在整合一大堆關鍵組件的規格——GPU 速度和饋送、HBM 內存和容量、封裝外 I/O、網絡、CPU 主機、GPU 的 DRAM 擴展內存等等——并預測各種 AI 基礎模型的性能以及處理每個token的相對成本。

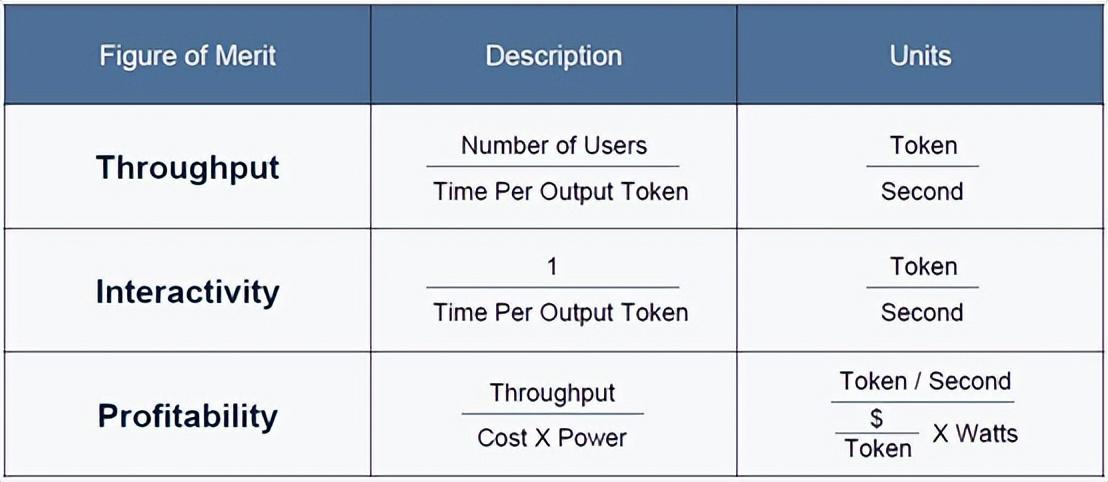

AI 系統架構模擬器關注三個性能指標,而不僅僅是大多數人談論的兩個。它們是吞吐量和交互性,每個人都對此著迷,但也將處理的盈利能力納入考量。提醒一下:

顯然,Ayar Labs 認為 AI 集群節點的所有關鍵元素——CPU、GPU、擴展 DRAM 內存以及用于連接 GPU 的節點內擴展交換——都應該使用光學而不是電互連,具體來說,AI 服務器應該使用由其 SuperNova 激光器泵浦(pumped )的 TeraPHY 設備。

但在我們開始進行系統架構比較之前,Wade 為他的論點添加了另一個層次,區分了三種不同類型的 AI 應用領域:

第一種是批處理( batch processing),其中查詢組被捆綁在一起并一起處理,就像五十年前的大型機事務更新一樣。(好吧,就像大型機在今天的夜班期間所做的大量工作一樣。)批處理級別需要每秒 25 個tokens或更少的交互級別。人機交互(我們習慣于以生成文本或圖像的 API 形式公開的應用程序)需要以每秒 25 到 50 個tokens的速度運行。而機器對機器代理應用程序的圣杯,其中各種 AI 以高速相互通信以解決特定問題 - 需要每秒 50 個tokens以上的交互率(interactivity rates)。

后一種應用在使用電氣互連的經濟實惠的系統上很難實現,正如 Ayar Labs 模擬器所示。公平地說,像 Nvidia 這樣的公司之所以如此粗暴地使用電氣互連和銅線,是因為個別光學元件的可靠性和成本問題仍需要解決。

但 Wade 表示,這些問題正在得到解決,而且其 TeraPHY 和 SuperNova 組合可以與 2026 年及以后推出的 GPU 一代相交叉。

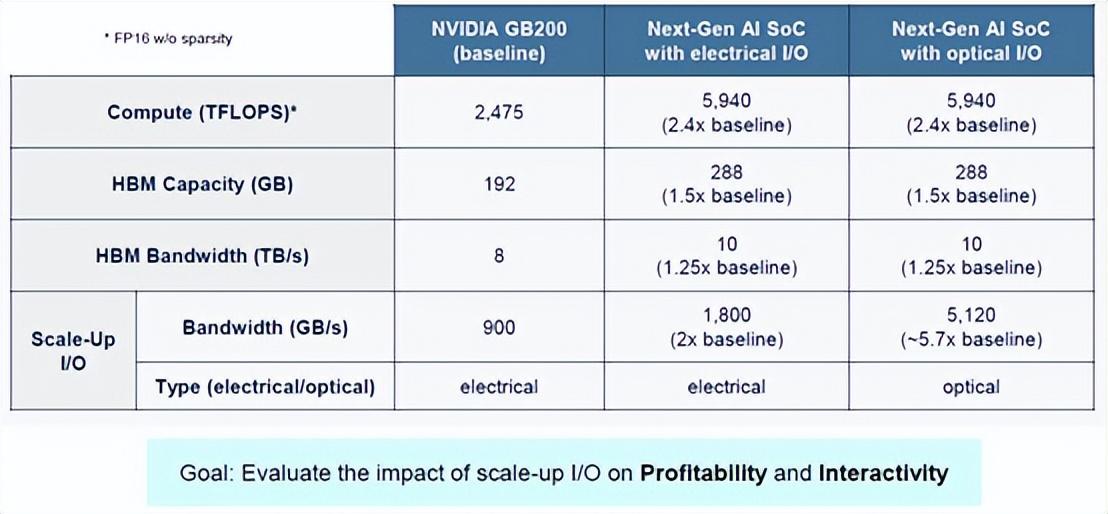

話雖如此,讓我們來看看 Blackwell GPU 的饋送和速度,以及Nvidia 2026 年路線圖上的未來“Rubin”GPU 以及 2027 年內存升級,可能會采用當前的電氣/銅線方式和假設的光纖/光纖方式進行架構。看一下這個:

Nvidia GB200 節點有一個“Grace”CG100 Arm CPU 和一對 Blackwell GB100 GPU 加速器,因此顯示的計算容量是規格表上的一半。看起來 GB200 將獲得 192 GB 的 HBM 容量和 8 TB/秒的完整帶寬,而 HGX B100 和 HGX B200 卡將獲得容量僅為 180 GB 的 Blackwell。至少目前如此。擴展電氣 I/O 來自每個 Blackwell 芯片上的 NVLink 5 控制器,該控制器有 18 個端口,運行速度為 224 Gb/秒,為 Blackwell GPU 提供 900 GB/秒的總傳輸和接收帶寬(總計 1.8 TB/秒)。

Wade 對 Rubin GPU 的外觀做了一些假設,我們認為它很有可能由四個通過 NVLink 6-C2C SerDes 互連的受限光罩(reticle-limited) GPU 芯片組成,就像 Blackwell 是兩個通過 NVLink 5-C2C SerDes 互連的受限光罩 GPU 一樣。我們知道 Rubin HBM 內存將提升至 288 GB,我們和 Wade 都預計 Rubin 設備中的帶寬將提升至每臺設備約 10 TB/秒。(2027 年,Rubin Ultra kicker 中的帶寬可能會進一步提升至 12 TB/秒。)可以合理地假設 NVLink 6 端口將再次將電氣互連的性能提高一倍,達到單向 1.8 TB/秒,這可能是通過將每個端口的信號量增加一倍來實現的。

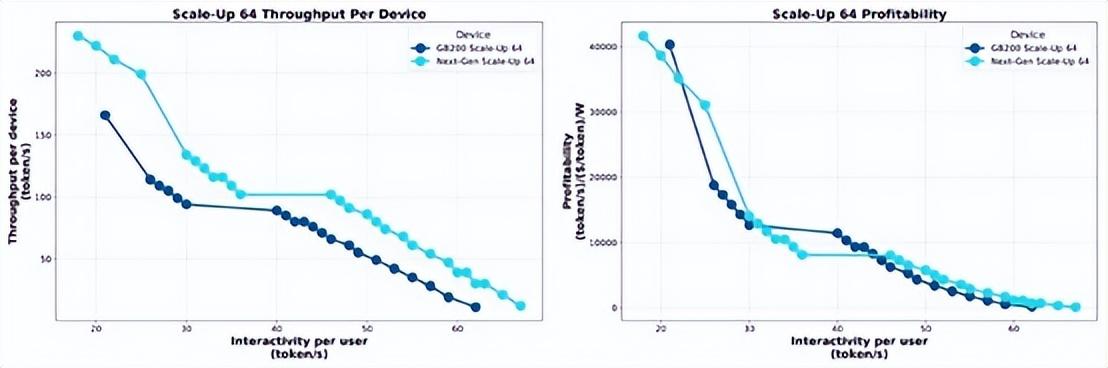

Ayar Labs 模擬器用 TeraPHY 光纖鏈路替換 NVLink 6-C2C,這樣,每個方向的帶寬將增加 5.7 倍,達到 5 TB/秒。模擬器還假設,與機架式 Blackwell 系統中使用的 NVSwitch 4 ASIC 相比,NVSwitch 5 芯片在 Rubin 一代中的性能將翻倍,而 Nvidia 將再次直接從 NVSwitch 5 芯片中驅動電信號。如果您通過 Ayar Labs AI 系統架構模擬器運行這兩個假設的 Nvidia 場景,并測量吞吐量和盈利能力(在互聯網時代我們稱之為每 SWaP 的美元,SWaP 是空間、瓦特和功率的縮寫),在一系列交互中,您會得到這張漂亮的圖表:

正如您所看到的,在具有電信號的 64 GPU 系統中,從 Blackwell 轉移到 Rubin 并沒有真正在一定交互水平的吞吐量方面產生太大的變化,并且每瓦特每單位工作成本也不會有太大變化。看起來,對于給定的工作單位,Rubin 的成本將與 Blackwell 相同,至少對于 Wade 所做的假設而言是如此。(考慮到現在在 AI 領域的高層,時間就是金錢,這對我們來說是合理的。)

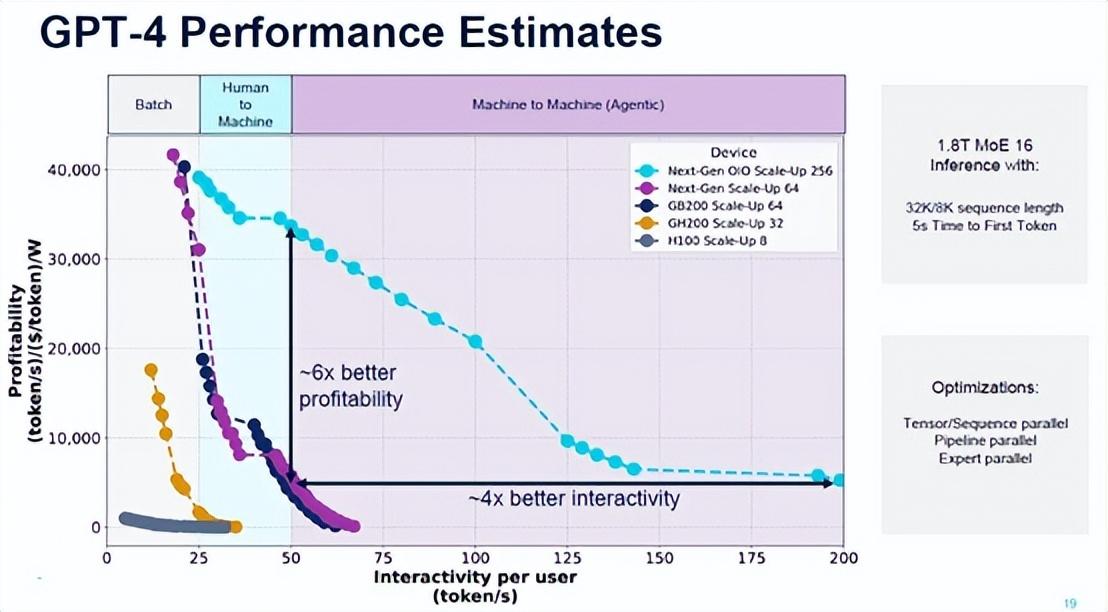

現在事情會變得有趣起來。讓我們看看 OpenAI 的 GPT-4 大型語言模型如何在 Ayar Labs 模擬器中針對不同規模的不同 Nvidia GPU 在盈利能力與交互性方面對運行推理進行對比:

這張圖表非常有趣。

首先,它表明八路 Hopper H100 節點對于批量 GenAI 來說是可以接受的,并且幾乎無法進行人機對話。有了 32 個 GH200 超級芯片集群(配備 141 GB HBM3E 內存),批量 GenAI 的成本大大降低,性能相對于較小的 H100 節點也有了很大的提高。配備 64 個 GPU 的 GB200 節點開始真正彎曲曲線,但在 64 個 GPU 的情況下,GB200 和未來的 GR200 之間的差異并不明顯。

但是,看看當 Rubin 推出光學 I/O 而不是電氣 NVLink 端口和電氣 NVSwitch 端口時會發生什么,并且機器擴展到 256 個連貫的 GPU,這在銅纜中是不可能的,因為您無法將那么多 GPU 彼此靠近以進行互連。機器對機器的多模型處理不僅成為可能。(再次,我們將指出:不要將機器聯網…… TeraPHY 確實如此。)假設的 Rubin GPU 的盈利能力和吞吐量相互作用的曲線在使用光學 I/O 時要好得多。

這張圖表表明了一些事情:Ayar Labs 正在試圖讓 Nvidia 收購它,或者試圖讓 Nvidia 使用其 OIO 芯片,或者嘗試過但失敗了,并利用這個故事試圖讓 AMD 收購它。英特爾現在連一杯咖啡都買不起。

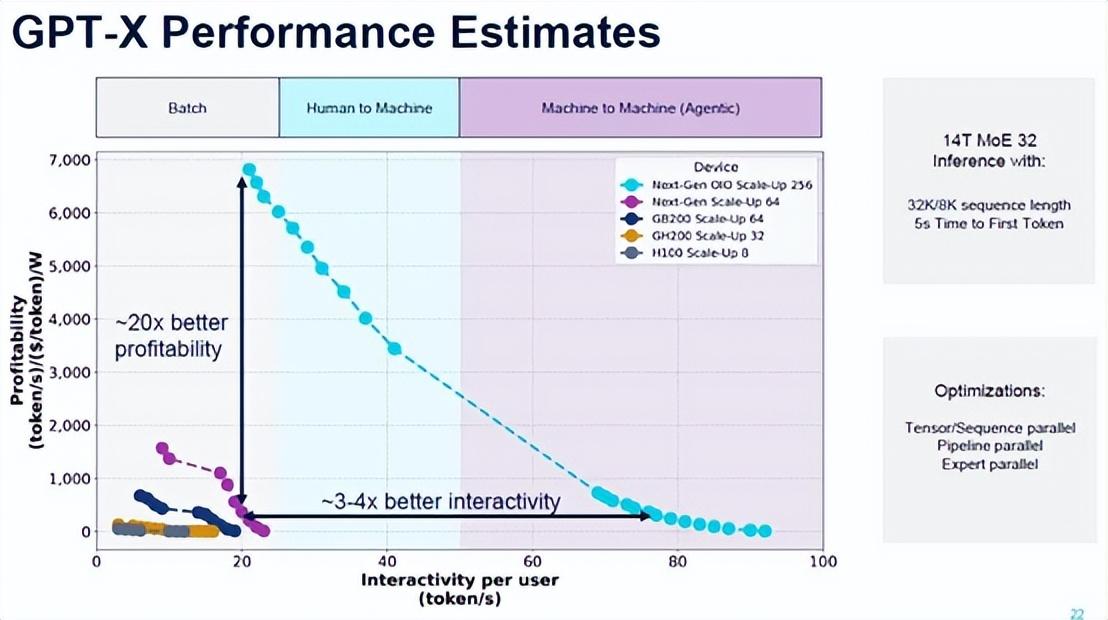

現在,讓我們來看看 OpenAI 在 2026 年左右推出的最先進的 GPT 模型,我們假設它將被稱為 GPT-6,但為了安全起見,Wade 將其稱為 GPT-X。

隨著 2026 年 GPT-X 的推出,該模型的復雜度將翻倍,達到 32 個不同的模型(稱為專家模型),而 Wade 預計模型的層數將從 GPT-4 的 120 層增加到 128 層。(我們認為層數可能會更高,可能高達 192 層;我們拭目以待)。標記序列長度將保持穩定,輸入為 32k,輸出為 8K,文本嵌入的模型維數將翻倍,達到 20,480。

如下所示,現有的 Hopper 和 Blackwell 配置從 8 個 GPU 擴展到 64 個 GPU,所有機器都被推入批量性能領域,只有采用銅 NVLink 互連的 Rubin 機架式機器才能進入人機領域。但是,借助節點內和節點間的光學 I/O 以及擴展到 256 個 Rubin GPU,Nvidia 可以構建一臺可以擴展到人機和機器對機器領域的推理機,同時在交互性和成本方面提供可接受的改進。

該圖表是 Ayar Labs、Eliyan、Avicena、Lightmatter 和 Celestial AI 等公司的廣告。我們強烈懷疑 Rubin 會將 NVLink 轉移到光學互連,坦率地說,考慮到Nvidia 多年前所做的原型設計以及 Nvidia 已經與 Ayar Labs 以及很可能與上面提到的其他一些公司合作的工作,我們已經預料到這樣的機器了。

NVLink 只是一種協議,現在或許是時候將其轉移到光學傳輸中了。我們迫不及待地想看看 Nvidia 會在這里做些什么。在機架中塞入更多 GPU 并將功率密度提高到 200 千瓦或人們談論的瘋狂的 500 千瓦可能不是答案。光學互連會將這個鐵芯稍微隔開一點,也許足以防止光學器件出現不良行為。

-

半導體

+關注

關注

334文章

27010瀏覽量

216300 -

gpu

+關注

關注

28文章

4701瀏覽量

128705 -

交換機

+關注

關注

21文章

2622瀏覽量

99259

發布評論請先 登錄

相關推薦

光貓產品需不需要做CTA進網許可認證?

光進銅退,已成定局?

光進銅退,已成定局?

評論