9月19日凌晨,阿里通義千問正式開源Qwen2.5系列大模型,最新發(fā)布包括了語言模型Qwen2.5,以及專門針對編程的Qwen2.5-Coder和數(shù)學(xué)的Qwen2.5-Math模型。PerfXCloud(澎峰云)大模型開發(fā)與服務(wù)平臺第一時間支持Qwen2.5 72B并在平臺完成上線,趕快來體驗吧!

Qwen2.5系列模型

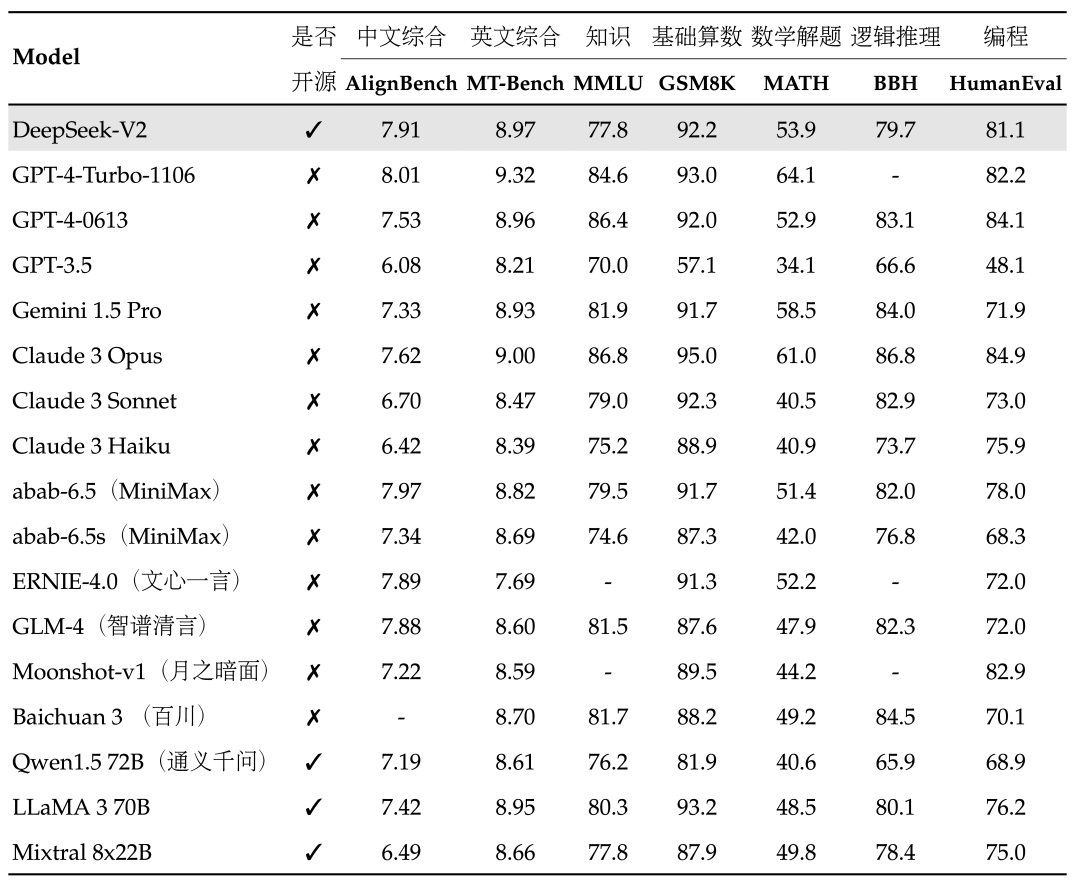

更大的訓(xùn)練數(shù)據(jù)集:Qwen2.5語言模型的所有尺寸都在最新的大規(guī)模數(shù)據(jù)集上進行了預(yù)訓(xùn)練,該數(shù)據(jù)集包含多達18Ttokens。相較于Qwen2,Qwen2.5獲得了顯著更多的知識(MMLU:85+),并在編程能力(HumanEval 85+)和數(shù)學(xué)能力(MATH 80+)方面有了大幅提升。

更強的指令遵循能力:新模型在指令執(zhí)行、生成長文本(超過8K標記)、理解結(jié)構(gòu)化數(shù)據(jù)(例如表格)以及生成結(jié)構(gòu)化輸出特別是JSON方面取得了顯著改進。Qwen2.5模型總體上對各種system prompt更具適應(yīng)性,增強了角色扮演實現(xiàn)和聊天機器人的條件設(shè)置功能。

長文本支持能力:與Qwen2類似,Qwen2.5語言模型支持高達128K tokens,并能生成最多8K tokens的內(nèi)容。

強大的多語言能力:它們同樣保持了對包括中文、英文、法文、西班牙文、葡萄牙文、德文、意大利文、俄文、日文、韓文、越南文、泰文、阿拉伯文等29種以上語言的支持。

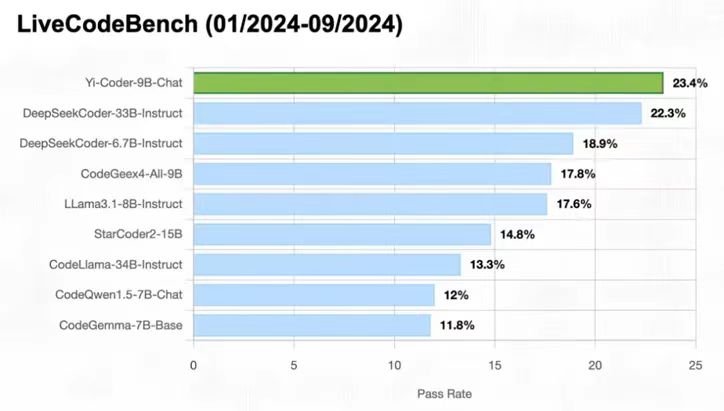

專業(yè)領(lǐng)域的專家語言模型能力增強:即用于編程的Qwen2.5-Coder和用于數(shù)學(xué)的Qwen2.5-Math,相比其前身CodeQwen1.5和Qwen2-Math有了實質(zhì)性的改進。具體來說,Qwen2.5-Coder在包含5.5T tokens編程相關(guān)數(shù)據(jù)上進行了訓(xùn)練,使即使較小的編程專用模型也能在編程評估基準測試中表現(xiàn)出媲美大型語言模型的競爭力。同時,Qwen2.5-Math支持中文和英文,并整合了多種推理方法,包括CoT(Chain of Thought)、PoT(Program of Thought)和TIR(Tool-Integrated Reasoning)。

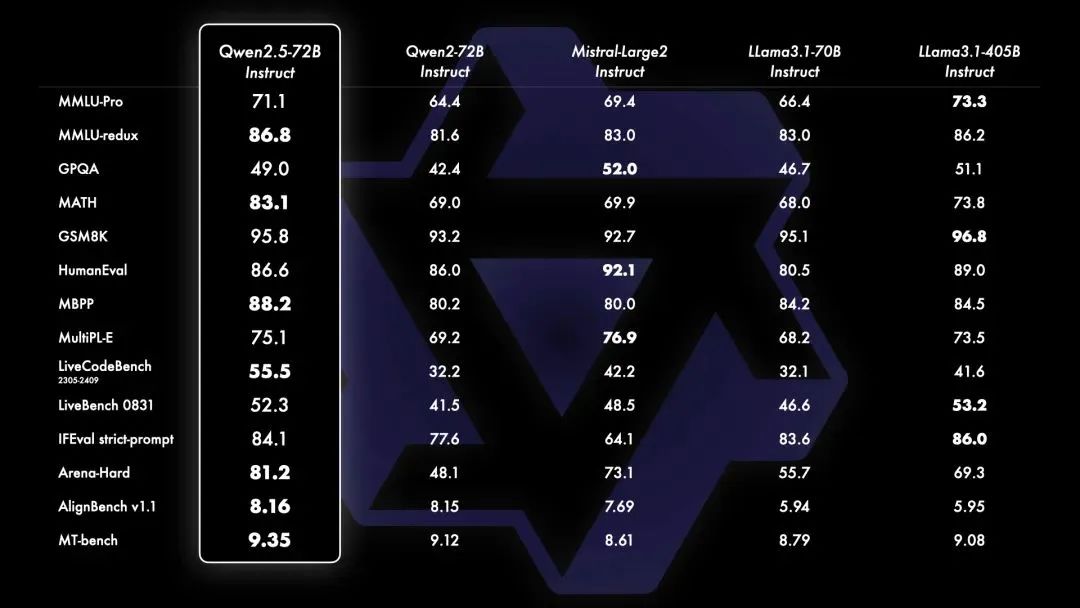

Qwen2.5-72B在多個基準測試中的結(jié)果

審核編輯 黃宇

-

開源

+關(guān)注

關(guān)注

3文章

3256瀏覽量

42419 -

模型

+關(guān)注

關(guān)注

1文章

3178瀏覽量

48729 -

大模型

+關(guān)注

關(guān)注

2文章

2339瀏覽量

2499

發(fā)布評論請先 登錄

相關(guān)推薦

阿里通義千問發(fā)布Qwen2.5-Turbo開源AI模型

阿里云開源Qwen2.5-Coder代碼模型系列

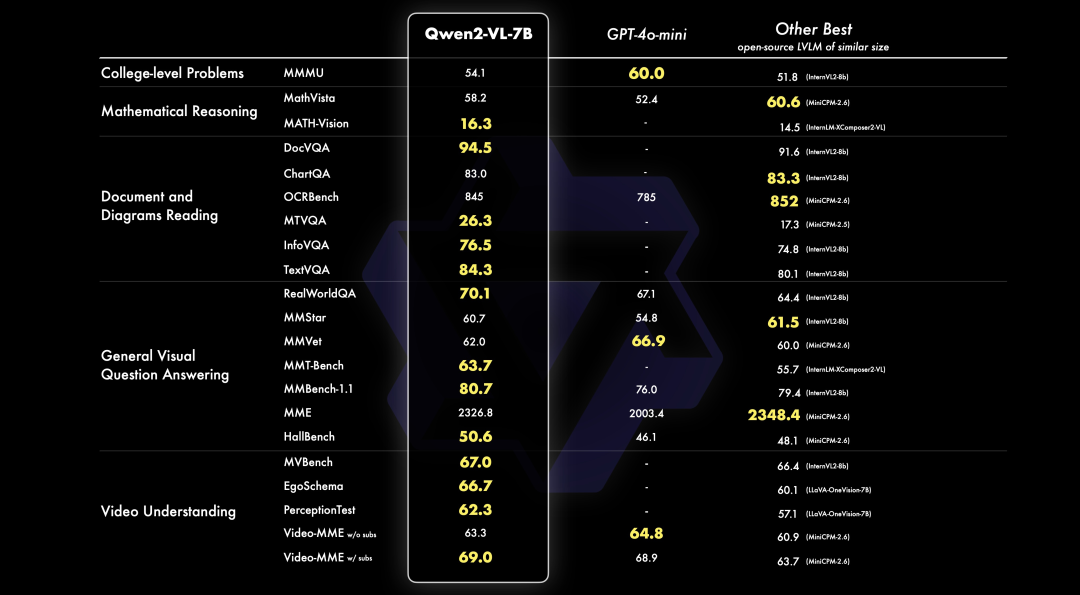

PerfXCloud重磅升級 阿里開源最強視覺語言模型Qwen2-VL-7B強勢上線!

零一萬物正式開源Yi-Coder系列模型 PerfXCloud火速支持等你體驗!

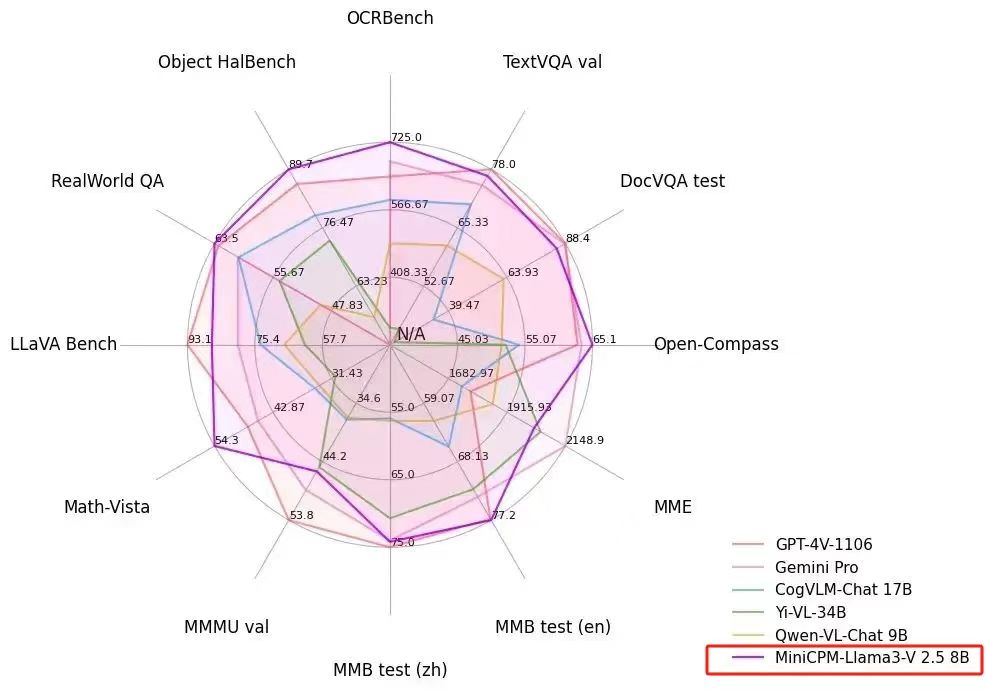

PerfXCloud 重大更新 端側(cè)多模態(tài)模型 MiniCPM-Llama3-V 2.5 閃亮上架

阿里Qwen2-Math系列震撼發(fā)布,數(shù)學(xué)推理能力領(lǐng)跑全球

PerfXCloud順利接入MOE大模型DeepSeek-V2

阿里通義千問Qwen2大模型發(fā)布并同步開源

通義千問開源千億級參數(shù)模型

通義千問推出1100億參數(shù)開源模型

Meta推出最強開源模型Llama 3 要挑戰(zhàn)GPT

新火種AI|谷歌深夜炸彈!史上最強開源模型Gemma,打響新一輪AI之戰(zhàn)

號稱全球最強開源模型 ——Qwen2.5 系列震撼來襲!PerfXCloud同步上線,快來體驗!

號稱全球最強開源模型 ——Qwen2.5 系列震撼來襲!PerfXCloud同步上線,快來體驗!

評論