訓(xùn)練一個(gè)神經(jīng)網(wǎng)絡(luò)通常要利用損失函數(shù)了解網(wǎng)絡(luò)生成的結(jié)果與目標(biāo)結(jié)果有多遠(yuǎn)。例如,在圖像分類網(wǎng)絡(luò)中,損失函數(shù)通常會(huì)對(duì)錯(cuò)誤的分類進(jìn)行懲罰;如果網(wǎng)絡(luò)將狗誤認(rèn)為貓,那就會(huì)造成很大的損失。然而,并不是所有問(wèn)題都能很輕易地用損失函數(shù)來(lái)定義,尤其是涉及人類感知方面的決定,例如圖像壓縮或文本到語(yǔ)音系統(tǒng)的應(yīng)用。生成對(duì)抗網(wǎng)絡(luò)(GANs)作為一種機(jī)器學(xué)習(xí)工具,使許多領(lǐng)域的應(yīng)用都得到了改善,包括用文本生成圖像、超分辨率圖像的生成、教機(jī)器人學(xué)習(xí)抓握以及提供解決方案。然而,這些新的理論和軟件工程上的挑戰(zhàn)卻難以跟上GANs研究的步伐。

生成網(wǎng)絡(luò)不斷改進(jìn)的過(guò)程。剛開(kāi)始會(huì)生成隨機(jī)的噪音,最終網(wǎng)絡(luò)學(xué)會(huì)生成MNIST數(shù)字集

為了讓生成對(duì)抗網(wǎng)絡(luò)更易于實(shí)驗(yàn),谷歌開(kāi)發(fā)者開(kāi)源了一個(gè)輕量級(jí)的庫(kù)——TFGAN,它可以讓GAN的訓(xùn)練和評(píng)估過(guò)程更容易。同時(shí),TFGAN提供了經(jīng)過(guò)良好測(cè)試的損失函數(shù)和評(píng)估指標(biāo),并提供了易于使用的例子,突出了TFGAN強(qiáng)大的表現(xiàn)力和靈活性。同時(shí),谷歌還發(fā)布了一個(gè)教程,包括一個(gè)高級(jí)API,可以快速得到在你的數(shù)據(jù)上訓(xùn)練的模型。

該圖表明了對(duì)抗性損失在圖像壓縮上的影響。最上層是ImageNet中的圖像補(bǔ)丁。中間一行是在傳統(tǒng)損失上訓(xùn)練的神經(jīng)網(wǎng)絡(luò)壓縮和解壓縮圖像的結(jié)果。最下面一行展示了在傳統(tǒng)損失和對(duì)抗損失上訓(xùn)練的兩種不同結(jié)果。由此可見(jiàn),生成對(duì)抗網(wǎng)絡(luò)損失的圖像更清晰、更細(xì)致,但與原圖還是有一定差距

除此之外,TFGAN提供簡(jiǎn)單的函數(shù)能覆蓋大多數(shù)GANs的案例,所以只需幾行代碼就能讓模型在你的數(shù)據(jù)上運(yùn)行。但是它是以模塊化的方式構(gòu)建的,為的是支持更多GANs設(shè)計(jì)。開(kāi)發(fā)者可以用任何模塊進(jìn)行損失、評(píng)估、訓(xùn)練函數(shù)。

大多數(shù)文本到語(yǔ)音(TTS)神經(jīng)網(wǎng)絡(luò)系統(tǒng)會(huì)產(chǎn)生過(guò)于平滑的圖譜。當(dāng)把生成對(duì)抗網(wǎng)絡(luò)應(yīng)用到Tacotron TTS系統(tǒng)中后,可以有效消除其中的人工痕跡

TFGAN的輕量級(jí)設(shè)計(jì)可以允許其與其他框架一起使用,或與本機(jī)TensorFlow代碼一起使用。利用TFGAN寫成的GAN模型在未來(lái)可以輕易的進(jìn)行改進(jìn),用戶可以從大量已經(jīng)實(shí)現(xiàn)的損失和功能中選擇,無(wú)需重新編寫模型。

最后,TFGAN的代碼已經(jīng)經(jīng)過(guò)了充分的測(cè)試,用戶不必?fù)?dān)心經(jīng)常出現(xiàn)的數(shù)字或統(tǒng)計(jì)錯(cuò)誤。

-

谷歌

+關(guān)注

關(guān)注

27文章

6141瀏覽量

105087 -

GaN

+關(guān)注

關(guān)注

19文章

1918瀏覽量

72975 -

tfgan

+關(guān)注

關(guān)注

0文章

2瀏覽量

1647

原文標(biāo)題:谷歌發(fā)布生成對(duì)抗網(wǎng)絡(luò)輕量級(jí)庫(kù)——TFGAN

文章出處:【微信號(hào):jqr_AI,微信公眾號(hào):論智】歡迎添加關(guān)注!文章轉(zhuǎn)載請(qǐng)注明出處。

發(fā)布評(píng)論請(qǐng)先 登錄

相關(guān)推薦

圖像生成對(duì)抗生成網(wǎng)絡(luò)gan_GAN生成汽車圖像 精選資料推薦

圖像生成對(duì)抗生成網(wǎng)絡(luò)

谷歌開(kāi)源TFGAN輕量級(jí)的工具庫(kù) 目的是讓訓(xùn)練和評(píng)估GAN變得更加簡(jiǎn)單

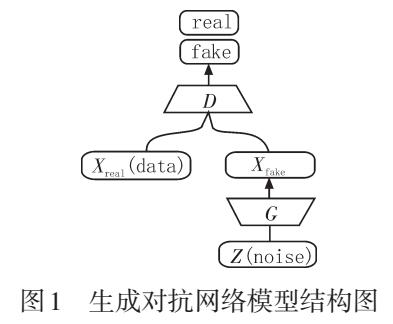

生成對(duì)抗網(wǎng)絡(luò)模型綜述

生成對(duì)抗網(wǎng)絡(luò)GAN,正在成為新的“深度學(xué)習(xí)”

生成對(duì)抗網(wǎng)絡(luò)在計(jì)算機(jī)視覺(jué)領(lǐng)域有什么應(yīng)用

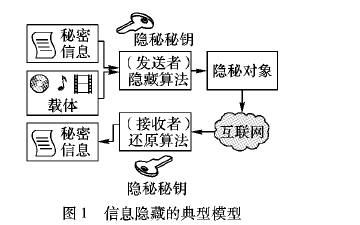

如何使用生成對(duì)抗網(wǎng)絡(luò)進(jìn)行信息隱藏方案資料說(shuō)明

生成對(duì)抗網(wǎng)絡(luò)之父伊恩·古德費(fèi)洛正式宣布加盟蘋果

基于密集卷積生成對(duì)抗網(wǎng)絡(luò)的圖像修復(fù)方法

基于結(jié)構(gòu)保持生成對(duì)抗網(wǎng)絡(luò)的圖像去噪

基于像素級(jí)生成對(duì)抗網(wǎng)絡(luò)的圖像彩色化模型

一款適合初學(xué)者超輕量級(jí)C語(yǔ)言網(wǎng)絡(luò)庫(kù)—Dyad

PyTorch教程20.2之深度卷積生成對(duì)抗網(wǎng)絡(luò)

谷歌開(kāi)發(fā)一個(gè)輕量級(jí)的庫(kù)——TFGAN 它可以讓生成對(duì)抗網(wǎng)絡(luò)更易于實(shí)驗(yàn)

谷歌開(kāi)發(fā)一個(gè)輕量級(jí)的庫(kù)——TFGAN 它可以讓生成對(duì)抗網(wǎng)絡(luò)更易于實(shí)驗(yàn)

評(píng)論