隨著AI技術的快速發展,語言不再是溝通的障礙。最新的AI同聲傳譯技術的突破,讓每個人都可以在不同語言環境下無縫交流,不必擔心語言差異帶來的不便。這種技術讓每個普通人隨時“攜帶”一個專屬的同聲傳譯員出門成為可能。那么,隨著技術的成熟,哪些應用場景將最先受到影響,成為我們日常生活的一部分?

當下,許多人對AI翻譯軟件已經不再陌生,這些軟件大多依托于文字翻譯技術,并逐步融入了AI語音合成功能,來模擬同聲傳譯的體驗。例如,科大訊飛同傳、有道翻譯官和騰訊翻譯君等產品,都是這一領域的代表。這類軟件的工作原理一般是首先快速識別講話者的語音,并將其轉化為文字,再通過強大的自然語言處理算法對這些文字進行翻譯,最后將翻譯后每個句子逐個轉化成語音并播放,實現“實時翻譯”的效果。

然而,這一系列流程不可避免地會帶來翻譯延遲問題。為了減少延遲,許多翻譯軟件選擇放棄語音播放功能,轉而只顯示翻譯后的文字。這種方式能夠實時翻譯語音并以“字幕”的形式不斷更新,即便由于輸入的變化導致翻譯結果頻繁調整、推倒重來,也不會影響用戶的閱讀體驗。通過取消語音播放,更新后的翻譯內容可以更迅速、連續地呈現在用戶面前,從而提升整體使用體驗。

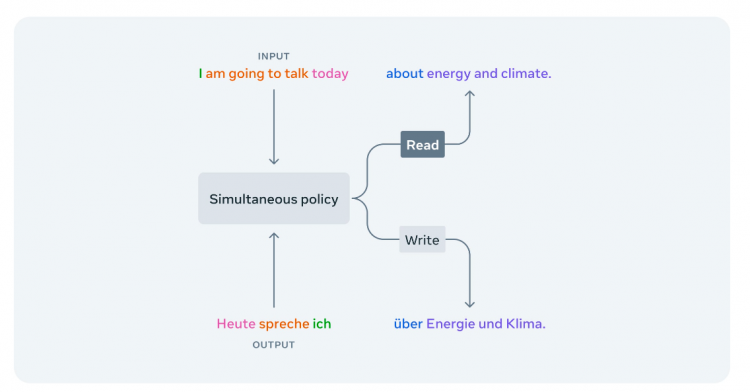

而AI同聲傳譯模型則使用了完全不同的原理。

得益于近年AI模型的爆發性進展,追求極低延遲的、直接將語音翻譯成語音的同聲傳譯模型在2024年開始逐漸出現。這類模型目的是直接或間接地將語音翻譯成目標語言的語音。其中,三款表現出色的模型尤其受到關注,也是最接近真人同聲傳譯的方案:Meta(原Facebook)的Seamless-Streaming,中科院計算技術研究所的StreamSpeech,以及知了未來的同聲傳譯v3模型。這類模型的有別于傳統的AI翻譯軟件,它會嘗試模仿人類翻譯時的行為,不將發言人講話的內容立馬翻譯出來,而是邊“聽”邊判斷當前發言內容是否足夠適合完整、是否需要聽取更多的內容才能進行翻譯。

Meta在AI領域擁有顯著的影響力,尤其是在開源貢獻和前沿技術研究方面。其AI研究部門Meta AI多個人工智能領域取得了重要突破,LLaMA(大型語言模型)作為其推出的開源模型,已經在AI研究界廣泛使用;并且其推出的開源框架PyTorch已經成為全球AI研究和應用中的主流工具。其同聲傳譯模型Seamless-Streaming此次同樣開源,允許任何人訪問其核心原理,根據其發表的相關論文顯示(https://ai.meta.com/resources/models-and-libraries/seamless-communication-models/),Seamless-Streaming選擇使用“EMMA”策略來判斷翻譯機是否應該立刻翻譯聽取到的內容還是等待更多內容的輸入。在測試使用中,Seamless-Streaming模型做到了3秒左右的延遲的準確翻譯,簡單來說就是翻譯內容滯后于原本發言3秒鐘左右。相較于傳統AI翻譯軟件“同聲傳譯”的15秒以上的延遲有了突破性的優化,真正達到了真人同聲傳譯延遲的水準,但可惜準確性相較于傳統AI翻譯仍有些不足。尤其是中文等復雜語言的翻譯測試中,時長出現會錯意、聽不懂“言下之意”的問題。

而作為國內最高學術機構和綜合性科研中心,中科院同樣開源了其關于StreamSpeech模型的研究。根據其發表的論文顯示(https://arxiv.org/abs/2406.03049),StreamSpeech主要采用了檢查“Alignments”的方式來判斷翻譯機的等待與否。令人震驚的是,該翻譯模型的翻譯延遲達到了驚人的0.3秒,值得一提的是,這甚至于人類的平均反應時間相當。這一翻譯速度已經遠遠超過真人能企及的水平,對于真人同聲傳譯員來說,從演講人說出單詞到聽到并理解到腦中的時間就已不止0.3秒。可惜目前該模行開源的部分中該模型僅支持英法、英西、英德的翻譯,暫時不支持中文。并且在低延遲模型的測試中,翻譯的流暢程度有些差強人意,翻譯出來的內容更像是“逐字機翻”而非流暢的翻譯語句意思。這個問題的出現更多是因為延遲太低,導致翻譯機“被迫”翻譯一些還沒有完成的句子所造成的。

不同于Meta與中科院,知了未來是一支位于倫敦的小型華人研發團隊。該團隊目前正在融資中,且并尚未開源其模型;其關于此模型公開信息僅有測試體驗窗口(https://translate.weil-ai.com/)與論文摘要。根據其公開的論文摘要顯示,知了未來的同聲傳譯v3模型相較于前兩家,創新之處在于其將“是否等待更多輸入”的功能直接交給了翻譯模型。現在其正在內測兩款模型:小(mini)模型以低延遲為首要目標,根據內測其翻譯延遲平均為1-3秒,在發言人講話清晰時翻譯準確率遠超上述兩款模型。大(large)模型以高精度為特點,翻譯延遲平均為2-5秒,而翻譯準確與流暢程度達到甚至超越了真人水準,甚至支持中英混合表達、古詩詞、方言與流行梗的準確翻譯。美中不足的是該模型目前內測名額有限,并且測試火爆經常出現排隊使用的狀況;其網頁翻譯功能距離落地產品還有一段距離,目前更像一個“模型展示”的網頁。

綜上所述,AI同聲傳譯的技術突破已經讓更多潛在的可能性進入現實,我們距離電影《流浪地球》中的“兩個不同語言的人戴上耳機之后可以正常交流”的場景已經肉眼可見的飛速接近。而當下最接近這個場景的知了未來同聲傳譯等軟件還未開始任何的產品落地;到底會先在哪個場景看到它的使用?誰會是第一批用戶?成為了交給市場的下一個問題。

在思考這個問題之前,我們回看一下同聲傳譯即將實現的核心功能:將講話人的聲音作為實時輸入,將翻譯好的語音模擬講話人的音調作為實時輸出。那么給定這個功能下,我們想了一些非常好的例子在這里分享給大家,希望能激發大家的靈感:

一、空乘播報

在國際航班上,乘務員通常被要求會講兩國甚至是多國語言。除了更好的服務旅客,更重要的是在飛行途中對于旅程等信息的播報,例如“入境須知、航班轉機信息”等內容需要讓不同國家的旅客聽明白的話就需要同時說不同的語言。而多語言對于空乘來說確實是一個不小的挑戰,但凡口語表達的不清晰就會給旅客造成困擾。而AI同聲傳譯或許在這個時候就可以幫上忙,僅需要空乘會說一種語言,AI負責將其內容以相同的音色傳入乘客的耳中,讓飛機上來自五湖四海的旅客都可以聽清楚聽明白、并且讓旅途更安心。

二、在線教育

隨著在線教育的全球化進程加快,越來越多的教育平臺和機構希望吸引來自世界各地的學生。然而,語言差異常常成為學生獲取優質教育資源的障礙。尤其是母語為小語種的學生,在學習非母語課程時,往往不僅難以理解,還影響到他們在數學、物理等核心學科的學習能力,許多有天賦的學生因此被埋沒。AI同聲傳譯技術恰好能夠打破這一壁壘,為講師提供實時翻譯服務,使得無論講師使用何種語言授課,學生都能同步獲取翻譯內容,從而在全球化的教育環境中不再受到語言的限制。

AI同聲傳譯技術能夠為這些場合提供實時、精準的翻譯服務,避免信息傳遞中的延遲與誤解,從而促進更加高效的國際交流與合作。那除此之外,未來還有哪些可能的使用場景?或許下一個突破點,就藏在我們日常生活中的某個細節。隨著技術的不斷完善,AI同聲傳譯將逐步進入更多的日常應用場景,成為未來全球化溝通不可或缺的一部分。

未來已來,我們拭目以待。

審核編輯 黃宇

-

AI

+關注

關注

87文章

30106瀏覽量

268401 -

語音合成

+關注

關注

2文章

87瀏覽量

16140

發布評論請先 登錄

相關推薦

明明我說的是25G信號,你卻讓我看12.5G的損耗?

AI同聲傳譯技術的新興力量知了未來已推動跨語言溝通革新

中興通訊全場景AI終端應用與裸眼3D新品亮相

蓮偶科技發布XR新品系列

技術干貨驛站 ▏深入理解C語言:掌握常量,讓你的代碼更加穩固高效!

為什么幾乎所有ECU系統都同時使用外部WDG和內部WDG?

三星Galaxy AI將支持19種語言,覆蓋粵語及法語等

英偉達H200性能顯著提升,年內將推出B200新一代AI半導體

寧德時代市值一天暴增千億

cy8c6347在release下使用Cy_SysLib_Delay()延時產生了混亂的原因?

琢磨了一天的CAN協議

AI同聲傳譯讓你瞬間掌握60種語言的那一天會發生什么事情?

AI同聲傳譯讓你瞬間掌握60種語言的那一天會發生什么事情?

評論